Kopiowanie danych i przekształcanie przy użyciu parametrów dynamicznych (co godzinę)

DOTYCZY:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Napiwek

Wypróbuj usługę Data Factory w usłudze Microsoft Fabric — rozwiązanie analityczne typu all-in-one dla przedsiębiorstw. Usługa Microsoft Fabric obejmuje wszystko, od przenoszenia danych do nauki o danych, analizy w czasie rzeczywistym, analizy biznesowej i raportowania. Dowiedz się, jak bezpłatnie rozpocząć nową wersję próbną !

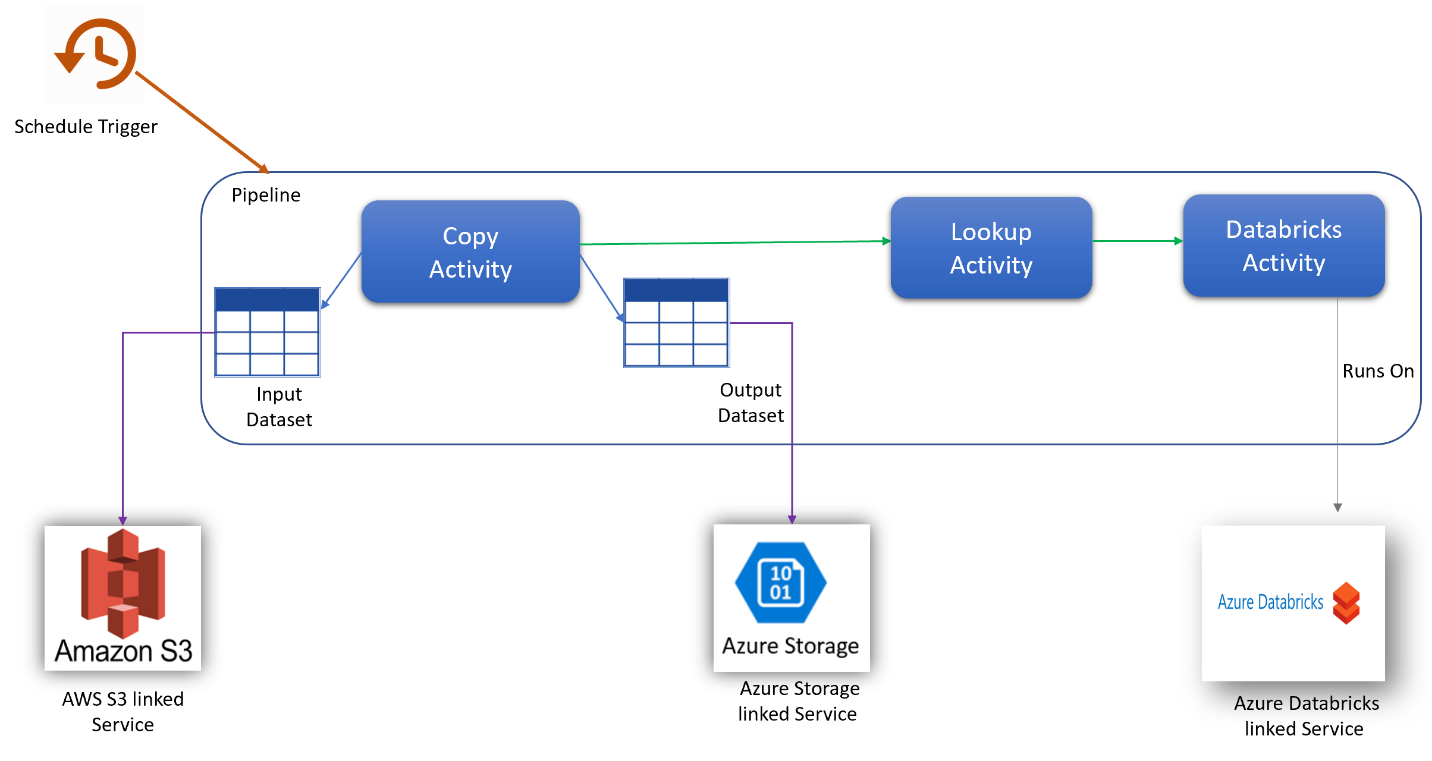

W tym scenariuszu chcesz skopiować dane z usługi AWS S3 do usługi Azure Blob Storage i przekształcić je za pomocą usługi Azure Databricks (z parametrami dynamicznymi w skrypcie) zgodnie z godzinnym harmonogramem przez 8 godzin każdego dnia w ciągu 30 dni.

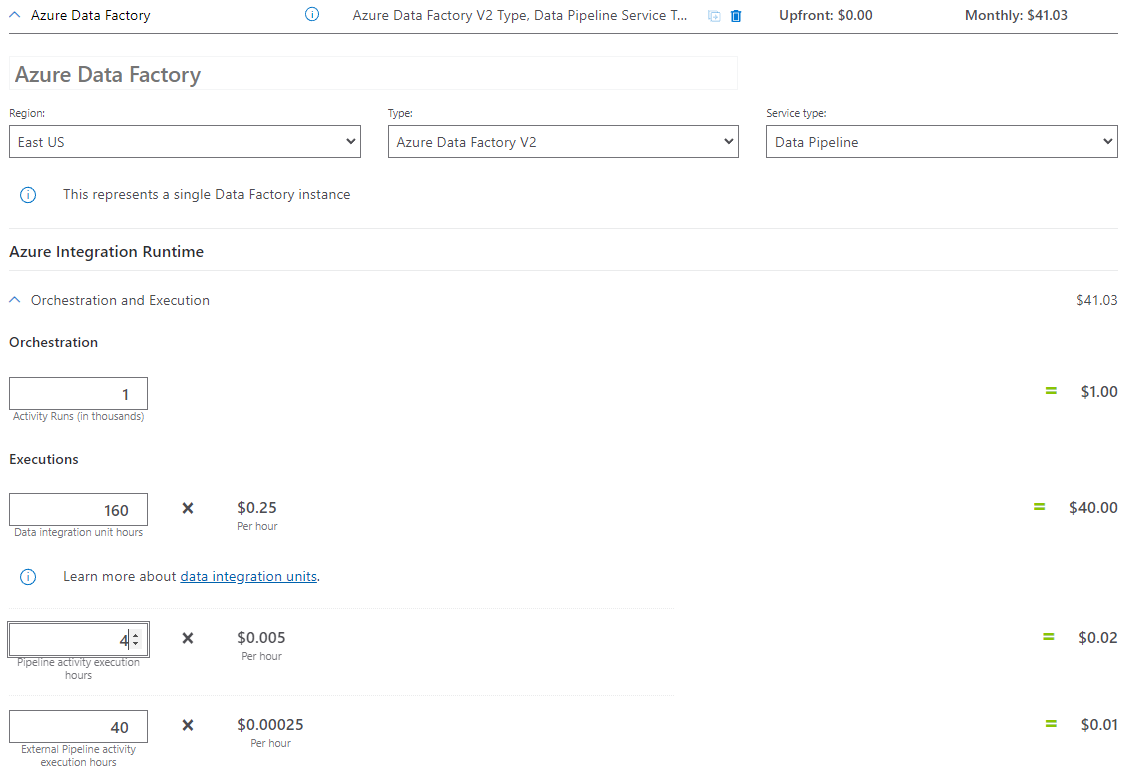

Ceny używane w tym przykładzie są hipotetyczne i nie są przeznaczone do oznaczania dokładnych rzeczywistych cen. Koszty odczytu/zapisu i monitorowania nie są wyświetlane, ponieważ są one zwykle niewielkie i nie będą miały znaczącego wpływu na ogólne koszty. Uruchomienia działań są również zaokrąglane do najbliższego 1000 w kalkulatorze cen.

Zapoznaj się z kalkulatorem cen platformy Azure, aby uzyskać bardziej szczegółowe scenariusze i oszacować przyszłe koszty korzystania z usługi.

Konfigurowanie

Aby zrealizować ten scenariusz, należy utworzyć potok z następującymi elementami:

- Jedno działanie kopiowania z wejściowym zestawem danych, który ma zostać skopiowany z usługi AWS S3, wyjściowy zestaw danych dla danych w usłudze Azure Storage.

- Jedno działanie lookup służące do dynamicznego przekazywania parametrów do skryptu przekształcania.

- Jedno działanie usługi Azure Databricks na potrzeby przekształcania danych.

- Jeden wyzwalacz harmonogramu do wykonywania potoku co godzinę przez 8 godzin dziennie. Jeśli chcesz uruchomić potok, możesz go wyzwolić natychmiast lub zaplanować. Oprócz samego potoku każde wystąpienie wyzwalacza jest liczone jako pojedyncze uruchomienie działania.

Szacowanie kosztów

| Operations | Typy i jednostki |

|---|---|

| Uruchamianie potoku | 4 Uruchomienia działań na wykonanie (1 dla uruchomienia wyzwalacza, 3 dla przebiegów działań) = 960 przebiegów działań, zaokrąglone w górę, ponieważ kalkulator zezwala tylko na przyrosty 1000. |

| Założenia dotyczące kopiowania danych: godziny diu na wykonanie = 10 minut | 10 min \ 60 min * 4 Środowisko Azure Integration Runtime (domyślne ustawienie DIU = 4) Aby uzyskać więcej informacji na temat jednostek integracji danych i optymalizacji wydajności kopiowania, zobacz ten artykuł |

| Wykonaj działanie Lookup, założenie: godziny aktywności potoku na wykonanie = 1 min | 1 min/60 min wykonywanie działania potoku |

| Wykonywanie działania usługi Databricks Założenia: zewnętrzne godziny wykonywania na wykonanie = 10 minut | 10 min/60 min wykonania działania potoku zewnętrznego |

Przykład cennika: przykład kalkulatora cen

Łączna cena scenariusza dla 30 dni: 41,03 USD

Powiązana zawartość

- Przykład cenowy: kopiowanie danych z usługi AWS S3 do usługi Azure Blob Storage co godzinę przez 30 dni

- Przykład cenowy: kopiowanie danych i przekształcanie za pomocą usługi Azure Databricks co godzinę przez 30 dni

- Przykład cenowy: uruchamianie pakietów usług SSIS w środowisku Azure-SSIS Integration Runtime

- Przykład cenowy: Używanie debugowania przepływu danych mapowania dla normalnego dnia roboczego

- Przykład cenowy: przekształcanie danych w magazynie obiektów blob za pomocą przepływów danych mapowania

- Przykład cenowy: integracja danych w zarządzanej sieci wirtualnej usługi Azure Data Factory

- Przykład cenowy: pobieranie danych różnicowych z usługi SAP ECC za pośrednictwem rozwiązania SAP CDC w przepływach danych mapowania

Opinia

Dostępne już wkrótce: W 2024 r. będziemy stopniowo wycofywać zgłoszenia z serwisu GitHub jako mechanizm przesyłania opinii na temat zawartości i zastępować go nowym systemem opinii. Aby uzyskać więcej informacji, sprawdź: https://aka.ms/ContentUserFeedback.

Prześlij i wyświetl opinię dla