Wykaz modeli i kolekcje

Wykaz modeli w usłudze Azure Machine Learning Studio to centrum do odnajdywania i używania szerokiej gamy modeli, które umożliwiają tworzenie aplikacji generujących sztuczną inteligencję. Wykaz modeli zawiera setki modeli od dostawców modeli, takich jak usługa Azure OpenAI, Mistral, Meta, Cohere, Nvidia, Hugging Face, w tym modele trenowane przez firmę Microsoft. Modele od dostawców innych niż Microsoft są produktami innych niż Microsoft, zgodnie z definicją w warunkach produktu firmy Microsoft i podlegają warunkom dostarczonym z modelem.

Kolekcje modeli

Modele są zorganizowane według kolekcji w katalogu modeli. Istnieją trzy typy kolekcji w wykazie modeli:

- Modele wyselekcjonowane według usługi Azure AI: najbardziej popularne, otwarte modele innych firm z wagą i właściwościami, pakowane i optymalizowane pod kątem bezproblemowej pracy na platformie Azure AI. Korzystanie z tych modeli podlega postanowieniom licencyjnym dostawcy modelu dostarczonym z modelem. Po wdrożeniu w usłudze Azure Machine Learning, dostępność modelu podlega odpowiedniej umowie SLA platformy Azure, a firma Microsoft zapewnia pomoc techniczną dotyczącą problemów z wdrażaniem. Modele od partnerów, takich jak Meta, NVIDIA, Mistral AI, to przykłady modeli dostępnych w kolekcji "Nadzorowane przez sztuczną inteligencję platformy Azure" w katalogu. Te modele można rozpoznać po zielonym znaczniku wyboru na kafelkach modelu w katalogu lub filtrować według kolekcji „Wyselekcjonowane według usługi Azure AI”.

- Modele azure OpenAI, dostępne wyłącznie na platformie Azure: flagowe modele usługi Azure OpenAI za pośrednictwem kolekcji "Azure OpenAI" za pośrednictwem integracji z usługą Azure OpenAI. Te modele są obsługiwane przez firmę Microsoft, a ich użycie podlega warunkom produktu i umowie SLA dla usługi Azure OpenAI Service.

- Otwarte modele z centrum Hugging Face: setki modeli z centrum HuggingFace są dostępne za pośrednictwem kolekcji "Hugging Face" na potrzeby wnioskowania w czasie rzeczywistym z punktami końcowymi online. Hugging Face tworzy i utrzymuje modele wymienione w kolekcji HuggingFace. Aby uzyskać pomoc, skorzystaj z forum HuggingFace lub pomocy technicznej aplikacji HuggingFace. Dowiedz się więcej o tym, jak wdrażać modele z usługi Hugging Face.

Sugerowanie dodatków do wykazu modeli: możesz przesłać żądanie dodania modelu do wykazu modeli przy użyciu tego formularza.

Omówienie możliwości wykazu modeli

Aby uzyskać informacje na temat modeli usługi Azure OpenAI, zobacz temat Azure OpenAI Service.

W przypadku modeli nadzorowanych przez usługę Azure AI i Open z centrum Rozpoznawanie twarzy hugging niektóre z nich można wdrożyć przy użyciu opcji zarządzanego środowiska obliczeniowego, a niektóre z nich są dostępne do wdrożenia przy użyciu bezserwerowych interfejsów API z rozliczeniami płatności zgodnie z rzeczywistym użyciem. Modele te można odnaleźć, porównać, ocenić, dostosować (jeśli są obsługiwane) i wdrożyć na dużą skalę i zintegrować je z aplikacjami generowania sztucznej inteligencji z zabezpieczeniami i ładem danych klasy korporacyjnej.

- Odnajdywanie: Przejrzyj karty modelu, wypróbuj przykładowe wnioskowanie i przejrzyj przykłady kodu, aby ocenić, dostosować lub wdrożyć model.

- Porównaj: Porównaj testy porównawcze między modelami i zestawami danych dostępnymi w branży, aby ocenić, który z nich spełnia Twój scenariusz biznesowy.

- Oceń: oceń, czy model jest odpowiedni dla konkretnego obciążenia, podając własne dane testowe. Metryki oceny ułatwiają wizualizowanie, jak dobrze wybrany model został wykonany w danym scenariuszu.

- Dostrajanie: Dostosuj modele z możliwością dostosowania przy użyciu własnych danych treningowych i wybierz najlepszy model, porównując metryki we wszystkich zadaniach dostrajania. Wbudowane optymalizacje przyspieszają dostrajanie i zmniejszają ilość pamięci i zasobów obliczeniowych potrzebnych do dostrajania.

- Wdrażanie: bezproblemowe wdrażanie wstępnie wytrenowanych modeli lub dostosowanych modeli w celu wnioskowania. Modele, które można wdrożyć w zarządzanych obliczeniach, można również pobrać.

Wdrażanie modelu: zarządzany interfejs API obliczeniowy i bezserwerowy (płatność zgodnie z rzeczywistym użyciem)

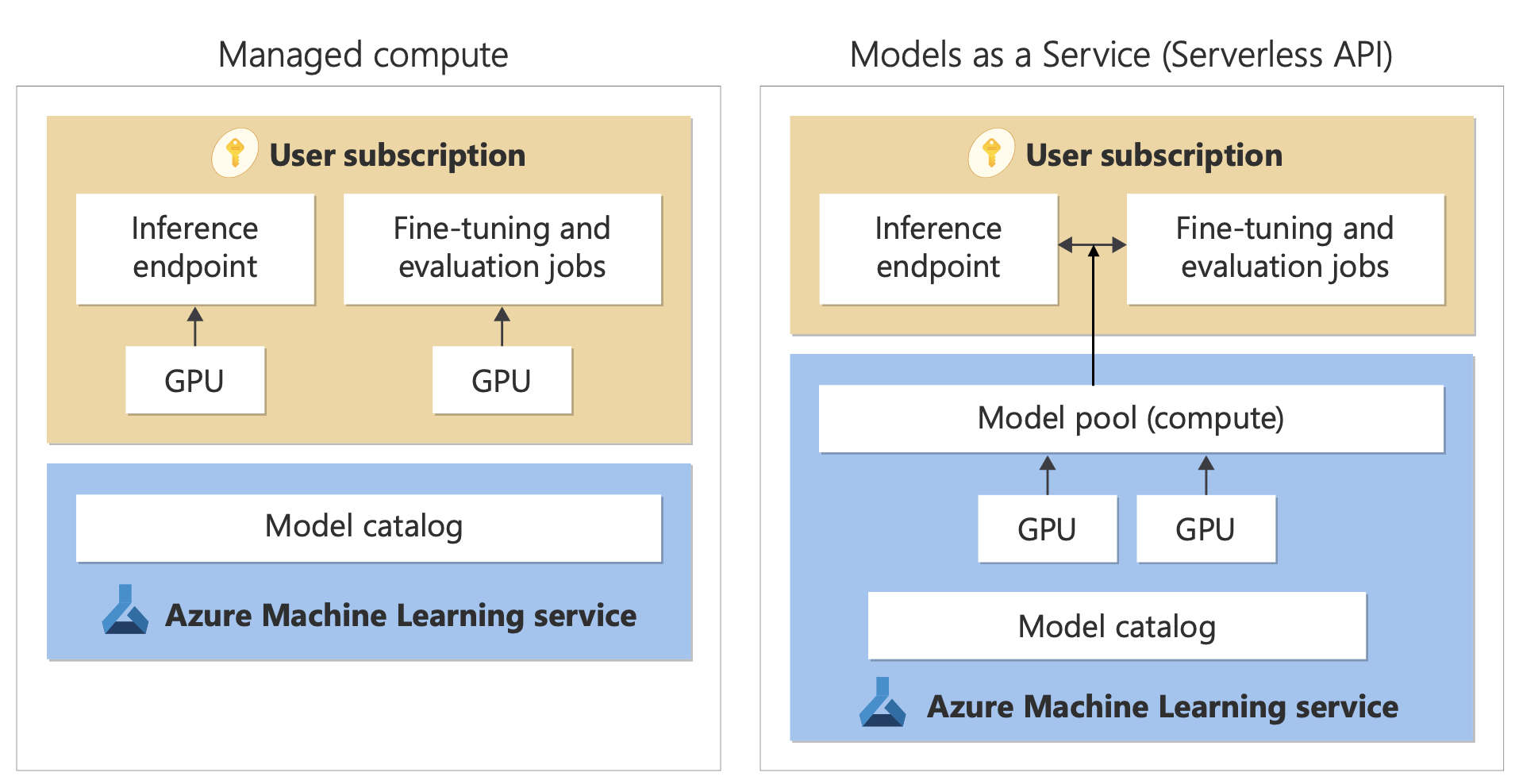

Katalog modeli oferuje dwa różne sposoby wdrażania modeli z katalogu na potrzeby użycia: zarządzane interfejsy API obliczeniowe i bezserwerowe. Opcje wdrażania dostępne dla każdego modelu różnią się; dowiedz się więcej o funkcjach i cechach opcji wdrażania i opcjach dostępnych dla określonych modeli w poniższych tabelach. Dowiedz się więcej o przetwarzaniu danych przy użyciu opcji wdrażania.

| Funkcje | Zarządzane obliczenia | Bezserwerowy interfejs API (płatność zgodnie z rzeczywistym użyciem) |

|---|---|---|

| Środowisko wdrażania i rozliczenia | Wagi modelu są wdrażane w dedykowanych maszynach wirtualnych z zarządzanymi punktami końcowymi online. Zarządzany punkt końcowy online, który może mieć co najmniej jedno wdrożenie, udostępnia interfejs API REST na potrzeby wnioskowania. Opłaty są naliczane za podstawowe godziny maszyny wirtualnej używane przez wdrożenia. | Dostęp do modeli odbywa się za pośrednictwem wdrożenia, które aprowizuje interfejs API w celu uzyskania dostępu do modelu. Interfejs API zapewnia dostęp do modelu hostowanego w centralnej puli procesorów GPU zarządzanej przez firmę Microsoft na potrzeby wnioskowania. Ten tryb dostępu jest określany jako „Modele jako usługa”. Opłaty są naliczane za dane wejściowe i wyjściowe w interfejsach API, zazwyczaj w tokenach; informacje o cenach są udostępniane przed wdrożeniem. |

| Uwierzytelnianie interfejsu API | Uwierzytelnienie kluczy i identyfikatora Microsoft Entra ID Dowiedz się więcej. | Tylko klucze. |

| Bezpieczeństwo zawartości | Użyj interfejsów API usługi Azure Content Safety Service. | Filtry bezpieczeństwa zawartości platformy Azure AI są dostępne zintegrowane z interfejsami API wnioskowania. Filtry bezpieczeństwa zawartości platformy Azure AI mogą być rozliczane oddzielnie. |

| Izolacja sieciowa | Zarządzana sieć wirtualna z punktami końcowymi online. Dowiedz się więcej. |

Opcje wdrażania

| Model | Zarządzane obliczenia | Bezserwerowy interfejs API (płatność zgodnie z rzeczywistym użyciem) |

|---|---|---|

| Modele rodziny Llama | Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Poinstruowanie Llama-3-70B-Poinstruowanie Llama-3-8B Llama-3-70B |

Llama-3-70B-Poinstruowanie Llama-3-8B-Poinstruowanie Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Modele rodziny Mistral | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Mistral-Nemo |

| Modele rodziny cohere | Niedostępny | Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-wielojęzyczny Cohere-rerank-3-english Cohere-rerank-3-wielojęzyczny |

| JAIS | Niedostępny | jais-30b-chat |

| Modele rodziny Phi3 | Phi-3-mini-4k-Poinstruowanie Phi-3-mini-128k-Poinstruowanie Phi-3-small-8k-Poinstruuj Phi-3-small-128k-Poinstruuj Phi-3-medium-4k-poinstruowanie Phi-3-medium-128k-instruct |

Phi-3-mini-4k-Poinstruowanie Phi-3-mini-128k-Poinstruowanie Phi-3-small-8k-Poinstruuj Phi-3-small-128k-Poinstruuj Phi-3-medium-4k-poinstruowanie Phi-3-medium-128k-instruct |

| Nixtla | Niedostępny | TimeGEN-1 |

| Inne modele | Dostępna | Niedostępny |

Zarządzane obliczenia

Możliwość wdrażania modeli za pomocą zarządzanych obliczeń opiera się na możliwościach platformy usługi Azure Machine Learning w celu umożliwienia bezproblemowej integracji w całym cyklu życia llMOps szerokiej kolekcji modeli w katalogu modeli.

W jaki sposób modele są udostępniane dla zarządzanych środowisk obliczeniowych?

Modele są udostępniane za pośrednictwem rejestrów usługi Azure Machine Learning, które umożliwiają pierwsze podejście uczenia maszynowego do hostowania i dystrybucji zasobów usługi Machine Learning, takich jak wagi modelu, środowiska uruchomieniowe kontenerów do uruchamiania modeli, potoków do oceny i dostrajania modeli i zestawów danych dla testów porównawczych i przykładów. Te rejestry uczenia maszynowego bazują na wysoce skalowalnej i gotowej dla przedsiębiorstw infrastrukturze, która:

Dostarcza artefakty modelu dostępu o małych opóźnieniach do wszystkich regionów świadczenia usługi Azure z wbudowaną replikacją geograficzną.

Obsługuje wymagania dotyczące zabezpieczeń przedsiębiorstwa jako ograniczenie dostępu do modeli za pomocą usługi Azure Policy i bezpieczne wdrażanie za pomocą zarządzanych sieci wirtualnych.

Ocenianie i dostosowywanie modeli wdrożonych za pomocą zarządzanych obliczeń

Możesz ocenić i dostosować kolekcję „Wyselekcjonowane przez sztuczną inteligencję platformy Azure” w usłudze Azure Machine Learning przy użyciu potoków usługi Azure Machine Learning. Możesz wybrać opcję wprowadzenia własnego kodu do oceny i dostosowania, a także uzyskać dostęp do wag modelu lub użyć składników usługi Azure Machine Learning, które oferują wbudowane funkcje oceny i dostosowania. Aby dowiedzieć się więcej, skorzystaj z tego linku.

Wdrażanie modeli na potrzeby wnioskowania za pomocą zarządzanych zasobów obliczeniowych

Modele dostępne do wdrożenia za pomocą zarządzanych zasobów obliczeniowych można wdrożyć w punktach końcowych online usługi Azure Machine Learning na potrzeby wnioskowania w czasie rzeczywistym lub mogą być używane do wnioskowania wsadowego wsadowego przetwarzania danych. Wdrożenie w zarządzanych obliczeniach wymaga, aby mieć limit przydziału maszyny wirtualnej w subskrypcji platformy Azure dla określonych jednostek SKU potrzebnych do optymalnego uruchomienia modelu. Niektóre modele umożliwiają wdrożenie tymczasowego udostępnionego limitu przydziału na potrzeby testowania modelu. Dowiedz się więcej o wdrażaniu modeli:

- Wdrażanie modeli Meta Llama

- Wdrażanie otwartych modeli utworzonych przez usługę Azure AI

- Wdrażanie przytulania modeli twarzy

Tworzenie aplikacji generatywnej sztucznej inteligencji przy użyciu zarządzanego środowiska obliczeniowego

Natychmiastowy przepływ oferuje możliwości tworzenia prototypów, eksperymentowania, iterowania i wdrażania aplikacji sztucznej inteligencji. Modele wdrożone przy użyciu zarządzanego środowiska obliczeniowego można używać w usłudze Prompt Flow za pomocą narzędzia Open Model LLM. Można również użyć interfejsu REST API udostępnianego przez zarządzane środowisko obliczeniowe w popularnych narzędziach LLM, takich jak LangChain z rozszerzeniem Azure Machine Learning.

Bezpieczeństwo zawartości dla modeli wdrożonych przy użyciu zarządzanych środowisk obliczeniowych

Usługa Azure AI Content Safety (AACS) jest dostępna do użycia z modelami wdrożonym w zarządzanych obliczeniach w celu ekranowania różnych kategorii szkodliwych treści, takich jak zawartość seksualna, przemoc, nienawiść i samookaleczenia oraz zaawansowane zagrożenia, takie jak wykrywanie ryzyka zabezpieczeń systemu i wykrywanie tekstu chronionego materiału. Możesz zapoznać się z tym notesem, aby zapoznać się z integracją referencyjną z usługą AACS for Llama 2 lub użyć narzędzia Bezpieczeństwo zawartości (tekst) w temacie Prompt Flow (Monituj przepływ ), aby przekazać odpowiedzi z modelu do usługi AACS na potrzeby kontroli zawartości. Opłaty będą naliczane oddzielnie zgodnie z cennikiem usługi AACS dla takiego użycia.

Praca z modelami, które nie są w wykazie modeli

W przypadku modeli niedostępnych w katalogu modeli usługa Azure Machine Learning udostępnia otwartą i rozszerzalną platformę do pracy z wybranymi modelami. Model można przenieść z dowolną strukturą lub środowiskiem uruchomieniowym przy użyciu otwartych i rozszerzalnych możliwości platformy usługi Azure Machine Learning, takich jak środowiska usługi Azure Machine Learning dla kontenerów , które mogą pakować struktury i środowiska uruchomieniowe oraz potoki usługi Azure Machine Learning na potrzeby kodu w celu oceny lub dostosowania modeli. Zapoznaj się z tym notesem, aby uzyskać przykładowe informacje dotyczące importowania modeli i pracy z wbudowanymi środowiskami uruchomieniowymi i potokami.

Bezserwerowe interfejsy API z rozliczeniami płatności zgodnie z rzeczywistym użyciem

Niektóre modele w wykazie modeli można wdrożyć jako bezserwerowe interfejsy API z rozliczeniami płatności zgodnie z rzeczywistym użyciem; ta metoda wdrażania nosi nazwę Models-as-a Service (MaaS). Modele dostępne za pośrednictwem usługi MaaS są hostowane w infrastrukturze zarządzanej przez firmę Microsoft, co umożliwia dostęp oparty na interfejsie API do modelu dostawcy modelu. Dostęp oparty na interfejsie API może znacznie obniżyć koszt uzyskiwania dostępu do modelu i znacznie uprościć środowisko aprowizacji. Większość modeli MaaS jest wyposażonych w ceny oparte na tokenach.

W jaki sposób modele innych firm są udostępniane w usłudze MaaS?

Modele, które są dostępne do wdrożenia jako bezserwerowe interfejsy API z rozliczeniami płatności zgodnie z rzeczywistym użyciem, są oferowane przez dostawcę modelu, ale hostowane w infrastrukturze platformy Azure zarządzanej przez firmę Microsoft i dostępne za pośrednictwem interfejsu API. Dostawcy modelu definiują postanowienia licencyjne i określają cenę użycia swoich modeli, podczas gdy usługa Azure Machine Learning Service zarządza infrastrukturą hostingu, udostępnia interfejsy API wnioskowania i działa jako procesor danych dla monitów przesłanych i danych wyjściowych zawartości przez modele wdrożone za pośrednictwem usługi MaaS. Dowiedz się więcej o przetwarzaniu danych dla usługi MaaS w artykule dotyczącym prywatności danych.

Płatność za użycie modelu w usłudze MaaS

Środowisko odnajdywania, subskrypcji i użycia modeli wdrożonych za pośrednictwem usługi MaaS znajduje się w usłudze Azure AI Studio i usłudze Azure Machine Learning Studio. Użytkownicy akceptują postanowienia licencyjne dotyczące używania modeli, a informacje o cenach użycia są udostępniane podczas wdrażania. Modele od dostawców innych firm są rozliczane za pośrednictwem witryny Azure Marketplace zgodnie z warunkami użytkowania w komercyjnej witrynie Marketplace; modele firmy Microsoft są rozliczane przy użyciu mierników platformy Azure jako usług użycia firmy First Party. Zgodnie z opisem w warunkach produktu usługi zużycie przez firmę First Party są kupowane przy użyciu mierników platformy Azure, ale nie podlegają warunkom świadczenia usług platformy Azure. Korzystanie z tych modeli podlega postanowieniom licencyjnym.

Wdrażanie modeli na potrzeby wnioskowania za pomocą usługi MaaS

Wdrażanie modelu za pomocą usługi MaaS umożliwia użytkownikom uzyskanie dostępu do gotowych do korzystania z interfejsów API wnioskowania bez konieczności konfigurowania infrastruktury lub aprowizacji procesorów GPU, oszczędzania czasu inżynieryjnego i zasobów. Te interfejsy API można zintegrować z kilkoma narzędziami LLM, a użycie jest rozliczane zgodnie z opisem w poprzedniej sekcji.

Dostrajanie modeli za pomocą usługi MaaS z płatnością zgodnie z rzeczywistym użyciem

W przypadku modeli, które są dostępne za pośrednictwem usługi MaaS i obsługują dostrajanie, użytkownicy mogą korzystać z hostowanego dostrajania przy użyciu rozliczeń z płatnością zgodnie z rzeczywistym użyciem, aby dostosować modele przy użyciu udostępnianych przez nich danych. Aby uzyskać więcej informacji, zobacz dostosowywanie modelu Llama 2 w usłudze Azure AI Studio.

RAG z modelami wdrożonym za pośrednictwem usługi MaaS

Usługa Azure AI Studio umożliwia użytkownikom korzystanie z indeksów wektorów i pobierania rozszerzonej generacji. Modele, które można wdrożyć jako bezserwerowe interfejsy API, mogą służyć do generowania osadzania i wnioskowania na podstawie danych niestandardowych w celu wygenerowania odpowiedzi specyficznych dla ich przypadku użycia. Aby uzyskać więcej informacji, zobacz Pobieranie rozszerzonej generacji i indeksów.

Regionalna dostępność ofert i modeli

Wdrożenie z płatnością zgodnie z rzeczywistym użyciem jest dostępne tylko dla użytkowników, których subskrypcja platformy Azure należy do konta rozliczeniowego w kraju, w którym dostawca modelu udostępnił ofertę (zobacz "region dostępności oferty" w tabeli w następnej sekcji). Jeśli oferta jest dostępna w odpowiednim regionie, użytkownik musi mieć obszar roboczy w regionie świadczenia usługi Azure, w którym model jest dostępny do wdrożenia lub dostrajania, zgodnie z tym, co ma zastosowanie (zobacz kolumny "Region obszaru roboczego" w poniższej tabeli).

| Model | Dostępność regionalna oferty | Region obszaru roboczego na potrzeby wdrożenia | Region obszaru roboczego na potrzeby dostrajania |

|---|---|---|---|

| Llama-3-70B-Poinstruowanie Llama-3-8B-Instruct |

Kraje zarządzane przez firmę Microsoft | Wschodnie stany USA 2, Szwecja Środkowa, Północno-środkowe stany USA, Południowo-środkowe stany USA, Zachodnie stany USA, Wschodnie stany USA, Zachodnie stany USA 3 | Niedostępny |

| Llama-2-7b Llama-2-13b Llama-2-70b |

Kraje zarządzane przez firmę Microsoft | Wschodnie stany USA 2, Wschodnie stany USA, Zachodnie stany USA 3, Zachodnie stany USA, Północno-środkowe stany USA, Południowo-środkowe stany USA | Zachodnie stany USA 3 |

| Llama-2-7b-chat Llama-2-13b-chat Llama-2-70b-chat |

Kraje zarządzane przez firmę Microsoft | Wschodnie stany USA 2, Wschodnie stany USA, Zachodnie stany USA 3, Zachodnie stany USA, Północno-środkowe stany USA, Południowo-środkowe stany USA | Niedostępny |

| Mistral Small | Kraje zarządzane przez firmę Microsoft | Wschodnie stany USA 2, Szwecja Środkowa, Północno-środkowe stany USA, Południowo-środkowe stany USA, Wschodnie stany USA, Zachodnie stany USA 3, Zachodnie stany USA | Niedostępny |

| Mistral Large (2402) Mistral Large (2407) |

Kraje zarządzane przez firmę Microsoft Brazylia Hongkong Izrael |

Wschodnie stany USA 2, Szwecja Środkowa, Północno-środkowe stany USA, Południowo-środkowe stany USA, Wschodnie stany USA, Zachodnie stany USA 3, Zachodnie stany USA | Niedostępny |

| Mistral Nemo | Kraje zarządzane przez firmę Microsoft Brazylia Hongkong Izrael |

Wschodnie stany USA 2, Szwecja Środkowa, Północno-środkowe stany USA, Południowo-środkowe stany USA, Wschodnie stany USA, Zachodnie stany USA 3, Zachodnie stany USA | Niedostępny |

| Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual |

Kraje zarządzane przez firmę Microsoft Japonia |

Wschodnie stany USA 2, Szwecja Środkowa, Północno-środkowe stany USA, Południowo-środkowe stany USA, Wschodnie stany USA, Zachodnie stany USA 3, Zachodnie stany USA | Niedostępny |

| Cohere-rerank-3-english Cohere-rerank-3-wielojęzyczny |

Kraje zarządzane przez firmę Microsoft | Wschodnie stany USA 2, Szwecja Środkowa, Północno-środkowe stany USA, Południowo-środkowe stany USA, Wschodnie stany USA, Zachodnie stany USA 3, Zachodnie stany USA | Niedostępny |

| TimeGEN-1 | Kraje zarządzane przez firmę Microsoft Meksyk Izrael |

Wschodnie stany USA, Wschodnie stany USA 2, Północno-środkowe stany USA, Południowo-środkowe stany USA, Szwecja Środkowa, Zachodnie stany USA, Zachodnie stany USA 3 | Niedostępny |

| jais-30b-chat | Kraje zarządzane przez firmę Microsoft | Wschodnie stany USA 2, Szwecja Środkowa, Północno-środkowe stany USA, Południowo-środkowe stany USA, Wschodnie stany USA, Zachodnie stany USA 3, Zachodnie stany USA | Niedostępny |

| Phi-3-mini-4k-poinstruowanie Phi-3-mini-128k-poinstruowanie |

Kraje zarządzane przez firmę Microsoft | Wschodnie stany USA 2, Szwecja Środkowa | Niedostępny |

| Phi-3-small-8k-poinstruowanie Phi-3-small-128k-Poinstruuj |

Kraje zarządzane przez firmę Microsoft | Wschodnie stany USA 2, Szwecja Środkowa | Niedostępny |

| Phi-3-medium-4k-poinstruowanie, Phi-3-medium-128k-poinstruowanie | Kraje zarządzane przez firmę Microsoft | Wschodnie stany USA 2, Szwecja Środkowa | Niedostępny |

Bezpieczeństwo zawartości dla modeli wdrażanych za pośrednictwem usługi MaaS

Ważne

Ta funkcja jest obecnie w publicznej wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone.

Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

W przypadku modeli językowych wdrożonych za pośrednictwem bezserwerowych interfejsów API usługa Azure AI implementuje domyślną konfigurację filtrów moderowania tekstu bezpieczeństwa zawartości usługi Azure AI, które wykrywają szkodliwe treści, takie jak nienawiść, samookaleczenia, treści seksualne i brutalne. Aby dowiedzieć się więcej na temat filtrowania zawartości (wersja zapoznawcza), zobacz kategorie zagrożeń w Bezpieczeństwo zawartości platformy Azure AI.

Napiwek

Filtrowanie zawartości (wersja zapoznawcza) nie jest dostępne dla niektórych typów modeli wdrożonych za pośrednictwem bezserwerowych interfejsów API. Te typy modeli obejmują modele osadzania i modele szeregów czasowych.

Filtrowanie zawartości (wersja zapoznawcza) odbywa się synchronicznie, ponieważ procesy usługi monituje o wygenerowanie zawartości i mogą być rozliczane oddzielnie zgodnie z cennikiem usługi AACS dla takiego użycia. Filtrowanie zawartości (wersja zapoznawcza) dla poszczególnych punktów końcowych bezserwerowych można wyłączyć w momencie pierwszego wdrożenia modelu językowego lub nowszego na stronie szczegółów wdrożenia, wybierając przełącznik filtrowania zawartości.

Załóżmy, że postanawiasz użyć interfejsu API innego niż interfejs API wnioskowania modelu AI platformy Azure do pracy z modelem wdrożonym za pośrednictwem bezserwerowego interfejsu API. W takiej sytuacji filtrowanie zawartości (wersja zapoznawcza) nie jest włączone, chyba że zaimplementowano je oddzielnie przy użyciu bezpieczeństwa zawartości usługi Azure AI. Aby dowiedzieć się więcej na temat rozpoczynania pracy z bezpieczeństwem zawartości usługi Azure AI, zobacz Szybki start: analizowanie zawartości tekstu. Jeśli nie używasz filtrowania zawartości (wersja zapoznawcza) podczas pracy z modelami wdrożonym za pośrednictwem bezserwerowych interfejsów API, wystąpi większe ryzyko ujawnienia użytkownikom szkodliwej zawartości.

Izolacja sieciowa dla modeli wdrożonych za pośrednictwem bezserwerowych interfejsów API

Punkty końcowe dla modeli wdrożonych jako bezserwerowe interfejsy API są zgodne z ustawieniem flagi dostępu do sieci publicznej (PNA) obszaru roboczego, w którym istnieje wdrożenie. Aby zabezpieczyć punkt końcowy usługi MaaS, wyłącz flagę PNA w obszarze roboczym. Komunikację przychodzącą z klienta do punktu końcowego można zabezpieczyć przy użyciu prywatnego punktu końcowego dla obszaru roboczego.

Aby ustawić flagę PNA dla obszaru roboczego:

- Przejdź do portalu Azure Portal.

- Wyszukaj usługę Azure Machine Learning i wybierz swój obszar roboczy z listy obszarów roboczych.

- Na stronie Przegląd użyj okienka nawigacji po lewej stronie, aby przejść do pozycji Ustawienia>Sieć.

- Na karcie Dostęp publiczny można skonfigurować ustawienia flagi dostępu do sieci publicznej.

- Zapisz zmiany. Propagacja zmian może potrwać do pięciu minut.

Ograniczenia

- Jeśli masz obszar roboczy z prywatnym punktem końcowym utworzonym przed 11 lipca 2024 r., nowe punkty końcowe usługi MaaS dodane do tego obszaru roboczego nie będą zgodne z konfiguracją sieci. Zamiast tego należy utworzyć nowy prywatny punkt końcowy dla obszaru roboczego i utworzyć nowe wdrożenia bezserwerowego interfejsu API w obszarze roboczym, aby nowe wdrożenia mogły być zgodne z konfiguracją sieciową obszaru roboczego.

- Jeśli masz obszar roboczy z wdrożeniami usługi MaaS utworzonymi przed 11 lipca 2024 r. i włączysz prywatny punkt końcowy w tym obszarze roboczym, istniejące wdrożenia usługi MaaS nie będą zgodne z konfiguracją sieci obszaru roboczego. Aby wdrożenia bezserwerowego interfejsu API w obszarze roboczym postępowały zgodnie z konfiguracją obszaru roboczego, należy ponownie utworzyć wdrożenia.

- Obecnie obsługa danych nie jest dostępna dla wdrożeń usługi MaaS w prywatnych obszarach roboczych, ponieważ prywatne obszary robocze mają wyłączoną flagę PNA.

- Propagowanie dowolnej zmiany konfiguracji sieci (na przykład włączenie lub wyłączenie flagi PNA) może potrwać do pięciu minut.

Dowiedz się więcej

- Dowiedz się , jak używać podstawowych modeli w usłudze Azure Machine Learning do dostrajania, oceny i wdrażania przy użyciu interfejsu użytkownika usługi Azure Machine Learning Studio lub metod opartych na kodzie.

- Zapoznaj się z wykazem modeli w usłudze Azure Machine Learning Studio. Potrzebujesz obszaru roboczego usługi Azure Machine Learning, aby eksplorować katalog.

- Ocenianie, dostosowywanie i wdrażanie modeli wyselekcjonowanych przez usługę Azure Machine Learning.

Opinia

Dostępne już wkrótce: W 2024 r. będziemy stopniowo wycofywać zgłoszenia z serwisu GitHub jako mechanizm przesyłania opinii na temat zawartości i zastępować go nowym systemem opinii. Aby uzyskać więcej informacji, sprawdź: https://aka.ms/ContentUserFeedback.

Prześlij i wyświetl opinię dla