Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Ważne

Obsługa programu Machine Learning Studio (wersja klasyczna) zakończy się 31 sierpnia 2024 r. Zalecamy przejście do usługi Azure Machine Learning przed tym terminem.

Od 1 grudnia 2021 r. nie będzie można tworzyć nowych zasobów programu Machine Learning Studio (wersja klasyczna). Do 31 sierpnia 2024 r. można będzie nadal korzystać z istniejących zasobów programu Machine Learning Studio (wersja klasyczna).

- Zobacz informacje dotyczące przenoszenia projektów uczenia maszynowego z programu ML Studio (klasycznego) do Azure Machine Learning.

- Dowiedz się więcej o Azure Machine Learning.

Dokumentacja programu ML Studio (wersja klasyczna) jest wycofywana i może nie być aktualizowana w przyszłości.

Ocenia wyniki modelu klasyfikacji lub regresji przy użyciu standardowych metryk

Kategoria: Machine Learning / Ocena

Uwaga

Dotyczy: tylko Machine Learning Studio (wersja klasyczna)

Podobne moduły przeciągania i upuszczania są dostępne w projektancie Azure Machine Learning.

Omówienie modułu

W tym artykule opisano, jak używać modułu Evaluate Model (Ocena modelu) w programie Machine Learning Studio (klasycznym) do mierzenia dokładności wytrenowanego modelu. Udostępniasz zestaw danych zawierający wyniki wygenerowane na podstawie modelu, a moduł Evaluate Model oblicza zestaw standardowych metryk oceny w branży.

Metryki zwracane przez usługę Evaluate Model zależą od typu modelu, który oceniasz:

W przypadku modeli rekomendacji użyj modułu Evaluate Recommender (Ocena modułu rekomendacji ).

Porada

Jeśli dopiero zaczynasz oceniać model, zalecamy użycie tych przykładów w galerii sztucznej inteligencji platformy Azure, która tworzy model, a następnie wyjaśnia, jak korzystać z powiązanych metryk:

- Porównanie modeli regresji

- Porównanie klasyfikatorów binarnych

- Porównanie klasyfikatorów wieloklasowych

Zalecamy również serię wideo dr Stephen Elston, w ramach kursu uczenia maszynowego z EdX.

Jak używać funkcji Evaluate Model

Istnieją trzy sposoby korzystania z modułu Evaluate Model (Ocena modelu ):

- Generowanie wyników na podstawie danych treningowych i ocenianie modelu na podstawie tych wyników

- Generowanie wyników w modelu, ale porównywanie tych wyników z wynikami w zestawie testów zarezerwowanych

- Porównanie wyników dla dwóch różnych, ale powiązanych modeli przy użyciu tego samego zestawu danych

Korzystanie z danych treningowych

Aby ocenić model, należy połączyć zestaw danych zawierający zestaw kolumn wejściowych i wyników. Jeśli żadne inne dane nie są dostępne, możesz użyć oryginalnego zestawu danych.

- Połączenie dane wyjściowe Scored datset elementu Score Model (Generowanie wyników dla modelu) do danych wejściowych elementu Evaluate Model (Ocena modelu).

- Kliknij pozycję Oceń moduł Model i wybierz pozycję Uruchom, aby wygenerować wyniki oceny.

Korzystanie z danych testowych

Typowym scenariuszem w uczeniu maszynowym jest oddzielenie oryginalnego zestawu danych do zestawów danych szkoleniowych i testowych przy użyciu modułu Split (Podział) lub modułu Partition and Sample (Partycja i przykład).

- Połączenie dane wyjściowe Scored dataset (Generowanie wyników dla modelu) do danych wejściowych elementu Evaluate Model (Ocena modelu).

- Połączenie dane wyjściowe modułu Split Data (Podział danych), który zawiera dane testowe po prawej stronie danych wejściowych funkcji Evaluate Model (Ocena modelu).

- Kliknij pozycję Oceń moduł Model i wybierz pozycję Uruchom, aby wygenerować wyniki oceny.

Porównanie wyników z dwóch modeli

Możesz również połączyć drugi zestaw wyników z wartością Evaluate Model( Ocena modelu). Wyniki mogą być udostępnionym zestawem oceny, który ma znane wyniki lub zestaw wyników z innego modelu dla tych samych danych.

Ta funkcja jest przydatna, ponieważ można łatwo porównać wyniki z dwóch różnych modeli na tych samych danych. Możesz też porównać wyniki z dwóch różnych przebiegów na tych samych danych z różnymi parametrami.

- Połączenie dane wyjściowe Scored datset elementu Score Model (Generowanie wyników dla modelu) do danych wejściowych elementu Evaluate Model (Ocena modelu).

- Połączenie dane wyjściowe modułu Score Model (Generowanie wyników dla modelu) dla drugiego modelu po prawej stronie danych wejściowych elementu Evaluate Model (Ocena modelu).

- Kliknij prawym przyciskiem myszy pozycję Oceń model, a następnie wybierz pozycję Uruchom, aby wygenerować wyniki oceny.

Wyniki

Po uruchomieniu polecenia Evaluate Model (Ocena modelu) kliknij prawym przyciskiem myszy moduł i wybierz pozycję Wyniki oceny , aby wyświetlić wyniki. Oto co możesz zrobić:

- Zapisywanie wyników jako zestawu danych w celu łatwiejszej analizy za pomocą innych narzędzi

- Generowanie wizualizacji w interfejsie studio (klasycznym)

Jeśli połączysz zestawy danych z obydwoma danymi wejściowymi elementu Evaluate Model, wyniki będą zawierać metryki dla obu zestawów danych lub obu modeli. Model lub dane dołączone do lewego portu są prezentowane najpierw w raporcie, a następnie metryki dla zestawu danych lub modelu dołączonego do odpowiedniego portu.

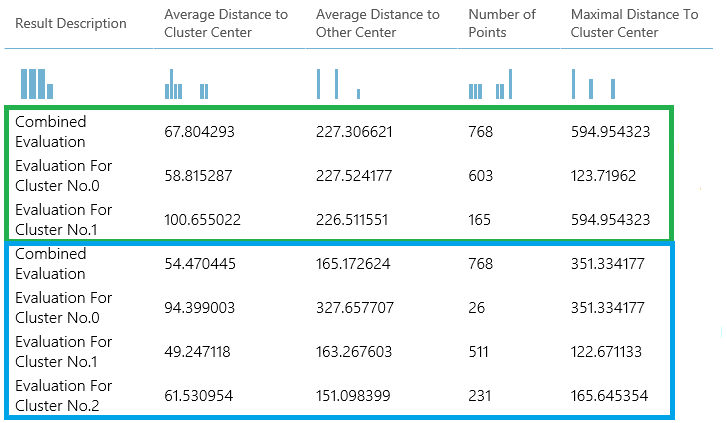

Na przykład na poniższej ilustracji przedstawiono porównanie wyników z dwóch modeli klastrowania, które zostały utworzone na tych samych danych, ale z różnymi parametrami.

Ponieważ jest to model klastrowania, wyniki oceny są inne niż w przypadku porównywania wyników z dwóch modeli regresji lub porównania dwóch modeli klasyfikacji. Jednak ogólna prezentacja jest taka sama.

Metryki

W tej sekcji opisano metryki zwracane dla określonych typów modeli obsługiwanych do użycia z usługą Evaluate Model:

Metryki dla modeli klasyfikacji

Podczas oceniania modeli klasyfikacji są zgłaszane następujące metryki. W przypadku porównywania modeli są one klasyfikowane według metryki wybranej do oceny.

Dokładność mierzy dobro modelu klasyfikacji jako proporcję rzeczywistych wyników do łącznej liczby przypadków.

Precyzja to proporcja rzeczywistych wyników dla wszystkich dodatnich wyników.

Kompletność to ułamek wszystkich prawidłowych wyników zwracanych przez model.

Wynik F jest obliczany jako średnia ważona dokładności i kompletność z zakresu od 0 do 1, gdzie idealna wartość wyniku F wynosi 1.

Funkcja AUC mierzy obszar pod krzywą wykreślowaną z prawdziwie dodatnimi na osi y i fałszywie dodatnimi na osi x. Ta metryka jest przydatna, ponieważ zapewnia pojedynczą liczbę, która umożliwia porównywanie modeli różnych typów.

Średnia utrata dziennika to pojedynczy wynik używany do wyrażenia kary za nieprawidłowe wyniki. Jest obliczana jako różnica między dwoma rozkładami prawdopodobieństwa — prawdziwym i jednym w modelu.

Utrata dziennika trenowania to pojedynczy wynik, który reprezentuje przewagę klasyfikatora w przypadku przewidywania losowego. Utrata dziennika mierzy niepewność modelu przez porównanie prawdopodobieństwa, które generuje do znanych wartości (prawdy podstawowej) w etykietach. Chcesz zminimalizować utratę dziennika dla modelu jako całości.

Metryki dla modeli regresji

Metryki zwracane dla modeli regresji są zwykle zaprojektowane w celu oszacowania ilości błędu. Model jest uważany za dopasowany do źródła danych, jeśli różnica między obserwowanych i przewidywanych wartości jest mała. Jednak patrząc na wzorzec reszt (różnica między dowolnym przewidywanym punktem a odpowiadającą jej rzeczywistą wartością) może powiedzieć wiele o potencjalnych stronniczości w modelu.

Następujące metryki są zgłaszane do oceny modeli regresji. Podczas porównywania modeli są one klasyfikowane według metryki wybranej do oceny.

Ujemne prawdopodobieństwo dziennika mierzy funkcję utraty, niższy wynik jest lepszy. Należy pamiętać, że ta metryka jest obliczana tylko dla regresji liniowej bayesowskiej i regresji lasu decyzyjnego; w przypadku innych algorytmów wartość jest

Infinityoznaczana dla niczego.Średni błąd bezwzględny (MAE) mierzy, jak blisko przewidywania są rzeczywiste wyniki; w związku z tym niższy wynik jest lepszy.

Błąd średniokwadratowy (RMSE) tworzy pojedynczą wartość, która podsumowuje błąd w modelu. Dzięki squaring różnicy metryka pomija różnicę między nadmiernym przewidywaniem a niedo przewidywaniami.

Względny błąd bezwzględny (RAE) to względna różnica bezwzględna między oczekiwaną i rzeczywistą wartością; względne, ponieważ średnia różnica jest podzielona przez średnią arytmetyczną.

Błąd względny kwadratu (RSE) podobnie normalizuje całkowity błąd kwadratowy przewidywanych wartości przez podzielenie przez całkowity błąd kwadratowy rzeczywistych wartości.

Średni błąd Zero One (MZOE) wskazuje, czy przewidywanie było poprawne, czy nie. Innymi słowy:

ZeroOneLoss(x,y) = 1kiedyx!=y; w przeciwnym razie0.Współczynnik determinacji, często określany jako R2, reprezentuje moc predykcyjną modelu jako wartość z zakresu od 0 do 1. Zero oznacza, że model jest losowy (nic nie wyjaśnia); 1 oznacza, że istnieje idealne dopasowanie. Należy jednak zachować ostrożność podczas interpretowania wartości R2 , ponieważ niskie wartości mogą być całkowicie normalne, a wysokie wartości mogą być podejrzane.

Metryki dla modeli klastrowania

Ponieważ modele klastrowania różnią się znacznie od modeli klasyfikacji i regresji w wielu aspektach, funkcja Evaluate Model zwraca również inny zestaw statystyk dla modeli klastrowania.

Statystyki zwrócone dla modelu klastrowania opisują liczbę punktów danych przypisanych do każdego klastra, ilość separacji między klastrami oraz sposób ścisłego łączenia punktów danych w każdym klastrze.

Statystyki modelu klastrowania są średnie dla całego zestawu danych z dodatkowymi wierszami zawierającymi statystyki na klaster.

Na przykład poniższe wyniki pokazują część wyników z przykładowego eksperymentu, który klastruje dane w zestawie danych PIMA Indian Diabetes Binary Classification, który jest dostępny w programie Machine Learning Studio (wersja klasyczna).

| Opis wyniku | Średnia odległość do centrum klastra | Średnia odległość do innego środka | Liczba punktów | Maksymalna odległość do centrum klastra |

|---|---|---|---|---|

| Łączna ocena | 55.915068 | 169.897505 | 538 | 303.545166 |

| Ocena dla klastra nr 0 | 0 | 1 | 570 | 0 |

| Ocena dla klastra nr 1 | 0 | 1 | 178 | 0 |

| Ocena dla klastra nr 2 | 0 | 1 | 178 | 0 |

Z tych wyników uzyskasz następujące informacje:

Moduł Sweep Clustering tworzy wiele modeli klastrowania wymienionych w kolejności dokładności. Dla uproszczenia pokazaliśmy tutaj tylko najlepiej sklasyfikowany model. Modele są mierzone przy użyciu wszystkich możliwych metryk, ale modele są klasyfikowane przy użyciu określonej metryki. Jeśli zmienisz metrykę, inny model może być wyżej sklasyfikowany.

Wynik połączonej oceny w górnej części każdej sekcji wyników zawiera średnie wyniki dla klastrów utworzonych w tym konkretnym modelu.

Ten najlepiej sklasyfikowany model miał miejsce w celu utworzenia trzech klastrów; inne modele mogą tworzyć dwa klastry lub cztery klastry. W związku z tym ten połączony wynik oceny pomaga porównać modele z różnymi liczbą klastrów.

Wyniki w kolumnie Average Distance to Cluster Center (Średnia odległość do centrum klastra) reprezentują bliskość wszystkich punktów w klastrze do centroid tego klastra.

Wyniki w kolumnie Average Distance to Other Center (Średnia odległość do innego centrum) reprezentują, jak blisko, średnio każdy punkt w klastrze to centroidy wszystkich innych klastrów.

Możesz wybrać dowolną z czterech metryk, aby zmierzyć tę odległość, ale wszystkie pomiary muszą używać tej samej metryki.

Kolumna Liczba punktów pokazuje liczbę punktów danych przypisanych do każdego klastra wraz z całkowitą ogólną liczbą punktów danych w dowolnym klastrze.

Jeśli liczba punktów danych przypisanych do klastrów jest mniejsza niż całkowita liczba dostępnych punktów danych, oznacza to, że nie można przypisać punktów danych do klastra.

Wyniki w kolumnie Maximal Distance to Cluster Center reprezentują sumę odległości między każdym punktem a centroid klastra tego punktu.

Jeśli ta liczba jest wysoka, może to oznaczać, że klaster jest szeroko rozproszony. Należy przejrzeć tę statystykę wraz ze średnią odległością do centrum klastra , aby określić rozkład klastra.

Przykłady

Aby zapoznać się z przykładami generowania, wizualizowania i interpretowania metryk oceny, zobacz te przykładowe eksperymenty w galerii sztucznej inteligencji platformy Azure. Te eksperymenty pokazują, jak utworzyć wiele modeli i użyć funkcji Evaluate Model w celu określenia, który model jest najlepszy.

Porównanie klasyfikatorów binarnych: wyjaśnia, jak porównać wydajność różnych klasyfikatorów utworzonych przy użyciu tych samych danych.

Porównaj klasyfikatory wieloklasowe: pokazuje, jak porównać dokładność różnych modeli klasyfikacji utworzonych na zestawie danych rozpoznawania liter.

Porównanie regresji: przeprowadzi Cię przez proces oceniania różnych modeli regresji.

Szacowanie zapotrzebowania: dowiedz się, jak połączyć metryki oceny z wielu modeli.

Przewidywanie relacji klientów: pokazuje, jak ocenić wiele powiązanych modeli.

Oczekiwane dane wejściowe

| Nazwa | Typ | Opis |

|---|---|---|

| Zestaw danych z wynikami | Tabela danych | Zestaw danych z wynikami |

| Wynikowy zestaw danych do porównania | Tabela danych | Wynikowy zestaw danych do porównania (opcjonalnie) |

Dane wyjściowe

| Nazwa | Typ | Opis |

|---|---|---|

| Wyniki oceny | Tabela danych | Wynik oceny danych |

Wyjątki

| Wyjątek | Opis |

|---|---|

| Błąd 0003 | Wyjątek występuje, jeśli co najmniej jeden z danych wejściowych ma wartość null lub jest pusty. |

| Błąd 0013 | Wyjątek występuje, jeśli przekazano do ucznia modułu nieprawidłowy typ. |

| Błąd 0020 | Wyjątek występuje, jeśli liczba kolumn w niektórych zestawach danych przekazanych do modułu jest za mała. |

| Błąd 0021 | Wyjątek występuje, jeśli liczba wierszy w niektórych zestawach danych przekazanych do modułu jest za mała. |

| Błąd 0024 | Wyjątek występuje, jeśli zestaw danych nie zawiera kolumny etykiety. |

| Błąd 0025 | Wyjątek występuje, jeśli zestaw danych nie zawiera kolumny oceny. |

Zobacz też

Model weryfikacji krzyżowej

Ocena modułu poleceń

Evaluate

Klasyfikacja modelu