Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Ważne

Obsługa programu Machine Learning Studio (wersja klasyczna) zakończy się 31 sierpnia 2024 r. Zalecamy przejście do usługi Azure Machine Learning przed tym terminem.

Od 1 grudnia 2021 r. nie będzie można tworzyć nowych zasobów programu Machine Learning Studio (wersja klasyczna). Do 31 sierpnia 2024 r. można będzie nadal korzystać z istniejących zasobów programu Machine Learning Studio (wersja klasyczna).

- Zobacz informacje dotyczące przenoszenia projektów uczenia maszynowego z programu ML Studio (klasycznego) do Azure Machine Learning.

- Dowiedz się więcej o Azure Machine Learning.

Dokumentacja programu ML Studio (wersja klasyczna) jest wycofywana i może nie być aktualizowana w przyszłości.

Ładuje dane ze źródeł zewnętrznych w Internecie; od różnych form magazynu opartego na chmurze na platformie Azure, takich jak tabele, obiekty blob i bazy danych SQL oraz lokalne bazy danych SQL Server

Kategoria: Dane wejściowe i wyjściowe

Uwaga

Dotyczy: tylko Machine Learning Studio (wersja klasyczna)

Podobne moduły przeciągania i upuszczania są dostępne w projektancie Azure Machine Learning.

Omówienie modułu

W tym artykule opisano sposób użycia modułu Importuj dane w programie Machine Learning Studio (wersja klasyczna), aby załadować dane do eksperymentu uczenia maszynowego z istniejących usług danych w chmurze.

Moduł zawiera teraz kreatora ułatwiającego wybranie opcji magazynu i wybranie spośród istniejących subskrypcji i kont w celu szybkiego skonfigurowania wszystkich opcji. Musisz edytować istniejące połączenie danych? Brak problemu; Kreator ładuje wszystkie poprzednie szczegóły konfiguracji, aby nie trzeba było uruchamiać ponownie od podstaw.

Po zdefiniowaniu żądanych danych i nawiązaniu połączenia ze źródłem importowanie danych wywnioskuje typ danych każdej kolumny na podstawie zawartych wartości i ładuje dane do obszaru roboczego usługi Machine Learning Studio (wersja klasyczna). Dane wyjściowe importu danych to zestaw danych, który może być używany z dowolnym eksperymentem.

Ważne

Obecnie istnieją ograniczenia dotyczące typów obsługiwanych kont magazynu. Aby uzyskać więcej informacji, zobacz Uwagi techniczne.

Jeśli dane źródłowe zostaną zmienione, możesz odświeżyć zestaw danych i dodać nowe dane, ponownie uruchamiając polecenie Importuj dane. Jeśli jednak nie chcesz ponownie odczytywać ze źródła przy każdym uruchomieniu eksperymentu, wybierz opcję Użyj buforowanych wyników na wartość TRUE. Po wybraniu tej opcji moduł sprawdza, czy eksperyment został uruchomiony wcześniej przy użyciu tych samych opcji źródła i tych samych opcji wejściowych. Jeśli zostanie znaleziony poprzedni przebieg, dane w pamięci podręcznej są używane zamiast ponownie ładować dane ze źródła.

Uwaga

Ten moduł został wcześniej nazwany Czytelnik. Jeśli wcześniej użyto modułu Czytelnik w eksperymencie, zostanie zmieniona na Import Data (Importowanie danych ) podczas odświeżania eksperymentu.

Źródła danych

Moduł Import Data (Importowanie danych) obsługuje następujące źródła danych. Kliknij linki, aby uzyskać szczegółowe instrukcje i przykłady użycia każdego źródła danych.

Jeśli nie masz pewności, jak lub gdzie należy przechowywać dane, zapoznaj się z tym przewodnikiem dotyczącym typowych scenariuszy danych w procesie nauki o danych: scenariusze zaawansowanej analizy w Machine Learning.

| Źródło danych | Używanie z usługą |

|---|---|

| Adres URL sieci Web za pośrednictwem protokołu HTTP | Pobieranie danych hostowanych w internetowym adresie URL używającym protokołu HTTP i podanych w formatach CSV, TSV, ARFF lub SvmLight |

| Zapytanie hive | Pobieranie danych z magazynu rozproszonego w usłudze Hadoop. Należy określić żądane dane przy użyciu języka HiveQL |

| Azure SQL Database | Pobieranie danych z Azure SQL Database lub z Azure SQL Data Warehouse |

| Tabela platformy Azure | Pobieranie danych przechowywanych w usłudze tabel platformy Azure |

| Importowanie z Azure Blob Storage | Pobieranie danych przechowywanych w usłudze Azure Blob Service |

| Dostawcy źródeł danych | Pobieranie danych udostępnianych jako źródło danych w formacie OData |

| Importowanie z lokalnej bazy danych SQL Server | Pobieranie danych z lokalnej bazy danych SQL Server przy użyciu bramy Microsoft Zarządzanie danymi Gateway |

| Azure Cosmos DB | Pobieranie danych przechowywanych w formacie JSON w usłudze Azure Cosmos DB. |

Porada

Chcesz zaimportować dane w formacie JSON? Zarówno język R, jak i Python obsługują interfejsy API REST, dlatego użyj modułów Execute Python Script (Wykonywanie skryptu języka Python) lub Execute R Script (Wykonywanie skryptu języka R) w celu analizowania danych i zapisywania ich jako zestawu danych usługi Azure ML.

Możesz też użyć interfejsu API usługi SQL DB dla usługi CosmosDB, który obsługuje wiele magazynów JSON, w tym MongoDB, do odczytywania danych przy użyciu opcji Importuj z usługi Azure Cosmos DB. Aby uzyskać więcej informacji, zobacz Importowanie z usługi Azure Cosmos DB.

Jak używać importowanych danych

Dodaj moduł Import Data (Importowanie danych ) do eksperymentu. Ten moduł można znaleźć w kategorii Dane wejściowe i wyjściowe w programie Studio (wersja klasyczna).

Kliknij pozycję Uruchom Kreatora importu danych , aby skonfigurować źródło danych przy użyciu kreatora.

Kreator pobiera nazwę konta i poświadczenia oraz pomaga skonfigurować inne opcje. Jeśli edytujesz istniejącą konfigurację, najpierw ładuje bieżące wartości.

Jeśli nie chcesz używać kreatora, kliknij pozycję Źródło danych i wybierz typ odczytywanego magazynu w chmurze.

Dodatkowe ustawienia zależą od wybranego typu magazynu i tego, czy magazyn jest zabezpieczony, czy nie. Może być konieczne podanie nazwy konta, typu pliku lub poświadczeń. Niektóre źródła nie wymagają uwierzytelniania; dla innych użytkowników może być konieczne poznanie nazwy konta, klucza lub nazwy kontenera.

Aby uzyskać szczegółowe informacje, zobacz listę źródeł danych.

Wybierz opcję Użyj buforowanych wyników , jeśli chcesz buforować zestaw danych do ponownego użycia w kolejnych uruchomieniach.

Zakładając, że nie wprowadzono żadnych innych zmian w parametrach modułu, eksperyment ładuje dane tylko przy pierwszym uruchomieniu modułu, a następnie używa buforowanej wersji zestawu danych.

Usuń zaznaczenie tej opcji, jeśli musisz ponownie załadować dane przy każdym uruchomieniu eksperymentu.

Uruchom eksperyment.

Gdy importowanie danych ładuje dane do programu Studio (klasycznego), wywnioskuje typ danych każdej kolumny na podstawie wartości, które zawiera, liczbowych lub kategorycznych.

Jeśli nagłówek jest obecny, nagłówek jest używany do nazywania kolumn wyjściowego zestawu danych.

Jeśli w danych nie ma istniejących nagłówków kolumn, nowe nazwy kolumn są generowane przy użyciu formatu col1, col2,... ,coln.

Wyniki

Po zakończeniu importowania kliknij wyjściowy zestaw danych i wybierz pozycję Visualize (Wizualizacja), aby sprawdzić, czy dane zostały pomyślnie zaimportowane.

Jeśli chcesz zapisać dane do ponownego użycia, zamiast importować nowy zestaw danych za każdym razem, gdy eksperyment zostanie uruchomiony, kliknij prawym przyciskiem myszy dane wyjściowe i wybierz polecenie Zapisz jako zestaw danych. Wybierz nazwę zestawu danych. Zapisany zestaw danych zachowuje dane w czasie zapisywania, a dane nie są aktualizowane po ponownym uruchomieniu eksperymentu, nawet jeśli zestaw danych w eksperymencie ulegnie zmianie. Może to być przydatne do tworzenia migawek danych.

Po zaimportowaniu danych może być konieczne kilka dodatkowych przygotowań do modelowania i analizy:

Generowanie podsumowań statystycznych danych przy użyciu funkcji Sumuj dane lub Obliczanie statystyk podstawowych.

Użyj funkcji Edytuj metadane , aby zmienić nazwy kolumn, obsługiwać kolumnę jako inny typ danych lub wskazać, że niektóre kolumny są etykietami lub funkcjami.

Użyj opcji Wybierz kolumny w zestawie danych , aby wybrać podzbiór kolumn do przekształcenia lub użycia w modelowaniu. Przekształcone lub usunięte kolumny można łatwo ponownie dołączyć do oryginalnego zestawu danych przy użyciu modułu Dodawanie kolumn lub modułu Dołączanie danych .

Użyj partycji i przykładu , aby podzielić zestaw danych, przeprowadzić próbkowanie lub pobrać pierwsze n wierszy.

Użyj polecenia Zastosuj SQL Transformation, aby agregować dane, filtrować lub przekształcać przy użyciu instrukcji SQL.

Użyj tych modułów, aby wyczyścić kolumny tekstowe i wygenerować nowe funkcje tekstowe:

- Wstępne przetwarzanie tekstu

- Wyodrębnianie cech n-gramów z tekstu

- Rozpoznawanie jednostek nazwanych

- Wykonaj skrypt języka Python, aby zaimplementować niestandardową usługę NLP opartą na nltk.

Uwagi techniczne

Ta sekcja zawiera listę znanych problemów z modułem Importowanie danych , a także niektóre ogólne informacje dotyczące rozwiązywania problemów, które nie są specyficzne dla typu źródłowego.

Obsługiwane typy kont

Często platforma Azure publikuje nowe usługi lub nowe typy magazynów; jednak w programie Machine Learning Studio (wersja klasyczna) jest implementowane opóźnienie, natomiast obsługa nowych typów kont jest implementowana.

Obecnie Machine Learning obsługuje wszystkie konta magazynu ogólnego przeznaczenia, z wyjątkiem tych korzystających z magazynu strefowo nadmiarowego (ZRS).

Obsługiwane są opcje magazynu lokalnie nadmiarowego (LRS) i magazynu geograficznie nadmiarowego.

Blokowe obiekty blob są obsługiwane, ale uzupełnialne obiekty blob nie są obsługiwane.

Typowe pytania i problemy

W tej sekcji opisano niektóre znane problemy, typowe pytania i obejścia.

Nagłówki muszą być pojedynczymi wierszami

W przypadku importowania z plików CSV należy pamiętać, że Machine Learning zezwala na pojedynczy wiersz nagłówka. Nie można wstawić nagłówków wielowierszowych.

Separatory niestandardowe obsługiwane podczas importowania, ale nie eksportu

Moduł Import Data (Importowanie danych ) obsługuje importowanie danych, które używają alternatywnych separatorów kolumn, takich jak średnik (;), który jest często używany w Europie. Podczas importowania danych z plików CSV w magazynie zewnętrznym wybierz opcję CSV z kodowaniem i wybierz obsługiwane kodowanie.

Nie można jednak wygenerować alternatywnych separatorów podczas przygotowywania danych do eksportu przy użyciu modułu Konwertuj na wolumin CSV .

Słabe rozdzielenie kolumn na danych ciągu zawierających przecinki

W polach tekstowych można również znaleźć tylko każdy znak, który można określić jako separator kolumn (tabulatory, spacje, przecinki itp.). Importowanie tekstu z pliku CSV zawsze wymaga ostrożności, aby uniknąć oddzielania tekstu między niepotrzebnymi nowymi kolumnami. Jest to typowy problem podczas przetwarzania tekstu, który prawdopodobnie napotkano i obsłużono na różne sposoby.

Problemy mogą również wystąpić podczas próby wyeksportowania kolumny danych ciągu zawierającej przecinki. Machine Learning nie obsługuje żadnej specjalnej obsługi ani specjalnego tłumaczenia takich danych, takich jak ujęcie ciągów w cudzysłów. Ponadto nie można używać znaków ucieczki przed przecinkiem, aby upewnić się, że przecinki są obsługiwane jako znak literału. W związku z tym nowe pola są tworzone w pliku wyjściowym dla każdego przecinka napotkanego w polu ciągu.

Aby uniknąć problemów z eksportowaniem, użyj modułu Preprocess Text ,aby usunąć znaki interpunkcyjne z pól ciągów.

Możesz również użyć niestandardowego skryptu języka R lub skryptu języka Python , aby przetworzyć złożony tekst i upewnić się, że dane można zaimportować lub wyeksportować poprawnie.

Wymagane jest kodowanie UTF-8

Machine Learning wymaga kodowania UTF-8. Jeśli importowane dane używają innego kodowania lub zostały wyeksportowane ze źródła danych, które używa innego kodowania domyślnego, różne problemy mogą pojawić się w tekście.

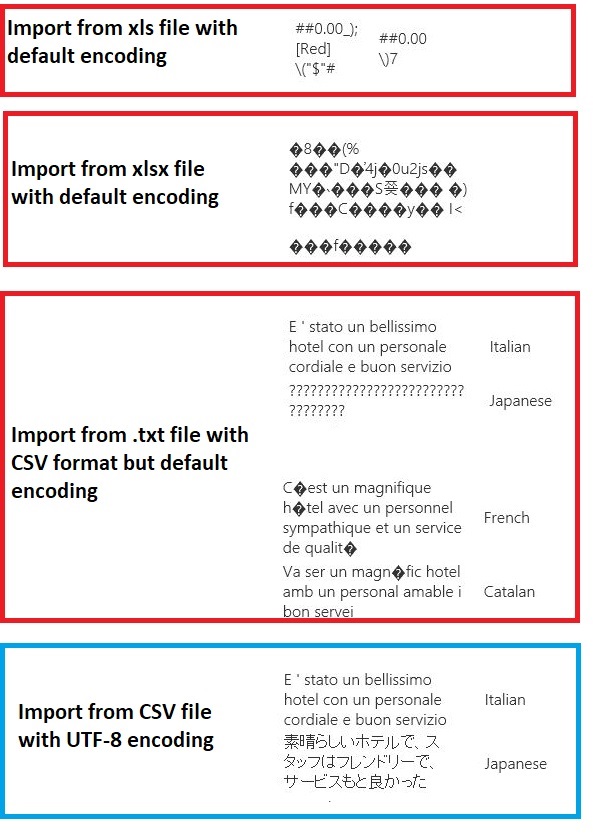

Na przykład na poniższej ilustracji znajduje się ten sam wielojęzyczny zestaw danych wyeksportowany z Excel, a następnie zaimportowany do Machine Learning w ramach czterech różnych kombinacji typu pliku i kodowania.

Trzeci przykład reprezentuje dane, które zostały utracone podczas zapisywania z Excel w formacie CSV, ponieważ poprawne kodowanie nie zostało określone w tym czasie. W związku z tym, jeśli wystąpią problemy, upewnij się, że nie tylko plik, z którego importujesz, ale czy plik został poprawnie wyeksportowany ze źródła.

Zestaw danych nie ma nazw kolumn

Jeśli importowane zestawy danych nie mają nazw kolumn, należy określić jedną z opcji "brak nagłówka". W tym celu import danych dodaje domyślne nazwy kolumn przy użyciu formatu Col1, Col2 itp. Później użyj polecenia Edytuj metadane , aby naprawić nazwy kolumn.

Jeśli eksportujesz zestaw danych do pliku CSV, użyj polecenia Edytuj metadane , aby dodać nazwy kolumn przed przekonwertowaniem lub wyeksportowaniem go.

Obejścia nieobsługiwanych źródeł danych

Jeśli musisz pobrać dane ze źródła, które nie znajduje się na liście, możesz wypróbować różne obejścia:

Aby przekazać dane z pliku na komputerze, kliknij pozycję Nowy w programie Studio (klasycznym), wybierz pozycję Zestaw danych, a następnie wybierz pozycję Z pliku lokalnego. Znajdź plik i określ format (TSV, CSV itp.). Aby uzyskać więcej informacji, zobacz Importowanie danych szkoleniowych do programu Studio (wersja klasyczna).

Użyj języka R lub Python. Możesz użyć modułu Execute R Script (Wykonywanie skryptu języka R ) z odpowiednim pakietem języka R, aby pobrać dane z innych baz danych w chmurze.

Moduł Execute Python Script (Wykonywanie skryptu języka Python ) umożliwia również odczytywanie i konwertowanie danych z różnych źródeł. Zobacz następujące przykłady od analityków danych firmy Microsoft w galerii analizy Cortana:

Pobieranie danych z klastrów platformy AWS. Możesz uruchomić zapytanie względem ogólnego klastra Hive z włączonym punktem końcowym WebHCat lub HCatalog. Możesz też opublikować jako stronę i odczytać z adresu URL sieci Web.

Pobieranie danych z MongoDB. Narzędzie do migracji danych dla usługi Azure Cosmos DB obsługuje szeroką gamę źródeł i formatów. Aby uzyskać więcej informacji i przykładów, zobacz Azure Cosmos DB: Narzędzie do migracji danych

Aby uzyskać więcej pomysłów i obejść, zobacz forum Machine Learning lub Galerię sztucznej inteligencji platformy Azure.

Parametry modułu

Każde źródło danych musi być skonfigurowane przy użyciu różnych opcji. W tej tabeli wymieniono tylko opcje wspólne dla wszystkich źródeł danych.

| Nazwa | Zakres | Typ | Domyślny | Opis |

|---|---|---|---|---|

| Źródło danych | Lista | Źródło danych lub ujście | Usługa Blob Service w usłudze Azure Storage | Źródłem danych może być HTTP, anonimowy protokół HTTPS, plik w usłudze Blob service lub table service, SQL bazy danych na platformie Azure, Azure SQL Data Warehouse, tabeli Hive lub punktu końcowego OData. |

| Używanie buforowanych wyników | PRAWDA/FAŁSZ | Wartość logiczna | FALSE | Jeśli wartość TRUE, moduł sprawdzi, czy eksperyment został uruchomiony wcześniej przy użyciu tych samych opcji źródłowych i tych samych danych wejściowych, a jeśli zostanie znaleziony poprzedni przebieg, używane są dane w pamięci podręcznej. Jeśli zostanie znaleziona wartość FALSE lub jeśli zostaną znalezione zmiany, dane zostaną ponownie załadowane ze źródła. |

Dane wyjściowe

| Nazwa | Typ | Opis |

|---|---|---|

| Zestaw danych wyników | Tabela danych | Zestaw danych z pobranymi danymi |

Wyjątki

| Wyjątek | Opis |

|---|---|

| Błąd 0027 | Wyjątek występuje, gdy dwa obiekty muszą mieć taki sam rozmiar, ale nie. |

| Błąd 0003 | Wyjątek występuje, jeśli co najmniej jeden z danych wejściowych ma wartość null lub jest pusty. |

| Błąd 0029 | Wyjątek występuje po przekazaniu nieprawidłowego identyfikatora URI. |

| Błąd 0030 | wyjątek występuje, gdy nie można pobrać pliku. |

| Błąd 0002 | Wyjątek występuje, jeśli nie można przeanalizować lub przekonwertować jednego lub większej liczby parametrów z określonego typu na typ wymagany przez metodę docelową. |

| Błąd 0009 | Wyjątek występuje, jeśli nazwa konta usługi Azure Storage lub nazwa kontenera jest niepoprawnie określona. |

| Błąd 0048 | Wyjątek występuje, gdy nie można otworzyć pliku. |

| Błąd 0015 | Wyjątek występuje, jeśli połączenie z bazą danych nie powiodło się. |

| Błąd 0046 | Wyjątek występuje, gdy nie można utworzyć katalogu na określonej ścieżce. |

| Błąd 0049 | Wyjątek występuje, gdy nie można przeanalizować pliku. |

Aby uzyskać listę błędów specyficznych dla modułów programu Studio (klasycznych), zobacz Machine Learning Kody błędów.

Aby uzyskać listę wyjątków interfejsu API, zobacz Machine Learning kody błędów interfejsu API REST.

Zobacz też

Dane wejściowe i wyjściowe

Konwersje formatu danych

Eksportowanie danych

Lista modułów A-Z