Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Rozszerzenie Visual Studio (VS) Code dla inżynierii danych Fabric w pełni obsługuje operacje tworzenia, odczytu, aktualizacji i usuwania (CRUD) definicji zadań Spark w Fabric. Po utworzeniu definicji zadania platformy Spark możesz przekazać więcej bibliotek, przesłać żądanie uruchomienia definicji zadania platformy Spark i sprawdzić historię uruchamiania.

Tworzenie definicji zadania platformy Spark

Aby utworzyć nową definicję zadania platformy Spark:

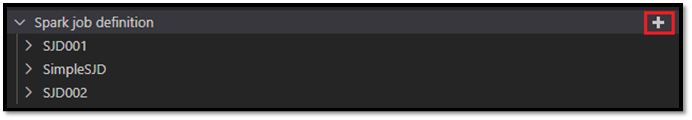

W Eksploratorze programu VS Code wybierz opcję Utwórz definicję zadania platformy Spark.

Wprowadź początkowe wymagane pola: name, referenced lakehouse i default lakehouse.

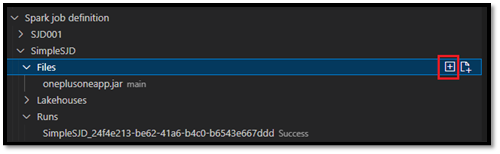

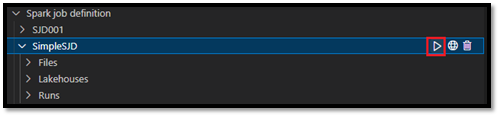

Procesy żądania i nazwa nowo utworzonej definicji zadania platformy Spark są wyświetlane w węźle głównym definicji zadania platformy Spark w Eksploratorze programu VS Code. W węźle nazwa definicji zadania platformy Spark zostaną wyświetlone trzy podwęźle:

- Pliki: lista głównego pliku definicji i innych bibliotek, do których odwołuje się odwołanie. Możesz przekazać nowe pliki z tej listy.

-

Lakehouse: lista wszystkich jezior, do których odwołuje się ta definicja zadania platformy Spark. Domyślny magazyn lakehouse jest oznaczony na liście i można uzyskać do niego dostęp za pośrednictwem ścieżki

Files/…, Tables/…względnej . - Uruchom: lista historii uruchamiania tej definicji zadania platformy Spark i stanu zadania każdego przebiegu.

Przekazywanie pliku definicji głównej do biblioteki, do których odwołuje się odwołanie

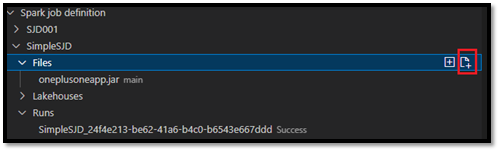

Aby przekazać lub zastąpić główny plik definicji, wybierz opcję Dodaj plik główny.

Aby przekazać plik biblioteki, do którego odwołuje się główny plik definicji, wybierz opcję Dodaj plik lib.

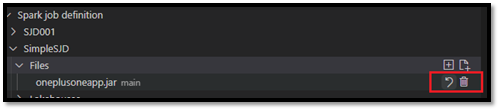

Po przekazaniu pliku możesz go przesłonić, klikając opcję Aktualizuj plik i przekazując nowy plik, lub możesz usunąć plik za pomocą opcji Usuń .

Przesyłanie żądania uruchomienia

Aby przesłać żądanie uruchomienia definicji zadania platformy Spark z programu VS Code:

Z opcji po prawej stronie nazwy definicji zadania platformy Spark, którą chcesz uruchomić, wybierz opcję Uruchom zadanie platformy Spark.

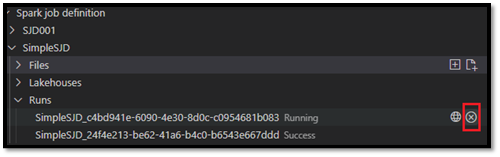

Po przesłaniu żądania nowa aplikacja platformy Apache Spark zostanie wyświetlona w węźle Uruchomienia na liście Eksplorator. Uruchomione zadanie można anulować, wybierając opcję Anuluj zadanie platformy Spark.

Otwieranie definicji zadania platformy Spark w portalu sieci szkieletowej

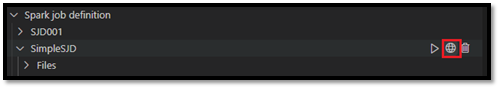

Możesz otworzyć stronę tworzenia definicji zadań platformy Spark w portalu sieci szkieletowej, wybierając opcję Otwórz w przeglądarce .

Możesz również wybrać pozycję Otwórz w przeglądarce obok ukończonego przebiegu, aby wyświetlić stronę monitorowania szczegółów tego przebiegu.

Debugowanie kodu źródłowego definicji zadania platformy Spark (Python)

Jeśli definicja zadania platformy Spark jest tworzona przy użyciu narzędzia PySpark (Python), możesz pobrać skrypt .py głównego pliku definicji i pliku definicji, do którego się odwołujesz, oraz debugować skrypt źródłowy w programie VS Code.

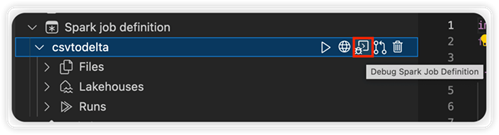

Aby pobrać kod źródłowy, wybierz opcję Debugowanie definicji zadania platformy Spark po prawej stronie definicji zadania platformy Spark.

Po zakończeniu pobierania zostanie automatycznie otwarty folder kodu źródłowego.

Po wyświetleniu monitu wybierz opcję Ufaj autorom . (Ta opcja jest wyświetlana tylko przy pierwszym otwarciu folderu. Jeśli nie wybierzesz tej opcji, nie możesz debugować ani uruchamiać skryptu źródłowego. Aby uzyskać więcej informacji, zobacz Zabezpieczenia zaufania obszaru roboczego programu Visual Studio Code).

Jeśli wcześniej pobrano kod źródłowy, zostanie wyświetlony monit o potwierdzenie, że chcesz zastąpić lokalną wersję przy użyciu nowego pobierania.

Uwaga

W folderze głównym skryptu źródłowego system tworzy podfolder o nazwie conf. W tym folderze plik o nazwie lighter-config.json zawiera pewne metadane systemowe potrzebne do zdalnego uruchamiania. Nie wprowadzaj w nim żadnych zmian.

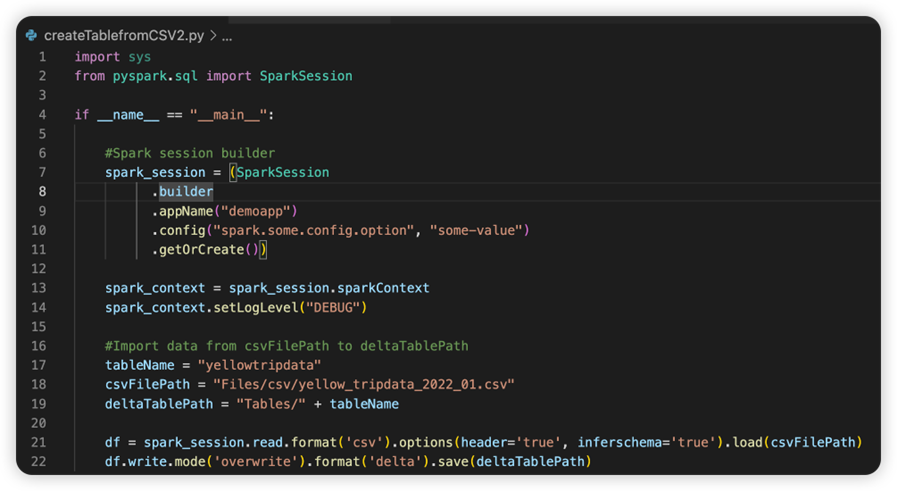

Plik o nazwie sparkconf.py zawiera fragment kodu, który należy dodać, aby skonfigurować obiekt SparkConf . Aby włączyć debugowanie zdalne, upewnij się, że obiekt SparkConf jest poprawnie skonfigurowany. Na poniższej ilustracji przedstawiono oryginalną wersję kodu źródłowego.

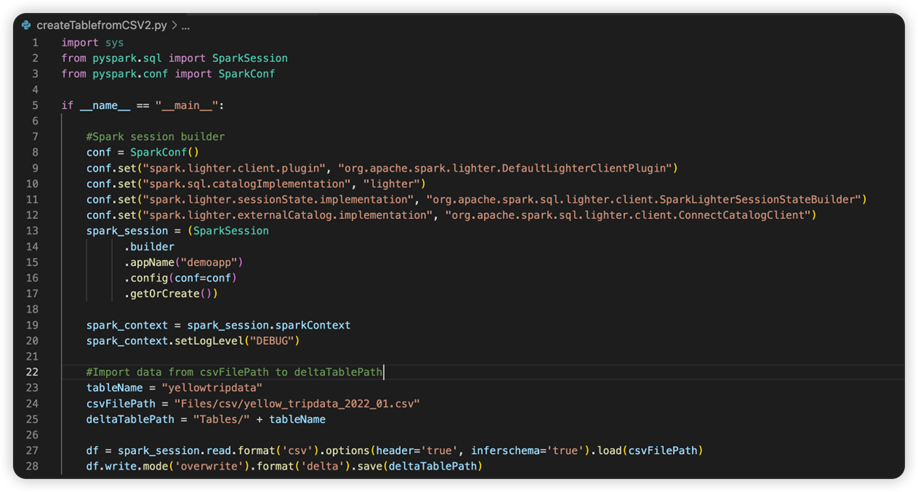

Następny obraz to zaktualizowany kod źródłowy po skopiowaniu i wklejeniu fragmentu kodu.

Po zaktualizowaniu kodu źródłowego przy użyciu niezbędnego ogranicznika należy wybrać właściwy interpreter języka Python. Upewnij się, że wybrano ten zainstalowany w środowisku synapse-spark-kernel conda.

Edytowanie właściwości definicji zadania platformy Spark

Możesz edytować szczegółowe właściwości definicji zadań platformy Spark, takich jak argumenty wiersza polecenia.

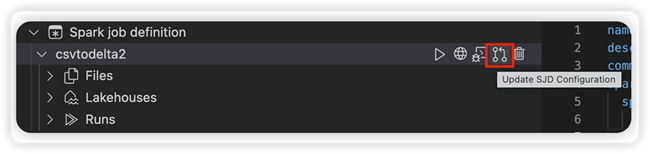

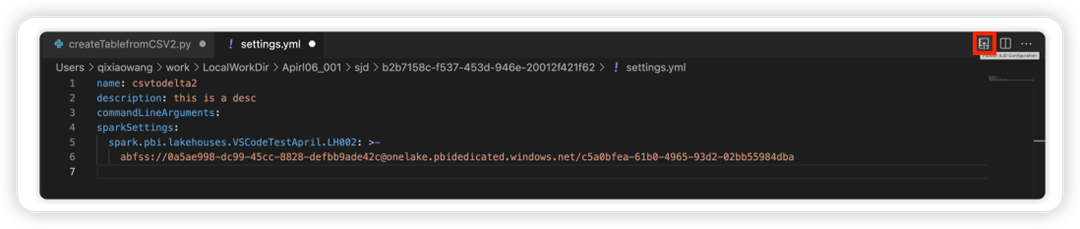

Wybierz opcję Aktualizuj konfigurację SJD, aby otworzyć plik settings.yml. Istniejące właściwości wypełniają zawartość tego pliku.

Zaktualizuj i zapisz plik .yml.

Wybierz opcję Publikuj właściwość SJD w prawym górnym rogu, aby zsynchronizować zmianę z powrotem do zdalnego obszaru roboczego.