Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Te samouczki przedstawiają kompletny scenariusz punkt po punkcie w doświadczeniu nauki o danych Fabric. Obejmują one każdy krok, od

- Pozyskiwanie danych

- Czyszczenie danych

- Przygotowywanie danych

na

- Trenowanie modelu uczenia maszynowego

- Generowanie szczegółowych informacji

a następnie obejmują użycie tych szczegółowych informacji za pomocą narzędzi do wizualizacji — na przykład usługi Power BI.

Ludzie nowi w usłudze Microsoft Fabric powinni odwiedzić stronę Co to jest Microsoft Fabric?.

Wprowadzenie

Cykl życia projektu nauki o danych zwykle obejmuje następujące kroki:

- Omówienie reguł biznesowych

- Uzyskiwanie danych

- Eksplorowanie, czyszczenie, przygotowywanie i wizualizowanie danych

- Trenowanie modelu i śledzenie eksperymentu

- Ocenianie modelu i generowanie szczegółowych informacji

Kroki często są wykonywane iteracyjnie. Cele i kryteria sukcesu każdego etapu zależą od współpracy, udostępniania danych i dokumentacji. Doświadczenie nauki o danych w ramach Fabric obejmuje wiele natywnie wbudowanych funkcji, które umożliwiają bezproblemową współpracę, pozyskiwanie, udostępnianie i wykorzystanie danych.

Te samouczki umieszczają Cię w roli analityka danych, który musi eksplorować, czyścić i przekształcać zestaw danych zawierający stan rezygnacji 10 000 klientów bankowych. Następnie utworzysz model uczenia maszynowego, aby przewidzieć, którzy klienci bankowi prawdopodobnie odejdą.

W samouczkach wykonasz następujące działania:

- Używaj notesów Fabric do scenariuszy związanych z nauką o danych

- Pozyskiwanie danych do usługi Fabric lakehouse przy użyciu platformy Apache Spark

- Ładowanie istniejących danych z tabel delty usługi Lakehouse

- Czyszczenie i przekształcanie danych przy użyciu platformy Apache Spark i języka Python

- Tworzenie eksperymentów i uruchomień w celu trenowania różnych modeli uczenia maszynowego

- Używaj MLflow i Fabric UI do rejestrowania i śledzenia wytrenowanych modeli

- Uruchamianie oceniania na dużą skalę i zapisywanie przewidywań i wyników wnioskowania w usłudze Lakehouse

- Wizualizowanie przewidywań w usłudze Power BI przy użyciu usługi DirectLake

Architektura

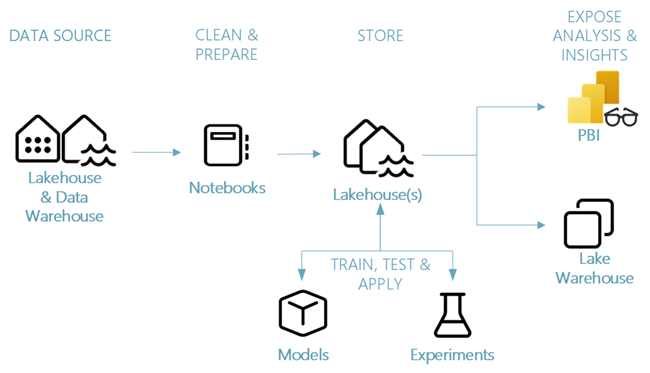

W tej serii samouczków przedstawiono uproszczony scenariusz nauki o danych obejmujący:

- Pozyskiwanie danych z zewnętrznego źródła danych.

- Eksploracja i czyszczenie danych.

- Trenowanie i rejestracja modelu uczenia maszynowego.

- Ocena wsadowa i zapisywanie przewidywań.

- Wizualizacja wyniku przewidywania w usłudze Power BI.

Różne składniki scenariusza nauki o danych

Źródła danych — aby pozyskiwać dane za pomocą sieci Szkieletowej, można łatwo i szybko łączyć się z usługami Azure Data Services, innymi platformami w chmurze i lokalnymi zasobami danych. Notesy Fabric umożliwiają przetwarzanie danych z następujących zasobów:

- Wbudowane systemy typu Lakehouse

- Magazyny danych

- Modele semantyczne

- Różne źródła danych platformy Apache Spark

- Różne źródła danych, które obsługują język Python

Ta seria samouczków koncentruje się na pozyskiwaniu i ładowaniu danych z lakehouse.

Eksplorowanie, czyszczenie i przygotowywanie — doświadczenie Fabric w nauce o danych wspiera czyszczenie, przekształcanie, eksplorację i tworzenie cech danych. Korzysta z wbudowanych środowisk Platformy Spark i narzędzi opartych na języku Python — na przykład biblioteki Data Wrangler i SemPy. W tym samouczku przedstawiono eksplorację seaborn danych za pomocą biblioteki języka Python oraz czyszczenie i przygotowywanie danych za pomocą platformy Apache Spark.

Modele i eksperymenty — za pomocą usługi Fabric można trenować, oceniać i oceniać modele uczenia maszynowego za pomocą wbudowanych eksperymentów. Aby zarejestrować i wdrożyć modele oraz śledzić eksperymenty, platforma MLflow oferuje bezproblemową integrację z usługą Fabric jako sposób modelowania elementów. Aby tworzyć i udostępniać szczegółowe informacje biznesowe, platforma Fabric oferuje inne funkcje przewidywania modeli na dużą skalę (PREDICT).

Magazyn — Fabric standaryzuje wykorzystanie Delta Lake, co oznacza, że wszystkie silniki Fabric mogą komunikować się z tym samym zestawem danych przechowywanym w magazynie danych typu lakehouse. Dzięki tej warstwie magazynowania można przechowywać zarówno dane ustrukturyzowane, jak i nieustrukturyzowane, które obsługują zarówno magazyn oparty na plikach, jak i format tabelaryczny. Dostęp do zestawów danych i przechowywanych plików można łatwo uzyskać za pośrednictwem wszystkich elementów środowiska usługi Fabric — na przykład notesów i potoków.

Uwidaczniaj analizę i szczegółowe informacje — usługa Power BI, wiodące w branży narzędzie do analizy biznesowej, może wykorzystywać dane typu lakehouse na potrzeby generowania raportów i wizualizacji. W zasobach notesu natywne biblioteki wizualizacji języka Python lub Spark

matplotlibseabornplotly- I tak dalej.

może wizualizować dane zapisane w jeziorodomek. Biblioteka SemPy obsługuje również wizualizację danych. Ta biblioteka obsługuje wbudowane, bogate wizualizacje specyficzne dla zadań

- Semantyczny model danych

- Zależności i ich naruszenia

- Przypadki użycia klasyfikacji i regresji