Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Ten artykuł wyjaśnia prompty i inżynierię promptów jako kluczowe koncepcje, które pomogą Ci tworzyć potężne możliwości generatywnej AI, które można wykorzystać w Copilot Studio.

Ważne

- Prompty wykorzystują modele oparte na Azure Foundry.

- Ta funkcja może podlegać limitom użycia lub możliwościom wykrywania wydajności.

Wymagania wstępne

- Twoje środowisko znajduje się na liście dostępnych regionów.

- Potrzebujesz punktów Copilota.

- Microsoft Dataverse jest zainstalowany w środowisku.

Czym jest prompt

Prompt składa się głównie z instrukcji w języku naturalnym, która nakazuje generatywnemu modelu AI wykonać zadanie. Model działa zgodnie z monitem, aby określić strukturę i treść tekstu, który ma wygenerować. Inżynieria monitów to proces tworzenia i udoskonalania monitu używanego przez model.

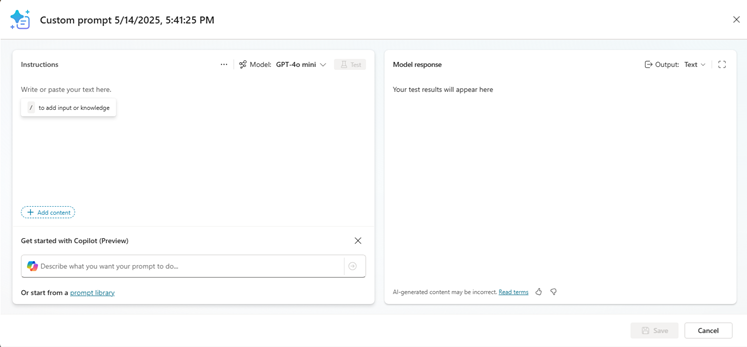

Doświadczenie kreatora promptów pozwala twórcom tworzyć, testować i zapisywać wielokrotnego użytku prompty. W tym doświadczeniu możesz także używać zmiennych wejściowych i danych wiedzy, aby dostarczać dynamiczne dane kontekstowe w czasie działania. Możesz udostępniać te prompty innym i używać ich jako agentów, przepływów pracy lub aplikacji.

Te monity mogą być wykorzystywane do wielu zadań lub scenariuszy biznesowych, takich jak podsumowanie zawartości, dzielenie danych, wyodrębnianie encji, tłumaczenie języków, ocena opinii lub formułowanie odpowiedzi na skargę. Na przykład możesz stworzyć prompt do wybrania zadań z firmowych e-maili i użyć ich w workflow Power Automate do budowy automatyzacji przetwarzania poczty elektronicznej.

W Copilot Studio prompty mogą być używane jako narzędzia agentów, aby poprawić doświadczenie czatu lub umożliwić zaawansowane automatyzacje AI lub węzły workflow do wprowadzania działań AI do automatyzacji deterministycznej.

Nadzór ludzki

Nadzór ludzki jest ważnym krokiem przy pracy z treściami generowanymi w modelu generatywnej AI. Takie modele są trenowane na ogromnych ilościach danych i mogą zawierać błędy oraz uprzedzenia. Ludzie powinni przejrzeć je przed publikacją w trybie online, wysłać do klienta lub użyć ich do poinformowania o podjęciu decyzji biznesowej. Nadzór ludzki pomaga zidentyfikować potencjalne błędy i uprzedzenia. Upewnia się również, że treść jest odpowiednia dla zamierzonego przypadku użycia i jest zgodna z wartościami firmy.

Ocena ludzka może również pomóc zidentyfikować ewentualne problemy z samym modelem. Jeśli na przykład model generuje zawartość, która nie ma znaczenia dla planowanego przypadku użycia, może okazać się konieczne dostosowanie monitu.

Odpowiedzialne używanie sztucznej inteligencji

Dokładamy wszelkich starań, aby tworzyć wzorzec odpowiedzialnego AI. Naszymi działaniami kierował podstawowy zestaw zasad: uczciwość, niezawodność i bezpieczeństwo, prywatność i zabezpieczenia, włączenie społeczne, przezroczystość i odpowiedzialność. Wprowadzamy te zasady w życie w całej firmie, aby opracowywać i wdrażać sztuczną inteligencję, która ma pozytywny wpływ na społeczeństwo. Stosujemy kompleksowe podejście, łącząc innowacyjne badania, wyjątkową inżynierię i odpowiedzialne zarządzanie. Obok przeprowadzonych przez OpenAI analiz w zakresie wyrównania wartości AI zalecamy struktury bezpiecznego wdrażania własnych technologii AI, które mają pomóc branży w zakresie realizacji bardziej odpowiedzialnych działań.

Dowiedz się więcej o przejrzystości w Transparency Note dla Azure OpenAI.