Nuta

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować się zalogować lub zmienić katalog.

Dostęp do tej strony wymaga autoryzacji. Możesz spróbować zmienić katalogi.

Ważne

Obsługa programu Machine Learning Studio (wersja klasyczna) zakończy się 31 sierpnia 2024 r. Zalecamy przejście do usługi Azure Machine Learning przed tym terminem.

Od 1 grudnia 2021 r. nie będzie można tworzyć nowych zasobów programu Machine Learning Studio (wersja klasyczna). Do 31 sierpnia 2024 r. można będzie nadal korzystać z istniejących zasobów programu Machine Learning Studio (wersja klasyczna).

- Zobacz informacje dotyczące przenoszenia projektów uczenia maszynowego z programu ML Studio (klasycznego) do Azure Machine Learning.

- Dowiedz się więcej o Azure Machine Learning.

Dokumentacja programu ML Studio (wersja klasyczna) jest wycofywana i może nie być aktualizowana w przyszłości.

W tym artykule opisano moduły w programie Machine Learning Studio (klasycznym), których można użyć do oceny modelu uczenia maszynowego. Ocena modelu jest wykonywana po zakończeniu trenowania, aby mierzyć dokładność przewidywań i oceniać dopasowanie modelu.

Uwaga

Dotyczy: tylko Machine Learning Studio (wersja klasyczna)

Podobne moduły przeciągania i upuszczania są dostępne w projektancie Azure Machine Learning.

W tym artykule opisano również ogólny proces w programie Machine Learning Studio (wersja klasyczna) na potrzeby tworzenia, trenowania, oceny i oceniania modeli.

Tworzenie i używanie modeli uczenia maszynowego w programie Machine Learning Studio (wersja klasyczna)

Typowy przepływ pracy uczenia maszynowego obejmuje następujące fazy:

- Wybierz odpowiedni algorytm i ustaw opcje początkowe.

- Trenowanie modelu przy użyciu zgodnych danych.

- Utwórz przewidywania przy użyciu nowych danych opartych na wzorcach w modelu.

- Oceń model, aby określić, czy przewidywania są dokładne, ilość błędów i czy występuje nadmierne dopasowanie.

program Machine Learning Studio (wersja klasyczna) obsługuje elastyczną, dostosowywalną strukturę do uczenia maszynowego. Każde zadanie w tym procesie jest wykonywane przez określony typ modułu. Moduł można modyfikować, dodawać lub usuwać bez przerywania reszty eksperymentu.

Użyj modułów w tej kategorii, aby ocenić istniejący model. Ocena modelu zwykle wymaga pewnego rodzaju zestawu danych wyników. Jeśli nie masz zestawu danych oceny, możesz wygenerować wyniki, oceniając. Możesz również użyć zestawu danych testowych lub innego zestawu danych, który zawiera "prawdę prawną" lub znane oczekiwane wyniki.

Więcej informacji na temat oceny modelu

Ogólnie rzecz biorąc, podczas oceniania modelu opcje zależą od typu ocenianego modelu oraz metryki, której chcesz użyć. W tych tematach wymieniono niektóre z najczęściej używanych metryk:

Machine Learning Studio (wersja klasyczna) udostępnia również różne wizualizacje, w zależności od typu używanego modelu oraz liczby klas, które przewiduje model. Aby uzyskać pomoc dotyczącą znajdowania tych wizualizacji, zobacz Wyświetlanie metryk oceny.

Interpretowanie tych statystyk często wymaga lepszego zrozumienia konkretnego algorytmu, na którym został wytrenowany model. Aby uzyskać dobre wyjaśnienie, jak ocenić model i jak interpretować wartości zwracane dla każdej miary, zobacz How to evaluate model performance in Machine Learning (Jak ocenić wydajność modelu w Machine Learning).

Lista modułów

Kategoria Machine Learning — Ocena obejmuje następujące moduły:

Model weryfikacji krzyżowej: krzyżowo weryfikuje oszacowania parametrów dla modeli klasyfikacji lub regresji przez partycjonowanie danych.

Użyj modułu Cross-Validate Model (Model cross-Validate ), aby przetestować poprawność zestawu treningowego i modelu. Krzyżowa walidacja partycjonuje dane na fałdy, a następnie testuje wiele modeli w kombinacjach składanych.

Ocena modelu: ocenia oceniany model klasyfikacji lub regresji przy użyciu standardowych metryk.

W większości przypadków użyjesz ogólnego modułu Evaluate Model (Ocena modelu ). Jest to szczególnie istotne, jeśli model jest oparty na jednej z obsługiwanych algorytmów klasyfikacji lub regresji.

Evaluate Recommender: ocenia dokładność prognoz modelu rekomendacji.

W przypadku modeli rekomendacji użyj modułu Evaluate Recommender (Ocena modułu rekomendacji ).

Zadania powiązane

- W przypadku modeli klastrowania użyj modułu Assign Data to Clusters (Przypisywanie danych do klastrów ). Następnie użyj wizualizacji w tym module, aby wyświetlić wyniki oceny.

- Możesz utworzyć niestandardowe metryki oceny. Aby utworzyć niestandardowe metryki oceny, podaj kod języka R w module Execute R Script (Wykonywanie skryptu języka R ) lub Kod języka Python w module Execute Python Script (Wykonywanie skryptu języka Python ). Ta opcja jest przydatna, jeśli chcesz użyć metryk opublikowanych w ramach bibliotek typu open source lub jeśli chcesz zaprojektować własną metrykę na potrzeby pomiaru dokładności modelu.

Przykłady

Interpretowanie wyników oceny modelu uczenia maszynowego jest sztuką. Wymaga zrozumienia wyników matematycznych, a także danych i problemów biznesowych. Zalecamy przejrzenie tych artykułów w celu wyjaśnienia sposobu interpretowania wyników w różnych scenariuszach:

- Wybieranie parametrów do optymalizacji algorytmów w Machine Learning

- Interpretowanie wyników modelu w Machine Learning

- Ocena wydajności modelu w Machine Learning

Uwagi techniczne

Ta sekcja zawiera szczegóły implementacji, porady i odpowiedzi na często zadawane pytania.

Wyświetlanie metryk oceny

Dowiedz się, gdzie szukać w programie Machine Learning Studio (klasycznym), aby znaleźć wykresy metryk dla każdego typu modelu.

Modele klasyfikacji dwuklasowej

Domyślny widok dla modeli klasyfikacji binarnej obejmuje interaktywny wykres ROC i tabelę wartości dla głównych metryk.

Dostępne są dwie opcje wyświetlania modeli klasyfikacji binarnej:

- Kliknij prawym przyciskiem myszy dane wyjściowe modułu, a następnie wybierz pozycję Wizualizuj.

- Kliknij prawym przyciskiem myszy moduł, wybierz pozycję Wyniki oceny, a następnie wybierz pozycję Wizualizuj.

Możesz również użyć suwaka, aby zmienić wartość progu prawdopodobieństwa. Próg określa, czy wynik powinien zostać zaakceptowany jako true, czy nie. Następnie możesz zobaczyć, jak te wartości się zmieniają.

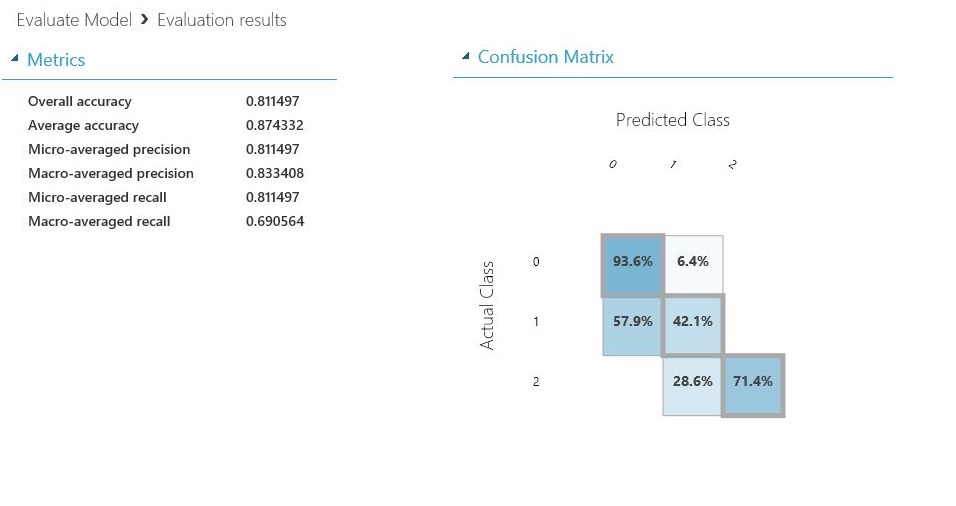

Modele klasyfikacji wieloklasowej

Domyślny widok metryk dla modeli klasyfikacji wieloklasowej zawiera macierz pomyłek dla wszystkich klas i zestaw metryk dla modelu jako całości.

Dostępne są dwie opcje wyświetlania modeli klasyfikacji wieloklasowej:

- Kliknij prawym przyciskiem myszy dane wyjściowe modułu, a następnie wybierz pozycję Wizualizuj.

- Kliknij prawym przyciskiem myszy moduł, wybierz pozycję Wyniki oceny, a następnie wybierz pozycję Wizualizuj.

Dla uproszczenia poniżej przedstawiono dwa wyniki, które są wyświetlane obok siebie:

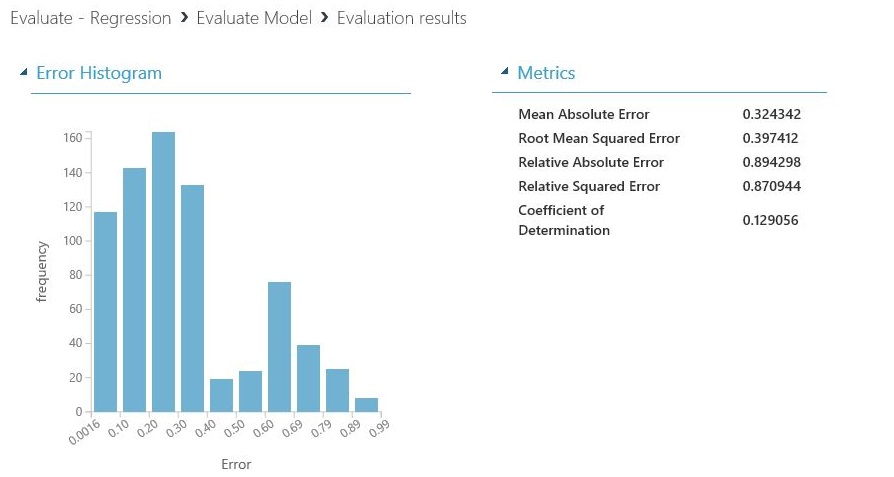

Modele regresji

Widok metryk dla modeli regresji różni się w zależności od typu utworzonego modelu. Widok metryk jest oparty na podstawowych interfejsach algorytmów i najlepiej nadaje się do metryk modelu.

Dostępne są dwie opcje wyświetlania modeli regresji:

- Aby wyświetlić metryki dokładności w tabeli, kliknij prawym przyciskiem myszy dane wyjściowe modułu Evaluate Model (Ocena modelu), a następnie wybierz pozycję Visualize (Wizualizacja).

- Aby wyświetlić histogram błędu z wartościami, kliknij prawym przyciskiem myszy moduł, wybierz pozycję Wyniki oceny, a następnie wybierz pozycję Wizualizuj.

Widok Histogramu błędu może pomóc zrozumieć, jak błąd jest dystrybuowany. Jest on udostępniany dla następujących typów modeli i zawiera tabelę domyślnych metryk, takich jak błąd średniokwadratowy głównego (RMSE).

Następujące modele regresji generują tabelę metryk domyślnych wraz z niektórymi metrykami niestandardowymi:

- Regresja liniowa bayesijska

- Regresja lasu decyzyjnego

- Szybka regresja kwantylowa lasu decyzyjnego

- Regresja porządkowa

Wskazówki do pracy z danymi

Aby wyodrębnić liczby bez kopiowania i wklejania z interfejsu użytkownika programu Machine Learning Studio (wersja klasyczna), możesz użyć nowej biblioteki programu PowerShell dla Machine Learning. Możesz uzyskać metadane i inne informacje dotyczące całego eksperymentu lub z poszczególnych modułów.

Aby wyodrębnić wartości z modułu Evaluate Model (Ocena modelu ), należy dodać unikatowy komentarz do modułu, aby ułatwić identyfikację. Następnie użyj polecenia cmdlet Download-AmlExperimentNodeOutput , aby pobrać metryki i ich wartości z wizualizacji w formacie JSON.

Aby uzyskać więcej informacji, zobacz Tworzenie modeli uczenia maszynowego przy użyciu programu PowerShell.