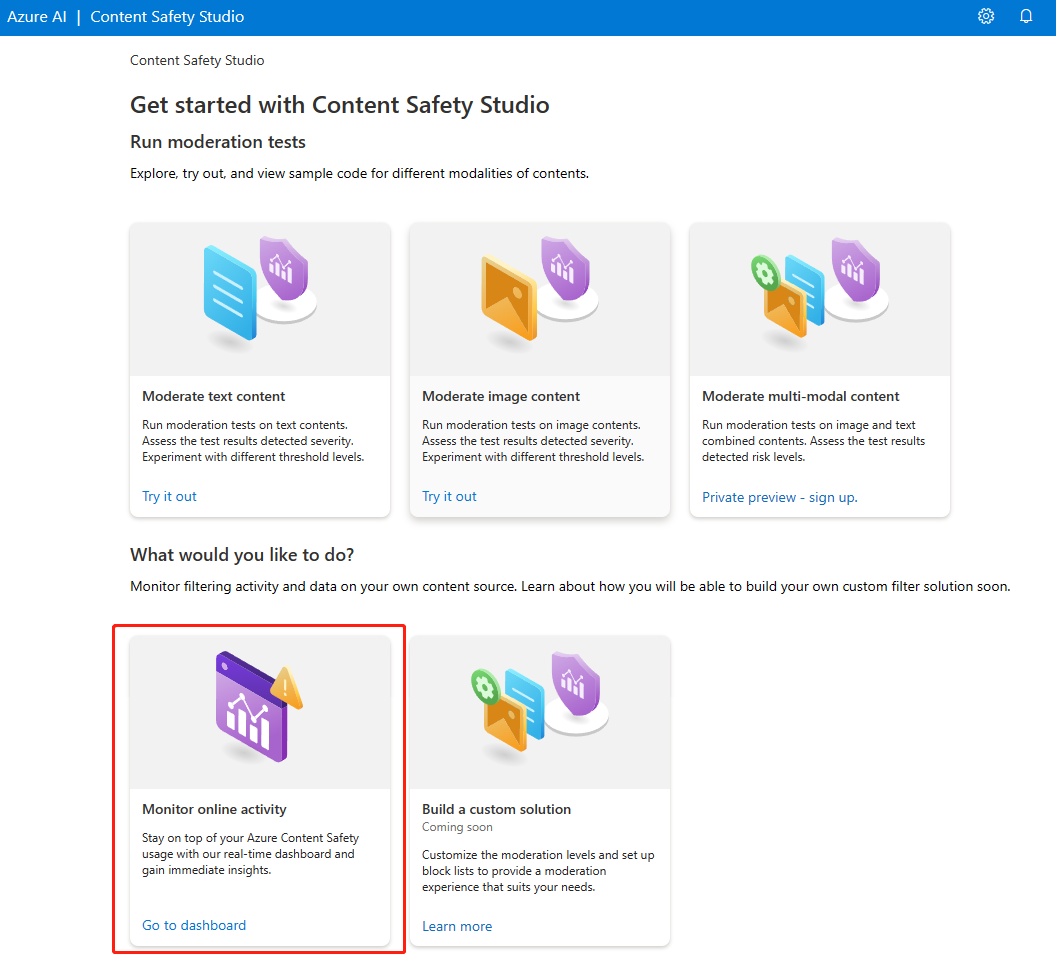

Início Rápido: Content Safety Studio da IA do Azure

Neste início rápido, mostramos a introdução ao serviço de Segurança de Conteúdo de IA do Azure usando o Content Safety Studio no seu navegador.

Cuidado

Alguns dos conteúdos de exemplo fornecidos pelo Content Safety Studio podem ser ofensivos. As imagens de exemplo são desfocadas por padrão. O critério do usuário é aconselhado.

Pré-requisitos

- Uma conta ativa do Azure. Se não tiver uma, poderá criá-la gratuitamente.

- Um recurso Content Safety do Azure.

- A função

Cognitive Services Useratribuída ao recurso de Segurança de Conteúdo na assinatura desejada do Azure. - Entre no Content Safety Studio com sua assinatura do Azure e o recurso Content Safety.

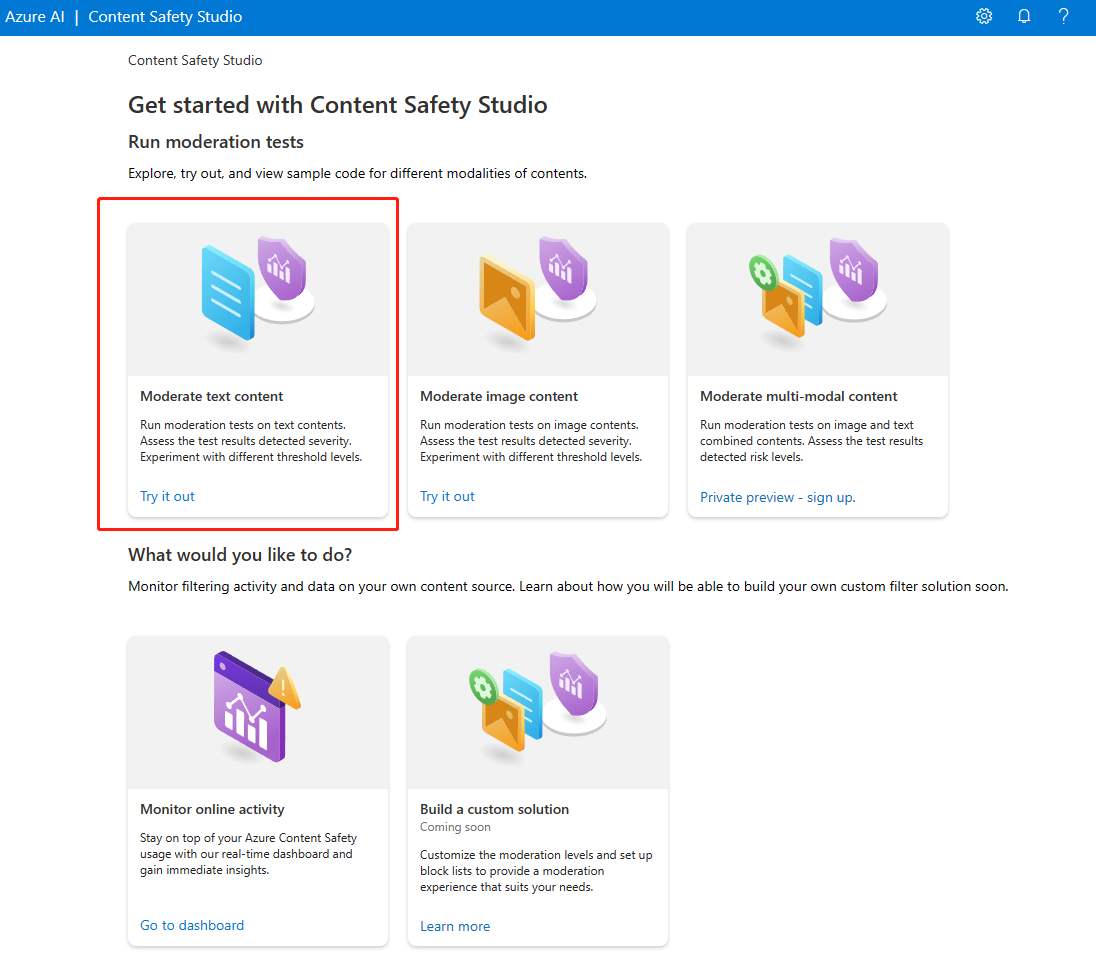

Analisar conteúdo do texto

Na página Moderar conteúdo de texto, você pode experimentar rapidamente a moderação de texto.

- Selecione o painel Moderar conteúdo de texto.

- Adicione texto ao campo de entrada ou selecione o texto de exemplo nos painéis da página.

Dica

Tamanho e granularidade do texto

Confira os requisitos de entrada para ver as limitações máximas de comprimento de texto.

- Selecione Executar teste.

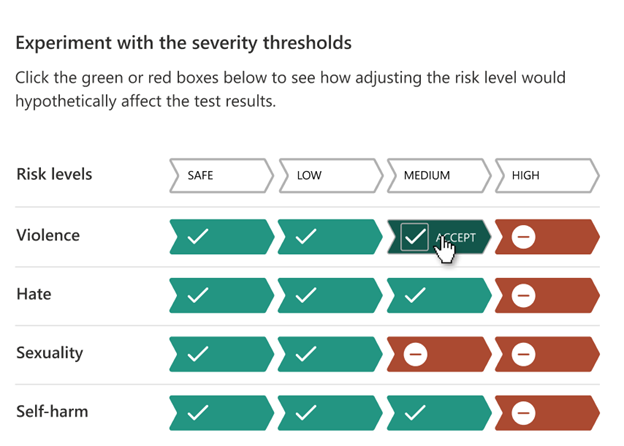

O serviço retorna todas as categorias que foram detectadas, com o nível de severidade para cada (0-Seguro, 2-Baixo, 4-Médio, 6-Alto). Ele também retorna um resultado binário Aceito/Rejeitado, com base nos filtros configurados. Use a matriz na guia Configurar filtros à direita para definir os níveis de severidade permitidos/proibidos de cada categoria. Depois, você pode reexecutar o texto para ver como o filtro funciona.

A guia Usar lista de bloqueados à direita permite que você crie, edite e adicione uma lista de bloqueados ao fluxo de trabalho de moderação. Se você tiver uma lista de bloqueados habilitada ao executar o teste, obterá um painel de Detecção de lista de bloqueados em Resultados. Ele relata todas as correspondências com a lista de bloqueados.

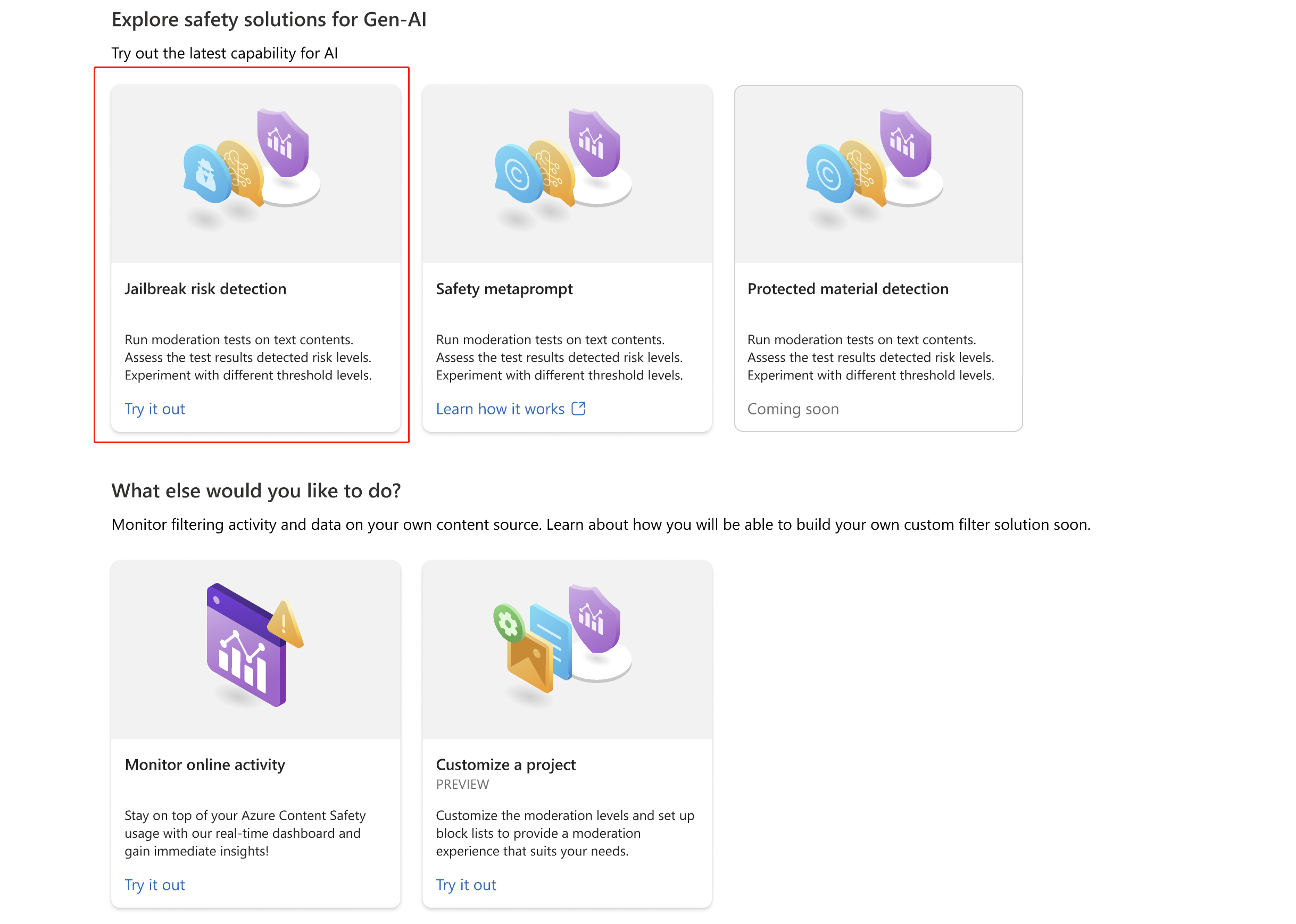

Detectar ataques de entrada do usuário

O painel do Prompt Shields permite testar a detecção de risco de entrada do usuário. Detectar prompts do usuário projetados para fazer com que o modelo de IA generativa exiba comportamentos que ele foi treinado para evitar ou violar as regras definidas na mensagem do sistema. Esses ataques podem variar desde interpretações elaboradas até subversões sutis do objetivo de segurança.

- Selecione o painel do Prompt Shields.

- Selecione um exemplo de texto na página ou insira seu próprio conteúdo para teste. Você também pode carregar um arquivo CSV para fazer um teste em lote.

- Selecione Executar teste.

O serviço retorna o sinalizador de risco e o tipo para cada amostra.

Para obter mais informações, consulte o guia conceitual do Prompt Shields.

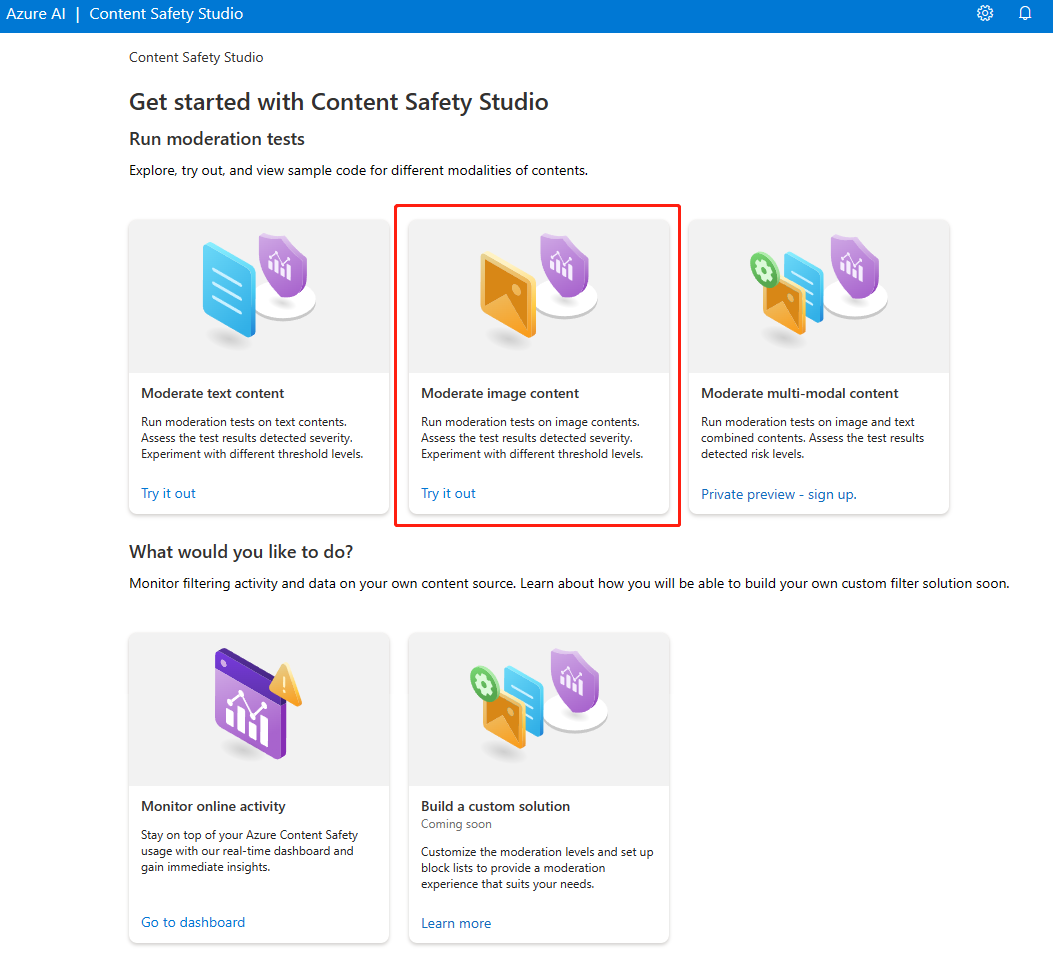

Analisar conteúdo da imagem

Na página Moderar conteúdo de imagem, você pode experimentar rapidamente a moderação de imagem.

- Selecione o painel Moderar conteúdo de imagem.

- Selecione uma imagem de exemplo nos painéis da página ou carregue sua própria imagem. O tamanho máximo para envios de imagem é de 4 MB e as dimensões de imagem devem ter entre 50 x 50 pixels e 2.048 x 2.048 pixels. As imagens podem estar em formatos JPEG, PNG, GIF, BMP, TIFF ou WEBP.

- Selecione Executar teste.

O serviço retorna todas as categorias que foram detectadas, com o nível de severidade para cada (0-Seguro, 2-Baixo, 4-Médio, 6-Alto). Ele também retorna um resultado binário Aceito/Rejeitado, com base nos filtros configurados. Use a matriz na guia Configurar filtros à direita para definir os níveis de severidade permitidos/proibidos de cada categoria. Depois, você pode reexecutar o texto para ver como o filtro funciona.

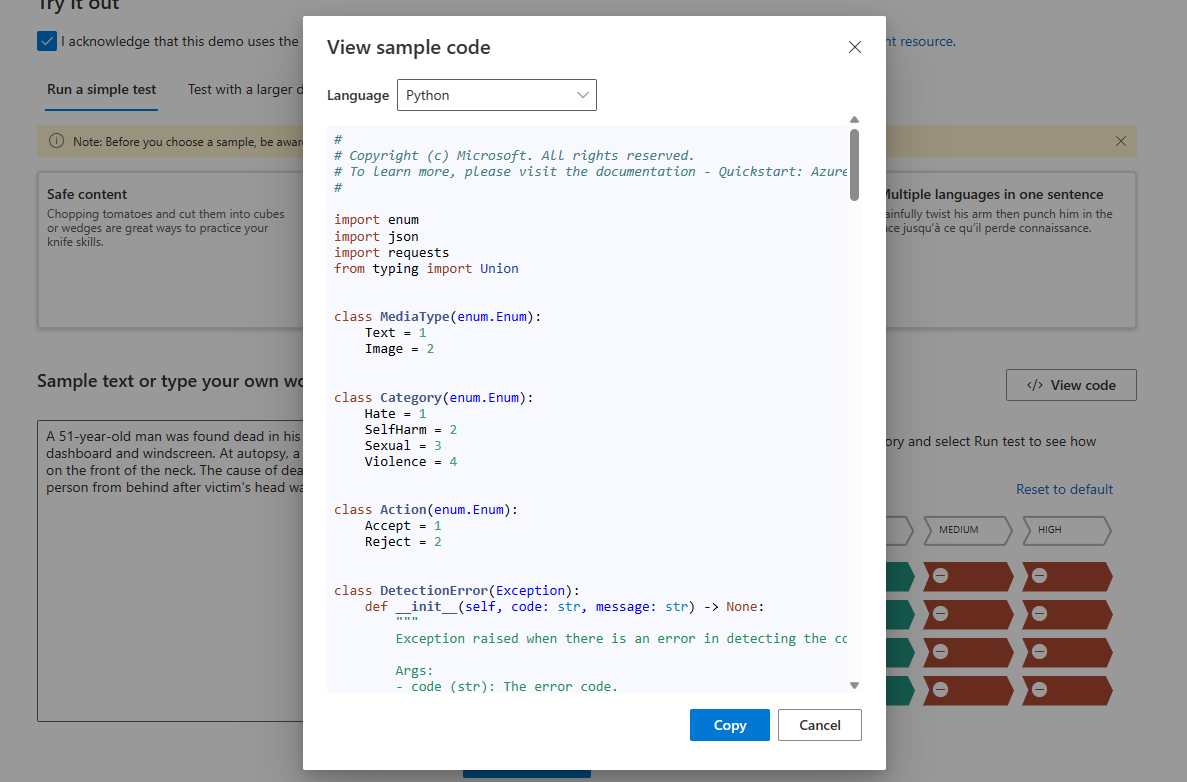

Exibir e exportar os dados

Você pode usar o recurso Exibir Código na página Analisar conteúdo de texto ou Analisar conteúdo de imagem para exibir e copiar o código de exemplo, que inclui a configuração para a filtragem de severidade, lista de bloqueados e funções de moderação. Depois, você pode implantar o código do seu lado.

Monitorar a atividade online

A página Monitorar atividade online permite exibir o uso e as tendências da API.

Você pode escolher qual Tipo de mídia monitorar. Você também pode especificar o intervalo de tempo que deseja verificar selecionando Mostrar dados para o último __.

No gráfico Rejeitar taxa por categoria, você também pode ajustar os limites de severidade de cada categoria.

Você também pode editar listas de bloqueados se quiser alterar alguns termos, com base no gráfico Os 10 principais termos bloqueados.

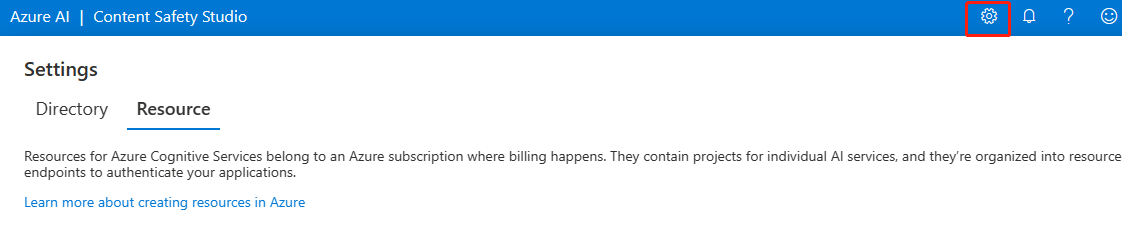

Gerenciar o recurso

Para exibir detalhes do recurso, como nome e tipo de preço, selecione o ícone Configurações no canto superior direito da página inicial do Content Safety Studio e selecione a guia Recurso. Se você tiver outros recursos, também poderá mudar os recursos.

Limpar os recursos

Se você quiser limpar e remover um recurso dos serviços de IA do Azure, poderá excluir o recurso ou o grupo de recursos. Excluir o grupo de recursos também exclui todos os recursos associados a ele.

Próximas etapas

Em seguida, comece a usar a Segurança de Conteúdo de IA do Azure por meio das APIs REST ou de um SDK do cliente, para que você possa integrar perfeitamente o serviço ao seu aplicativo.

Comentários

Em breve: Ao longo de 2024, eliminaremos os problemas do GitHub como o mecanismo de comentários para conteúdo e o substituiremos por um novo sistema de comentários. Para obter mais informações, consulte https://aka.ms/ContentUserFeedback.

Enviar e exibir comentários de