Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

O Azure AI Foundry Models é o destino único para descobrir, avaliar e implantar modelos de IA poderosos, seja você criando um copilot personalizado, criando um agente, aprimorando um aplicativo existente ou explorando novos recursos de IA.

Com os Modelos da Foundry, você pode:

- Explore um catálogo avançado de modelos de ponta da Microsoft, OpenAI, DeepSeek, Hugging Face, Meta e muito mais.

- Compare e avalie modelos lado a lado usando tarefas reais e seus próprios dados.

- Implante com confiança, graças às ferramentas internas para ajuste fino, observabilidade e IA responsável.

- Escolha seu caminho: traga seu próprio modelo, use um hospedado ou integre-se perfeitamente aos serviços do Azure.

- Seja você um desenvolvedor, cientista de dados ou arquiteto corporativo, o Foundry Models oferece a flexibilidade e o controle para criar soluções de IA que são dimensionadas de forma segura, responsável e rápida.

O Azure AI Foundry oferece um catálogo abrangente de modelos de IA. Há mais de 1900 modelos que vão desde modelos de fundação, modelos de raciocínio, modelos de linguagem pequenos, modelos multimodal, modelos específicos de domínio, modelos do setor e muito mais.

Nosso catálogo é organizado em duas categorias principais:

Entender a distinção entre essas categorias ajuda você a escolher os modelos certos com base em seus requisitos específicos e metas estratégicas.

Modelos vendidos diretamente pelo Azure

Estes são modelos hospedados e vendidos pela Microsoft nos Termos de Produto da Microsoft. Esses modelos passaram por uma avaliação rigorosa e estão profundamente integrados ao ecossistema de IA do Azure. Os modelos vêm de uma variedade de provedores principais e oferecem integração aprimorada, desempenho otimizado e suporte direto da Microsoft, incluindo SLAs (Contratos de Nível de Serviço) de nível empresarial.

Características dos modelos vendidos diretamente pelo Azure:

- Suporte oficial de primeira parte da Microsoft

- Alto nível de integração com serviços e infraestrutura do Azure

- Extensa validação e comparação de desempenho

- Adesão aos padrões de IA Responsável da Microsoft

- Escalabilidade, confiabilidade e segurança de nível empresarial

Esses modelos também têm o benefício da Taxa de transferência provisionada fungível, o que significa que você pode usar sua cota e reservas de forma flexível em qualquer um desses modelos.

Modelos de parceiros e comunidade

Esses modelos constituem a grande maioria dos Modelos de AI Foundry do Azure. Esses modelos são fornecidos por organizações confiáveis de terceiros, parceiros, laboratórios de pesquisa e colaboradores da comunidade. Esses modelos oferecem funcionalidades de IA especializadas e diversas, abrangendo uma ampla variedade de cenários, setores e inovações.

Características dos modelos de parceiros e da comunidade.

- Desenvolvido e com suporte por parceiros externos e colaboradores da comunidade

- Variedade diversificada de modelos especializados que atendem a casos de nicho ou de uso amplo

- Normalmente validados pelos próprios provedores, com diretrizes de integração fornecidas pelo Azure

- Inovação orientada pela comunidade e disponibilidade rápida de modelos de ponta

- Integração de IA padrão do Azure, com suporte e manutenção gerenciados pelos respectivos provedores

Os modelos são implantáveis como opções de implantação de Computação Gerenciada ou Padrão (pré-pago). O provedor de modelos seleciona como os modelos são implantáveis.

Escolhendo entre modelos diretos e modelos de parceiro e comunidade

Ao selecionar modelos dos Modelos Foundry de IA do Azure, considere o seguinte:

- Casos e requisitos de uso: os modelos vendidos diretamente pelo Azure são ideais para cenários que exigem integração profunda do Azure, suporte garantido e SLAs empresariais. Modelos de parceiros e da comunidade se destacam em casos de uso especializados e cenários conduzidos por inovação.

- Expectativas de suporte: os modelos vendidos diretamente pelo Azure vêm com suporte e manutenção robustos fornecidos pela Microsoft. Esses modelos são suportados por seus provedores, com diferentes níveis de SLA e estruturas de suporte.

- Inovação e especialização: modelos de parceiros e comunidade oferecem acesso rápido a inovações especializadas e recursos de nicho geralmente desenvolvidos pelos principais laboratórios de pesquisa e provedores de IA emergentes.

Coleções de modelos

O catálogo de modelos organiza modelos em coleções diferentes, incluindo:

Modelos do Azure OpenAI disponíveis exclusivamente no Azure: modelos de destaque do Azure OpenAI disponíveis por meio de uma integração com o Azure OpenAI em modelos Foundry. A Microsoft dá suporte a esses modelos e seu uso de acordo com os termos do produto e o SLA do Azure OpenAI.

Modelos abertos do hub Hugging Face: centenas de modelos do hub Hugging Face para inferência em tempo real com computação gerenciada. O Hugging Face cria e mantém modelos listados nessa coleção. Para obter ajuda, use o fórum do Hugging Face ou o suporte do Hugging Face. Saiba mais em Implantar modelos abertos com a IA do Azure Foundry.

Você pode enviar uma solicitação para adicionar um modelo ao catálogo de modelos usando este formulário.

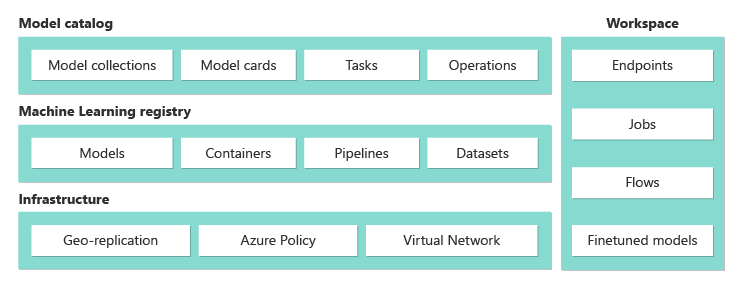

Visão geral dos recursos do Catálogo de Modelos

O catálogo de modelos no portal do Azure AI Foundry é o ponto central para descobrir e utilizar uma ampla gama de modelos para criar aplicativos de IA generativos. O catálogo de modelos apresenta centenas de modelos em provedores de modelo, como Azure OpenAI, Mistral, Meta, Cohere, NVIDIA e Hugging Face, incluindo modelos treinados pela Microsoft. Modelos de provedores diferentes da Microsoft são produtos não Microsoft, conforme definido nos Termos de Produto da Microsoft e estão sujeitos aos termos fornecidos com os modelos.

Você pode pesquisar e descobrir modelos que atendem às suas necessidades por meio de filtros e pesquisa de palavra-chave. O catálogo de modelos também oferece o quadro de classificação de desempenho dos modelos e as métricas de referência para modelos selecionados. Você pode acessá-los selecionando Navegar na tabela de classificação e Comparar modelos. Os dados de parâmetro de comparação também podem ser acessados na guia Parâmetro de comparação do cartão do modelo.

Nos filtros do catálogo de modelos, você encontrará:

- Coleção: você pode filtrar modelos com base na coleção de provedores de modelos.

- Setor: você pode filtrar os modelos treinados no conjunto de dados específico do setor.

- Funcionalidades: você pode filtrar recursos de modelo exclusivos, como raciocínio e chamada de ferramenta.

- Opções de implantação: você pode filtrar os modelos que dão suporte a opções de implantação específicas.

- Padrão: essa opção permite que você pague por chamada à API.

- Provisionado: mais adequado para pontuação em tempo real para um grande volume consistente.

- Lote: mais adequado para trabalhos em lotes com otimização de custo, não latência. Nenhum suporte de playground é fornecido para a implantação em lote.

- Computação gerenciada: essa opção permite implantar um modelo em uma máquina virtual do Azure. Você pagará pelas despesas de hospedagem e processamento de inferências.

- Tarefas de inferência: você pode filtrar modelos com base no tipo de tarefa de inferência.

- Tarefas de ajuste: você pode filtrar modelos com base no tipo de tarefa de ajuste.

- Licenças: você pode filtrar modelos com base no tipo de licença.

No cartão de modelo, você encontrará:

- Fatos rápidos: você verá as principais informações sobre o modelo rapidamente.

- Detalhes: esta página contém as informações detalhadas sobre o modelo, incluindo descrição, informações de versão, tipo de dados com suporte etc.

- Parâmetros de comparação: você encontrará métricas de parâmetro de comparação de desempenho para modelos selecionados.

- Implantações existentes: se você já implantou o modelo, poderá encontrá-lo na guia Implantações existentes.

- Licença: você encontrará informações legais relacionadas ao licenciamento do modelo.

- Artefatos: esta aba será exibida somente para modelos abertos. Você pode ver os ativos do modelo e baixá-los por meio da interface do usuário.

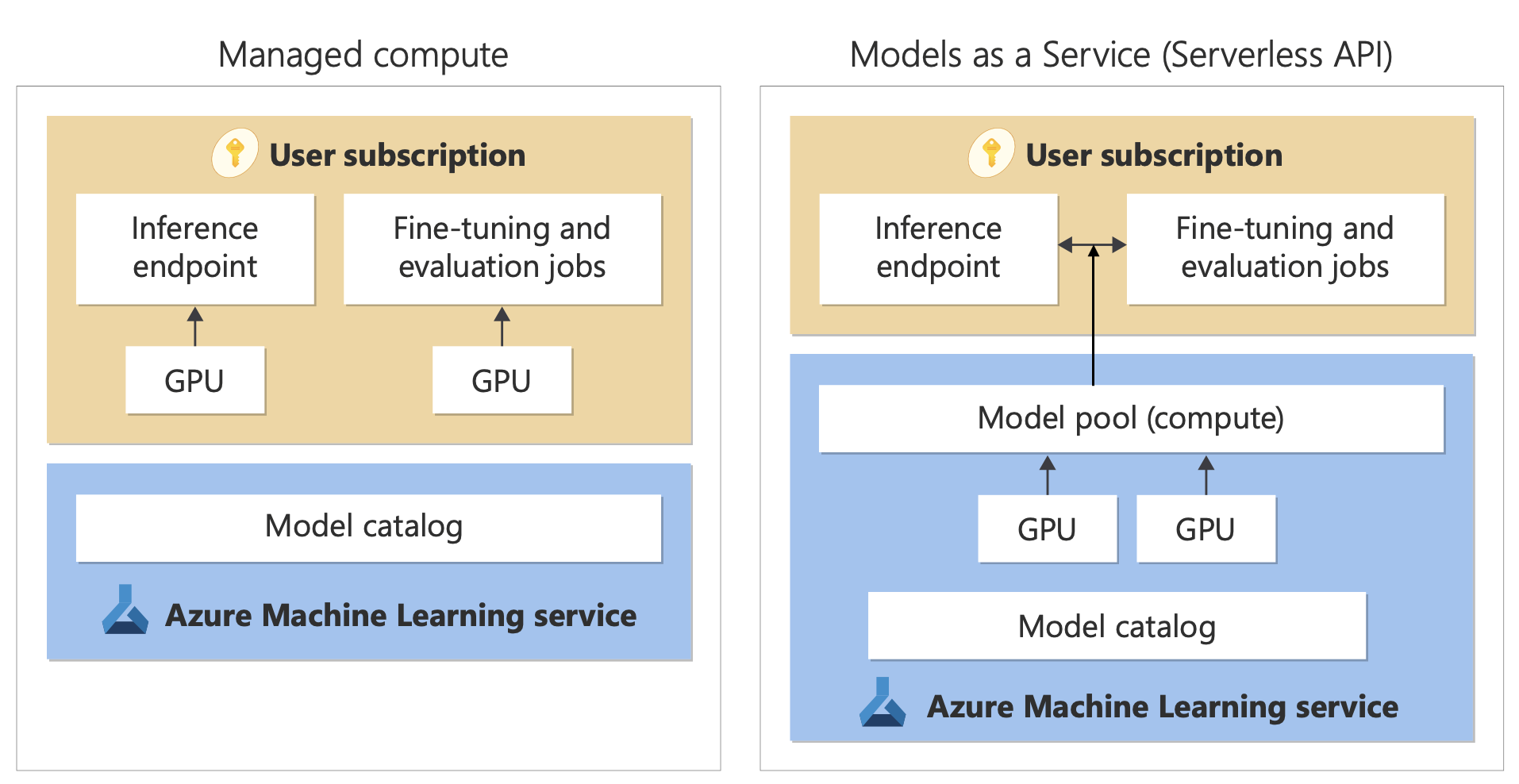

Implantação de modelo: computação gerenciada e implantações padrão

Além de implantar no Azure OpenAI, o catálogo de modelos oferece duas maneiras distintas de implantar modelos para seu uso: computação gerenciada e implantações padrão.

As opções de implantação e os recursos disponíveis para cada modelo variam, conforme descrito nas tabelas a seguir. Saiba mais sobre o processamento de dados com as opções de implantação.

Funcionalidades das opções de implantação de modelo

| Características | Computação gerenciada | Implantação padrão |

|---|---|---|

| Experiência de implantação e faturamento | Os pesos do modelo são implantados nas máquinas virtuais dedicadas com computação gerenciada. Uma computação gerenciada, que pode ter uma ou mais implantações, disponibiliza uma API REST para inferência. Você será cobrado pelas horas principais da máquina virtual usadas pelas implantações. | O acesso aos modelos é feito por meio de uma implantação que provisiona uma API para acessar o modelo. A API fornece acesso ao modelo hospedado e gerenciado pela Microsoft para inferência. Você será cobrado por entradas e saídas para as APIs, normalmente em tokens. As informações de preços são fornecidas antes da implantação. |

| Autenticação da API | Chaves e autenticação do Microsoft Entra. | Somente chaves. |

| Segurança de conteúdo | Utilize APIs do serviço Segurança de Conteúdo da IA do Azure. | Os filtros IA do Azure Content Safety estão disponíveis integrados com APIs de inferência. Os filtros da Segurança de Conteúdo da IA do Azure são cobrados separadamente. |

| Isolamento da rede | Configurar redes gerenciadas para hubs de IA do Azure Foundry. | A computação gerenciada segue a configuração do sinalizador de acesso à rede pública (PNA) do seu hub. Para obter mais informações, consulte o isolamento de rede para modelos implantados por meio da seção de implantações padrão mais adiante neste artigo. |

Modelos disponíveis para opções de implantação com suporte

Para modelos do Azure OpenAI, consulte Azure OpenAI.

Para exibir uma lista de modelos com suporte para implantação padrão ou Computação Gerenciada, acesse a home page do catálogo de modelos no Azure AI Foundry. Use o filtro de opções de implantação para selecionar a implantação Padrão ou a Computação Gerenciada.

Ciclo de vida do modelo: substituição e desativação

Os modelos de IA evoluem rapidamente e, quando uma nova versão ou um novo modelo com recursos atualizados na mesma família de modelos estiver disponível, os modelos mais antigos poderão ser desativados no catálogo de modelos do AI Foundry. Para permitir uma transição suave para uma versão de modelo mais recente, alguns modelos fornecem aos usuários a opção de habilitarem as atualizações automáticas. Para saber mais sobre o ciclo de vida de diferentes modelos, datas de aposentadoria de modelos futuros e modelos e versões de substituição sugeridos, consulte:

- Substituições e desativações de modelo do OpenAI do Azure

- Preterimentos e desativações do modelo de implantação padrão

Computação gerenciada

A capacidade de implantar modelos como computação gerenciada se baseia nos recursos de plataforma do Azure Machine Learning para permitir a integração perfeita da ampla coleção de modelos no catálogo de modelos em todo o ciclo de vida das operações de modelos de linguagem grandes (LLM).

Disponibilidade de modelos para implantação como computação gerenciada

Os modelos são disponibilizados por meio de registros do Azure Machine Learning. Esses registros permitem uma abordagem prioritária em machine learning para hospedagem e distribuição de ativos do Azure Machine Learning. Esses ativos incluem pesos do modelo, runtimes de contêiner para executar os modelos, pipelines para avaliar e ajustar os modelos, e conjuntos de dados para os parâmetros de comparação e exemplos.

Os registros se baseiam em uma infraestrutura altamente escalonável e pronta para a empresa que:

Fornece artefatos de modelo de acesso de baixa latência para todas as regiões do Azure com replicação geográfica integrada.

Dá suporte aos requisitos de segurança empresarial, como limitar o acesso a modelos usando o Azure Policy e a implantação segura com redes virtuais gerenciadas.

Implantação de modelos para a inferência com a computação gerenciada

Os modelos disponíveis para implantação no processamento gerenciado podem ser implantados no processamento gerenciado do Azure Machine Learning para inferência em tempo real. A implantação na computação gerenciada exige que você tenha uma cota de máquina virtual em sua assinatura do Azure para os produtos específicos que você precisa para executar o modelo de maneira ideal. Alguns modelos permitem implantar em cota compartilhada temporariamente para testar o modelo.

Saiba mais sobre como implantar modelos:

Crie aplicativos de IA generativa com a computação gerenciada

O recurso prompt flow no Azure Machine Learning oferece uma ótima experiência para protótipos. Você pode usar modelos implantados com computação gerenciada no fluxo de prompt com a Ferramenta Open Model LLM. Você também pode usar a API REST exposta pela computação gerenciada em ferramentas LLM populares como LangChain com a extensão Azure Machine Learning.

Segurança de conteúdo para modelos implantados como computação gerenciada

O serviço Segurança de Conteúdo de IA do Azure está disponível para uso com computação gerenciada filtrar várias categorias de conteúdo prejudicial, como conteúdo sexual, violência, ódio e automutilação. Você também pode usar o serviço para filtrar ameaças avançadas, como detecção de risco de jailbreak e detecção de texto de material protegido.

Você pode consultar este notebook como exemplo de integração com a Segurança de Conteúdo de IA do Azure para Llama 2. Ou você pode usar a ferramenta Segurança de Conteúdo (Texto) no fluxo de prompt para passar respostas do modelo para a Segurança de Conteúdo de IA do Azure para filtragem. Você é cobrado separadamente por esse uso, conforme descrito em preços de Segurança de Conteúdo de IA do Azure.

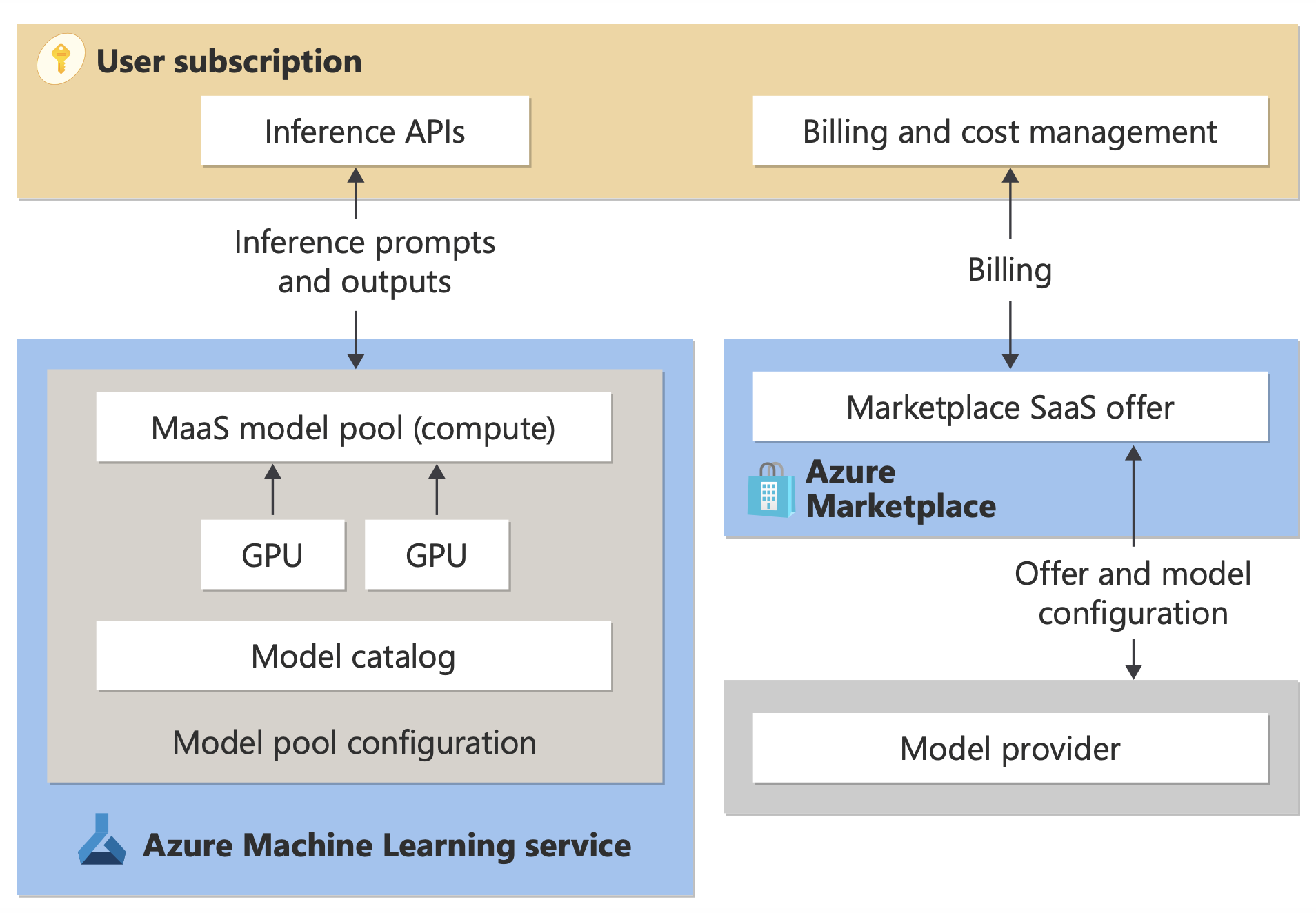

Cobrança de implantação padrão

Você pode implantar determinados modelos no catálogo de modelos com cobrança Standard. Esse método de implantação, também chamado de implantação padrão, fornece uma maneira de consumir os modelos como APIs sem hospedá-los em sua assinatura. Os modelos são hospedados na infraestrutura gerenciada pela Microsoft, o que permite o acesso baseado em API ao modelo do provedor de modelos. O acesso baseado em API pode reduzir drasticamente o custo de acesso a um modelo e simplificar a experiência de provisionamento.

Os modelos disponíveis para implantação como implantações padrão são oferecidos pelo provedor de modelos, mas são hospedados em uma infraestrutura do Azure gerenciada pela Microsoft e acessados por meio da API. Os provedores de modelo definem os termos de licença e definem o preço para o uso de seus modelos. O Serviço do Azure Machine Learning:

- Gerencia a infraestrutura de hospedagem.

- Disponibiliza as APIs de inferência.

- Atua como o processador de dados para prompts enviados e saída de conteúdo por modelos implantados pelo MaaS.

Saiba mais sobre processamento de dados para MaaS no artigo sobre privacidade de dados.

Observação

As assinaturas do CSP (Provedor de Soluções na Nuvem) não têm a capacidade de comprar modelos de implantação padrão.

Faturamento

A experiência de descoberta, assinatura e consumo para modelos implantados via MaaS está no portal de IA do Azure Foundry e no Estúdio do Azure Machine Learning. Os usuários aceitam termos de licença para uso dos modelos. As informações de preços para consumo são fornecidas durante a implantação.

Modelos de provedores que não são da Microsoft são cobrados por meio do Azure Marketplace, de acordo com o Termos de Uso do Marketplace Comercial da Microsoft.

Os modelos da Microsoft são cobrados por meio de medidores do Azure como Serviços de Consumo de Primeira Parte. Conforme descrito nos Termos do Produto, você compra Serviços de Consumo de Primeira Parte usando medidores do Azure, mas eles não estão sujeitos aos termos de serviço do Azure. O uso desses modelos está sujeito aos termos de licença fornecidos.

Modelos de ajuste fino

Determinados modelos também dão suporte ao ajuste fino. Para esses modelos, você pode aproveitar a computação gerenciada (versão prévia) ou o ajuste de implantações padrão para adaptar os modelos usando os dados fornecidos. Para obter mais informações, consulte a Visão geral de ajuste fino.

RAG com modelos implantados como implantações padrão

No portal de IA do Azure Foundry, você pode usar índices de vetor e RAG (geração aumentada de recuperação). Você pode usar modelos que podem ser implantados por meio de implantações padrão para gerar inserções e inferências com base em dados personalizados. Essas inserções e inferências podem gerar respostas específicas ao seu caso de uso. Para saber mais, confira Criar e consumir índices de vetor no portal de IA do Azure Foundry.

Disponibilidade regional de ofertas e modelos

A cobrança por token está disponível apenas para usuários cuja assinatura do Azure pertence a uma conta de cobrança em um país/região onde o provedor do modelo disponibilizou a oferta. Se a oferta estiver disponível na região relevante, o usuário precisará ter um recurso de projeto na região do Azure em que o modelo está disponível para implantação ou ajuste fino, conforme aplicável. Consulte a disponibilidade de região para modelos em implantações padrão | AZure AI Foundry para obter informações detalhadas.

Segurança de conteúdo para modelos implantados por meio de implantações padrão

Para modelos de linguagem implantados por meio da implantação padrão, a IA do Azure implementa uma configuração padrão de filtros de moderação de texto de Segurança de Conteúdo de IA do Azure que detectam conteúdo prejudicial, como ódio, automutilação, conteúdo sexual e violento. Para saber mais sobre filtragem de conteúdo, consulte Diretrizes e controles para Modelos Vendidos Diretamente pela Azure.

Dica

A filtragem de conteúdo não está disponível para determinados tipos de modelo implantados por meio de implantações padrão. Esses tipos de modelo incluem modelos de inserção e modelos de série temporal.

A filtragem de conteúdo ocorre de forma síncrona à medida que o serviço processa solicitações para gerar conteúdo. Você pode ser cobrado separadamente de acordo com os Preços de Segurança de Conteúdo de IA do Azure para tal uso. Você pode desativar a filtragem de conteúdo para endpoints serverless individuais das seguintes formas:

- No momento em que você implanta um modelo de linguagem pela primeira vez

- Posteriormente, ao selecionar a alternância de filtragem de conteúdo na página de detalhes da implantação

Suponha que você decida usar uma API diferente da API de Inferência de Modelo para trabalhar com um modelo implantado por meio de uma implantação padrão. Em tal situação, a filtragem de conteúdo não está habilitada, a menos que você a implemente separadamente usando a Segurança de Conteúdo de IA do Azure.

Para começar a usar a Segurança de Conteúdo de IA do Azure, confira Início Rápido: Analisar conteúdo de texto. Se você não usar a filtragem de conteúdo ao trabalhar com modelos implantados por padrão, você corre um risco maior de expor os usuários a conteúdo prejudicial.

Isolamento de rede para modelos implantados por meio de implantações padrão

Os pontos de extremidade dos modelos implantados como implantações padrão seguem a configuração do sinalizador de acesso à rede pública do hub da Fábrica de IA do Azure que contém o projeto no qual a implantação existe. Para ajudar a proteger sua implantação padrão, desabilite o sinalizador de acesso à rede pública no hub do Azure AI Foundry. Você pode ajudar a proteger a comunicação de entrada de um cliente até seu ponto de extremidade usando um ponto de extremidade privado para o hub.

Para definir o sinalizador de acesso à rede pública para o hub do Azure AI Foundry:

- Acesse o portal do Azure.

- Pesquise o grupo de recursos ao qual o hub pertence e selecione seu hub do Azure AI Foundry nos recursos listados para esse grupo de recursos.

- Na página de visão geral do hub, no painel esquerdo, vá para Configurações>Rede.

- Na aba Acesso público, você pode configurar as definições para o sinalizador de acesso à rede pública.

- Salve suas alterações. Suas alterações podem levar até cinco minutos para serem propagadas.

Limitações

Se você tiver um hub da Fábrica de IA do Azure com um ponto de extremidade privado criado antes de 11 de julho de 2024, as implantações padrão adicionadas a projetos neste hub não seguirão a configuração de rede do hub. Em vez disso, você precisa criar um novo ponto de extremidade privado para o hub e criar uma nova implantação padrão no projeto para que as novas implantações possam seguir a configuração de rede do hub.

Se você tiver um hub do Azure AI Foundry com implantações do MaaS criadas antes de 11 de julho de 2024 e habilitar um ponto de extremidade privado nesse hub, as implantações padrão existentes não seguirão a configuração de rede do hub. Para que as implantações padrão no hub sigam a configuração de rede do hub, você precisa criar as implantações novamente.

Atualmente, o suporte ao Azure OpenAI On Your Data não está disponível para implantações padrão em hubs privados, pois os hubs privados têm o sinalizador de acesso à rede pública desabilitado.

Qualquer alteração na configuração de rede (por exemplo, habilitar ou desabilitar o sinalizador de acesso à rede pública) pode levar até cinco minutos para ser propagada.