Início Rápido: Configurar o acompanhamento do corpo do Azure Kinect

Este guia de início rápido explicará o processo de como obter acompanhamento do corpo em execução no Azure Kinect DK.

Requisitos do sistema

O SDK de Acompanhamento do Corpo requer uma GPU NVIDIA instalada no computador host. O requisito do computador host de acompanhamento do corpo recomendado é descrito na página requisitos do sistema.

Instalar o software

Instalar o driver NVIDIA mais recente

Baixe e instale o driver NVIDIA mais recente para sua placa gráfica. Drivers mais antigos podem não ser compatíveis com os binários CUDA redistribuídos com o SDK de acompanhamento do corpo.

Pacotes Redistribuíveis do Visual C++ para Visual Studio 2015

Baixar e instalar os Pacotes Redistribuíveis do Visual C++ para Visual Studio 2015.

Configurar o hardware

Configurar o Azure Kinect DK

Inicie o Azure Kinect Viewer para verificar se o Azure Kinect DK está configurado corretamente.

Baixar o SDK de rastreamento de corpo

- Selecione o link para Baixar o SDK de acompanhamento do Corpo

- Instale o SDK de Acompanhamento do Corpo em seu computador.

Verificar o acompanhamento do corpo

Inicie o Visualizador de Acompanhamento do Corpo do Azure Kinect para verificar se o SDK do Acompanhamento do Corpo está configurado corretamente. O visualizador é instalado com o instalador MSI do SDK. Você pode encontrá-lo no menu iniciar ou em <SDK Installation Path>\tools\k4abt_simple_3d_viewer.exe.

Se você não tiver uma GPU suficientemente avançada e ainda quiser testar o resultado, poderá iniciar o Visualizador de Acompanhamento do Corpo do Azure Kinect na linha de comando por meio do seguinte comando: <SDK Installation Path>\tools\k4abt_simple_3d_viewer.exe CPU

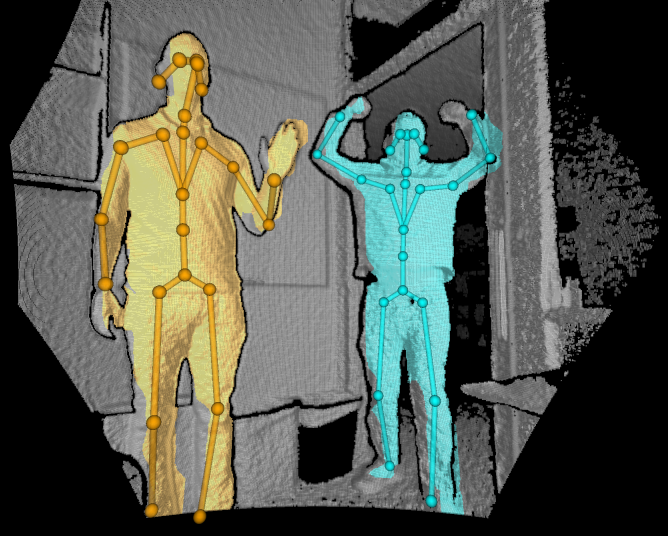

Se tudo estiver configurado corretamente, será exibida uma janela com uma nuvem de ponto 3D e corpos rastreados.

Como especificar o ambiente de execução do ONNX Runtime

O SDK de Acompanhamento de Corpo dá suporte a ambientes de execução da CPU, do CUDA, do DirectML (somente Windows) e do TensorRT para inferência do modelo de estimativa de pose. Por padrão, o K4ABT_TRACKER_PROCESSING_MODE_GPU usa a execução do CUDA no Linux e a execução do DirectML no Windows. Três outros modos foram adicionados para selecionar ambientes de execução específicos: K4ABT_TRACKER_PROCESSING_MODE_GPU_CUDA, K4ABT_TRACKER_PROCESSING_MODE_GPU_DIRECTML e K4ABT_TRACKER_PROCESSING_MODE_GPU_TENSORRT.

Observação

O ONNX Runtime exibe avisos para opcodes que não são acelerados. Eles podem ser ignorados com segurança.

O ONNX Runtime inclui variáveis de ambiente para controlar o cache de modelo do TensorRT. Os valores recomendados são:

- ORT_TENSORRT_ENGINE_CACHE_ENABLE=1

- ORT_TENSORRT_CACHE_PATH="pathname"

A pasta precisa ser criada antes da inicialização do acompanhamento de corpo.

Importante

O TensorRT processa previamente o modelo antes da inferência, resultando em tempos de inicialização estendidos quando comparado a outros ambientes de execução. O cache de mecanismo limita isso à primeira execução, mas é experimental e é específico do modelo, da versão do ONNX Runtime, da versão do TensorRT e do modelo de GPU.

O ambiente de execução do TensorRT dá suporte a FP32 (padrão) e FP16. O FP16 troca o aumento de desempenho de aproximadamente 2x pela diminuição mínima da precisão. Para especificar o FP16:

- ORT_TENSORRT_FP16_ENABLE=1

DLLs necessárias para ambientes de execução do ONNX Runtime

| Mode | ORT 1.10 | CUDA 11.4.3 | CUDNN 8.2.2.26 | TensorRT 8.0.3.4 |

|---|---|---|---|---|

| CPU | msvcp140 | - | - | - |

| onnxruntime | ||||

| CUDA | msvcp140 | cudart64_110 | cudnn64_8 | - |

| onnxruntime | cufft64_10 | cudnn_ops_infer64_8 | ||

| onnxruntime_providers_cuda | cublas64_11 | cudnn_cnn_infer64_8 | ||

| onnxruntime_providers_shared | cublasLt64_11 | |||

| DirectML | msvcp140 | - | - | - |

| onnxruntime | ||||

| directml | ||||

| TensorRT | msvcp140 | cudart64_110 | - | nvinfer |

| onnxruntime | cufft64_10 | nvinfer_plugin | ||

| onnxruntime_providers_cuda | cublas64_11 | |||

| onnxruntime_providers_shared | cublasLt64_11 | |||

| onnxruntime_providers_tensorrt | nvrtc64_112_0 | |||

| nvrtc-builtins64_114 |

Exemplos

É possível encontrar os exemplos sobre como usar o SDK de acompanhamento do corpo aqui.