Observação

O acesso a essa página exige autorização. Você pode tentar entrar ou alterar diretórios.

O acesso a essa página exige autorização. Você pode tentar alterar os diretórios.

Importante

O suporte para o Machine Learning Studio (clássico) terminará em 31 de agosto de 2024. É recomendável fazer a transição para o Azure Machine Learning até essa data.

A partir de 1º de dezembro de 2021, você não poderá criar recursos do Machine Learning Studio (clássico). Até 31 de agosto de 2024, você pode continuar usando os recursos existentes do Machine Learning Studio (clássico).

- Confira informações sobre como mover projetos de machine learning do ML Studio (clássico) para o Azure Machine Learning.

- Saiba mais sobre o Azure Machine Learning.

A documentação do ML Studio (clássico) está sendo desativada e pode não ser atualizada no futuro.

Este artigo descreve os módulos no Machine Learning Studio (clássico) que você pode usar para avaliar um modelo de machine learning. A avaliação do modelo é realizada após a conclusão do treinamento, para medir a precisão das previsões e avaliar o ajuste do modelo.

Observação

Aplica-se a: somente Machine Learning Studio (clássico)

Módulos semelhantes do tipo "arrastar e soltar" estão disponíveis no designer do Azure Machine Learning.

Este artigo também descreve o processo geral no Machine Learning Studio (clássico) para criação, treinamento, avaliação e pontuação de modelo.

Criar e usar modelos de machine learning no Machine Learning Studio (clássico)

O fluxo de trabalho típico para machine learning inclui estas fases:

- Escolha um algoritmo adequado e defina as opções iniciais.

- Treine o modelo usando dados compatíveis.

- Crie previsões usando novos dados baseados nos padrões do modelo.

- Avalie o modelo para determinar se as previsões são precisas, a quantidade de erro e se ocorre uma sobreajuste.

Machine Learning Studio (clássico) dá suporte a uma estrutura flexível e personalizável para machine learning. Cada tarefa nesse processo é executada por um tipo específico de módulo. O módulo pode ser modificado, adicionado ou removido sem interromper o restante do experimento.

Use os módulos nessa categoria para avaliar um modelo existente. A avaliação de modelo normalmente requer algum tipo de conjunto de dados de resultados. Se você não tiver um conjunto de dados de avaliação, poderá gerar resultados pontuando. Você também pode usar um conjunto de dados de teste ou algum outro conjunto de dados que contenha "verdade de base" ou resultados esperados conhecidos.

Mais sobre avaliação de modelo

Em geral, ao avaliar um modelo, suas opções dependem do tipo de modelo que você está avaliando e da métrica que você deseja usar. Estes tópicos listam algumas das métricas mais usadas:

Machine Learning Studio (clássico) também fornece uma variedade de visualizações, dependendo do tipo de modelo que você está usando e quantas classes seu modelo está prevendo. Para obter ajuda para encontrar essas visualizações, consulte Exibir métricas de avaliação.

Interpretar essas estatísticas geralmente requer uma maior compreensão do algoritmo específico no qual o modelo foi treinado. Para obter uma boa explicação de como avaliar um modelo e como interpretar os valores retornados para cada medida, consulte Como avaliar o desempenho do modelo em Machine Learning.

Lista de módulos

A categoria Machine Learning – Avaliar inclui os seguintes módulos:

Modelo de validação cruzada: valida as estimativas de parâmetro para modelos de classificação ou regressão particionando os dados.

Use o módulo Modelo de Validação Cruzada se quiser testar a validade do conjunto de treinamento e do modelo. A validação cruzada particiona os dados em dobras e testa vários modelos em combinações de dobras.

Avaliar Modelo: avalia um modelo de classificação ou regressão pontuado usando métricas padrão.

Na maioria dos casos, você usará o módulo modelo de avaliação genérico. Isso é especialmente verdadeiro se o modelo for baseado em um dos algoritmos de classificação ou regressão com suporte.

Avaliar Recomendador: avalia a precisão das previsões do modelo recomendador.

Para modelos de recomendação, use o módulo Avaliar Recomendador .

Tarefas relacionadas

- Para modelos de clustering, use o módulo Atribuir Dados a Clusters . Em seguida, use as visualizações nesse módulo para ver os resultados da avaliação.

- Você pode criar métricas de avaliação personalizadas. Para criar métricas de avaliação personalizadas, forneça código R no módulo Executar Script R ou código Python no módulo Executar Script Python . Essa opção é útil se você quiser usar métricas que foram publicadas como parte de bibliotecas de software livre ou se quiser projetar sua própria métrica para medir a precisão do modelo.

Exemplos

Interpretar os resultados da avaliação do modelo de machine learning é uma arte. Ele requer a compreensão dos resultados matemáticos, além dos dados e dos problemas de negócios. Recomendamos que você examine estes artigos para obter uma explicação de como interpretar resultados em cenários diferentes:

- Escolha parâmetros para otimizar seus algoritmos em Machine Learning

- Interpretar os resultados do modelo em Machine Learning

- Avaliar o desempenho do modelo em Machine Learning

Observações técnicas

Esta seção contém detalhes de implementação, dicas e respostas para perguntas frequentes.

Exibir métricas de avaliação

Saiba onde procurar no Machine Learning Studio (clássico) para localizar os gráficos de métrica para cada tipo de modelo.

Modelos de classificação de duas classes

A exibição padrão para modelos de classificação binária inclui um gráfico ROC interativo e uma tabela de valores para as métricas principais.

Você tem duas opções para exibir modelos de classificação binária:

- Clique com o botão direito do mouse na saída do módulo e selecione Visualizar.

- Clique com o botão direito do mouse no módulo, selecione Resultados da avaliação e selecione Visualizar.

Você também pode usar o controle deslizante para alterar o valor limite de probabilidade. O limite determina se um resultado deve ser aceito como verdadeiro ou não. Em seguida, você pode ver como esses valores são alterados.

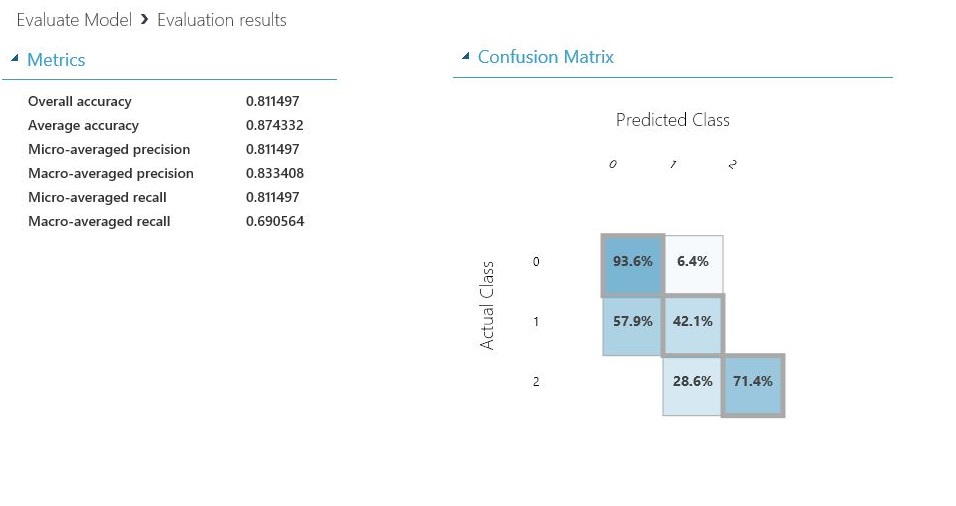

Modelos de classificação multiclasse

A exibição de métricas padrão para modelos de classificação de várias classes inclui uma matriz de confusão para todas as classes e um conjunto de métricas para o modelo como um todo.

Você tem duas opções para exibir modelos de classificação de várias classes:

- Clique com o botão direito do mouse na saída do módulo e selecione Visualizar.

- Clique com o botão direito do mouse no módulo, selecione Resultados da avaliação e selecione Visualizar.

Para simplificar, aqui estão os dois resultados, mostrados lado a lado:

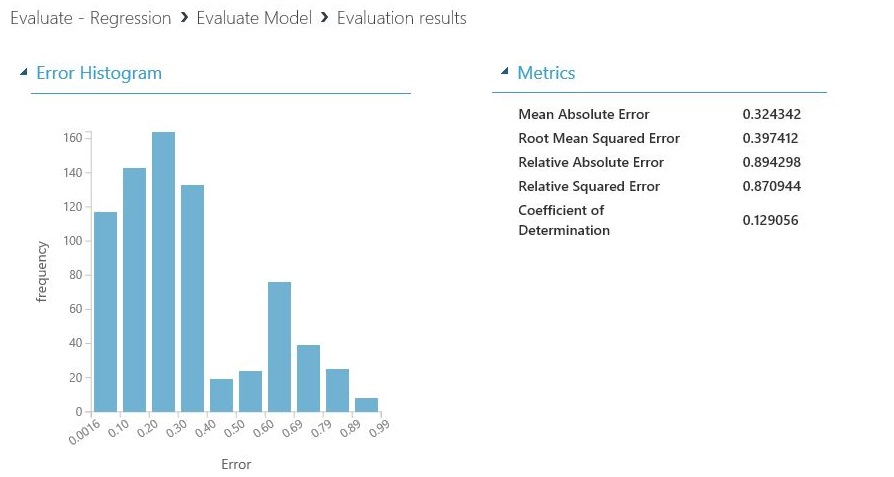

Modelos de regressão

A exibição de métricas para modelos de regressão varia dependendo do tipo de modelo que você criou. A exibição de métricas baseia-se nas interfaces de algoritmo subjacentes e no melhor ajuste para as métricas do modelo.

Você tem duas opções para exibir modelos de regressão:

- Para exibir as métricas de precisão em uma tabela, clique com o botão direito do mouse na saída do módulo Avaliar Modelo e selecione Visualizar.

- Para exibir um histograma de erro com os valores, clique com o botão direito do mouse no módulo, selecione Resultados de avaliação e selecione Visualizar.

A exibição de Histograma de Erro pode ajudá-lo a entender como o erro é distribuído. Ele é fornecido para os tipos de modelo a seguir e inclui uma tabela de métricas padrão, como RMSE (erro quadrado médio raiz).

Os seguintes modelos de regressão geram uma tabela de métricas padrão, juntamente com algumas métricas personalizadas:

- Regressão linear Bayesiana

- Regressão de Floresta de Decisão

- Regressão rápida de quantil de floresta

- Regressão ordinal

Dicas para trabalhar com os dados

Para extrair os números sem copiar e colar da interface do usuário do Machine Learning Studio (clássico), você pode usar a nova biblioteca do PowerShell para Machine Learning. Você pode obter metadados e outras informações para um experimento inteiro ou de módulos individuais.

Para extrair valores de um módulo Avaliar Modelo , você deve adicionar um comentário exclusivo ao módulo para facilitar a identificação. Em seguida, use o cmdlet Download-AmlExperimentNodeOutput para obter as métricas e seus valores da visualização no formato JSON.

Para obter mais informações, consulte Criar modelos de machine learning usando o PowerShell.