Conectores Power Query (versão prévia – desativado)

Importante

O suporte ao conector Power Query foi introduzido como uma visualização pública restrita em Termos de Uso complementares para visualizações do Microsoft Azure, mas agora está descontinuado. Se você tiver uma solução de pesquisa que usa um conector Power Query, migre para uma solução alternativa.

Migrar até 28 de novembro de 2022

A versão prévia do conector Power Query foi anunciada em maio de 2021 e não avançará para a disponibilidade geral. As diretrizes de migração a seguir estão disponíveis para Snowflake e PostgreSQL. Se você estiver usando um conector diferente e precisar de instruções de migração, use as informações de contato por email fornecidas em sua versão prévia para solicitar ajuda ou abrir um tíquete com o Suporte do Azure.

Pré-requisitos

- Uma conta de armazenamento do Azure. Se você não possuir uma, crie uma conta de armazenamento.

- Azure Data Factory. Se você não tiver um, crie um Data Factory. Consulte os Preços do Pipeline do Data Factory antes da implementação para entender os custos associados. Consulte também os preços do Data Factory por meio de exemplos.

Migrar um pipeline de dados do Snowflake

Esta seção explica como copiar dados de um banco de dados Snowflake para um índice do Azure Cognitive Search. Não há processo para indexação direta do Snowflake para Azure Cognitive Search, portanto, esta seção inclui uma fase de preparo que copia o conteúdo do banco de dados para um contêiner de blob do Armazenamento do Azure. Em seguida, você indexará desse contêiner de preparo usando um pipeline do Data Factory.

Etapa 1: recuperar informações do banco de dados Snowflake

Vá para o Snowflake e entre na sua conta. Uma conta Snowflake se parece com https://< account_name.snowflakecomputing.com>.

Depois de entrar, colete as informações a seguir do painel esquerdo. Você precisará dessas informações na próxima etapa:

- Em Dados, selecione Bancos de Dados e copie o nome da fonte de banco de dados.

- Em Administração, selecione Usuários & Funções e copie o nome do usuário. Verifique se o usuário tem permissões de leitura.

- Em Administração, selecione Contas e copie o valor LOCATOR da conta.

- Da URL do Snowflake, semelhante a

https://app.snowflake.com/<region_name>/xy12345/organization). copie o nome da região. Por exemplo, emhttps://app.snowflake.com/south-central-us.azure/xy12345/organization, o nome da região ésouth-central-us.azure. - Em Administração, selecione Warehouses e copie o nome do warehouse associado ao banco de dados que você usará como origem.

Etapa 2: configurar o Serviço Vinculado Snowflake

Entre no Azure Data Factory Studio com sua conta do Azure.

Selecione o data factory e, em seguida, Continuar.

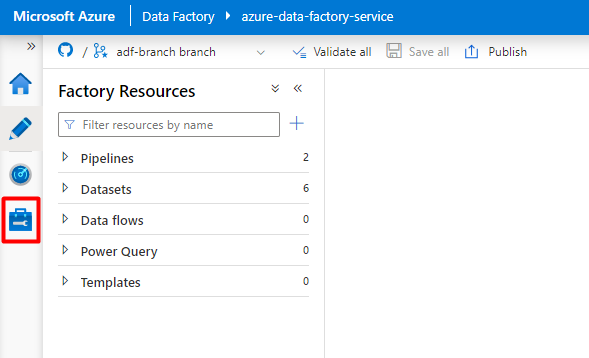

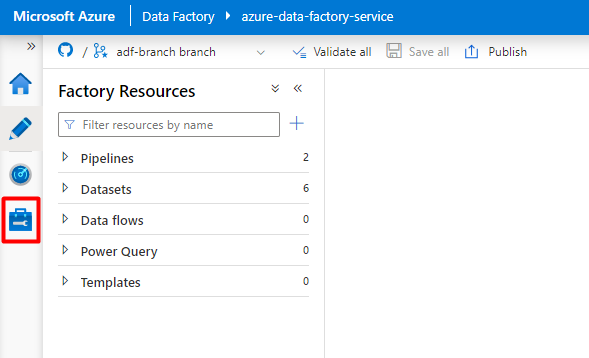

No menu à esquerda, selecione o ícone Gerenciar.

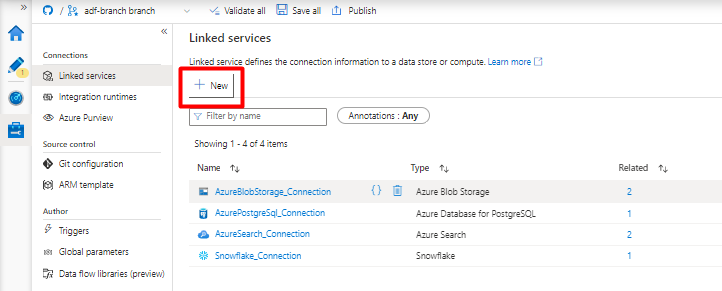

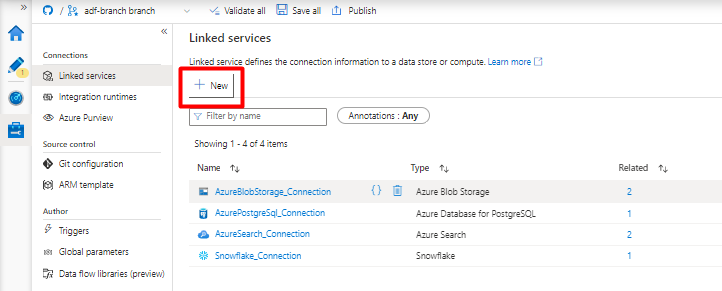

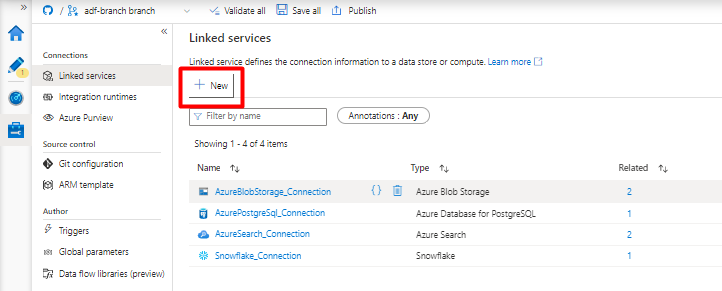

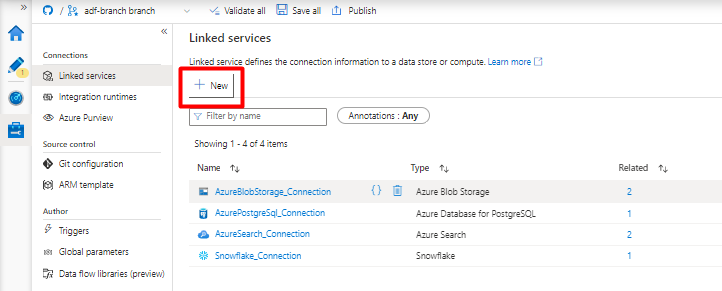

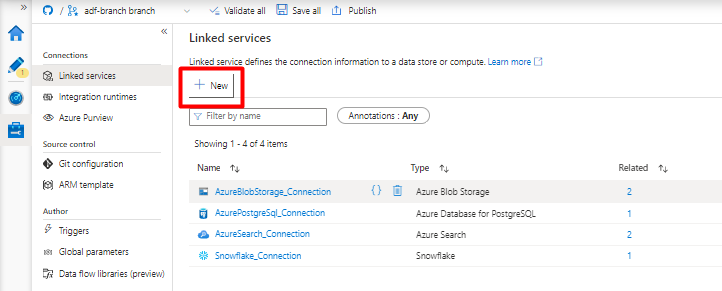

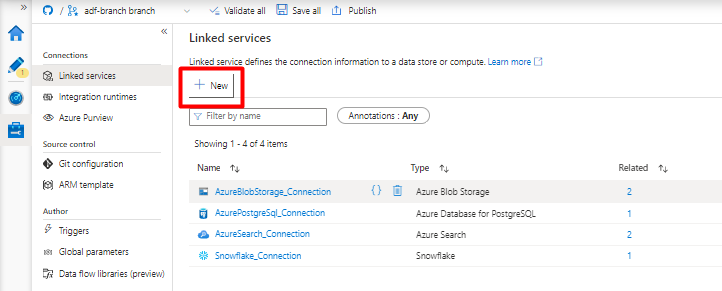

Em Serviços vinculados, selecione Novo.

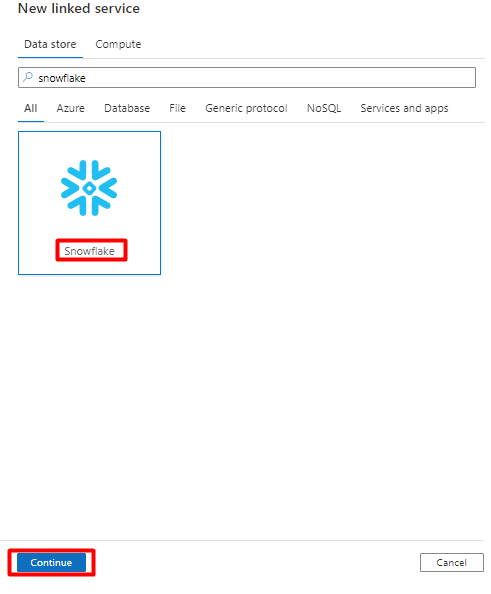

No painel direito, na pesquisa do armazenamento de dados, insira "snowflake". Selecione o bloco Snowflake e, em seguida, Continuar.

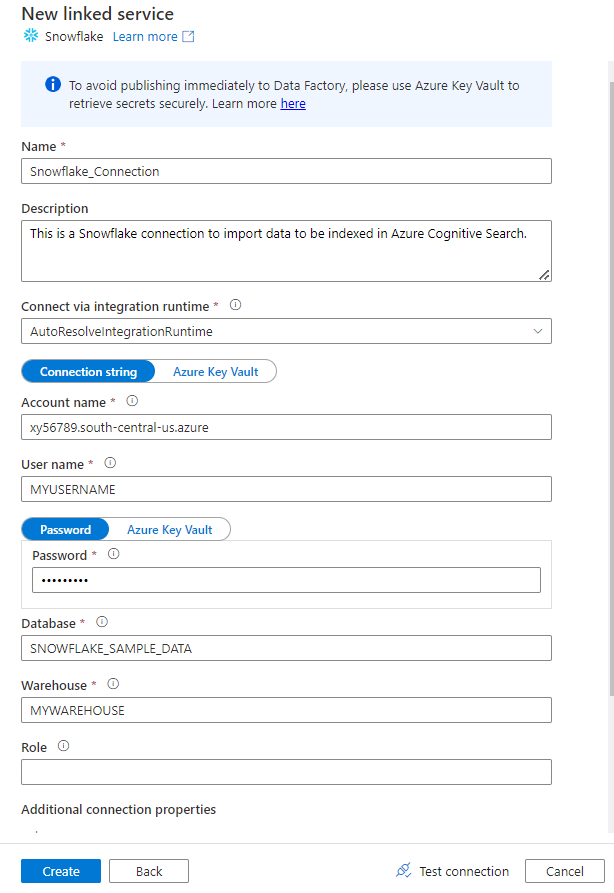

Preencha o novo formulário de serviço vinculado com os dados coletados na etapa anterior. O nome da conta inclui um valor LOCATOR e a região (por exemplo:

xy56789south-central-us.azure).

Depois que o formulário for concluído, selecione Testar conexão.

Se o teste for bem-sucedido, selecione Criar.

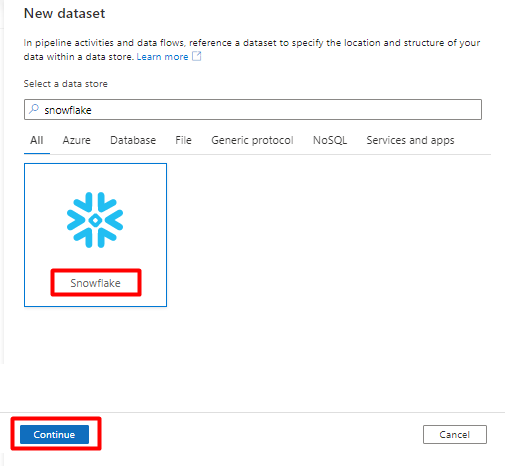

Etapa 3: configurar o conjunto de dados Snowflake

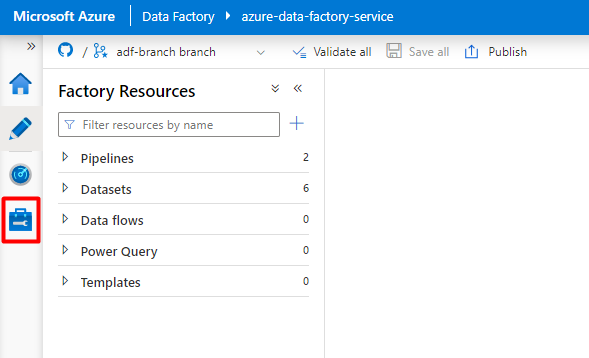

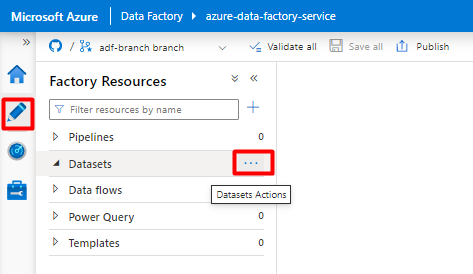

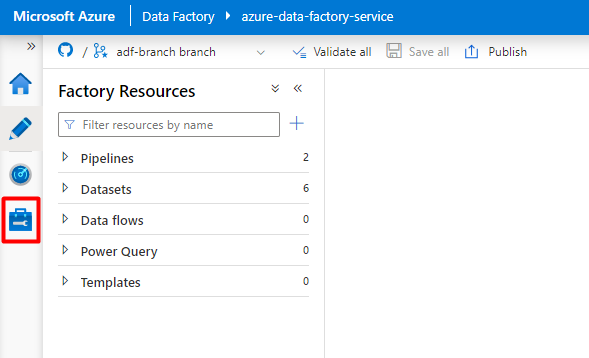

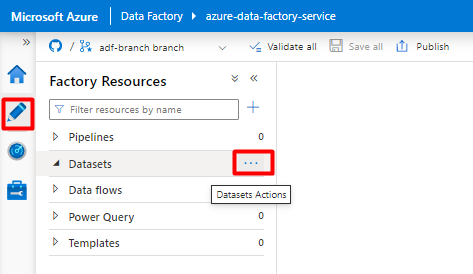

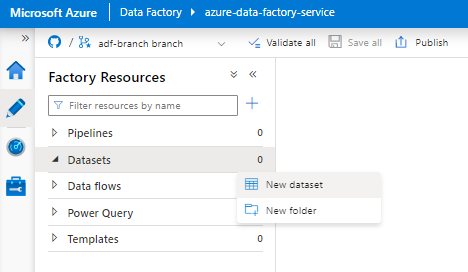

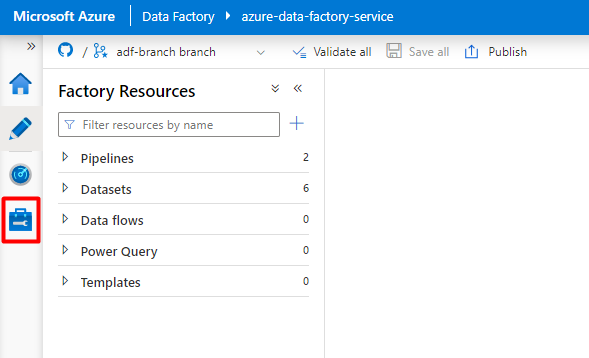

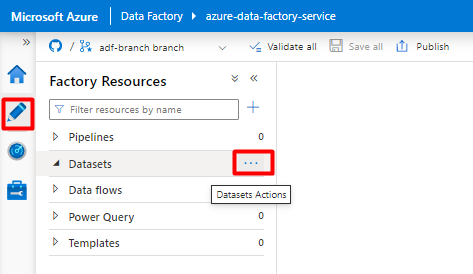

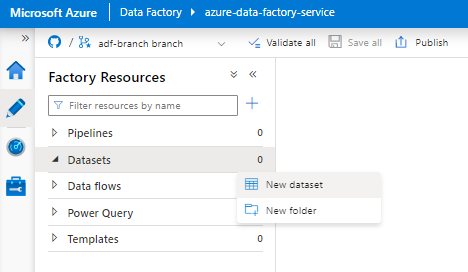

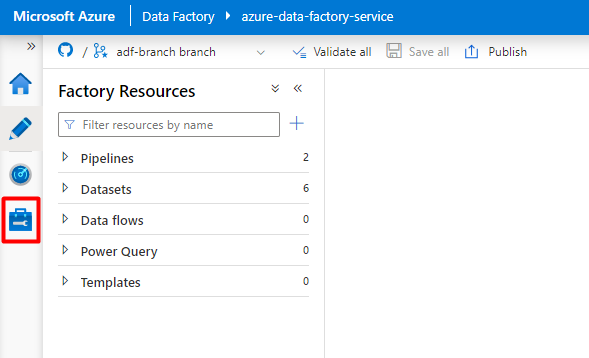

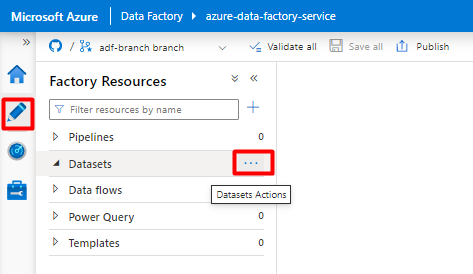

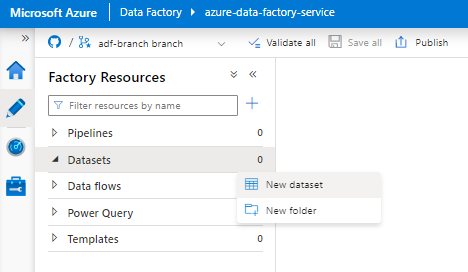

No menu à esquerda, selecione o ícone Autor.

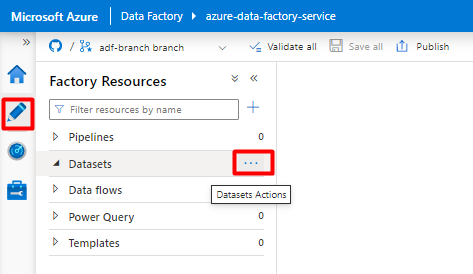

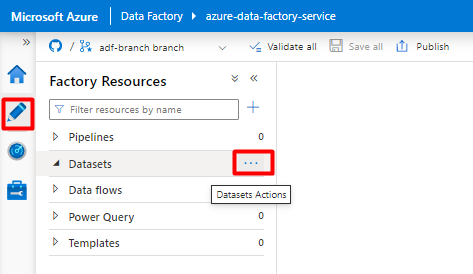

Selecione conjuntos de dados e, em seguida, selecione o menu de reticências Ações de Conjuntos de Dados (

...).

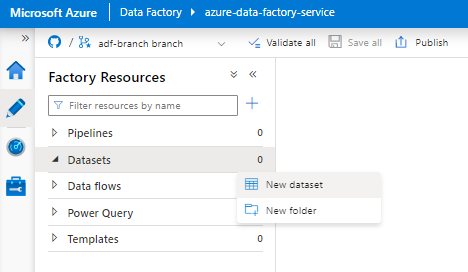

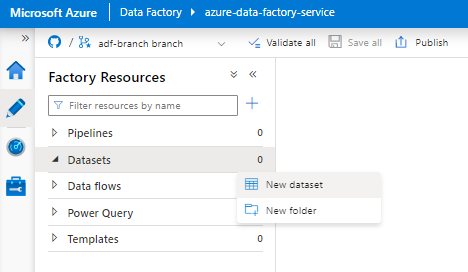

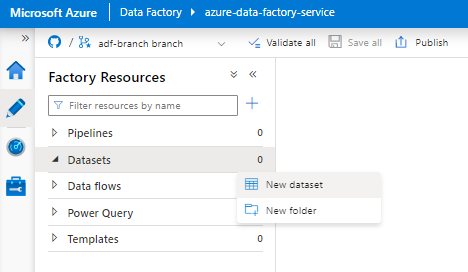

SelecioneNovo conjunto de dados.

No painel direito, na pesquisa do armazenamento de dados, insira "snowflake". Selecione o bloco Snowflake e, em seguida, Continuar.

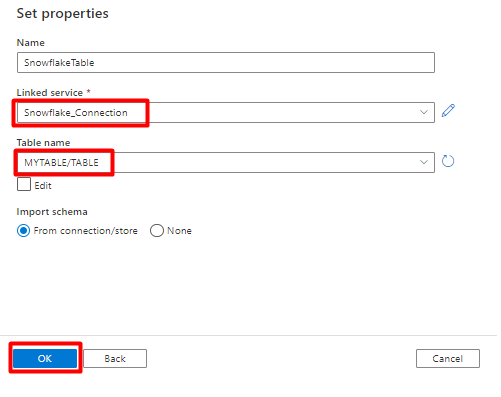

Em Definir Propriedades:

- Selecione o Serviço Vinculado criado na Etapa 2.

- Selecione a tabela que você deseja importar e selecione OK.

Selecione Save.

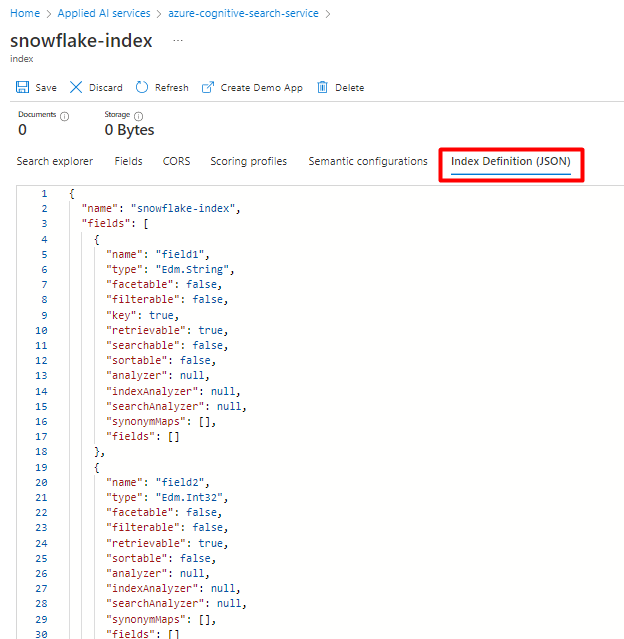

Etapa 4: criar um novo índice no Azure Cognitive Search

Crie um novo índice em seu serviço de Azure Cognitive Search com o mesmo esquema que o configurado atualmente para seus dados do Snowflake.

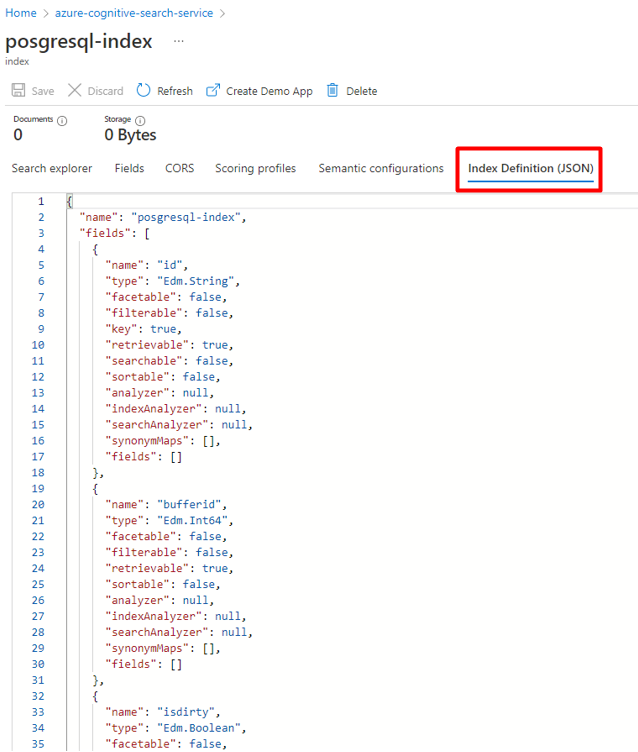

Você pode redefinir o índice que está usando no momento para o Snowflake Power Connector. No portal do Azure, localize o índice e, em seguida, selecione Definição de Índice (JSON). Selecione a definição e copie no corpo da nova solicitação de índice.

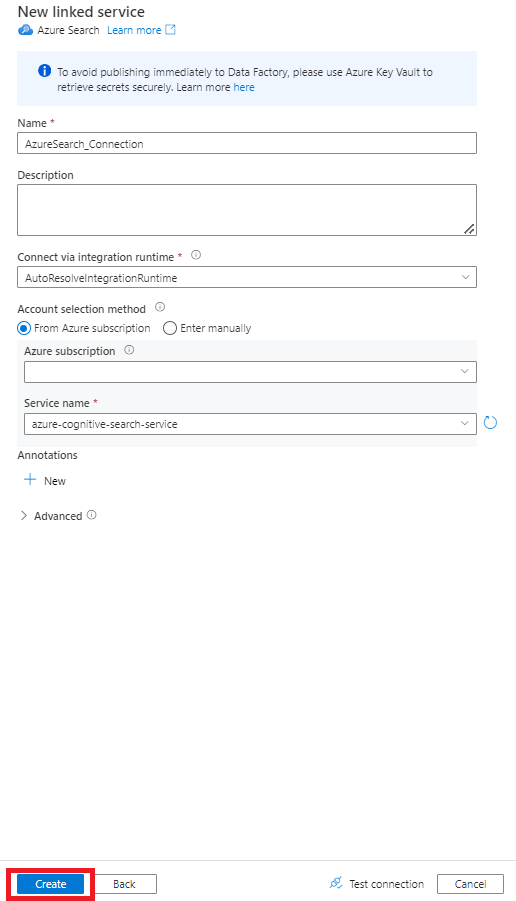

Etapa 5: configurar o Serviço Vinculado do Azure Cognitive Search

No menu à esquerda, selecione o ícone Gerenciar.

Em Serviços vinculados, selecione Novo.

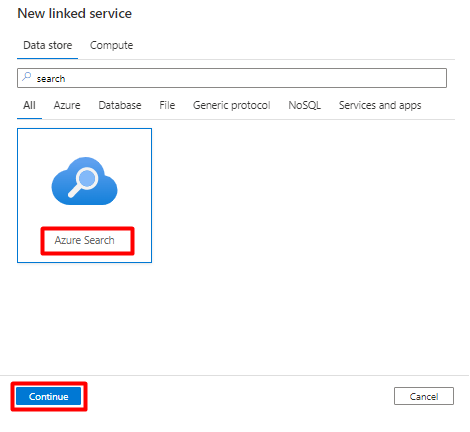

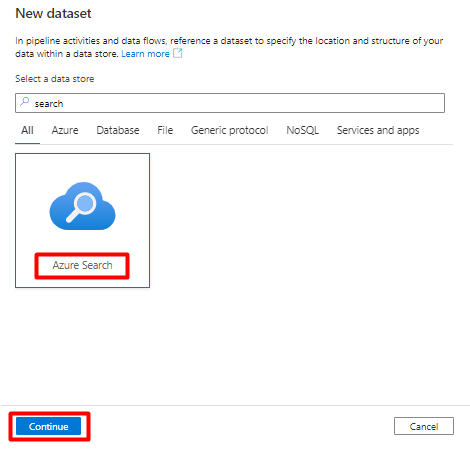

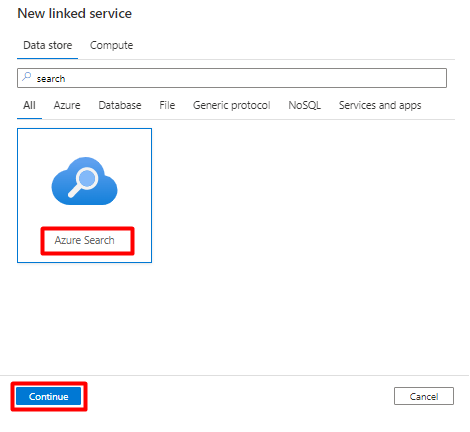

No painel direito, na pesquisa do armazenamento de dados, insira "pesquisar". Selecione o bloco do Azure Search e, em seguida, Continuar.

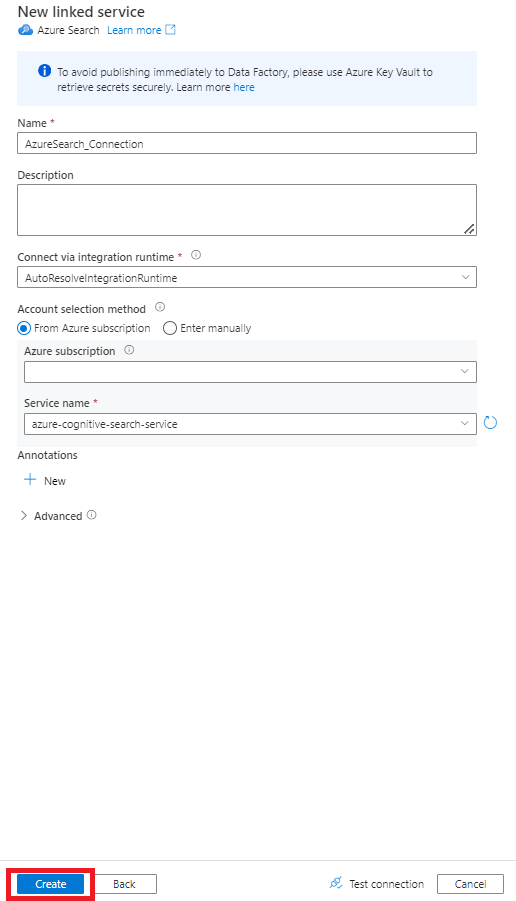

Preencha os novos valores de serviço vinculados:

- Escolha a assinatura do Azure em que está localizado o serviço do Azure Cognitive Search.

- Escolha o serviço do Azure Cognitive Search que tem o indexador do conector Power Query.

- Selecione Criar.

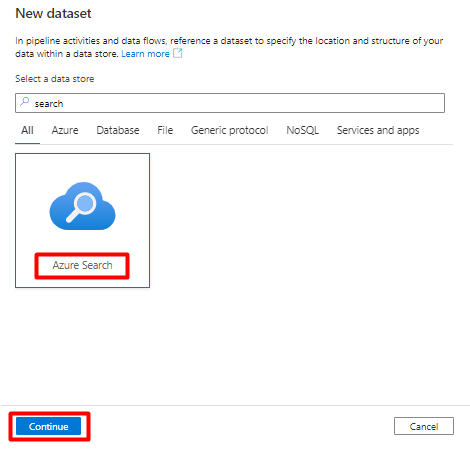

Etapa 6: configurar o Conjunto de Dados do Azure Cognitive Search

No menu à esquerda, selecione o ícone Autor.

Selecione conjuntos de dados e, em seguida, selecione o menu de reticências Ações de Conjuntos de Dados (

...).

SelecioneNovo conjunto de dados.

No painel direito, na pesquisa do armazenamento de dados, insira "pesquisar". Selecione o bloco do Azure Search e, em seguida, Continuar.

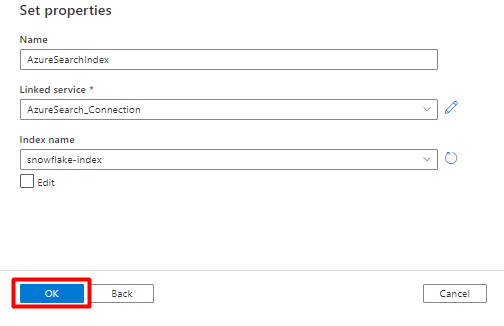

Em Definir Propriedades:

Selecione Save.

Etapa 7: configurar o Serviço Vinculado do Armazenamento de Blobs do Azure

No menu à esquerda, selecione o ícone Gerenciar.

Em Serviços vinculados, selecione Novo.

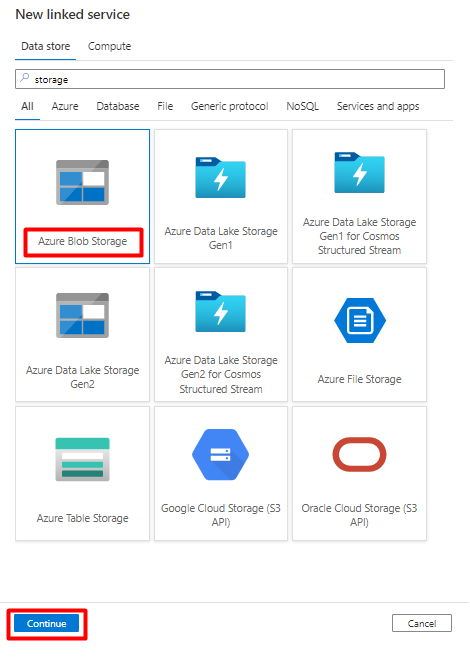

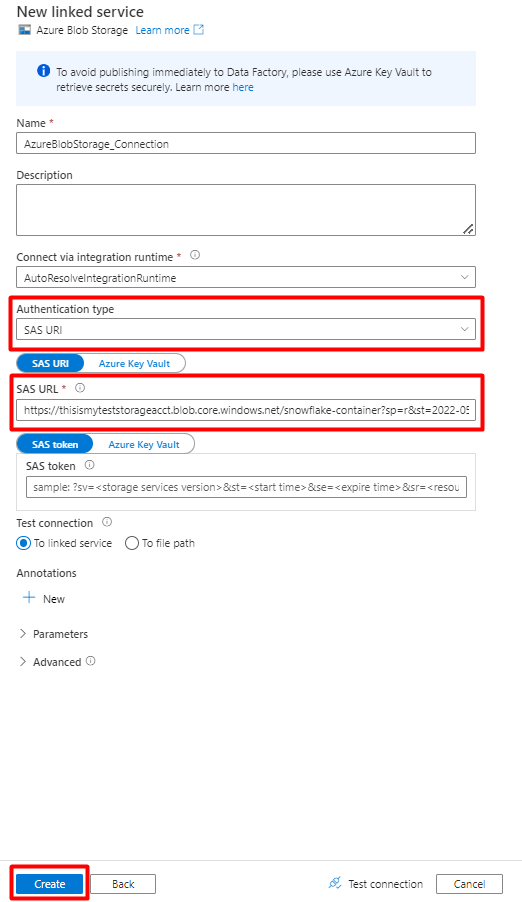

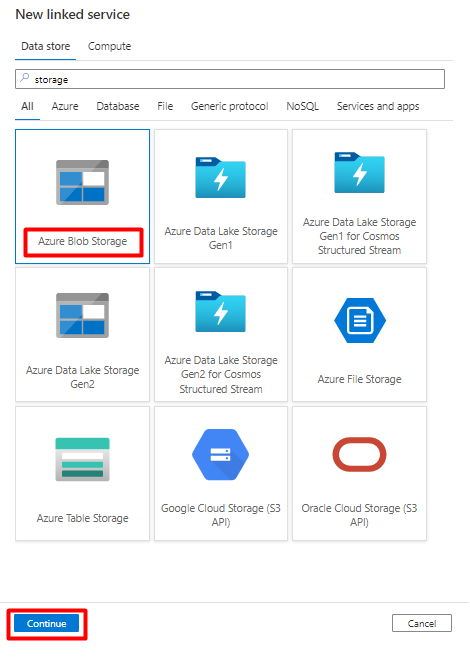

No painel direito, na pesquisa do armazenamento de dados, insira "armazenar". Selecione o bloco do Armazenamento de Blobs do Azure e, em seguida, Continuar.

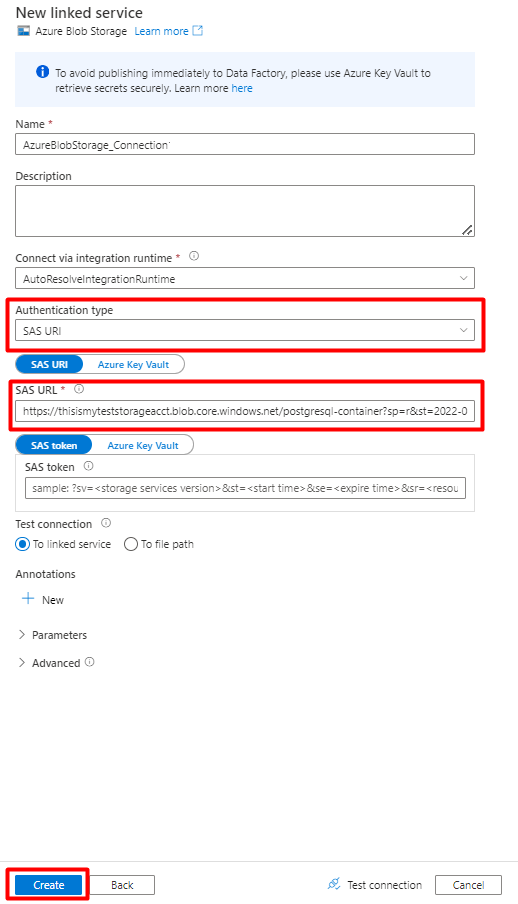

Preencha os novos valores de serviço vinculados:

Escolha o tipo de Autenticação: URI SAS. Somente esse tipo de autenticação pode ser usado para importar dados do Snowflake para Armazenamento de Blobs do Azure.

Gere uma URL SAS para a conta de armazenamento que você usará para preparo. Cole a URL SAS do Blob no campo URL SAS.

Selecione Criar.

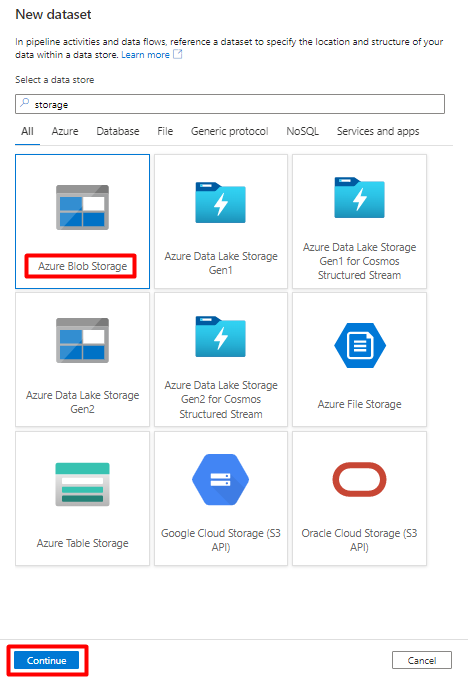

Etapa 8: configurar o conjunto de dados de armazenamento

No menu à esquerda, selecione o ícone Autor.

Selecione conjuntos de dados e, em seguida, selecione o menu de reticências Ações de Conjuntos de Dados (

...).

SelecioneNovo conjunto de dados.

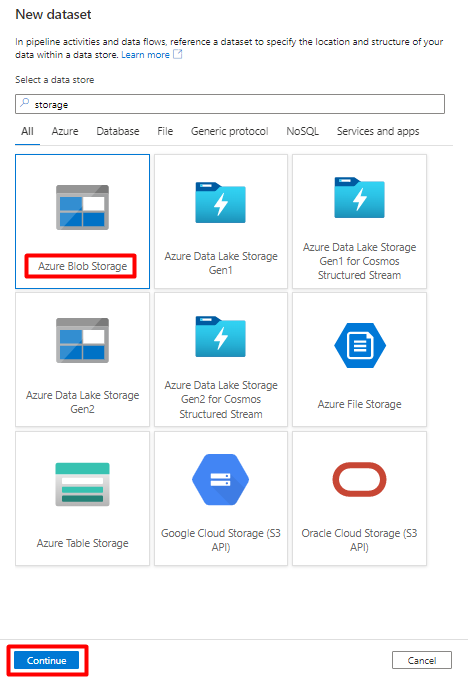

No painel direito, na pesquisa do armazenamento de dados, insira "armazenar". Selecione o bloco do Armazenamento de Blobs do Azure e, em seguida, Continuar.

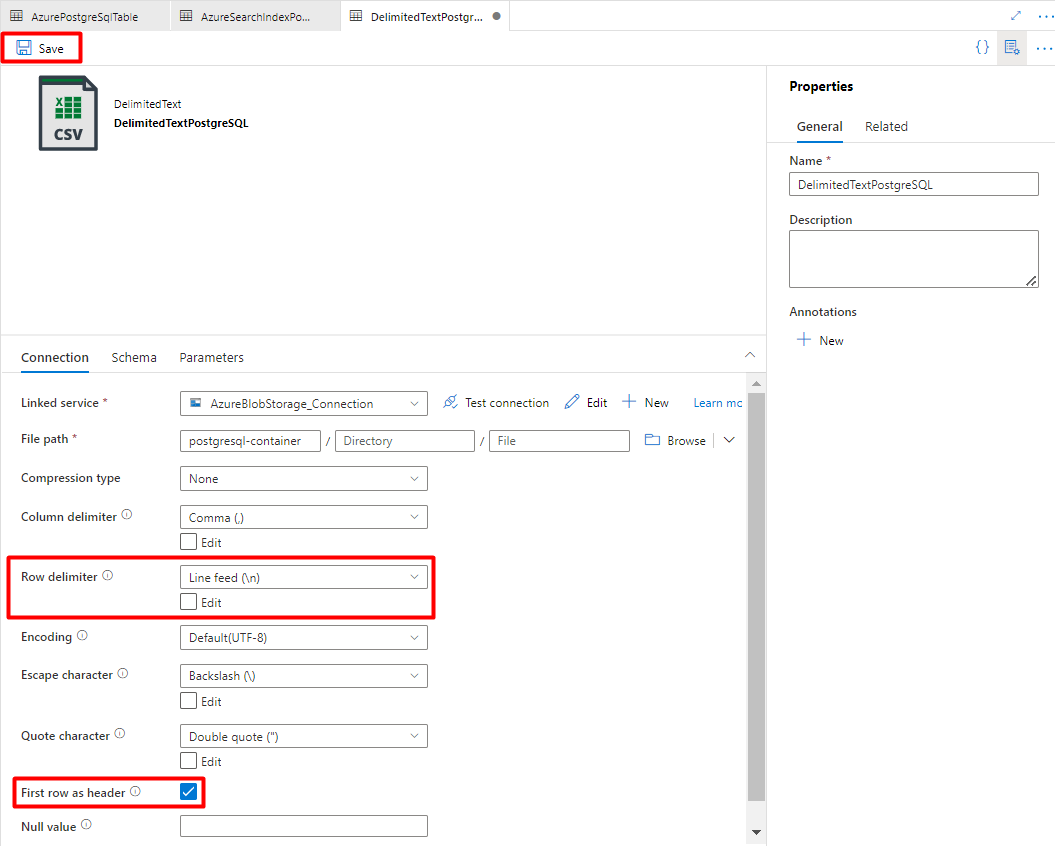

Selecione DelimitedText como formato e, em seguida, Continuar.

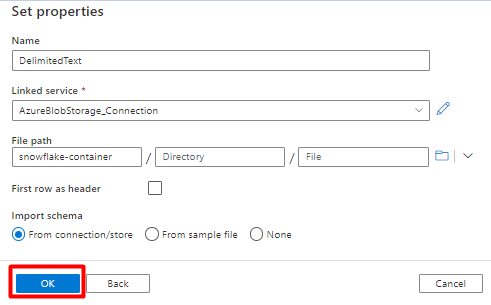

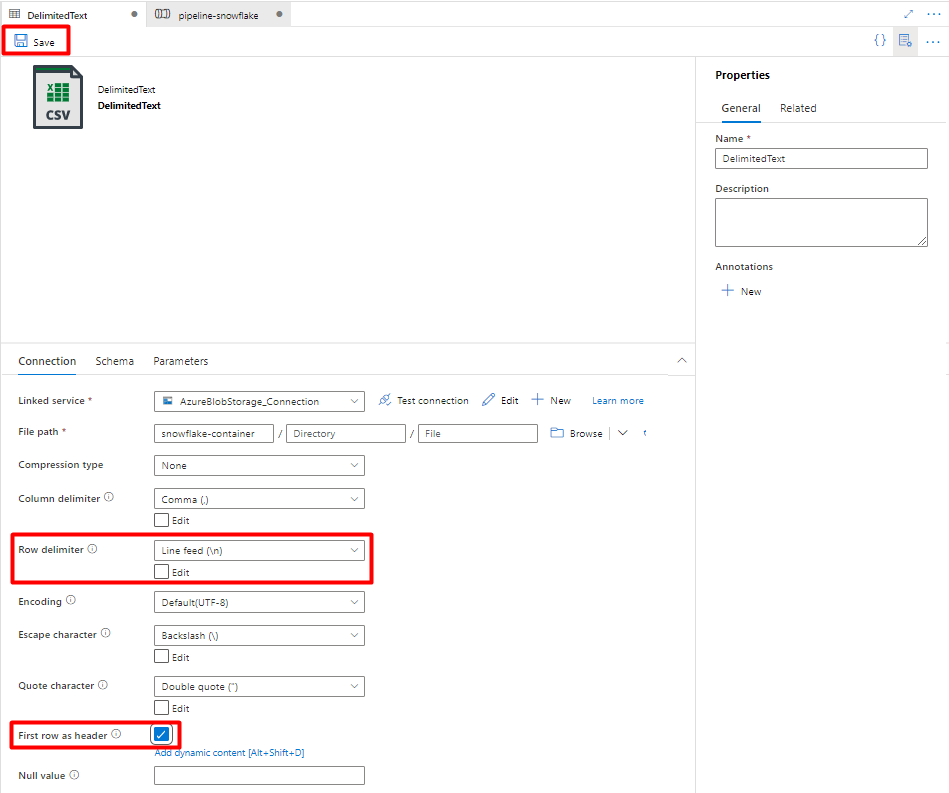

Em Definir Propriedades:

No serviço Vinculado, selecione o serviço vinculado criado na Etapa 7.

No caminho do arquivo, escolha o contêiner que será o coletor para o processo de preparo e selecione OK.

Em delimitador de linha, selecione Alimentação de linha (\n).

Marque a primeira linha como uma caixa de cabeçalho.

Selecione Salvar.

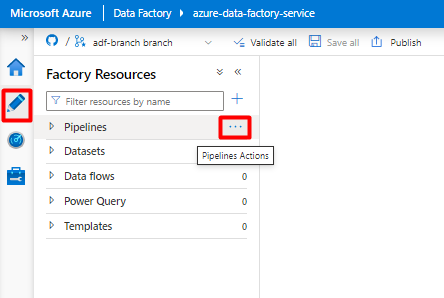

Etapa 9 – Configurar pipelines

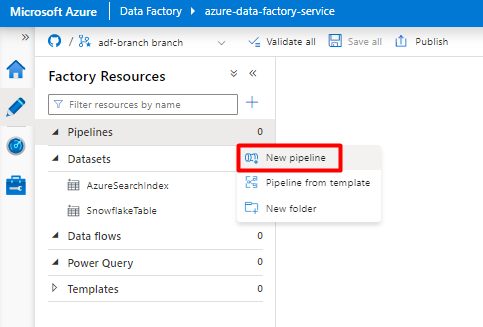

No menu à esquerda, selecione o ícone Autor.

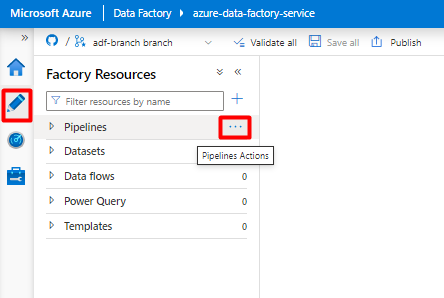

Selecione Pipelines e, em seguida, o menu de reticências do Pipelines Actions (

...).

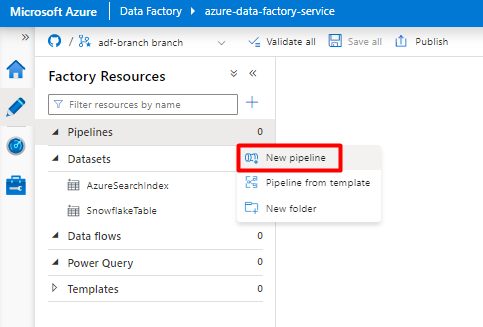

Selecione Novo pipeline.

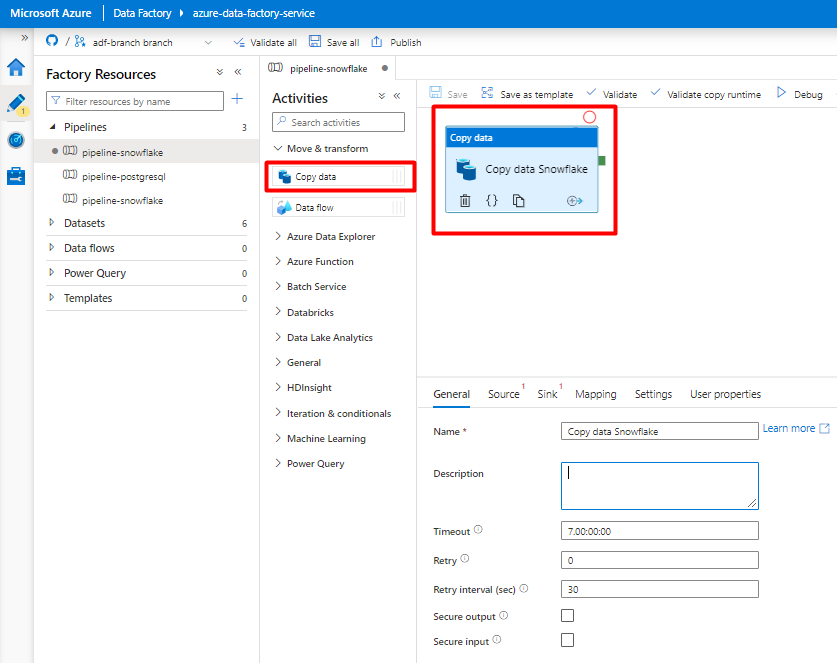

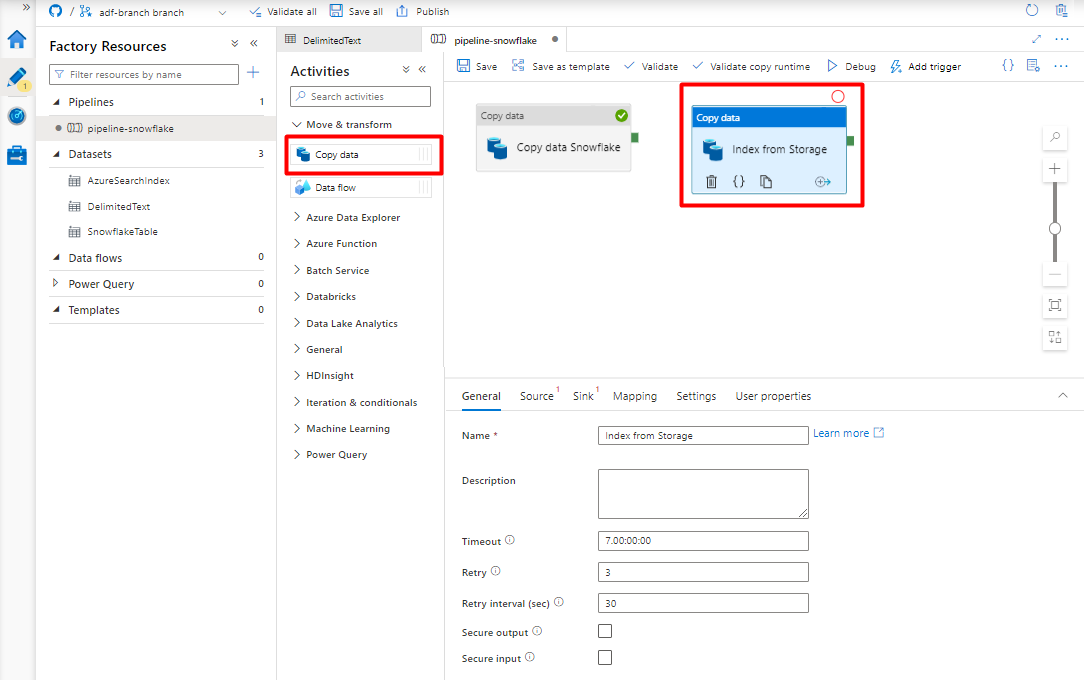

Crie e configure as atividades do Data Factory que copiam do Snowflake para o contêiner do Armazenamento do Azure:

Expanda Mover & seção transformar e arraste e solte a atividade Copiar Dados para a tela do editor de pipeline em branco.

Abra a guia Geral. Aceite os valores padrão, a menos que você precise personalizar a execução.

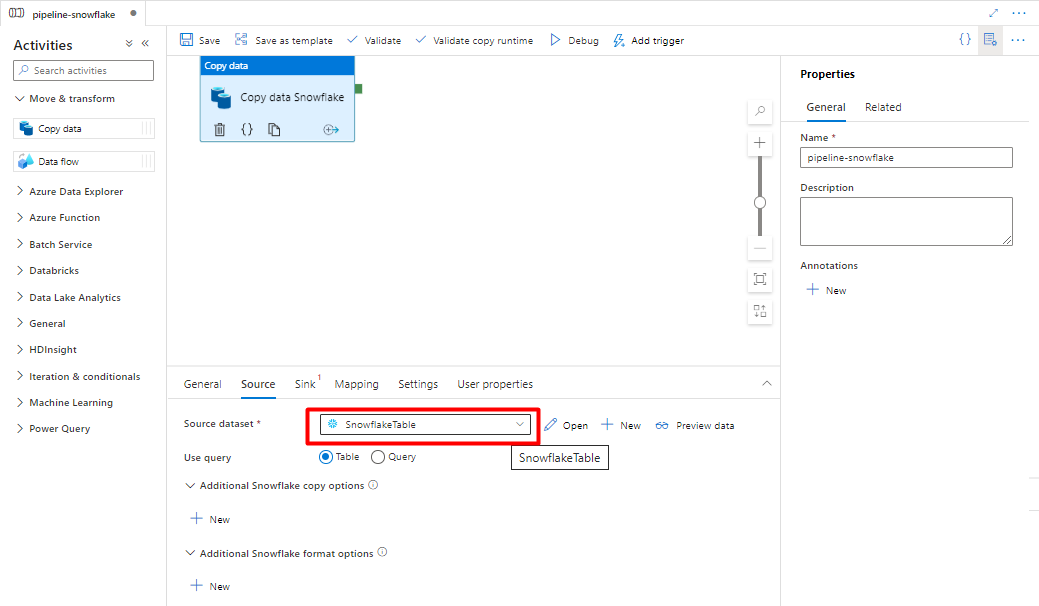

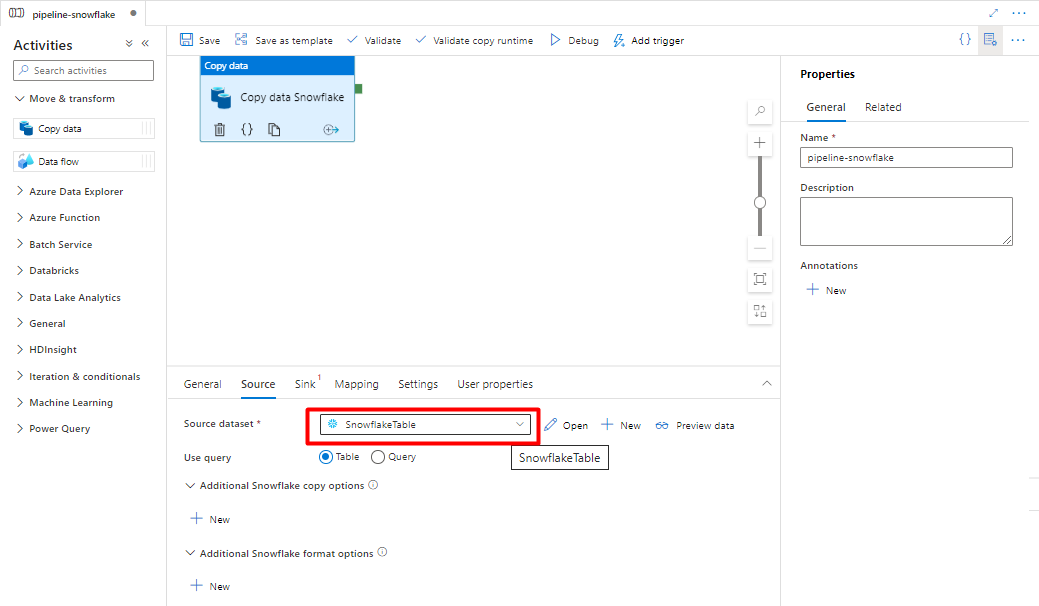

Na guia Origem, selecione sua tabela Snowflake. Deixe os valores padrão para as opções restantes.

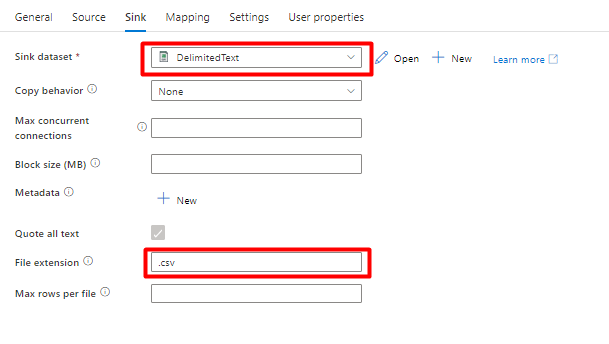

Na guia Coletor:

Selecione Armazenamento do conjunto de dados DelimitedText criado na Etapa 8.

Na Extensão de Arquivo, adicione .csv.

Deixe os valores padrão para as opções restantes.

Selecione Save.

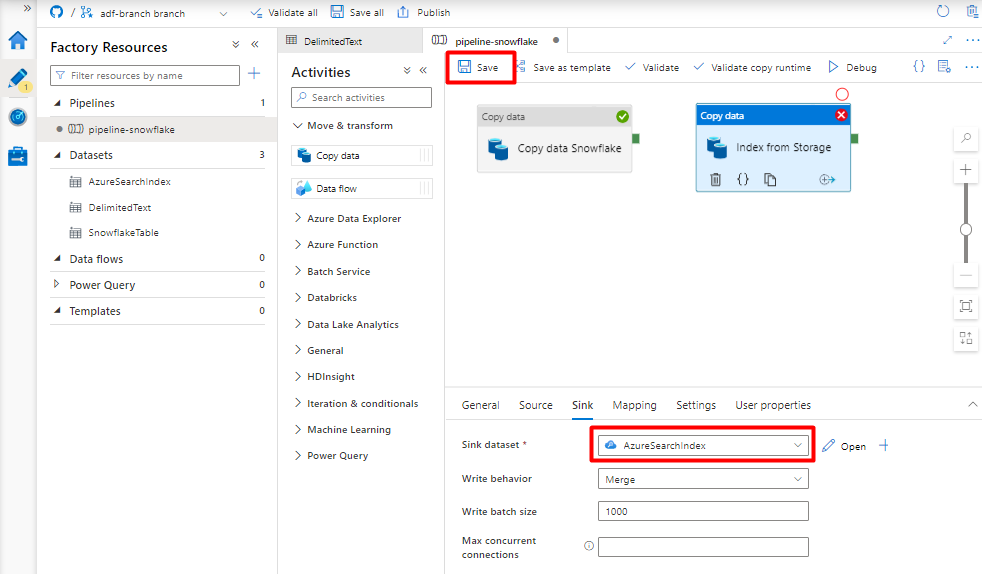

Configure as atividades que copiam do Blob de Armazenamento do Azure para um índice de pesquisa:

Expanda Mover & seção transformar e arraste e solte a atividade Copiar Dados para a tela do editor de pipeline em branco.

Na guia Geral, aceite os valores padrão, a menos que você precise personalizar a execução.

Na guia Origem:

- Selecione Armazenamento do conjunto de dados DelimitedText criado na Etapa 8.

- No tipo de caminho de arquivo, selecione o caminho do arquivo Curinga.

- Deixe todos os campos restantes com valores padrão.

Na guia Coletor, selecione o índice Azure Cognitive Search. Deixe os valores padrão para as opções restantes.

Selecione Save.

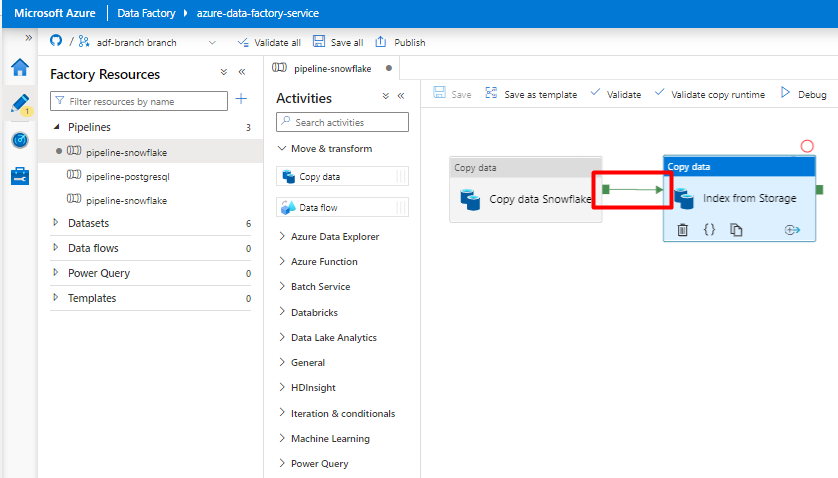

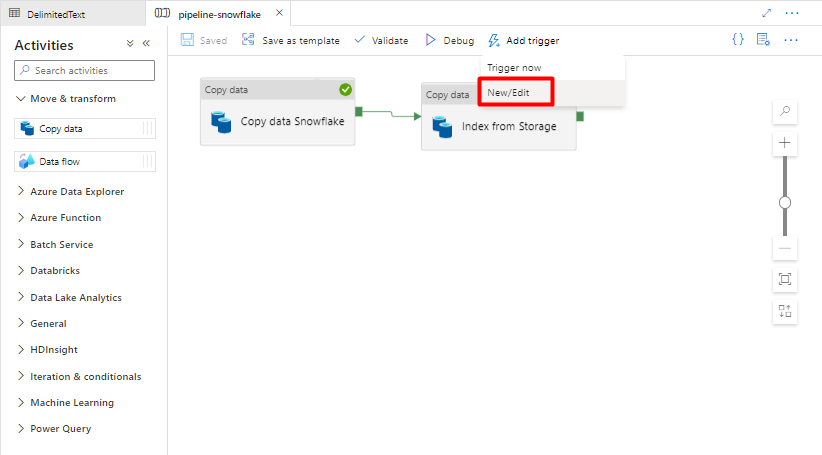

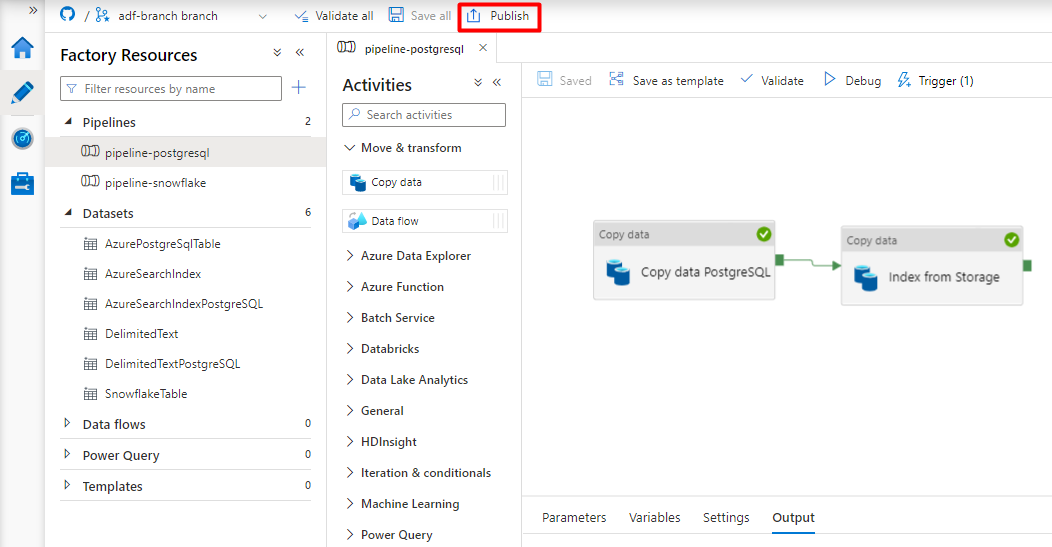

Etapa 10: configurar a ordem de atividade

No editor de tela pipeline, selecione o pequeno quadrado verde na borda do bloco de atividade do pipeline. Arraste-o para a atividade "Índices de Armazenamento da Conta para Azure Cognitive Search" para definir a ordem de execução.

Selecione Salvar.

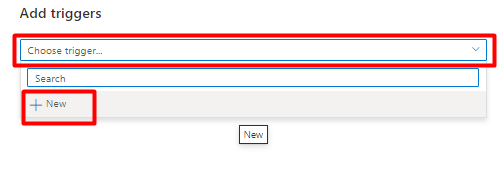

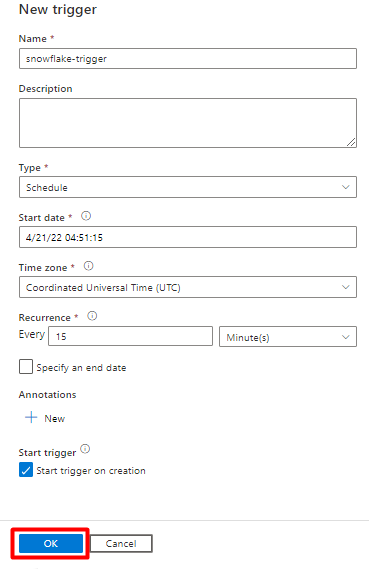

Etapa 11: adicionar um gatilho de pipeline

Selecione Adicionar gatilho para agendar a execução do pipeline e selecione Nova/Edição.

Na lista suspensa Escolher gatilho, selecione Novo.

Examine as opções de gatilho para executar o pipeline e selecione OK.

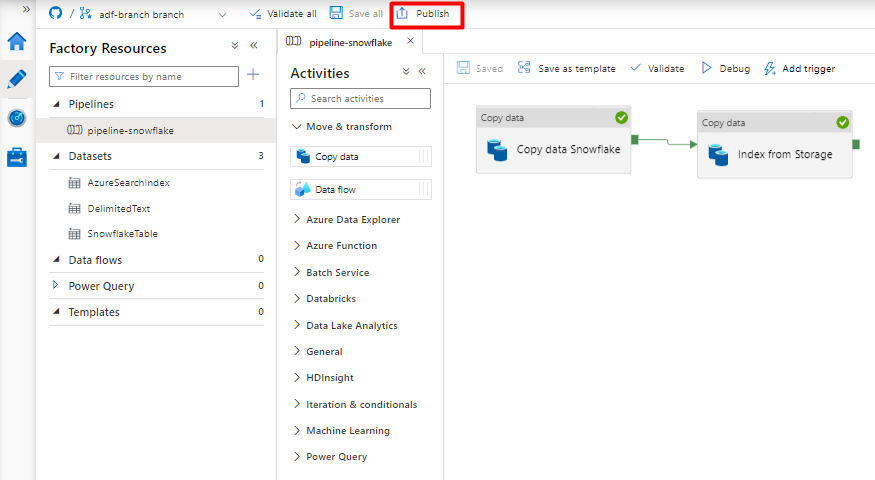

Selecione Save.

Selecione Publicar.

Migrar um pipeline de dados do PostgreSQL

Esta seção explica como copiar dados de um banco de dados PostgreSQL para um índice do Azure Cognitive Search. Não há processo para indexação direta do PostgreSQL para Azure Cognitive Search, portanto, esta seção inclui uma fase de preparo que copia o conteúdo do banco de dados para um contêiner de blob do Armazenamento do Azure. Em seguida, você indexará desse contêiner de preparo usando um pipeline do Data Factory.

Etapa 1: configurar o Serviço Vinculado do PostgreSQL

Entre no Azure Data Factory Studio com sua conta do Azure.

Escolha o Data Factory e selecione Continuar.

No menu à esquerda, selecione o ícone Gerenciar.

Em Serviços vinculados, selecione Novo.

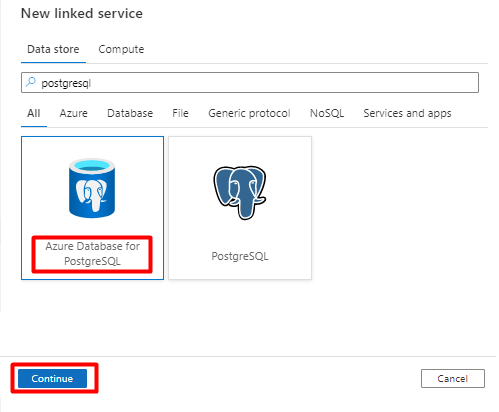

No painel direito, na pesquisa do armazenamento de dados, insira "postgresql". Selecione o bloco PostgreSQL que representa onde seu banco de dados PostgreSQL está localizado (Azure ou outro) e selecione Continuar. Neste exemplo, o banco de dados PostgreSQL está localizado no Azure.

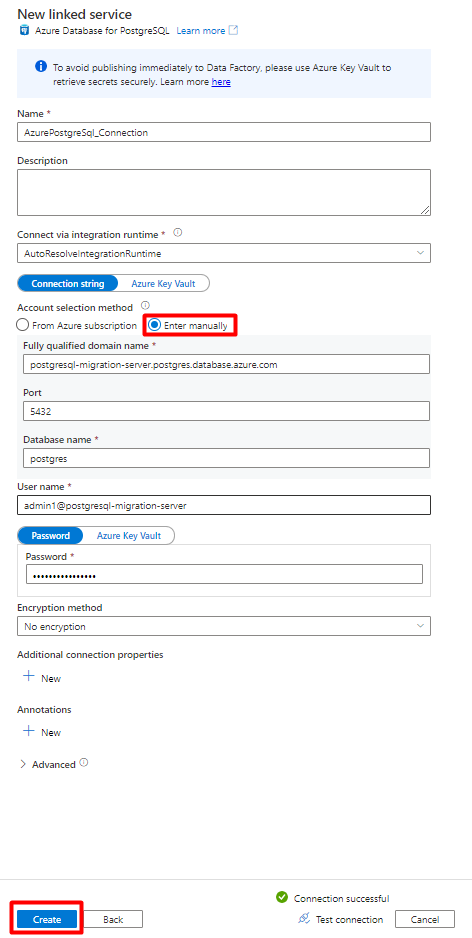

Preencha os novos valores de serviço vinculados:

Em Método de seleção de conta, selecione Inserir manualmente.

Na página visão geral Banco de Dados do Azure para PostgreSQL no portal do Azure, cole os seguintes valores em seu respectivo campo:

- Adicione o nome do servidor ao nome de domínio totalmente qualificado.

- Adicione Administração nome de usuário ao nome de usuário.

- Adicione banco de dados ao nome do banco de dados.

- Insira a senha do nome do usuário do administrador para a Senha do nome de usuário.

- Selecione Criar.

Etapa 2: configurar o conjunto de dados PostgreSQL

No menu à esquerda, selecione o ícone Autor.

Selecione conjuntos de dados e, em seguida, selecione o menu de reticências Ações de Conjuntos de Dados (

...).

SelecioneNovo conjunto de dados.

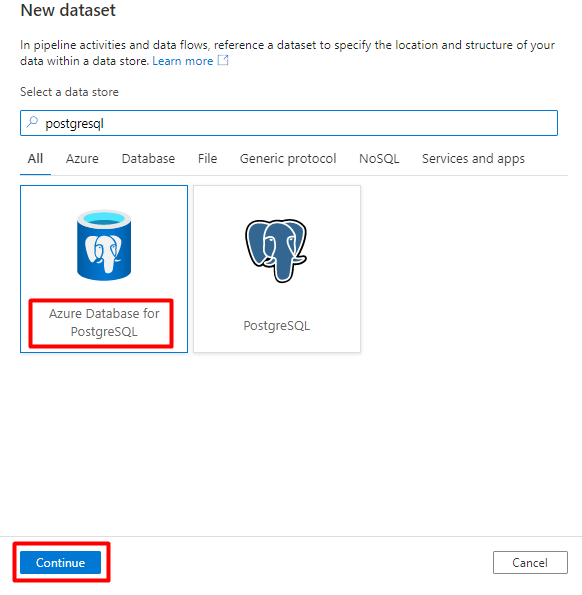

No painel direito, na pesquisa do armazenamento de dados, insira "postgresql". Selecione o bloco PostgreSQL do Azure. Selecione Continuar.

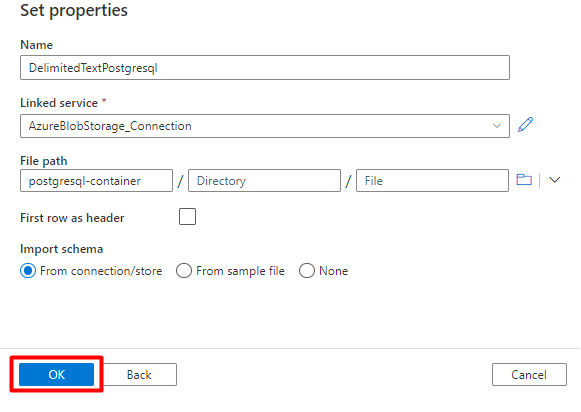

Preencha os valores Defina as propriedades:

Escolha o Serviço Vinculado do PostgreSQL criado na Etapa 1.

Selecione a tabela que deseja importar/indexar.

Selecione OK.

Selecione Save.

Etapa 3: criar um novo índice no Azure Cognitive Search

Crie um novo índice no serviço Azure Cognitive Search com o mesmo esquema que o usado para os dados do PostgreSQL.

Você pode redefinir o índice que está usando no momento para o PostgreSQL Power Connector. No portal do Azure, localize o índice e, em seguida, selecione Definição de Índice (JSON). Selecione a definição e copie no corpo da nova solicitação de índice.

Etapa 4: configurar o Serviço Vinculado do Azure Cognitive Search

No menu à esquerda, selecione o ícone Gerenciar.

Em Serviços vinculados, selecione Novo.

No painel direito, na pesquisa do armazenamento de dados, insira "pesquisar". Selecione o bloco do Azure Search e, em seguida, Continuar.

Preencha os novos valores de serviço vinculados:

- Escolha a assinatura do Azure em que está localizado o serviço do Azure Cognitive Search.

- Escolha o serviço do Azure Cognitive Search que tem o indexador do conector Power Query.

- Selecione Criar.

Etapa 5: configurar o Conjunto de Dados do Azure Cognitive Search

No menu à esquerda, selecione o ícone Autor.

Selecione conjuntos de dados e, em seguida, selecione o menu de reticências Ações de Conjuntos de Dados (

...).

SelecioneNovo conjunto de dados.

No painel direito, na pesquisa do armazenamento de dados, insira "pesquisar". Selecione o bloco do Azure Search e, em seguida, Continuar.

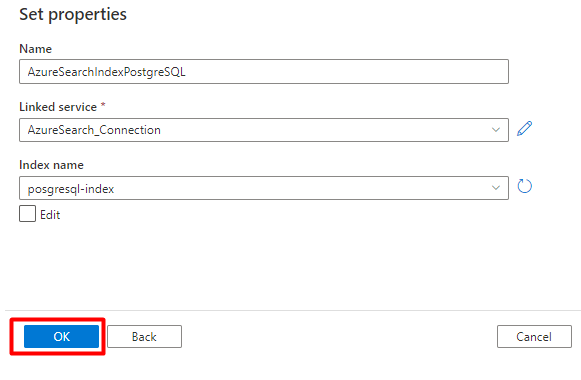

Em Definir Propriedades:

Selecione Save.

Etapa 6: configurar o Serviço Vinculado do Armazenamento de Blobs do Azure

No menu à esquerda, selecione o ícone Gerenciar.

Em Serviços vinculados, selecione Novo.

No painel direito, na pesquisa do armazenamento de dados, insira "armazenar". Selecione o bloco do Armazenamento de Blobs do Azure e, em seguida, Continuar.

Preencha os novos valores de serviço vinculados:

Escolha o tipo de autenticação: URI SAS. Somente esse método pode ser usado para importar dados do PostgreSQL para Armazenamento de Blobs do Azure.

Gere uma URL SAS para a conta de armazenamento que você usará para preparo e copie a URL SAS do Blob para o campo URL SAS.

Selecione Criar.

Etapa 7: configurar o conjunto de dados de armazenamento

No menu à esquerda, selecione o ícone Autor.

Selecione conjuntos de dados e, em seguida, selecione o menu de reticências Ações de Conjuntos de Dados (

...).

SelecioneNovo conjunto de dados.

No painel direito, na pesquisa do armazenamento de dados, insira "armazenar". Selecione o bloco do Armazenamento de Blobs do Azure e, em seguida, Continuar.

Selecione DelimitedText como formato e, em seguida, Continuar.

Em delimitador de linha, selecione Alimentação de linha (\n).

Marque a primeira linha como uma caixa de cabeçalho.

Selecione Salvar.

Etapa 8 – Configurar pipelines

No menu à esquerda, selecione o ícone Autor.

Selecione Pipelines e, em seguida, o menu de reticências do Pipelines Actions (

...).

Selecione Novo pipeline.

Crie e configure as atividades do Data Factory que copiam do PostgreSQL para o contêiner do Armazenamento do Azure.

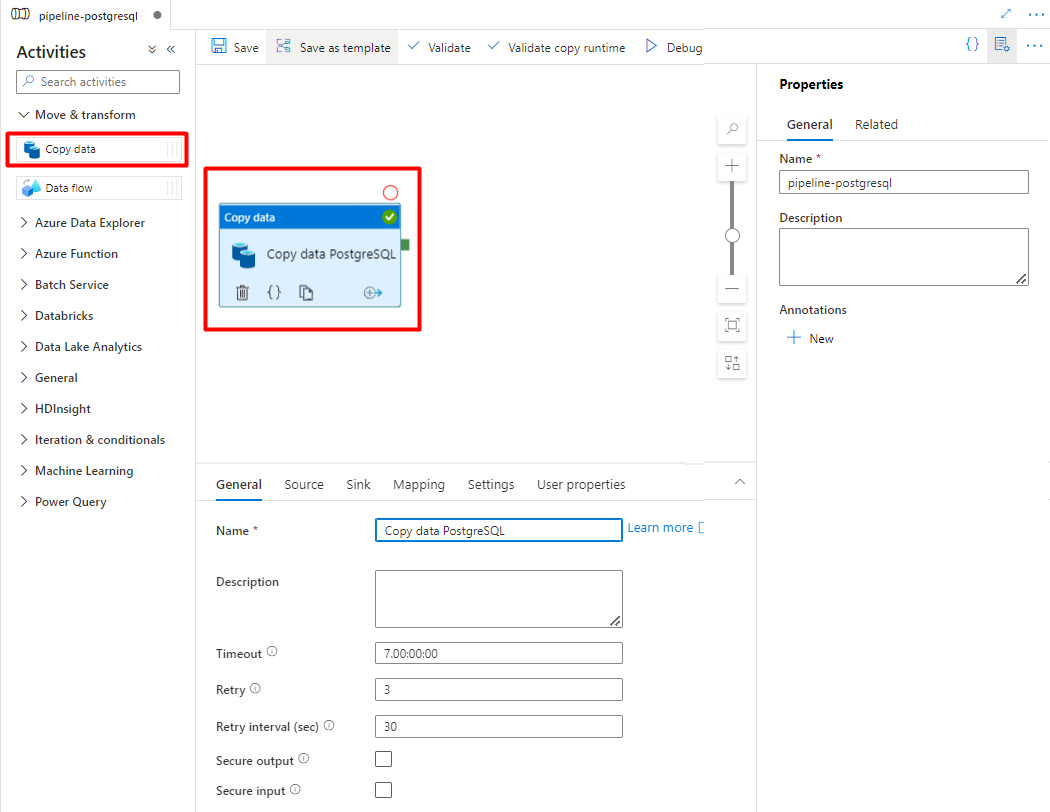

Expanda Mover & seção transformar e arraste e solte a atividade Copiar Dados para a tela do editor de pipeline em branco.

Abra a guia Geral e aceite os valores padrão, a menos que você precise personalizar a execução.

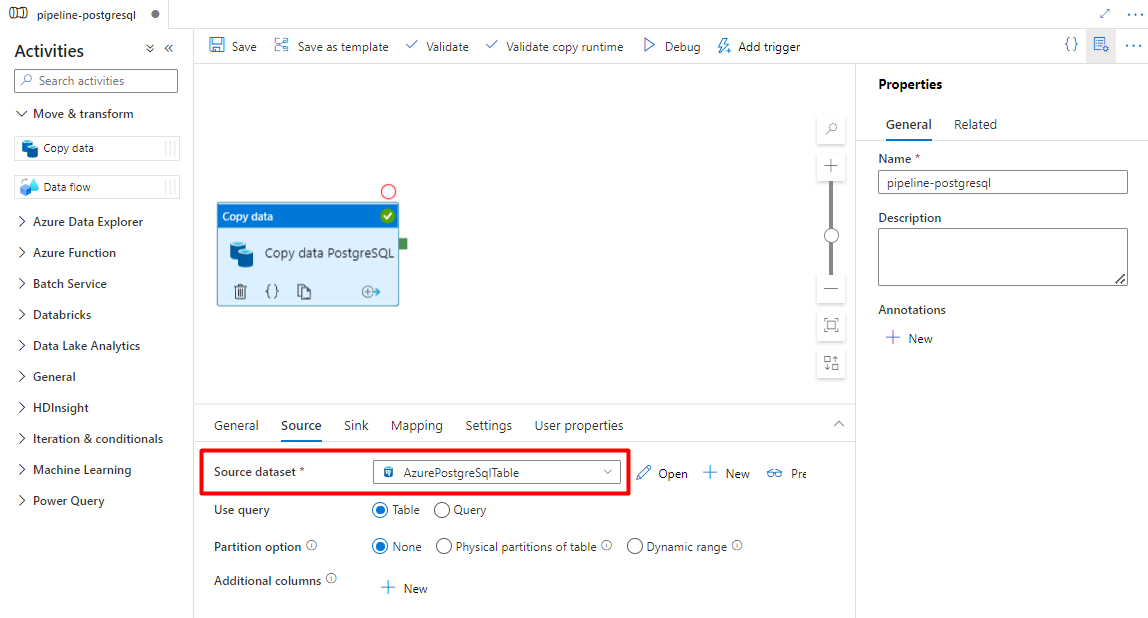

Na guia Origem, selecione a tabela PostgreSQL. Deixe os valores padrão para as opções restantes.

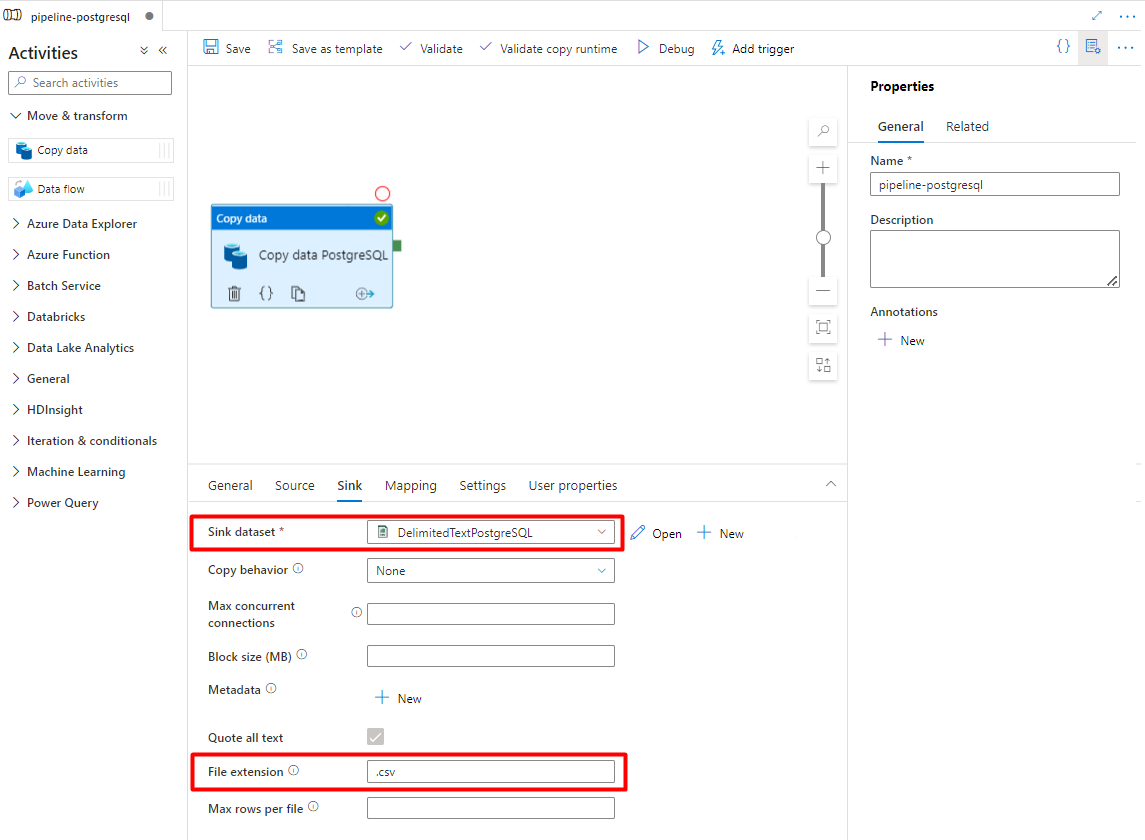

Na guia Coletor:

Selecione o conjunto de dados Armazenamento DelimitedText PostgreSQL configurado na Etapa 7.

Na Extensão de Arquivo, adicione .csv

Deixe os valores padrão para as opções restantes.

Selecione Save.

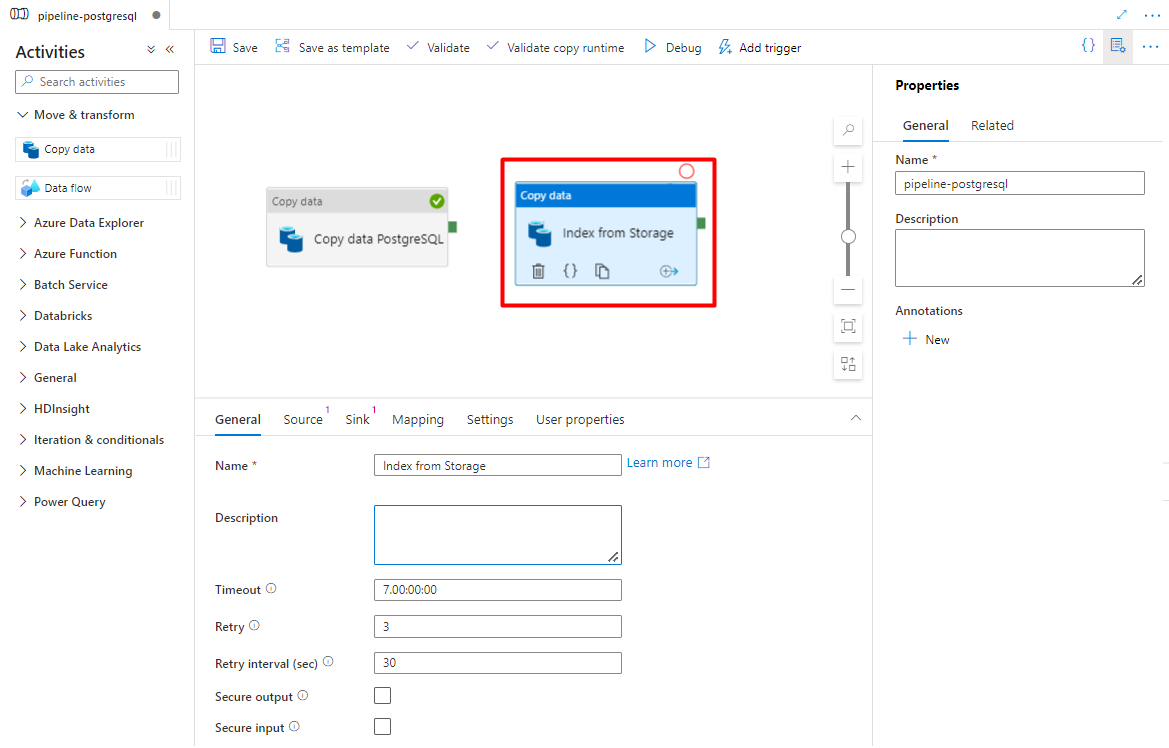

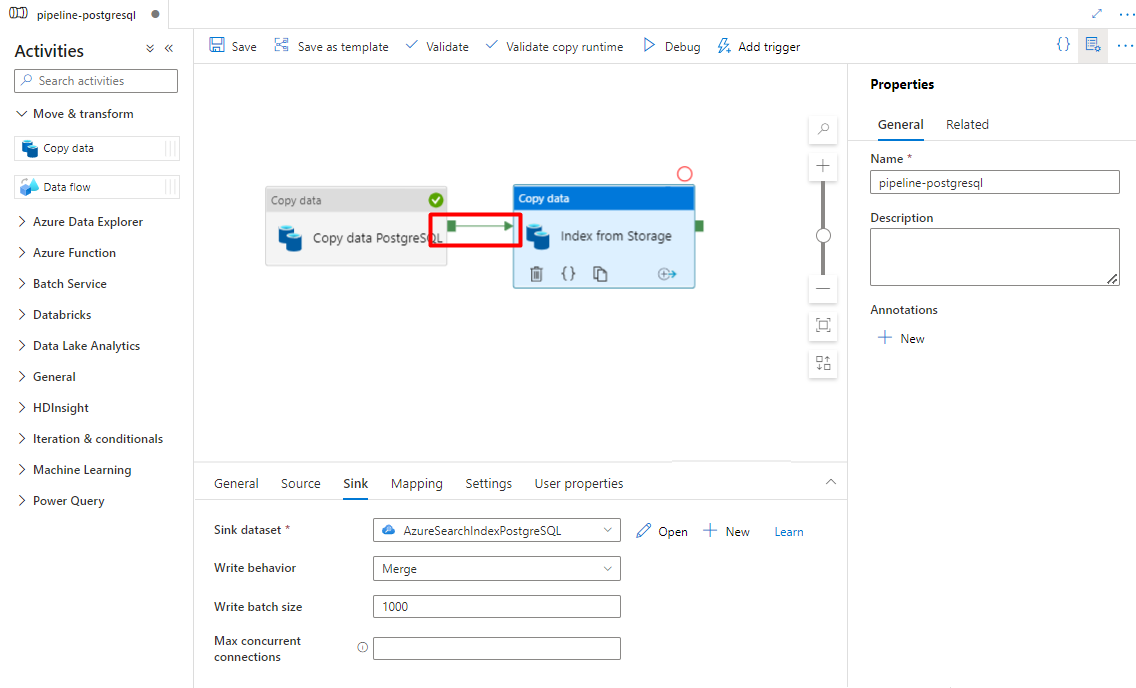

Configure as atividades que copiam do Armazenamento do Azure para um índice de pesquisa:

Expanda Mover & seção transformar e arraste e solte a atividade Copiar Dados para a tela do editor de pipeline em branco.

Na guia Geral, mantenha os valores padrão, a menos que você precise personalizar a execução.

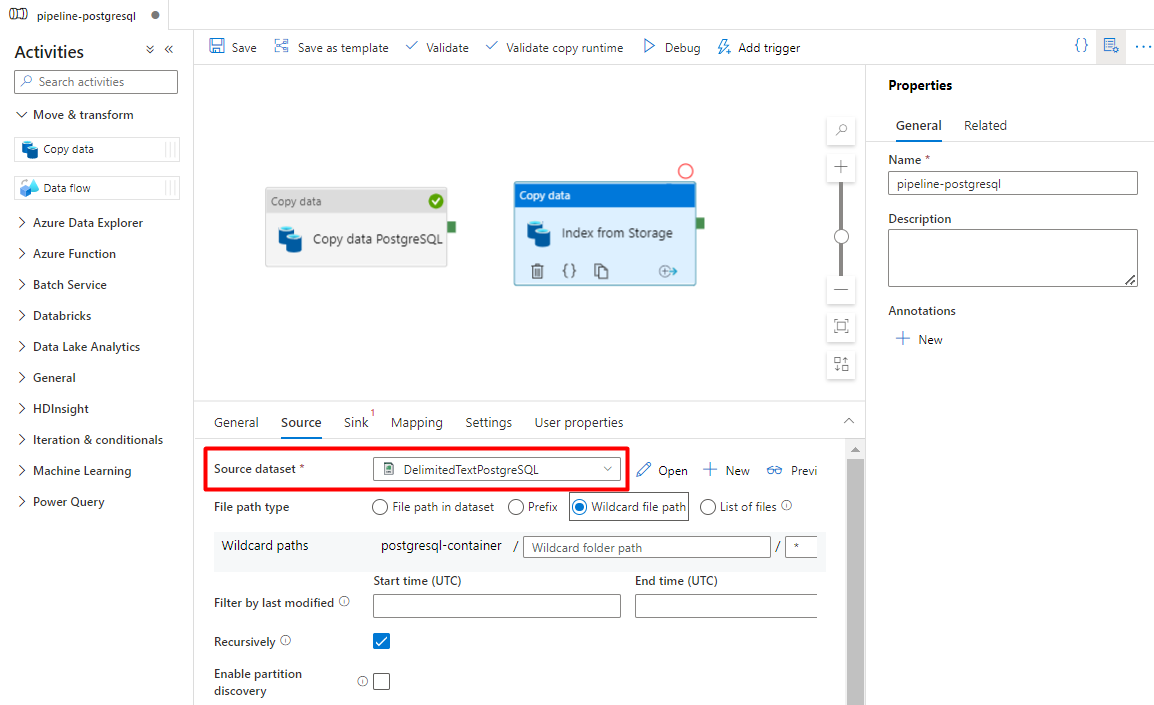

Na guia Origem:

- Selecione o conjunto de dados de origem Armazenamento configurado na Etapa 7.

- No campo tipo de caminho de arquivo, selecione o caminho do arquivo Curinga.

- Deixe todos os campos restantes com valores padrão.

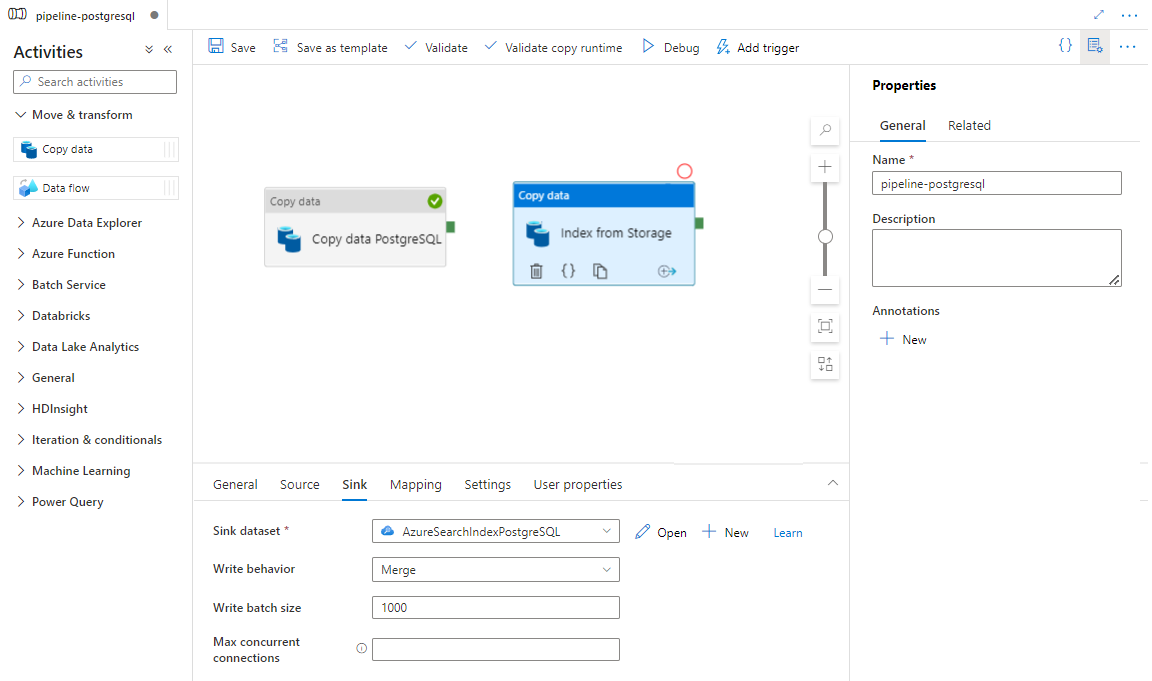

Na guia Coletor, selecione o índice Azure Cognitive Search. Deixe os valores padrão para as opções restantes.

Selecione Save.

Etapa 9: configurar a ordem de atividade

No editor de tela pipeline, selecione o pequeno quadrado verde na borda da atividade do pipeline. Arraste-o para a atividade "Índices de Armazenamento da Conta para Azure Cognitive Search" para definir a ordem de execução.

Selecione Salvar.

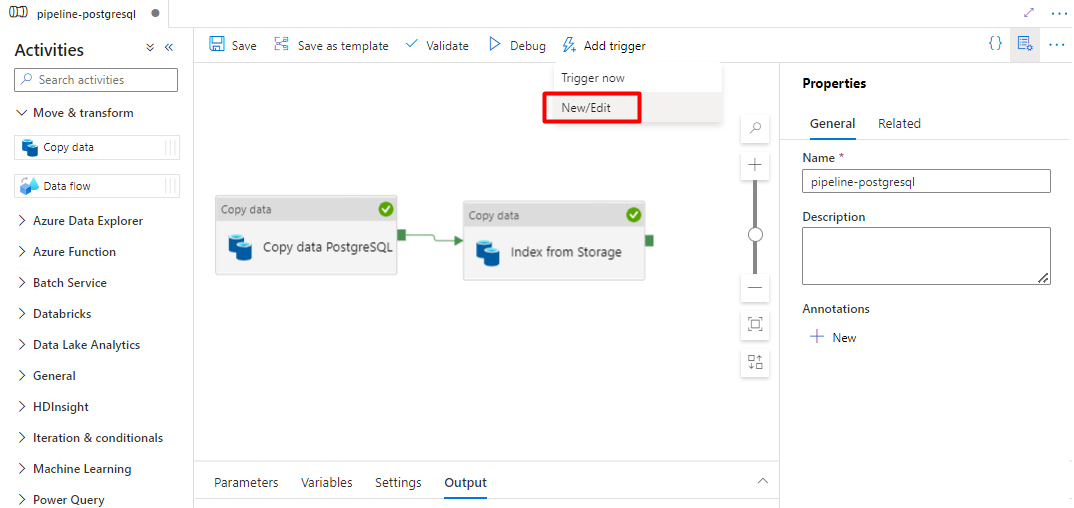

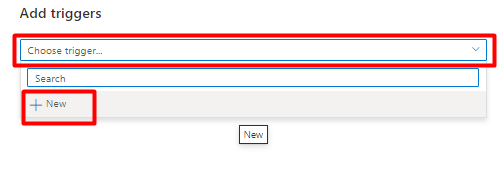

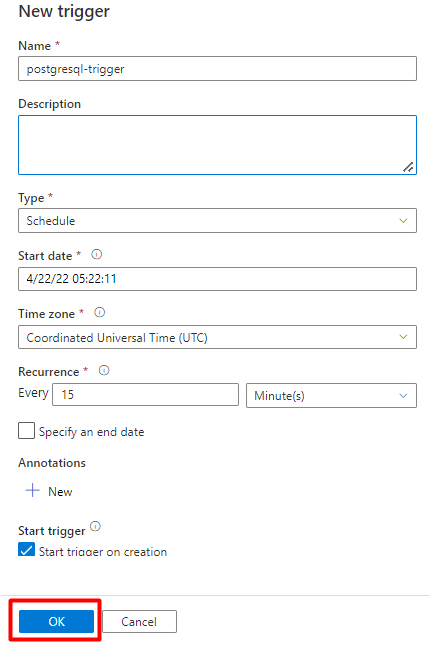

Etapa 10: adicionar um gatilho de pipeline

Selecione Adicionar gatilho para agendar a execução do pipeline e selecione Nova/Edição.

Na lista suspensa Escolher gatilho, selecione Novo.

Examine as opções de gatilho para executar o pipeline e selecione OK.

Selecione Save.

Selecione Publicar.

Conteúdo herdado para pré-visualização do conector do Power Query

Um conector Power Query é usado com um indexador de pesquisa para automatizar a ingestão de dados de várias fontes de dados, incluindo aquelas em outros provedores de nuvem. Ele usa Power Query para recuperar os dados.

As novas fontes de dados com suporte nesta versão prévia incluem:

- Amazon Redshift

- Elasticsearch

- PostgreSQL

- Objetos do Salesforce

- Relatórios do Salesforce

- Smartsheet

- Snowflake

Funcionalidade com suporte

Os conectores do Power Query são usados em indexadores. Um indexador no Azure Cognitive Search é um rastreador que extrai dados e metadados pesquisáveis de uma fonte de dados externa e popula um índice com base em mapeamentos de campo a campo entre o índice e a fonte de dados. Essa abordagem às vezes é chamada de 'modelo de pull' porque o serviço obtém os dados sem que você precise escrever código que adiciona dados a um índice. Os indexadores fornecem uma maneira conveniente para os usuários indexarem conteúdo de sua fonte de dados sem precisarem escrever seu próprio rastreador ou modelo de push.

Os indexadores que referenciam fontes de dados de Power Query oferecem o mesmo nível de suporte a conjuntos de habilidades, agendamentos, lógica de detecção de alteração de marca d'água alta e a maior parte dos parâmetros a que outros indexadores dão suporte.

Pré-requisitos

Embora você não possa mais usar esse recurso, ele tinha os seguintes requisitos durante a versão prévia:

O serviço Azure Cognitive Search em uma região com suporte.

Visualizar o registro. Esse recurso precisa ser habilitado no back-end.

Conta do Armazenamento de Blobs do Azure, usada como um intermediário para os dados. Os dados fluirão de sua fonte de dados, depois para o Armazenamento de Blobs e, em seguida, para o índice. Esse requisito existe apenas na versão prévia restrita inicial.

Disponibilidade regional

A versão prévia só estava disponível nos serviços de pesquisa nas seguintes regiões:

- Centro dos EUA

- Leste dos EUA

- Leste dos EUA 2

- Centro-Norte dos EUA

- Norte da Europa

- Centro-Sul dos Estados Unidos

- Centro-Oeste dos EUA

- Europa Ocidental

- Oeste dos EUA

- Oeste dos EUA 2

Limitações de visualização

Esta seção descreve as limitações específicas da versão prévia atual.

Não há suporte para extrair dados binários da fonte de dados.

Não há suporte para a sessão de depuração.

Introdução ao Portal do Azure

O portal do Azure fornece suporte aos conectores do Power Query. Ao analisar metadados no contêiner de blobs do Azure, o assistente para Importar dados no Azure Cognitive Search é capaz de criar um índice padrão, mapear os campos de origem para campos de índice de destino e carregar o índice em uma única operação. Dependendo do tamanho e complexidade da fonte de dados, é possível ter um índice de pesquisa de texto completo operando em minutos.

O vídeo a seguir mostra como configurar um conector do Power Query no Azure Cognitive Search.

Etapa 1 - Preparar os dados de origem

Certifique-se de que sua fonte de dados contenha dados. O assistente de importação de dados lê metadados e executa a amostragem de dados para inferir um esquema de índice, mas também carrega dados de sua fonte de dados. Se os dados estiverem ausentes, o assistente irá parar e retornar um erro.

Etapa 2 - Iniciar o Assistente para Importação de Dados

Depois que você for aprovado para a versão prévia, a equipe do Azure Cognitive Search fornecerá um link para o Portal do Microsoft Azure que usará um sinalizador de recurso para você acessar os conectores do Power Query. Abra esta página e inicie o assistente na barra de comandos na página do serviço Azure Cognitive Search selecionando Importar dados.

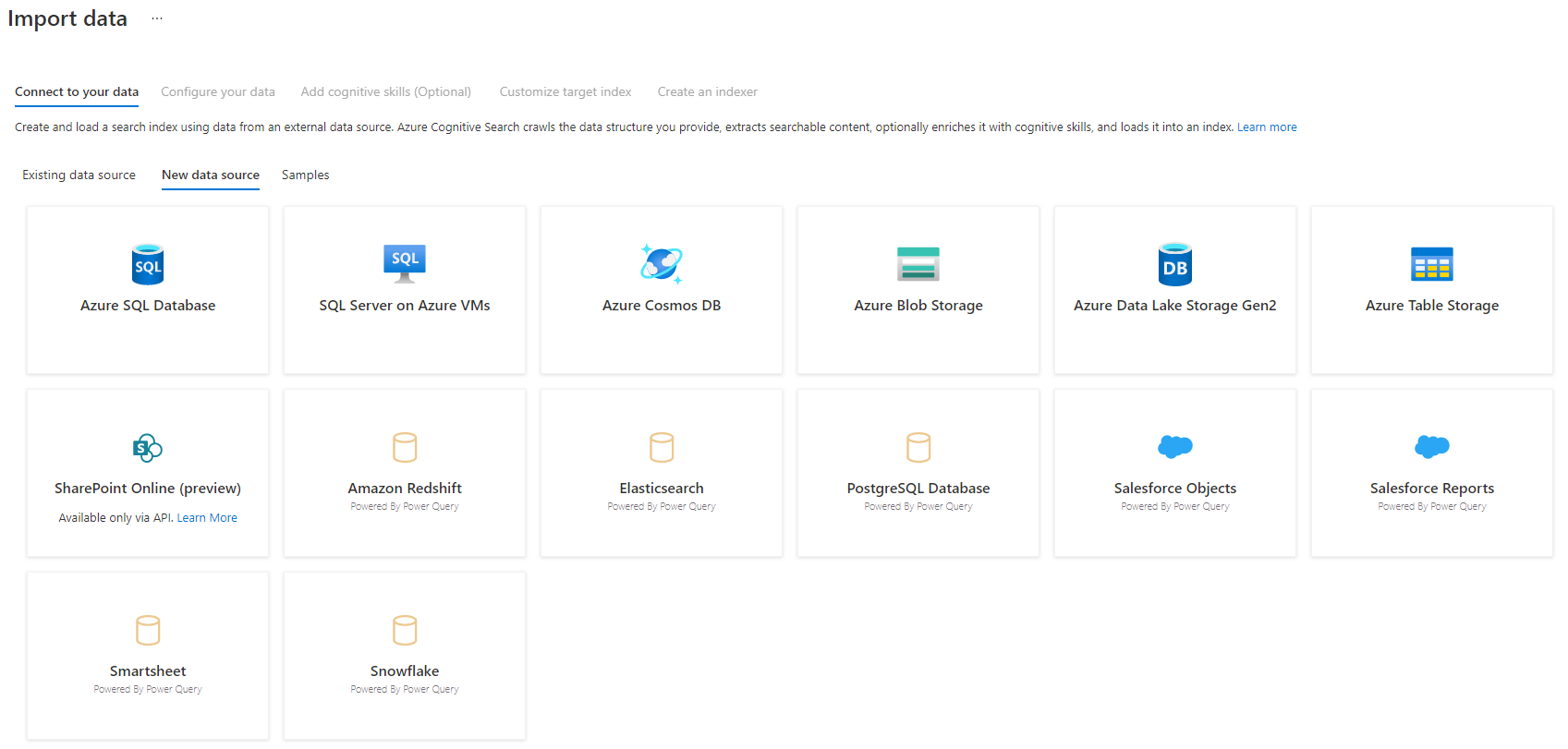

Etapa 3 - Selecionar a fonte de dados

Há algumas fontes de dados das quais você pode efetuar pull de dados usando essa versão prévia. Todas as fontes de dados que usam Power Query incluirão "Da plataforma Power Query" em seu bloco. Selecionar a fonte de dados.

Depois de selecionar a fonte de dados, selecione Avançar: configurar seus dados para mover para a próxima seção.

Etapa 4 - Configurar os dados

Nesta etapa, você configurará a conexão. Cada fonte de dados requer informações diferentes. Em algumas fontes de dados, a documentação do Power Query fornece detalhes adicionais sobre como se conectar aos seus dados.

Depois de fornecer suas credenciais de conexão, selecione Avançar.

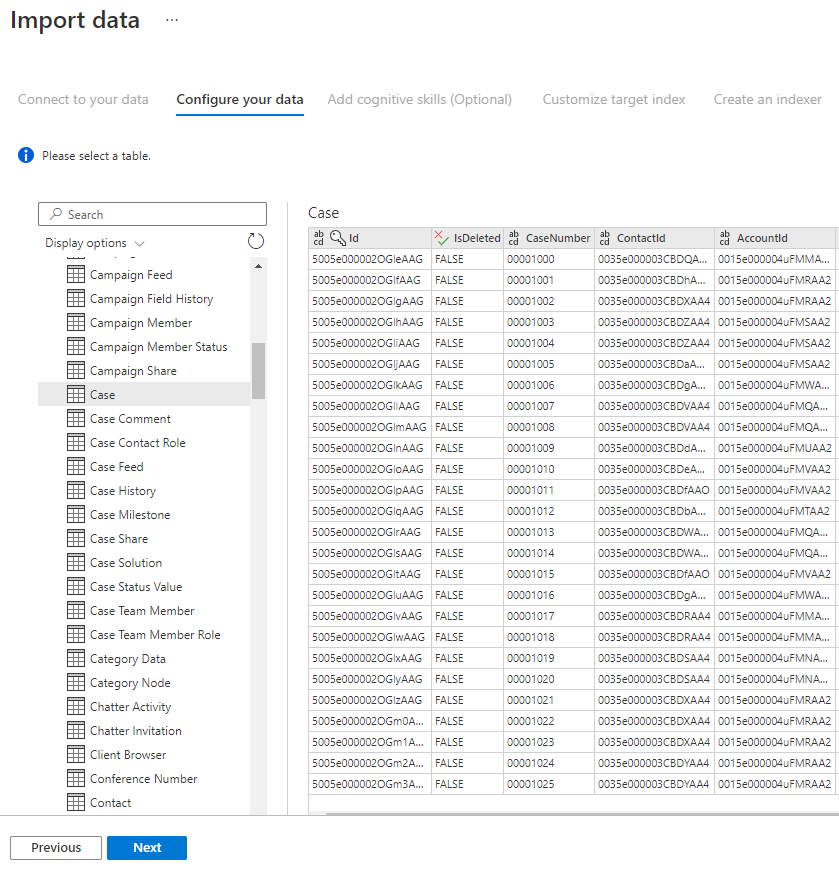

Etapa 5 - Selecionar os dados

O assistente de importação dará uma versão prévia de várias tabelas que estão disponíveis na fonte de dados. Nesta etapa, você verificará uma tabela que contém os dados que deseja importar para o índice.

Depois de selecionar a tabela, selecione Avançar.

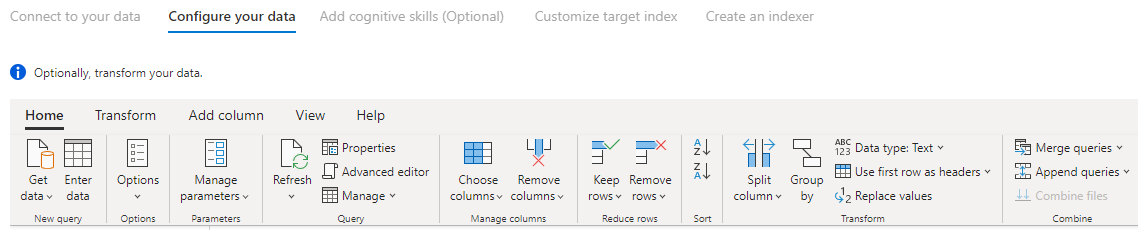

Etapa 6 – Transformar os dados (opcional)

Os conectores do Power Query fornecem uma experiência de interface do usuário rica que permite que você manipule os dados para enviar os dados corretos para o índice. Você pode remover colunas, filtrar linhas, e muito mais.

Não é necessário transformar os dados antes de importá-los para o Azure Cognitive Search.

Para obter mais informações sobre como transformar dados com o Power Query, consulte Usando o Power Query no Power BI Desktop.

Depois que os dados forem transformados, selecione Avançar.

Etapa 7 – Adicionar o Armazenamento de Blob do Azure

No momento, a versão prévia do conector do Power Query exige que você forneça uma conta de armazenamento de blobs. Essa etapa existe apenas na versão prévia restrita inicial. Essa conta de armazenamento de blob servirá como armazenamento temporário para dados que se movem da fonte de dados para um índice do Azure Cognitive Search.

É recomendável fornecer uma cadeia de conexão de conta de armazenamento de acesso completo:

{ "connectionString" : "DefaultEndpointsProtocol=https;AccountName=<your storage account>;AccountKey=<your account key>;" }

É possível obter a cadeia de conexão no portal do Azure navegando para a folha da conta de armazenamento > Configurações > Chaves (para contas de armazenamento Clássicas) ou Configurações > Chaves de acesso (para contas de armazenamento do Azure Resource Manager).

Depois de fornecer um nome de fonte de dados e uma cadeia de conexão, selecione "Avançar: adicionar habilidades cognitivas (opcional)".

Etapa 8 - Adicionar habilidades cognitivas (opcional)

O enriquecimento de IA é uma extensão de indexadores que podem ser usados para tornar seu conteúdo mais pesquisável.

Você pode adicionar quaisquer enriquecimentos que adicionem benefícios ao seu cenário. Ao concluir, selecione Avançar: Personalizar índice de destino.

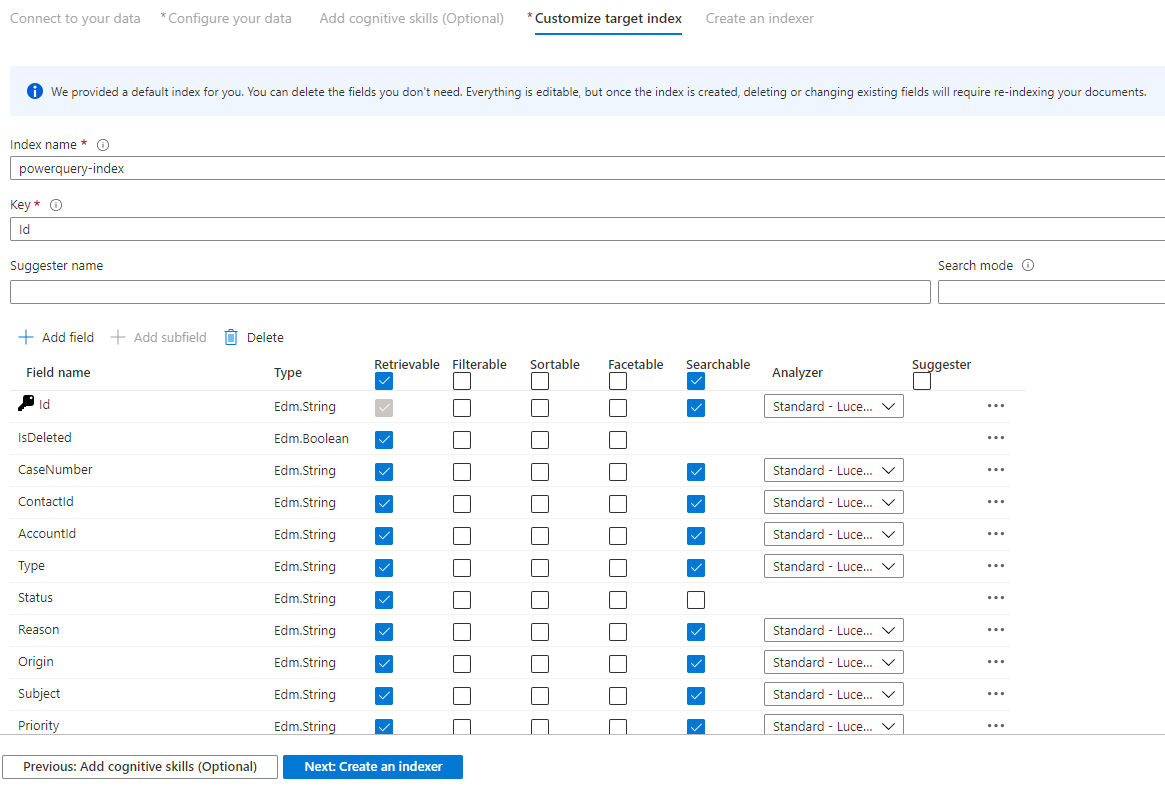

Etapa 9 - Personalizar índice de destino

Na página Índice, deve haver uma lista de campos com um tipo de dados e uma série de caixas de seleção para definir os atributos de índice. O assistente pode gerar uma lista de campos com base em metadados e na amostragem dos dados de origem.

Você pode selecionar atributos em massa clicando na caixa de seleção na parte superior de uma coluna de atributo. Escolha Recuperável e Pesquisável para cada campo que tiver que ser retornado a um aplicativo cliente e sujeito ao processamento de pesquisa de texto completo. Você notará que os inteiros não são de texto completo nem de pesquisa difusa (os números são avaliados verbatim e costumam ser úteis em filtros).

Revise a descrição de atributos de índice e analisadores de linguagem para mais informações.

Reserve um tempo para revisar suas seleções. Depois de executar o assistente, são criadas estruturas de dados físicos, e você só poderá editar esses campos se remover e recriar todos os objetos.

Ao concluir, selecione Avançar: criar um indexador.

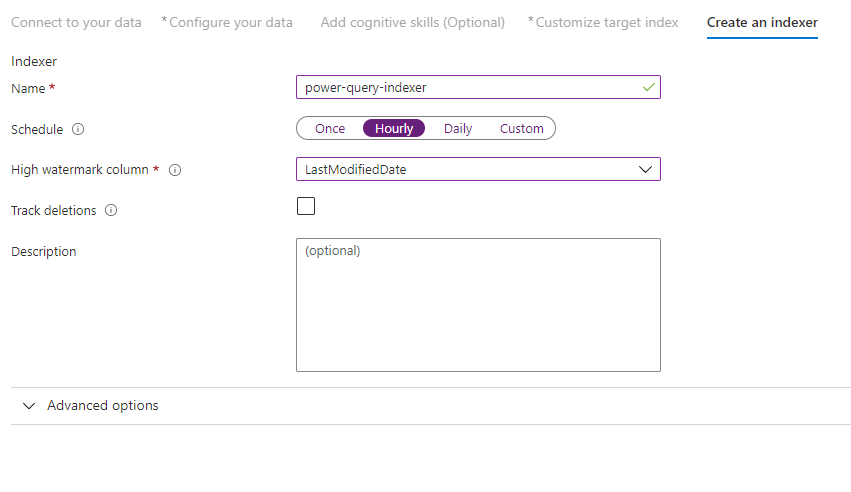

Etapa 10 - Criar um indexador

A última etapa cria o indexador. Dar um nome ao indexador permite que ele exista como um recurso autônomo, que pode ser agendado e gerenciado independentemente do objeto de fonte de dados e índice criado na mesma sequência do assistente.

A saída do assistente de importação de dados é um indexador que rastreia sua fonte de dados e importa os dados que você selecionou para um índice no Azure Cognitive Search.

Ao criar o indexador, você pode optar por executar o indexador em um agendamento e adicionar a detecção de alterações. Para adicionar a detecção de alterações, designe uma coluna de 'marca d'água alta'.

Depois de terminar de preencher esta página, selecione Enviar.

Política de detecção de alteração de marca d’água alta

Essa política de detecção de alteração se baseia em uma coluna de “marca d'água alta” que captura a versão ou a hora em que uma linha foi atualizada pela última vez.

Requisitos

- Todas as inserções especificam um valor para a coluna.

- Todas as atualizações de um item também alteram o valor da coluna.

- O valor dessa coluna aumenta com cada inserção ou atualização.

Nomes de colunas sem suporte

Os nomes de campo em um índice do Azure Cognitive Search precisam atender a determinados requisitos. Um desses requisitos é que alguns caracteres, como "/", não são permitidos. Se um nome de coluna em seu banco de dados não atender a esses requisitos, a detecção de esquema de índice não reconhecerá sua coluna como um nome de campo válido e você não verá essa coluna listada como um campo sugerido para o índice. Geralmente, o uso de mapeamentos de campo resolveria esse problema, mas não há suporte para mapeamentos de campo no portal.

Para indexar o conteúdo de uma coluna em uma tabela que tem um nome de campo sem suporte, renomeie a coluna durante a fase "Transformar os dados" do processo de importação de dados. Por exemplo, você pode renomear uma coluna denominada "Código de cobrança/CEP" como "CEP". Ao renomear a coluna, a detecção do esquema de índice a reconhecerá como um nome de campo válido e a adicionará como uma sugestão à definição do índice.

Próximas etapas

Este artigo explicou como extrair dados usando os conectores Power Query. Como essa versão prévia do recurso foi descontinuada, ela também explica como migrar soluções existentes para um cenário com suporte.

Para saber mais sobre indexadores, consulte Indexadores no Azure Cognitive Search.