Ferramenta LLM para fluxos no Azure AI Studio

Importante

Alguns dos recursos descritos neste artigo podem estar disponíveis apenas na visualização. Essa visualização é fornecida sem um contrato de nível de serviço e não a recomendamos para cargas de trabalho de produção. Algumas funcionalidades poderão não ser suportadas ou poderão ter capacidades limitadas. Para obter mais informações, veja Termos Suplementares de Utilização para Pré-visualizações do Microsoft Azure.

Para usar modelos de linguagem grandes (LLMs) para processamento de linguagem natural, use a ferramenta LLM de fluxo de prompt.

Nota

Para incorporar texto em representações vetoriais densas para várias tarefas de processamento de linguagem natural, consulte Ferramenta de incorporação.

Pré-requisitos

Prepare um prompt conforme descrito na documentação da ferramenta Prompt. A ferramenta LLM e a ferramenta Prompt suportam modelos Jinja . Para obter mais informações e práticas recomendadas, consulte Técnicas de engenharia imediatas.

Crie com a ferramenta LLM

Crie ou abra um fluxo no Azure AI Studio. Para obter mais informações, consulte Criar um fluxo.

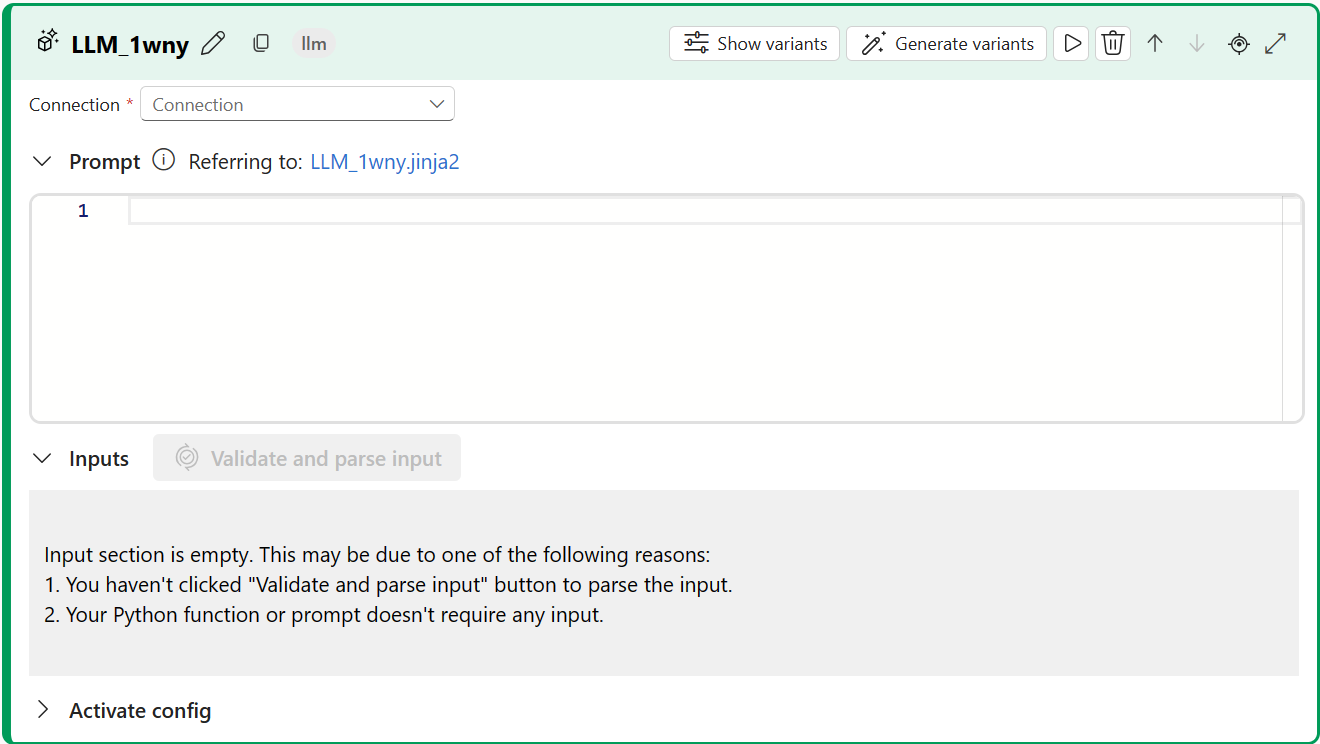

Selecione + LLM para adicionar a ferramenta LLM ao seu fluxo.

Selecione a conexão com um dos recursos provisionados. Por exemplo, selecione Default_AzureOpenAI.

Na lista suspensa Api, selecione bate-papo ou conclusão.

Insira valores para os parâmetros de entrada da ferramenta LLM descritos na tabela Entradas de conclusão de texto. Se você selecionou a API de chat , consulte a tabela Entradas de chat. Se você selecionou a API de conclusão , consulte a tabela Entradas de conclusão de texto. Para obter informações sobre como preparar a entrada de prompt, consulte Pré-requisitos.

Adicione mais ferramentas ao seu fluxo, conforme necessário. Ou selecione Executar para executar o fluxo.

As saídas são descritas na tabela Saídas.

Entradas

Os seguintes parâmetros de entrada estão disponíveis.

Entradas de preenchimento de texto

| Nome | Tipo | Descrição | Obrigatório |

|---|---|---|---|

| Prompt | string | Prompt de texto para o modelo de idioma. | Sim |

| modelo, deployment_name | string | O modelo de linguagem a ser usado. | Sim |

| max_tokens | integer | O número máximo de tokens a serem gerados na conclusão. O padrão é 16. | Não |

| temperatura | flutuante | A aleatoriedade do texto gerado. A predefinição é 1. | Não |

| parar | list | A sequência de parada para o texto gerado. O padrão é null. | Não |

| sufixo | string | O texto foi anexado ao final da conclusão. | Não |

| top_p | flutuante | A probabilidade de usar a escolha superior dos tokens gerados. A predefinição é 1. | Não |

| Logprobs | integer | O número de probabilidades de log a serem geradas. O padrão é null. | Não |

| echo | boolean | O valor que indica se o prompt deve ser repetido na resposta. A predefinição é falsa. | Não |

| presence_penalty | flutuante | O valor que controla o comportamento do modelo em relação à repetição de frases. O padrão é 0. | Não |

| frequency_penalty | flutuante | O valor que controla o comportamento do modelo em relação à geração de frases raras. O padrão é 0. | Não |

| best_of | integer | O número de melhores finalizações a gerar. A predefinição é 1. | Não |

| logit_bias | dicionário | O viés logit para o modelo de linguagem. O padrão é dicionário vazio. | Não |

Entradas de chat

| Nome | Tipo | Descrição | Obrigatório |

|---|---|---|---|

| Prompt | string | O prompt de texto ao qual o modelo de idioma deve responder. | Sim |

| modelo, deployment_name | string | O modelo de linguagem a ser usado. | Sim |

| max_tokens | integer | O número máximo de tokens a gerar na resposta. O padrão é inf. | Não |

| temperatura | flutuante | A aleatoriedade do texto gerado. A predefinição é 1. | Não |

| parar | list | A sequência de parada para o texto gerado. O padrão é null. | Não |

| top_p | flutuante | A probabilidade de usar a escolha superior dos tokens gerados. A predefinição é 1. | Não |

| presence_penalty | flutuante | O valor que controla o comportamento do modelo em relação à repetição de frases. O padrão é 0. | Não |

| frequency_penalty | flutuante | O valor que controla o comportamento do modelo em relação à geração de frases raras. O padrão é 0. | Não |

| logit_bias | dicionário | O viés logit para o modelo de linguagem. O padrão é dicionário vazio. | Não |

Saídas

A saída varia dependendo da API selecionada para entradas.

| API | Tipo de retorno | Description |

|---|---|---|

| Conclusão | string | O texto de uma conclusão prevista. |

| Chat | string | O texto de uma resposta de conversa. |

Próximos passos

Comentários

Brevemente: Ao longo de 2024, vamos descontinuar progressivamente o GitHub Issues como mecanismo de feedback para conteúdos e substituí-lo por um novo sistema de feedback. Para obter mais informações, veja: https://aka.ms/ContentUserFeedback.

Submeter e ver comentários