Nota

O acesso a esta página requer autorização. Podes tentar iniciar sessão ou mudar de diretório.

O acesso a esta página requer autorização. Podes tentar mudar de diretório.

Este tutorial orienta você na criação e execução de um pipeline do Azure Data Factory que executa uma carga de trabalho do Azure Batch. Um script Python é executado nos nós do Batch para obter uma entrada de valores separados por vírgulas (CSV) de um contentor de Blob do Azure, manipular os dados e escrever a saída noutro contentor de armazenamento. Use o Batch Explorer para criar um pool de lotes e nós, e o Azure Storage Explorer para trabalhar com contêineres e arquivos de armazenamento.

Neste tutorial, irá aprender a:

- Use o Batch Explorer para criar um pool do Batch e nodes.

- Use o Gerenciador de Armazenamento para criar contêineres de armazenamento e carregar arquivos de entrada.

- Desenvolva um script Python para manipular dados de entrada e produzir saída.

- Crie um pipeline do Data Factory que execute a carga de trabalho em lote.

- Use o Batch Explorer para examinar os arquivos de log de saída.

Pré-requisitos

- Uma conta do Azure com uma subscrição ativa. Se não tiver uma subscrição, crie uma conta gratuita.

- Uma conta de lote com uma conta de Armazenamento do Azure vinculada. Você pode criar as contas usando qualquer um dos seguintes métodos: Portal do Azure | Azure CLI | Bicep | modelo ARM | Terraform.

- Uma instância do Data Factory. Para criar o data factory, siga as instruções em Criar um data factory.

- Batch Explorer baixado e instalado.

- Storage Explorer baixado e instalado.

-

Python 3.8 ou superior, com o pacote azure-storage-blob instalado usando

pip. - O conjunto de dados de entrada iris.csv foi baixado do GitHub.

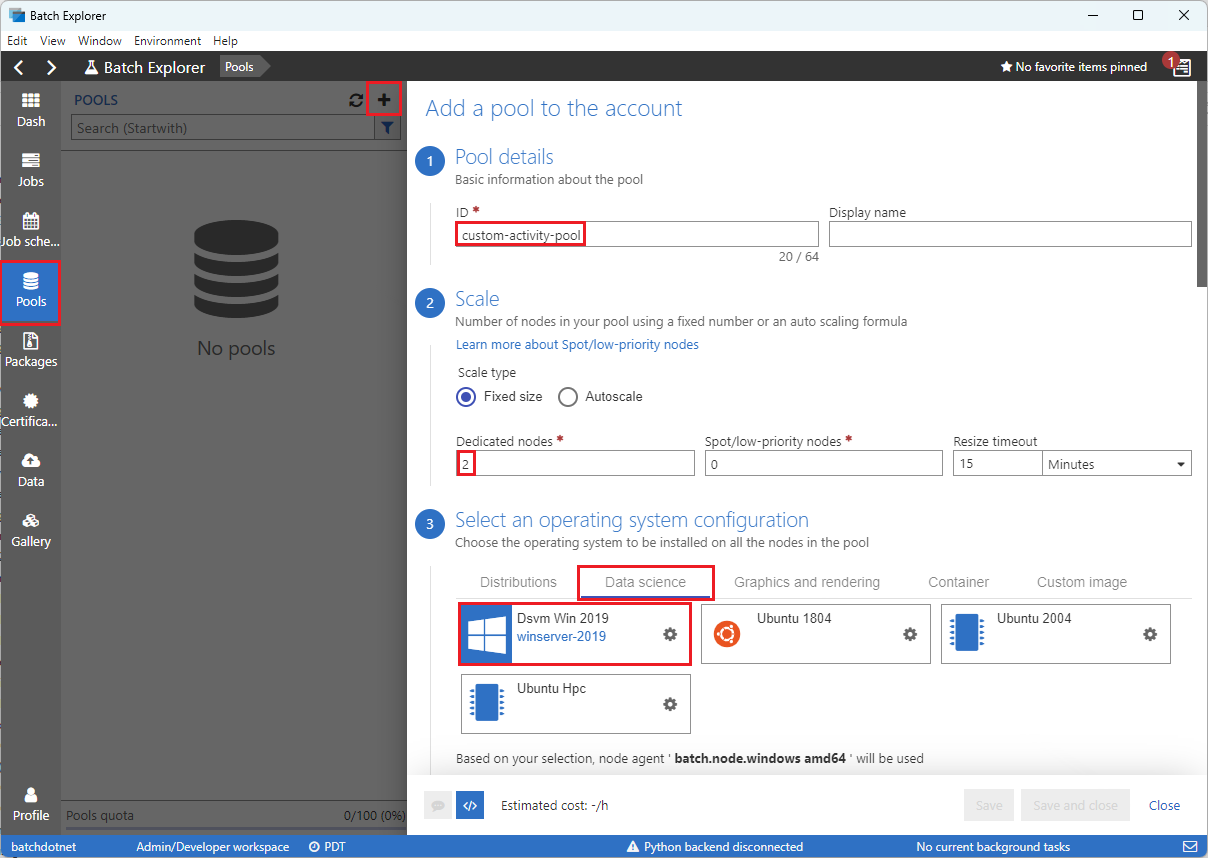

Usar o Batch Explorer para criar um pool de Batch e nós

Use o Batch Explorer para criar um pool de nós de computação para executar sua carga de trabalho.

Entre no Batch Explorer com suas credenciais do Azure.

Selecione sua conta Batch.

Selecione Pools na barra lateral esquerda e, em seguida, selecione o + ícone para adicionar um pool.

Preencha o formulário Adicionar um pool à conta da seguinte maneira:

- No campo ID, insira custom-activity-pool.

- No campo Nós dedicados, insira 2.

- Para Selecione uma configuração de sistema operacional, selecione a guia Ciência de dados e, em seguida, selecione Dsvm Win 2019.

- Em Escolha um tamanho de máquina virtual, selecione Standard_F2s_v2.

- Em Iniciar tarefa, selecione Adicionar uma tarefa inicial.

No ecrã Iniciar tarefa, em Linha de comandos, introduza

cmd /c "pip install azure-storage-blob pandas"e, em seguida, selecione Selecionar. Este comando instala o pacoteazure-storage-blobem cada nó quando é iniciado.

Selecione Guardar e fechar.

Usar o Explorador de Armazenamento para criar contentores de blob

Use o Gerenciador de Armazenamento para criar contêineres de blob para armazenar arquivos de entrada e saída e, em seguida, carregue seus arquivos de entrada.

- Entre no Gerenciador de Armazenamento com suas credenciais do Azure.

- Na barra lateral esquerda, localize e expanda a conta de armazenamento vinculada à sua conta do Batch.

- Clique com o botão direito do mouse em Contêineres de Blob e selecione Criar Contêiner de Blob ou selecione Criar Contêiner de Blob em Ações na parte inferior da barra lateral.

- Insira input no campo de entrada.

- Crie outro contêiner de blob chamado output.

- Selecione o contêiner de entrada e, em seguida, selecione > no painel direito.

- No ecrã Carregar arquivos, em Arquivos selecionados, selecione as reticências ... ao lado do campo de entrada.

- Navegue até a localização do arquivo de iris.csv baixado, selecione Abrir e, em seguida, selecione Carregar.

Desenvolver um script Python

O script Python a seguir carrega o arquivo de conjunto de dados iris.csv do contêiner de entrada do Storage Explorer, manipula os dados e salva os resultados no contêiner de saída.

O script precisa usar a cadeia de conexão para a conta de Armazenamento do Azure que está vinculada à sua conta Batch. Para obter o string de conexão:

- No portal do Azure, procure e selecione o nome da conta de armazenamento vinculada à sua conta do Batch.

- Na página da conta de armazenamento, selecione Teclas de acesso na navegação à esquerda em Segurança + rede.

- Em key1, selecione Mostrar ao lado de cadeia de conexão e, em seguida, selecione o ícone Copiar para copiar a cadeia de conexão.

Cole a cadeia de conexão no script a seguir, substituindo o <storage-account-connection-string> marcador de posição. Salve o script como um arquivo chamado main.py.

Importante

A exposição de chaves de conta na origem do aplicativo não é recomendada para uso em Produção. Você deve restringir o acesso às credenciais e consultá-las em seu código usando variáveis ou um arquivo de configuração. É preferível armazenar as chaves das contas de Batch e Armazenamento no Cofre de Chaves do Azure.

# Load libraries

# from azure.storage.blob import BlobClient

from azure.storage.blob import BlobServiceClient

import pandas as pd

import io

# Define parameters

connectionString = "<storage-account-connection-string>"

containerName = "output"

outputBlobName = "iris_setosa.csv"

# Establish connection with the blob storage account

blob = BlobClient.from_connection_string(conn_str=connectionString, container_name=containerName, blob_name=outputBlobName)

# Initialize the BlobServiceClient (This initializes a connection to the Azure Blob Storage, downloads the content of the 'iris.csv' file, and then loads it into a Pandas DataFrame for further processing.)

blob_service_client = BlobServiceClient.from_connection_string(conn_str=connectionString)

blob_client = blob_service_client.get_blob_client(container_name=containerName, blob_name=outputBlobName)

# Download the blob content

blob_data = blob_client.download_blob().readall()

# Load iris dataset from the task node

# df = pd.read_csv("iris.csv")

df = pd.read_csv(io.BytesIO(blob_data))

# Take a subset of the records

df = df[df['Species'] == "setosa"]

# Save the subset of the iris dataframe locally in the task node

df.to_csv(outputBlobName, index = False)

with open(outputBlobName, "rb") as data:

blob.upload_blob(data, overwrite=True)

Para obter mais informações sobre como trabalhar com o Armazenamento de Blobs do Azure, consulte a documentação do Armazenamento de Blobs do Azure.

Execute o script localmente para testar e validar a funcionalidade.

python main.py

O script deve produzir um arquivo de saída chamado iris_setosa.csv que contenha apenas os registros de dados que têm Species = setosa. Depois de verificar se ele funciona corretamente, carregue o arquivo de script main.py para o contêiner de entrada do Storage Explorer.

Configurar um pipeline de dados do Data Factory

Crie e valide um pipeline do Data Factory que usa seu script Python.

Obter informações da conta

O pipeline do Data Factory utiliza os nomes das suas contas de Batch e de Armazenamento, os valores das chaves das contas e o ponto de extremidade da conta de Batch. Para obter essas informações do portal do Azure:

Na barra de Pesquisa do Azure, procure e selecione o nome da sua conta de lote.

Na página da sua conta do Batch, selecione Teclas na navegação do lado esquerdo.

Na página Chaves, copie os seguintes valores:

- Conta em lote

- Ponto final da conta

- Chave de acesso primária

- Nome da conta de armazenamento

- Chave1

Criar e executar o pipeline

Se o Azure Data Factory Studio ainda não estiver em execução, selecione Iniciar estúdio na página do Data Factory no portal do Azure.

No Data Factory Studio, selecione o ícone de lápis Autor na navegação à esquerda.

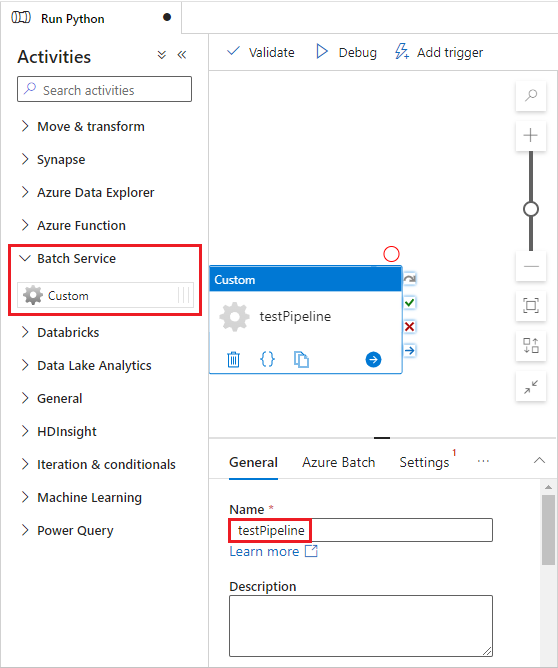

Em Recursos de Fábrica, selecione o + ícone e, em seguida, selecione Pipeline.

No painel Propriedades à direita, altere o nome do pipeline para Run Python.

No painel Atividades, expanda Serviço de Lote e arraste a Atividade Personalizada para a superfície do designer de pipeline.

Abaixo da tela do designer, na guia Geral, introduza testPipeline em Nome.

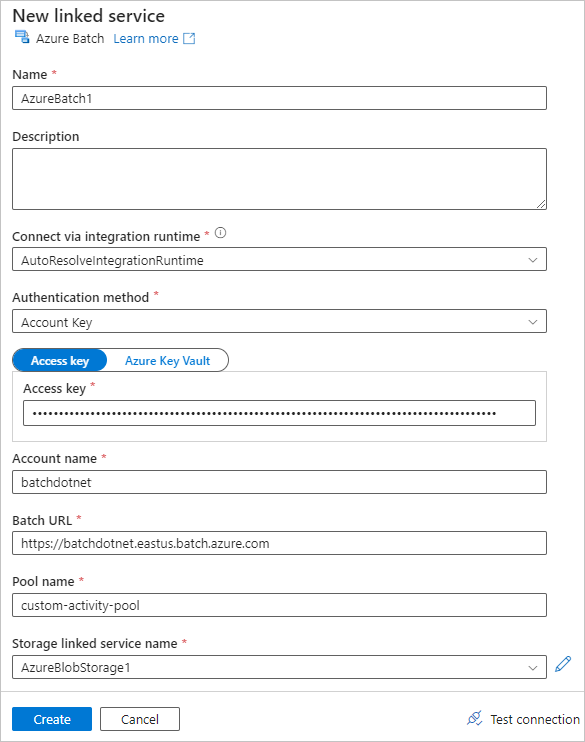

Selecione o separador Azure Batch, e depois selecione Novo.

Preencha o formulário Novo serviço vinculado da seguinte maneira:

- Nome: insira um nome para o serviço vinculado, como AzureBatch1.

- Chave de acesso: insira a chave de acesso primária que você copiou da sua conta do Batch.

- Nome da conta: Insira o nome da sua conta Batch.

-

URL do Batch: insere o ponto de extremidade da conta que copiaste da tua conta Batch, como

https://batchdotnet.eastus.batch.azure.com. - Nome do pool: insira custom-activity-pool, o pool que você criou no Batch Explorer.

- Nome do serviço vinculado à conta de armazenamento: selecione Novo. Na tela seguinte, insira um Nome para o serviço de armazenamento vinculado, como AzureBlobStorage1, selecione sua assinatura do Azure e conta de armazenamento vinculada e selecione Criar.

Na parte inferior do ecrã Batch New linked service, selecione Test connection. Quando a conexão for bem-sucedida, selecione Criar.

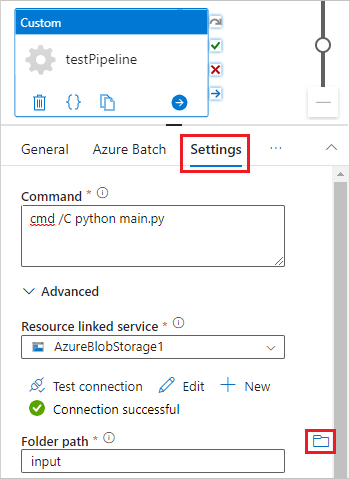

Selecione a guia Configurações e insira ou selecione as seguintes configurações:

-

Comando: Digite

cmd /C python main.py. - Serviço vinculado a recursos: selecione o serviço de armazenamento vinculado que você criou, como AzureBlobStorage1, e teste a conexão para garantir que ela seja bem-sucedida.

- Caminho da pasta: Selecione o ícone da pasta e, em seguida, selecione o contêiner de entrada e selecione OK. Os arquivos desta pasta são baixados do contêiner para os nós do pool antes que o script Python seja executado.

-

Comando: Digite

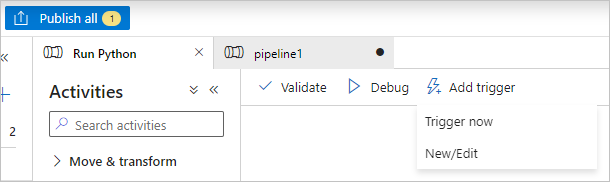

Para validar o pipeline, selecione Validar na barra de ferramentas do pipeline.

Selecione Depurar para testar o pipeline e garantir que ele funcione corretamente.

Selecione Publicar tudo para publicar a linha de produção.

Selecione Adicionar gatilho e, em seguida, selecione Acionar agora para executar o pipeline ou Novo/Editar para agendar.

Usar o Batch Explorer para exibir arquivos de log

Se a execução do pipeline produzir avisos ou erros, você poderá usar o Batch Explorer para examinar os arquivos de saída stdout.txt e stderr.txt para obter mais informações.

- No Batch Explorer, selecione Jobs na barra lateral esquerda.

- Selecione o trabalho adfv2-custom-activity-pool.

- Selecione uma tarefa que tenha um código de saída de falha.

- Veja os ficheiros stdout.txt e stderr.txt para investigar e diagnosticar o seu problema.

Limpar recursos

Contas em lote, trabalhos e tarefas são gratuitos, mas os nós de computação incorrem em cobranças mesmo quando não estão executando trabalhos. É melhor alocar grupos de nós apenas conforme necessário e apagar os grupos quando terminar de usá-los. A eliminação dos pools apaga toda a saída de tarefas nos nós e os próprios nós.

Os arquivos de entrada e saída permanecem na conta de armazenamento e podem incorrer em encargos. Quando você não precisar mais dos arquivos, poderá excluí-los ou contêineres. Quando não precisar mais da sua conta do Batch ou da conta de armazenamento vinculada, você poderá excluí-los.

Próximos passos

Neste tutorial, você aprendeu como usar um script Python com o Batch Explorer, o Storage Explorer e o Data Factory para executar uma carga de trabalho em lote. Para obter mais informações sobre o Data Factory, consulte O que é o Azure Data Factory?