Copie dados e transforme com parâmetros dinâmicos de hora em hora

APLICA-SE A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Gorjeta

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange tudo, desde a movimentação de dados até ciência de dados, análises em tempo real, business intelligence e relatórios. Saiba como iniciar uma nova avaliação gratuitamente!

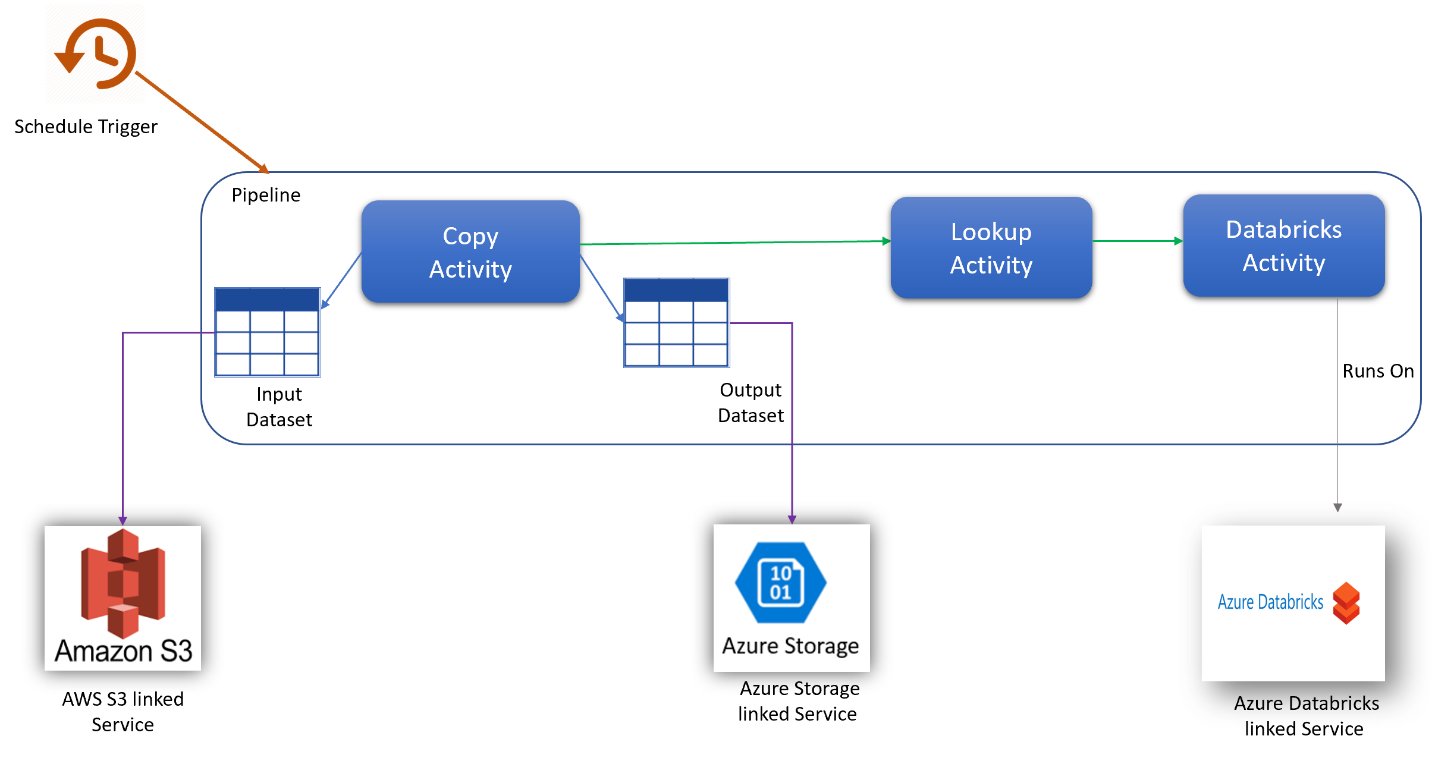

Nesse cenário, você deseja copiar dados do AWS S3 para o armazenamento de Blob do Azure e transformar com o Azure Databricks (com parâmetros dinâmicos no script) em uma programação horária por 8 horas todos os dias durante 30 dias.

Os preços utilizados neste exemplo abaixo são hipotéticos e não se destinam a implicar preços reais exatos. Os custos de leitura/escrita e monitorização não são apresentados, uma vez que são normalmente negligenciáveis e não terão um impacto significativo nos custos globais. As execuções de atividade também são arredondadas para os 1000 mais próximos nas estimativas da calculadora de preços.

Consulte a Calculadora de Preços do Azure para cenários mais específicos e para estimar seus custos futuros para usar o serviço.

Configuração

Para realizar o cenário, você precisa criar um pipeline com os seguintes itens:

- Uma atividade de cópia com um conjunto de dados de entrada para os dados a serem copiados do AWS S3, um conjunto de dados de saída para os dados no armazenamento do Azure.

- Uma atividade de pesquisa para passar parâmetros dinamicamente para o script de transformação.

- Uma atividade do Azure Databricks para a transformação de dados.

- Um gatilho de agendamento para executar o pipeline a cada hora durante 8 horas por dia. Quando quiser executar um pipeline, você pode acioná-lo imediatamente ou agendá-lo. Além do pipeline em si, cada instância de gatilho conta como uma única execução de atividade.

Estimativa de custos

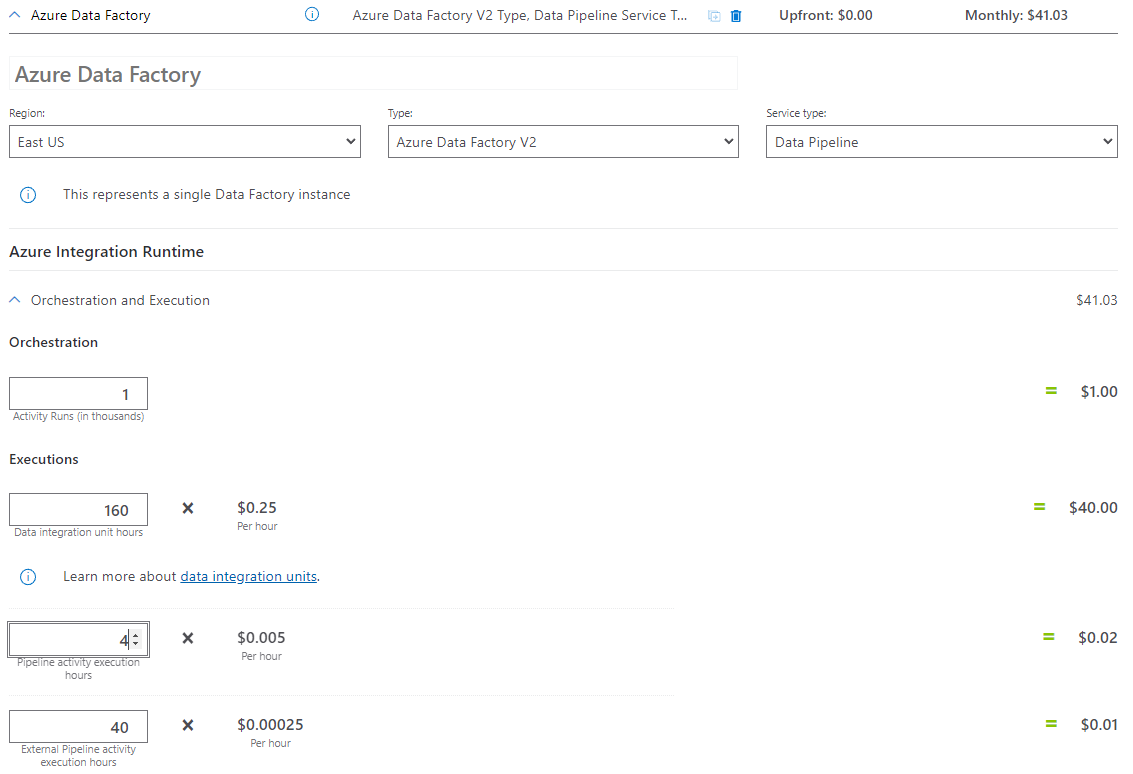

| Operações | Tipos e Unidades |

|---|---|

| Executar pipeline | 4 execuções de atividade por execução (1 para execução de gatilho, 3 para execuções de atividade) = 960 execuções de atividade, arredondadas para cima, uma vez que a calculadora só permite incrementos de 1000. |

| Suposição de dados de cópia: horas DIU por execução = 10 min | 10 min \ 60 min * 4 Azure Integration Runtime (configuração DIU padrão = 4) Para obter mais informações sobre unidades de integração de dados e otimização do desempenho da cópia, consulte este artigo |

| Executar atividade de pesquisa Suposição: horas de atividade de pipeline por execução = 1 min | 1 min / 60 min Execução da atividade de pipeline |

| Executar atividade Databricks Suposição: horas de execução externa por execução = 10 min | 10 min / 60 min Execução da atividade de pipeline externo |

Exemplo de definição de preço: Exemplo de calculadora de preços

Preço total do cenário para 30 dias: $41.03

Conteúdos relacionados

- Exemplo de definição de preço: copie dados do AWS S3 para o armazenamento de Blob do Azure por hora por 30 dias

- Exemplo de definição de preço: copie dados e transforme com o Azure Databricks de hora em hora por 30 dias

- Exemplo de preços: Executar pacotes SSIS no tempo de execução de integração Azure-SSIS

- Exemplo de definição de preço: Usando a depuração de fluxo de dados de mapeamento para um dia de trabalho normal

- Exemplo de definição de preço: transformar dados no armazenamento de blob com fluxos de dados de mapeamento

- Exemplo de preços: Integração de dados na VNET gerenciada do Azure Data Factory

- Exemplo de definição de preço: Obter dados delta do SAP ECC via SAP CDC no mapeamento de fluxos de dados

Comentários

Brevemente: Ao longo de 2024, vamos descontinuar progressivamente o GitHub Issues como mecanismo de feedback para conteúdos e substituí-lo por um novo sistema de feedback. Para obter mais informações, veja: https://aka.ms/ContentUserFeedback.

Submeter e ver comentários