Exemplo de definição de preço: Obter dados delta do SAP ECC via SAP CDC no mapeamento de fluxos de dados

APLICA-SE A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Gorjeta

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange tudo, desde a movimentação de dados até ciência de dados, análises em tempo real, business intelligence e relatórios. Saiba como iniciar uma nova avaliação gratuitamente!

Nesse cenário, você deseja obter alterações delta de uma tabela no SAP ECC por meio do conector SAP CDC, fazer algumas transformações necessárias em voo e, em seguida, gravar dados no armazenamento do Azure Data Lake Gen2 no fluxo de dados de mapeamento do ADF diariamente. Calcularemos os preços para execução em um cronograma uma vez por hora durante 8 horas durante 30 dias.

Os preços usados neste exemplo abaixo são hipotéticos e não pretendem implicar preços reais exatos. Os custos de leitura/gravação e monitoramento não são mostrados, pois normalmente são insignificantes e não afetam significativamente os custos gerais. As execuções de atividade também são arredondadas para os 1000 mais próximos nas estimativas da calculadora de preços.

Consulte a Calculadora de Preços do Azure para cenários mais específicos e para estimar seus custos futuros para usar o serviço.

Configuração

Para realizar o cenário, você precisa criar um pipeline com os seguintes itens:

- Uma atividade de Fluxo de Dados de Mapeamento com um conjunto de dados de entrada para os dados a serem carregados do SAP ECC, a lógica de transformação e um conjunto de dados de saída para os dados no armazenamento do Azure Data Lake Gen2.

- Um Self-Hosted Integration Runtime referenciado ao conector SAP CDC.

- Um gatilho de agendamento para executar o pipeline. Quando quiser executar um pipeline, você pode acioná-lo imediatamente ou agendá-lo. Além do pipeline em si, cada instância de gatilho conta como uma única execução de atividade.

Estimativa de custos

Para carregar dados do SAP ECC por meio do conector SAP CDC no Mapping Data Flow, você precisa instalar seu Self-Hosted Integration Runtime em uma máquina local ou VM para se conectar diretamente ao seu sistema SAP ECC. Dado isso, você será cobrado no Self-Hosted Integration Runtime com US$ 0,10/hora e no Mapping Data Flow com sua unidade de preço vCore-hour.

Supondo que cada vez que são necessários 15 minutos para concluir o trabalho, as estimativas de custo são as seguintes.

| Operações | Tipos e Unidades |

|---|---|

| Executar pipeline | 2 Execuções de atividade por execução (1 para execução de gatilho, 1 para execução de atividade) = 480, arredondado para cima, uma vez que a calculadora só permite incrementos de 1000. |

| Fluxo de dados: horas de execução de computação geral com 8 núcleos por execução = 15 minutos | 15 min / 60 min |

| Self-Hosted Integration Runtime: horas de execução de movimentação de dados60 por execução = 15 minutos | 15 min / 60 min |

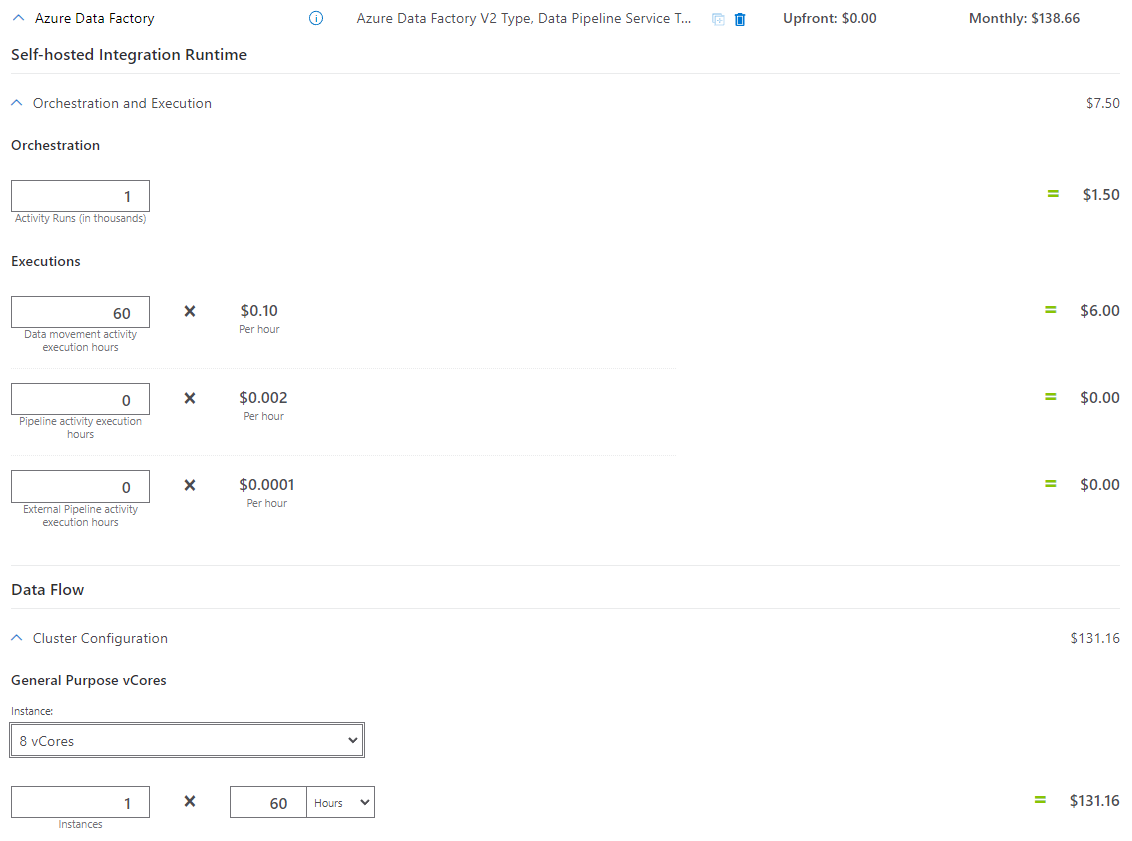

Exemplo de calculadora de preços

Preço total do cenário para 30 dias: $138.66

Conteúdos relacionados

- Exemplo de definição de preço: copie dados do AWS S3 para o armazenamento de Blob do Azure por hora por 30 dias

- Exemplo de definição de preço: copie dados e transforme com o Azure Databricks de hora em hora por 30 dias

- Exemplo de definição de preço: copie dados e transforme com parâmetros dinâmicos de hora em hora por 30 dias

- Exemplo de preços: Executar pacotes SSIS no tempo de execução de integração Azure-SSIS

- Exemplo de definição de preço: Usando a depuração de fluxo de dados de mapeamento para um dia de trabalho normal

- Exemplo de definição de preço: transformar dados no armazenamento de blob com fluxos de dados de mapeamento

- Exemplo de preços: Integração de dados na VNET gerenciada do Azure Data Factory