Tamanhos de máquinas virtuais da série HBv2

Aplica-se a: ✔️ VMs ✔️ Linux VMs ✔️ do Windows Conjuntos ✔️ de escala flexíveis Conjuntos de balanças uniformes

Vários testes de desempenho foram executados em VMs de tamanho da série HBv2. Seguem-se alguns dos resultados deste teste de desempenho.

| Carga de trabalho | HBv2 |

|---|---|

| Tríade STREAM | 350 GB/s (21-23 GB/s por CCX) |

| Linpack de alto desempenho (HPL) | 4 TeraFLOPS (Rpeak, FP64), 8 TeraFLOPS (Rmax, FP32) |

| Latência RDMA & largura de banda | 1,2 microssegundos, 190 Gb/s |

| FIO em SSD NVMe local | 2,7 GB/s de leitura, 1,1 GB/s de gravação; 102k IOPS lê, 115 IOPS grava |

| IOR em 8 * SSD Premium do Azure (P40 Managed Disks, RAID0)** | 1,3 GB/s de leitura, 2,5 GB/gravações; 101k IOPS lê, 105k IOPS grava |

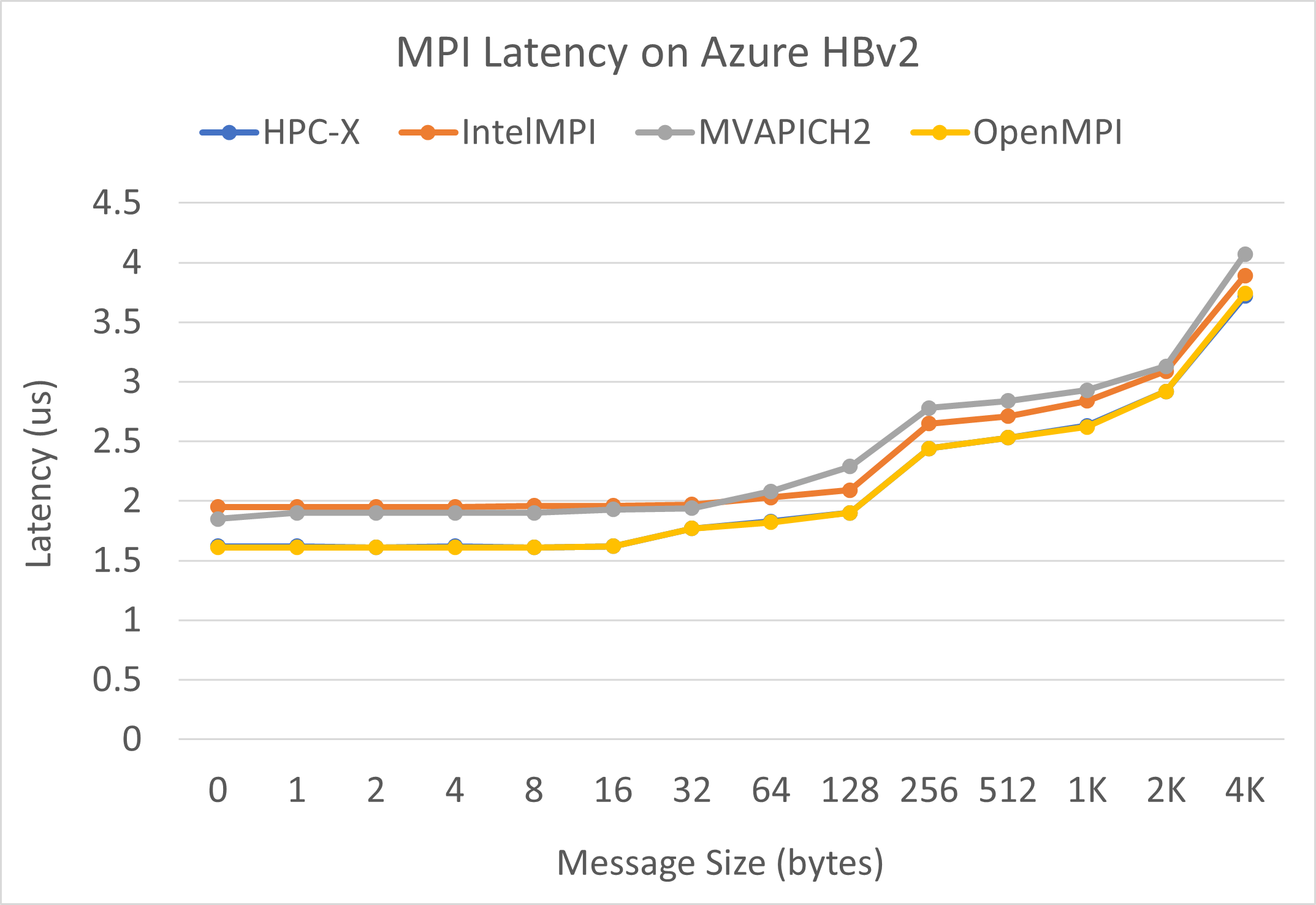

Latência do IPM

O teste de latência MPI do conjunto de microbenchmark OSU é executado. Os scripts de exemplo estão no GitHub.

./bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./osu_latency

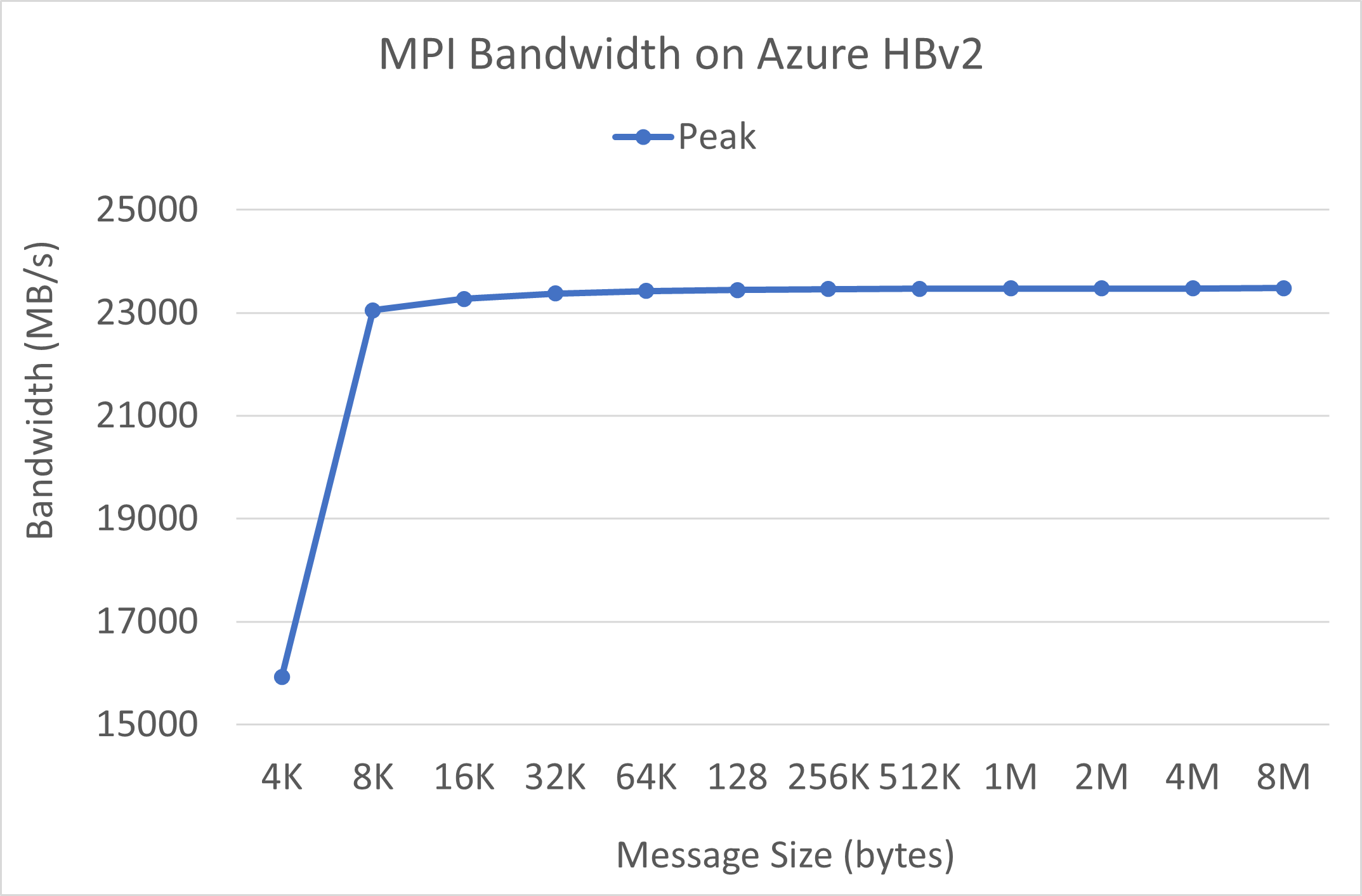

Largura de banda MPI

O teste de largura de banda MPI do pacote de microbenchmark OSU é executado. Os scripts de exemplo estão no GitHub.

./mvapich2-2.3.install/bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./mvapich2-2.3/osu_benchmarks/mpi/pt2pt/osu_bw

Mellanox Perftest

O pacote Mellanox Perftest tem muitos testes InfiniBand, como latência (ib_send_lat) e largura de banda (ib_send_bw). Um exemplo de comando está abaixo.

numactl --physcpubind=[INSERT CORE #] ib_send_lat -a

Próximos passos

- Leia sobre os anúncios mais recentes, exemplos de carga de trabalho HPC e resultados de desempenho nos Blogs da Comunidade de Tecnologia de Computação do Azure.

- Para obter uma exibição de arquitetura de nível mais alto da execução de cargas de trabalho HPC, consulte Computação de alto desempenho (HPC) no Azure.