Nota

O acesso a esta página requer autorização. Podes tentar iniciar sessão ou mudar de diretório.

O acesso a esta página requer autorização. Podes tentar mudar de diretório.

Este artigo mostra como criar pools personalizados do Apache Spark no Microsoft Fabric para suas cargas de trabalho de análise. Os pools do Apache Spark permitem que você crie ambientes de computação personalizados com base em suas necessidades, para que você obtenha o melhor desempenho e uso de recursos.

Especifique os nós mínimo e máximo para dimensionamento automático. O sistema adiciona e desativa nós à medida que as necessidades de computação do seu trabalho mudam, tornando o dimensionamento eficiente e melhorando o desempenho. Os pools de faíscas ajustam o número de executores automaticamente, para que você não precise configurá-los manualmente. O sistema altera a contagem de executores com base no volume de dados e nas necessidades de computação das tarefas, para que se possa concentrar nas suas cargas de trabalho em vez de ajuste de desempenho e gerenciamento de recursos.

Sugestão

Quando você configura pools do Spark, o tamanho do nó é determinado pelas Unidades de Capacidade (), que representam a capacidade de computação atribuída a cada nó. Para obter mais informações sobre tamanhos de nó e UC, consulte a seção Opções de tamanho de nó neste guia.

Pré-requisitos

Para criar um pool do Spark personalizado, verifique se você tem acesso de administrador ao espaço de trabalho. O administrador de capacidade habilita a opção Pools de espaços de trabalho personalizados na seção Computação do Spark das configurações do administrador de capacidade. Para obter mais informações, consulte Configurações de computação do Spark para capacidades de malha.

Criar pools Spark personalizados

Para criar ou gerenciar o pool do Spark associado ao seu espaço de trabalho:

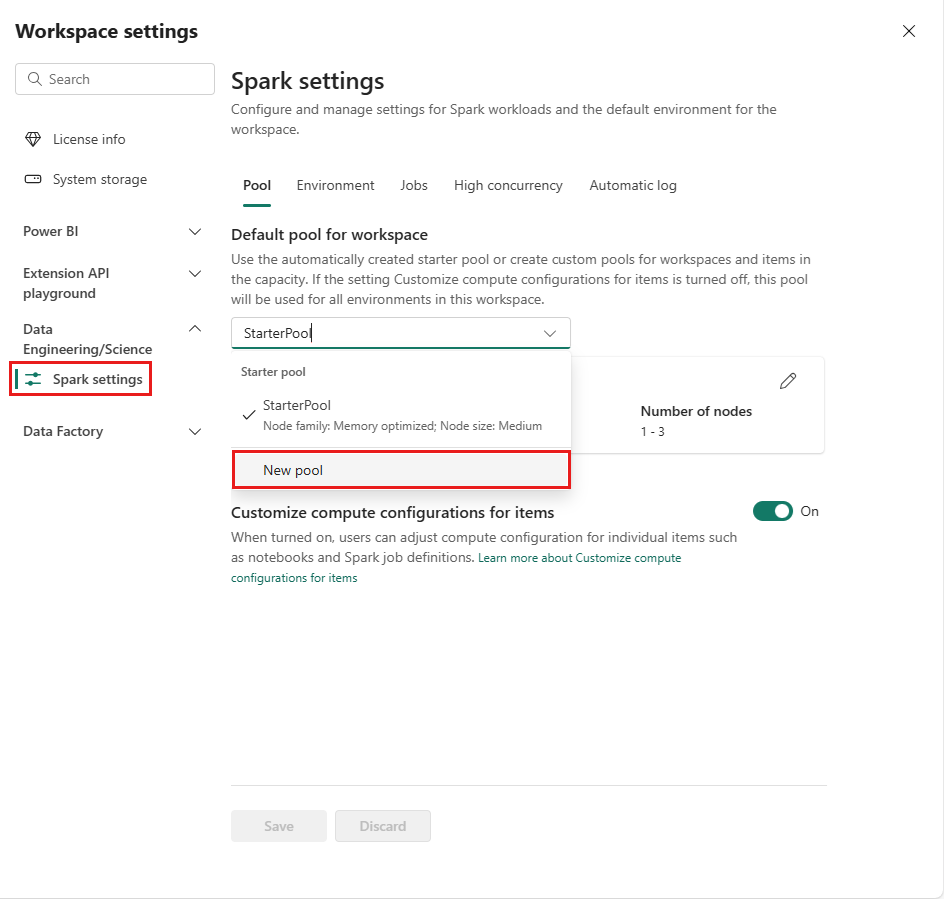

Vá para o seu espaço de trabalho e selecione Configurações do espaço de trabalho.

Selecione a opção de Engenharia/Ciência de Dados para expandir o menu e, em seguida, selecione Configurações do Spark.

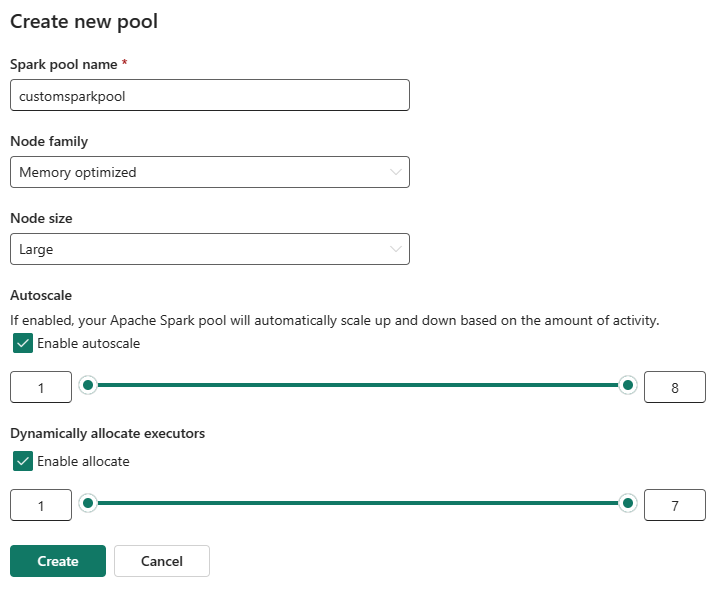

Selecione a opção New Pool. No ecrã Criar Pool, nomeie o seu pool do Spark. Escolha também a família de

nós e selecione um tamanho de nóentre os tamanhos disponíveis ( Small ,Medium ,Large ,X-Large eXX-Large ) com base nos requisitos de computação para as suas cargas de trabalho.Você pode definir a configuração mínima do nó para seus pools personalizados como 1. Como o Fabric Spark fornece disponibilidade restaurável para clusters com um único nó, não é necessário preocupar-se com falhas de tarefas, perda de sessão durante falhas ou excesso de custos com computação para tarefas menores do Spark.

Você pode habilitar ou desabilitar o dimensionamento automático para seus pools Spark personalizados. Quando o dimensionamento automático estiver habilitado, o pool adquirirá dinamicamente novos nós até o limite máximo de nós especificado pelo usuário e, em seguida, os desativará após a execução do trabalho. Esse recurso garante um melhor desempenho ajustando os recursos com base nos requisitos do trabalho. Você está autorizado a dimensionar os nós, que se encaixam nas unidades de capacidade adquiridas como parte do SKU de capacidade do Fabric.

Você pode ajustar o número de executores usando um controle deslizante. Cada executor é um processo do Spark que executa tarefas e mantém dados na memória. O aumento dos executores pode melhorar o paralelismo, mas também aumenta o tamanho e o tempo de inicialização do cluster. Você também pode optar por habilitar a alocação dinâmica de executores para seu pool do Spark, que determina automaticamente o número ideal de executores dentro do limite máximo especificado pelo usuário. Esse recurso ajusta o número de executores com base no volume de dados, resultando em melhor desempenho e utilização de recursos.

Esses pools personalizados têm uma duração de pausa automática padrão de 2 minutos após o período de inatividade ter expirado. Quando a duração da pausa automática é atingida, a sessão expira e os clusters são desalocados. Você é cobrado com base no número de nós e na duração durante a qual os pools Spark personalizados são usados.

Observação

Atualmente, os pools Spark personalizados no Microsoft Fabric oferecem suporte a um limite máximo de 200 nós. Ao configurar o dimensionamento automático ou definir contagens manuais de nós, certifique-se de que os valores mínimo e máximo permaneçam dentro desse limite. Exceder esse limite resultará em erros de validação durante a criação ou atualização do pool.

Opções de tamanho do nó

Ao configurar um pool de faíscas personalizado, você escolhe entre os seguintes tamanhos de nó:

| Tamanho do nó | vCores | Memória (GB) | Descrição |

|---|---|---|---|

| Pequeno | 4 | 32 | Para trabalhos leves de desenvolvimento e teste. |

| Médio | 8 | 64 | Para cargas de trabalho gerais e operações típicas. |

| Grande | 16 | 128 | Para tarefas que consomem muita memória ou grandes trabalhos de processamento de dados. |

| X-Grande | 32 | 256 | Para as cargas de trabalho mais exigentes do Spark que precisam de recursos significativos. |

Conteúdo relacionado

- Saiba mais na documentação pública do Apache Spark .

- Introdução às configurações de administração do espaço de trabalho Spark no Microsoft Fabric.