O que é o Data Factory no Microsoft Fabric?

O Data Factory permite que você tenha uma experiência moderna de integração de dados para ingerir, preparar e transformar dados de um rico conjunto de fontes de dados (por exemplo, bancos de dados, data warehouse, Lakehouse, dados em tempo real e muito mais). Se você é um cidadão ou desenvolvedor profissional, você será capaz de transformar os dados com transformações inteligentes e alavancar um rico conjunto de atividades. Podemos criar pipelines para executar uma ou mais atividades, acessar fontes de dados ou serviços por meio de serviços vinculados e, depois de criar um pipeline, podemos adicionar gatilhos para executar automaticamente nossos processos em momentos específicos ou em resposta a cenários em mudança. Com o Data Factory no Microsoft Fabric, estamos trazendo recursos de cópia rápida (movimentação de dados) para fluxos de dados e pipelines de dados. Com o Fast Copy, você pode mover dados entre seus armazenamentos de dados favoritos de forma extremamente rápida. Mais importante ainda, o Fast Copy permite que você traga dados para o Lakehouse e o Data Warehouse no Microsoft Fabric para análise.

Há dois recursos principais de alto nível implementados pelo Data Factory: fluxos de dados e pipelines.

- Os fluxos de dados permitem que você aproveite mais de 300 transformações no designer de fluxos de dados, permitindo que você transforme dados mais facilmente e com mais flexibilidade do que qualquer outra ferramenta - incluindo transformações de dados inteligentes baseadas em IA.

- Os pipelines de dados permitem que você aproveite os recursos avançados de orquestração de dados prontos para uso para compor fluxos de trabalho de dados flexíveis que atendam às necessidades da sua empresa.

Fluxos de Dados

Os fluxos de dados fornecem uma interface low-code para a ingestão de dados de centenas de fontes de dados, transformando seus dados usando transformações de dados 300+. Em seguida, você pode carregar os dados resultantes em vários destinos, como bancos de dados SQL do Azure e muito mais. Os fluxos de dados podem ser executados repetidamente usando atualização manual ou agendada, ou como parte de uma orquestração de pipeline de dados.

Os fluxos de dados são criados usando a experiência familiar do Power Query que está disponível atualmente em vários produtos e serviços da Microsoft, como Excel, Power BI, Power Platform, aplicativos Dynamics 365 Insights e muito mais. O Power Query permite que todos os utilizadores, desde cidadãos a integradores de dados profissionais, realizem a ingestão e transformações de dados no seu património de dados. Execute junções, agregações, limpeza de dados, transformações personalizadas e muito mais, tudo a partir de uma interface do usuário fácil de usar, altamente visual e low-code.

Pipelines de dados

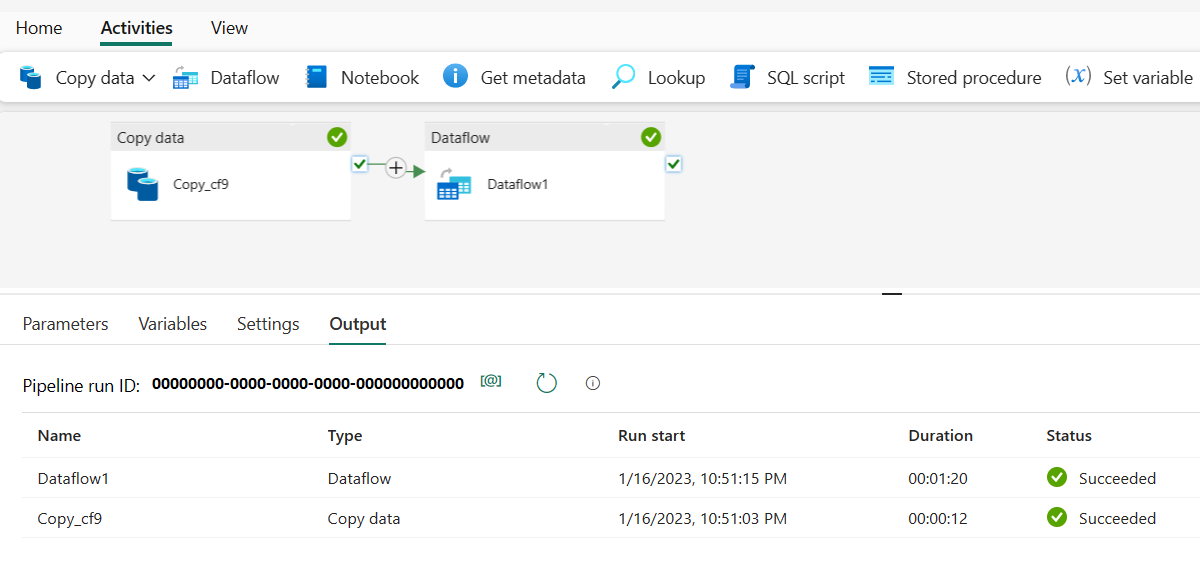

Os pipelines de dados permitem recursos poderosos de fluxo de trabalho em escala de nuvem. Com pipelines de dados, você pode criar fluxos de trabalho complexos que podem atualizar seu fluxo de dados, mover dados de tamanho PB e definir pipelines de fluxo de controle sofisticados.

Use pipelines de dados para criar fluxos de trabalho complexos de ETL e data factory que podem executar muitas tarefas diferentes em escala. Os recursos de fluxo de controle são incorporados em pipelines de dados que permitem criar lógica de fluxo de trabalho, que fornece loops e condicionais.

Adicione uma atividade de cópia orientada por configuração juntamente com sua atualização de fluxo de dados low-code em um único pipeline para um pipeline de dados ETL de ponta a ponta. Você pode até mesmo adicionar atividades code-first para Spark Notebooks, scripts SQL, procs armazenados e muito mais.

Conteúdos relacionados

Para começar a usar o Microsoft Fabric, vá para Guia de início rápido: crie seu primeiro Dataflow Gen2 para obter e transformar dados.

Comentários

Brevemente: Ao longo de 2024, vamos descontinuar progressivamente o GitHub Issues como mecanismo de feedback para conteúdos e substituí-lo por um novo sistema de feedback. Para obter mais informações, veja: https://aka.ms/ContentUserFeedback.

Submeter e ver comentários