Nota

O acesso a esta página requer autorização. Podes tentar iniciar sessão ou mudar de diretório.

O acesso a esta página requer autorização. Podes tentar mudar de diretório.

A IA generativa (GenAI) está sendo adotada a uma taxa sem precedentes à medida que as organizações se envolvem ativamente ou experimentam com a GenAI em várias capacidades. As equipes de segurança podem mitigar e gerenciar os riscos de forma mais eficaz, ganhando proativamente visibilidade sobre o uso de IA dentro da organização e implementando os controles correspondentes. Este artigo descreve como descobrir o uso de aplicativos de IA em sua organização, incluindo a avaliação do risco para seus dados confidenciais.

Este é o segundo artigo de uma série. Antes de usar este artigo, certifique-se de ter realizado as tarefas em Preparar para a segurança de IA para preparar seu ambiente com os recursos prescritos neste artigo.

A Microsoft fornece ferramentas para ajudá-lo a obter visibilidade sobre os riscos de dados, acesso, usuários e aplicativos para a IA que você cria e usa. Esses recursos ajudam você a resolver vulnerabilidades de forma proativa enquanto cria uma postura de segurança forte para a IA.

A tabela a seguir descreve a ilustração e também percorre as etapas de implementação desses recursos.

| Passo | Tarefa | Âmbito de aplicação |

|---|---|---|

| 1 | Obtenha visibilidade de todas as identidades de agente criadas no Microsoft Copilot Studio e no Azure AI Foundry com o Microsoft Entra Agent ID. | Agentes criados no Microsoft Copilot Studio e no Azure AI Foundry |

| 2 | Obtenha visibilidade sobre o uso de IA com o Microsoft Purview Data Security Posture Management (DSPM) para IA. Aplique políticas para proteger dados confidenciais. | Copilotos, agentes e outros aplicativos de IA que usam LLMs (módulos de linguagem grande) de terceiros, incluindo sites de IA suportados. |

| 3 | Descubra, sancione e bloqueie aplicativos de IA com o Microsoft Defender for Cloud Apps | Aplicativos SaaS AI |

| 4 | Descubra cargas de trabalho de IA implantadas em seu ambiente e obtenha informações de segurança com o Microsoft Defender for Cloud Security Posture Management (CSPM) | Aplicações personalizadas de IA construídas com a Azure AI |

Etapa 1 — Obtenha visibilidade sobre os agentes com o Entra Agent ID (Pré-visualização)

À medida que as organizações constroem e adotam agentes de IA, é um desafio acompanhar esses atores não humanos. O que torna esses agentes poderosos – sua capacidade de lidar de forma autônoma com tarefas complexas e agir como colegas de equipe virtuais – também levanta preocupações. É por isso que é fundamental rastrear as identidades dos agentes, gerenciar seu ciclo de vida e permissões e proteger cuidadosamente seu acesso aos recursos da sua organização.

O Microsoft Entra Agent ID (Preview) fornece um diretório unificado de todas as identidades de agente criadas no Microsoft Copilot Studio e no Azure AI Foundry. Este é um primeiro passo para proporcionar ainda maior visibilidade, proteção e governança do volume crescente de agentes nas organizações.

| Tarefa | Recursos recomendados |

|---|---|

| Ver todos os agentes na sua organização | entre no centro de administração do Microsoft Entra e navegue até Aplicativos corporativos. Na barra de filtros na parte superior da exibição de lista, defina a lista suspensa Tipo de aplicativo como ID do agente (Visualização). Instantaneamente, sua lista de aplicativos corporativos será reduzida para mostrar os agentes de IA (criados por meio do Copilot Studio ou do Azure AI Foundry) que estão registrados em seu locatário. |

| Saiba mais consultando este blog | Anunciando o Microsoft Entra Agent ID: Proteja e gerencie seus agentes de IA |

Etapa 2 — Obtenha visibilidade sobre o uso de IA com o Gerenciamento de Postura de Segurança de Dados (DSPM) para IA

O Microsoft Purview Data Security Posture Management (DSPM) para IA se concentra em como a IA é usada em sua organização, especialmente como seus dados interagem com as ferramentas de IA. Ele funciona com sites de IA generativa. O DSPM para IA fornece informações mais detalhadas para o Microsoft Copilots e aplicativos SaaS de terceiros, como o ChatGPT Enterprise e o Google Gemini.

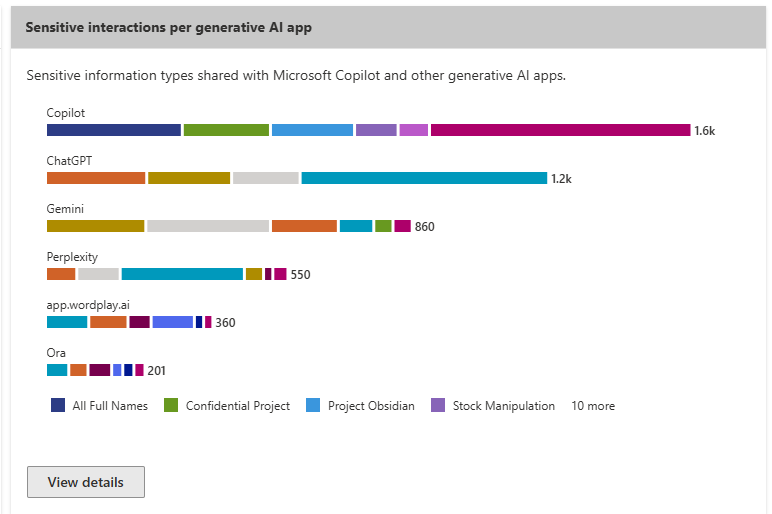

O diagrama a seguir mostra uma das visualizações agregadas sobre o impacto do uso da IA em seus dados — interações sensíveis por aplicativo de IA generativo.

O DSPM para IA oferece um conjunto de recursos que ajudam você a adotar IA com segurança sem ter que escolher entre produtividade e proteção:

- Insights e análises sobre a atividade de IA na sua organização

- Políticas prontas para uso para proteger dados e evitar a perda de dados em prompts de IA

- Avaliações de risco de dados para identificar, corrigir e monitorar o potencial compartilhamento excessivo de dados

- Ações recomendadas com base nos dados do seu inquilino

- Controles de conformidade para aplicar políticas ideais de tratamento e armazenamento de dados

Para monitorar interações com sites de IA de terceiros, os dispositivos devem ser integrados ao Microsoft Purview. Se você seguiu as orientações em Preparar para segurança de IA, inscreveu dispositivos no gerenciamento com o Microsoft Intune e, em seguida, integrou esses dispositivos ao Defender for Endpoint. A integração de dispositivos é compartilhada entre o Microsoft 365 (incluindo o Microsoft Purview) e o Microsoft Defender for Endpoint (MDE).

Use os recursos a seguir para descobrir aplicativos e dados de IA com o DSPM para IA.

| Tarefa | Recursos recomendados |

|---|---|

| Certifique-se de que os dispositivos estão integrados ao Microsoft Purview. | Se os dispositivos ainda não estiverem integrados ao Defender for Endpoint, há vários métodos para integrá-los. Consulte Integrar dispositivos Windows no Microsoft 365. |

| Entenda os pré-requisitos e como funciona o DSPM para IA | Considerações para implantar o Microsoft Purview Data Security Posture Management for AI |

| Comece a usar o DSPM para IA | Como usar o Gerenciamento de Postura de Segurança de Dados para IA |

| Rever sites de IA suportados | Sites de IA suportados pela Microsoft Purview para segurança de dados e proteções de conformidade |

Etapa 3 — Descubra, sancione e bloqueie aplicativos de IA com o Microsoft Defender for Cloud Apps

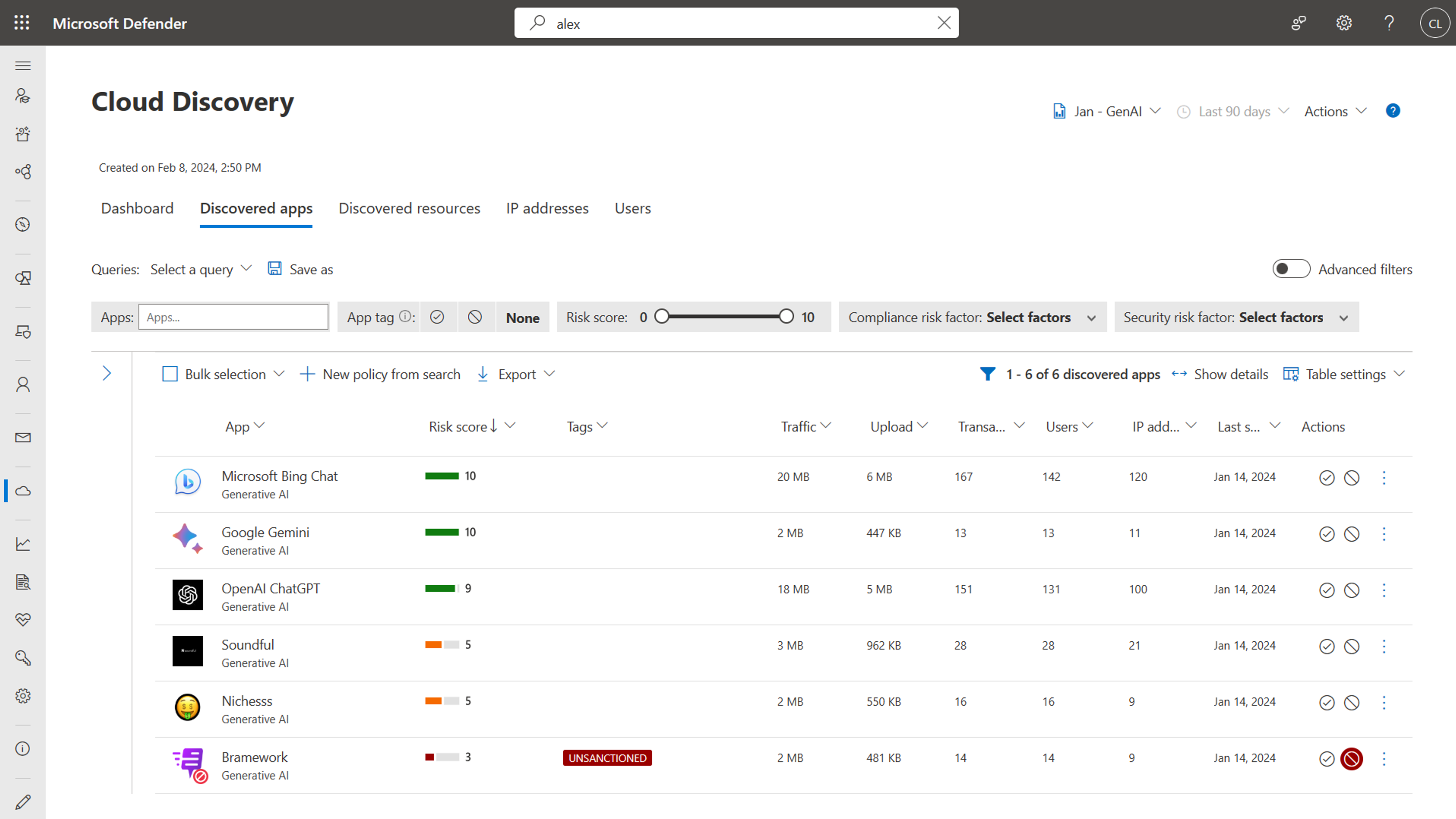

O Microsoft Defender for Cloud Apps ajuda as equipes de segurança a descobrir aplicativos e uso SaaS GenAI.

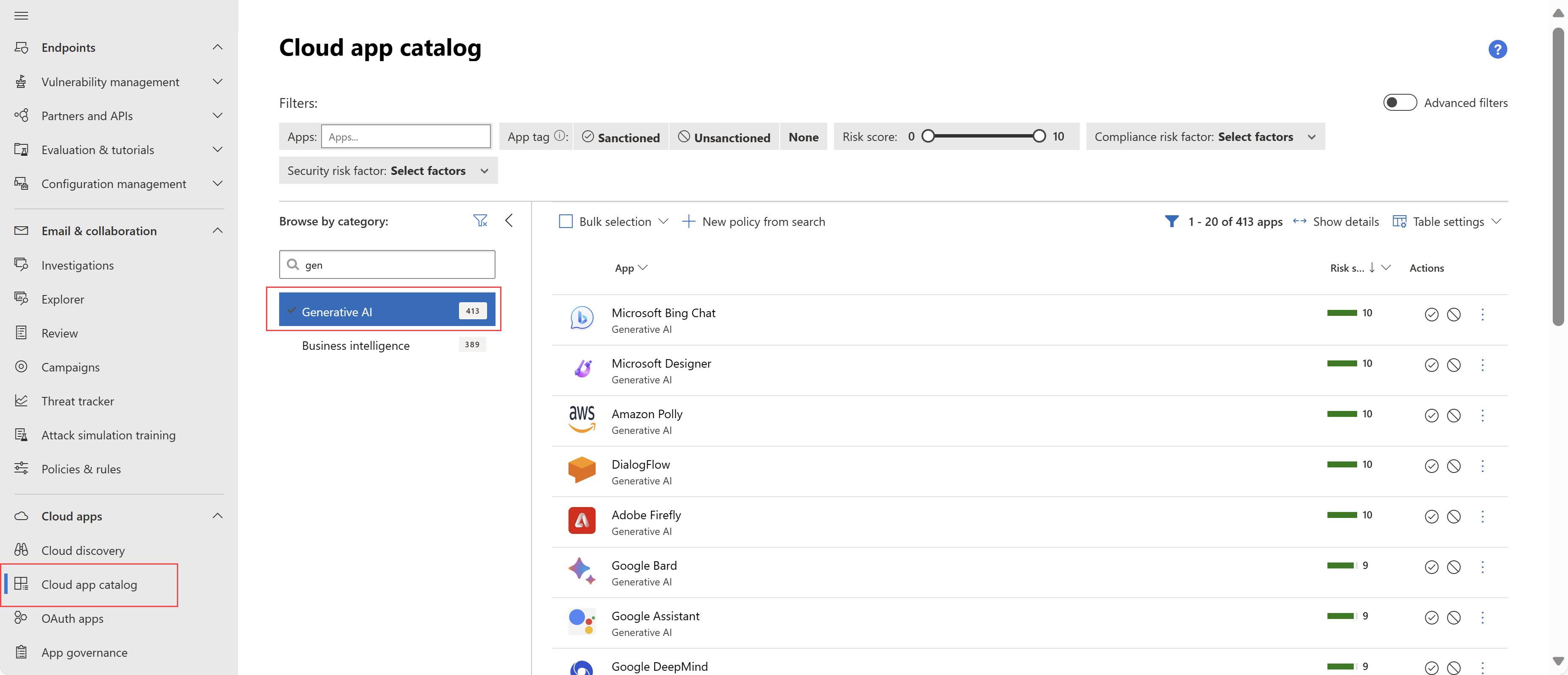

O catálogo de aplicativos do Defender for Cloud Apps inclui uma categoria de IA generativa para aplicativos LLM (modelo de linguagem grande), como Microsoft Bing Chat, Google Bard, ChatGPT e muito mais. O Defender for Cloud Apps adicionou mais de mil aplicativos generativos relacionados à IA ao catálogo, fornecendo visibilidade sobre como os aplicativos de IA generativa são usados em sua organização e ajudando você a gerenciá-los com segurança.

Com o Defender for Cloud Apps, você pode:

- Filtrar em aplicativos de IA generativa

- Descubra os aplicativos de IA que são usados em sua organização

- Veja avaliações de risco prontas para uso para cada aplicativo, incluindo 90+ fatores de risco em conformidade regulatória e de segurança

- Sancionar ou não sancionar (bloquear) o uso de aplicações específicas

- Crie políticas que continuem a descobrir aplicativos de IA com base nos critérios definidos, incluindo pontuação de risco, número de usuários por dia e outros. Você pode até mesmo cancelar automaticamente a sanção de aplicativos que atendem aos critérios.

Use os recursos a seguir para as próximas etapas.

| Tarefa | Recursos recomendados |

|---|---|

| Pilote e implante o Defender for Cloud Apps | Como faço para testar e implantar o Microsoft Defender for Cloud Apps? |

| Reveja este vídeo tutorial | Descubra quais aplicativos de IA generativa são usados em seu ambiente usando o Defender for Cloud Apps |

| Ver aplicações descobertas | Ver aplicações descobertas com o painel de deteção na nuvem |

| Encontre seu aplicativo na nuvem e calcule a pontuação de risco | Catálogo de aplicativos na nuvem e pontuações de risco - Microsoft Defender for Cloud Apps |

| Governar aplicações detetadas | Governar aplicativos descobertos - Microsoft Defender for Cloud Apps |

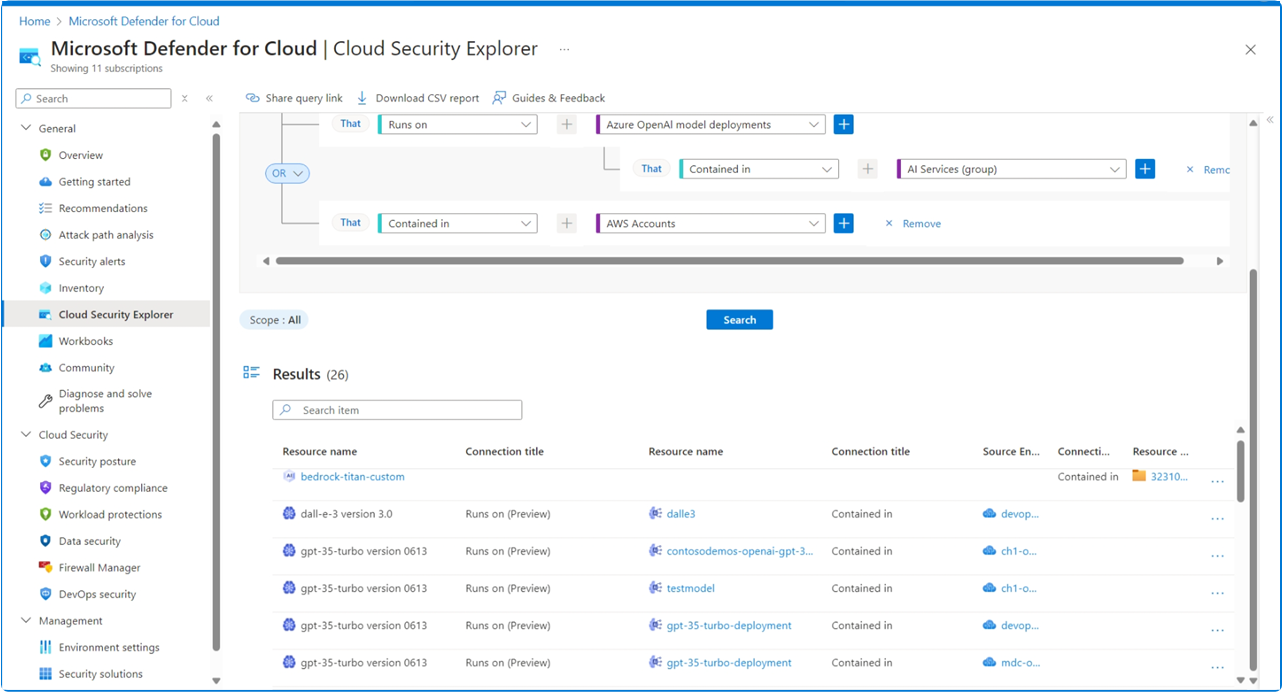

Etapa 4 — Descubra cargas de trabalho de IA implantadas em seu ambiente e obtenha informações de segurança com o Microsoft Defender for Cloud

O plano Defender Cloud Security Posture Management (CSPM) no Microsoft Defender for Cloud fornece recursos de gerenciamento de postura de segurança de IA, começando com a descoberta de aplicativos de IA criados em seus ambientes:

- Descobrindo o Guia de Materiais de IA Generativa (AI BOM), que inclui componentes de aplicativos, dados e artefatos de IA, desde o código até a nuvem.

- Fortalecer a postura de segurança de aplicativos de IA generativa com recomendações integradas e explorando e remediando riscos de segurança.

- Usando a análise de caminho de ataque para identificar e remediar riscos.

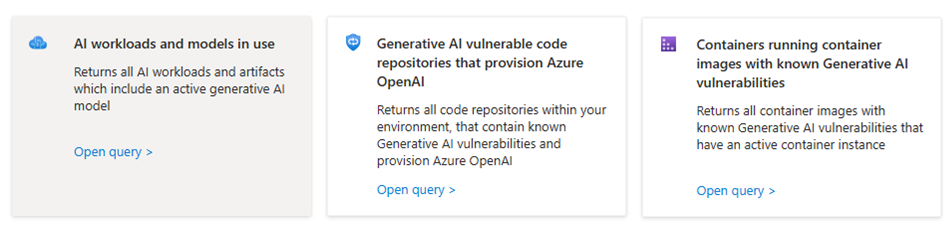

Use o explorador de segurança na nuvem para identificar cargas de trabalho de IA generativas e modelos em execução em seu ambiente. O explorador de segurança na nuvem inclui consultas pré-configuradas:

- Cargas de trabalho e modelos de IA em uso

- Repositórios de código vulneráveis à IA generativa que provisionam o Azure OpenAI

- Contêineres que executam imagens de contêiner com vulnerabilidades conhecidas de IA generativa.

Você também pode configurar suas próprias consultas.

Use os recursos a seguir para as próximas etapas.

| Tarefa | Recursos recomendados |

|---|---|

| Saiba mais sobre o gerenciamento de postura de segurança de IA | Gerenciamento de postura de segurança de IA com o Defender for Cloud |

| Descubra cargas de trabalho de IA | Cargas de trabalho e modelos de IA em uso |

| Explore os riscos para os artefatos de IA generativa em pré-implantação | Riscos para artefatos de inteligência artificial generativa antes da implementação |

Próximo passo para proteger a IA

Depois de descobrir o uso de IA em sua organização, o próximo passo é aplicar proteções:

- Proteja dados confidenciais usados com aplicativos de IA

- Implementar proteção contra ameaças especificamente para uso de IA

Veja o próximo artigo desta série: Como protejo minha organização ao usar aplicativos de IA?