Čo je výpočet Apache Spark v službe Microsoft Fabric?

Vzťahuje sa na:✅ Dátový inžinier a dátovú vedu v službe Microsoft Fabric

Prostredie služby Microsoft Fabric Dátový inžinier ing a dátovej vedy funguje na plne spravovanej výpočtovej platforme Apache Spark. Táto platforma je navrhnutá tak, aby poskytovala jedinečnú rýchlosť a efektivitu. S štartovacími bazénmi môžete očakávať rýchlu inicializáciu relácie Apache Spark, zvyčajne do 5 až 10 sekúnd bez nutnosti manuálneho nastavenia. Tiež získate flexibilitu na prispôsobenie bazénov Apache Spark podľa špecifických požiadaviek dátového inžinierstva a dátovej vedy. Platforma umožňuje optimalizovanú a prispôsobenú analýzu.

Úvodné bazény

Štartovacie bazény predstavujú rýchly a jednoduchý spôsob, ako v priebehu niekoľkých sekúnd použiť službu Spark na platforme Microsoft Fabric. Relácie služby Spark môžete použiť okamžite namiesto toho, aby ste čakali, kým vám Spark nastaví uzly, čo vám pomôže urobiť viac s údajmi a rýchlejšie získať prehľady.

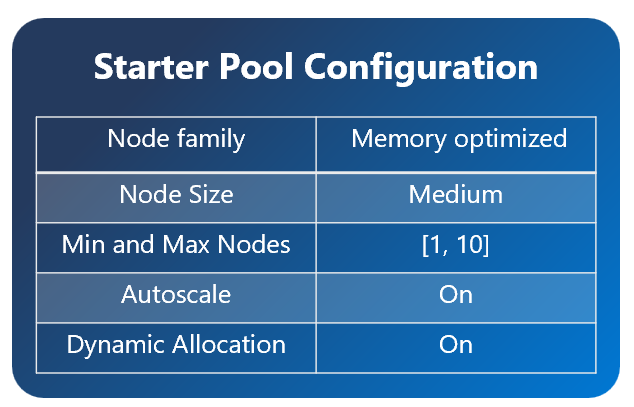

Úvodné bazény majú klastre Apache Spark, ktoré sú vždy zapnuté a pripravené pre vaše požiadavky. Používajú stredne veľké uzly, ktoré sa dynamicky zväčšujú na základe vašich potrieb práce v službe Spark.

Úvodné fondy majú tiež predvolené nastavenia, ktoré vám umožnia rýchlo nainštalovať knižnice bez spomalenia času spustenia relácie. Ak však chcete z nastavení pracovného priestoru alebo kapacity použiť ďalšie vlastné vlastnosti alebo knižnice Apache Spark, uzly vám však trvá dlhšie. Pokiaľ ide o fakturáciu a spotrebu kapacity, za spotrebu kapacity sa účtujú poplatky, keď začnete vykonávať svoj notebook alebo definíciu práce v službe Apache Spark. Za čas, kedy sú klastre nečinné vo fonde, sa vám nebudú účtovať poplatky.

Ak napríklad odošlete úlohu poznámkového bloku do úvodného fondu, účtuje sa len za časové obdobie, počas ktorého je aktívna relácia poznámkového bloku. Fakturovaný čas nezahŕňa nečinný čas ani čas potrebný na prispôsobenie relácie pomocou kontextu služby Spark.

Bazény Spark

Fond spark je spôsob, ako službe Spark povedať, aký druh zdrojov potrebujete pre svoje úlohy analýzy údajov. Svoj fond Spark môžete pomenovať a vybrať si, koľko a koľko uzlov (pracovné počítače) sú veľké. Službe Spark môžete tiež oznámiť, ako upraviť počet uzlov v závislosti od toho, koľko práce máte. Vytvorenie fondu Spark je bezplatné. Platíte len vtedy, keď spustíte úlohu Spark v bazéne, a potom Spark nastaví uzly za vás.

Ak svoj fond Spark nepoužívate počas 2 minút po uplynutí relácie, váš fond spark sa zruší. Toto predvolené časové obdobie uplynutia platnosti relácie je nastavené na 20 minút a môžete ho podľa potreby zmeniť. Ak ste správcom pracovného priestoru, môžete pre svoj pracovný priestor vytvoriť aj vlastné fondy spark a nastaviť ich ako predvolenú pre ostatných používateľov. Týmto spôsobom môžete ušetriť čas a vyhnúť sa nastaveniu nového fondu Spark zakaždým, keď spustíte poznámkový blok alebo úlohu Spark. Spustenie vlastných bazénov služby Spark trvá približne tri minúty, pretože služba Spark musí získať uzly zo služby Azure.

Môžete dokonca vytvoriť bazény Spark s jedným uzlom nastavením minimálneho počtu uzlov na jeden, takže ovládač a spustiteľný súbor sa spustí v jednom uzle, ktorý je dodávaný s regenerovateľným ha a je vhodný pre malé vyťaženia.

Veľkosť a počet uzlov, ktoré môžete mať vo vlastnom fonde spark, závisí od kapacity služby Microsoft Fabric. Kapacita je miera výpočtového výkonu, ktorý môžete použiť v Azure. Jedným zo spôsobov, ako si to predstaviť, je, že dve apache Spark VCores (jednotka výpočtového výkonu pre Spark) sa rovná jednej kapacitnej jednotke. Napríklad kapacita služby Fabric SKU F64 má 64 kapacitných jednotiek, čo zodpovedá 128 jednotkám Spark VCores. Tieto virtuálne jadrá služby Spark môžete použiť na vytvorenie uzlov rôznych veľkostí pre vlastný fond Spark, ak celkový počet spark vcores nepresiahne 128.

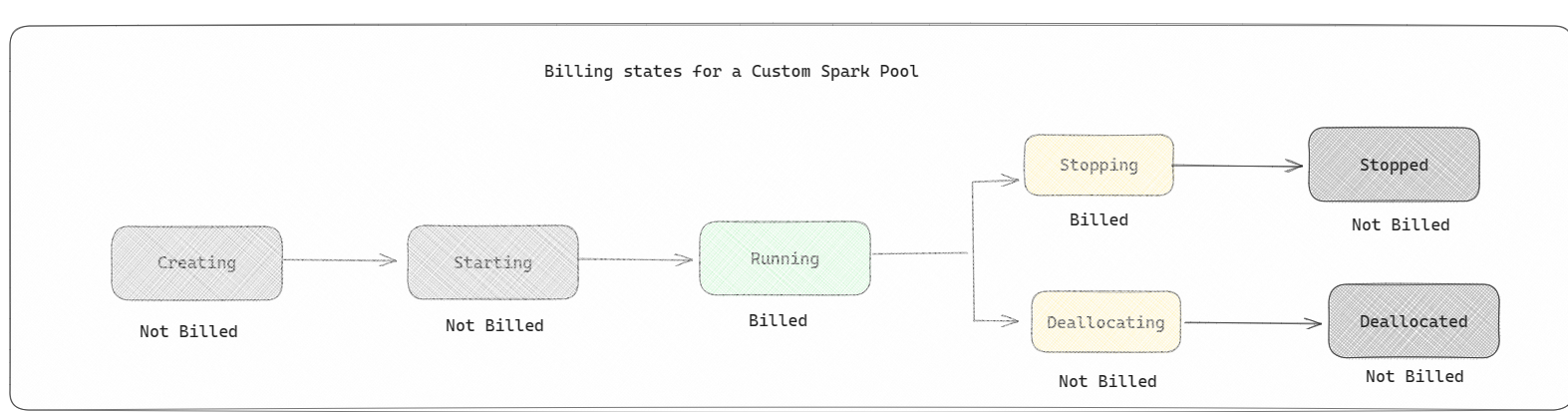

Spark bazény sa účtujú ako štartér bazény; za vlastné fondy Spark, ktoré ste vytvorili, neplatíte, pokiaľ nemáte vytvorenú reláciu služby Spark určenú na spustenie poznámkového bloku alebo definície pracovnej úlohy služby Spark. Účtujete sa len za čas spustenia vašej práce. Po dokončení úlohy sa vám neúčtujú fázy, ako je vytvorenie klastra a kolokácia riešenia.

Ak napríklad odošlete úlohu poznámkového bloku do vlastného fondu Spark, za časové obdobie, keď je relácia aktívna, sa účtuje len. Fakturácia tejto relácie poznámkového počítača sa zastaví alebo uplynie po ukončení alebo uplynutí platnosti relácie služby Spark. Nie ste účtované za čas potrebný na získanie inštancií klastra z cloudu ani za čas potrebný na inicializáciu kontextu služby Spark.

Možné konfigurácie vlastného fondu pre F64 na základe predchádzajúceho príkladu:

| Fabric capacity SKU | Kapacitné jednotky | Spark VCores | Veľkosť uzla | Maximálny počet uzlov |

|---|---|---|---|---|

| F64 | 64 | 384 | Malé | 96 |

| F64 | 64 | 384 | Stredné | 48 |

| F64 | 64 | 384 | Veľké | 24 |

| F64 | 64 | 384 | X-Large | 12 |

| F64 | 64 | 384 | XX-veľké | 6 |

Poznámka

Ak chcete vytvoriť vlastné fondy, potrebujete povolenia správcu pre pracovný priestor. Správca kapacity služby Microsoft Fabric musí udeliť povolenia, aby správcom pracovného priestoru umožnili veľkosť vlastných bazénov služby Spark. Ďalšie informácie nájdete v téme Začíname s vlastnými bazénmi Spark v službe Fabric

Uzly

Inštancia fondu Apache Spark sa skladá z jedného uzla hlavy a uzlov pracovníkov, môže v inštancii Spark začať minimálne jeden uzol. Uzol hlavy prevádzkuje ďalšie služby správy, ako napríklad Livy, Yarn Resource Manager, Zookeeper a ovládač Apache Spark. Všetky uzly spúšťajú služby, ako napríklad Agent uzla a Správca uzlov priadze. Všetky uzly pracovníkov spúšťajú službu Apache Spark Executor.

Veľkosti uzla

Fond Spark možno definovať s veľkosťami uzla, ktoré siahajú od malého výpočtového uzla (so 4 virtuálnym jadrom a 28 GB pamäte) až po dvojitý veľký výpočtový uzol navyše (so 64 virtuálnymi jadrami a 400 GB pamäte na uzol). Veľkosti uzla možno zmeniť po vytvorení fondu, hoci by sa aktívna relácia musela reštartovať.

| Veľkosť | virtuálne jadro | Pamäť |

|---|---|---|

| Malé | 4 | 28 GB |

| Stredné | 8 | 56 GB |

| Veľké | 16 | 112 GB |

| X-Large | 32 | 224 GB |

| XX-veľké | 64 | 400 GB |

Automatické škálovanie

Automatické škálovanie pre fondy Apache Spark umožňuje automatické zvýšenie a zníženie výpočtových prostriedkov na základe objemu aktivity. Keď povolíte funkciu automatického škálovania, nastavíte minimálny a maximálny počet uzlov na škálovanie. Keď vypnete funkciu automatického škálovania, počet množiny uzlov zostáva pevný. Toto nastavenie môžete zmeniť po vytvorení fondu, aj keď možno budete musieť reštartovať inštanciu.

Poznámka

V predvolenom nastavení je nastavenie spark.yarn.executor.vyradenie.povolené na hodnotu true. Umožňuje automatickému vypnutiu nedostatočne vytvorených uzlov optimalizovať výpočtovú efektivitu. Ak sa uprednostňuje menej agresívne škálovanie, táto konfigurácia môže byť nastavená na hodnotu false

Dynamická alokácia

Dynamická alokácia umožňuje aplikácii Apache Spark požiadať o viac spúšťačov v prípade, že úlohy presiahnu zaťaženie, ktoré môžu znášať aktuálni vykonávatelia. Po dokončení úloh sa tiež uvoľnia vykonávatelia a ak sa aplikácia Spark presunie do stavu nečinnosti. Pre podnikových používateľov je často ťažké vyladiť konfigurácie vykonávača, pretože sa výrazne líšia v rôznych fázach procesu vykonávania úloh v službe Spark. Tieto konfigurácie závisia aj od objemu spracovaných údajov, ktorý sa z času na čas mení. Možnosť dynamického prideľovania vykonávateľov môžete povoliť ako súčasť konfigurácie fondu, ktorá umožňuje automatické prideľovanie vykonávateľov do aplikácie Spark na základe uzlov dostupných vo fonde spark.

Keď povolíte dynamickú možnosť prideľovania pre každú odoslaovú aplikáciu Spark, systém vyhradzuje vykonávateľov počas kroku odosielania úloh na základe minimálnych uzlov. Ak chcete podporovať úspešné scenáre automatickej škály, zadajte maximálne uzly.