Utvärdera frågor manuellt i Azure AI Studio Playground

Viktigt!

Vissa av de funktioner som beskrivs i den här artikeln kanske bara är tillgängliga i förhandsversionen. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade. Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

När du kommer igång med promptteknik bör du testa olika indata en i taget för att utvärdera att frågans effektivitet kan vara mycket tidsintensiv. Det beror på att det är viktigt att kontrollera om innehållsfiltren fungerar korrekt, om svaret är korrekt med mera.

För att göra den här processen enklare kan du använda manuell utvärdering i Azure AI Studio, ett utvärderingsverktyg som gör att du kontinuerligt itererar och utvärderar din uppmaning mot dina testdata i ett enda gränssnitt. Du kan också manuellt betygsätta utdata, modellens svar, så att du får förtroende för din fråga.

Manuell utvärdering kan hjälpa dig att komma igång med att förstå hur bra din fråga fungerar och iterera i din uppmaning för att säkerställa att du når önskad nivå av förtroende.

I den här artikeln lär du dig att:

- Generera dina manuella utvärderingsresultat

- Betygsätt dina modellsvar

- Iterera i prompten och omvärdera

- Spara och jämför resultat

- Utvärdera med inbyggda mått

Förutsättningar

För att generera manuella utvärderingsresultat måste du ha följande redo:

En testdatauppsättning i något av följande format: csv eller jsonl. Om du inte har någon tillgänglig datauppsättning kan du även mata in data manuellt från användargränssnittet.

En distribution av någon av dessa modeller: GPT 3.5-modeller, GPT 4-modeller eller Davinci-modeller. Mer information om hur du skapar en distribution finns i Distribuera modeller.

Kommentar

Manuell utvärdering stöds endast för Azure OpenAI-modeller för närvarande för chatt- och slutförandeaktivitetstyper.

Generera dina manuella utvärderingsresultat

Från Playground väljer du Manuell utvärdering för att påbörja processen med att manuellt granska modellsvaren baserat på dina testdata och fråga. Din fråga övergår automatiskt till din manuella utvärdering och nu behöver du bara lägga till testdata för att utvärdera uppmaningen mot.

Detta kan göras manuellt med hjälp av textrutorna i kolumnen Indata .

Du kan också importera data för att välja en av dina tidigare befintliga datamängder i projektet eller ladda upp en datauppsättning som är i CSV- eller JSONL-format. När du har läst in dina data uppmanas du att mappa kolumnerna på rätt sätt. När du är klar och väljer Importera fylls data på rätt sätt i kolumnerna nedan.

Kommentar

Du kan lägga till så många som 50 indatarader i din manuella utvärdering. Om dina testdata har fler än 50 indatarader laddar vi upp de första 50 i indatakolumnen.

Nu när dina data har lagts till kan du köra för att fylla i utdatakolumnen med modellens svar.

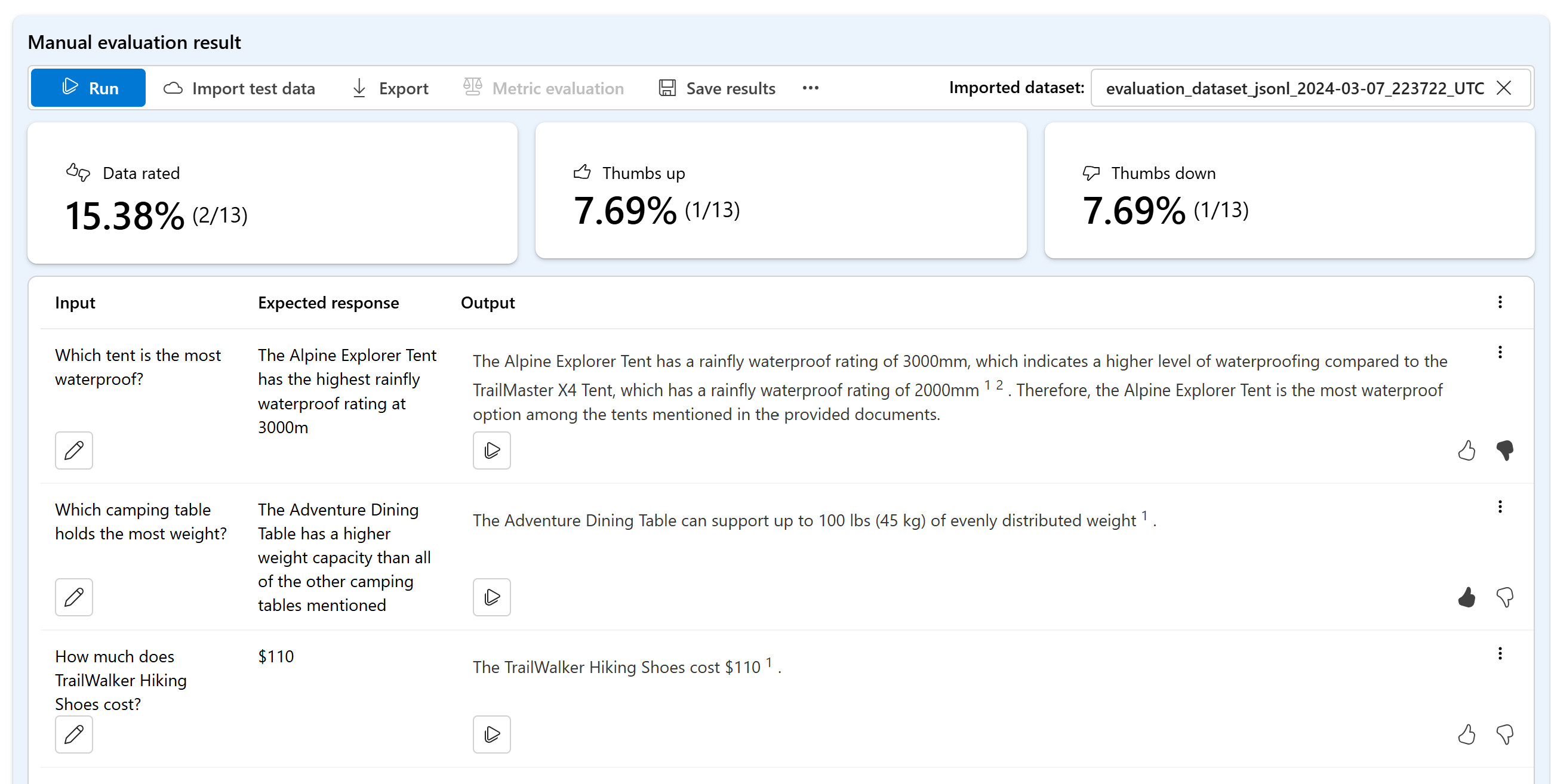

Betygsätt dina modellsvar

Du kan ange en tumme upp- eller nedklassificering för varje svar för att utvärdera promptens utdata. Baserat på de omdömen du angav kan du visa dessa svarspoäng i sammanfattningarna.

Iterera i prompten och omvärdera

Baserat på sammanfattningen kanske du vill göra ändringar i din fråga. Du kan använda promptkontrollerna ovan för att redigera konfigurationen av din fråga. Detta kan vara att uppdatera systemmeddelandet, ändra modellen eller redigera parametrarna.

När du har gjort dina ändringar kan du välja att köra alla igen för att uppdatera hela tabellen eller fokusera på att köra om specifika rader som inte uppfyllde dina förväntningar första gången.

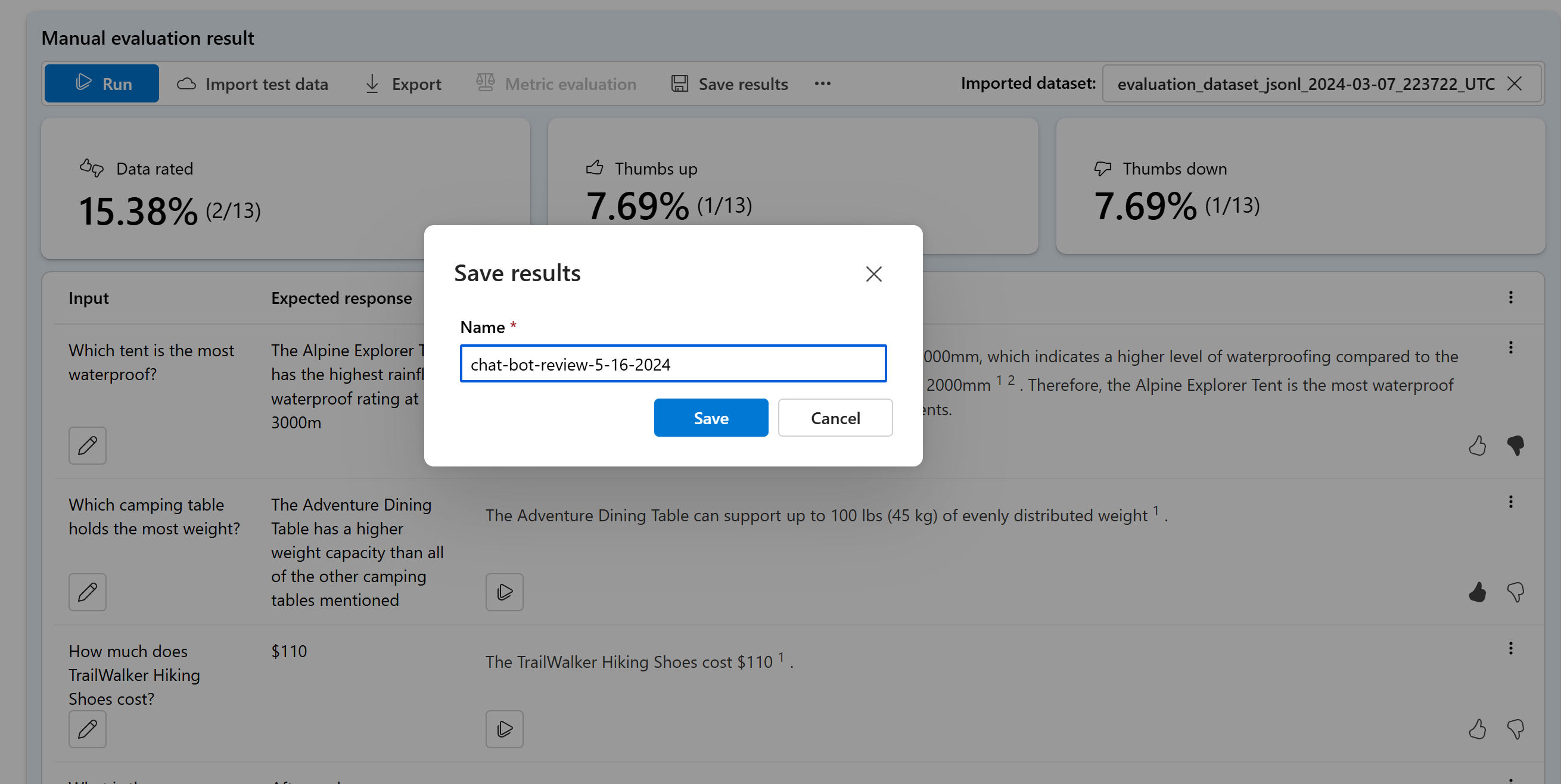

Spara och jämför resultat

När du har fyllt i dina resultat kan du spara resultat för att dela förloppet med ditt team eller fortsätta din manuella utvärdering där du slutade senare.

Du kan också jämföra upp- och nedbetygen för dina olika manuella utvärderingar genom att spara dem och visa dem på fliken Utvärdering under Manuell utvärdering.

Nästa steg

Läs mer om hur du utvärderar dina generativa AI-program:

Läs mer om skadereduceringstekniker.

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för