Så här utvärderar du generativa AI-appar med Azure AI Studio

Viktigt!

Vissa av de funktioner som beskrivs i den här artikeln kanske bara är tillgängliga i förhandsversionen. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade. Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

För att noggrant utvärdera prestandan för ditt generativa AI-program när det tillämpas på en betydande datamängd kan du starta en utvärderingsprocess. Under den här utvärderingen testas ditt program med den angivna datamängden och dess prestanda mäts kvantitativt med både matematiska och AI-assisterade mått. Den här utvärderingskörningen ger dig omfattande insikter om programmets funktioner och begränsningar.

För att utföra den här utvärderingen kan du använda utvärderingsfunktionerna i Azure AI Studio, en omfattande plattform som erbjuder verktyg och funktioner för att utvärdera prestanda och säkerhet för din generativa AI-modell. I AI Studio kan du logga, visa och analysera detaljerade utvärderingsmått.

I den här artikeln lär du dig att skapa en utvärderingskörning från en testdatauppsättning eller ett flöde med inbyggda utvärderingsmått från Azure AI Studio-användargränssnittet. För större flexibilitet kan du upprätta ett anpassat utvärderingsflöde och använda den anpassade utvärderingsfunktionen. Om ditt mål endast är att utföra en batchkörning utan utvärdering kan du också använda den anpassade utvärderingsfunktionen.

Förutsättningar

Om du vill köra en utvärdering med AI-assisterade mått måste du ha följande redo:

- En testdatauppsättning i något av följande format:

csvellerjsonl. - En Azure OpenAI-anslutning.

- En distribution av någon av dessa modeller: GPT 3.5-modeller, GPT 4-modeller eller Davinci-modeller.

Skapa en utvärdering med inbyggda utvärderingsmått

Med en utvärderingskörning kan du generera måttutdata för varje datarad i testdatauppsättningen. Du kan välja ett eller flera utvärderingsmått för att utvärdera utdata från olika aspekter. Du kan skapa en utvärderingskörning från utvärderings- och promptflödessidorna i AI Studio. Sedan visas en utvärderingsguide som hjälper dig att konfigurera en utvärderingskörning.

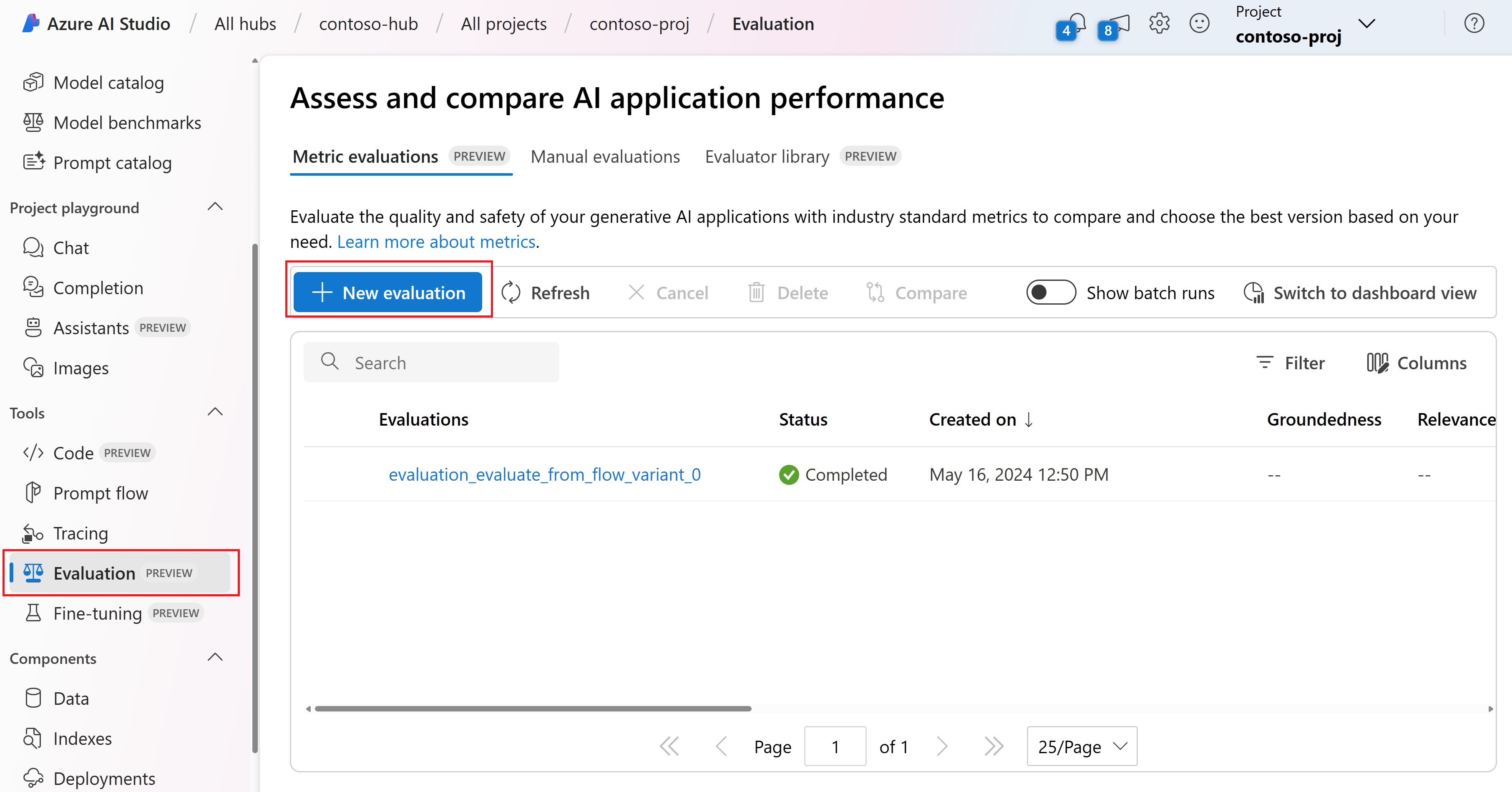

Från sidan Utvärdera

På den komprimerade vänstra menyn väljer du Utvärdering>+ Ny utvärdering.

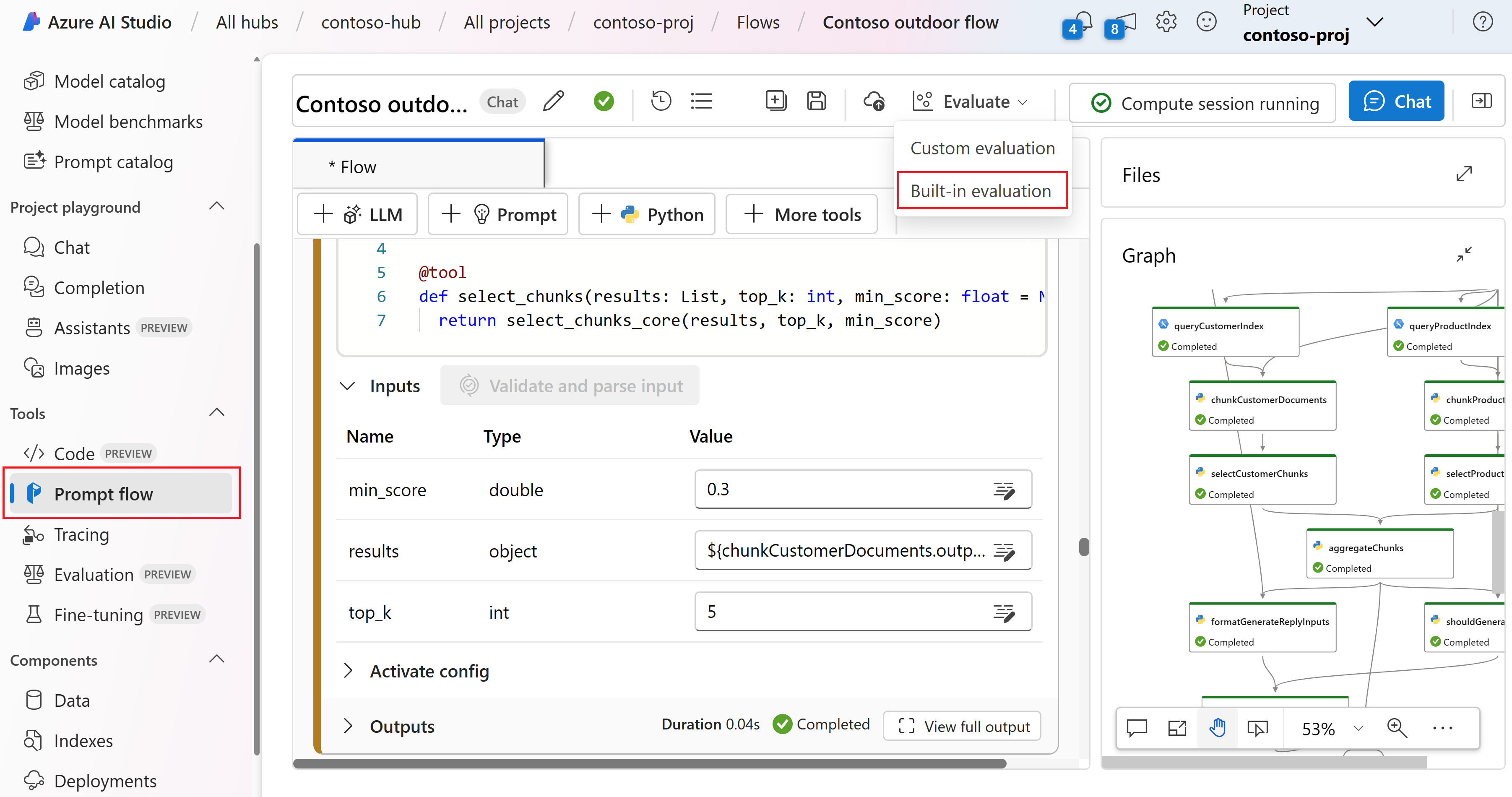

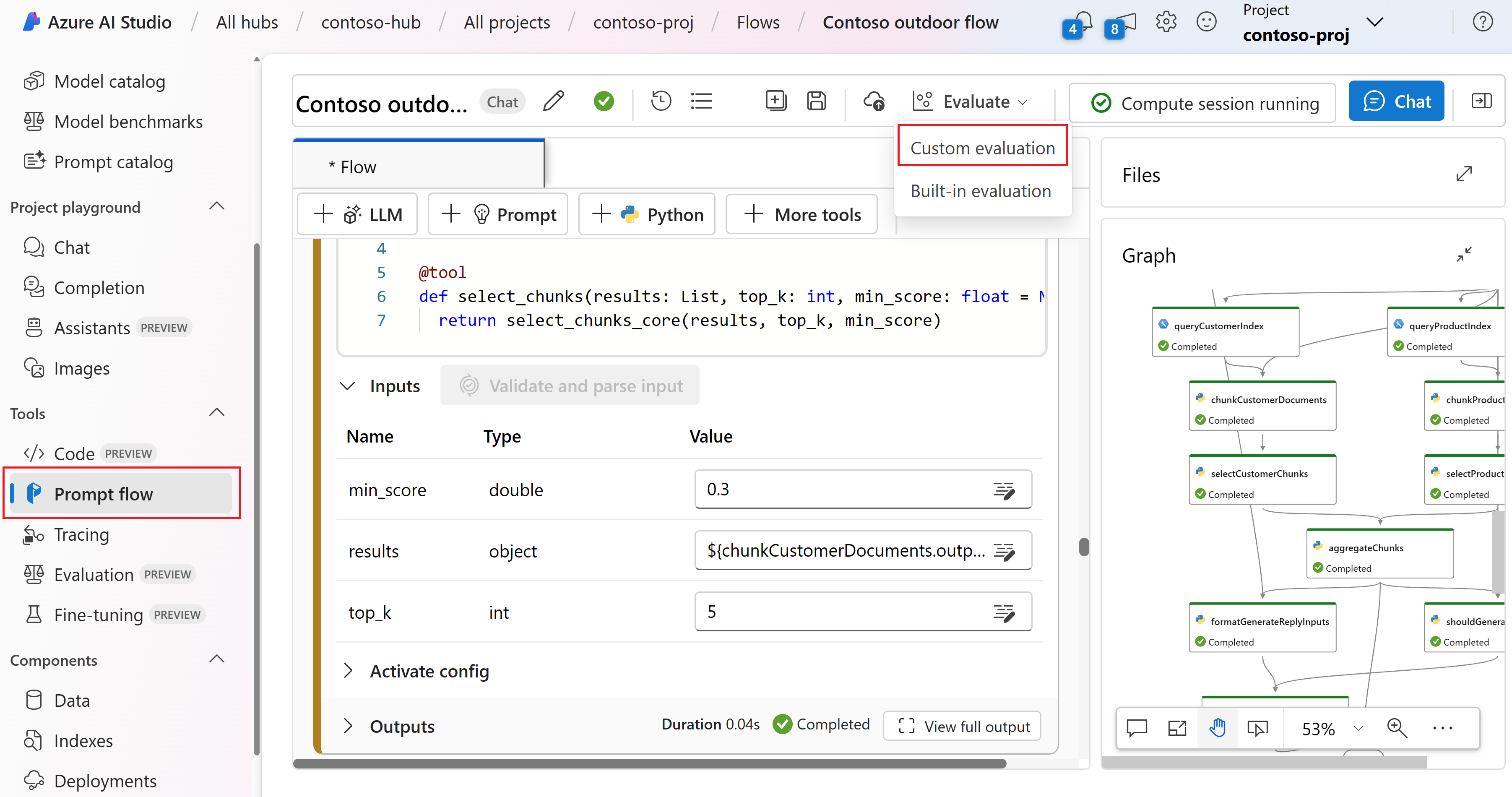

Från flödessidan

På den komprimerade vänstra menyn väljer du Prompt flow>Evaluate>Built-in evaluation (Utvärdera inbyggd utvärdering).

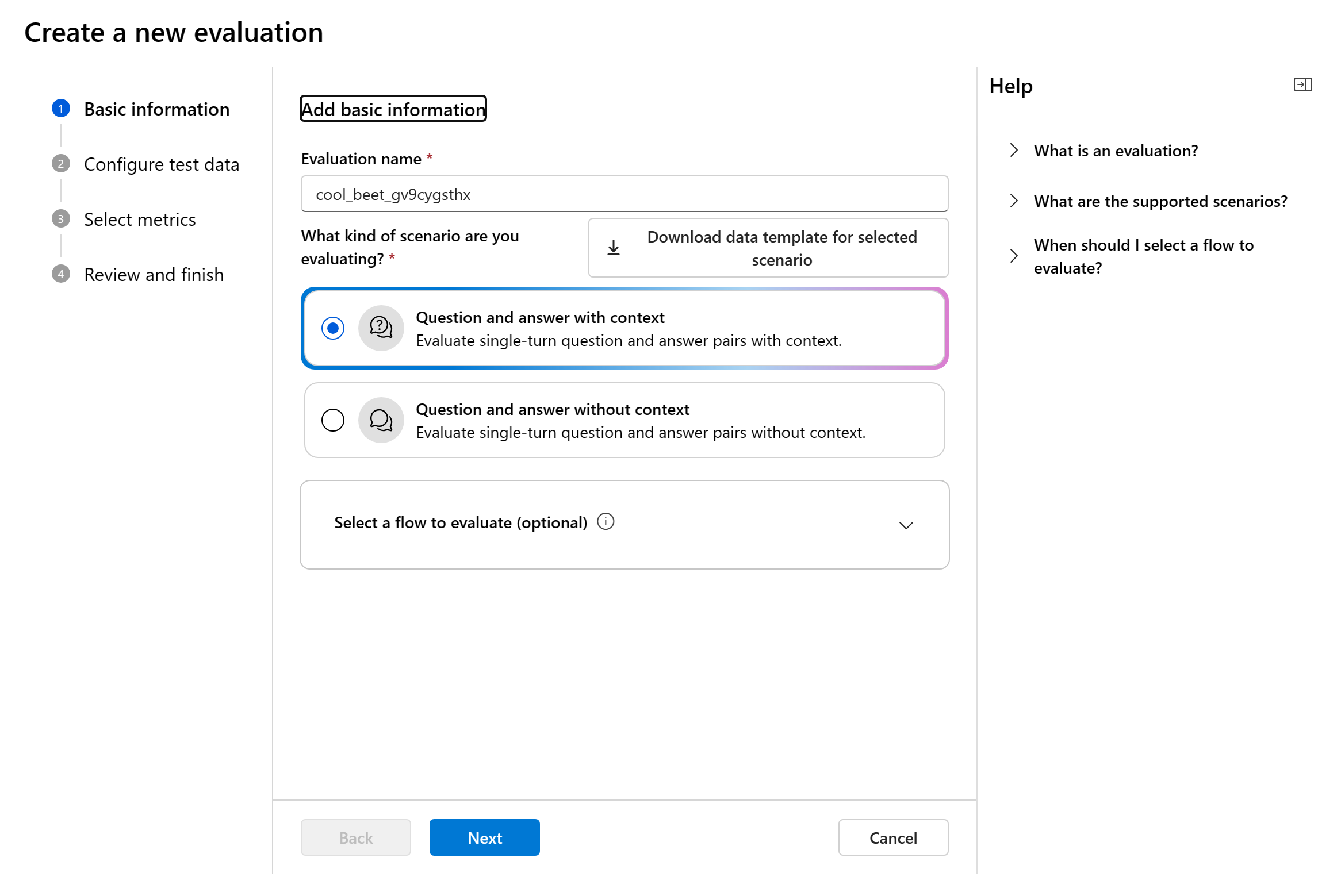

Grundläggande information

När du startar en utvärdering från utvärderingssidan måste du bestämma vad som är utvärderingsmålet först. Genom att ange lämpligt utvärderingsmål kan vi skräddarsy utvärderingen efter programmets specifika karaktär, vilket säkerställer korrekta och relevanta mått. För närvarande stöder vi två typer av utvärderingsmål:

Datauppsättning: Du har redan din modell genererade utdata i en testdatauppsättning. Fråga efter flöde: Du har skapat ett flöde och vill utvärdera utdata från flödet.

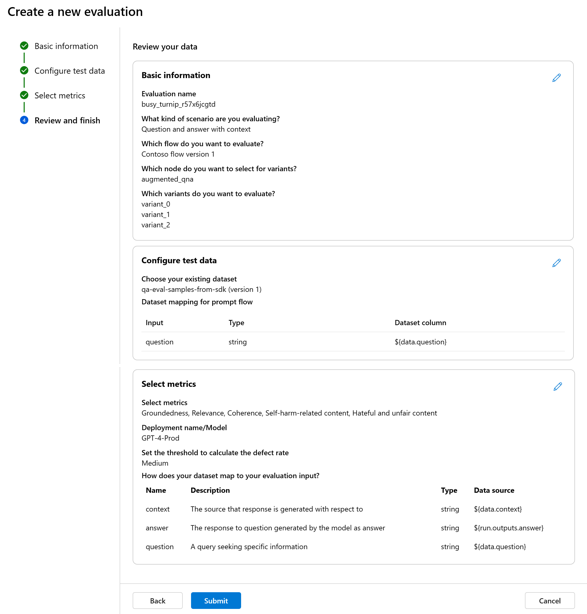

När du anger guiden för att skapa utvärdering kan du ange ett valfritt namn för utvärderingskörningen och välja det scenario som bäst överensstämmer med programmets mål. Vi erbjuder för närvarande stöd för följande scenarier:

- Fråga och svar med kontext: Det här scenariot är utformat för program som omfattar att besvara användarfrågor och ge svar med kontextinformation.

- Fråga och svar utan kontext: Det här scenariot är utformat för program som omfattar att besvara användarfrågor och tillhandahålla svar utan kontext.

Du kan använda hjälppanelen för att kontrollera vanliga frågor och svar och vägleda dig själv genom guiden.

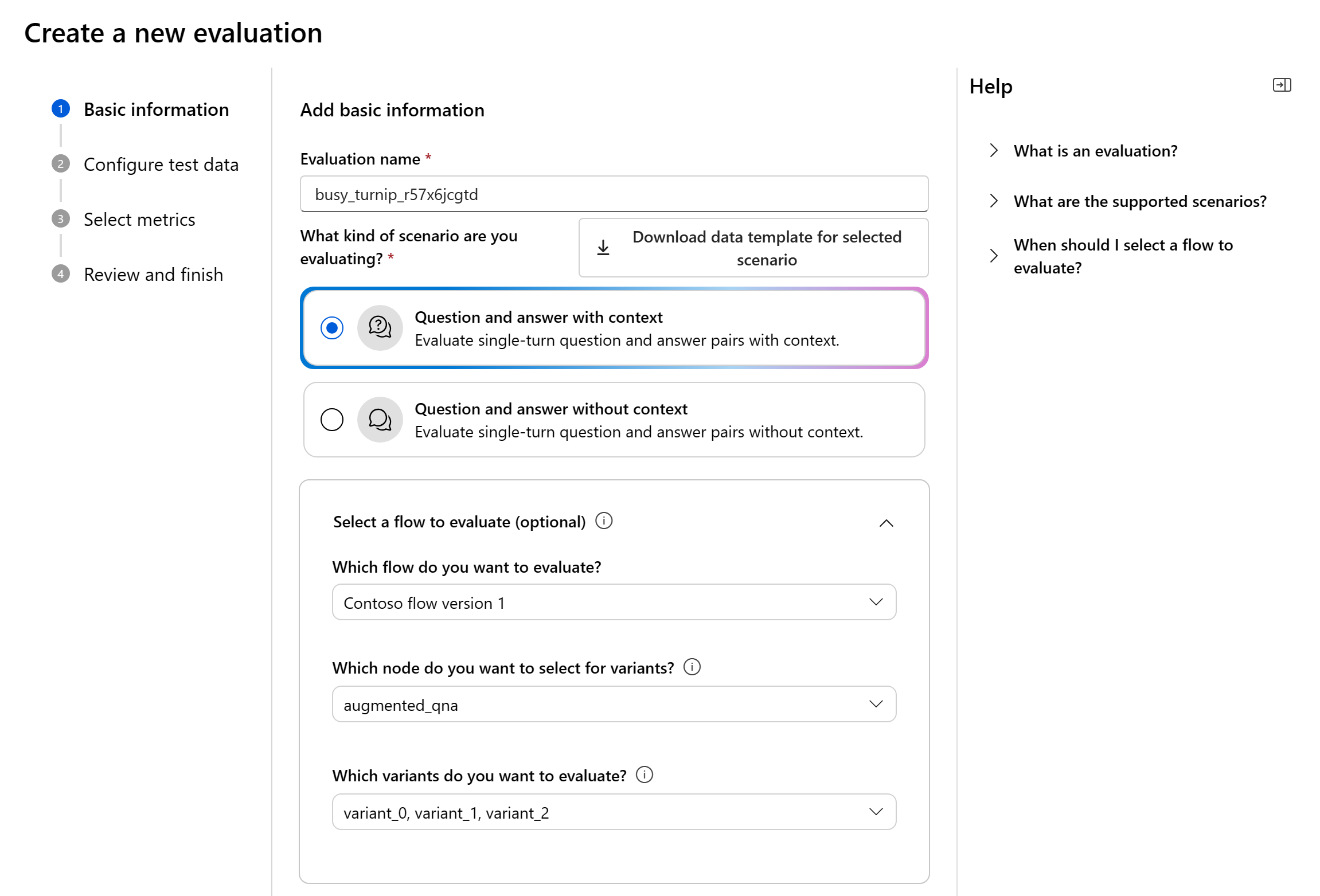

Om du utvärderar ett promptflöde kan du välja det flöde som ska utvärderas. Om du initierar utvärderingen från sidan Flöde väljer vi automatiskt ditt flöde att utvärdera. Om du tänker utvärdera ett annat flöde kan du välja ett annat. Det är viktigt att observera att du i ett flöde kan ha flera noder, som var och en kan ha en egen uppsättning varianter. I sådana fall måste du ange noden och de varianter som du vill utvärdera under utvärderingsprocessen.

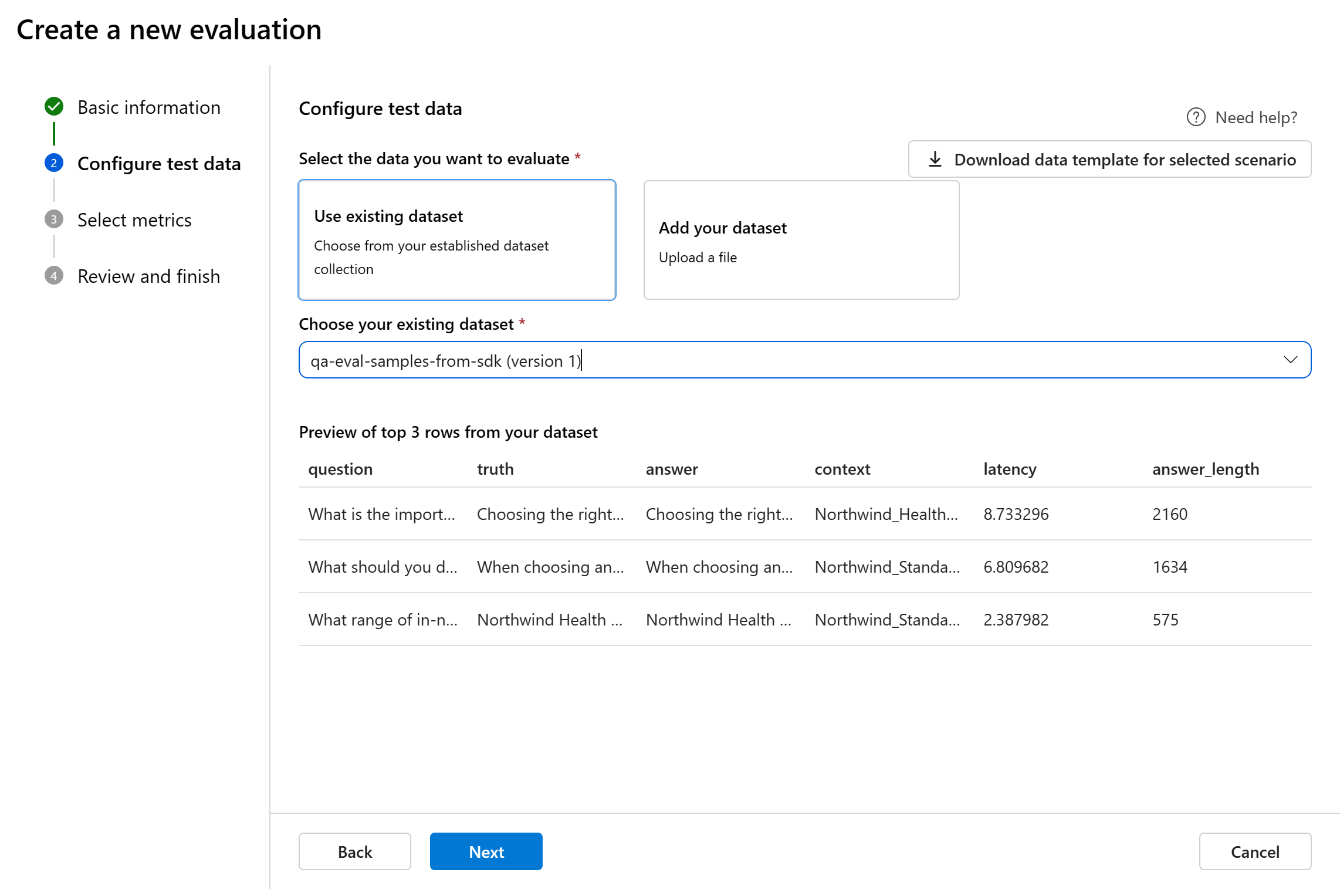

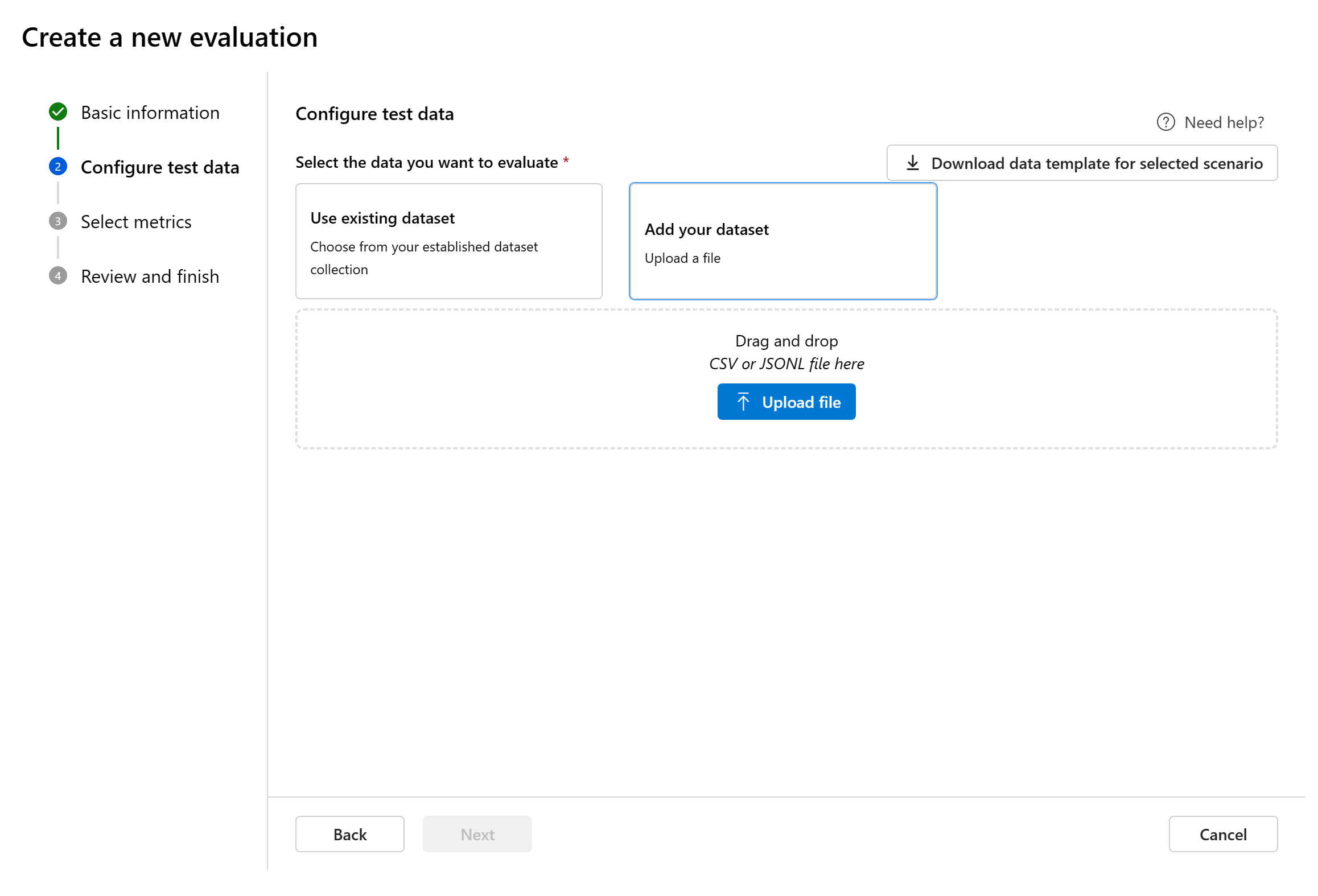

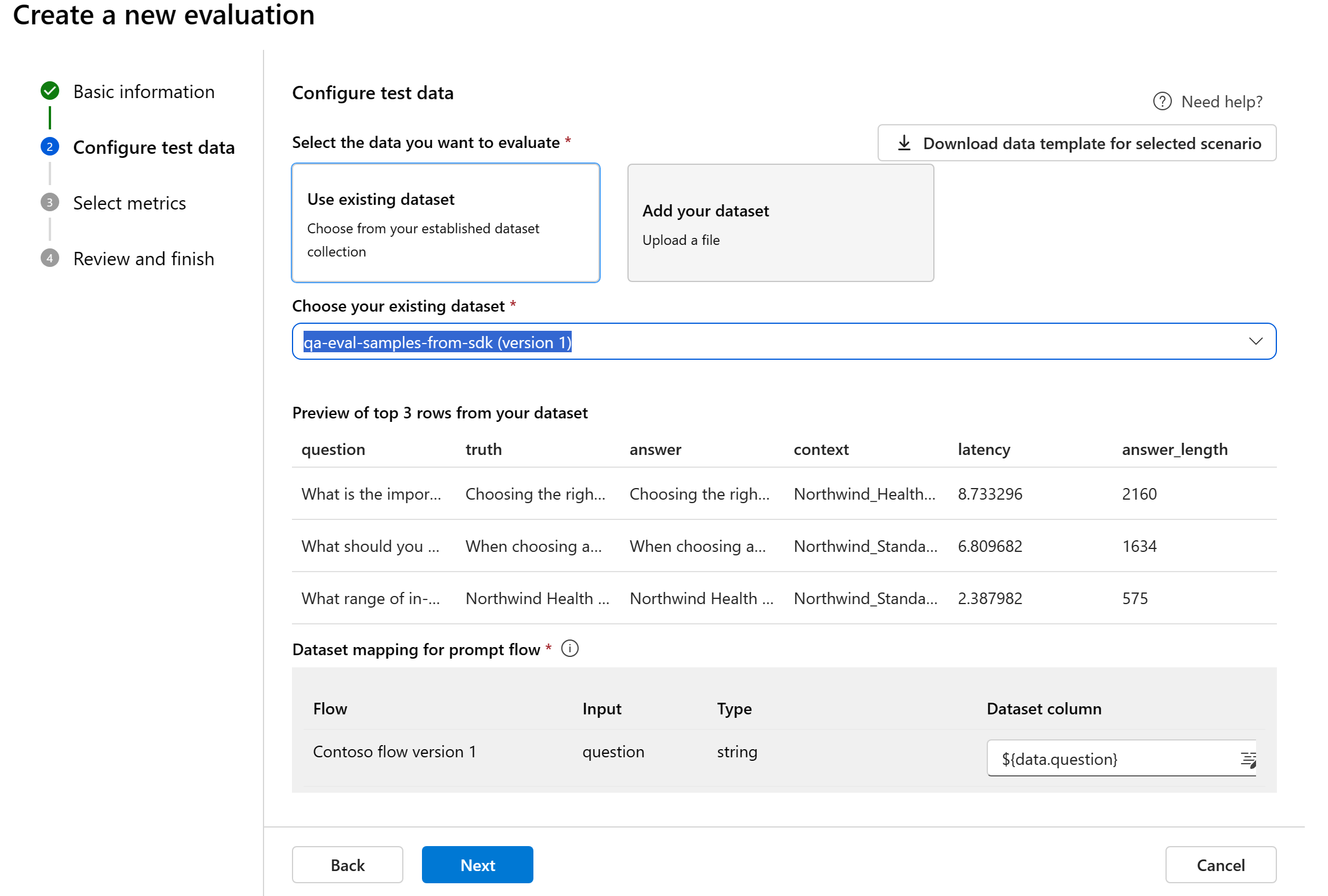

Konfigurera testdata

Du kan välja från befintliga datauppsättningar eller ladda upp en ny datauppsättning specifikt för att utvärdera. Testdatauppsättningen måste ha modellgenererade utdata som ska användas för utvärdering om inget flöde har valts i föregående steg.

Välj befintlig datauppsättning: Du kan välja testdatauppsättningen från din etablerade datauppsättningssamling.

Lägg till ny datauppsättning: Du kan ladda upp filer från din lokala lagring. Vi stöder

.csvendast filformat och.jsonlfilformat.Datamappning för flöde: Om du väljer ett flöde att utvärdera kontrollerar du att dina datakolumner är konfigurerade för att justera med de indata som krävs för att flödet ska köra en batchkörning och generera utdata för utvärdering. Utvärderingen utförs sedan med hjälp av utdata från flödet. Konfigurera sedan datamappningen för utvärderingsindata i nästa steg.

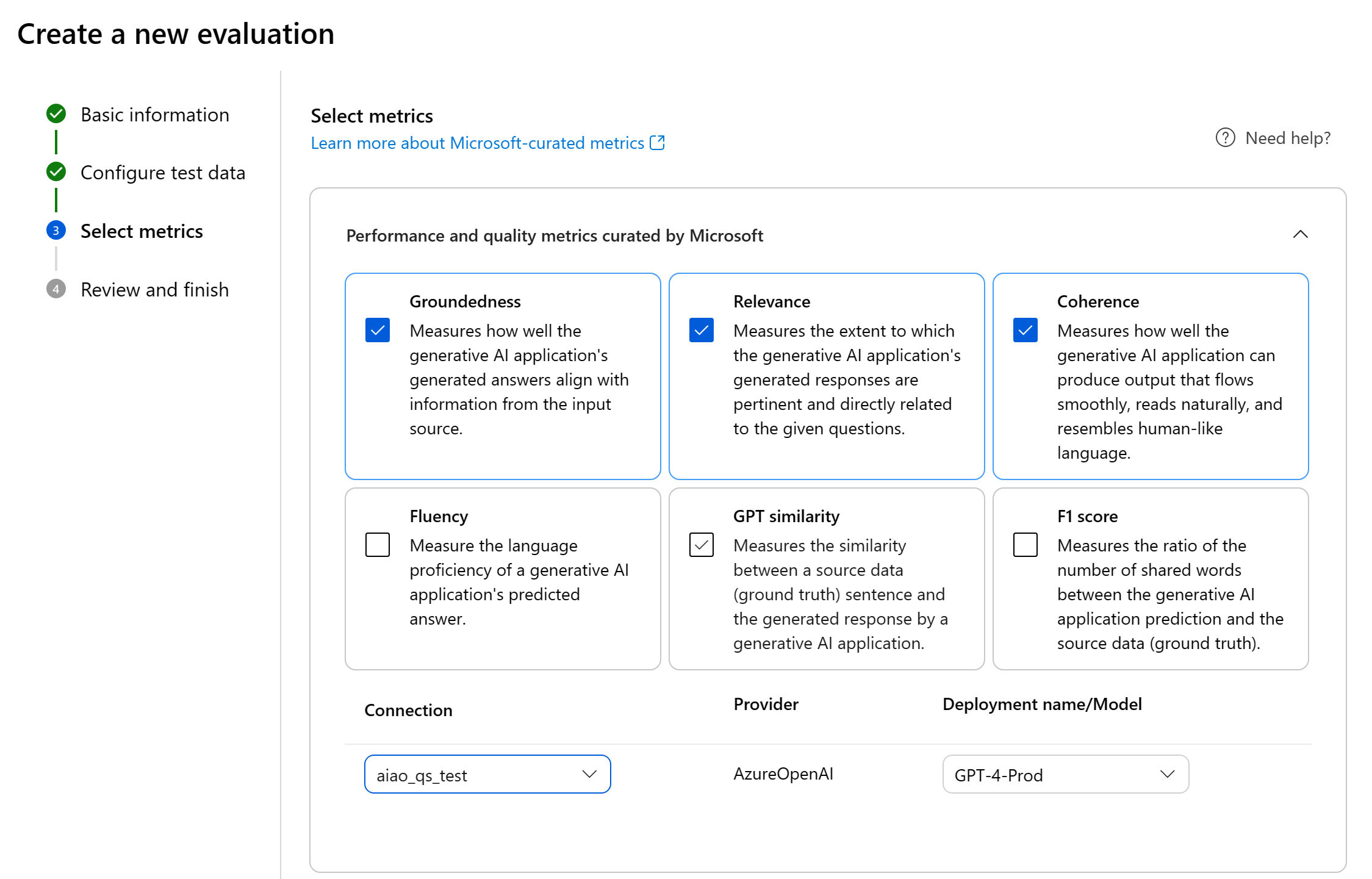

Välj mått

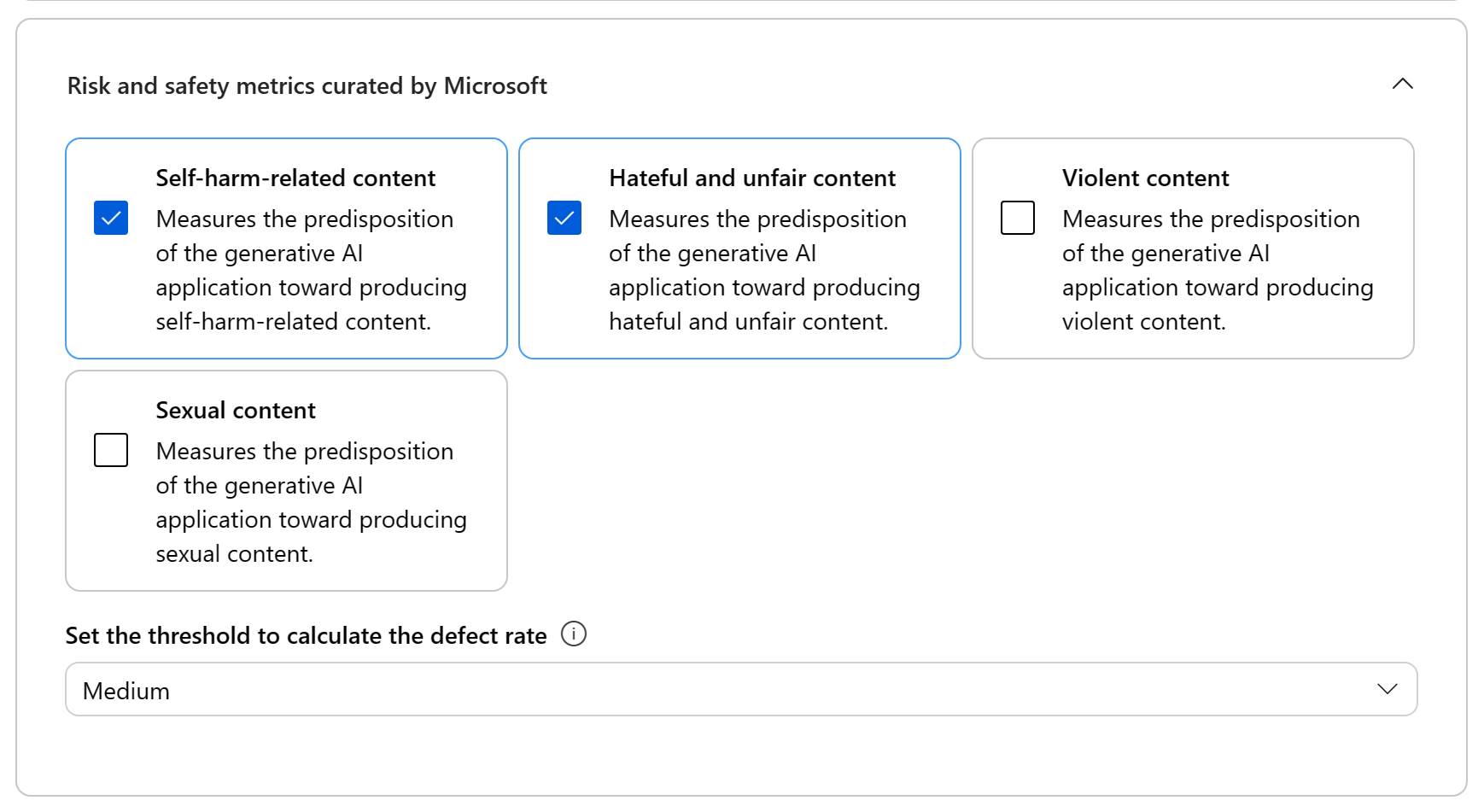

Vi stöder två typer av mått som kurerats av Microsoft för att underlätta en omfattande utvärdering av ditt program:

- Prestanda- och kvalitetsmått: Dessa mått utvärderar det genererade innehållets övergripande kvalitet och enhetlighet.

- Risk- och säkerhetsmått: Dessa mått fokuserar på att identifiera potentiella innehållsrisker och säkerställa säkerheten för det genererade innehållet.

Du kan referera till tabellen för den fullständiga listan över mått som vi erbjuder stöd för i varje scenario. Mer detaljerad information om varje måttdefinition och hur den beräknas finns i Utvärderings- och övervakningsmått.

| Scenario | Prestanda- och kvalitetsmått | Risk- och säkerhetsmått |

|---|---|---|

| Fråga och svar med kontext | Groundedness, Relevans, Koherens, Fluency, GPT-likhet, F1-poäng | Självskaderelaterat innehåll, Hatiskt och orättvist innehåll, Våldsamt innehåll, Sexuellt innehåll, Skyddat material, Indirekt attack |

| Fråga och svar utan sammanhang | Koherens, fluency, GPT-likhet, F1-poäng | Självskaderelaterat innehåll, Hatiskt och orättvist innehåll, Våldsamt innehåll, Sexuellt innehåll, Skyddat material, Indirekt attack |

När du använder AI-assisterade mått för prestanda- och kvalitetsutvärdering måste du ange en GPT-modell för beräkningsprocessen. Välj en Azure OpenAI-anslutning och en distribution med antingen GPT-3.5, GPT-4 eller Davinci-modellen för våra beräkningar.

För risk- och säkerhetsmått behöver du inte ange någon anslutning och distribution. Azure AI Studio-säkerhetsutvärderingarna tillhandahåller en GPT-4-modell som kan generera allvarlighetsgradspoäng för innehållsrisker och resonemang så att du kan utvärdera ditt program för innehållsskador.

Du kan ange tröskelvärdet för att beräkna defektfrekvensen för måtten för innehållsskador (självskaderelaterat innehåll, hatiskt och orättvist innehåll, våldsamt innehåll, sexuellt innehåll). Defektfrekvensen beräknas genom att ta en procentandel instanser med allvarlighetsgraderna (Mycket låg, Låg, Medel, Hög) över ett tröskelvärde. Som standard anger vi tröskelvärdet som "Medium".

För skyddat material och indirekt attack beräknas defektfrekvensen genom att ta en procentandel av de instanser där utdata är "true" (Defekt hastighet = (#trues/#instances) × 100).

Kommentar

AI-assisterade risk- och säkerhetsmått hanteras av Azure AI Studio-säkerhetsutvärderingars backend-tjänst och är endast tillgänglig i följande regioner: USA, östra 2, Frankrike, centrala, Storbritannien, södra, Sverige, centrala

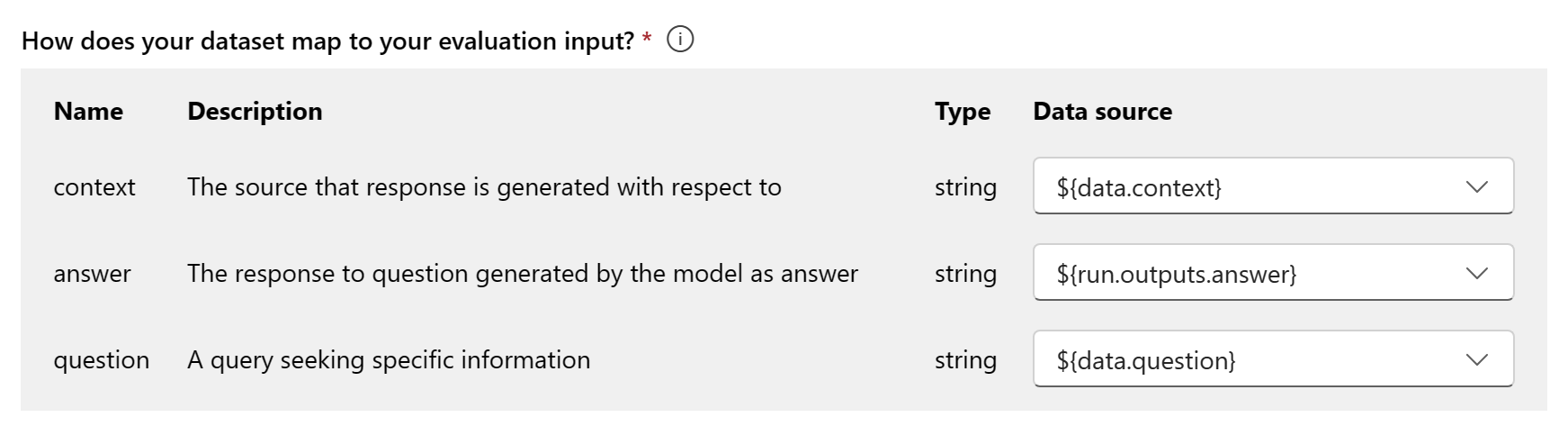

Datamappning för utvärdering: Du måste ange vilka datakolumner i datauppsättningen som motsvarar de indata som behövs i utvärderingen. Olika utvärderingsmått kräver olika typer av dataindata för exakta beräkningar.

Kommentar

Om du utvärderar från data bör "svar" mappas till svarskolumnen i datauppsättningen ${data$answer}. Om du utvärderar från flödet ska "svar" komma från flödesutdata ${run.outputs.answer}.

Vägledning om specifika datamappningskrav för varje mått finns i informationen i tabellen:

Fråga som besvarar måttkrav

| Mått | Fråga | Svar | Kontext | Grund sanning |

|---|---|---|---|---|

| Grundstötning | Obligatoriskt: Str | Obligatoriskt: Str | Obligatoriskt: Str | Ej tillämpligt |

| Koherens | Obligatoriskt: Str | Obligatoriskt: Str | Saknas | Saknas |

| Flyt | Obligatoriskt: Str | Obligatoriskt: Str | Saknas | Saknas |

| Relevans | Obligatoriskt: Str | Obligatoriskt: Str | Obligatoriskt: Str | Ej tillämpligt |

| GPT-likhet | Obligatoriskt: Str | Obligatoriskt: Str | Ej tillämpligt | Obligatoriskt: Str |

| F1-poäng | Obligatoriskt: Str | Obligatoriskt: Str | Ej tillämpligt | Obligatoriskt: Str |

| Självskaderelaterat innehåll | Obligatoriskt: Str | Obligatoriskt: Str | Saknas | Saknas |

| Hatiskt och orättvist innehåll | Obligatoriskt: Str | Obligatoriskt: Str | Saknas | Saknas |

| Våldsamt innehåll | Obligatoriskt: Str | Obligatoriskt: Str | Saknas | Saknas |

| Sexuellt innehåll | Obligatoriskt: Str | Obligatoriskt: Str | Saknas | Saknas |

| Skyddat material | Obligatoriskt: Str | Obligatoriskt: Str | Saknas | Saknas |

| Indirekt attack | Obligatoriskt: Str | Obligatoriskt: Str | Saknas | Saknas |

- Fråga: frågan som ställs av användaren i frågesvarsparet

- Svar: svaret på frågan som genereras av modellen som svar

- Kontext: källan som svaret genereras med avseende på (d.s. grunddokument)

- Grundsanning: svaret på frågan som genereras av användare/människa som det sanna svaret

Granska och slutför

När du har slutfört alla nödvändiga konfigurationer kan du granska och fortsätta med att välja Skicka för att skicka utvärderingskörningen.

Skapa en utvärdering med anpassat utvärderingsflöde

Du kan utveckla egna utvärderingsmetoder:

På flödessidan: Välj Utvärdera anpassad utvärdering i det komprimerade vänstra menyflödet>>.

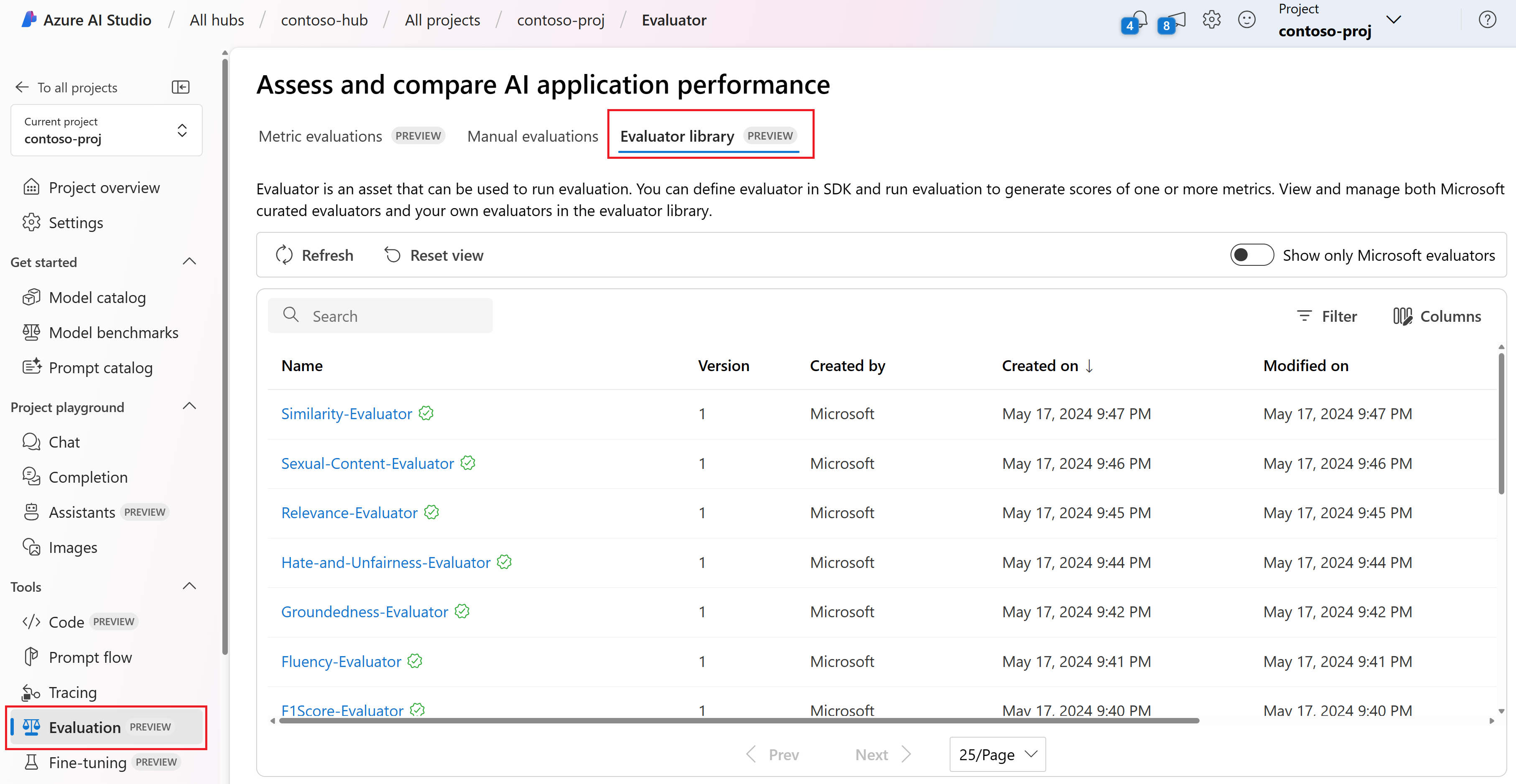

Visa och hantera utvärderarna i utvärderingsbiblioteket

Utvärderingsbiblioteket är en central plats där du kan se information och status för dina utvärderare. Du kan visa och hantera Microsoft-utvärderare.

Dricks

Du kan använda anpassade utvärderare via SDK för promptflöde. Mer information finns i Utvärdera med SDK för promptflöde.

Utvärderingsbiblioteket möjliggör även versionshantering. Du kan jämföra olika versioner av ditt arbete, återställa tidigare versioner om det behövs och samarbeta enklare med andra.

Om du vill använda utvärderingsbiblioteket i AI Studio går du till projektets utvärderingssida och väljer fliken Utvärderarbibliotek.

Du kan välja utvärderarens namn för att se mer information. Du kan se namn, beskrivning och parametrar och kontrollera alla filer som är associerade med utvärderaren. Här är några exempel på Microsoft-utvärderare:

- För prestanda- och kvalitetsutvärderingar som kurerats av Microsoft kan du visa kommentarsprompten på informationssidan. Du kan anpassa dessa uppmaningar till ditt eget användningsfall genom att ändra parametrarna eller kriterierna enligt dina data och mål med SDK för promptflöde. Du kan till exempel välja Groundedness-Evaluator och kontrollera filen Prompty som visar hur vi beräknar måttet.

- För risk- och säkerhetsutvärderingar som kurerats av Microsoft kan du se definitionen av måtten. Du kan till exempel välja självskadebeteenderelaterad innehållsutvärdering och lära dig vad det innebär och hur Microsoft avgör de olika allvarlighetsgraderna för det här säkerhetsmåttet

Nästa steg

Läs mer om hur du utvärderar dina generativa AI-program: