AI och Machine Learning på Databricks

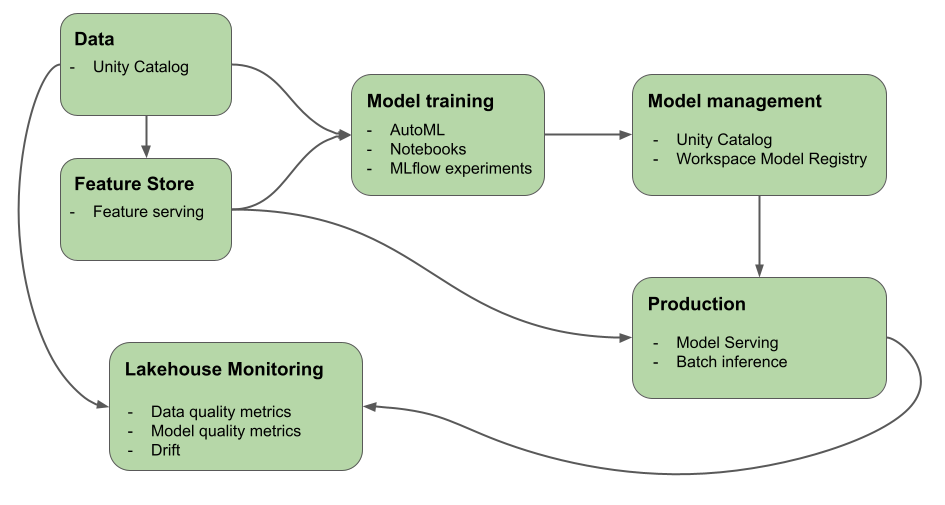

Den här artikeln beskriver de verktyg som Azure Databricks tillhandahåller för att hjälpa dig att skapa och övervaka AI- och ML-arbetsflöden. Diagrammet visar hur dessa komponenter fungerar tillsammans för att hjälpa dig att implementera din modellutvecklings- och distributionsprocess.

Varför ska du använda Databricks för maskininlärning och djupinlärning?

Med Azure Databricks kan du implementera hela ML-livscykeln på en enda plattform med styrning från slutpunkt till slutpunkt i hela ML-pipelinen. Azure Databricks innehåller följande inbyggda verktyg för att stödja ML-arbetsflöden:

- Unity Catalog för styrning, identifiering, versionshantering och åtkomstkontroll för data, funktioner, modeller och funktioner.

- Lakehouse-övervakning för dataövervakning.

- Funktionsutveckling och servering.

- Stöd för modelllivscykeln:

- Databricks AutoML för automatiserad modellträning.

- MLflow för modellutvecklingsspårning.

- Unity Catalog för modellhantering.

- Databricks-modellservering för modellservering med hög tillgänglighet och låg svarstid. Detta inkluderar distribution av LLM:er med hjälp av:

- Foundation Model-API:er som gör att du kan komma åt och köra frågor mot toppmoderna öppna modeller från en serveringsslutpunkt.

- Externa modeller som gör att du kan komma åt modeller som finns utanför Databricks.

- Lakehouse Monitoring för att spåra modellens förutsägelsekvalitet och drift.

- Databricks-arbetsflöden för automatiserade arbetsflöden och produktionsklara ETL-pipelines.

- Databricks Repos för kodhantering och Git-integrering.

Djupinlärning om Databricks

Det kan vara svårt att konfigurera infrastrukturen för djupinlärningsprogram.

Databricks Runtime for Machine Learning tar hand om det åt dig, med kluster som har inbyggda kompatibla versioner av de vanligaste djupinlärningsbiblioteken som TensorFlow, PyTorch och Keras, och som stöder bibliotek som Petastorm, Hyperopt och Horovod. Databricks Runtime ML-kluster innehåller även förkonfigurerat GPU-stöd med drivrutiner och stödbibliotek. Det stöder också bibliotek som Ray för parallellisering av beräkningsbearbetning för skalning av ML-arbetsflöden och AI-program.

Databricks Runtime ML-kluster innehåller även förkonfigurerat GPU-stöd med drivrutiner och stödbibliotek. Med Databricks Model Serving kan du skapa skalbara GPU-slutpunkter för djupinlärningsmodeller utan extra konfiguration.

För maskininlärningsprogram rekommenderar Databricks att du använder ett kluster som kör Databricks Runtime for Machine Learning. Se Skapa ett kluster med Databricks Runtime ML.

Information om hur du kommer igång med djupinlärning om Databricks finns i:

- Metodtips för djupinlärning i Azure Databricks

- Djupinlärning om Databricks

- Referenslösningar för djupinlärning

Stora språkmodeller (LLM) och generativ AI på Databricks

Databricks Runtime for Machine Learning innehåller bibliotek som Hugging Face Transformers och LangChain som gör att du kan integrera befintliga förtränade modeller eller andra bibliotek med öppen källkod i arbetsflödet. Databricks MLflow-integreringen gör det enkelt att använda MLflow-spårningstjänsten med transformatorpipelines, modeller och bearbetningskomponenter. Dessutom kan du integrera OpenAI-modeller eller lösningar från partner som John Snow Labs i dina Azure Databricks-arbetsflöden.

Med Azure Databricks kan du anpassa en LLM för dina data för din specifika uppgift. Med stöd av öppen källkod verktyg, till exempel Hugging Face och DeepSpeed, kan du effektivt ta en grundläggande LLM och träna den med dina egna data för att förbättra dess noggrannhet för din specifika domän och arbetsbelastning. Du kan sedan använda den anpassade LLM:en i dina generativa AI-program.

Dessutom tillhandahåller Databricks API:er för Foundation Model och externa modeller som gör att du kan komma åt och köra frågor mot toppmoderna öppna modeller från en serveringsslutpunkt. Med hjälp av API:er för Foundation Model kan utvecklare snabbt och enkelt skapa program som utnyttjar en generativ AI-modell av hög kvalitet utan att upprätthålla sin egen modelldistribution.

För SQL-användare tillhandahåller Databricks AI-funktioner som SQL-dataanalytiker kan använda för att komma åt LLM-modeller, inklusive från OpenAI, direkt i sina datapipelines och arbetsflöden. Se AI Functions på Azure Databricks.

Databricks Runtime för Machine Learning

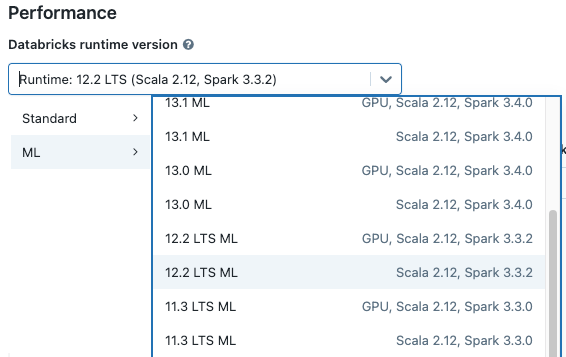

Databricks Runtime for Machine Learning (Databricks Runtime ML) automatiserar skapandet av ett kluster med inbyggd maskininlärning och djupinlärningsinfrastruktur, inklusive de vanligaste ML- och DL-biblioteken. Den fullständiga listan över bibliotek i varje version av Databricks Runtime ML finns i viktig information.

För att få åtkomst till data i Unity Catalog för arbetsflöden för maskininlärning måste åtkomstläget för klustret vara en enda användare (tilldelad). Delade kluster är inte kompatibla med Databricks Runtime för Machine Learning. Dessutom stöds inte Databricks Runtime ML i TableACLs-kluster eller -kluster med spark.databricks.pyspark.enableProcessIsolation config värdet true.

Skapa ett kluster med Databricks Runtime ML

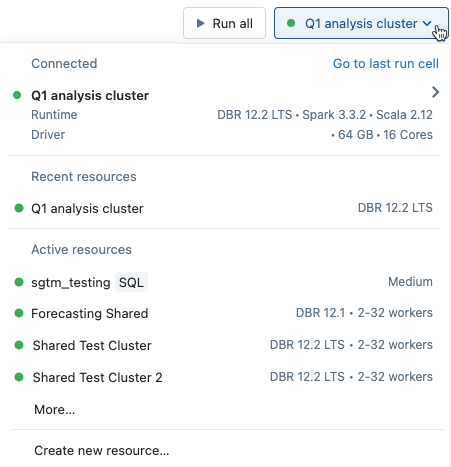

När du skapar ett kluster väljer du en Databricks Runtime ML-version från listrutan Databricks-körningsversion. Både CPU- och GPU-aktiverade ML-körningar är tillgängliga.

Om du väljer ett kluster från den nedrullningsbara menyn i anteckningsboken visas Databricks Runtime-versionen till höger om klusternamnet:

Om du väljer en GPU-aktiverad ML-körning uppmanas du att välja en kompatibel drivrutinstyp och arbetstyp. Inkompatibla instanstyper är nedtonade i den nedrullningsbara menyn. GPU-aktiverade instanstyper visas under etiketten GPU-accelererad .

Kommentar

För att få åtkomst till data i Unity Catalog för arbetsflöden för maskininlärning måste åtkomstläget för klustret vara en enda användare (tilldelad). Delade kluster är inte kompatibla med Databricks Runtime för Machine Learning.

Bibliotek som ingår i Databricks Runtime ML

Databricks Runtime ML innehåller en mängd populära ML-bibliotek. Biblioteken uppdateras med varje version så att de innehåller nya funktioner och korrigeringar.

Databricks har angett en delmängd av de bibliotek som stöds som bibliotek på den översta nivån. För dessa bibliotek ger Databricks snabbare uppdateringstakt och uppdaterar till de senaste paketversionerna med varje körningsversion (med undantag för beroendekonflikter). Databricks tillhandahåller även avancerad support, testning och inbäddade optimeringar för bibliotek på den översta nivån.

En fullständig lista över bibliotek på den översta nivån och andra bibliotek finns i viktig information för Databricks Runtime ML.

Nästa steg

Kom igång genom att läsa:

Ett rekommenderat MLOps-arbetsflöde på Databricks Machine Learning finns i:

Mer information om viktiga Databricks Machine Learning-funktioner finns i: