Skala Azure OpenAI för JavaScript-chatt med RAG med Azure Container Apps

Lär dig hur du lägger till belastningsutjämning i ditt program för att utöka chattappen utöver gränserna för Azure OpenAI-token och modellkvoter. Den här metoden använder Azure Container Apps för att skapa tre Azure OpenAI-slutpunkter samt en primär container för att dirigera inkommande trafik till en av de tre slutpunkterna.

Den här artikeln kräver att du distribuerar två separata exempel:

Chattapp

Om du inte har distribuerat chattappen ännu väntar du tills lastbalanserarens exempel har distribuerats.

Om du redan har distribuerat chattappen en gång ändrar du miljövariabeln så att den stöder en anpassad slutpunkt för lastbalanseraren och distribuerar om den igen.

Chattappen är tillgänglig på följande språk:

Appen Lastbalanserare

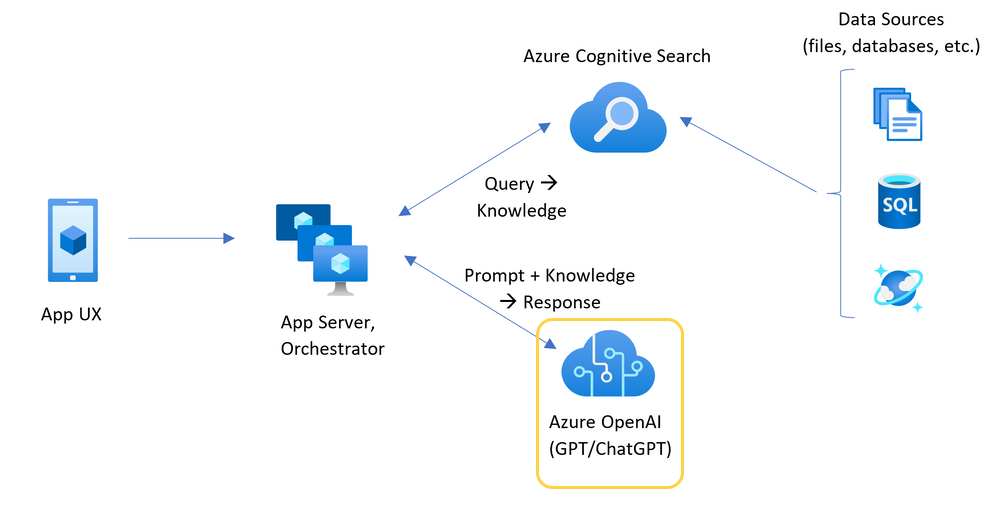

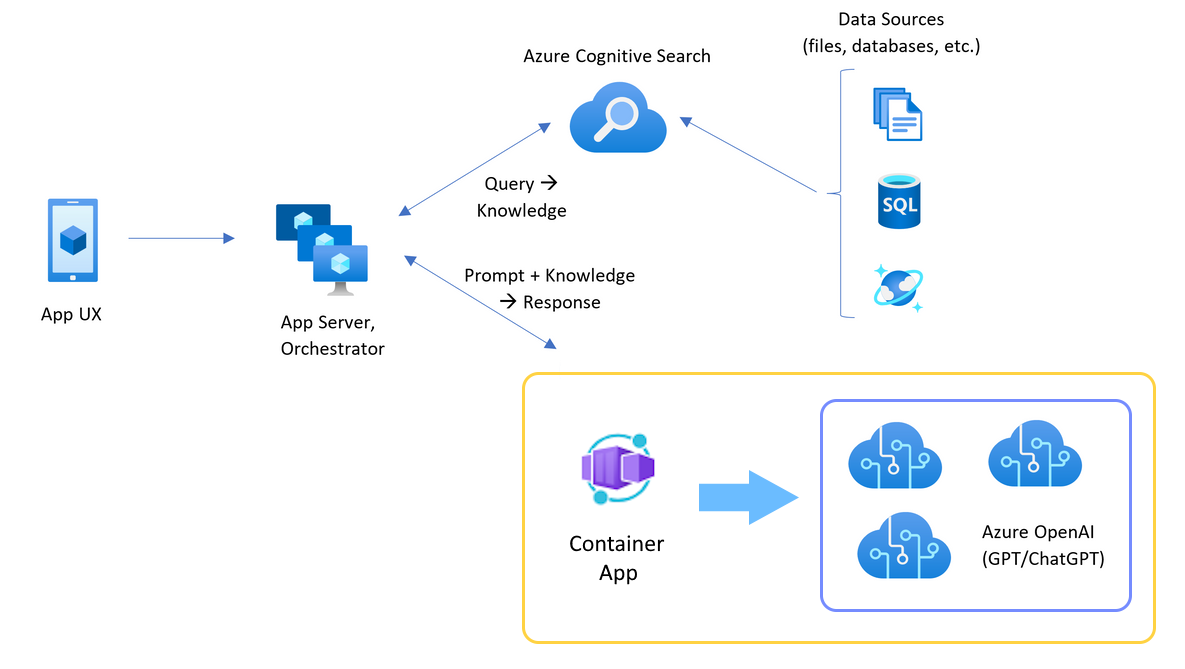

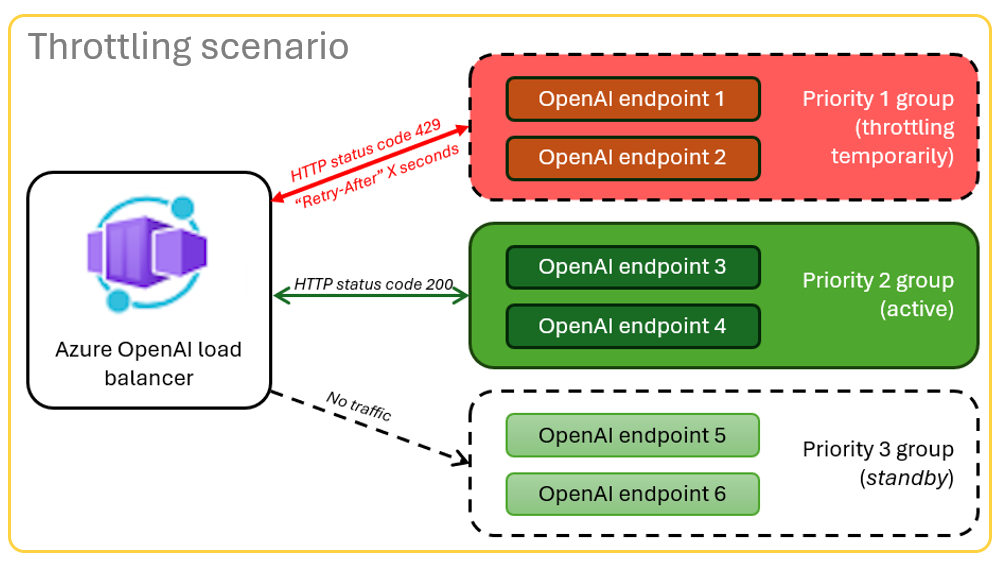

Arkitektur för belastningsutjämning av Azure OpenAI med Azure Container Apps

Eftersom Azure OpenAI-resursen har specifika token- och modellkvotgränser är en chattapp med en enda Azure OpenAI-resurs benägen att få konversationsfel på grund av dessa gränser.

Om du vill använda chattappen utan att nå dessa gränser använder du en belastningsutjämningslösning med Azure Container Apps. Den här lösningen exponerar sömlöst en enskild slutpunkt från Azure Container Apps för din chattappserver.

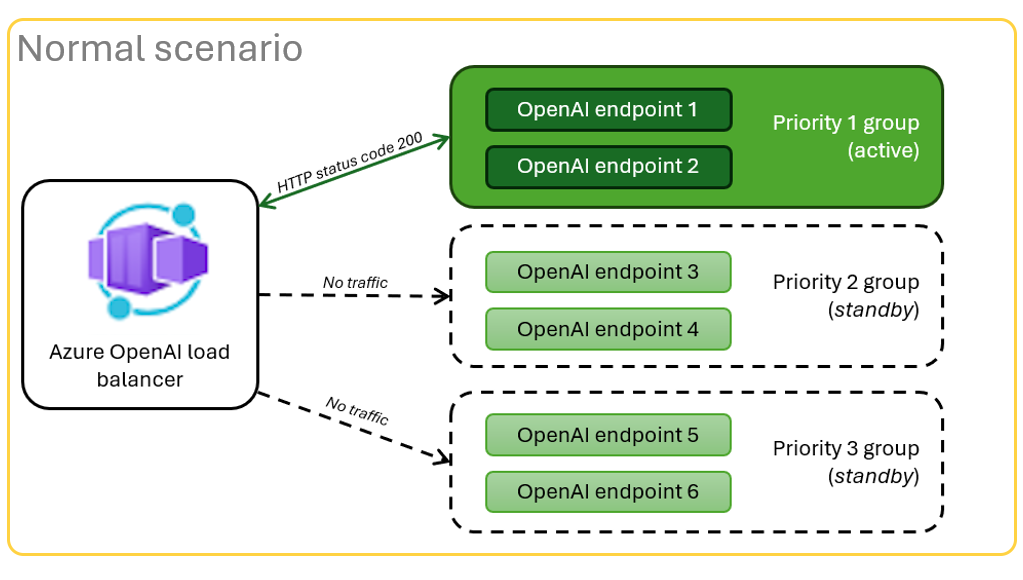

Azure Container-appen finns framför en uppsättning Azure OpenAI-resurser. Containerappen löser två scenarier: normal och begränsad. I ett normalt scenario där token- och modellkvoten är tillgänglig returnerar Azure OpenAI-resursen 200 tillbaka via containerappen och appservern.

När en resurs är i ett begränsat scenario , till exempel på grund av kvotgränser, kan Azure Container-appen försöka igen med en annan Azure OpenAI-resurs direkt till fullvärdig den ursprungliga chattappens begäran.

Förutsättningar

En Azure-prenumeration. Skapa en kostnadsfritt

Åtkomst beviljad till Azure OpenAI i den önskade Azure-prenumerationen.

För närvarande måste man ansöka om att få åtkomst till den här tjänsten. Du kan ansöka om åtkomst till Azure OpenAI genom att fylla i formuläret på https://aka.ms/oai/access.

Dev-containrar är tillgängliga för båda exemplen, med alla beroenden som krävs för att slutföra den här artikeln. Du kan köra dev-containrarna i GitHub Codespaces (i en webbläsare) eller lokalt med hjälp av Visual Studio Code.

- GitHub-konto

Öppna exempelappen För lokal balanseringsapp för containerappar

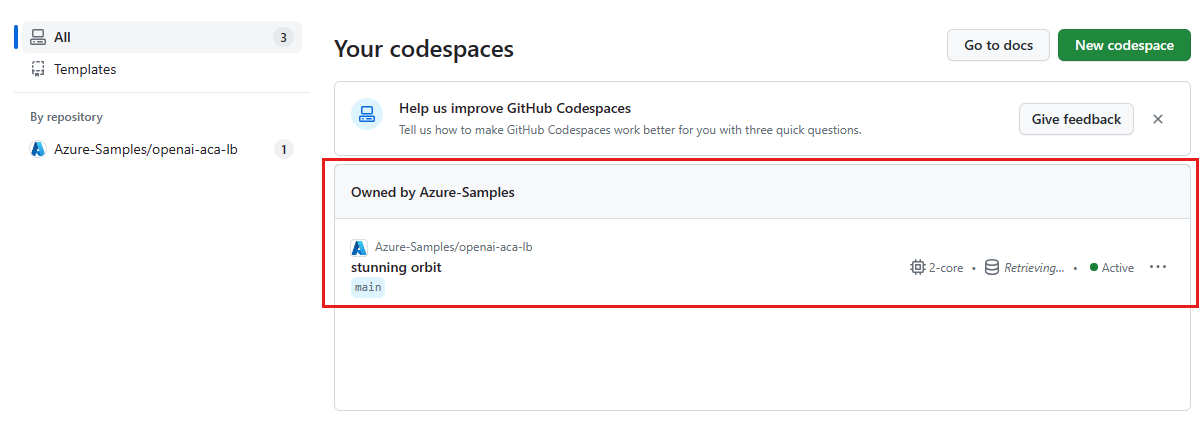

GitHub Codespaces kör en utvecklingscontainer som hanteras av GitHub med Visual Studio Code för webben som användargränssnitt. För den enklaste utvecklingsmiljön använder du GitHub Codespaces så att du har rätt utvecklarverktyg och beroenden förinstallerade för att slutföra den här artikeln.

Viktigt!

Alla GitHub-konton kan använda Codespaces i upp till 60 timmar kostnadsfritt varje månad med 2 kärninstanser. Mer information finns i GitHub Codespaces månadsvis inkluderade lagrings- och kärntimmar.

Distribuera Lastbalanserare för Azure Container Apps

Om du vill distribuera lastbalanseraren till Azure loggar du in på Azure Developer CLI (AZD).

azd auth loginSlutför inloggningsinstruktionerna.

Distribuera lastbalanserarens app.

azd upDu måste välja en prenumeration och region för distributionen. Dessa behöver inte vara samma prenumeration och region som chattappen.

Vänta tills distributionen är klar innan du fortsätter.

Hämta URL:en i slutet av distributionen med namnet Endpoint. Detta är det

CONTAINER_APP_URLsom används i nästa avsnitt.

Distribuera om chattappen med lastbalanserarens slutpunkt

Dessa slutförs i chattappexemplet.

Öppna chattappexemplets utvecklingscontainer med något av följande alternativ.

Språk Codespaces Visual Studio-koden .NET JavaScript Python Logga in på Azure Developer CLI (AZD).

azd auth loginSlutför inloggningsinstruktionerna.

Skapa en AZD-miljö med ett namn som

chat-app.azd env new <name>Lägg till följande miljövariabel, som instruerar chattappens serverdel att använda en anpassad URL för OpenAI-begäranden.

azd env set OPENAI_HOST azure_customLägg till följande miljövariabel och ersätt

<CONTAINER_APP_URL>url:en från föregående avsnitt. Den här åtgärden talar om för chattappens serverdel vad värdet är för den anpassade URL:en för OpenAI-begäran.azd env set AZURE_OPENAI_CUSTOM_URL <CONTAINER_APP_URL>Distribuera chattappen.

azd up

Nu kan du använda chattappen med förtroende för att den är skapad för att skala över många användare utan att kvoten tar slut.

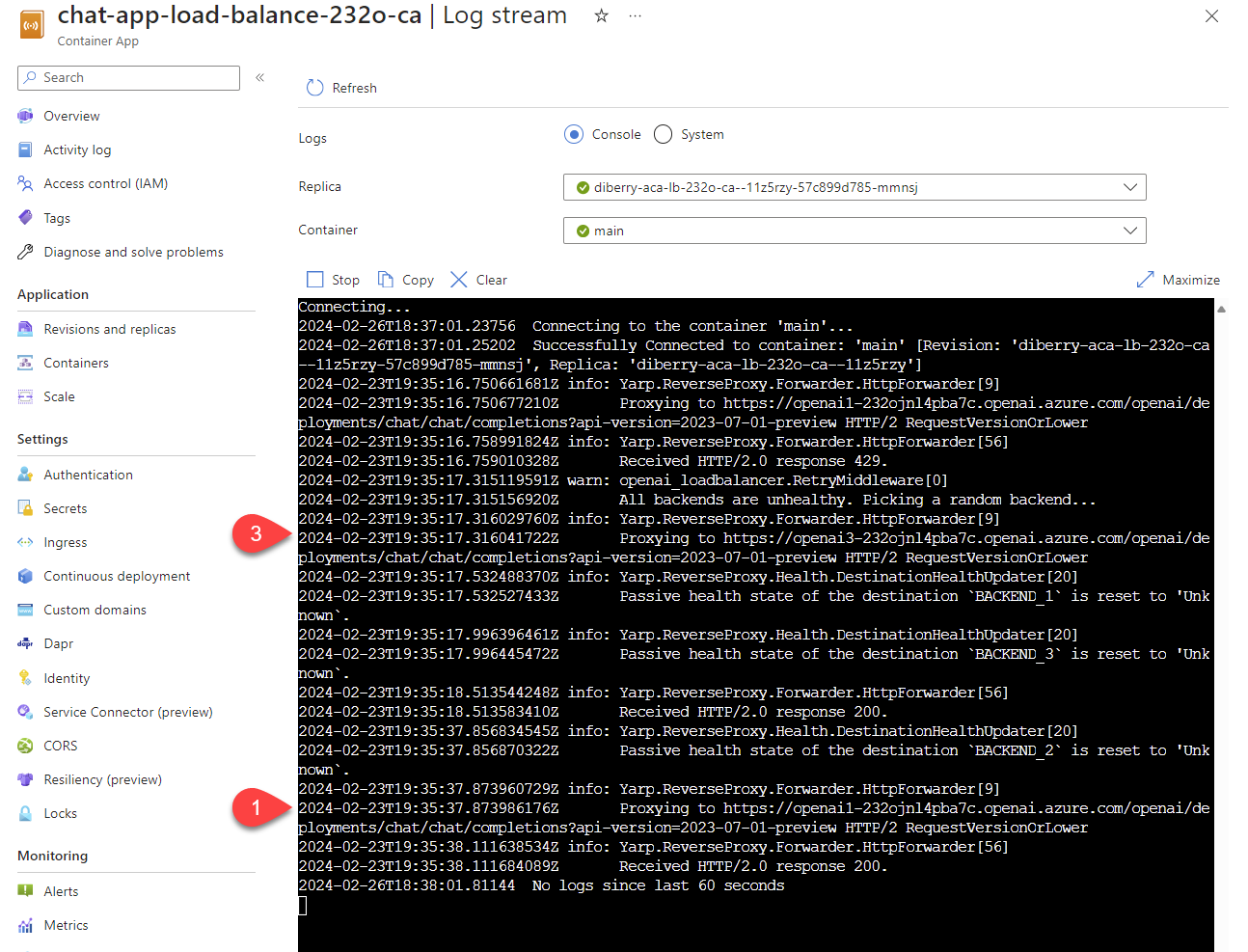

Strömma loggar för att se lastbalanserarens resultat

I listan över resurser i gruppen väljer du resursen Container App.

Välj Övervakning –> Loggström för att visa loggen.

Använd chattappen för att generera trafik i loggen.

Leta efter loggarna som refererar till Azure OpenAI-resurserna. Var och en av de tre resurserna har sin numeriska identitet i loggkommenten som börjar med

Proxying to https://openai3, där3anger den tredje Azure OpenAI-resursen.

När du använder chattappen, när lastbalanseraren får statusen att begäran har överskridit kvoten, roterar lastbalanseraren automatiskt till en annan resurs.

Konfigurera token per minutkvot (TPM)

Som standard distribueras var och en av OpenAI-instanserna i lastbalanseraren med en kapacitet på 30 000 TPM (token per minut). Du kan använda chattappen med förtroende för att den är skapad för att skala över många användare utan att kvoten tar slut. Ändra det här värdet när:

- Du får distributionskapacitetsfel: sänk det värdet.

- Planera högre kapacitet, öka värdet.

Använd följande kommando för att ändra värdet.

azd env set OPENAI_CAPACITY 50Distribuera om lastbalanseraren.

azd up

Rensa resurser

När du är klar med både chattappen och lastbalanseraren rensar du resurserna. De Azure-resurser som skapas i den här artikeln faktureras till din Azure-prenumeration. Om du inte förväntar dig att behöva dessa resurser i framtiden tar du bort dem för att undvika att debiteras mer.

Rensa chattappresurser

Gå tillbaka till chattappartikeln för att rensa resurserna.

Rensa resurser för uppladdningsbalanserare

Kör följande Azure Developer CLI-kommando för att ta bort Azure-resurserna och ta bort källkoden:

azd down --purge --force

Växlarna tillhandahåller:

purge: Borttagna resurser rensas omedelbart. På så sätt kan du återanvända Azure OpenAI TPM.force: Borttagningen sker tyst, utan att användarens medgivande krävs.

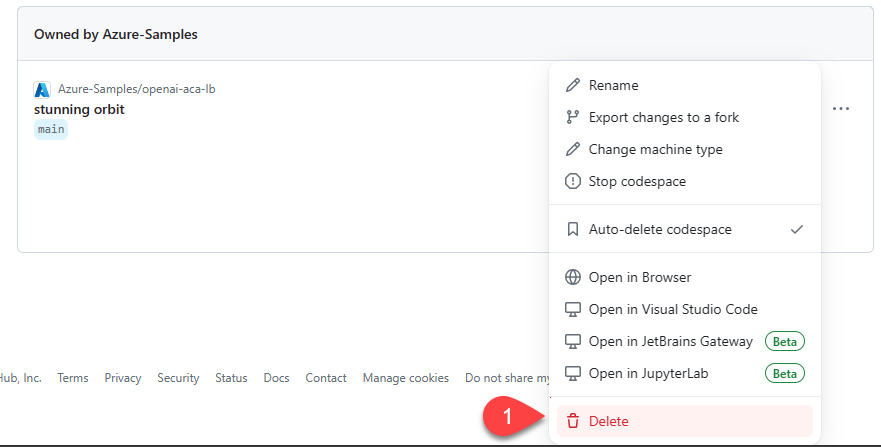

Rensa GitHub Codespaces

Om du tar bort GitHub Codespaces-miljön kan du maximera mängden kostnadsfria timmar per kärna som du får för ditt konto.

Viktigt!

Mer information om ditt GitHub-kontos rättigheter finns i GitHub Codespaces månadsvis inkluderade lagrings- och kärntimmar.

Logga in på GitHub Codespaces-instrumentpanelen (https://github.com/codespaces).

Leta upp de codespaces som körs från

azure-samples/openai-aca-lbGitHub-lagringsplatsen.

Öppna snabbmenyn för kodområdet och välj sedan Ta bort.

Få hjälp

Om du har problem med att distribuera Azure API Management-lastbalanseraren loggar du problemet till lagringsplatsens problem.

Exempelkod

Exempel som används i den här artikeln är:

Gå vidare

- Använda Azure Load Testing för att läsa in test av chattappen med

Feedback

Kommer snart: Under hela 2024 kommer vi att fasa ut GitHub-problem som feedbackmekanism för innehåll och ersätta det med ett nytt feedbacksystem. Mer information finns i: https://aka.ms/ContentUserFeedback.

Skicka och visa feedback för