Not

Åtkomst till denna sida kräver auktorisation. Du kan prova att logga in eller byta katalog.

Åtkomst till denna sida kräver auktorisation. Du kan prova att byta katalog.

Verktyget OPEN Model LLM möjliggör användning av olika öppna modeller och grundläggande modeller, till exempel Falcon och Llama 2, för bearbetning av naturligt språk i Azure Machine Learning-promptflödet.

Varning

Utfasningsmeddelande: VERKTYGET OPEN Model LLM har blivit inaktuellt till förmån för LLM-verktyget, som ger stöd för alla modeller som stöds av Azure AI-modellinferens-API:et och därmed ger det större flexibilitet.

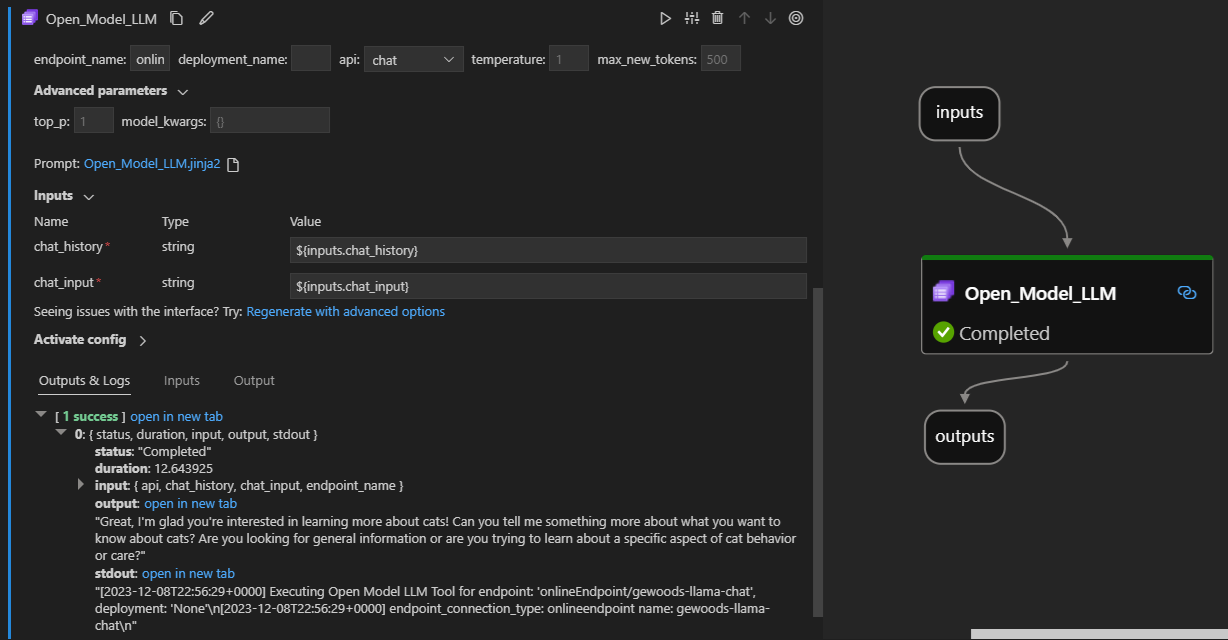

Så här fungerar det i visual Studio Code-flödestillägget. I det här exemplet används verktyget för att anropa en LlaMa-2-chattslutpunkt och fråga "Vad är CI?".

Det här promptflödesverktyget har stöd för två olika TYPER av LLM-API:

- Chatt: Visas i föregående exempel. Typen av chatt-API underlättar interaktiva konversationer med textbaserade indata och svar.

- Slutförande: Api-typen För slutförande används för att generera textavslut för enskilda svar baserat på angivna promptindata.

Snabböversikt: Hur gör jag för att använda LLM-verktyget Öppna modell?

- Välj en modell från Azure Machine Learning-modellkatalogen och få den distribuerad.

- Anslut till modelldistributionen.

- Konfigurera llm-verktygsinställningarna för öppna modeller.

- Förbered kommandotolken.

- Kör flödet.

Förutsättningar: Modelldistribution

- Välj den modell som matchade ditt scenario från Azure Machine Learning-modellkatalogen.

-

Använd knappen Distribuera för att distribuera modellen till en slutpunkt för Azure Machine Learning-onlineinferens.

- Använd något av standarddistributionsalternativen.

Mer information finns i Distribuera grundmodeller till slutpunkter för slutsatsdragning.

Förutsättningar: Anslut till modellen

För att promptflödet ska kunna använda din distribuerade modell måste du ansluta till den. Det finns två sätt att ansluta.

Slutpunktsanslutningar

När ditt flöde är kopplat till en Azure Machine Learning- eller Microsoft Foundry-arbetsyta kan verktyget Open Model LLM använda slutpunkterna på arbetsytan.

Använda Azure Machine Learning- eller Foundry-arbetsytor: Om du använder promptflöde i någon av de webbsidebaserade webbläsararbetsytorna är onlineslutpunkterna tillgängliga på den arbetsytan som upp automatiskt.

Använd VS Code eller kod först: Om du använder promptflöde i VS Code eller något av code first-erbjudandena måste du ansluta till arbetsytan. Verktyget Open Model LLM använder azure.identity DefaultAzureCredential-klienten för auktorisering. Ett sätt är att ange värden för miljöautentiseringsuppgifter.

Anpassade anslutningar

VERKTYGET ÖPPNA MODELL LLM använder CustomConnection. Prompt flow stöder två typer av anslutningar:

Anslutningar till arbetsytor – Anslutningar som lagras som hemligheter på en Azure Machine Learning-arbetsyta. Dessa anslutningar kan användas, men på många ställen skapas och underhålls de ofta i Studio-användargränssnittet. Mer information om hur du skapar en anpassad anslutning i Studio-användargränssnittet finns i skapa en anpassad anslutning.

Lokala anslutningar – Anslutningar som lagras lokalt på datorn. Dessa anslutningar är inte tillgängliga i Studio UX, men kan användas med VS Code-tillägget. Mer information om hur du skapar en lokal anpassad anslutning finns i skapa en lokal anslutning.

De nycklar som krävs för att ange är:

-

endpoint_url

- Det här värdet finns på den tidigare skapade slutpunkten för slutsatsdragning.

-

endpoint_api_key

- Se till att ange det som ett hemligt värde.

- Det här värdet finns på den tidigare skapade slutpunkten för slutsatsdragning.

-

model_family

- Värden som stöds: LLAMA, DOLLY, GPT2 eller FALCON

- Det här värdet beror på vilken typ av distribution du riktar in dig på.

Köra verktyget: Indata

VERKTYGET ÖPPNA MODELL LLM har många parametrar, varav vissa krävs. Mer information finns i följande tabell. Du kan matcha dessa parametrar med föregående skärmbild för visuell klarhet.

| Namn | Typ | Beskrivning | Obligatoriskt |

|---|---|---|---|

| API | sträng | DET API-läge som är beroende av vilken modell som används och vilket scenario som valts. Värden som stöds: (Slutförande | Chatt) | Ja |

| endpoint_name | sträng | Namnet på en slutpunkt för onlineinferens med en modell som stöds distribuerad på den. Prioriterar över anslutningen. | Ja |

| temperatur | flyttal | Slumpmässigheten i den genererade texten. Standard är 1. | Nej |

| max_new_tokens | heltal | Det maximala antalet token som ska genereras i slutförandet. Standardvärdet är 500. | Nej |

| top_p | flyttal | Sannolikheten att använda det översta valet från de genererade token. Standard är 1. | Nej |

| model_kwargs | ordbok | Dessa indata används för att tillhandahålla konfiguration som är specifik för den modell som används. Till exempel kan Llama-02-modellen använda {"temperature":0.4}. Standard: {} | Nej |

| distributionsnamn | sträng | Namnet på distributionen som ska riktas mot slutpunkten Online-slutsatsdragning. Om inget värde skickas används trafikinställningarna för inferenserlastbalanseraren. | Nej |

| snabb | sträng | Textprompten som språkmodellen använder för att generera sitt svar. | Ja |

Utdata

| API (gränssnitt för programmering av applikationer) | Returtyp | Beskrivning |

|---|---|---|

| Fullbordande | sträng | Texten i ett förutsagt slutförande |

| Chatt | sträng | Texten i ett svar i konversationen |

Distribuera till en onlineslutpunkt

När du distribuerar ett flöde som innehåller VERKTYGET ÖPPNA MODELL LLM till en onlineslutpunkt finns det ett extra steg för att konfigurera behörigheter. Under distributionen via webbsidorna finns det ett val mellan systemtilldelade och användartilldelade identitetstyper. Hur som helst, med hjälp av Azure Portal (eller en liknande funktion) lägger du till rollen "Läsare" jobb till identiteten på Azure Machine Learning-arbetsytan eller Ai Studio-projektet, som är värd för slutpunkten. Distributionen av promptflödet kan behöva uppdateras.