Not

Åtkomst till denna sida kräver auktorisation. Du kan prova att logga in eller byta katalog.

Åtkomst till denna sida kräver auktorisation. Du kan prova att byta katalog.

Viktigt

Stödet för Machine Learning Studio (klassisk) upphör den 31 augusti 2024. Vi rekommenderar att du byter till Azure Machine Learning innan dess.

Från och med den 1 december 2021 kan du inte längre skapa nya Machine Learning Studio-resurser (klassisk). Du kan fortsätta att använda befintliga Machine Learning Studio-resurser (klassisk) till och med den 31 augusti 2024.

- Se information om hur du flyttar maskininlärningsprojekt från ML Studio (klassisk) till Azure Machine Learning.

- Läs mer om Azure Machine Learning.

Dokumentationen om ML Studio (klassisk) håller på att dras tillbaka och kanske inte uppdateras i framtiden.

Läser in data från externa källor på webben. från olika former av molnbaserad lagring i Azure, till exempel tabeller, blobbar och SQL databaser, och från lokala SQL Server databaser

Kategori: Indata och utdata

Anteckning

Gäller endast för: Machine Learning Studio (klassisk)

Liknande dra och släpp-moduler finns i Azure Machine Learning designer.

Modulöversikt

Den här artikeln beskriver hur du använder modulen Importera data i Machine Learning Studio (klassisk) för att läsa in data i ett maskininlärningsexperiment från befintliga molndatatjänster.

Modulen innehåller nu en guide som hjälper dig att välja ett lagringsalternativ och välja bland befintliga prenumerationer och konton för att snabbt konfigurera alla alternativ. Behöver du redigera en befintlig dataanslutning? Inga problem; guiden läser in all tidigare konfigurationsinformation så att du inte behöver börja om från början.

När du har definierat de data som du vill ha och ansluter till källan härleder Import Data datatypen för varje kolumn baserat på de värden som den innehåller och läser in data i din Machine Learning Studio-arbetsyta (klassisk). Utdata från Importera data är en datauppsättning som kan användas med valfritt experiment.

Viktigt

För närvarande finns det begränsningar för vilka typer av lagringskonton som stöds. Mer information finns i Tekniska anteckningar.

Om källdata ändras kan du uppdatera datauppsättningen och lägga till nya data genom att köra importdata igen. Men om du inte vill läsa igen från källan varje gång du kör experimentet väljer du alternativet Använd cachelagrade resultat till SANT. När det här alternativet har valts kontrollerar modulen om experimentet har körts tidigare med samma källalternativ och samma indataalternativ. Om en tidigare körning hittas används data i cacheminnet i stället för att läsa in data från källan igen.

Anteckning

Den här modulen hette tidigare Läsare. Om du tidigare använde modulen Läsare i ett experiment byter du namn till Importera data när du uppdaterar experimentet.

Datakällor

Modulen Importera data stöder följande datakällor. Klicka på länkarna för detaljerade instruktioner och exempel på hur du använder varje datakälla.

Om du inte är säker på hur eller var du ska lagra dina data kan du läsa den här guiden till vanliga datascenarier i datavetenskapsprocessen: Scenarier för avancerad analys i Machine Learning.

| Datakälla | Använda med |

|---|---|

| Webb-URL via HTTP | Hämta data som finns på en webb-URL som använder HTTP och som har angetts i CSV-, TSV-, ARFF- eller SvmLight-format |

| Hive-fråga | Hämta data från distribuerad lagring i Hadoop. Du anger vilka data du vill använda med hiveQL-språket |

| Azure SQL Database | Hämta data från Azure SQL Database eller från Azure SQL Data Warehouse |

| Azure Tabell | Hämta data som lagras i Azure-tabelltjänsten |

| Importera från Azure Blob Storage | Hämta data som lagras i Azure Blob Service |

| Dataflödesproviders | Hämta data som exponeras som en feed i OData-format |

| Importera från lokal SQL Server-databas | Hämta data från en lokal SQL Server databas med hjälp av Microsoft Datahantering Gateway |

| Azure Cosmos DB | Hämta data som lagras i JSON-format i Azure Cosmos DB. |

Tips

Behöver du importera data i JSON-format? Både R och Python stöder REST-API:er, så använd modulerna Execute Python Script (Kör Python-skript) eller Execute R Script (Kör R-skript) för att parsa dina data och spara dem som en Azure-ML-datauppsättning.

Du kan också använda SQL DB API för CosmosDB, som stöder flera JSON-butiker, inklusive MongoDB, för att läsa dina data med hjälp av alternativet Importera från Azure Cosmos DB. Mer information finns i Importera från Azure Cosmos DB.

Så här använder du importdata

Lägg till modulen Importera data i experimentet. Du hittar den här modulen i kategorin Dataindata och utdata i Studio (klassisk).

Klicka på Guiden Starta dataimport för att konfigurera datakällan med hjälp av en guide.

Guiden hämtar kontonamnet och autentiseringsuppgifterna och hjälper dig att konfigurera andra alternativ. Om du redigerar en befintlig konfiguration läser den in de aktuella värdena först.

Om du inte vill använda guiden klickar du på Datakälla och väljer den typ av molnbaserad lagring som du läser från.

Ytterligare inställningar beror på vilken typ av lagring du väljer och om lagringen är skyddad eller inte. Du kan behöva ange kontonamn, filtyp eller autentiseringsuppgifter. Vissa källor kräver inte autentisering. för andra kan du behöva känna till kontonamnet, en nyckel eller containernamnet.

Mer information finns i listan över datakällor.

Välj alternativet Använd cachelagrade resultat om du vill cachelagra datauppsättningen för återanvändning vid efterföljande körningar.

Förutsatt att det inte har gjorts några andra ändringar av modulparametrar läser experimentet in data bara första gången modulen körs och använder därefter en cachelagrad version av datauppsättningen.

Avmarkera det här alternativet om du behöver läsa in data varje gång du kör experimentet.

Kör experimentet.

När importdata läser in data i Studio (klassisk) härleder den datatypen för varje kolumn baserat på de värden som den innehåller, antingen numeriska eller kategoriska.

Om en rubrik finns används rubriken för att namnge kolumnerna i utdatauppsättningen.

Om det inte finns några befintliga kolumnrubriker i data genereras nya kolumnnamn med formatet col1, col2,... ,coln.

Resultat

När importen är klar klickar du på utdatauppsättningen och väljer Visualisera för att se om data har importerats.

Om du vill spara data för återanvändning i stället för att importera en ny uppsättning data varje gång experimentet körs högerklickar du på utdata och väljer Spara som datauppsättning. Välj ett namn för datauppsättningen. Den sparade datauppsättningen bevarar data vid tidpunkten för sparandet och data uppdateras inte när experimentet körs igen, även om datauppsättningen i experimentet ändras. Detta kan vara praktiskt för att ta ögonblicksbilder av data.

När du har importerat data kan det behövas några ytterligare förberedelser för modellering och analys:

Generera statistiska sammanfattningar av data med hjälp av Sammanfatta data eller Beräkningsstatistik.

Använd Redigera metadata för att ändra kolumnnamn, för att hantera en kolumn som en annan datatyp eller för att ange att vissa kolumner är etiketter eller funktioner.

Använd Välj kolumner i datauppsättning för att välja en delmängd av kolumner som ska transformeras eller användas i modellering. De omvandlade eller borttagna kolumnerna kan enkelt återanslutas till den ursprungliga datauppsättningen med hjälp av modulen Lägg till kolumner eller modulen Koppla data .

Använd Partition och Exempel för att dela upp datauppsättningen, utföra sampling eller hämta de översta n raderna.

Använd Använd SQL transformation för att aggregera data, filtrera eller transformera med hjälp av SQL-instruktioner.

Använd dessa moduler för att rensa textkolumner och generera nya textfunktioner:

- Förbearbeta text

- Extrahera N-Gram-funktioner från text

- Igenkänning av namngiven enhet

- Kör Python Script för att implementera anpassad NLP baserat på nltk.

Tekniska anteckningar

Det här avsnittet innehåller en lista över kända problem med modulen Importera data samt viss allmän felsökningsinformation som inte är specifik för en källtyp.

Kontotyper som stöds

Ofta släpper Azure nya tjänster eller nya lagringstyper. Det uppstår dock vanligtvis en fördröjning medan stöd för nya kontotyper implementeras i Machine Learning Studio (klassisk).

För närvarande stöder Machine Learning alla allmänna lagringskonton, förutom de som använder zonredundant lagring (ZRS).

Lokalt redundant lagring (LRS) och geo-redundanta lagringsalternativ stöds.

Blockblobar stöds men inte tilläggsblobar.

Vanliga frågor och problem

I det här avsnittet beskrivs några kända problem, vanliga frågor och lösningar.

Rubriker måste vara enskilda rader

Om du importerar från CSV-filer bör du vara medveten om att Machine Learning tillåter en enda rubrikrad. Du kan inte infoga sidhuvuden med flera rader.

Anpassade avgränsare stöds vid import men inte export

Modulen Importera data stöder import av data som använder alternativa kolumnavgränsare, till exempel semikolon (;), som ofta används i Europa. När du importerar data från CSV-filer i extern lagring väljer du alternativet CSV med kodningar och väljer en kodning som stöds.

Du kan dock inte generera alternativa avgränsare när du förbereder data för export med hjälp av modulen Konvertera till CSV .

Dålig kolumnseparation på strängdata som innehåller kommatecken

Nästan alla tecken som kan anges som en kolumnavgränsare (flikar, blanksteg, kommatecken osv.) kan också hittas slumpmässigt i textfält. Att importera text från CSV kräver alltid försiktighet för att undvika att separera text mellan onödiga nya kolumner. Det är ett vanligt problem vid textbearbetning som du förmodligen har stött på och hanterat på olika sätt.

Problem kan också uppstå när du försöker exportera en kolumn med strängdata som innehåller kommatecken. Machine Learning stöder inte någon särskild hantering eller särskild översättning av sådana data, till exempel omsluta strängar inom citattecken. Du kan inte heller använda escape-tecken före ett kommatecken för att säkerställa att kommatecken hanteras som ett literaltecken. Därför skapas nya fält i utdatafilen för varje kommatecken som påträffas i strängfältet.

Om du vill undvika problem vid export använder du modulen Förbearbeta text för att ta bort skiljetecken från strängfält.

Du kan också använda anpassat R-skript eller Python skript för att bearbeta komplex text och se till att data kan importeras eller exporteras korrekt.

UTF-8-kodning krävs

Machine Learning kräver UTF-8-kodning. Om de data som du importerar använder en annan kodning, eller har exporterats från en datakälla som använder en annan standardkodning, kan olika problem visas i texten.

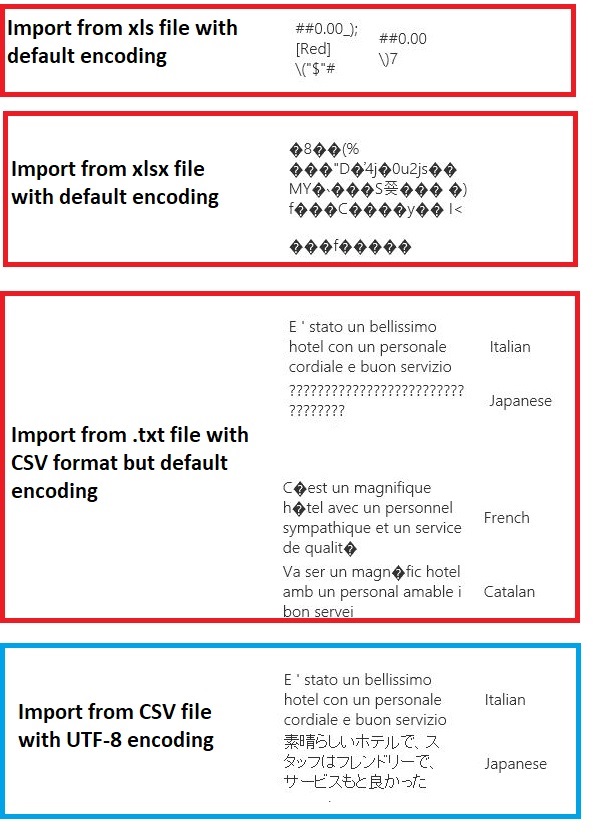

Följande bild innehåller till exempel samma datauppsättning för flera språk som exporteras från Excel och sedan importeras till Machine Learning under fyra olika kombinationer av filtyp och kodning.

Det tredje exemplet representerar data som gick förlorade under sparandet från Excel i CSV-format, eftersom rätt kodning inte angavs vid den tidpunkten. Om du stöter på problem kontrollerar du därför inte bara filen som du importerar från, utan om filen har exporterats korrekt från källan.

Datauppsättningen har inga kolumnnamn

Om den datauppsättning som du importerar inte har kolumnnamn måste du ange något av alternativen "inget sidhuvud". När du gör det lägger Import Data till standardkolumnnamn med formatet Col1, Col2 osv. Senare använder du Redigera metadata för att åtgärda kolumnnamnen.

Om du exporterar en datauppsättning till en CSV-fil använder du Redigera metadata för att lägga till kolumnnamn innan du konverterar eller exporterar den.

Lösningar för datakällor som inte stöds

Om du behöver hämta data från en källa som inte finns i listan finns det olika lösningar som du kan prova:

Om du vill ladda upp data från en fil på datorn klickar du på Ny i Studio (klassisk), väljer Datauppsättning och väljer sedan Från lokal fil. Leta upp filen och ange formatet (TSV, CSV osv.). Mer information finns i Importera träningsdata till Studio (klassisk).

Använd R eller Python. Du kan använda modulen Execute R Script (Kör R-skript ) med ett lämpligt R-paket för att hämta data från andra molndatabaser.

I modulen Execute Python Script (Kör Python Skript) kan du också läsa och konvertera data från en mängd olika källor. Se de här exemplen från Microsofts dataexperter i Cortana Intelligence Gallery:

Hämta data från AWS-kluster. Du kan köra en fråga mot ett allmänt Hive-kluster med WebHCat- eller HCatalog-slutpunkten aktiverad. Eller publicera som en sida och läsa från webb-URL:en.

Hämta data från MongoDB. Datamigreringsverktyget för Azure Cosmos DB stöder en mängd olika källor och format. Mer information och exempel finns i Azure Cosmos DB: Datamigreringsverktyg

Fler idéer och lösningar finns i Machine Learning-forumet eller Azure AI-galleriet.

Modulparametrar

Varje datakälla måste konfigureras med olika alternativ. Den här tabellen visar bara de alternativ som är gemensamma för alla datakällor.

| Name | Intervall | Typ | Standardvärde | Description |

|---|---|---|---|---|

| Datakälla | Lista | DataKälla eller mottagare | Blob-tjänst i Azure Storage | Datakällan kan vara HTTP, anonym HTTPS, en fil i blobtjänsten eller tabelltjänsten, en SQL databas i Azure, en Azure SQL Data Warehouse, en Hive-tabell eller en OData-slutpunkt. |

| Använda cachelagrade resultat | SANT/FALSKT | Boolesk | FALSE | Om sant kontrollerar modulen om experimentet har körts tidigare med samma källalternativ och samma indataalternativ, och om en tidigare körning hittas används data i cacheminnet. Om FALSE, eller om ändringar hittas, läses data in igen från källan. |

Utdata

| Namn | Typ | Description |

|---|---|---|

| Resultatdatauppsättning | Datatabell | Datauppsättning med nedladdade data |

Undantag

| Undantag | Description |

|---|---|

| Fel 0027 | Ett undantag inträffar när två objekt måste ha samma storlek, men det är de inte. |

| Fel 0003 | Ett undantag inträffar om en eller flera indata är null eller tomma. |

| Fel 0029 | Ett undantag inträffar när en ogiltig URI skickas. |

| Fel 0030 | ett undantag inträffar när det inte går att ladda ned en fil. |

| Fel 0002 | Ett undantag inträffar om en eller flera parametrar inte kunde parsas eller konverteras från den angivna typen till den typ som krävs av målmetoden. |

| Fel 0009 | Ett undantag inträffar om Namnet på Azure-lagringskontot eller containernamnet har angetts felaktigt. |

| Fel 0048 | Ett undantag inträffar när det inte går att öppna en fil. |

| Fel 0015 | Ett undantag inträffar om databasanslutningen har misslyckats. |

| Fel 0046 | Ett undantag inträffar när det inte går att skapa en katalog på den angivna sökvägen. |

| Fel 0049 | Ett undantag inträffar när det inte går att parsa en fil. |

En lista över fel som är specifika för Studio-moduler (klassiska) finns i Machine Learning Felkoder.

En lista över API-undantag finns i Machine Learning REST API-felkoder.

Se även

Indata och utdata

Konvertering av dataformat

Exportera data

A-Z-modullista