Not

Åtkomst till den här sidan kräver auktorisering. Du kan prova att logga in eller ändra kataloger.

Åtkomst till den här sidan kräver auktorisering. Du kan prova att ändra kataloger.

I den här självstudien lär du dig hur du skapar en Spark-jobbdefinition i Microsoft Fabric.

Det går snabbt och enkelt att skapa Spark-jobbdefinitionen. det finns flera sätt att komma igång.

Du kan skapa en Spark-jobbdefinition från Fabric-portalen eller med hjälp av Rest-API:et för Microsoft Fabric. Den här artikeln fokuserar på att skapa en Spark-jobbdefinition från Fabric-portalen. Information om hur du skapar en Spark-jobbdefinition med hjälp av REST-API:et finns i Apache Spark-jobbdefinitions-API v1 och Apache Spark-jobbdefinitions-API v2.

Förutsättningar

Innan du börjar behöver du:

- Ett Fabric-klientkonto med en aktiv prenumeration. Skapa ett konto utan kostnad.

- En arbetsyta i Microsoft Fabric. Mer information finns i Skapa och hantera arbetsytor i Microsoft Fabric.

- Minst ett sjöhus på arbetsytan. Lakehouse fungerar som standardfilsystem för Spark-jobbdefinitionen. Mer information finns i Skapa ett sjöhus.

- En huvuddefinitionsfil för Spark-jobbet. Den här filen innehåller programlogik och är obligatorisk för att köra ett Spark-jobb. Varje Spark-jobbdefinition kan bara ha en huvuddefinitionsfil.

Du måste ge Spark-jobbdefinitionen ett namn när du skapar den. Namnet måste vara unikt i den aktuella arbetsytan. Den nya Spark-jobbdefinitionen skapas i den aktuella arbetsytan.

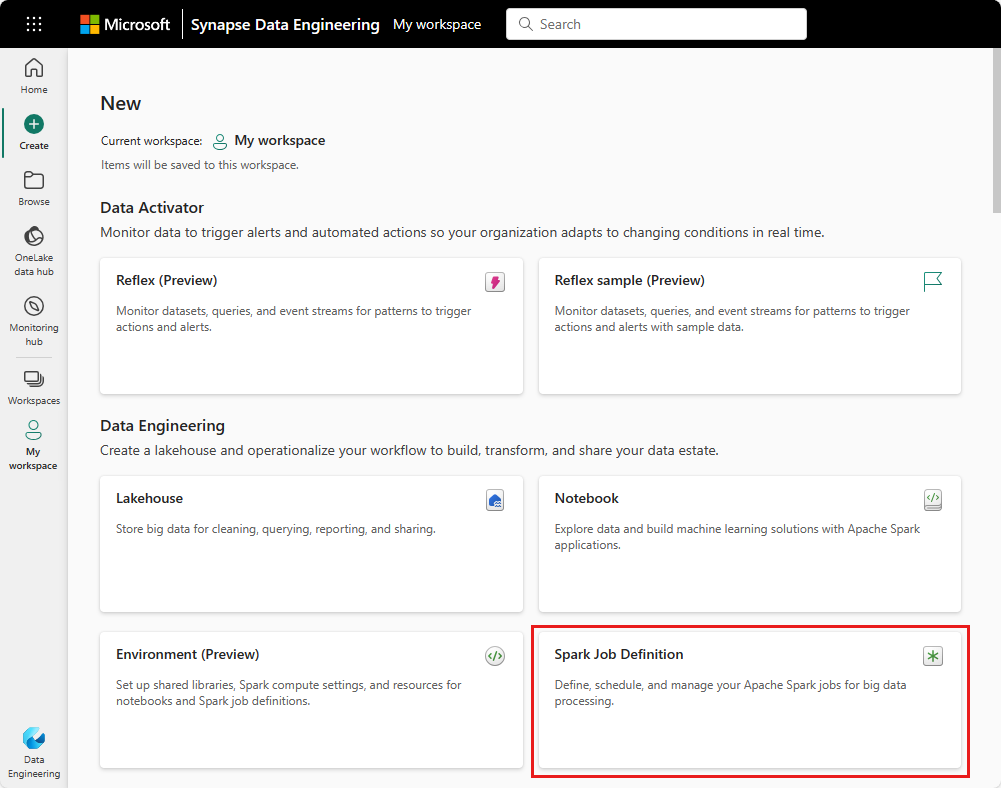

Skapa en Spark-jobbdefinition i Fabric-portalen

Följ dessa steg för att skapa en Spark-jobbdefinition i Infrastrukturportalen:

- Logga in på Microsoft Fabric-portalen.

- Navigera till önskad arbetsyta där du vill skapa Spark-jobbdefinitionen.

- Välj Nytt objekt>Spark-jobbdefinition.

- I fönstret Ny Spark-jobbdefinition anger du följande information:

- Namn: Ange ett unikt namn för Spark-jobbdefinitionen.

- Plats: Välj arbetsytans plats.

- Välj Skapa för att skapa Spark-jobbdefinitionen.

En alternativ ingångspunkt för att skapa en Spark-jobbdefinition är panelen Dataanalys med hjälp av en SQL... på Fabric-hemsidan. Du hittar samma alternativ genom att välja panelen Allmänt.

När du väljer panelen uppmanas du att skapa en ny arbetsyta eller välja en befintlig. När du har valt arbetsytan öppnas sidan Skapa Spark-jobbdefinition.

Anpassa en Spark-jobbdefinition för PySpark (Python)

Innan du skapar en Spark-jobbdefinition för PySpark behöver du en exempelfil i Parquet-format som laddas upp till lakehouse.

- Ladda ned parquet-exempelfilen yellow_tripdata_2022-01.parquet.

- Gå till lakehouse där du vill ladda upp filen.

- Ladda upp den till avsnittet "Files" i lakehouse.

Så här skapar du en Spark-jobbdefinition för PySpark:

Välj PySpark (Python) i listrutan Språk .

Ladda ned createTablefromParquet.py exempeldefinitionsfil. Ladda upp den som huvuddefinitionsfil. Huvuddefinitionsfilen (jobb. Main) är filen som innehåller programlogik och är obligatorisk för att köra ett Spark-jobb. För varje Spark-jobbdefinition kan du bara ladda upp en huvuddefinitionsfil.

Kommentar

Du kan ladda upp huvuddefinitionsfilen från ditt lokala skrivbord eller ladda upp från en befintlig Azure Data Lake Storage (ADLS) Gen2 genom att tillhandahålla filens fullständiga ABFSS-sökväg. Exempel:

abfss://your-storage-account-name.dfs.core.windows.net/your-file-pathDu kan också ladda upp referensfiler som

.py(Python)-filer. Referensfilerna är de Python-moduler som huvuddefinitionsfilen importerar. Precis som huvuddefinitionsfilen kan du ladda upp från skrivbordet eller en befintlig ADLS Gen2. Flera referensfiler stöds.Dricks

Om du använder en ADLS Gen2-sökväg kontrollerar du att filen är tillgänglig. Du måste ge det användarkonto som kör jobbet rätt behörighet till lagringskontot. Här är två olika sätt som du kan ge behörigheten:

- Tilldela användarkontot en deltagarroll för lagringskontot.

- Bevilja läs- och körningsbehörighet till användarkontot för filen via ADLS Gen2-åtkomstkontrollistan (ACL).

För en manuell körning används kontot för den aktuella inloggade användaren för att köra jobbet.

Ange kommandoradsargument för jobbet om det behövs. Använd ett blanksteg som en delning för att separera argumenten.

Lägg till lakehouse-referensen till jobbet. Minst en lakehouse-referens måste läggas till i jobbet. Det här lakehouse är standardkontexten för lakehouse för jobbet.

Flera lakehouse-referenser stöds. Leta reda på lakehouse-namnet som inte är standard och den fullständiga OneLake-URL:en på sidan Spark-inställningar .

Anpassa en Spark-jobbdefinition för Scala/Java

Så här skapar du en Spark-jobbdefinition för Scala/Java:

Välj Spark(Scala/Java) i listrutan Språk .

Ladda upp huvuddefinitionsfilen som en

.jar(Java)-fil. Huvuddefinitionsfilen är den fil som innehåller programlogik för det här jobbet och är obligatorisk för att köra ett Spark-jobb. För varje Spark-jobbdefinition kan du bara ladda upp en huvuddefinitionsfil. Ange huvudklassnamnet.Du kan också ladda upp referensfiler som

.jar(Java)-filer. Referensfilerna är de filer som huvuddefinitionsfilen refererar till/importerar.Ange kommandoradsargument för jobbet om det behövs.

Lägg till lakehouse-referensen till jobbet. Minst en lakehouse-referens måste läggas till i jobbet. Det här lakehouse är standardkontexten för lakehouse för jobbet.

Anpassa en Spark-jobbdefinition för R

Så här skapar du en Spark-jobbdefinition för SparkR(R):

Välj SparkR(R) i listrutan Språk .

Ladda upp huvuddefinitionsfilen som en

.r(R)-fil. Huvuddefinitionsfilen är den fil som innehåller programlogik för det här jobbet och är obligatorisk för att köra ett Spark-jobb. För varje Spark-jobbdefinition kan du bara ladda upp en huvuddefinitionsfil.Du kan också ladda upp referensfiler som

.r(R)-filer. Referensfilerna är de filer som refereras till/importeras av huvuddefinitionsfilen.Ange kommandoradsargument för jobbet om det behövs.

Lägg till lakehouse-referensen till jobbet. Minst en lakehouse-referens måste läggas till i jobbet. Det här lakehouse är standardkontexten för lakehouse för jobbet.

Kommentar

Spark-jobbdefinitionen skapas i den aktuella arbetsytan.

Alternativ för att anpassa Spark-jobbdefinitioner

Det finns några alternativ för att ytterligare anpassa körningen av Spark-jobbdefinitioner.

Spark Compute: På fliken Spark Compute kan du se Fabric-körningsversionen som används för att köra Spark-jobbet. Du kan också se spark-konfigurationsinställningarna som används för att köra jobbet. Du kan anpassa Spark-konfigurationsinställningarna genom att välja knappen Lägg till .

Optimering: På fliken Optimering kan du aktivera och konfigurera återförsöksprincipen för jobbet. När det är aktiverat görs ett nytt försök om det misslyckas. Du kan också ange det maximala antalet återförsök och intervallet mellan återförsök. För varje återförsök startas jobbet om. Kontrollera att jobbet är idempotent.