Kommentar

Åtkomst till den här sidan kräver auktorisering. Du kan prova att logga in eller ändra kataloger.

Åtkomst till den här sidan kräver auktorisering. Du kan prova att ändra kataloger.

Microsoft Fabric Runtime är en Azure-integrerad plattform baserad på Apache Spark som möjliggör körning och hantering av datateknik och datavetenskapsupplevelser. Den kombinerar viktiga komponenter från både interna källor och källor med öppen källkod, vilket ger kunderna en omfattande lösning. För enkelhetens skull refererar vi till Microsoft Fabric Runtime som drivs av Apache Spark som Fabric Runtime.

Huvudkomponenter i Fabric Runtime:

Apache Spark – ett kraftfullt bibliotek med distribuerad databehandling med öppen källkod som möjliggör storskalig databearbetning och analysuppgifter. Apache Spark är en mångsidig och högpresterande plattform för datateknik och datavetenskap.

Delta Lake – ett lagringslager med öppen källkod som ger APACHE Spark acid-transaktioner och andra funktioner för datatillförlitlighet. Delta Lake är integrerat i Fabric Runtime och förbättrar databehandlingsfunktionerna och säkerställer datakonsekvens i flera samtidiga åtgärder.

Den ursprungliga körmotorn – är en transformativ förbättring för Apache Spark-beräkningsarbetsbelastningar som ger betydande prestandavinster genom att köra Spark-frågor direkt på lakehouse-infrastrukturen. Sömlöst integrerat och det kräver inga kodändringar, undviker beroende av leverantör och stöder både Parquet- och Delta-format i Apache Spark-API:erna i Runtime 1.3 (Spark 3.5). Den här motorn ökar frågehastigheten upp till fyra gånger snabbare än traditionell OSS Spark, vilket visas av TPC-DS 1 TB-benchmark, vilket minskar driftskostnaderna och förbättrar effektiviteten för olika datauppgifter, inklusive datainmatning, ETL, analys och interaktiva frågor. Den interna körningsmotorn baseras på två viktiga OSS-komponenter: Velox, ett C++-databasaccelerationsbibliotek som introducerades av Meta och Apache Gluten (inkubering), ett mellanlager som ansvarar för att avlasta JVM-baserade SQL-motorers körning till inbyggda motorer som introducerades av Intel.

Standardpaket för Java/Scala, Python och R – paket som stöder olika programmeringsspråk och miljöer. Dessa paket installeras och konfigureras automatiskt, vilket gör att utvecklare kan använda sina föredragna programmeringsspråk för databearbetningsuppgifter.

Microsoft Fabric Runtime bygger på ett robust operativsystem med öppen källkod som säkerställer kompatibilitet med olika maskinvarukonfigurationer och systemkrav.

Nedan hittar du en omfattande jämförelse av viktiga komponenter, inklusive Apache Spark-versioner, operativsystem som stöds, Java, Scala, Python, Delta Lake och R, för Apache Spark-baserade körningar inom Microsoft Fabric-plattformen.

Tips/Råd

Använd alltid den senaste, allmänt tillgängliga körningsversionen (GA) för din produktionsarbetsbelastning, som för närvarande är Runtime 1.3.

| Komponent | Körtid 1.2 | Körtid 1.3 | Runtime-miljö 2.0 |

|---|---|---|---|

| utgivningsfas | EOSA | GA | Experimentell (förhandsversion) |

| Apache Spark-version | 3.4.1 | 3.5.5 | 4.0.0 |

| Operativsystem | Mariner 2.0 | Mariner 2.0 | Mariner 3.0 |

| Java-version | 11 | 11 | 21 |

| Scala-version | 2.12.17 | 2.12.17 | 2.13.16 |

| Python-version | 3.10 | 3.11 | 3.12.11 |

| Delta Lake-version | 2.4.0 | 3.2 | 4.0.0 |

Besök Runtime 1.2, Runtime 1.3 eller Runtime 2.0 för att utforska information, nya funktioner, förbättringar och migreringsscenarier för den specifika körningsversionen.

Nätverksoptimeringar

I Microsoft Fabric innehåller både Spark-motorn och Delta Lake-implementeringarna plattformsspecifika optimeringar och funktioner. De här funktionerna är utformade för att använda inbyggda integreringar på plattformen. Observera att alla dessa funktioner kan inaktiveras för att uppnå standardfunktionerna spark och Delta Lake. Körningsmiljöer för Apache Spark omfattar:

- Den fullständiga versionen av Apache Spark med öppen källkod.

- En samling med nästan 100 inbyggda, distinkta förbättringar av frågeprestanda. De här förbättringarna omfattar funktioner som partitionscachelagring (vilket gör att FileSystem-partitionscachen kan minska metaarkivanrop) och Korskoppling till projektion av skalära underfrågor.

- Inbyggd intelligent cache.

I Fabric Runtime för Apache Spark och Delta Lake finns det inbyggda skrivfunktioner som har två viktiga syften:

- De erbjuder differentierad prestanda för skrivarbete, optimerar skrivprocessen.

- De använder V-Order-optimering som standard för Delta Parquet-filer. Delta Lake V-Order-optimeringen är avgörande för att leverera överlägsen läsprestanda för alla Fabric-motorer. Mer information om hur det fungerar och hur du hanterar det finns i den dedikerade artikeln om Delta Lake-tabelloptimering och V-Order.

Stöd för flera körmiljöer

Fabric stöder flera körningar, vilket ger användarna flexibilitet att smidigt växla mellan dem, vilket minimerar risken för inkompatibiliteter eller störningar.

Som standard använder alla nya arbetsytor den senaste GA-körningsversionen, som för närvarande är Runtime 1.3.

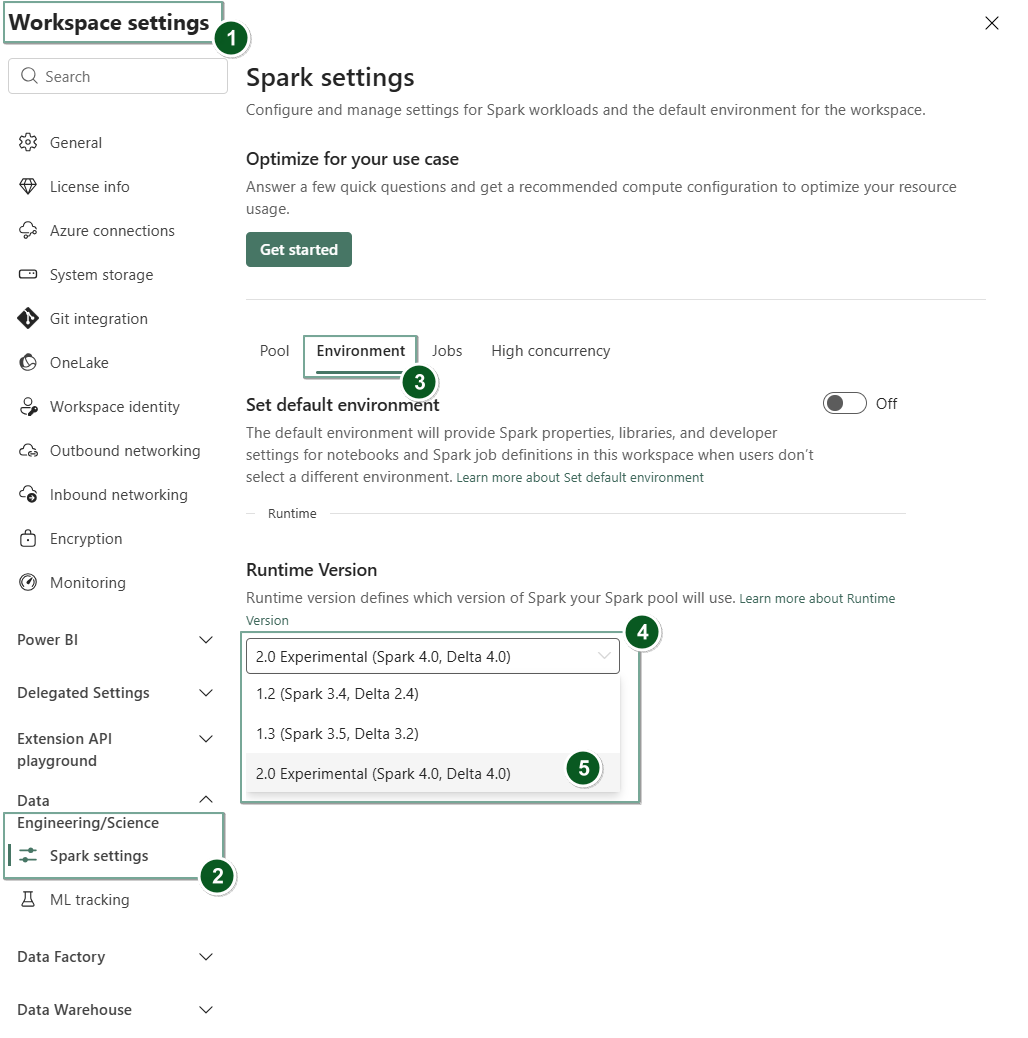

Om du vill ändra körningsversionen på arbetsytenivå går du till Arbetsyteinställningar>Data Engineering/Science>Spark-inställningar. På fliken Miljö väljer du den önskade körtidsversionen från de tillgängliga alternativen. Välj Spara för att bekräfta ditt val.

När du har gjort den här ändringen fungerar alla systemskapade objekt på arbetsytan, inklusive Lakehouses, SJD och Notebooks, med den nyligen valda körningsversionen på arbetsytenivå från och med nästa Spark-session. Om du för närvarande använder en notebook-fil med en befintlig session för ett jobb eller någon lakehouse-relaterad aktivitet, fortsätter Spark-sessionen som den är. Från och med nästa session eller jobb tillämpas dock den valda körningsversionen.

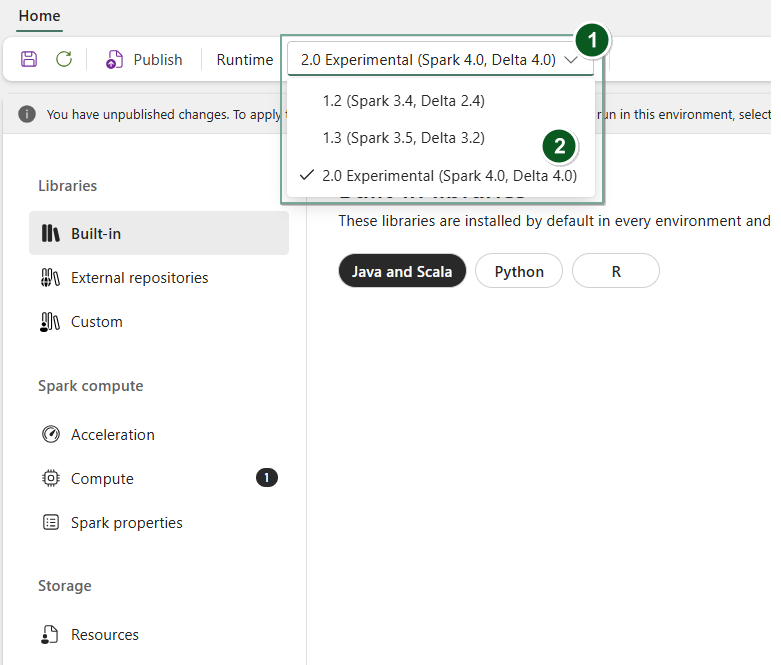

Om du vill ändra körningen på Environment objektnivå skapar du dessutom ett nytt miljöobjekt eller öppnar ett befintligt, under listrutan Körning väljer du önskad körningsversion bland de tillgängliga alternativen, väljer Save och sedan Publish dina ändringar. Sedan kan du använda det här Environment objektet med ditt Notebook eller Spark Job Definition.

Konsekvenser av körningstidsändringar i Spark-inställningar

I allmänhet strävar vi efter att migrera alla Spark-inställningar. Men om vi upptäcker att Spark-inställningen inte är kompatibel med Runtime B utfärdar vi ett varningsmeddelande och avstår från att implementera inställningen.

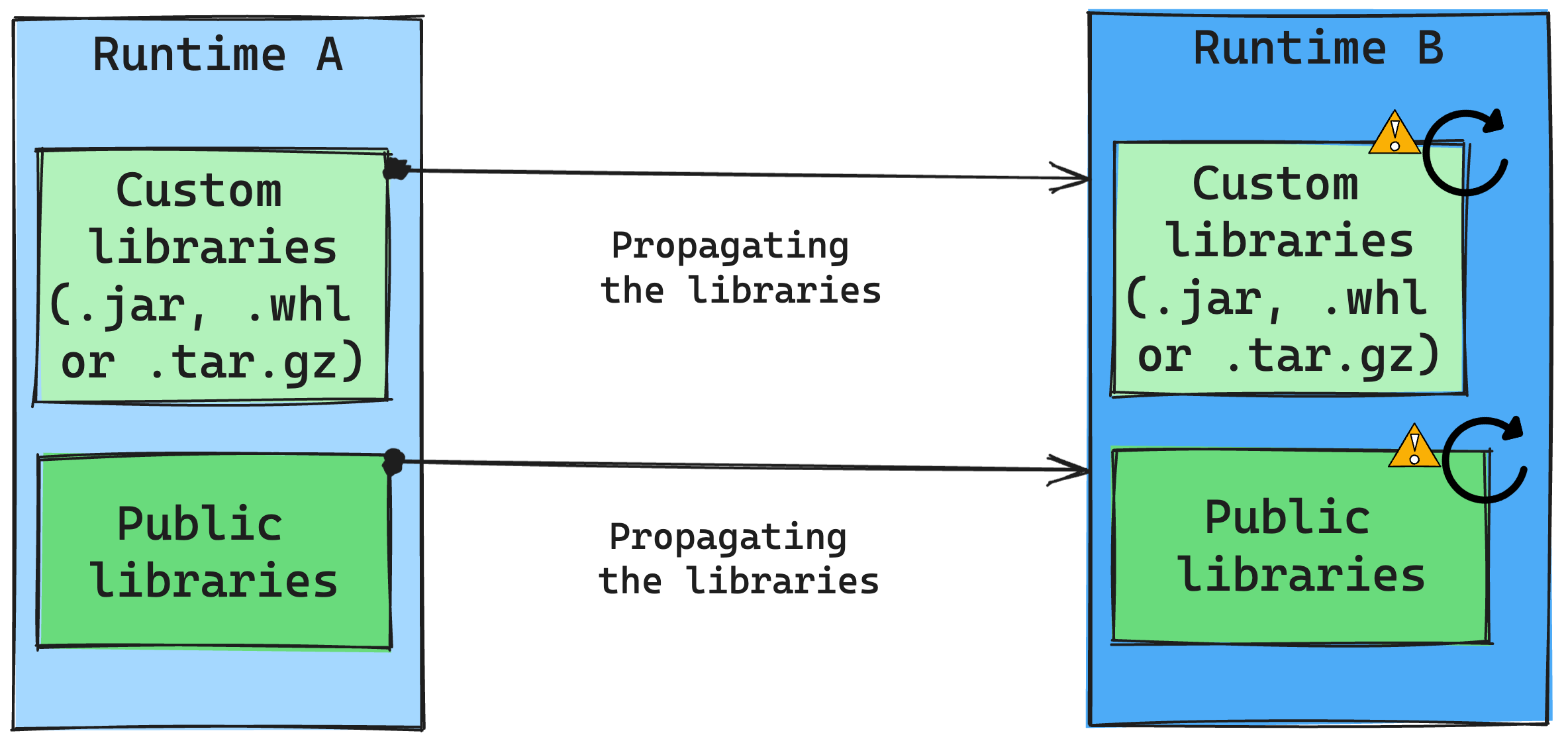

Konsekvenser av ändringar under körning för bibliotekshantering

I allmänhet är vår metod att migrera alla bibliotek från Runtime A till Runtime B, inklusive både publika och anpassade runtimes. Om Python- och R-versionerna förblir oförändrade bör biblioteken fungera korrekt. För Jars är det dock mycket troligt att de inte fungerar på grund av ändringar i beroenden och andra faktorer som ändringar i Scala, Java, Spark och operativsystemet.

Användaren ansvarar för att uppdatera eller ersätta bibliotek som inte fungerar med Runtime B. Om det finns en konflikt, vilket innebär att Runtime B innehåller ett bibliotek som ursprungligen definierades i Runtime A, försöker vårt bibliotekshanteringssystem skapa det nödvändiga beroendet för Runtime B baserat på användarens inställningar. Byggprocessen misslyckas dock om en konflikt uppstår. I felloggen kan användarna se vilka bibliotek som orsakar konflikter och göra justeringar i sina versioner eller specifikationer.

Uppgradera Delta Lake-protokollet

Delta Lake-funktioner är alltid bakåtkompatibla, vilket säkerställer att tabeller som skapats i en lägre Delta Lake-version sömlöst kan interagera med högre versioner. Men när vissa funktioner är aktiverade (till exempel genom att använda delta.upgradeTableProtocol(minReaderVersion, minWriterVersion)-metoden) kan framåtkompatibilitet med lägre Delta Lake-versioner komprometteras. I sådana fall är det viktigt att ändra arbetsbelastningar som refererar till de uppgraderade tabellerna så att de överensstämmer med en Delta Lake-version som upprätthåller kompatibiliteten.

Varje Delta-tabell är associerad med en protokollspecifikation som definierar de funktioner som den stöder. Program som interagerar med tabellen, antingen för läsning eller skrivning, förlitar sig på den här protokollspecifikationen för att avgöra om de är kompatibla med tabellens funktionsuppsättning. Om ett program saknar möjlighet att hantera en funktion som anges som stöds i tabellens protokoll kan det inte läsa från eller skriva till den tabellen.

Protokollspecifikationen är uppdelad i två olika komponenter: protokollet "read" och "write". Mer information finns på sidan "Hur hanterar Delta Lake funktionskompatibilitet?".

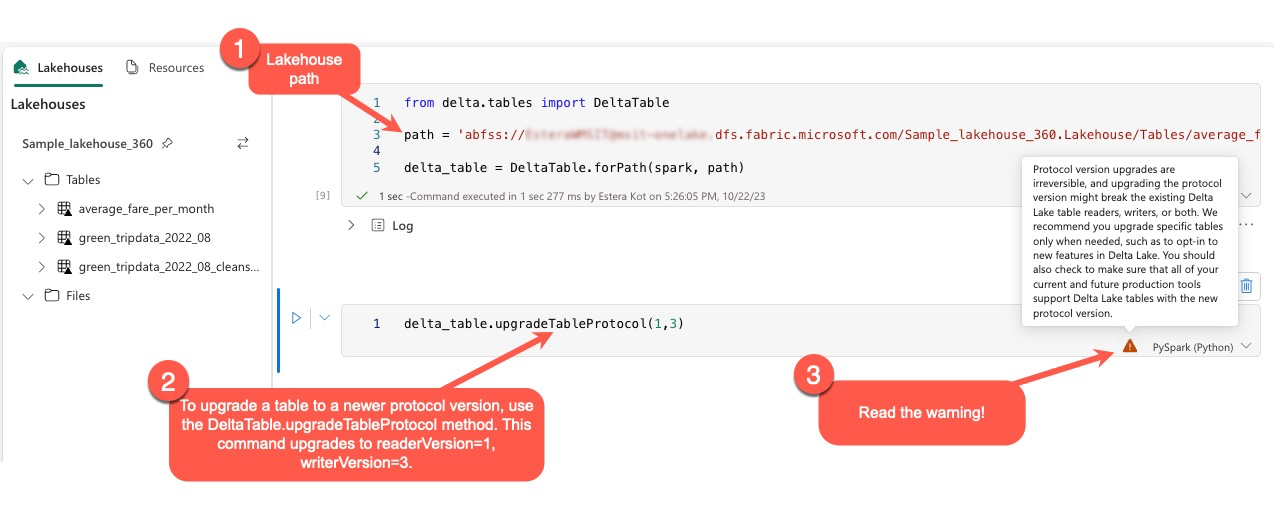

Användare kan köra kommandot delta.upgradeTableProtocol(minReaderVersion, minWriterVersion) i PySpark-miljön och i Spark SQL och Scala. Med det här kommandot kan de initiera en uppdatering i Delta-tabellen.

Det är viktigt att observera att när de utför den här uppgraderingen får användarna en varning som anger att uppgraderingen av Delta-protokollversionen är en icke-omvänd process. Det innebär att när uppdateringen har körts kan den inte ångras.

Protokollversionsuppgraderingar kan potentiellt påverka kompatibiliteten för befintliga Delta Lake-tabellläsare, skrivare eller båda. Därför rekommenderar vi att du fortsätter med försiktighet och uppgraderar protokollversionen endast när det behövs, till exempel när du använder nya funktioner i Delta Lake.

Viktigt!

Mer information om vilka protokollversioner och funktioner som är kompatibla för alla Microsoft Fabric-upplevelser finns i Delta Lake-tabellformatets samverkan.

Dessutom bör användarna kontrollera att alla aktuella och framtida produktionsarbetsbelastningar och processer är kompatibla med Delta Lake-tabeller med hjälp av den nya protokollversionen för att säkerställa en sömlös övergång och förhindra eventuella störningar.