Modul 1: Skapa en pipeline med Data Factory

Den här modulen tar 10 minuter att mata in rådata från källlagret i tabellen Brons i ett data lakehouse med hjälp av aktiviteten Kopiera i en pipeline.

De övergripande stegen i modul 1 är följande:

- Skapa en datapipeline.

- Använd en kopieringsaktivitet i pipelinen för att läsa in exempeldata till ett Data Lakehouse.

Skapa en datapipeline

Ett Microsoft Fabric-klientkonto med en aktiv prenumeration krävs. Skapa ett kostnadsfritt konto.

Kontrollera att du har en Microsoft Fabric-aktiverad arbetsyta: Skapa en arbetsyta.

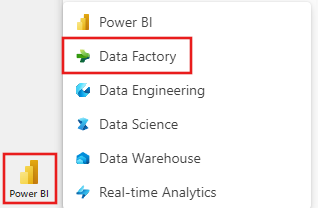

Logga in på Power BI.

Välj power BI-standardikonen längst ned till vänster på skärmen och växla till Data Factory-upplevelsen .

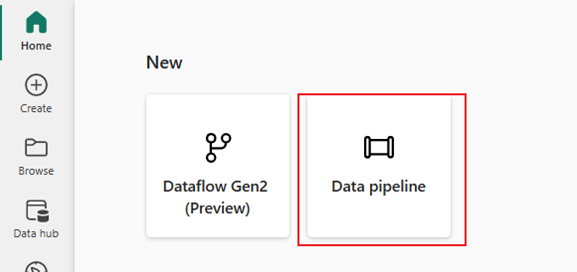

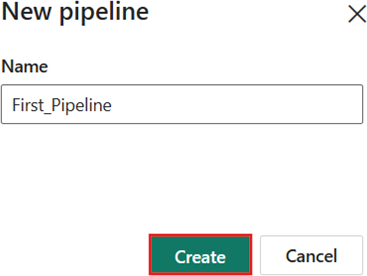

Välj Datapipeline och ange ett pipelinenamn. Välj sedan Skapa.

Använda en aktiviteten Kopiera i pipelinen för att läsa in exempeldata till ett data lakehouse

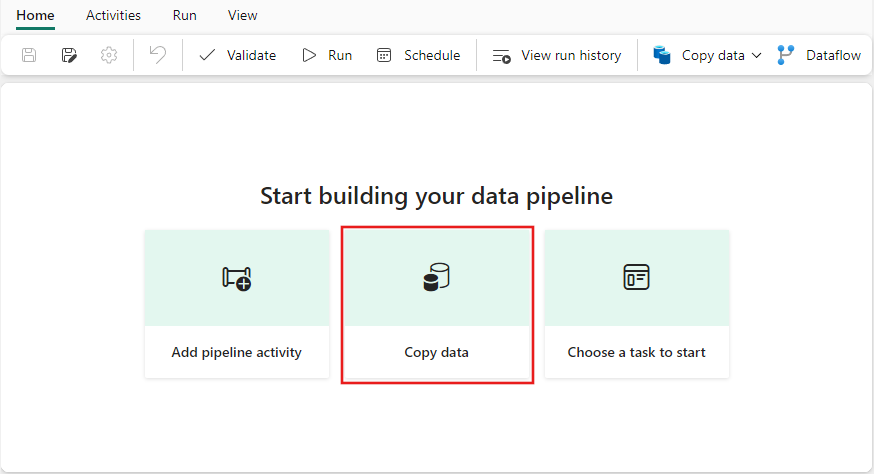

Steg 1: Använd kopieringsassistenten för att konfigurera en kopieringsaktivitet.

Välj Kopiera data för att öppna verktyget kopieringsassistenten.

Steg 2: Konfigurera inställningarna i kopieringsassistenten.

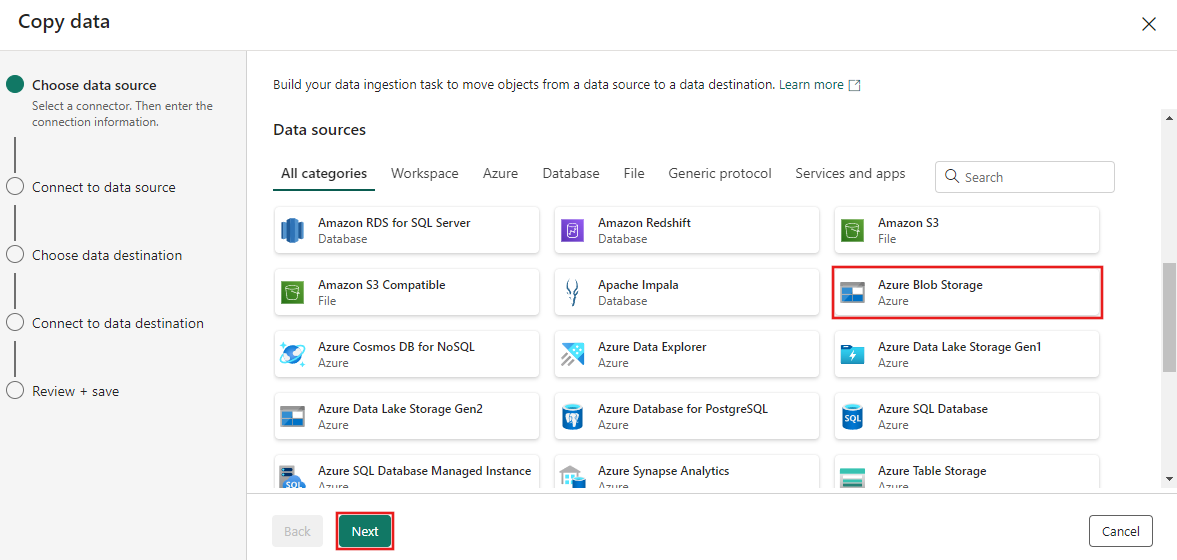

Dialogrutan Kopiera data visas med det första steget, Välj datakälla, markerat. Rulla nedåt om det behövs till avsnittet Datakällor och välj datakällans typ av Azure Blob Storage . Välj sedan Nästa.

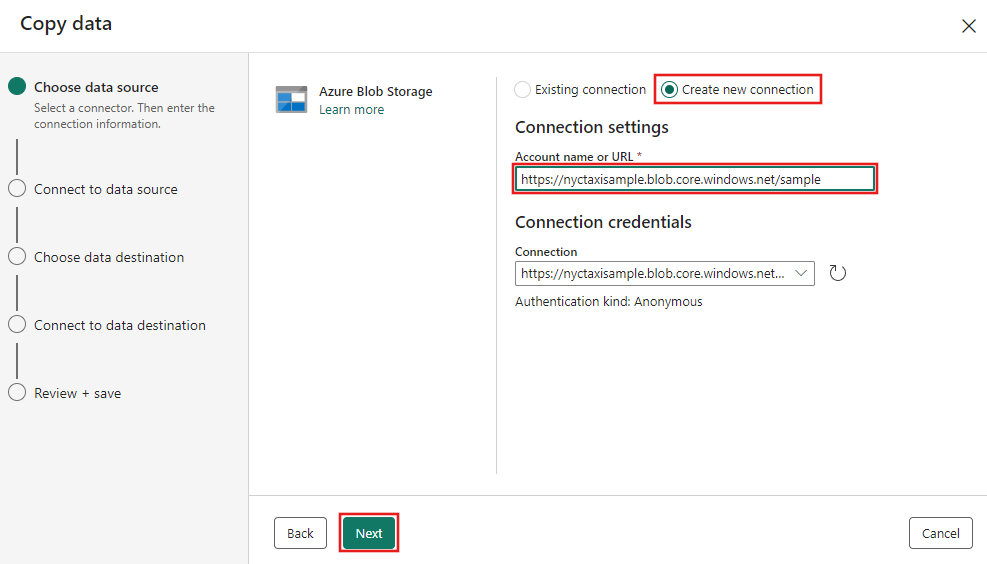

I nästa steg väljer du Skapa ny anslutning och anger sedan URL:en för bloblagringen som är värd för exempeldata som tillhandahålls för den här självstudien på

https://nyctaxisample.blob.core.windows.net/sample. Autentiseringstyp är Anonym. Välj Nästa när du har angett URL:en.

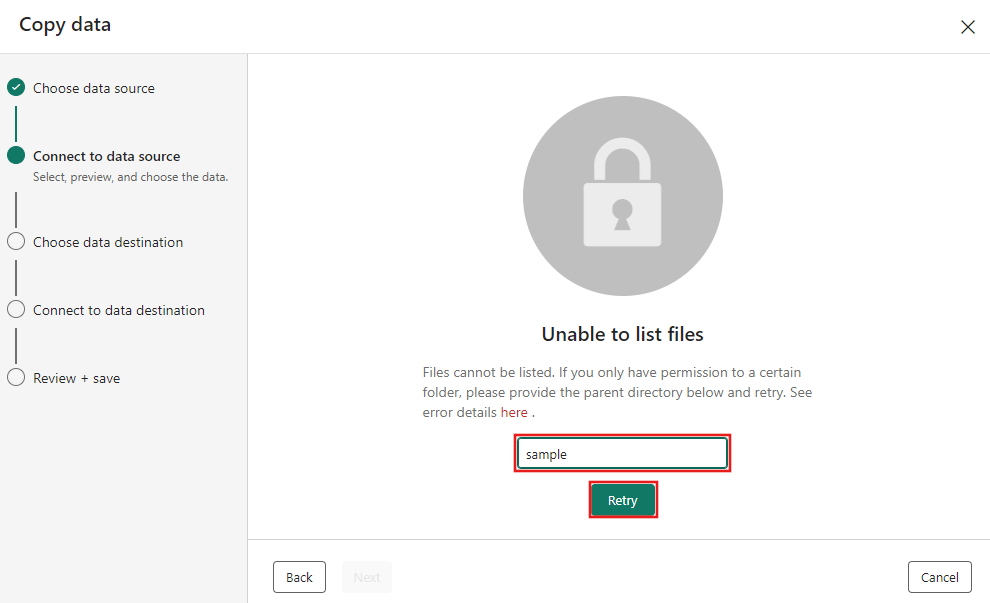

Steget Anslut till datakälla visas, och till en början visas ett fel Som inte kan visa filer, eftersom behörigheter bara har beviljats till exempelmappen i bloblagringen. Ange mappnamn, exempel och välj Försök igen.

Kommentar

Bloblagringsmappen är skiftlägeskänslig och bör vara i alla gemener.

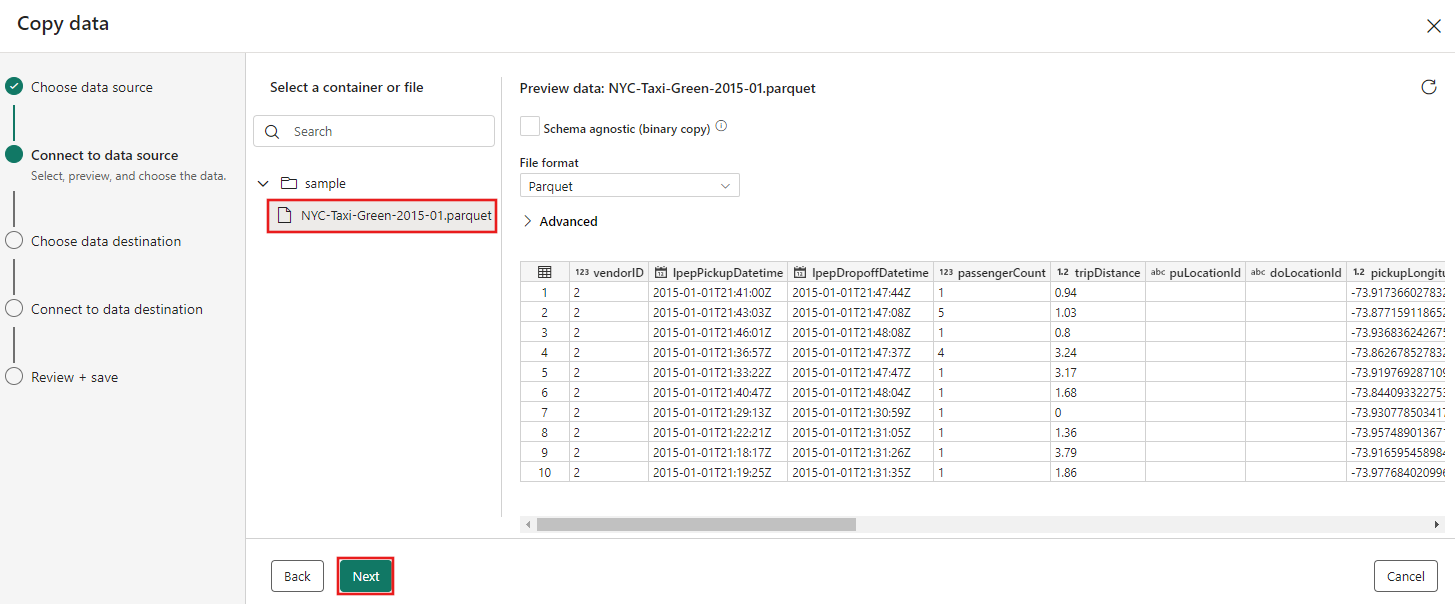

Blob storage-webbläsaren visas härnäst. Välj filen NYC-Taxi-Green-2015-01.parquet och vänta tills dataförhandsgranskningen visas. Välj sedan Nästa.

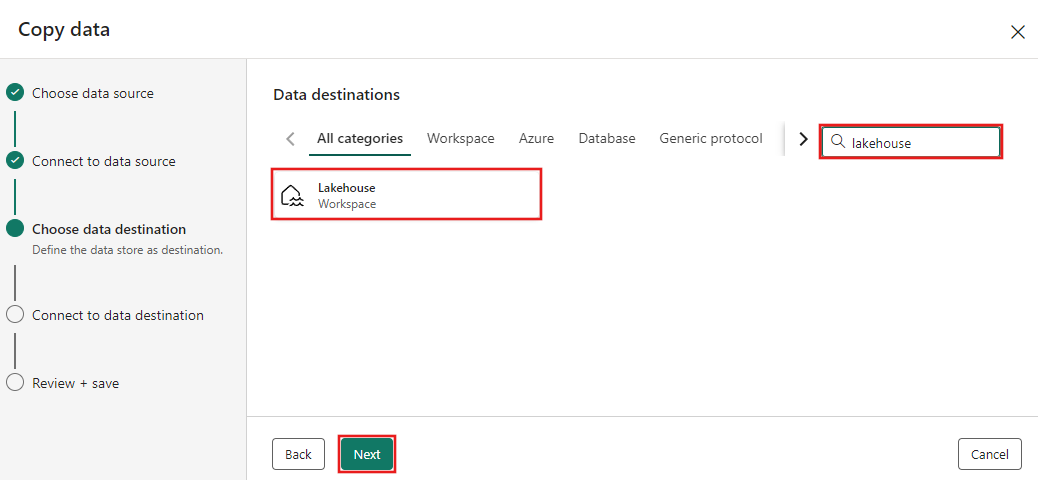

I steget Välj datamål i kopieringsassistenten väljer du Lakehouse och sedan Nästa.

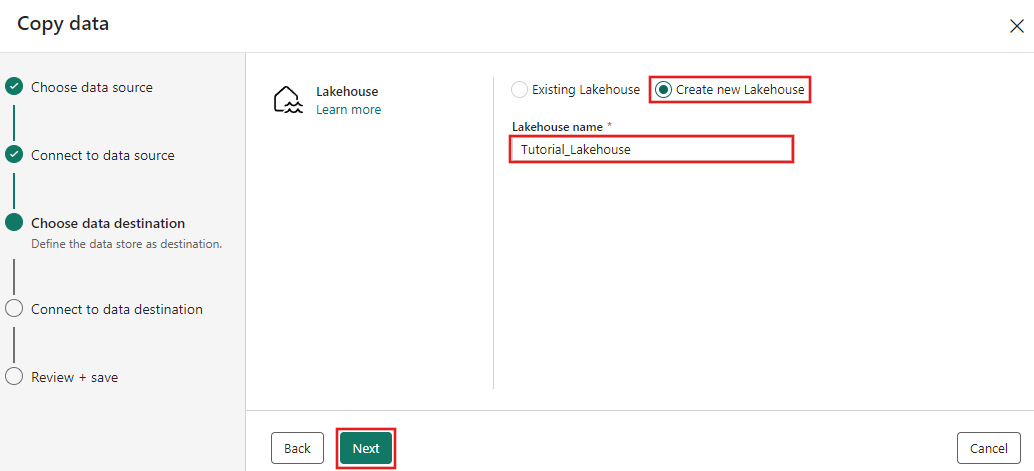

Välj Skapa nytt Lakehouse på konfigurationssidan för datamål som visas och ange ett namn för det nya Lakehouse. Välj sedan Nästa igen.

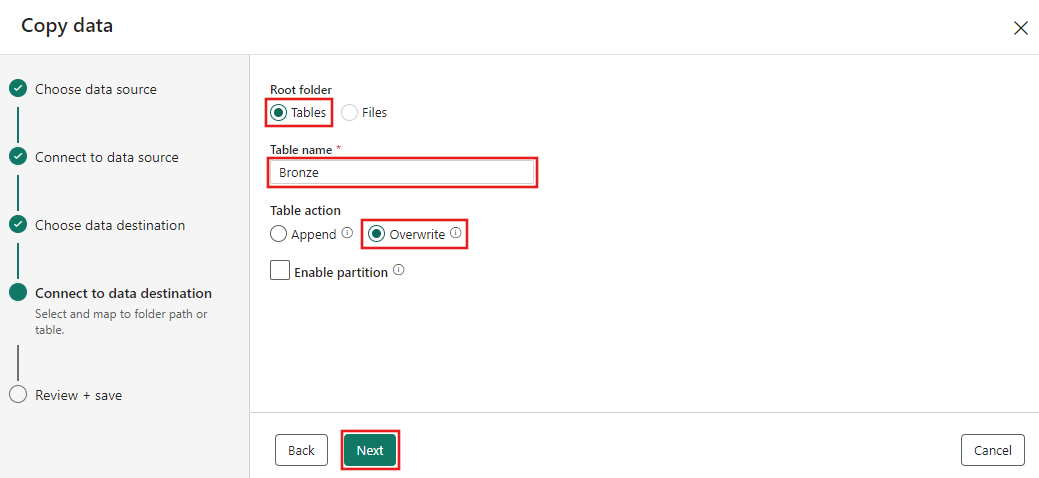

Konfigurera nu information om ditt Lakehouse-mål på sidan Välj och mappa till mappsökväg eller tabell. Välj Tabeller för rotmappen, ange ett tabellnamn och välj åtgärden Skriv över. Markera inte kryssrutan Aktivera partition som visas när du har valt åtgärden Skriv över tabell.

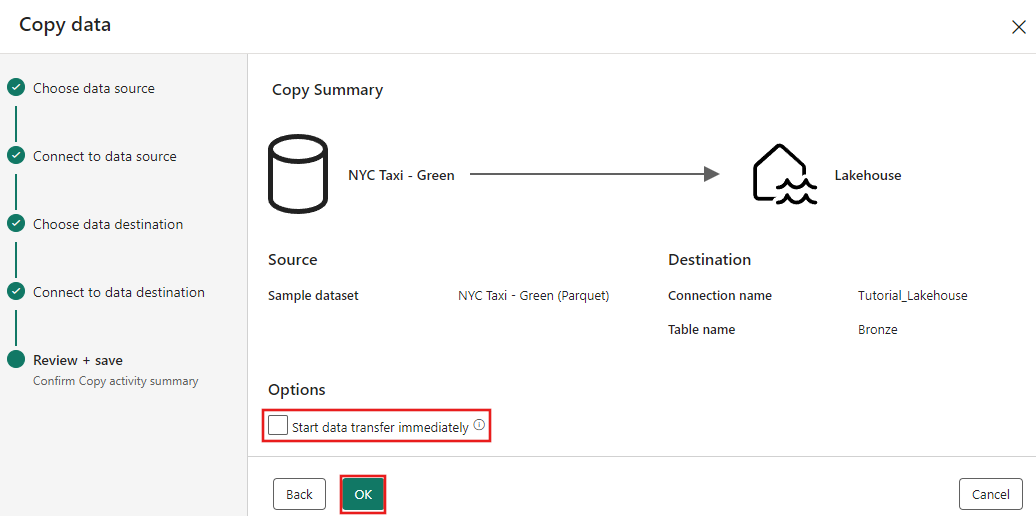

Granska slutligen konfigurationen på sidan Granska + spara i kopieringsdataassistenten. I den här självstudien avmarkerar du kryssrutan Starta dataöverföring omedelbart eftersom vi kör aktiviteten manuellt i nästa steg. Välj sedan OK.

Steg 3: Kör och visa resultatet av din aktiviteten Kopiera.

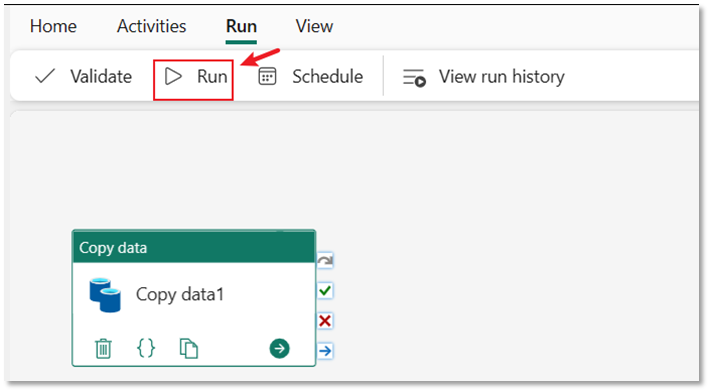

Välj fliken Kör i pipelineredigeraren. Välj sedan knappen Kör och sedan Spara och kör i kommandotolken för att köra aktiviteten Kopiera.

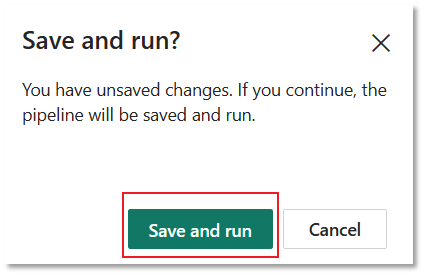

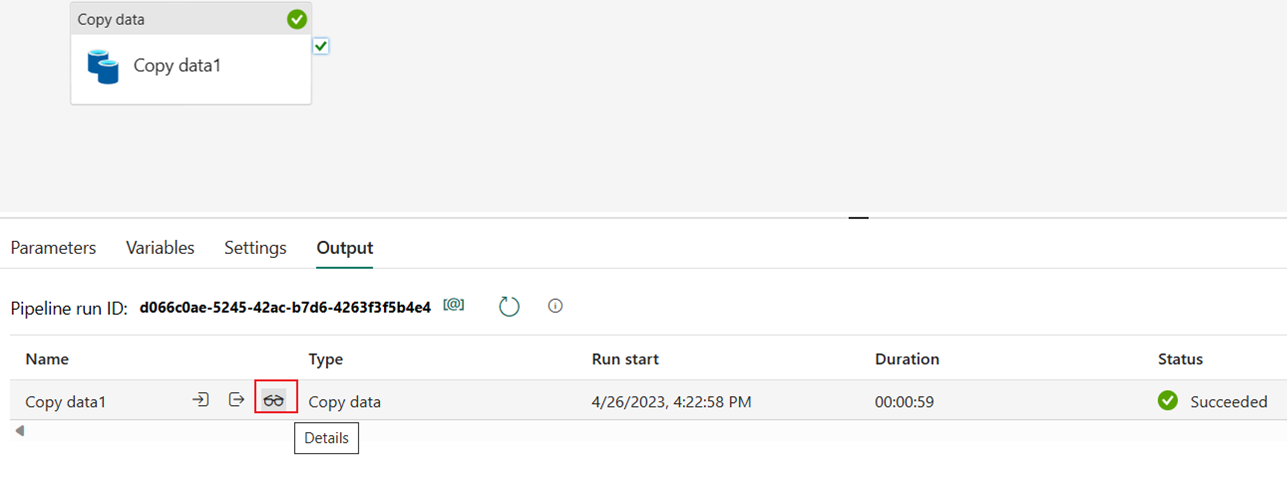

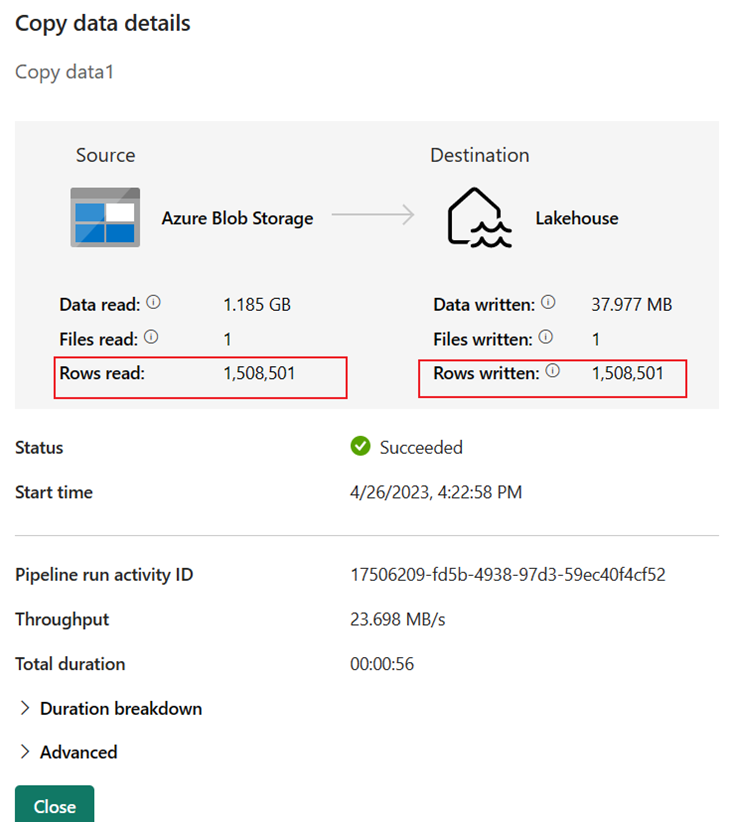

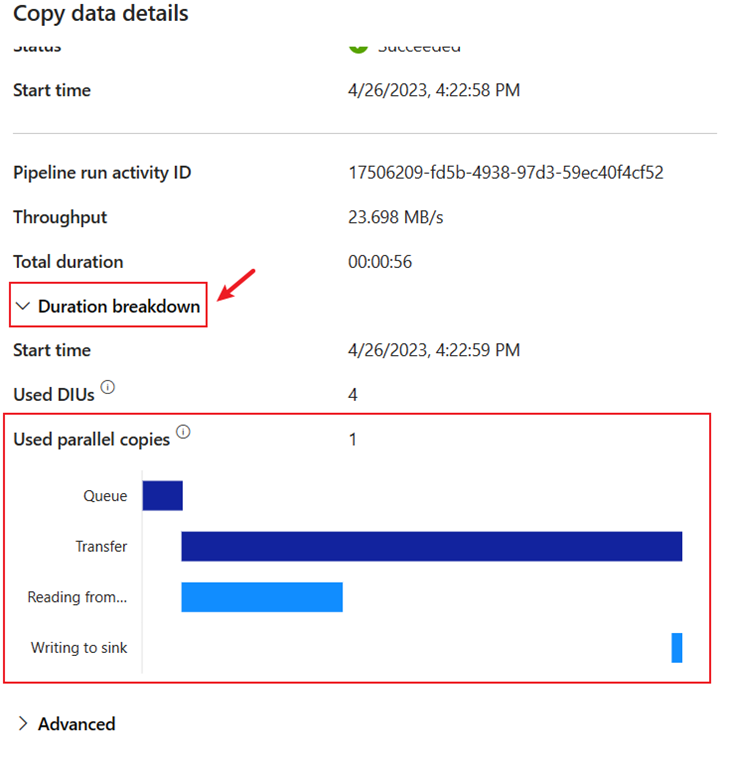

Du kan övervaka körningen och kontrollera resultatet på fliken Utdata under pipelinearbetsytan. Välj knappen Kör information (ikonen "glasögon" som visas när du hovrar över pipelinekörningen som körs) för att visa körningsinformationen.

Körningsinformationen visar 1 508 501 rader som lästs och skrivits.

Expandera avsnittet Varaktighetsfördelning för att se varaktigheten för varje steg i aktiviteten Kopiera. När du har granskat kopieringsinformationen väljer du Stäng.

Relaterat innehåll

I den här första modulen i vår självstudie från slutpunkt till slutpunkt för din första dataintegrering med hjälp av Data Factory i Microsoft Fabric lärde du dig att:

- Skapa en datapipeline.

- Lägg till en aktiviteten Kopiera i pipelinen.

- Använd exempeldata och skapa en data lakehouse för att lagra data i en ny tabell.

- Kör pipelinen och visa dess information och varaktighetsuppdelning.

Fortsätt till nästa avsnitt nu för att skapa ditt dataflöde.