Not

Åtkomst till denna sida kräver auktorisation. Du kan prova att logga in eller byta katalog.

Åtkomst till denna sida kräver auktorisation. Du kan prova att byta katalog.

Din AI-säkerhetsstatus är en viktig del av din övergripande säkerhetsstrategi. AI prioriterar specifika delar av en cybersäkerhetsstrategi, till exempel dataskydd. Den här artikeln hjälper dig att utveckla din strategi och dina prioriteringar för att skydda AI. Efterföljande artiklar i den här samlingen hjälper dig att identifiera de specifika elementen i cybersäkerhet som du prioriterar när du använder AI-följeslagare, verktyg och nya appar.

Din säkerhetsstatus definieras som organisationens övergripande kapacitet för cybersäkerhetsskydd, tillsammans med förberedelsenivån och driftstatusen för att hantera pågående cybersäkerhetshot. Den här hållningen bör vara kvantifierbar och mätbar, på samma sätt som andra viktiga mått som rör organisationens driftsstatus eller välbefinnande.

Att skapa en stark säkerhetsposition för AI innebär att arbeta inom din organisation, särskilt ledare i hela organisationen, för att utveckla en strategi och en uppsättning prioriteringar och mål. Sedan identifierar du det tekniska arbete som krävs för att uppnå målen och leda de olika teamen för att uppnå dem. Artiklarna i det här biblioteket innehåller en metod med vägledning som är specifik för AI:

- Förbered din miljö med grundläggande säkerhetsskydd. Du har förmodligen redan många av dessa skydd på plats.

- Upptäck de AI-appar som används i din organisation, inklusive de typer av data som apparna använder.

- Skydda användningen av AI-verktyg i din organisation. Detta omfattar AI-specifika dataskyddsfunktioner och säkerställer att din organisation har implementerat starkt skydd mot hot.

- Styr AI för efterlevnad.

Använd det här biblioteket tillsammans med följande ramverk på Microsoft Learn:

I bilden:

- Använd det här biblioteket (Security for AI-bibliotek) för att lära dig hur du implementerar funktioner för att skydda AI-appar och data i din miljö. Dessa skydd hjälper dig att bygga din Zero Trust-grund.

- Använd ramverket för zero trust-implementering för att fortsätta att göra framsteg mot säkerhet från slutpunkt till slutpunkt. Var och en av zero trust-affärsscenarierna ökar också din säkerhet för AI-appar och data.

- Använd Cloud Adoption Framework för AI för att utveckla din end-to-end färdplan för implementering av AI, inklusive generativ och icke-generativ AI. Det här biblioteket innehåller strategier för att välja AI-tekniker, processer för att skydda och styra AI samt resurser för AI-design och implementering.

Förstå motivationen hos dina företagsledare

En stark AI-säkerhetsstatus möjliggör innovation – det ger organisationer möjlighet att skapa och distribuera AI med förtroende och flexibilitet. Målet är att ge organisationen möjlighet att på ett säkert sätt bygga, distribuera och skala AI-system samtidigt som man skyddar mot risker som kan undergräva förtroende, efterlevnad eller driftsstabilitet. Genom att bädda in säkerhet i grunden för AI-initiativ kan organisationer frigöra den fulla potentialen hos AI på ett ansvarsfullt sätt, vilket säkerställer att den förblir en strategisk tillgång snarare än en källa till oavsiktlig skada.

Börja utveckla din strategi och dina prioriteringar genom att anpassa dig till dina företagsledare. Vad motiverar dina ledare och varför bryr de sig om din säkerhetsstatus för AI? Följande tabell innehåller exempelperspektiv, men det är viktigt att du träffar var och en av dessa ledare och team och får en gemensam förståelse för varandras motivationer.

| Yrkesroll | Därför är det viktigt att skapa en stark säkerhetsstatus för AI |

|---|---|

| Verkställande direktör (VD) | AI-system formar i allt högre grad strategiska beslut och kundinteraktioner. Ett intrång eller manipulering av AI kan leda till dåliga beslut, regelgranskning, ryktesskada och förlorat förtroende. Stark AI-säkerhet är avgörande för att organisationen ska kunna skydda företagets rykte, säkerställa juridisk efterlevnad och säkerställa en lyckad AI-omvandling. |

| Marknadschef (CMO) | AI-verktyg ger kundinsikter, målinriktning och anpassning. Om de komprometteras kan dessa verktyg leda till dataläckor, partiska utdata eller varumärkesskador på grund av olämpligt innehåll eller mål. Att skydda AI säkerställer förtroende för kundengagemang, bevarar varumärkesintegriteten, förhindrar PR-katastrofer och visar företagets åtagande att skydda kundens integritet. |

| Chief Information Officer (CIO) | En säker AI-miljö är viktig för att säkerställa systemets tillförlitlighet, förhindra obehörig åtkomst och upprätthålla driftsresiliens. Detta gör det möjligt för CIO:er att på ett säkert sätt integrera AI-tekniker som förbättrar verksamheten utan att utsätta företaget för onödiga risker. |

| Chief Information Security Officer (CISO) | AI introducerar nya attackytor och nya risker samtidigt som befintliga risker ökar. Nya attackytor omfattar uppmaningar, svar, modeller, RAG-data, MCP (Model Context Protocol), träningsdata och dataförgiftning, jailbreak-attacker, datasäkerhet med mera. CISO måste leda arbetet med hotmodellering och skydd av AI-pipelines för att upprätthålla företagets säkerhetsstatus. Robust AI-säkerhet är en förlängning av den övergripande strategin för cyberförsvar för att skydda organisationens tillgångar, uppfylla säkerhetsramverk och upprätthålla kund- och intressentförtroende i intelligenta system. |

| Chief Technology Officer (CTO) | En stark AI-säkerhetsposition är avgörande för att CTOs ska kunna skydda organisationens tekniska tillgångar och säkerställa att AI-system fungerar tillförlitligt som avsett. Genom att bädda in säkerhet i AI-utvecklingslivscykeln hjälper CTO:n till att förhindra överträdelser av känsliga algoritmer och upprätthålla hög kvalitet och förtroende för AI-drivna produkter. Detta gör det möjligt för innovation att fortsätta utan onödiga risker. |

| Operativ chef (COO) | AI automatiserar kritiska processer i leveranskedjan, logistiken och driften. Attacker på AI-system kan störa tjänster, öka driftrisken och orsaka kostsamma fördröjningar. En stark AI-säkerhetsstatus säkerställer affärskontinuitet och effektivitet. |

| Ekonomichef (CFO) | CFOs ser en robust AI-säkerhetsstatus som nödvändig för att skydda organisationen. Det bidrar till att undvika oförutsedda ekonomiska förluster och säkerställer efterlevnad av lagar och rapporteringsskyldigheter. |

Hantera det växande hotlandskapet för AI

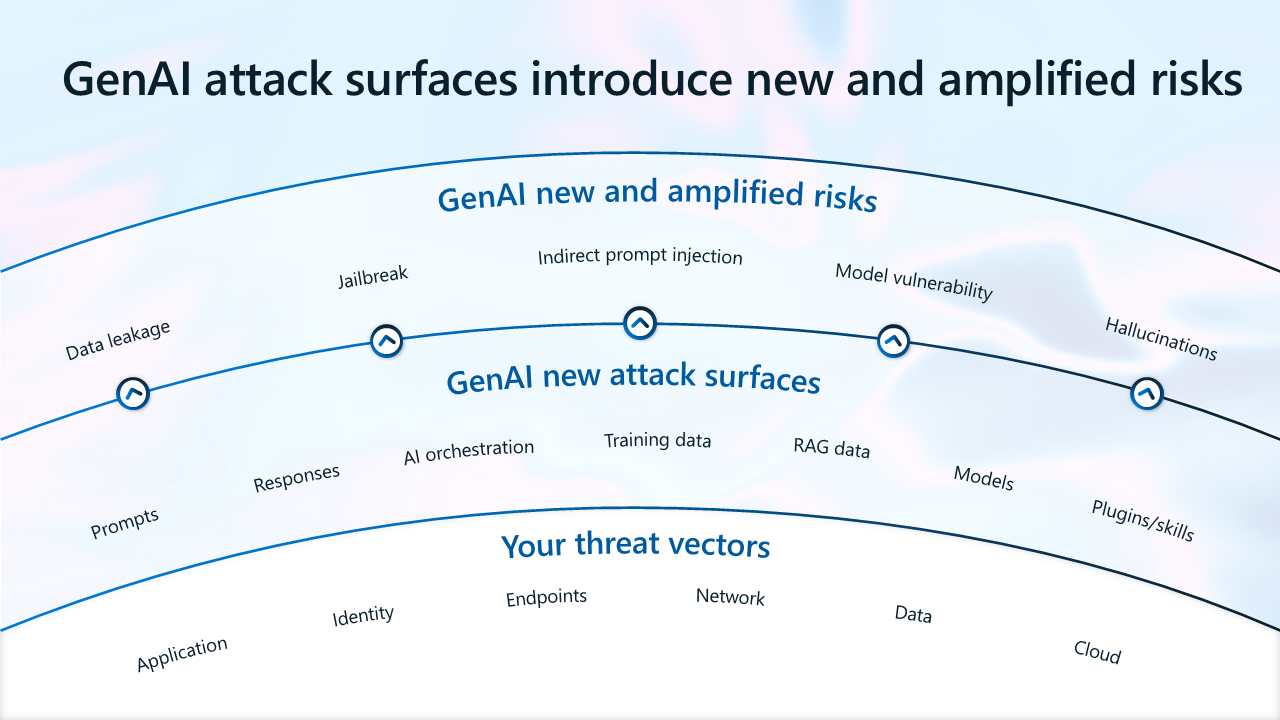

GenAI introducerar nya attackytor, vilket effektivt ändrar risklandskapet. Förutom att hantera traditionella hotvektorer måste säkerhets- och riskledare också hantera förstärkta risker, till exempel dataläckage och dataöverdelning, samt nya risker som snabbinmatningar, felaktig information, modellsårbarheter och felaktig information. Att ta itu med det växande hotlandskapet är avgörande för att möjliggöra tillförlitlig AI.

I bilden:

- GenAI-attackytor medför nya och förstärkta risker.

- Hotvektorer som förblir oförändrade är dina program, identiteter, slutpunkter, nätverk, data och molnresurser.

- GenAI introducerar nya attackytor, inklusive uppmaningar, svar, AI-orkestrering, träningsdata, RAG-data (Retrieval-Augmented Generation-data, vilket innebär data som är resultatet av interaktioner mellan dina data eller andra externa data med språkmodeller), AI-modeller och AI-plugin-program.

- GenAI introducerar nya förstärkta risker, inklusive dataläckage, jailbreak (genom vilken enheter som annars är skyddade kan komprometteras), indirekt promptinjektion och sårbarhet i modeller.

För närvarande är de vanligaste säkerhetsincidenterna inom AI:

- Dataläckage och överdelning – Användare kan läcka känsliga data till skugg-AI-appar (appar som inte godkänts av IT-teamet). Användare kan också komma åt känsliga data med hjälp av AI-appar.

- Sårbarheter och nya hot – Dåliga aktörer kan utnyttja sårbarheter i AI-appar för att få åtkomst till värdefulla resurser.

- Inkompatibilitet – Förordningar, inklusive nya AI-regler, kan öka osäkerheten. Inkompatibel AI-implementering kan öka ansvaret.

Följande två exempelscenarier belyser behovet av att skapa en stark säkerhetsstatus för AI.

Hur sker överdelning och läckage av data?

I det här exemplet hittar och använder en Contoso-anställd, Adele, känsliga data med flera AI-appar.

| Steg | Beskrivning | Ohanterade risker |

|---|---|---|

| 1 | Adele hör en teammedlem referera till Project Obsidian. Hon använder Microsoft 365 Copilot för att hitta mer information om det. Copilot ger henne en sammanfattning och en länk till dokumenten. | Copilot kan bearbeta känsliga data utan begränsningar. Känsliga data överexponeras till anställda, inklusive de som inte ska ha åtkomst. |

| 2 | Adele fortsätter att använda Copilot för att hitta och samla in mer information om Project Obsidian. | Det finns inga kontroller för att identifiera avvikelser i AI-appar. |

| 3 | Av nyfikenhet vill Adele se vad ChatGPT skulle sammanfatta, så hon klistrar in innehållet i filen i ChatGTP. | Det finns inget skydd mot dataförlust (DLP) för att förhindra dataläckage till AI-appar för konsumenter. |

| 4 | Projektinformationen avslöjades i förtid, vilket resulterade i dataintrång. Contoso förbjöd därför alla AI-appar på arbetsplatsen. | Att förbjuda konsument-AI direkt kan leda till ökad mörk användning. |

Contoso kunde ha minimerat dessa risker genom att förbereda, identifiera och skydda AI-appanvändning.

| Fas | Beskrivning |

|---|---|

| Förbereda | Använd Entra och SharePoint Advanced Management för att rätt storleksanpassa anställdas åtkomst till resurser. Använd Purview Information Protection för att klassificera och märka känsliga data. |

| Upptäck | Använd Purview DSPM för AI för att identifiera datarisker. Använd en överdelningsutvärderingsrapport för att utvärdera överdelningsrisker. |

| Skydda |

Tillämpa Purview DLP för Microsoft 365 Copilot för att förhindra att Copilot sammanfattar känsliga data. Använd Purview Insider Risk Management för att identifiera och undersöka avvikelseaktiviteter. Använd Adaptive Protection för att dynamiskt begränsa åtkomsten för högriskanvändare. Använd Defender för Cloud Apps att blockera högriskappar. Använd villkorlig åtkomst i Entra för att kräva att Adele godkänner användningsvillkoren innan du beviljar åtkomst till ChatGPT. Använd Purview-slutpunkts-DLP för att blockera klistra in känsliga data till konsument-appar för AI. |

Hur kan AI medföra risk för efterlevnad?

I nästa exempel tilldelas Jane att leda AI-styrning för Contoso.

| Steg | Beskrivning | Ohanterade risker |

|---|---|---|

| 1 | Jane har svårt att tolka regelkrav till kontroller som it-teamen kan implementera. | Brist på experter som är väl bevandrade i både regelkrav och teknik. |

| 2 | Jane börjar förbereda sig för riskbedömningar men känner inte till de AI-system som skapas och används på Contoso. Hon har inte heller insyn i användningen och potentiella efterlevnadsrisker. | Ingen insyn i AI-system som distribueras i miljön. Ingen styrning av AI-användning. |

| 3 | Efter flera interna intervjuer inser Jane att utvecklarna samtidigt bygger cirka 14 AI-appar, med olika standarder för säkerhet, skydd och sekretesskontroller implementerade. | Ingen insyn i de kontroller som byggs in i AI-system av utvecklare. |

| 4 | Vissa AI-appar använder personliga data utan standardskydd för att bedöma risker. | Ingen riskbedömning på plats. |

| 5 | Kunder klagar på att Contoso AI skapar skadligt och ogrundat innehåll. | Brist på kontroller för AI-utdata. |

AI-regler medför osäkerhet och överväldigande ansvarsrisk för ledare som ansvarar för AI-styrning. Utan några ändringar riskerar Contoso att bryta mot AI:s regelkrav och riskerar eventuellt påföljder och ryktesskador.

Contoso kunde ha minimerat dessa risker genom att förbereda, identifiera och skydda AI-appanvändning.

| Fas | Beskrivning |

|---|---|

| Förbereda | Använd Purview Compliance Manager för att få vägledning om hur du implementerar kontroller som kan hjälpa dig att uppfylla efterlevnadskraven. |

| Upptäck | Använd Defender för molnet för att upptäcka AI-resurser som har distribuerats i molnmiljöer. Använd Defender för Cloud Apps för att identifiera SaaS AI-appar som används. |

| Regera | Styra AI-användning med Microsoft Purview Audit, datalivscykelhantering, kommunikationsefterlevnad och eDiscovery. Använd AI-rapporter i Azure AI Foundry för utvecklare för att dokumentera AI-projektinformation. Använd Priva Privacy Assessments för att proaktivt utvärdera sekretessrisker för varje AI-projekt. Använd Azure AI Content Safety för att minska risken för skadligt eller ogrundat innehåll. |

Med proaktiv användning av styrningsfunktioner kan organisationer utvärdera och hantera risker när ai införs.

Fem steg för att implementera effektiv säkerhet för AI

I takt med att medvetenheten om riskerna i samband med den snabba implementeringen av GenAI ökar svarar många organisationer proaktivt genom att avsätta betydande resurser för att förbättra sina säkerhetsåtgärder. Säkerhets- och riskledare kan vidta flera åtgärder för att skapa en väg mot säker AI-innovation.

Dessa rekommenderade metoder fokuserar på att främja en samarbetsmiljö och implementera effektiva säkerhetsåtgärder som stöder GenAI-framsteg samtidigt som organisationens intressen skyddas.

Steg 1 – Skapa ett säkerhetsteam för AI

En majoritet av företagen inser behovet av att bilda dedikerade, tvärfunktionella team för att hantera de unika säkerhetsutmaningar som AI utgör. Dedikerade säkerhetsteam ser till att AI-system testas noggrant, sårbarheter identifieras snabbt och minimeras och säkerhetsprotokoll uppdateras kontinuerligt för att hålla jämna steg med växande hot.

80 procent av de svarande i undersökningen har för närvarande (45%) eller planerar att ha (35%) ett dedikerat team för att hantera säkerheten för AI. Över 6 av 10 sa att deras team kommer att rapportera till en säkerhetsbeslutsfattare, vilket säkerställer inte bara vaksam tillsyn utan också strategisk vision och ledarskap när det gäller att ta itu med AI-relaterade risker.

I synnerhet var medianen för teamets storlek eller avsedda teamstorlek för dessa dedikerade säkerhetsteam 24 anställda, vilket understryker de betydande resurser som företag åtar sig att skydda sina AI-initiativ. När företagets storlek räknades in varierade teamstorlekarna.

Här följer några metodtips som organisationer kan använda för att skapa ett effektivt korsfunktionellt säkerhetsteam för AI.

Skapa en AI-kommitté för att främja samarbete mellan avdelningar

Säkerhet för AI är en samlad insats som sträcker sig bortom IT-avdelningen. Uppmuntra samarbete mellan team som säkerhet, IT, juridik, efterlevnad och riskhantering för att skapa omfattande säkerhetsstrategier. Att ha varierande perspektiv och expertis kommer att förbättra effektiviteten i säkerhetsprotokoll.

Anställa olika kompetensuppsättningar

Att bilda ett framgångsrikt säkerhetsteam för AI kräver en balans mellan färdigheter. Leta efter teammedlemmar med expertis inom datavetenskap, cybersäkerhet, programvaruteknik och maskininlärning. Den här mångfalden säkerställer att olika säkerhetsaspekter omfattas, från teknisk utveckling till skydd mot hot.

Upprätta tydliga roller och ansvarsområden

För effektiv produktivitet definierar du tydligt varje gruppmedlems roll. Se till att alla förstår sitt specifika ansvar, vilket främjar ansvarsskyldighet och undviker överlappning i arbetet.

Investera i kontinuerlig utbildning och utveckling

Den snabba utvecklingen av AI-tekniker kräver kontinuerlig utbildning för säkerhetsteam. Ge tillgång till utbildningsprogram och workshops som fokuserar på metoder, nya hot och etiska överväganden relaterade till säkerhet för AI. Den här investeringen ger inte bara teammedlemmar möjlighet utan säkerställer också att organisationen ligger före potentiella sårbarheter.

Steg 2 – Optimera resurser för att skydda GenAI

Införandet av AI-program inom organisationer är inte bara revolutionerande åtgärder utan kräver också betydande förändringar i resurs- och budgetallokering, särskilt inom IT-säkerhet.

En betydande majoritet av säkerhets- och riskledarna (78%) tror att deras IT-säkerhetsbudget kommer att öka för att hantera de unika utmaningar och möjligheter som AI medför. Den här justeringen är avgörande av flera skäl. AI-system kräver en robust säkerhetsinfrastruktur för att fungera säkert. Det kan handla om att uppgradera befintliga säkerhetssystem, implementera strängare åtkomstkontroller och förbättra datasäkerhet och styrning. Andra resurser kan också behövas för att uppfylla nya ai-regelkrav.

Tidigare i den här artikeln rekommenderar Microsoft att du utför arbetet för att förstå motivationen hos företagsledare och olika affärsenheter i organisationen. Att identifiera de viktigaste problemen och gemensamma affärsmål är ett viktigt steg mot att förhandla om resurser för att uppnå målen.

Att allokera medel för efterlevnadsbedömningar, juridiska samråd och granskningar blir avgörande för att anpassa organisationens AI-strategi till ett branschramverk och möjliggöra säkrare, säkrare och kompatibla AI-användning och -system. Det är också viktigt att prioritera medel för kontinuerlig utbildning och kompetensutveckling för anställda, vilket skulle kunna omfatta specialiserad utbildning om säkerhetsverktyg för AI, riskhanteringsstrategier och etiska överväganden vid AI-användning.

Steg 3 – Ta en Noll förtroende-metod

När du förbereder dig för AI-implementering ger en Zero Trust-strategi säkerhets- och riskledare en uppsättning principer som hjälper till att hantera några av deras främsta problem, inklusive dataöverdelning eller överexponering och skugg-IT. En Zero Trust-metod övergår från ett nätverksfokus till ett tillgångs- och datacentrerat fokus och behandlar varje åtkomstbegäran som ett potentiellt hot, oavsett ursprung.

Zero Trust verifierar ständigt identiteterna för varje användare och enhet, vilket säkerställer att endast de med tydliga behörigheter kan nå känslig information. Genom att dynamiskt justera säkerhetsåtgärder baserat på realtidsutvärderingar minimerar Zero Trust risken för dataläckage och skyddar en organisation från både interna och externa hot. Kontinuerlig verifiering, åtkomst med minst privilegier och dynamisk riskhantering är hörnstenarna i den här metoden, vilket ger ett robust och anpassningsbart säkerhetsramverk som stöder framgången för en organisations säkerhet från slutpunkt till slutpunkt.

Genom att använda Zero Trust kan organisationer skydda sina AI-distributioner och veta att deras säkerhet verifieras och skyddas kontinuerligt. Zero Trust gör det möjligt för organisationer att ta till sig AI på ett säkert sätt, vilket säkerställer att AI:s kraftfulla funktioner utnyttjas på ett säkert och effektivt sätt.

All säkerhetsvägledning för AI som tillhandahålls av Microsoft är förankrad i Zero Trust-principer. Genom att följa säkerhetsriktlinjerna som rekommenderas för GenAI skapar du en stark Zero Trust-grund.

Steg 4 – Investera i delat ansvar med partner som du litar på

En resurs som ofta används för att informera strategi och prioriteringar är modellen för delat ansvar. Ditt ansvar för att skydda AI-användning i din organisation baseras på vilken typ av appar som används. De partner som du investerar i delar ansvar med dig.

En modell för delat ansvar hjälper säkerhetsteamen att vägleda sin organisation att välja:

- GenAI-appar som minskar ansvaret för sina organisationer.

- Partner som har förtjänat sitt förtroende.

Det här diagrammet sammanfattar ansvarsfördelningen för både dig och Microsoft. Många organisationer använder modellen för delat ansvar för att prioritera användningen av SaaS-appar i samarbete med betrodda leverantörer och för att minska antalet anpassade appar.

Mer information finns i AI-modellen för delat ansvar – Microsoft Azure.

Förutom att investera med partner som har förtjänat ditt förtroende rekommenderar många säkerhetspersonal att konsolidera säkerhetsverktyg och leverantörer. Microsoft erbjuder en omfattande säkerhetslösning för AI med verktyg som fungerar tillsammans, vilket avsevärt minskar mängden integrationsarbete för säkerhetsteam.

Steg 5 – Anta en omfattande säkerhetslösning för AI

AI medför specifika risker som traditionella säkerhetsåtgärder kanske inte helt tar itu med. Säkerheten för AI är utformad för att minska dessa risker.

En stor majoritet av företagen planerar att skaffa specialiserade verktyg och plattformar för att säkra både användning och utveckling av AI-program. När de tillfrågades om hur de planerar att skydda användningen och utvecklingen av AI-program i sina organisationer, sade de flesta respondenter i undersökningen (72%) att de planerar att skaffa en ny dedikerad säkerhetslösning för att skydda användningen och utvecklingen av AI, medan 64% uppgav att de planerar att använda befintliga säkerhetslösningar för att skydda AI.

IT- och säkerhetsledare tror att de främsta budgetbidragsgivarna för nya lösningar för skydd och styrning av AI kommer att vara IT-avdelningar (63%) och informationssäkerhets-/cybersäkerhetsavdelningar (57%). Dessa resultat visar att förutom att fortsätta använda befintliga säkerhetslösningar ser organisationer behovet av att leta efter nya lösningar som kan hjälpa till att hantera de förstärkta och framväxande riskerna med AI.

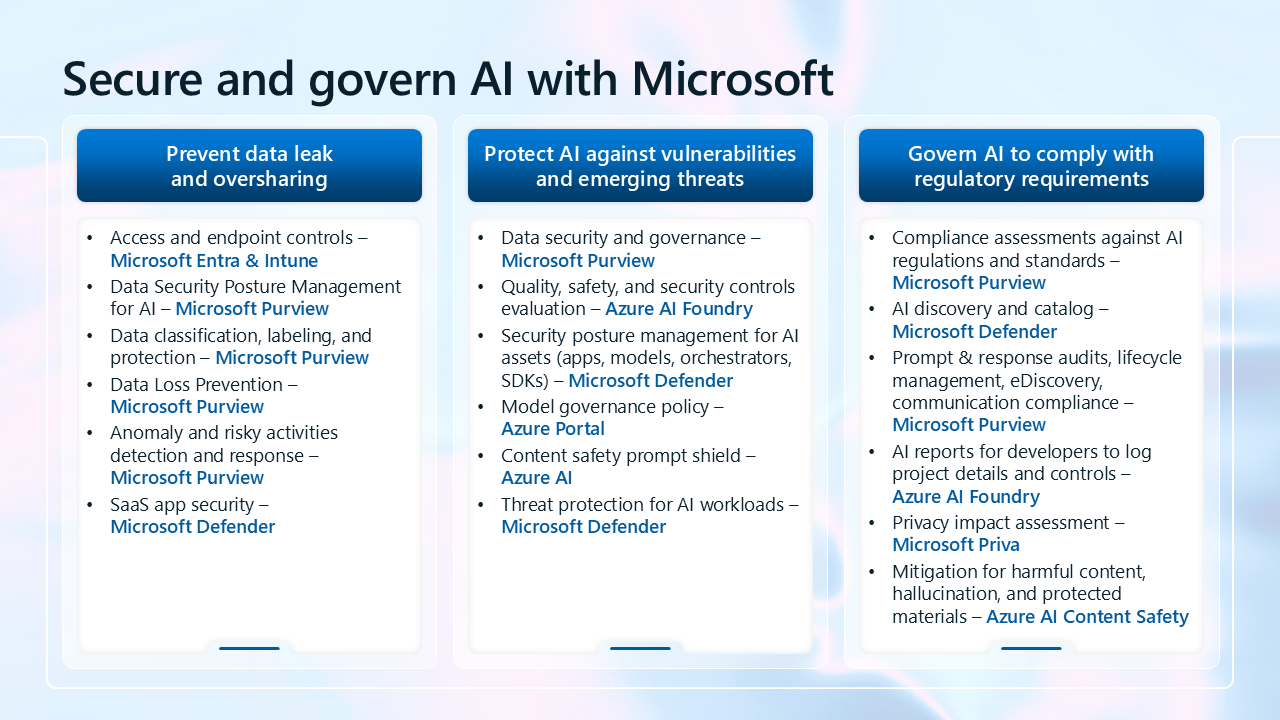

Utöver Microsofts heltäckande säkerhetsplattform tillhandahåller Microsoft omfattande säkerhetsverktyg för att skydda AI, från identifiering av AI-verktyg och data till skydd som utformats specifikt för att minimera AI-hot. Dessa verktyg omfattar avancerade instrumentpaneler och efterlevnadsresurser som hjälper dig att hålla koll på risker och regelmässiga skyldigheter.

Följande bild är en sammanfattning av alla funktioner som Microsoft tillhandahåller för att skydda införandet av AI. De här funktionerna visas också i tabellen nedan.

| Främsta kundproblemet | Förmågor |

|---|---|

| Förhindra dataläckage och överdelning | – Åtkomst- och slutpunktskontroller – Microsoft Entra & Intune – Hantering av datasäkerhetsstatus för AI – Microsoft Purview – Dataklassificering, etikettering och skydd – Microsoft Purview – Skydd mot dataförlust – Microsoft Purview – Identifiering och svar för avvikelse- och riskfyllda aktiviteter – Microsoft Purview – SaaS-appsäkerhet – Microsoft Defender |

| Skydda AI mot sårbarheter och nya hot | – Datasäkerhet och styrning – Microsoft Purview – Utvärdering av kvalitets-, säkerhets- och säkerhetskontroller – Azure AI Foundry – Hantering av säkerhetsstatus för AI-tillgångar (appar, modeller, orkestrerare, SDK:er) – Microsoft Defender – Modellstyrningsprincip – Azure-portalen – Sköld för innehållssäkerhetsprompter – Azure AI – Skydd mot hot för AI-arbetsbelastningar – Microsoft Defender |

| Styra AI för att uppfylla regelkrav | – Efterlevnadsbedömningar mot AI-regler och standarder – Microsoft Purview – AI-identifiering och katalog – Microsoft Defender – Granskningar av fråga och svar, livscykelhantering, eDiscovery, kommunikationsefterlevnad – Microsoft Purview – AI-rapporter för utvecklare för att logga projektinformation och kontroller – Azure AI Foundry – Konsekvensbedömning av sekretess – Microsoft Priva – Åtgärder för skadligt innehåll, felaktig information och skyddat material – Azure AI Content Safety |

Nästa steg för att skydda AI

Det här biblioteket vägleder dig genom processen att implementera säkerhet för AI i en stegvis metod.

Följ riktlinjerna i den här serien med artiklar för att lära dig mer om att skydda AI och identifiera och implementera funktioner för att uppnå organisationens mål.

Mer information om hur du optimerar din övergripande säkerhetsstatus och Noll förtroende finns i Modernisera säkerhetsstatusen snabbt.

Information om hur du kommer igång med rekommenderade säkerhetsskydd för AI-följeslagare finns i Använda Zero Trust-säkerhet för att förbereda dig för AI-följeslagare, inklusive Microsoft Copilots.