หมายเหตุ

การเข้าถึงหน้านี้ต้องได้รับการอนุญาต คุณสามารถลอง ลงชื่อเข้าใช้หรือเปลี่ยนไดเรกทอรีได้

การเข้าถึงหน้านี้ต้องได้รับการอนุญาต คุณสามารถลองเปลี่ยนไดเรกทอรีได้

Note

ขณะนี้ Fabric Runtime 2.0 อยู่ในขั้นตอนการแสดงตัวอย่างการทดลอง สําหรับข้อมูลเพิ่มเติม โปรดดู ข้อจํากัดและหมายเหตุ

Fabric Runtime มอบการผสานรวมที่ราบรื่นภายในระบบนิเวศ Microsoft Fabric นําเสนอสภาพแวดล้อมที่มีประสิทธิภาพสําหรับโครงการวิศวกรรมข้อมูลและวิทยาศาสตร์ข้อมูลที่ขับเคลื่อนโดย Apache Spark

บทความนี้แนะนํา Fabric Runtime 2.0 Experimental (Preview) ซึ่งเป็นรันไทม์ล่าสุดที่ออกแบบมาสําหรับการคํานวณข้อมูลขนาดใหญ่ใน Microsoft Fabric โดยเน้นย้ําถึงคุณสมบัติและส่วนประกอบหลักที่ทําให้รุ่นนี้เป็นก้าวสําคัญสําหรับการวิเคราะห์ที่ปรับขนาดได้และปริมาณงานขั้นสูง

Fabric Runtime 2.0 รวมส่วนประกอบและการอัปเกรดต่อไปนี้ที่ออกแบบมาเพื่อปรับปรุงความสามารถในการประมวลผลข้อมูลของคุณ:

- อาปาเช่ สปาร์ค 4.0

- ระบบปฏิบัติการ: Azure Linux 3.0 (Mariner 3.0)

- ชวา: 21

- สกาล่า: 2.13

- หลาม: 3.12

- ทะเลสาบเดลต้า: 4.0

เปิดใช้งานรันไทม์ 2.0

คุณสามารถเปิดใช้งานรันไทม์ 2.0 ได้ที่ระดับพื้นที่ทํางานหรือระดับรายการสภาพแวดล้อม ใช้การตั้งค่าพื้นที่ทํางานเพื่อใช้ Runtime 2.0 เป็นค่าเริ่มต้นสําหรับปริมาณงาน Spark ทั้งหมดในพื้นที่ทํางานของคุณ อีกวิธีหนึ่งคือ สร้างรายการ สภาพแวดล้อม ที่มีรันไทม์ 2.0 เพื่อใช้กับสมุดบันทึกเฉพาะหรือข้อกําหนดงาน Spark ซึ่งจะแทนที่ค่าเริ่มต้นของพื้นที่ทํางาน

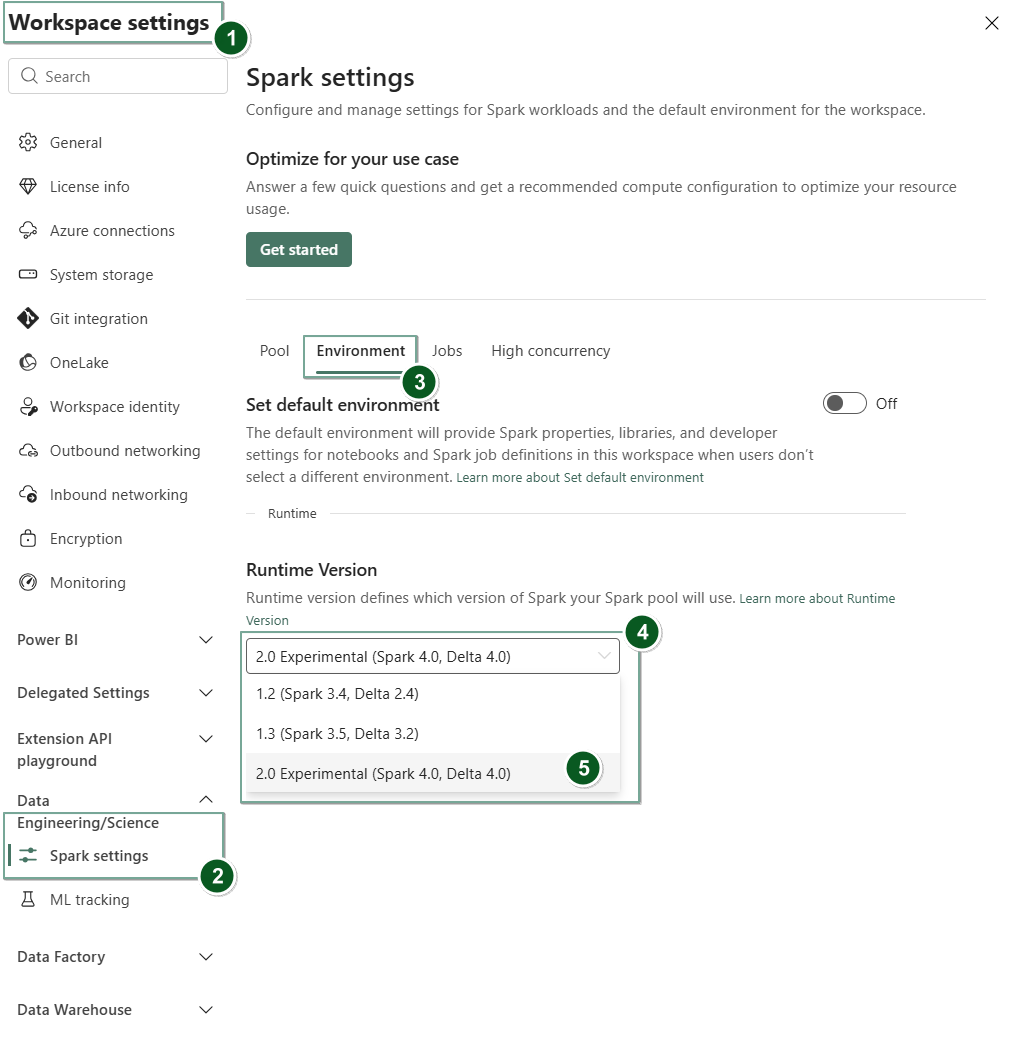

เปิดใช้งานรันไทม์ 2.0 ในการตั้งค่าพื้นที่ทํางาน

เมื่อต้องการตั้งค่ารันไทม์ 2.0 เป็นค่าเริ่มต้นสําหรับพื้นที่ทํางานทั้งหมดของคุณ:

นําทางไปยังแท็บ การตั้งค่า พื้นที่ทํางานภายในพื้นที่ทํางาน Fabric ของคุณ

ไปที่แท็บวิศวกรรมข้อมูล/วิทยาศาสตร์ แล้วเลือกการตั้งค่า Spark

เลือกแท็บ สภาพแวดล้อม

ภายใต้ดรอปดาวน์ เวอร์ชันรันไทม์ ให้เลือก 2.0 ทดลอง (Spark 4.0, Delta 4.0) และบันทึกการเปลี่ยนแปลงของคุณ การดําเนินการนี้ตั้งค่ารันไทม์ 2.0 เป็นรันไทม์เริ่มต้นสําหรับพื้นที่ทํางานของคุณ

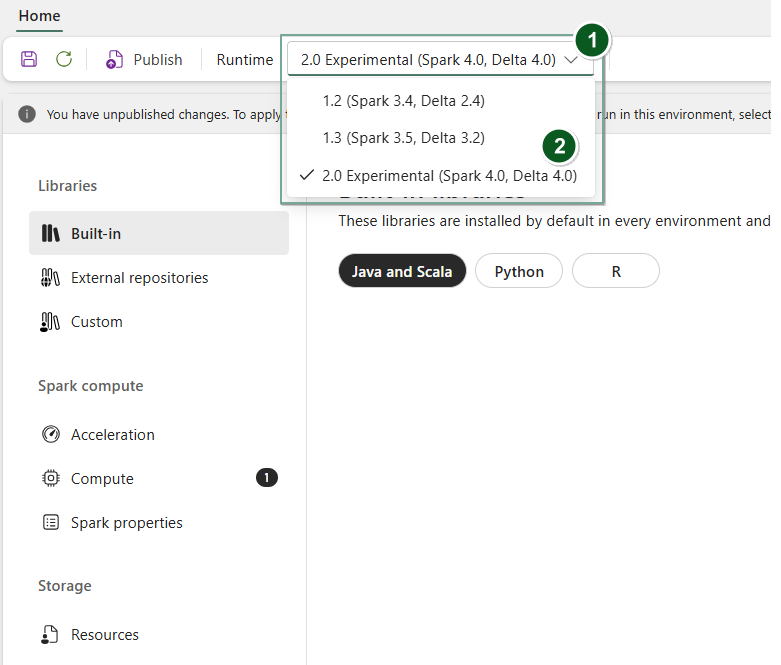

เปิดใช้งานรันไทม์ 2.0 ในรายการสภาพแวดล้อม

หากต้องการใช้ Runtime 2.0 กับสมุดบันทึกเฉพาะหรือข้อกําหนดงาน Spark:

สร้างรายการสภาพแวดล้อมใหม่หรือรายการ ที่ เปิดอยู่และที่มีอยู่

ภายใต้ดรอปดาวน์รันไทม์ ให้เลือก 2.0 ทดลอง (Spark 4.0, Delta 4.0)

SaveและPublishการเปลี่ยนแปลงของคุณสําคัญ

เซสชัน Spark 2.0 อาจใช้เวลาประมาณ 2-5 นาทีในการเริ่มต้น เนื่องจากพูลเริ่มต้นไม่ได้เป็นส่วนหนึ่งของการทดลองในช่วงต้น

ถัดไป คุณสามารถใช้รายการสภาพแวดล้อมนี้กับ หรือ ของคุณ

NotebookSpark Job Definition

ตอนนี้คุณสามารถเริ่มทดลองกับการปรับปรุงและฟังก์ชันใหม่ล่าสุดที่นํามาใช้ใน Fabric Runtime 2.0 (Spark 4.0 และ Delta Lake 4.0)

ตัวอย่างสาธารณะทดลอง

ขั้นตอนการแสดงตัวอย่างทดลองรันไทม์ Fabric 2.0 ช่วยให้คุณเข้าถึงฟีเจอร์และ API ใหม่ๆ จากทั้ง Spark 4.0 และ Delta Lake 4.0 ได้ก่อนใคร การแสดงตัวอย่างช่วยให้คุณใช้การปรับปรุงล่าสุดที่ใช้ Spark ได้ทันที เพื่อให้มั่นใจว่าความพร้อมและการเปลี่ยนแปลงที่ราบรื่นสําหรับการเปลี่ยนแปลงในอนาคต เช่น Java, Scala และ Python เวอร์ชันที่ใหม่กว่า

เคล็ดลับ

สําหรับข้อมูลล่าสุด รายการการเปลี่ยนแปลงโดยละเอียด และบันทึกย่อประจํารุ่นเฉพาะสําหรับ Fabric runtimes ตรวจสอบและสมัครใช้งาน การเผยแพร่และการอัปเดต Spark Runtimes

ข้อจํากัดและหมายเหตุ

ขณะนี้ Fabric Runtime 2.0 อยู่ในขั้นตอนการแสดงตัวอย่างสาธารณะแบบทดลอง ซึ่งออกแบบมาเพื่อให้ผู้ใช้สํารวจและทดลองกับคุณลักษณะและ API ล่าสุดจาก Spark และ Delta Lake ในสภาพแวดล้อมการพัฒนาหรือการทดสอบ แม้ว่าเวอร์ชันนี้จะให้การเข้าถึงฟังก์ชันหลัก แต่ก็มีข้อจํากัดบางประการ:

คุณสามารถใช้เซสชัน Spark 4.0 เขียนโค้ดในสมุดบันทึก จัดกําหนดการข้อกําหนดงาน Spark และใช้กับ PySpark, Scala และ Spark SQL ได้ อย่างไรก็ตาม ภาษา R ไม่ได้รับการสนับสนุนในรุ่นแรกนี้

คุณสามารถติดตั้งไลบรารีได้โดยตรงในโค้ดของคุณด้วย pip และ conda คุณสามารถตั้งค่า Spark ผ่านตัวเลือก %%configure ในสมุดบันทึกและ Spark Job Definitions (SJD)

คุณสามารถอ่านและเขียนไปยัง Lakehouse ด้วย Delta Lake 4.0 ได้ แต่คุณสมบัติขั้นสูงบางอย่าง เช่น V-order, การเขียน Parquet ดั้งเดิม, การบดอัดอัตโนมัติ, การเพิ่มประสิทธิภาพการเขียน, การผสานแบบสุ่มต่ํา, การผสาน, วิวัฒนาการสคีมา และการเดินทางข้ามเวลาไม่รวมอยู่ในรุ่นแรกนี้

Spark Advisor ไม่พร้อมใช้งานในขณะนี้ อย่างไรก็ตาม เครื่องมือตรวจสอบ เช่น Spark UI และบันทึกได้รับการสนับสนุนในรุ่นแรกนี้

คุณลักษณะต่างๆ เช่น การผสานรวมวิทยาศาสตร์ข้อมูล รวมถึง Copilot และตัวเชื่อมต่อ รวมถึง Kusto, SQL Analytics, Cosmos DB และ MySQL Java Connector ยังไม่ได้รับการสนับสนุนในรุ่นแรกนี้ ไลบรารีวิทยาศาสตร์ข้อมูลไม่ได้รับการสนับสนุนในสภาพแวดล้อม PySpark PySpark ใช้งานได้กับการตั้งค่า Conda พื้นฐานเท่านั้น ซึ่งรวมถึง PySpark เพียงอย่างเดียวโดยไม่มีไลบรารีเพิ่มเติม

การรวมกับรายการสภาพแวดล้อมและ Visual Studio Code ไม่ได้รับการสนับสนุนในการนําออกใช้ก่อนหน้านี้

ไม่สนับสนุนการอ่านและเขียนข้อมูลไปยังบัญชี Azure Storage สําหรับการใช้งานทั่วไป v2 (GPv2) ด้วยโพรโทคอล WASB หรือ ABFS

Note

แชร์ความคิดเห็นของคุณเกี่ยวกับ Fabric Runtime ในแพลตฟอร์มไอเดีย อย่าลืมพูดถึงเวอร์ชันและขั้นตอนการเผยแพร่ที่คุณอ้างถึง เราให้ความสําคัญกับความคิดเห็นของชุมชนและจัดลําดับความสําคัญของการปรับปรุงตามการโหวต เพื่อให้แน่ใจว่าเราตอบสนองความต้องการของผู้ใช้

จุดเด่นหลัก

อาปาเช่ สปาร์ค 4.0

Apache Spark 4.0 ถือเป็นก้าวสําคัญในการเปิดตัวครั้งแรกในซีรีส์ 4.x ซึ่งรวบรวมความพยายามร่วมกันของชุมชนโอเพ่นซอร์สที่มีชีวิตชีวา

ในเวอร์ชันนี้ Spark SQL ได้รับการเสริมสร้างอย่างมีนัยสําคัญด้วยคุณสมบัติใหม่ที่ทรงพลังซึ่งออกแบบมาเพื่อเพิ่มการแสดงออกและความเก่งกาจสําหรับปริมาณงาน SQL เช่น การสนับสนุนประเภทข้อมูล VARIANT, ฟังก์ชันที่ผู้ใช้กําหนดโดย SQL, ตัวแปรเซสชัน, ไวยากรณ์ไปป์ และการเปรียบเทียบสตริง PySpark เห็นความทุ่มเทอย่างต่อเนื่องทั้งในด้านการทํางานและประสบการณ์โดยรวมของนักพัฒนา โดยนํา API การพล็อตดั้งเดิม API แหล่งข้อมูล Python ใหม่ รองรับ Python UDTF และการสร้างโปรไฟล์แบบรวมสําหรับ PySpark UDF ควบคู่ไปกับการปรับปรุงอื่นๆ อีกมากมาย การสตรีมแบบมีโครงสร้างพัฒนาขึ้นด้วยการเพิ่มคีย์ที่ให้การควบคุมที่ดีขึ้นและง่ายต่อการดีบัก โดยเฉพาะอย่างยิ่งการแนะนํา Arbitrary State API v2 เพื่อการจัดการสถานะที่ยืดหยุ่นยิ่งขึ้น และแหล่งข้อมูลของรัฐเพื่อการดีบักที่ง่ายขึ้น

คุณสามารถตรวจสอบรายการทั้งหมดและการเปลี่ยนแปลงโดยละเอียดได้ที่นี่: https://spark.apache.org/releases/spark-release-4-0-0.html

Note

ใน Spark 4.0 SparkR ถูกเลิกใช้และอาจถูกลบออกในเวอร์ชันในอนาคต

เดลต้าเลค 4.0

Delta Lake 4.0 แสดงถึงความมุ่งมั่นร่วมกันในการทําให้ Delta Lake ทํางานร่วมกันได้ในทุกรูปแบบ ทํางานได้ง่ายขึ้น และมีประสิทธิภาพมากขึ้น Delta 4.0 เป็นการเปิดตัวครั้งสําคัญที่อัดแน่นไปด้วยคุณสมบัติใหม่ที่ทรงพลัง การเพิ่มประสิทธิภาพ และการปรับปรุงพื้นฐานสําหรับอนาคตของเลคเฮาส์ข้อมูลแบบเปิด

คุณสามารถตรวจสอบรายการทั้งหมดและการเปลี่ยนแปลงโดยละเอียดที่แนะนําใน Delta Lake 3.3 และ 4.0 ได้ที่นี่: https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0

สําคัญ

คุณลักษณะเฉพาะของ Delta Lake 4.0 เป็นการทดลองและใช้งานได้กับประสบการณ์ Spark เท่านั้น เช่น สมุดบันทึกและคําจํากัดความของงาน Spark หากคุณต้องการใช้ตาราง Delta Lake เดียวกันในปริมาณงาน Microsoft Fabric หลายรายการ อย่าเปิดใช้งานคุณลักษณะเหล่านั้น หากต้องการเรียนรู้เพิ่มเติมเกี่ยวกับเวอร์ชันและคุณลักษณะของโปรโตคอลที่เข้ากันได้กับประสบการณ์การใช้งาน Microsoft Fabric ทั้งหมด โปรดอ่าน การทํางานร่วมกันของรูปแบบตาราง Delta Lake

เนื้อหาที่เกี่ยวข้อง

- รันไทม์ Apache Spark ใน Fabric - ภาพรวม การกําหนดเวอร์ชัน และการสนับสนุนรันไทม์หลายรายการ

- คู่มือการโยกย้าย Spark Core

- คู่มือการโยกย้าย SQL, ชุดข้อมูล และ DataFrame

- คู่มือการโยกย้ายแบบสตรีมมิ่งที่มีโครงสร้าง

- คู่มือการโยกย้าย MLlib (Machine Learning)

- คู่มือการโยกย้าย PySpark (Python บน Spark)

- คู่มือการโยกย้าย SparkR (R บน Spark)