หมายเหตุ

การเข้าถึงหน้านี้ต้องได้รับการอนุญาต คุณสามารถลอง ลงชื่อเข้าใช้หรือเปลี่ยนไดเรกทอรีได้

การเข้าถึงหน้านี้ต้องได้รับการอนุญาต คุณสามารถลองเปลี่ยนไดเรกทอรีได้

บทความนี้อธิบายข้อความแจ้งและวิศวกรรมพร้อมท์เป็นแนวคิดหลักที่จะช่วยคุณสร้างความสามารถ Generative AI ที่ทรงพลังซึ่งสามารถใช้ใน Copilot Studio

สําคัญ

- พร้อมท์ใช้แบบจําลองที่ขับเคลื่อนโดย Azure Foundry

- ความสามารถนี้อาจขึ้นอยู่กับขีดจำกัดการใช้งานหรือการควบคุมปริมาณความจุ

ข้อกําหนดเบื้องต้น

- สภาพแวดล้อมของคุณอยู่ในรายการ ภูมิภาคที่มีอยู่

- คุณต้องมีเครดิต Copilot

- Microsoft Dataverse ได้รับการติดตั้งบนสภาพแวดล้อม

พรอมต์คืออะไร

พรอมต์ส่วนใหญ่ประกอบด้วยคําสั่งภาษาธรรมชาติที่บอกโมเดล AI เชิงกําเนิดให้ทํางาน แบบจำลองจะปฏิบัติตามพร้อมท์เพื่อกำหนดโครงสร้างและเนื้อหาของข้อความที่ต้องการสร้าง วิศวกรรมพร้อมท์คือกระบวนการสร้างและปรับแต่งพร้อมท์ที่โมเดลใช้

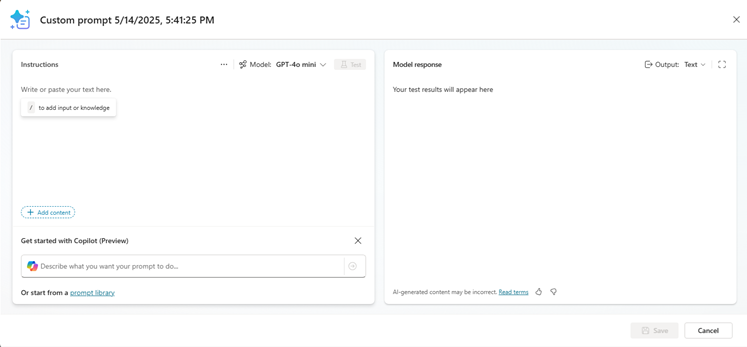

ประสบการณ์ตัวสร้างพร้อมท์ช่วยให้ผู้สร้างสามารถสร้าง ทดสอบ และบันทึกข้อความแจ้งที่นํากลับมาใช้ใหม่ได้ ในประสบการณ์นี้ คุณยังสามารถใช้ตัวแปรอินพุตและข้อมูลองค์ความรู้เพื่อให้ข้อมูลบริบทแบบไดนามิกขณะรันไทม์ คุณสามารถแชร์ข้อความแจ้งเหล่านี้กับผู้อื่นและใช้ตัวแทน เวิร์กโฟลว์ หรือแอปได้

พร้อมท์เหล่านี้สามารถใช้ได้สำหรับงานหรือสถานการณ์ทางธุรกิจจำนวนมาก เช่น การสรุปเนื้อหา การจัดหมวดหมู่ข้อมูล การแยกเอนทิตี การแปลภาษา การประเมินความรู้สึก หรือการกำหนดการตอบสนองต่อข้อร้องเรียน ตัวอย่างเช่น คุณสามารถแจ้งให้เลือกรายการการดําเนินการจากอีเมลของบริษัทของคุณ และใช้ในเวิร์กโฟลว์ Power Automate เพื่อสร้างระบบอัตโนมัติในการประมวลผลอีเมล

ใน Copilot Studio สามารถใช้ข้อความแจ้งเป็นเครื่องมือตัวแทนเพื่อปรับปรุงประสบการณ์การแชทหรือเปิดใช้งานระบบอัตโนมัติ AI ขั้นสูงหรือโหนดเวิร์กโฟลว์เพื่อใส่การดําเนินการ AI ในระบบอัตโนมัติที่กําหนด

การกำกับดูแลของมนุษย์

การกํากับดูแลของมนุษย์เป็นขั้นตอนสําคัญเมื่อทํางานกับเนื้อหาที่สร้างขึ้นจากโมเดล AI เชิงกําเนิด โมเดลดังกล่าวได้รับการฝึกอบรมเกี่ยวกับข้อมูลจํานวนมากและอาจมีข้อผิดพลาดและอคติ มนุษย์ควรตรวจสอบข้อมูลดังกล่าวก่อนที่คุณจะโพสต์ทางออนไลน์ ส่งให้ลูกค้า หรือใช้ข้อมูลดังกล่าวเพื่อประกอบการตัดสินใจทางธุรกิจ การกำกับดูแลโดยมนุษย์ช่วยให้คุณระบุข้อผิดพลาดและอคติที่อาจเกิดขึ้นได้ นอกจากนี้ยังทำให้แน่ใจว่าเนื้อหาเกี่ยวข้องกับกรณีการใช้งานที่ตั้งใจไว้และสอดคล้องกับค่านิยมของบริษัท

การตรวจสอบโดยมนุษย์ยังสามารถช่วยระบุปัญหาใดๆ กับตัวโมเดลได้อีกด้วย ตัวอย่างเช่น หากโมเดลกำลังสร้างเนื้อหาที่ไม่เกี่ยวข้องกับกรณีการใช้งานที่ต้องการ คุณอาจต้องปรับพร้อมท์

AI ที่รับผิดชอบ

เรามุ่งมั่นที่จะสร้าง AI ที่รับผิดชอบ โดยการออกแบบ งานของเราได้รับคำแนะนำจาก ชุดหลักการสำคัญ: ความยุติธรรม ความน่าเชื่อถือและความปลอดภัย ความเป็นส่วนตัวและความปลอดภัย ความครอบคลุม ความโปร่งใส และความรับผิดชอบ เรากำลังนำหลักการเหล่านี้ไปปฏิบัติทั่วทั้งบริษัทเพื่อพัฒนาและปรับใช้งาน AI ที่ส่งผลดีต่อสังคม เราใช้แนวทางที่ครอบคลุม ผสมผสานการวิจัยเชิงนวัตกรรม การวิศวกรรมที่ยอดเยี่ยม และการกำกับดูแลที่มีความรับผิดชอบ ควบคู่ไปกับการวิจัยชั้นนำของ OpenAI เกี่ยวกับการจัดตำแหน่ง AI เรากำลังพัฒนากรอบการทำงานสำหรับการใช้เทคโนโลยี AI ของเราเองอย่างปลอดภัย โดยมีจุดมุ่งหมายเพื่อช่วยนำทางอุตสาหกรรมไปสู่ผลลัพธ์ที่มีความรับผิดชอบมากขึ้น

เรียนรู้เพิ่มเติมเกี่ยวกับความโปร่งใสในบันทึกความโปร่งใสสําหรับ Azure OpenAI