Azure Data Factory ve Azure Synapse Analytics'te Veri Akışı etkinliği

UYGULANANLAR:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

İpucu

Kuruluşlar için hepsi bir arada analiz çözümü olan Microsoft Fabric'te Data Factory'yi deneyin. Microsoft Fabric , veri taşımadan veri bilimine, gerçek zamanlı analize, iş zekasına ve raporlamaya kadar her şeyi kapsar. Yeni bir deneme sürümünü ücretsiz olarak başlatmayı öğrenin!

Eşleme veri akışları aracılığıyla verileri dönüştürmek ve taşımak için Veri Akışı etkinliğini kullanın. Veri akışlarını yeni kullanıyorsanız bkz. Eşleme Veri Akışı genel bakış

Kullanıcı arabirimiyle Veri Akışı etkinliği oluşturma

İşlem hattında Veri Akışı etkinliği kullanmak için aşağıdaki adımları tamamlayın:

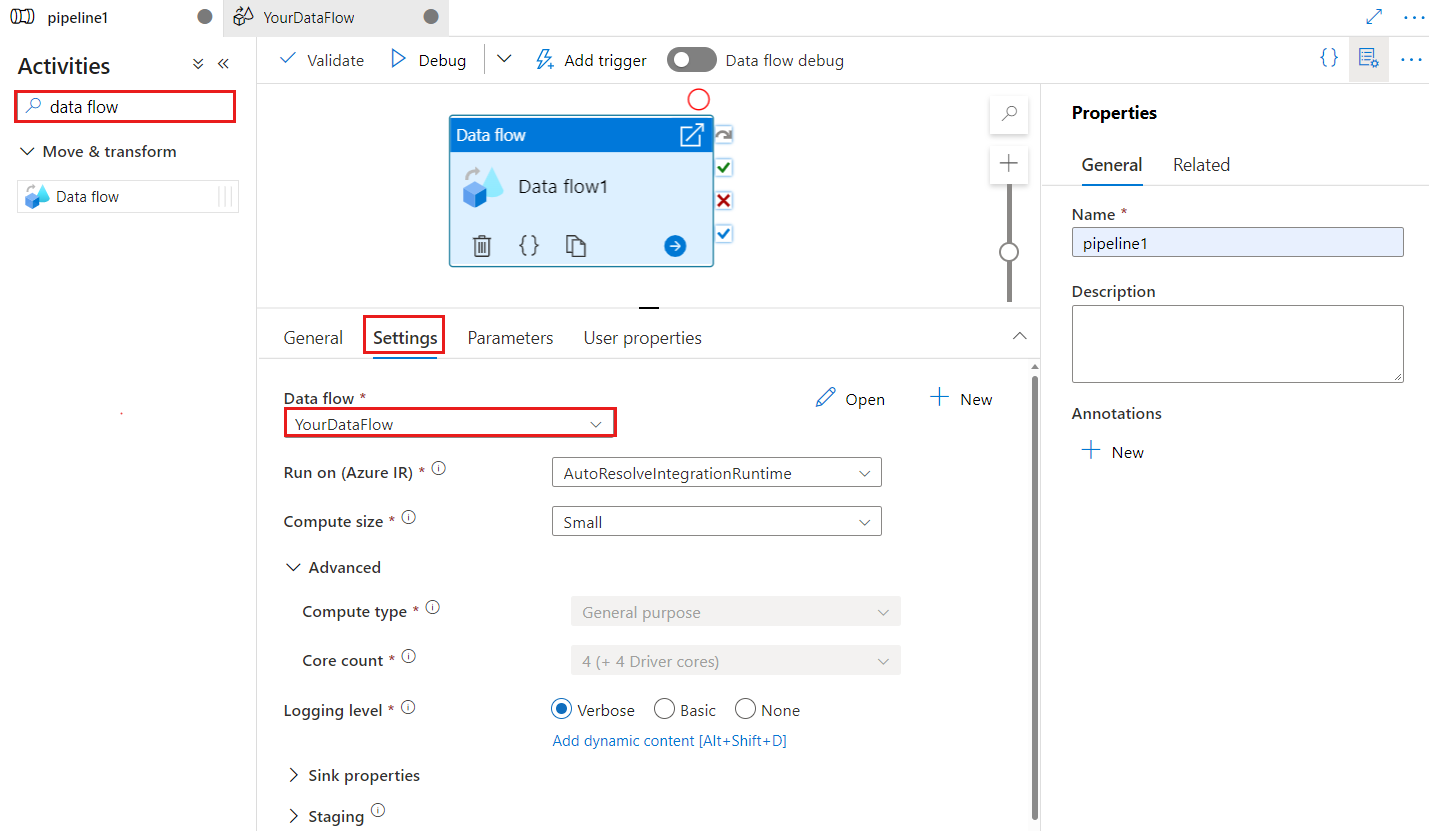

İşlem hattı Etkinlikleri bölmesinde Veri Akışı arayın ve Veri Akışı etkinliğini işlem hattı tuvaline sürükleyin.

Tuvalde henüz seçili değilse yeni Veri Akışı etkinliğini ve ayrıntılarını düzenlemek için Ayarlar sekmesini seçin.

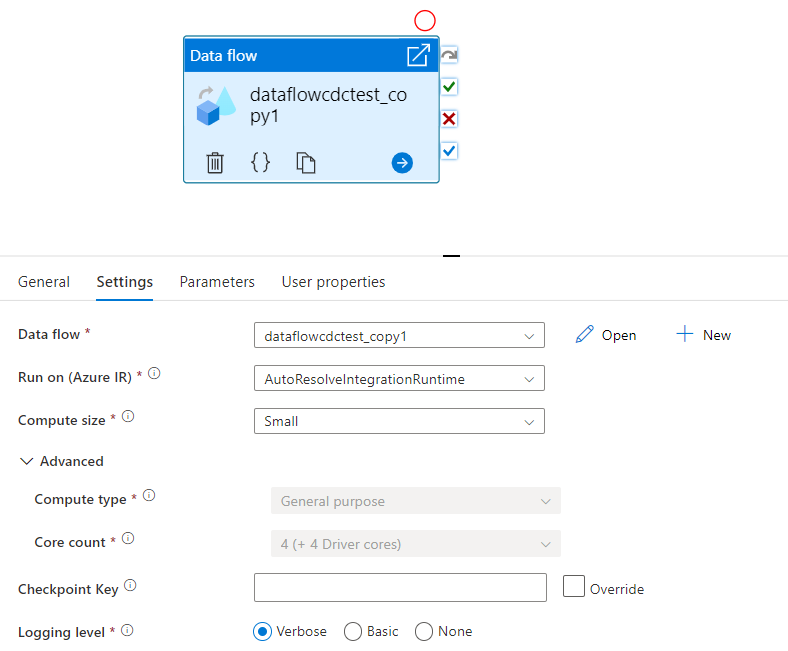

Denetim noktası anahtarı, değiştirilen veri yakalama için veri akışı kullanıldığında denetim noktasını ayarlamak için kullanılır. Üzerine yazabilirsiniz. Veri akışı etkinlikleri, "işlem hattı adı + etkinlik adı" yerine denetim noktası anahtarı olarak guid değeri kullanır, böylece yeniden adlandırma eylemleri olsa bile müşterinin değişiklik verilerini yakalama durumunu her zaman izlemeye devam edebilir. Tüm mevcut veri akışı etkinliği geriye dönük uyumluluk için eski desen anahtarını kullanır. Değişiklik veri yakalama etkin veri akışı kaynağıyla yeni bir veri akışı etkinliği yayımladıktan sonra denetim noktası anahtarı seçeneği aşağıda gösterilmiştir.

Yeni düğmesini kullanarak mevcut bir veri akışını seçin veya yeni bir akış oluşturun. Yapılandırmanızı tamamlamak için gereken diğer seçenekleri belirleyin.

Sözdizimi

{

"name": "MyDataFlowActivity",

"type": "ExecuteDataFlow",

"typeProperties": {

"dataflow": {

"referenceName": "MyDataFlow",

"type": "DataFlowReference"

},

"compute": {

"coreCount": 8,

"computeType": "General"

},

"traceLevel": "Fine",

"runConcurrently": true,

"continueOnError": true,

"staging": {

"linkedService": {

"referenceName": "MyStagingLinkedService",

"type": "LinkedServiceReference"

},

"folderPath": "my-container/my-folder"

},

"integrationRuntime": {

"referenceName": "MyDataFlowIntegrationRuntime",

"type": "IntegrationRuntimeReference"

}

}

Tür özellikleri

| Özellik | Açıklama | İzin verilen değerler | Zorunlu |

|---|---|---|---|

| Dataflow | Yürütülmekte olan Veri Akışı başvurusu | DataFlowReference | Yes |

| integrationRuntime | Veri akışının üzerinde çalıştığı işlem ortamı. Belirtilmezse, Azure tümleştirme çalışma zamanını otomatik olarak çözümleme kullanılır. | IntegrationRuntimeReference | Hayır |

| compute.coreCount | Spark kümesinde kullanılan çekirdek sayısı. Yalnızca otomatik çözümle Azure Tümleştirme çalışma zamanı kullanılıyorsa belirtilebilir | 8, 16, 32, 48, 80, 144, 272 | Hayır |

| compute.computeType | Spark kümesinde kullanılan işlem türü. Yalnızca otomatik çözümle Azure Tümleştirme çalışma zamanı kullanılıyorsa belirtilebilir | "Genel" | Hayır |

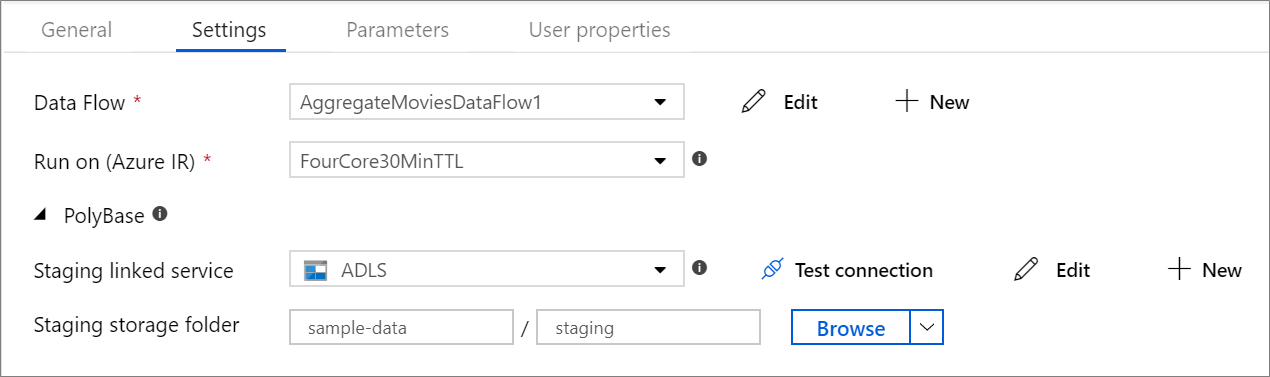

| staging.linkedService | Azure Synapse Analytics kaynağı veya havuzu kullanıyorsanız PolyBase hazırlama için kullanılan depolama hesabını belirtin. Azure Depolama alanınız sanal ağ hizmet uç noktasıyla yapılandırıldıysa, depolama hesabında "güvenilen Microsoft hizmetine izin ver" özelliği etkinleştirilmiş yönetilen kimlik doğrulamasını kullanmanız gerekir. Bkz . Azure depolama ile Sanal Ağ Hizmet Uç Noktalarını kullanmanın etkisi. Ayrıca sırasıyla Azure Blob ve Azure Data Lake Storage 2. Nesil için gerekli yapılandırmaları öğrenin. |

LinkedServiceReference | Yalnızca veri akışı bir Azure Synapse Analytics'i okur veya yazarsa |

| staging.folderPath | Azure Synapse Analytics kaynağı veya havuzu kullanıyorsanız, PolyBase hazırlama için kullanılan blob depolama hesabındaki klasör yolu | String | Yalnızca veri akışı Azure Synapse Analytics'i okur veya yazarsa |

| traceLevel | Veri akışı etkinlik yürütmenizin günlük düzeyini ayarlama | Fine, Coarse, None | Hayır |

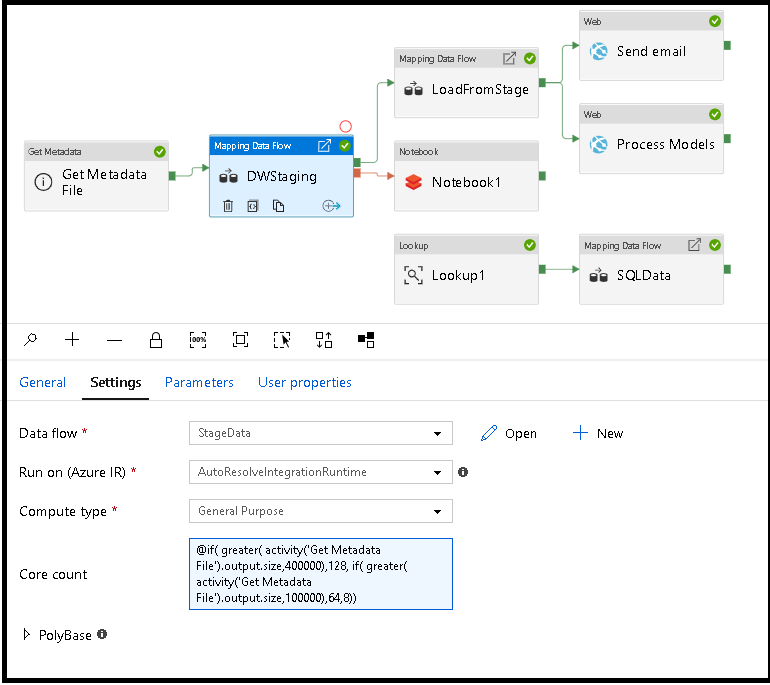

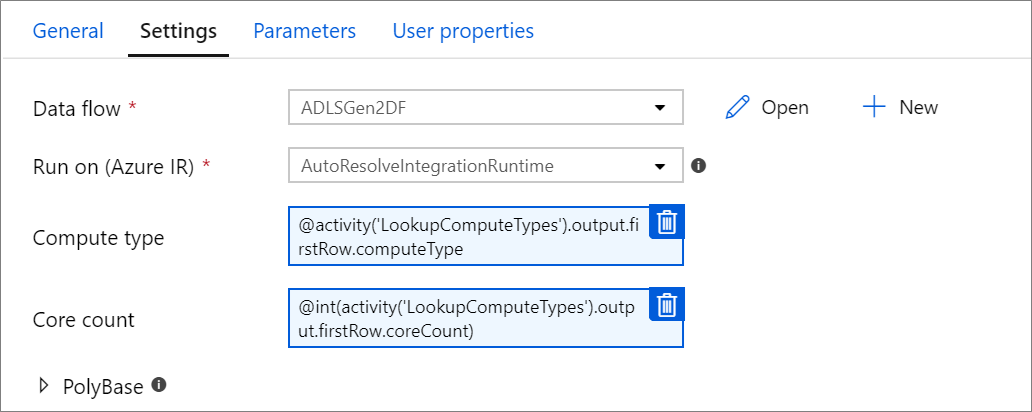

Çalışma zamanında veri akışı hesaplamayı dinamik olarak boyutlandırma

Çekirdek Sayısı ve İşlem Türü özellikleri, çalışma zamanında gelen kaynak verilerinizin boyutuna göre dinamik olarak ayarlanabilir. Kaynak veri kümesi verilerinin boyutunu bulmak için Arama veya Meta Verileri Al gibi işlem hattı etkinliklerini kullanın. Ardından, Veri Akışı etkinlik özelliklerinde Dinamik İçerik Ekle'yi kullanın. Küçük, orta veya büyük işlem boyutları seçebilirsiniz. İsteğe bağlı olarak, "Özel" öğesini seçin ve işlem türlerini ve çekirdek sayısını el ile yapılandırın.

İşte bu tekniği açıklayan kısa bir video öğreticisi

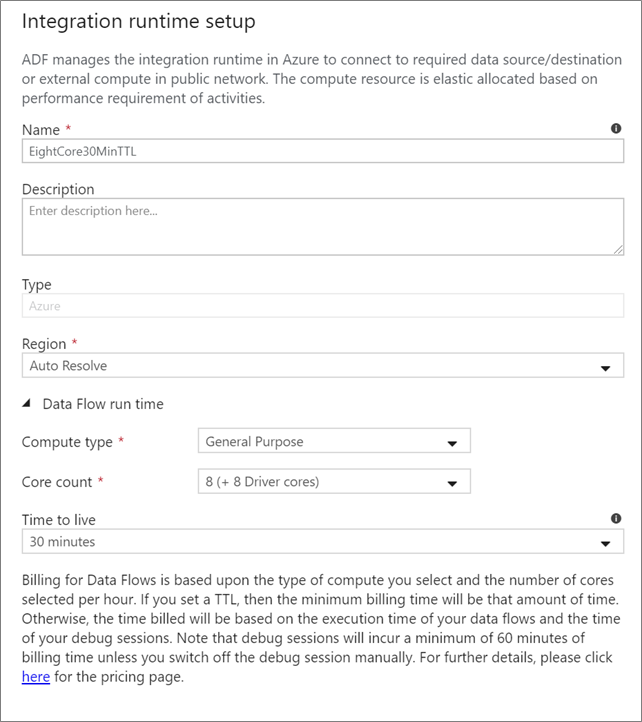

Veri Akışı tümleştirme çalışma zamanı

Veri Akışı etkinlik yürütmeniz için hangi Integration Runtime'ın kullanılacağını seçin. Varsayılan olarak, hizmet dört çalışan çekirdeğiyle Azure Tümleştirme çalışma zamanını otomatik olarak çözümlemeyi kullanır. Bu IR genel amaçlı bir işlem türüne sahiptir ve hizmet örneğiniz ile aynı bölgede çalışır. İşletimselleştirilmiş işlem hatları için veri akışı etkinliği yürütmeniz için belirli bölgeleri, işlem türünü, çekirdek sayıları ve TTL'yi tanımlayan kendi Azure Integration Runtime'larınızı oluşturmanız kesinlikle önerilir.

8+8 (toplam 16 sanal çekirdek) yapılandırması ve 10 dakikalık Yaşam süresi (TTL) ile Genel Amaçlı en düşük işlem türü, çoğu üretim iş yükü için en düşük öneridir. Azure IR, küçük bir TTL ayarlayarak, soğuk bir küme için birkaç dakikalık başlangıç süresine neden olmayacak sıcak bir kümeyi koruyabilir. Daha fazla bilgi için bkz . Azure tümleştirme çalışma zamanı.

Önemli

Veri Akışı etkinliğindeki Integration Runtime seçimi yalnızca işlem hattınızın tetiklenen yürütmeleri için geçerlidir. Veri akışlarıyla işlem hattınızda hata ayıklama işlemi, hata ayıklama oturumunda belirtilen kümede çalıştırılır.

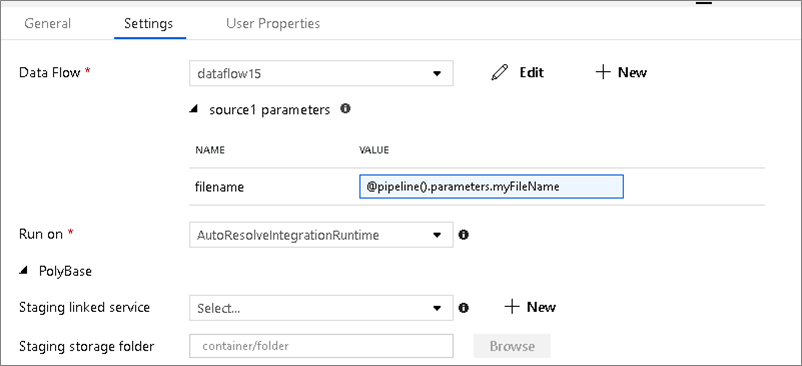

PolyBase

Havuz veya kaynak olarak Azure Synapse Analytics kullanıyorsanız PolyBase toplu iş yükünüz için bir hazırlama konumu seçmeniz gerekir. PolyBase, verileri satır satır yüklemek yerine toplu olarak yüklemeye olanak tanır. PolyBase, Azure Synapse Analytics'e yükleme süresini önemli ölçüde azaltır.

Denetim noktası anahtarı

Veri akışı kaynakları için değişiklik yakalama seçeneğini kullanırken, ADF denetim noktasını sizin için otomatik olarak korur ve yönetir. Varsayılan denetim noktası anahtarı, veri akışı adının ve işlem hattı adının karmasıdır. Kaynak tablolarınız veya klasörleriniz için dinamik bir desen kullanıyorsanız, bu karmayı geçersiz kılmak ve kendi denetim noktası anahtar değerinizi burada ayarlamak isteyebilirsiniz.

Günlük düzeyi

Veri akışı etkinliklerinizin her işlem hattı yürütmesinin tüm ayrıntılı telemetri günlüklerini tam olarak günlüğe kaydetmesini istemiyorsanız, isteğe bağlı olarak günlük düzeyinizi "Temel" veya "Yok" olarak ayarlayabilirsiniz. Veri akışlarınızı "Ayrıntılı" modda yürütürken (varsayılan), veri dönüştürme sırasında hizmetin her bölüm düzeyinde etkinliği tam olarak günlüğe kaydetmesini istiyorsunuz. Bu pahalı bir işlem olabileceğinden, yalnızca sorun giderme sırasında ayrıntılı bir şekilde etkinleştirilmesi genel veri akışınızı ve işlem hattı performansınızı iyileştirebilir. "Temel" modu yalnızca dönüştürme sürelerini günlüğe kaydederken "Yok" yalnızca sürelerin özetini sağlar.

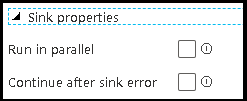

Havuz özellikleri

Veri akışlarındaki gruplandırma özelliği hem havuzlarınızın yürütme sırasını ayarlamanıza hem de havuzları aynı grup numarasını kullanarak birlikte gruplandırmanıza olanak tanır. Grupları yönetmeye yardımcı olmak için hizmetlerden havuzları aynı grupta paralel olarak çalıştırmasını isteyebilirsiniz. Havuzlardan biri hatayla karşılaştıklarında bile havuz grubunu devam etmek üzere ayarlayabilirsiniz.

Veri akışı havuzlarının varsayılan davranışı, her havuzu sırayla, seri bir şekilde yürütmek ve havuz içinde bir hatayla karşılaşıldığında veri akışının başarısız olmasıdır. Ayrıca, veri akışı özelliklerine gidip havuzlar için farklı öncelikler ayarlamadığınız sürece tüm havuzlar varsayılan olarak aynı gruba ayarlanır.

Yalnızca ilk satır

Bu seçenek yalnızca "Etkinlik çıkışı" için önbellek havuzlarının etkinleştirildiği veri akışları için kullanılabilir. doğrudan işlem hattınıza eklenen veri akışı çıkışı 2 MB ile sınırlıdır. "Yalnızca ilk satır" ayarı, veri akışı etkinlik çıkışını doğrudan işlem hattınıza eklerken veri akışından gelen veri çıkışını sınırlamanıza yardımcı olur.

Veri Akışı parametreleştirme

Parametreli veri kümeleri

Veri akışınız parametreli veri kümeleri kullanıyorsa, Ayarlar sekmesinde parametre değerlerini ayarlayın.

Parametreli veri akışları

Veri akışınız parametreliyse, Parametreler sekmesinde veri akışı parametrelerinin dinamik değerlerini ayarlayın. Dinamik veya değişmez değer parametre değerleri atamak için işlem hattı ifade dilini veya veri akışı ifade dilini kullanabilirsiniz. Daha fazla bilgi için bkz. Veri Akışı Parametreleri.

Parametreli işlem özellikleri.

Azure Integration runtime'ı otomatik olarak çözümlemeyi kullanır ve compute.coreCount ve compute.computeType değerlerini belirtirseniz çekirdek sayısını veya işlem türünü parametreleştirebilirsiniz.

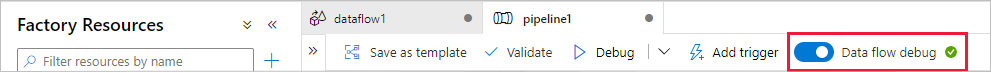

Veri Akışı etkinliğinde işlem hattı hata ayıklaması

Veri Akışı etkinliğiyle bir hata ayıklama işlem hattı çalıştırması yürütmek için üst çubukta Veri Akışı Hata Ayıklama kaydırıcısı aracılığıyla veri akışı hata ayıklama modunu açmalısınız. Hata ayıklama modu, etkin bir Spark kümesinde veri akışını çalıştırmanızı sağlar. Daha fazla bilgi için bkz . Hata Ayıklama Modu.

Hata ayıklama işlem hattı, Veri Akışı etkinlik ayarlarında belirtilen tümleştirme çalışma zamanı ortamına değil etkin hata ayıklama kümesine karşı çalışır. Hata ayıklama modunu başlatırken hata ayıklama işlem ortamını seçebilirsiniz.

Veri Akışı etkinliğini izleme

Veri Akışı etkinliği bölümleme, aşama süresi ve veri kökeni bilgilerini görüntüleyebileceğiniz özel bir izleme deneyimine sahiptir. eylemler'in altındaki gözlük simgesi aracılığıyla izleme bölmesini açın. Daha fazla bilgi için bkz. İzleme Veri Akışı.

sonraki bir etkinlikte Veri Akışı etkinlik sonuçlarını kullanma

Veri akışı etkinliği, her havuza yazılan satır sayısı ve her kaynaktan okunan satır sayısıyla ilgili ölçümleri verir. Bu sonuçlar, etkinlik çalıştırması sonucunun bölümünde döndürülür output . Döndürülen ölçümler aşağıdaki json biçimindedir.

{

"runStatus": {

"metrics": {

"<your sink name1>": {

"rowsWritten": <number of rows written>,

"sinkProcessingTime": <sink processing time in ms>,

"sources": {

"<your source name1>": {

"rowsRead": <number of rows read>

},

"<your source name2>": {

"rowsRead": <number of rows read>

},

...

}

},

"<your sink name2>": {

...

},

...

}

}

}

Örneğin, 'dataflowActivity' adlı bir etkinlikte 'sink1' adlı havuza yazılan satır sayısına ulaşmak için kullanın @activity('dataflowActivity').output.runStatus.metrics.sink1.rowsWritten.

Bu havuz içinde kullanılan 'source1' adlı kaynaktan okunan satır sayısını almak için kullanın @activity('dataflowActivity').output.runStatus.metrics.sink1.sources.source1.rowsRead.

Not

Havuza sıfır satır yazıldıysa ölçümlerde gösterilmez. Varlık, işlevi kullanılarak contains doğrulanabilir. Örneğin, contains(activity('dataflowActivity').output.runStatus.metrics, 'sink1') herhangi bir satırın sink1'e yazılıp yazılmadığını denetler.

İlgili içerik

Desteklenen denetim akışı etkinliklerine bakın:

Geri Bildirim

Çok yakında: 2024 boyunca, içerik için geri bildirim mekanizması olarak GitHub Sorunları’nı kullanımdan kaldıracak ve yeni bir geri bildirim sistemiyle değiştireceğiz. Daha fazla bilgi için bkz. https://aka.ms/ContentUserFeedback.

Gönderin ve geri bildirimi görüntüleyin