Bu makalede, otomatik bir sürüş sistemi için çevrimdışı veri işlemleri ve veri yönetimi (DataOps) geliştirmeye yönelik bir çözüm ve rehberlik sunulur. DataOps çözümü, Otonom araç operasyonları (AVOps) tasarım kılavuzunda özetlenen çerçeve üzerine kurulmuştur. DataOps, AVOps'un yapı taşları arasında yer alır. Diğer yapı taşları makine öğrenmesi işlemleri (MLOps), doğrulama işlemleri (ValOps), DevOps ve merkezi AVOps işlevleridir.

Apache®, Apache Spark ve Apache Parquet, Apache Software Foundation'ın Birleşik Devletler ve/veya diğer ülkelerdeki kayıtlı ticari markaları veya ticari markalarıdır. Bu işaretlerin kullanılması Apache Software Foundation tarafından onaylanmamaktadır.

Mimari

Bu makaledeki mimari diyagramlarını içeren bir Visio dosyası indirin.

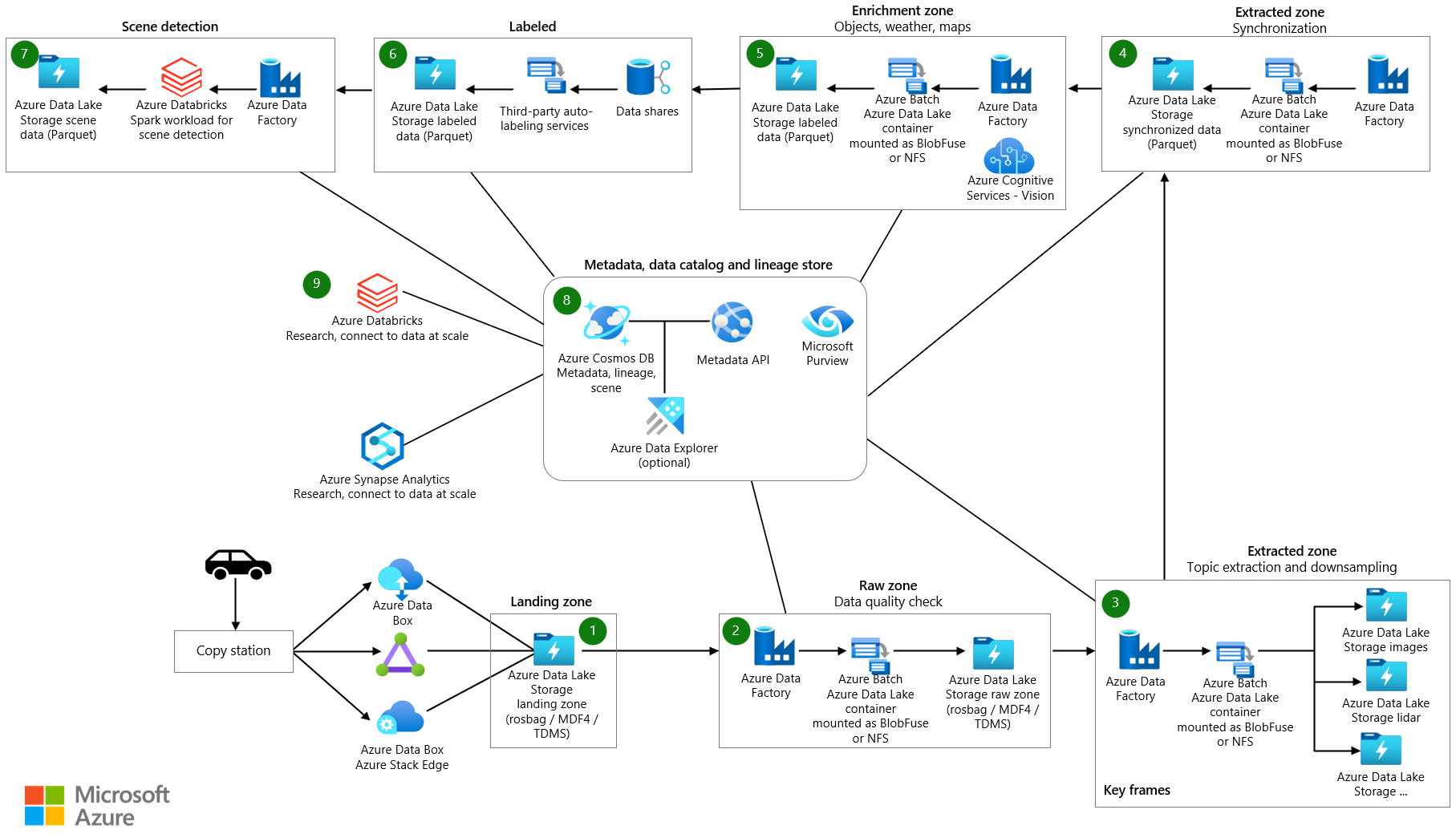

Veri akışı

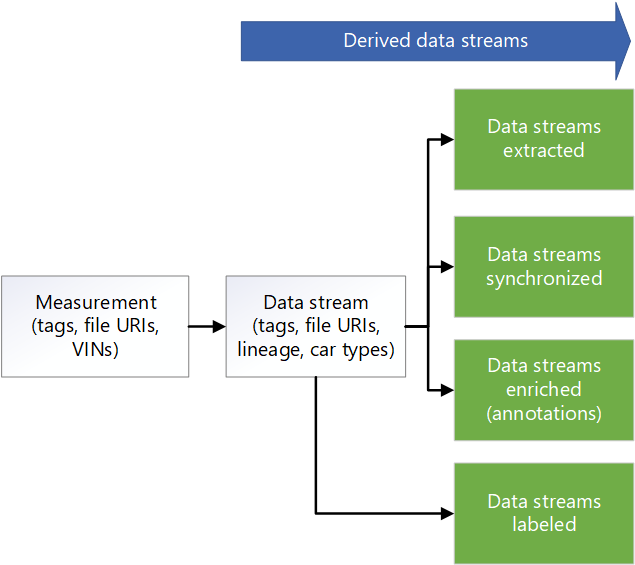

Ölçüm verileri bir aracın veri akışlarından kaynaklanır. Kaynaklar arasında kameralar, araç telemetrisi ve radar, ultrasonik ve lidar algılayıcıları yer alır. Araçtaki veri kaydediciler ölçüm verilerini günlükçü depolama cihazlarında depolar. Günlükçü depolama verileri bir giriş veri gölüne yüklenir. Azure Data Box veya Azure Stack Edge gibi bir hizmet ya da Azure ExpressRoute gibi ayrılmış bir bağlantı verileri Azure'a alır. Aşağıdaki biçimlerdeki ölçüm verileri Azure Data Lake Depolama'a eklenir: Ölçüm Veri Biçimi sürüm 4 (MDF4), teknik veri yönetimi sistemleri (TDMS) ve rosbag. Karşıya yüklenen veriler, verileri almak ve doğrulamak için belirlenen Giriş adlı ayrılmış bir depolama hesabı girer.

Giriş depolama hesabındaki verileri işlemek için zamanlanmış bir aralıkta bir Azure Data Factory işlem hattı tetikleniyor. İşlem hattı aşağıdaki adımları işler:

- Sağlama toplamı gibi bir veri kalitesi denetimi gerçekleştirir. Bu adım düşük kaliteli verileri kaldırarak yalnızca yüksek kaliteli verilerin bir sonraki aşamaya geçmesini sağlar. Azure Uygulaması Hizmeti, kalite denetimi kodunu çalıştırmak için kullanılır. Eksik olduğu düşünülen veriler gelecekte işlenmek üzere arşivlenmiştir.

- Köken izleme için App Service kullanarak bir meta veri API'sini çağırır. Bu adım, yeni bir veri akışı oluşturmak için Azure Cosmos DB'de depolanan meta verileri güncelleştirir. Her ölçüm için bir ham veri akışı vardır.

- Verileri Data Lake Depolama'de Raw adlı bir depolama hesabına kopyalar.

- Diğer bileşenlerin ve hizmetlerin veri akışını kullanabilmesi için veri akışını tamamlandı olarak işaretlemek için meta veri API'sini çağırır.

- Ölçümleri arşivler ve Giriş depolama hesabından kaldırır.

Data Factory ve Azure Batch, aşağı akış sistemlerinin kullanabileceği bilgileri ayıklamak için ham bölgedeki verileri işler:

- Batch ham dosyadaki konu başlıklarından verileri okur ve verileri ilgili klasörlerdeki seçili konulara aktarır.

- Ham bölgedeki dosyaların her birinin boyutu 2 GB'tan fazla olabileceğinden, her dosyada paralel işleme ayıklama işlevleri çalıştırılır. Bu işlevler görüntü işleme, lidar, radar ve GPS verilerini ayıklar. Ayrıca meta veri işleme de gerçekleştirirler. Data Factory ve Batch, paralelliği ölçeklenebilir bir şekilde gerçekleştirmek için bir yol sağlar.

- Etiketlenmesi ve ek açıklama eklemesi gereken veri miktarını azaltmak için veriler altörneklenir.

Araç günlükçüden alınan veriler çeşitli algılayıcılar arasında eşitlenmemişse, geçerli bir veri kümesi oluşturmak için verileri eşitleyen bir Data Factory işlem hattı tetiklenir. Eşitleme algoritması Batch üzerinde çalışır.

Data Factory işlem hattı, verileri zenginleştirmek için çalışır. İyileştirmelere örnek olarak telemetri verileri, araç günlükçü verileri ve hava durumu, harita veya nesne verileri gibi diğer veriler verilebilir. Zenginleştirilmiş veriler, veri bilimcilerine algoritma geliştirmede kullanabilecekleri içgörüler sağlamaya yardımcı olur. Oluşturulan veriler eşitlenen verilerle uyumlu Apache Parquet dosyalarında tutulur. Zenginleştirilmiş veriler hakkındaki meta veriler Azure Cosmos DB'deki bir meta veri deposunda depolanır.

Üçüncü taraf iş ortakları el ile veya otomatik etiketleme gerçekleştirir. Veriler Azure Veri Paylaşımı aracılığıyla üçüncü taraf iş ortaklarıyla paylaşılır ve Microsoft Purview ile tümleşiktir. Veri Paylaşımı adlı ayrılmış bir depolama hesabı kullanır Data Lake Depolama etiketlenmiş verileri kuruluşa döndürmek için etiketlenmiştir.

Data Factory işlem hattı, sahne algılama gerçekleştirir. Sahne meta verileri meta veri deposunda tutulur. Sahne verileri Parquet veya Delta dosyalarında nesne olarak depolanır.

Zenginleştirme verileri ve algılanan sahneler için meta verilerin yanı sıra Azure Cosmos DB'deki meta veri deposu, ölçümler için sürücü verileri gibi meta verileri depolar. Bu depo, ayıklama, alt örnekleme, eşitleme, zenginleştirme ve sahne algılama işlemlerinden geçerken verilerin kökeni için meta veriler de içerir. Meta veri API'si ölçümlere, kökenlere ve sahne verilerine erişmek ve verilerin depolandığı yeri aramak için kullanılır. Sonuç olarak meta veri API'si bir depolama katmanı yöneticisi görevi görür. Verileri depolama hesaplarına yayar. Ayrıca geliştiricilere veri konumlarını almak için meta veri tabanlı bir arama kullanma yolu da sağlar. Bu nedenle meta veri deposu, çözümün veri akışı genelinde izlenebilirlik ve köken sunan merkezi bir bileşendir.

Azure Databricks ve Azure Synapse Analytics, meta veri API'sine bağlanmak ve Data Lake Depolama erişmek ve veriler üzerinde araştırma yapmak için kullanılır.

Bileşenler

- Data Box hızlı, ucuz ve güvenilir bir şekilde Azure'a terabaytlarlık veri göndermenin bir yolunu sağlar. Bu çözümde Data Box, toplanan araç verilerini bölgesel bir taşıyıcı aracılığıyla Azure'a aktarmak için kullanılır.

- Azure Stack Edge cihazları uç konumlarında Azure işlevselliği sağlar. Azure özelliklerine örnek olarak işlem, depolama, ağ ve donanım hızlandırmalı makine öğrenmesi verilebilir.

- ExpressRoute , özel bir bağlantı üzerinden şirket içi ağı Microsoft bulutuna genişletir.

- Data Lake Depolama büyük miktarda veriyi yerel, ham biçiminde tutar. Bu durumda Data Lake Depolama verileri ham veya ayıklanmış gibi aşamalara göre depolar.

- Data Factory ayıklama, dönüştürme, yükleme (ETL) ve ayıklama, yükleme, dönüştürme (ELT) iş akışları oluşturmak ve zamanlamak için tam olarak yönetilen, sunucusuz bir çözümdür. Burada Data Factory, toplu işlem aracılığıyla ETL gerçekleştirir ve veri taşımayı ve verileri dönüştürmeyi düzenlemeye yönelik veri temelli iş akışları oluşturur.

- Batch , Azure'da büyük ölçekli paralel ve yüksek performanslı bilgi işlem (HPC) toplu işlerini verimli bir şekilde çalıştırır. Bu çözüm, veri düzenleme, verileri filtreleme ve hazırlama ve meta verileri ayıklama gibi görevler için büyük ölçekli uygulamalar çalıştırmak için Batch'i kullanır.

- Azure Cosmos DB , genel olarak dağıtılmış, çok modelli bir veritabanıdır. Burada depolanan ölçümler gibi meta veri sonuçlarını depolar.

- Veri Paylaşımı gelişmiş güvenlik özelliğine sahip iş ortağı kuruluşlarla veri paylaşır. Veri sağlayıcıları yerinde paylaşımı kullanarak verileri kopyalamadan veya anlık görüntüler almadan bulunduğu yerde paylaşabilir. Bu çözümde Veri Paylaşımı verileri etiketleme şirketleriyle paylaşır.

- Azure Databricks , kurumsal düzeydeki veri çözümlerini büyük ölçekte korumak için bir dizi araç sağlar. Büyük miktarda araç verisi üzerinde uzun süre çalışan operasyonlar için gereklidir. Veri mühendisleri, analiz çalışma alanı olarak Azure Databricks'i kullanır.

- Azure Synapse Analytics , veri ambarları ve büyük veri sistemleri arasında içgörü elde etme süresini kısaltıyor.

- Azure Bilişsel Arama veri kataloğu arama hizmetleri sağlar.

- App Service sunucusuz tabanlı bir web uygulaması hizmeti sağlar. Bu durumda App Service meta veri API'sini barındırıyor.

- Microsoft Purview , kuruluşlar genelinde veri idaresi sağlar.

- Azure Container Registry , kapsayıcı görüntülerinin yönetilen kayıt defterini oluşturan bir hizmettir. Bu çözüm, kapsayıcıları işleme konularını depolamak için Container Registry'yi kullanır.

- Uygulama Analizler, uygulama performansı yönetimi sağlayan bir Azure İzleyici uzantısıdır. Bu senaryoda, Uygulama Analizler ölçüm ayıklama konusunda gözlemlenebilirlik oluşturmanıza yardımcı olur: Çözüm her ölçümü ayıklama için işlerken özel olayları, özel ölçümleri ve diğer bilgileri günlüğe kaydetmek için Application Analizler kullanabilirsiniz. Ayrıca her ölçüm hakkında ayrıntılı bilgi almak için log analytics üzerinde sorgular oluşturabilirsiniz.

Senaryo ayrıntıları

Otonom araçlar için sağlam bir DataOps çerçevesi tasarlamak, verilerinizi kullanmak, kökenini takip etmek ve kuruluşunuz genelinde kullanılabilir hale getirmek için çok önemlidir. İyi tasarlanmış bir DataOps işlemi olmadan, otonom araçların oluşturduğu çok büyük miktardaki veriler hızla bunaltıcı hale gelebilir ve yönetilmesi zor olabilir.

Etkili bir DataOps stratejisi uyguladığınızda, verilerinizin düzgün bir şekilde depolandığından, kolayca erişilebilir olduğundan ve net bir kökene sahip olduğundan emin olmanıza yardımcı olursunuz. Ayrıca verileri yönetmeyi ve analiz etmenizi kolaylaştırarak daha bilinçli karar alma ve gelişmiş araç performansı sağlarsınız.

Verimli bir DataOps işlemi, verileri kuruluşunuz genelinde kolayca dağıtmanın bir yolunu sağlar. Daha sonra çeşitli ekipler, işlemlerini iyileştirmek için ihtiyaç duydukları bilgilere erişebilir. DataOps, kuruluşunuzun genel verimliliğini artırmaya yardımcı olan işbirliği ve içgörü paylaşımını kolaylaştırır.

Otonom araçlar bağlamında veri operasyonları için tipik zorluklar şunlardır:

- Araştırma ve geliştirme araçlarından günlük terabayt ölçeğinde veya petabayt ölçeğinde ölçüm verilerinin yönetimi.

- Etiketleme, ek açıklamalar ve kalite denetimleri gibi birden çok ekip ve iş ortağı arasında veri paylaşımı ve işbirliği.

- Sürüm oluşturma ve ölçüm verilerinin kökenini yakalayan güvenlik açısından kritik bir algı yığını için izlenebilirlik ve köken.

- Anlamsal segmentasyon, görüntü sınıflandırma ve nesne algılama modellerini geliştirmek için meta veriler ve veri bulma.

Bu AVOps DataOps çözümü, bu zorlukların nasıl ele alınacakları konusunda rehberlik sağlar.

Olası kullanım örnekleri

Bu çözüm, otomatik sürüş için çözümler geliştiren otomotiv orijinal ekipman üreticilerine (OEM), katman 1 satıcılarına ve bağımsız yazılım satıcılarına (ISV) avantaj sağlar.

Federasyon veri işlemleri

AVOps uygulayan bir kuruluşta, AVOps için gereken karmaşıklık nedeniyle birden çok ekip DataOps'a katkıda bulunur. Örneğin, bir ekip veri toplama ve veri alımından sorumlu olabilir. Lidar verilerinin veri kalitesi yönetiminden başka bir ekip sorumlu olabilir. Bu nedenle, DataOps için aşağıdaki veri ağı mimarisi ilkelerinin dikkate alınması önemlidir:

- Veri sahipliğini ve mimarisini etki alanına yönelik merkezi olmayan hale getirme. Ayrılmış bir ekip, söz konusu etki alanı için veri ürünleri (örneğin etiketlenmiş veri kümeleri) sağlayan bir veri etki alanından sorumludur.

- Ürün olarak veriler. Her veri etki alanı, data-lake tarafından uygulanan depolama kapsayıcılarında çeşitli bölgelere sahiptir. İç kullanım için bölgeler vardır. Ayrıca, veri yinelemesini önlemek için diğer veri etki alanları veya dış kullanım için yayımlanmış veri ürünleri içeren bir bölge de vardır.

- Otonom, etki alanı odaklı veri ekiplerini etkinleştirmek için bir platform olarak kendi kendine hizmet verme verileri.

- Merkezi meta veri deposu ve veri kataloğu gerektiren AVOps veri etki alanları arasında birlikte çalışabilirliği ve erişimi etkinleştirmek için federasyon idaresi. Örneğin, bir etiketleme veri etki alanının veri toplama etki alanına erişmesi gerekebilir.

Veri ağı uygulamaları hakkında daha fazla bilgi için bkz . Bulut ölçeğinde analiz.

AVOps veri etki alanları için örnek yapı

Aşağıdaki tabloda AVOps veri etki alanlarının yapılandırılması için bazı fikirler sağlanmaktadır:

| Veri etki alanı | Yayımlanan veri ürünleri | Çözüm adımı |

|---|---|---|

| Veri toplama | Karşıya yüklenen ve doğrulanan ölçüm dosyaları | İniş ve ham |

| Ayıklanan görüntüler | Seçili ve ayıklanan görüntüler veya çerçeveler, lidar ve radar verileri | Ayıklanan |

| Ayıklanmış radar veya lidar | Lidar ve radar verileri seçili ve ayıklanmış | Ayıklanan |

| Ayıklanan telemetri | Seçili ve ayıklanmış araba telemetri verileri | Ayıklanan |

| Etiketli | Etiketli veri kümeleri | Etiketli |

| Yeniden derleme | Yinelenen simülasyon çalıştırmalarına dayalı olarak oluşturulan ana performans göstergeleri (KPI'ler) | Yeniden derleme |

Her AVOps veri etki alanı bir şema yapısına göre ayarlanır. Bu yapı Data Factory, Data Lake Depolama, veritabanları, Batch ve Azure Databricks veya Azure Synapse Analytics aracılığıyla Apache Spark çalışma zamanlarını içerir.

Meta veriler ve veri bulma

Her veri etki alanı merkezi değildir ve karşılık gelen AVOps veri ürünlerini tek tek yönetir. Merkezi veri bulma ve veri ürünlerinin nerede bulunduğunu bilmek için iki bileşen gerekir:

- İşlenen ölçüm dosyaları ve video dizileri gibi veri akışları hakkındaki meta verileri kalıcı hale getiren bir meta veri deposu. Bu bileşen, etiketlenmemiş dosyaların meta verilerini aramak gibi dizine alınması gereken ek açıklamalarla verileri bulunabilir ve izlenebilir hale getirir. Örneğin, meta veri deposunun belirli araç tanımlama numaraları (VIN) veya yayalar ya da diğer zenginleştirme tabanlı nesneler içeren çerçeveler için tüm çerçeveleri döndürmesini isteyebilirsiniz.

- Köken, AVOps veri etki alanları arasındaki bağımlılıkları ve AVOps veri döngüsüne hangi veri depolarının dahil olduğunu gösteren bir veri kataloğu. Veri kataloğuna örnek olarak Microsoft Purview gösteriliyor.

Azure Cosmos DB'yi temel alan meta veri depolarını genişletmek için Azure Veri Gezgini veya Azure Bilişsel Arama kullanabilirsiniz. Seçiminiz, veri bulma için ihtiyacınız olan son senaryoya bağlıdır. Anlamsal arama özellikleri için Azure Bilişsel Arama kullanın.

Aşağıdaki meta veri modeli diyagramı, çeşitli AVOps veri döngüsü yapılarında kullanılan tipik bir birleşik meta veri modelini gösterir:

Veri paylaşımı

Veri paylaşımı, AVOps veri döngüsündeki yaygın bir senaryodur. Kullanım alanları, etiketleme iş ortaklarını tümleştirmek için veri etki alanları ile dış paylaşım arasında veri paylaşımını içerir. Microsoft Purview, bir veri döngüsünde verimli veri paylaşımı için aşağıdaki özellikleri sağlar:

Etiket veri değişimi için önerilen biçimler arasında bağlam içindeki ortak nesneler (COCO) veri kümeleri ve Otomasyon ve Ölçüm Sistemlerinin Standartlaştırılması derneği (ASAM) OpenLABEL veri kümeleri yer alır.

Bu çözümde etiketlenmiş veri kümeleri MLOps işlemlerinde algı ve sensör füzyon modelleri gibi özel algoritmalar oluşturmak için kullanılır. Algoritmalar, araç değişen şeritler, engellenen yollar, yaya trafiği, trafik ışıkları ve trafik işaretleri gibi bir ortamdaki sahneleri ve nesneleri algılayabilir.

Veri işlem hattı

Bu DataOps çözümünde, verilerin veri işlem hattındaki farklı aşamalar arasında taşınması otomatikleştirilmiştir. Bu yaklaşım sayesinde süreç verimlilik, ölçeklenebilirlik, tutarlılık, yeniden üretilebilirlik, uyarlanabilirlik ve hata işleme avantajları sağlar. Genel geliştirme sürecini geliştirir, ilerlemeyi hızlandırır ve otonom sürüş teknolojilerinin güvenli ve etkili dağıtımını destekler.

Aşağıdaki bölümlerde aşamalar arasında veri taşımayı nasıl uygulayabileceğiniz ve depolama hesaplarınızı nasıl yapılandırmanız gerektiği açıklanmaktadır.

Hiyerarşik klasör yapısı

İyi düzenlenmiş bir klasör yapısı, otonom geliştirmede veri işlem hattının önemli bir bileşenidir. Böyle bir yapı, verimli veri yönetimi ve alma işlemlerini kolaylaştırarak veri dosyalarının sistematik ve kolay gezinilebilir bir düzenlemesini sağlar.

Bu çözümde ham klasördeki veriler aşağıdaki hiyerarşik yapıya sahiptir:

region/raw/<measurement-ID>/<data-stream-ID>/YYYY/MM/DD

Ayıklanan bölge depolama hesabındaki veriler benzer bir hiyerarşik yapı kullanır:

region/extracted/<measurement-ID>/<data-stream-ID>/YYYY/MM/DD

Benzer hiyerarşik yapıları kullanarak Data Lake Depolama hiyerarşik ad alanı özelliğinden yararlanabilirsiniz. Hiyerarşik yapılar, ölçeklenebilir ve uygun maliyetli nesne depolaması oluşturmaya yardımcı olur. Bu yapılar, nesne arama ve alma verimliliğini de artırır. Yıla ve VIN'e göre bölümleme, belirli araçlardan ilgili görüntüleri aramayı kolaylaştırır. Veri gölünde kamera, GPS cihazı veya lidar ya da radar sensörü gibi her sensör için bir depolama kapsayıcısı oluşturulur.

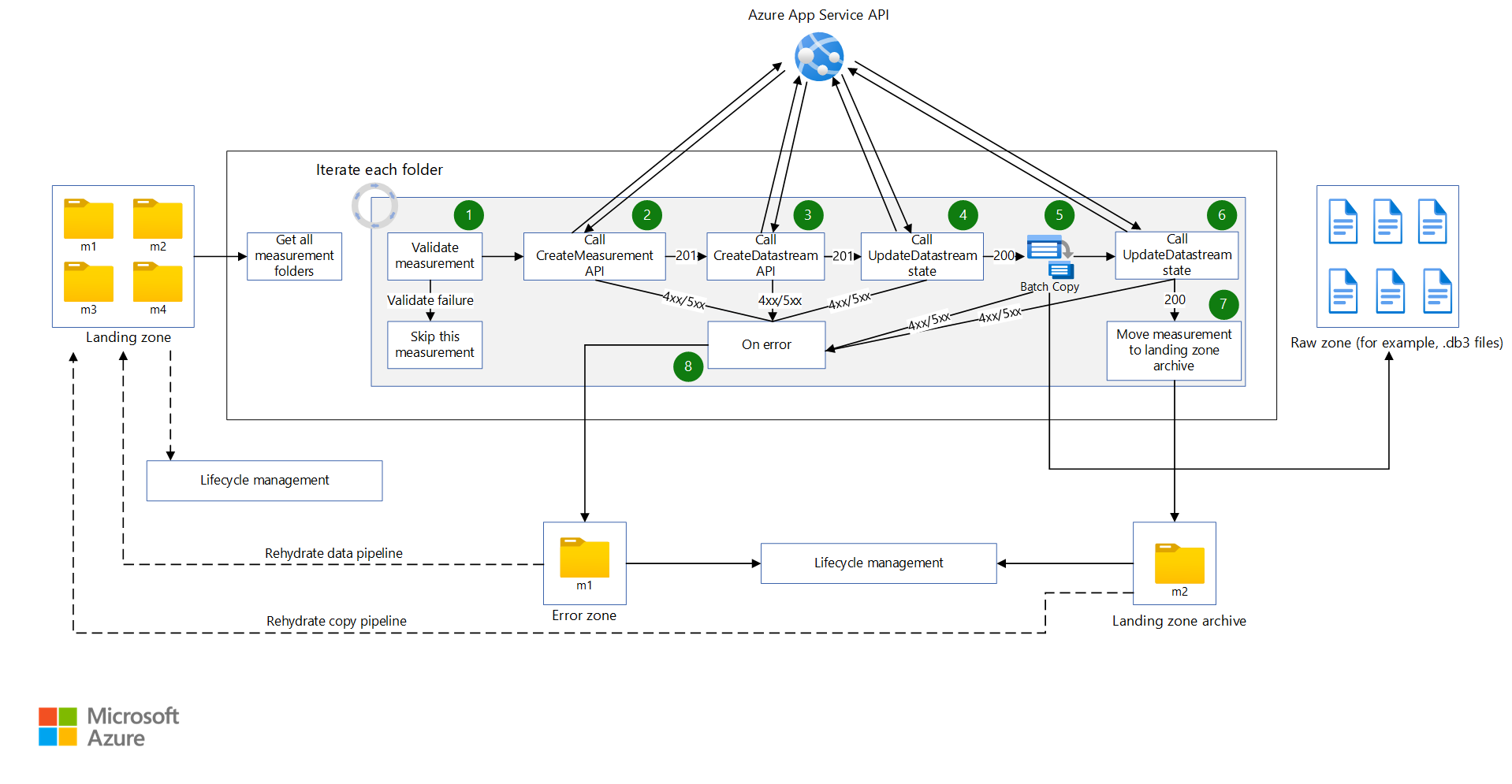

Ham depolama hesabına giriş depolama hesabı

Data Factory işlem hattı bir zamanlamaya göre tetikleniyor. İşlem hattı tetiklendiğinde veriler Giriş depolama hesabından Ham depolama hesabına kopyalanır.

İşlem hattı tüm ölçüm klasörlerini alır ve bunlar aracılığıyla yinelenir. Her ölçümde çözüm aşağıdaki etkinlikleri gerçekleştirir:

bir işlev ölçümü doğrular. işlevi, bildirim dosyasını ölçüm bildiriminden alır. Ardından işlev, geçerli ölçüm için tüm MDF4, TDMS ve rosbag ölçüm dosyalarının ölçüm klasöründe bulunup bulunmadığını denetler. Doğrulama başarılı olursa işlev sonraki etkinliğe geçer. Doğrulama başarısız olursa işlev geçerli ölçümü atlar ve sonraki ölçüm klasörüne geçer.

Ölçüm oluşturan bir API'ye web API çağrısı yapılır ve ölçüm bildirimi JSON dosyasındaki JSON yükü API'ye geçirilir. Çağrı başarılı olursa, ölçüm kimliğini almak için yanıt ayrıştırılır. Çağrı başarısız olursa, ölçüm hata işleme için hata durumundaki etkinliğe taşınır.

Not

Bu DataOps çözümü, uygulama hizmetine yönelik istek sayısını sınırladığınız varsayımı üzerine kurulmuştur. Çözümünüz belirsiz sayıda istekte bulunabilirse hız sınırlama desenini göz önünde bulundurun.

Gerekli JSON yükü oluşturularak veri akışı oluşturan bir API'ye web API çağrısı yapılır. Çağrı başarılı olursa, yanıt veri akışı kimliğini ve veri akışı konumunu almak için ayrıştırılır. Çağrı başarısız olursa, ölçüm hatadaki etkinliğe taşınır.

Veri akışının

Start Copydurumunu olarak güncelleştirmek için bir web API çağrısı yapılır. Çağrı başarılı olursa kopyalama etkinliği ölçüm dosyalarını veri akışı konumuna kopyalar. Çağrı başarısız olursa, ölçüm hatadaki etkinliğe taşınır.Data Factory işlem hattı Batch'i çağırarak ölçüm dosyalarını Giriş depolama hesabından Ham depolama hesabına kopyalar. Orchestrator uygulamasının kopyalama modülü, her ölçüm için aşağıdaki görevleri içeren bir iş oluşturur:

- Ölçüm dosyalarını Ham depolama hesabına kopyalayın.

- Ölçüm dosyalarını arşiv depolama hesabına kopyalayın.

- Giriş depolama hesabından ölçüm dosyalarını kaldırın.

Not

Bu görevlerde Batch, verileri kopyalamak ve kaldırmak için bir orchestrator havuzu ve AzCopy aracı kullanır. AzCopy, kopyalama veya kaldırma görevlerini gerçekleştirmek için SAS belirteçlerini kullanır. SAS belirteçleri bir anahtar kasasında depolanır ve ,

archivesaskeyverawsaskeyterimlerilandingsaskeykullanılarak başvurulur.Veri akışının

Copy Completedurumunu olarak güncelleştirmek için bir web API çağrısı yapılır. Çağrı başarılı olursa, sıra sonraki etkinliğe devam eder. Çağrı başarısız olursa, ölçüm hatadaki etkinliğe taşınır.Ölçüm dosyaları Giriş depolama hesabından giriş arşivine taşınır. Bu etkinlik, hidrat kopyalama işlem hattı aracılığıyla belirli bir ölçümü Giriş depolama hesabına geri taşıyarak yeniden çalıştırabilir. Bu bölgedeki ölçümlerin otomatik olarak silinmesi veya arşivlenmesi için yaşam döngüsü yönetimi bu bölge için açıktır.

Ölçümde hata oluşursa ölçüm bir hata bölgesine taşınır. Buradan, yeniden çalıştırmak için Giriş depolama hesabına taşınabilir. Alternatif olarak, yaşam döngüsü yönetimi ölçümü otomatik olarak silebilir veya arşivleyebilir.

Aaşağıdaki noktaları unutmayın:

- Bu işlem hatları bir zamanlamaya göre tetiklenir. Bu yaklaşım, işlem hattı çalıştırmalarının izlenebilirliğini geliştirmeye ve gereksiz çalıştırmaları önlemeye yardımcı olur.

- Her işlem hattı, önceki çalıştırmaların bir sonraki zamanlanmış çalıştırma başlamadan önce bitmesini sağlamak için eşzamanlılık değeriyle yapılandırılır.

- Her işlem hattı, ölçümleri paralel olarak kopyalanacak şekilde yapılandırılır. Örneğin, zamanlanmış bir çalıştırma kopyalamak için 10 ölçüm alırsa, işlem hattı adımları on ölçümün tümü için eşzamanlı olarak çalıştırılabilir.

- İşlem hattının tamamlanması beklenen süreden uzun sürüyorsa, her işlem hattı İzleyici'de bir uyarı oluşturacak şekilde yapılandırılır.

- Hatayla ilgili etkinlik daha sonraki gözlemlenebilirlik hikayelerinde uygulanır.

- Yaşam döngüsü yönetimi, eksik rosbag dosyaları içeren ölçümler gibi kısmi ölçümleri otomatik olarak siler.

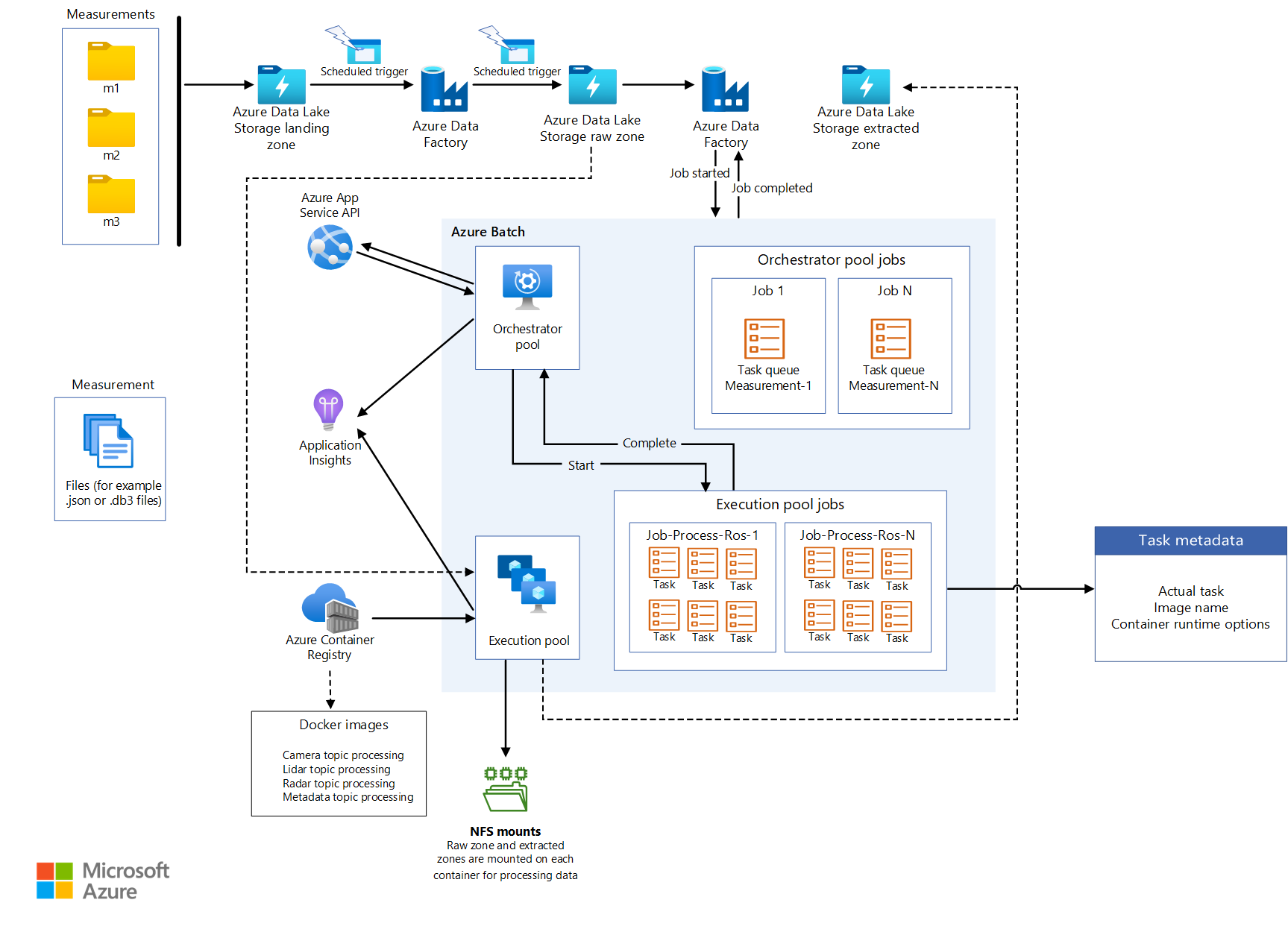

Toplu iş tasarımı

Tüm ayıklama mantığı, her ayıklama işlemi için bir kapsayıcı ile farklı kapsayıcı görüntülerinde paketlenmiştir. Batch, ölçüm dosyalarından bilgi ayıkladığında kapsayıcı iş yüklerini paralel olarak çalıştırır.

Batch, iş yüklerini işlemek için bir düzenleyici havuzu ve yürütme havuzu kullanır:

- Orchestrator havuzunda kapsayıcı çalışma zamanı desteği olmayan Linux düğümleri vardır. Havuz, yürütme havuzu için işler ve görevler oluşturmak için Batch API'sini kullanan Python kodunu çalıştırır. Bu havuz bu görevleri de izler. Data Factory, verileri ayıklayan kapsayıcı iş yüklerini düzenleyen orchestrator havuzunu çağırır.

- Yürütme havuzunda çalışan kapsayıcı iş yüklerini desteklemek için kapsayıcı çalışma zamanlarına sahip Linux düğümleri vardır. Bu havuz için işler ve görevler orchestrator havuzu aracılığıyla zamanlanır. Yürütme havuzunda işlemek için gereken tüm kapsayıcı görüntüleri JFrog kullanılarak kapsayıcı kayıt defterine gönderilir. Yürütme havuzu bu kayıt defterine bağlanacak ve gerekli görüntüleri çekecek şekilde yapılandırılmıştır.

Verilerin okunduğu ve yazıldığını Depolama hesaplar toplu iş düğümlerine ve düğümlerde çalışan kapsayıcılara NFS 3.0 aracılığıyla bağlanır. Bu yaklaşım, toplu iş düğümlerinin ve kapsayıcıların veri dosyalarını toplu iş düğümlerine yerel olarak indirmeye gerek kalmadan verileri hızlı bir şekilde işlemesine yardımcı olur.

Not

Toplu iş ve depolama hesaplarının bağlama için aynı sanal ağda olması gerekir.

Data Factory'den Batch'i çağırma

Ayıklama işlem hattında tetikleyici, meta veri dosyasının yolunu ve işlem hattı parametrelerindeki ham veri akışı yolunu geçirir. Data Factory, JSON dosyasını bildirim dosyasından ayrıştırmak için bir Arama etkinliği kullanır. Ham veri akışı kimliği, işlem hattı değişkeni ayrıştırılarak ham veri akışı yolundan ayıklanabilir.

Data Factory, veri akışı oluşturmak için bir API çağırır. API, ayıklanan veri akışının yolunu döndürür. Ayıklanan yol geçerli nesneye eklenir ve Data Factory, ayıklanan veri akışı yolunu ekledikten sonra geçerli nesneyi geçirerek özel bir etkinlik aracılığıyla Batch'i çağırır:

{

"measurementId":"210b1ba7-9184-4840-a1c8-eb£397b7c686",

"rawDataStreamPath":"raw/2022/09/30/KA123456/210b1ba7-9184-4840-

alc8-ebf39767c68b/57472a44-0886-475-865a-ca32{c851207",

"extractedDatastreamPath":"extracted/2022/09/30/KA123456

/210bIba7-9184-4840-a1c8-ebf39767c68b/87404c9-0549-4a18-93ff-d1cc55£d8b78",

"extractedDataStreamId":"87404bc9-0549-4a18-93ff-d1cc55fd8b78"

}

Adım adım ayıklama işlemi

Data Factory, ayıklama için bir ölçümü işlemek üzere düzenleyici havuzu için bir görevi olan bir iş zamanlar. Data Factory aşağıdaki bilgileri orchestrator havuzuna geçirir:

- Ölçüm kimliği

- Ayıklanması gereken MDF4, TDMS veya rosbag türünde ölçüm dosyalarının konumu

- Ayıklanan içeriğin depolama konumunun hedef yolu

- Ayıklanan veri akışı kimliği

Orchestrator havuzu, veri akışını güncelleştirmek ve durumunu

Processingolarak ayarlamak için bir API çağırır.Düzenleyici havuzu, ölçümün parçası olan her ölçüm dosyası için bir iş oluşturur. Her iş aşağıdaki görevleri içerir:

Görev Purpose Not Doğrulama Ölçüm dosyasından verilerin ayıklanabildiğini doğrular. Diğer tüm görevler bu göreve bağlıdır. İşlem meta verileri Ölçüm dosyasından meta verileri türetir ve dosyanın meta verilerini güncelleştirmek için bir API kullanarak dosyanın meta verilerini zenginleştirir. Işlem StructuredTopicsBelirli bir ölçüm dosyasından yapılandırılmış verileri ayıklar. Yapılandırılmış verileri ayıklamak için konu listesi yapılandırma nesnesi olarak geçirilir. Işlem CameraTopicsBelirli bir ölçüm dosyasından görüntü verilerini ayıklar. Görüntü ayıklama konularının listesi yapılandırma nesnesi olarak geçirilir. Işlem LidarTopicsBelirli bir ölçüm dosyasından lidar verilerini ayıklar. Lidar verilerini ayıklamak için konu listesi yapılandırma nesnesi olarak geçirilir. Işlem CANTopicsBelirli bir ölçüm dosyasından denetleyici alanı ağı (CAN) verilerini ayıklar. Veri ayıklama konularının listesi yapılandırma nesnesi olarak geçirilir. Düzenleyici havuzu her görevin ilerleme durumunu izler. Tüm ölçüm dosyaları için tüm işler tamamlandıktan sonra havuz, veri akışını güncelleştirmek ve durumunu

Completedolarak ayarlamak için bir API çağırır.Düzenleyici düzgün bir şekilde çıkar.

Not

Her görev, amacına uygun şekilde tanımlanmış mantığı olan ayrı bir kapsayıcı görüntüsüdür. Görevler, giriş olarak yapılandırma nesnelerini kabul eder. Örneğin, giriş çıkışın nereye yazıldığı ve hangi ölçüm dosyasının işlendiği belirtir. gibi

sensor_msgs/Imagekonu türleri dizisi, başka bir giriş örneğidir. Diğer tüm görevler doğrulama görevine bağlı olduğundan, bunun için bağımlı bir görev oluşturulur. Diğer tüm görevler bağımsız olarak işlenebilir ve paralel olarak çalıştırılabilir.

Dikkat edilmesi gereken noktalar

Bu önemli noktalar, bir iş yükünün kalitesini artırmak için kullanılabilecek bir dizi yol gösteren ilke olan Azure İyi Tasarlanmış Çerçeve'nin yapı taşlarını uygular. Daha fazla bilgi için bkz . Microsoft Azure İyi Tasarlanmış Çerçeve.

Güvenilirlik

Güvenilirlik, uygulamanızın müşterilerinize sağladığınız taahhütleri karşılayabilmesini sağlar. Daha fazla bilgi için bkz . Güvenilirlik sütununa genel bakış.

- Çözümünüzde, aynı Azure bölgesindeki benzersiz fiziksel konumlar olan Azure kullanılabilirlik alanlarını kullanmayı göz önünde bulundurun.

- Olağanüstü durum kurtarma ve hesap yük devretmeyi planlayın.

Güvenlik

Güvenlik, kasıtlı saldırılara ve değerli verilerinizin ve sistemlerinizin kötüye kullanılmasına karşı güvence sağlar. Daha fazla bilgi için bkz . Güvenlik sütununa genel bakış.

Bir otomotiv OEM'i ile Microsoft arasındaki sorumluluk ayrımını anlamak önemlidir. Bir araçta yığının tamamı OEM'e aittir, ancak veriler buluta taşınırken bazı sorumluluklar Microsoft'a aktarılır. Hizmet olarak Azure platformu (PaaS) katmanları, işletim sistemi de dahil olmak üzere fiziksel yığında yerleşik güvenlik sağlar. Mevcut altyapı güvenlik bileşenlerine aşağıdaki özellikleri ekleyebilirsiniz:

- Microsoft Entra kimliklerini ve Microsoft Entra Koşullu Erişim ilkelerini kullanan kimlik ve erişim yönetimi.

- Azure İlkesi kullanan altyapı idaresi.

- Microsoft Purview kullanan veri idaresi.

- Bekleyen verilerin yerel Azure depolama ve veritabanı hizmetlerini kullanan şifrelemesi. Daha fazla bilgi için bkz . Veri koruma konuları.

- Şifreleme anahtarlarının ve gizli dizilerinin korunması. Bu amaçla Azure Key Vault kullanın.

Maliyet iyileştirme

Maliyet iyileştirmesi, gereksiz giderleri azaltmanın ve operasyonel verimlilikleri iyileştirmenin yollarını arar. Daha fazla bilgi için bkz . Maliyet iyileştirme sütununa genel bakış.

Otomatik araçlar için DataOps çalıştıran OEM'ler ve katman 1 tedarikçileri için önemli bir sorun, işletim maliyetidir. Bu çözüm, maliyetleri iyileştirmeye yardımcı olmak için aşağıdaki uygulamaları kullanır:

- Azure'ın uygulama kodunu barındırmak için sunduğu çeşitli seçeneklerden yararlanma. Bu çözüm App Service ve Batch kullanır. Dağıtımınız için doğru hizmeti seçme hakkında yönergeler için bkz . Azure işlem hizmeti seçme.

- Azure Depolama yerinde veri paylaşımını kullanma.

- Yaşam döngüsü yönetimini kullanarak maliyetleri iyileştirme.

- Ayrılmış örnekleri kullanarak App Service'te maliyet tasarrufu.

Katkıda Bulunanlar

Bu makale Microsoft tarafından yönetilir. Başlangıçta aşağıdaki katkıda bulunanlar tarafından yazılmıştır.

Asıl yazarlar:

- Ryan Matsumura | Üst Düzey Program Yöneticisi

- Jochen Schroeer | Baş Mimar (Service Line Mobility)

- Brij Singh | Baş Yazılım Mühendisi

- Ginette Vellera | Kıdemli Yazılım Mühendisliği Lideri

Nonpublic LinkedIn profillerini görmek için LinkedIn'de oturum açın.

Sonraki adımlar

- Azure Batch nedir?

- Azure Data Factory nedir?

- Azure Data Lake Storage 2. Nesil'e giriş

- Azure Cosmos DB'ye hoş geldiniz

- App Service’e genel bakış

- Azure Veri Paylaşımı nedir?

- Azure Data Box nedir?

- Azure Stack Edge belgeleri

- Azure ExpressRoute nedir?

- Azure Machine Learning nedir?

- Azure Databricks nedir?

- Azure Synapse Analytics nedir?

- Azure İzleyici'ye genel bakış

- ROS Günlük Dosyaları (rosbags)

- Otonom Araçlar için Büyük Ölçekli Veri İşlemleri Platformu