你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

WANdisco LiveData Platform for Azure 可将 PB 级本地 Hadoop 数据迁移到 Azure Data Lake Storage 文件系统,而不会中断数据操作或停机。 该平台的持续检查可防止数据丢失,同时在传输的两端保持数据一致,即使数据正在进行修改。

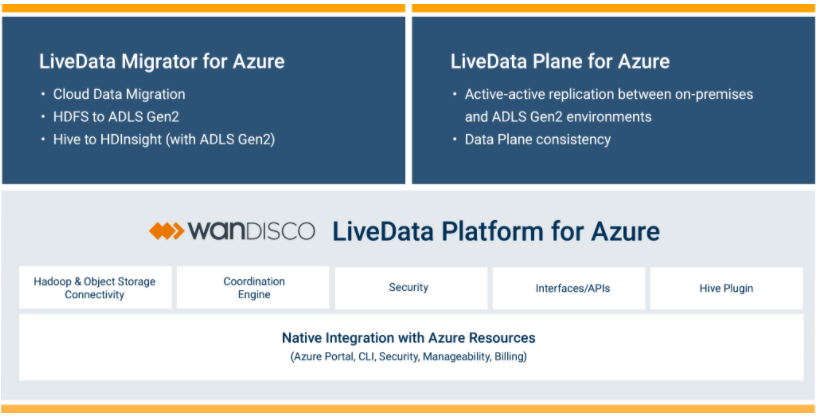

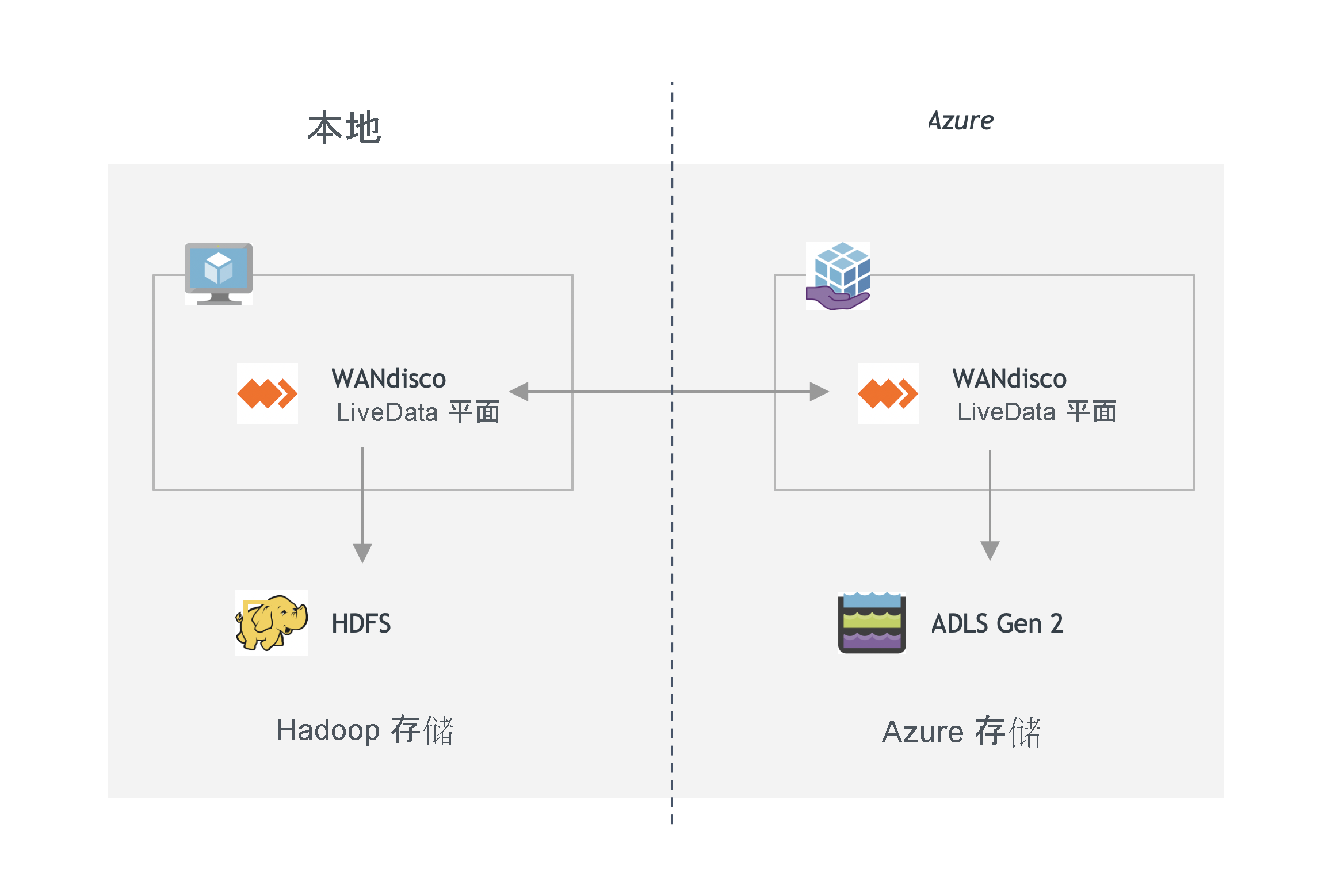

该平台由两项服务组成。 LiveData Migrator for Azure 将活跃使用的数据从本地环境迁移到 Azure 存储;LiveData Plane for Azure 可确保一致复制所有修改的数据或引入的数据。

使用 Azure 门户和 Azure CLI 管理这两项服务。 每项服务都遵循与所有其他 Azure 服务相同的即用即付计量计费模型:LiveData Platform for Azure 中的数据消耗会显示在每月 Azure 帐单上,该帐单将提供用量指标。

与通过将静态信息复制到 Azure Data Box 或使用 Hadoop 工具(如 DistCp)来“脱机”迁移数据不同,在使用 WANdisco LiveData for Azure“联机”迁移数据期间,你可以维护业务系统的全面运行。 即使在将数据迁移到 Azure 时,也要使大数据环境保持运行。

WANdisco LiveData Platform for Azure 的主要优势

WANdisco LiveData Platform for Azure 中支持广域网的共识引擎可实现数据一致性,并大规模执行实时数据复制。 有关详细信息,请参阅以下视频:

该平台的主要优势包括:

数据准确性:端到端的数据验证可防止数据丢失并确保传输的数据适合使用。

数据一致性:即使环境不断发生变化,环境之间的数据量也会自动保持一致。

数据效率:在完全控制带宽消耗的情况下持续传输大量数据。

停机时间消除:在迁移过程中与其他应用程序一起自由创建、修改、读取和删除数据,无需在将数据传输到 Azure 期间中断业务运营。 继续操作应用程序,分析基础结构,引入作业以及进行其他处理。

简单使用:使用平台的 Azure 集成来创建、配置、计划和跟踪自动迁移的进度。 此外,根据需要配置选择性数据复制、Hive 元数据、数据安全性和保密性。

WANdisco LiveData Platform for Azure 的主要功能

该平台的主要功能包括以下内容:

元数据迁移:除了 HDFS 数据外,还可以使用 LiveData Migrator for Azure 迁移元数据(从 Hive 和其他存储)。

计划传输:使用 LiveData Migrator for Azure 来控制和自动化启动数据传输的时间,无需手动迁移数据更改。

Kerberos:LiveData Migrator for Azure 支持完成 Kerberize 的群集。

排除模板:在 LiveData Migrator for Azure 中创建规则,以防止将某些文件大小或文件名(使用 glob 模式定义)迁移到目标存储。 在 Azure 门户中或使用 CLI 创建排除模板,并将它们应用于任意数量的迁移。

路径映射:为特定目标文件系统定义备用目标路径,这些路径会自动将传输的数据移动到指定的目录。

带宽管理:配置 LiveData Migrator for Azure 可用于防止带宽过度消耗的最大网络带宽量。

排除:定义模板查询,防止迁移符合条件的任何文件和目录,从而使你可以选择性地从源系统迁移数据。

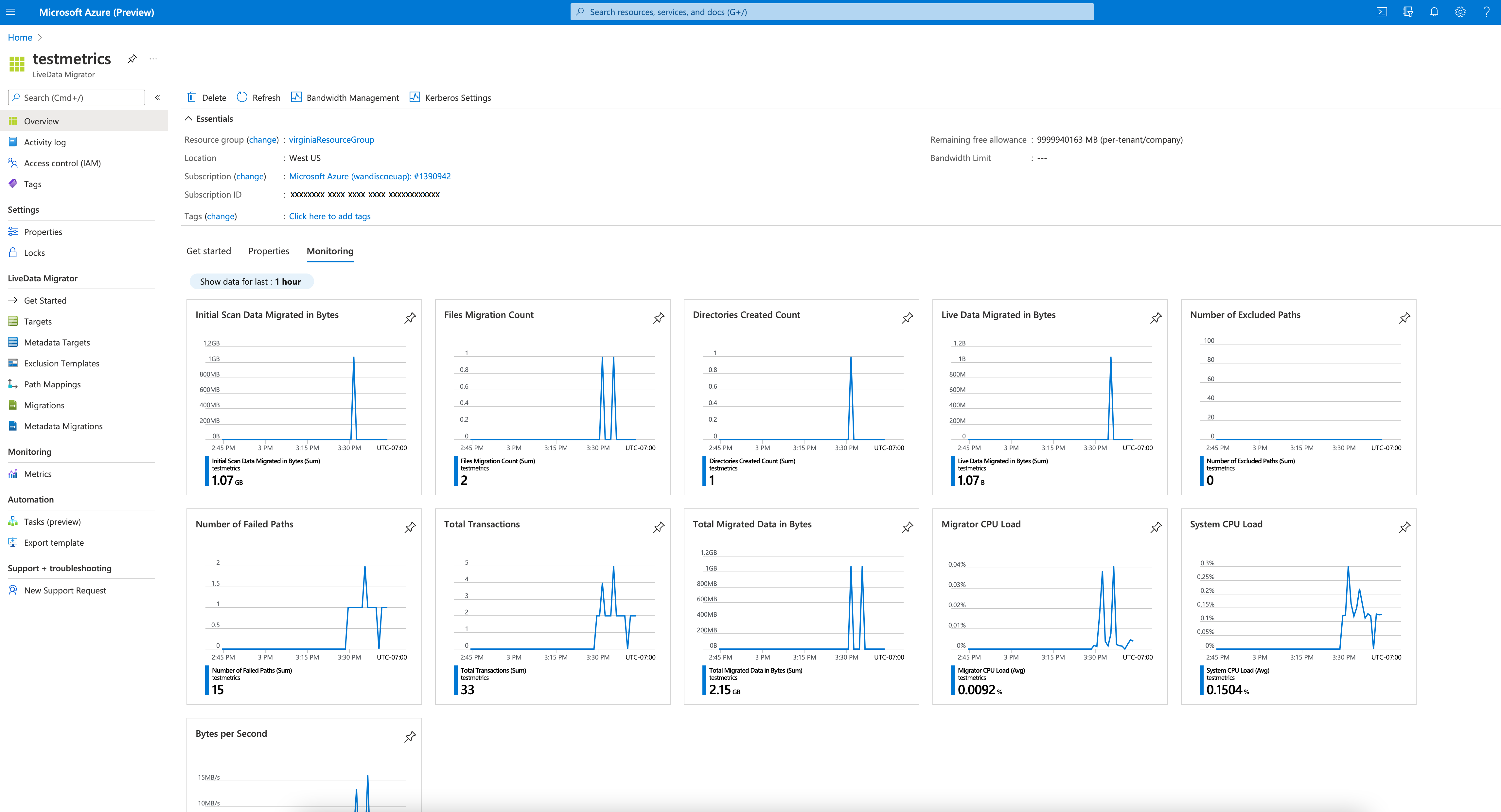

指标:查看有关 LiveData Migrator for Azure 中的数据传输的详细信息,例如一段时间内传输的文件、排除的路径、传输失败的项等。

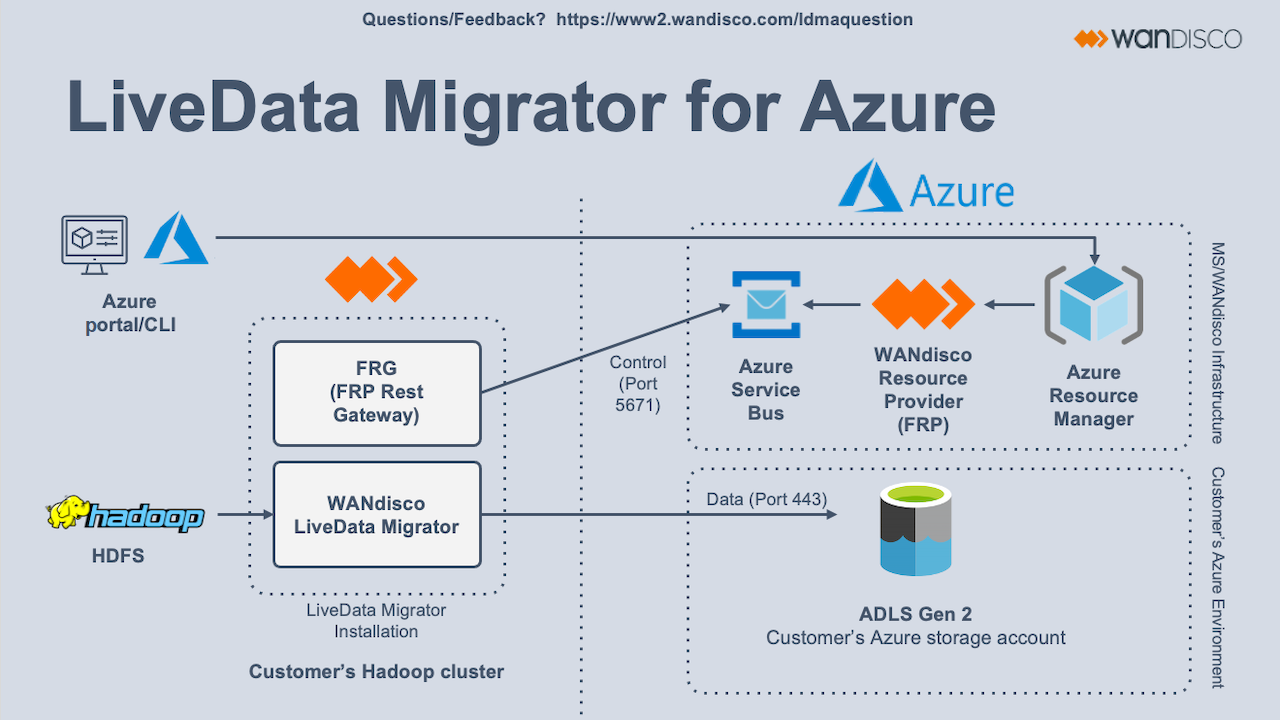

在没有风险的情况下更快地迁移大数据

WANdisco LiveData Platform for Azure 中包含的第一项服务是 LiveData Migrator for Azure,它将数据从本地环境迁移到 Azure 存储。 将 LiveData Migrator 部署到本地 Hadoop 群集后,它将自动为文件系统创建最佳配置。 从该处提供系统的 Kerberos 详细信息。 然后,LiveData Migrator for Azure 就可以将数据迁移到 Azure 存储。

在开始使用 LiveData Migrator for Azure 之前,请查看这些先决条件。

若要执行迁移,请执行以下操作:

在 Azure CLI 中:

- 通过运行

az provider register --namespace Wandisco.Fusion --consent-to-permissions在 Azure CLI 中注册 WANdisco 资源提供程序。 - 通过运行

az vm image terms accept --offer ldma --plan metered-v1 --publisher Wandisco --subscription <subscriptionID>接受 LiveData Platform 的按流量计费条款。

- 通过运行

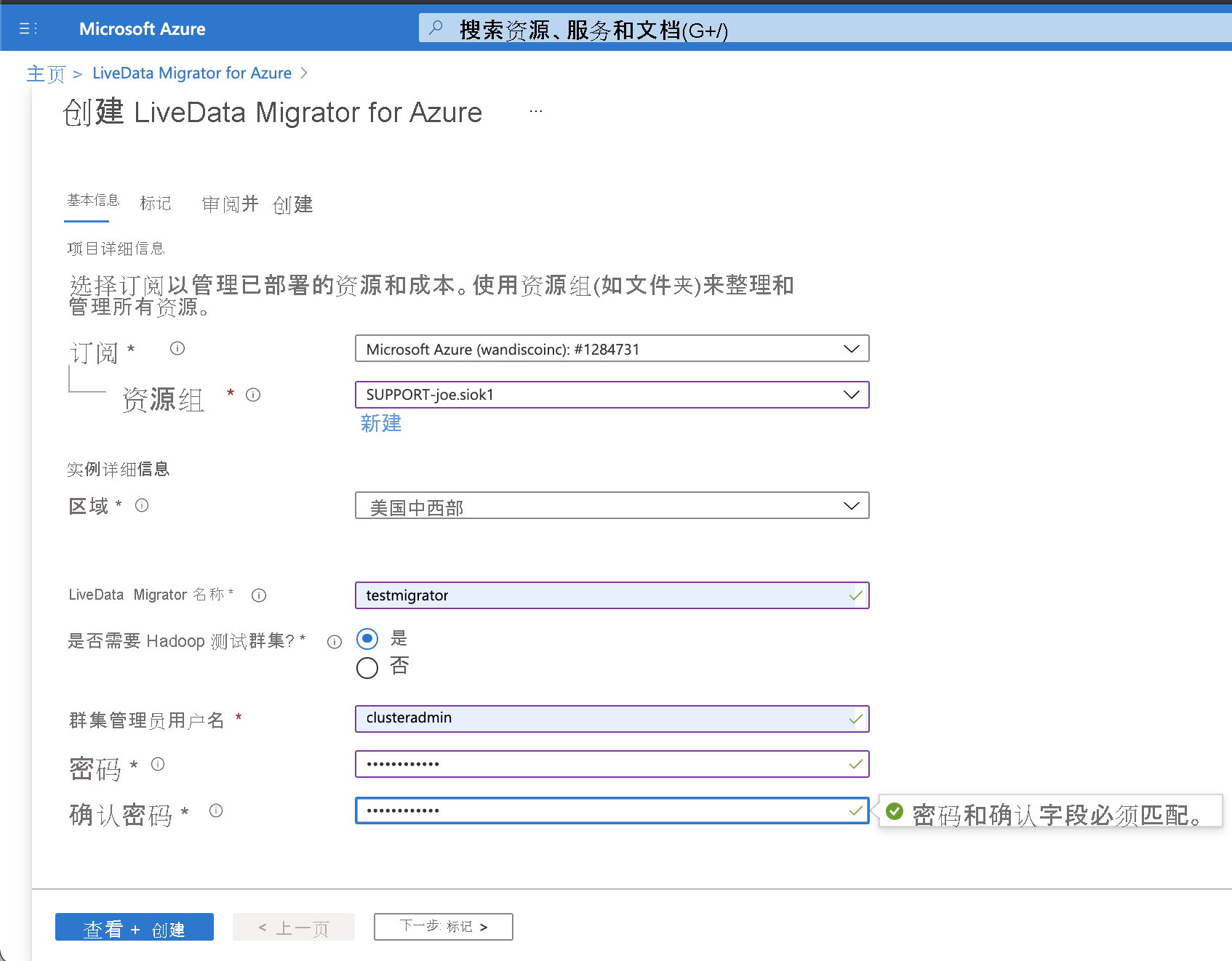

将 LiveData Migrator 实例从 Azure 门户部署到本地 Hadoop 群集。 (无需更改或重启群集。)

注意

WANdisco LiveData Migrator for Azure 提供了创建 Hadoop 测试群集的选项。

配置 Kerberos 详细信息(如果适用)。

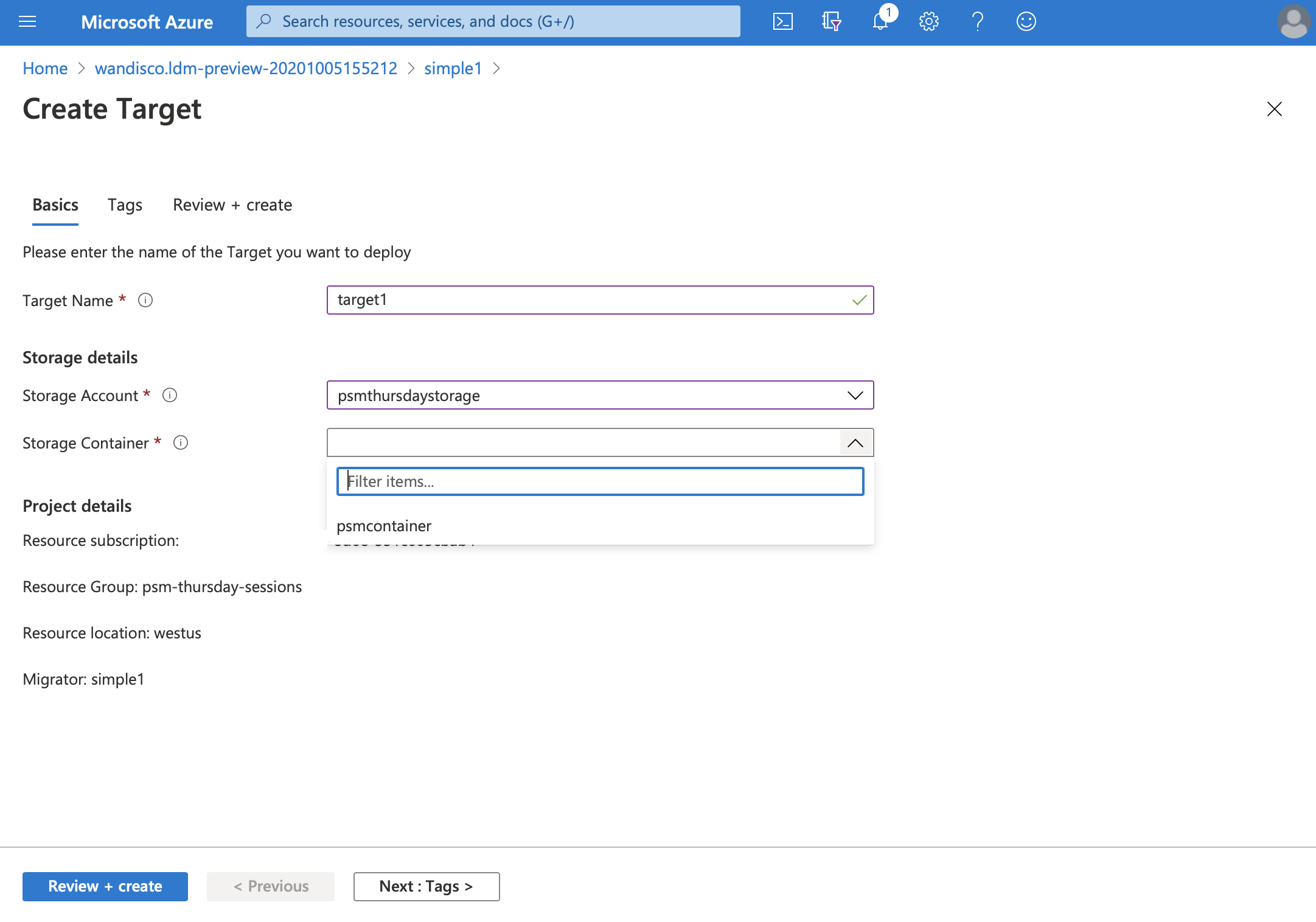

定义启用了 Azure Data Lake Storage 的目标存储帐户。

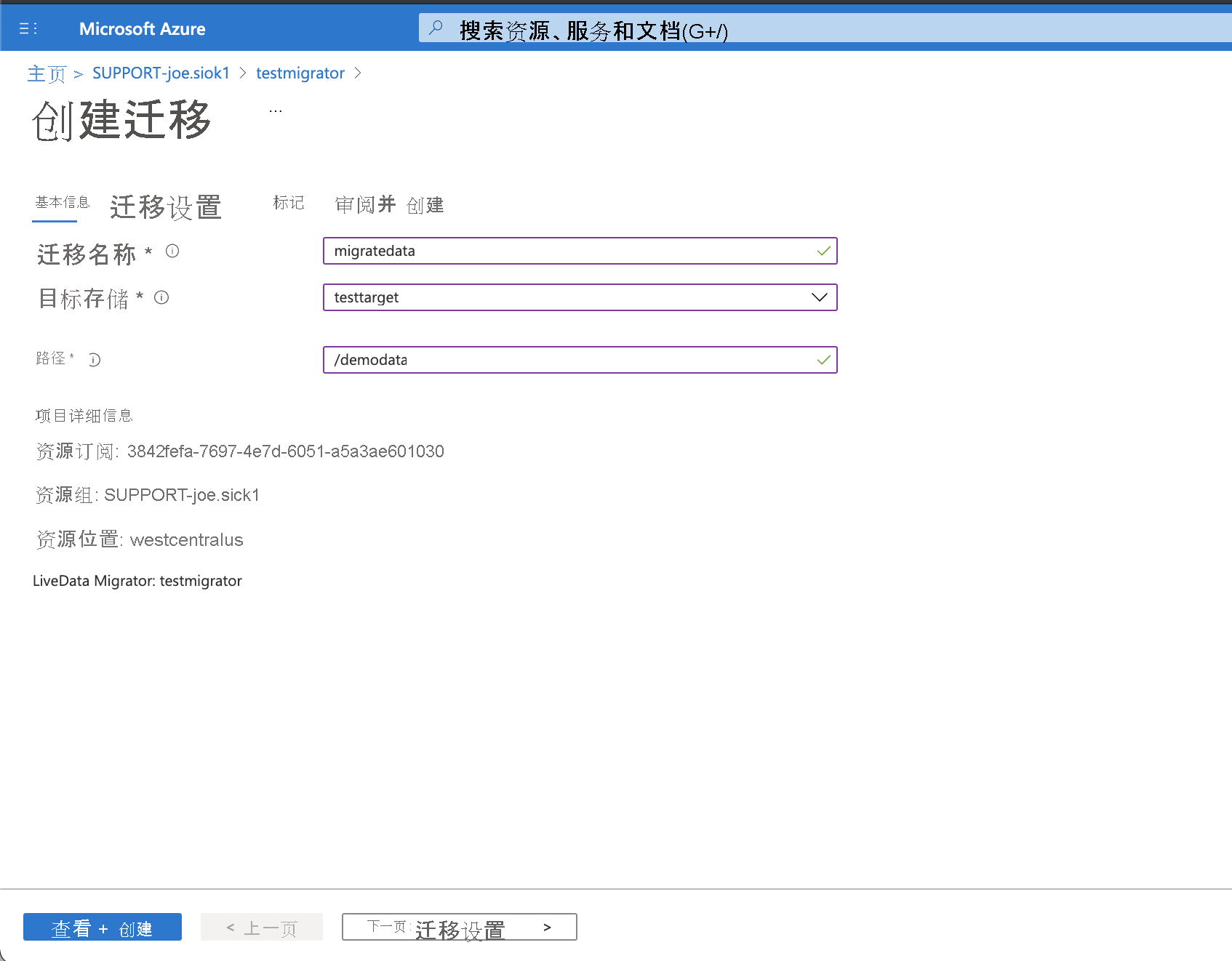

定义要迁移的数据的位置,例如:

/user/hive/warehouse。

开始迁移。

通过标准 Azure 工具(包括 Azure CLI 和 Azure 门户)监视迁移进度。

使用 LiveData Plane for Azure 双向复制活动更改下的数据

LiveData Platform 中包含的第二项服务是 LiveData Plane for Azure。 LiveData Plane 使用 WANdisco 的协调引擎,通过智能地对所有系统上的数据应用更改,以在许多本地 Hadoop 群集和 Azure 存储之间保持数据一致,从而消除在不同使用点发生数据冲突的风险。

初始迁移后,使数据与 LiveData Plane for Azure 保持一致:

从 Azure 门户开始,在本地和 Azure 中部署 LiveData Plane for Azure。 无需更改应用程序。

配置涵盖要保持一致的数据位置的复制规则,例如:

/user/contoso/sales/region/WA。根据需要运行访问和修改任一位置的数据的应用程序。

LiveData Plane for Azure 在所有环境中一致地复制数据更改,而不会对群集操作或应用程序性能产生重大影响。

体验版或试用版

在 LiveData Platform for Azure 的“市场”页面,有两个选项可供选择:

“立即获取”按钮会在订阅中启用该服务。 可以在那里使用自己的 Hadoop 群集或 WANdisco 的试用群集。

选择“体验版”,在为你预配置和托管的环境中测试 LiveData Migrator for Azure。 这使你可以在将 LiveData Migrator for Azure 添加到订阅之前先试用它,而不会对数据产生任何成本或风险。