Microsoft Fabric 環境是所有硬體和軟體設定的合併專案。 在環境中,您可以選取不同的 Spark 執行階段、設定運算資源、從公用存放庫或本機目錄安裝程式庫,以及設定其他設定。

本文概述如何建立、設定和使用環境。

建立環境

您可以從多個進入點建立新環境:

標準入口點:

在選擇時建立:

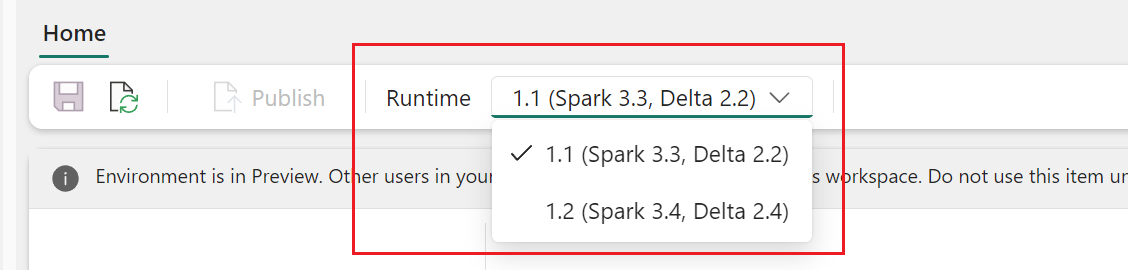

建立環境之後,請選取執行階段版本。 從下拉式功能表中選擇 Runtime 1.3 (Spark 3.5、Delta 3.2)。

設定環境

環境有三個主要元件:

- Spark 計算,其中包含 Spark 執行階段。

- 圖書館。

- 資源。

需要 Spark 計算和程式庫組態,發佈才會生效。 資源是可以即時變更的共用儲存體。 如需詳細資訊,請參閱 儲存和發佈變更。

設定 Spark 運算

對於環境,您可以從各種 Spark 執行階段 中進行選擇,其中包含自己的預設設定和預先安裝的套件。 若要檢視可用的執行階段,請移至環境的 [首頁] 索引標籤,然後選取 [執行階段]。 選取最符合您需求的執行階段。

重要

- 如果您要使用現有組態或程式庫更新環境的執行階段,則必須根據更新的執行階段版本重新發佈內容。

- 如果現有的組態或程式庫與新更新的執行階段版本不相容,則發佈會失敗。 您必須移除不相容的組態或程式庫,然後再次發佈環境。

Fabric Spark 計算 提供在 Spark 上運行的無與倫比的速度和效率,以及需求量身打造的體驗。 在您的環境中,您可以從工作區管理員和容量管理員所建立的各種集區中選擇。 您可以進一步調整設定及管理 Spark 屬性,以在 Spark 工作階段中生效。 如需詳細資訊,請參閱 < Fabric 環境中的 Spark 計算組態設定>。

管理程式庫

每個 Spark 執行階段都提供內建程式庫。 使用 Fabric 環境,您也可以從公用來源安裝程式庫,或上傳您或您的組織建置的自訂程式庫。 成功安裝程式庫之後,它們就會在您的 Spark 工作階段中使用。 如需詳細資訊,請參閱<Fabric 環境中的程式庫管理>。 如需在 Fabric 中管理程式庫的最佳做法,請參閱 在 Fabric 中管理 Apache Spark 程式庫。

使用資源

環境中的 資源 區段有助於在開發階段管理小型資源。 上傳至環境的檔案在附加時可跨筆記本存取。 如需詳細資訊,請參閱 管理 Fabric 環境中的資源。

儲存並發佈變更。

在 「首頁 」標籤上,您可以輕鬆找到 「儲存 並 發布」。 當 [程式庫 ] 和 [Spark 計算 ] 區段中有未儲存或未發佈的擱置變更時,就會啟用它們。

重要

- 如果已啟用 Private Link,工作區中的第一個 Spark 作業必須觸發 VNet 佈建,這可能需要大約 10-15 分鐘的時間。 由於環境發佈也會以 Spark 作業的形式執行,因此如果它恰好是在啟用 Private Link 之後執行的第一個 Spark 作業,則可能會遇到額外的延遲。

當擱置中的變更位於 [程式庫 ] 和 [Spark 運算 ] 區段中時,您也會看到橫幅,提示您 [儲存 並 發佈]。 功能與按鈕相同:

- 如果您重新整理或讓瀏覽器保持開啟,則未儲存的變更會遺失。 選取 [儲存] 以確定在您離開之前記錄您的變更。 儲存不會套用組態,但會快取系統中的變更。

- 若要將變更套用至 [程式庫] 和 Spark 計算,請選取 [發佈]。 「 擱置變更 」頁面隨即顯示,以便在發佈前進行最終檢閱。 接下來,選取 [全部發佈] 以在 Fabric 環境中起始設定。 此處理程序可能需要一些時間,特別是當涉及程式庫變更時。

- 若要取消發佈程序,請選取橫幅中的檢視 進度 ,然後取消作業。

- 發佈完成時會出現通知。 如果在流程期間發生任何問題,就會出現錯誤通知。

環境一次只接受一個 Publish 動作。 您無法在進行中的發佈動作期間變更 [程式庫] 或 [Spark 計算] 區段。

發佈不會影響新增、刪除或編輯 [資源] 區段中的檔案和資料夾。 管理資源的動作是即時的。 「 發佈」 動作不會封鎖 「資源」 區段中的變更。

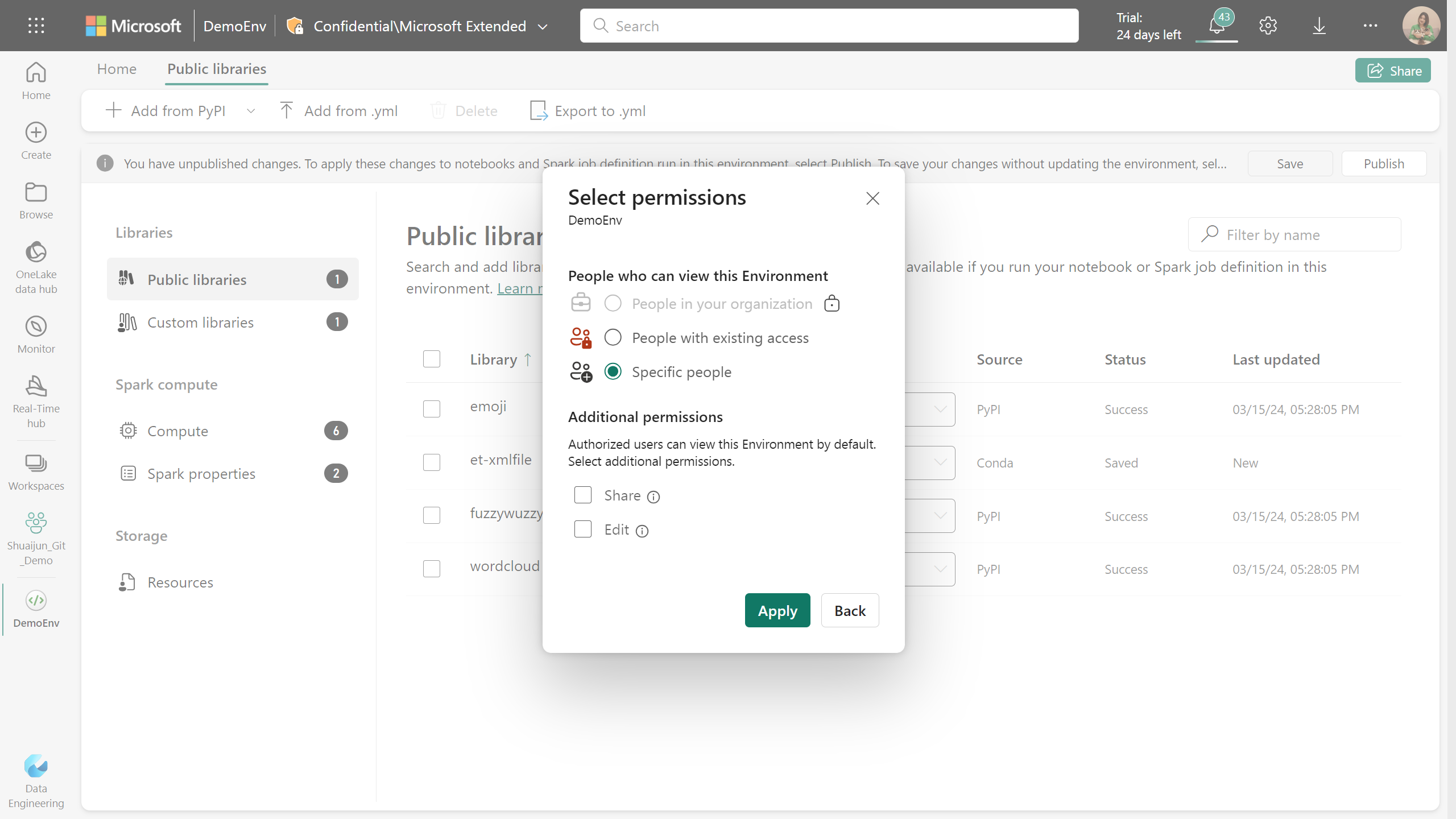

共用現有的環境

Fabric 支援共用具有不同層級權限的專案。

當您共用環境項目時,收件者會自動收到讀取權限。 有了此權限,他們可以探索環境的組態,並將其附加至筆記本或 Spark 作業。 為了順利執行程式碼,請務必在共用筆記本和 Spark 任務定義時授與附加環境的讀取權限。

您也可以使用共用和編輯權限共用環境。 具有共用權限的使用者可以繼續與其他人共用環境。 同時,具有編輯許可權的收件者可以更新環境的內容。

附加環境

您可以將 Fabric 環境附加至 資料工程/科學 工作區或筆記本和 Spark 作業定義。

將環境附加為工作區預設值

重要

選取環境作為工作區預設值之後,只有工作區管理員可以更新預設環境的內容。

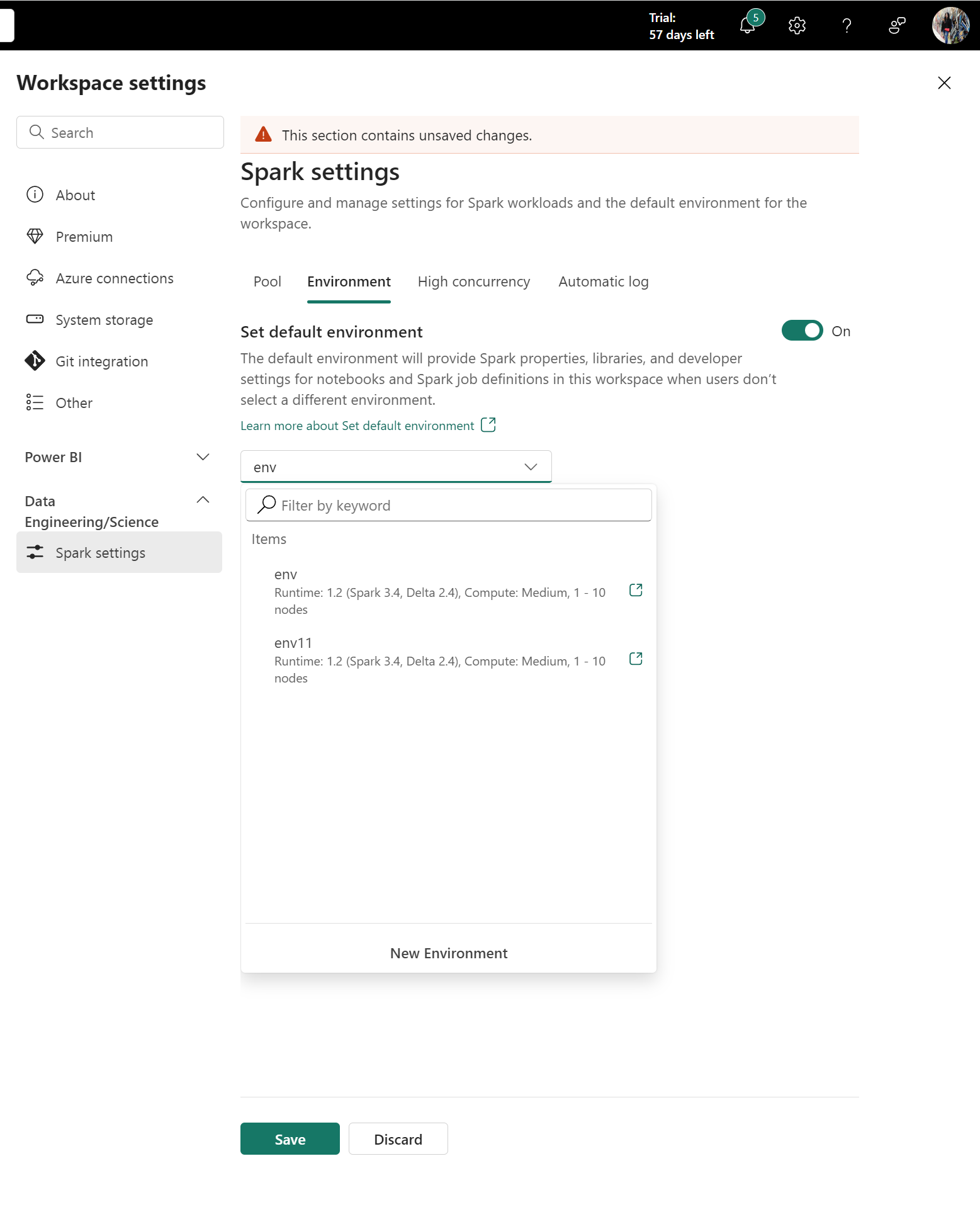

選取 [工作區設定>] [資料工程/科學>Spark 設定 ] 以查看 [環境] 索引標籤。

工作區管理員可以定義整個工作區的預設工作負載。 此處設定的值適用於附加至 工作區設定的筆記本和 Spark 作業定義。

[設定預設環境] 切換可以增強使用者體驗。 根據預設,這項切換設定為 [關閉]。 如果不需要預設的 Spark 屬性或程式庫作為工作區預設值,您可以在此情況下定義 Spark 執行階段。 如果您想要為工作區準備預設的 Spark 計算和程式庫,您可以將切換為 [ 開啟 ],並輕鬆地將環境附加為工作區預設值。 此選項可讓環境中的所有組態都有效作為 [工作區設定] 運作。

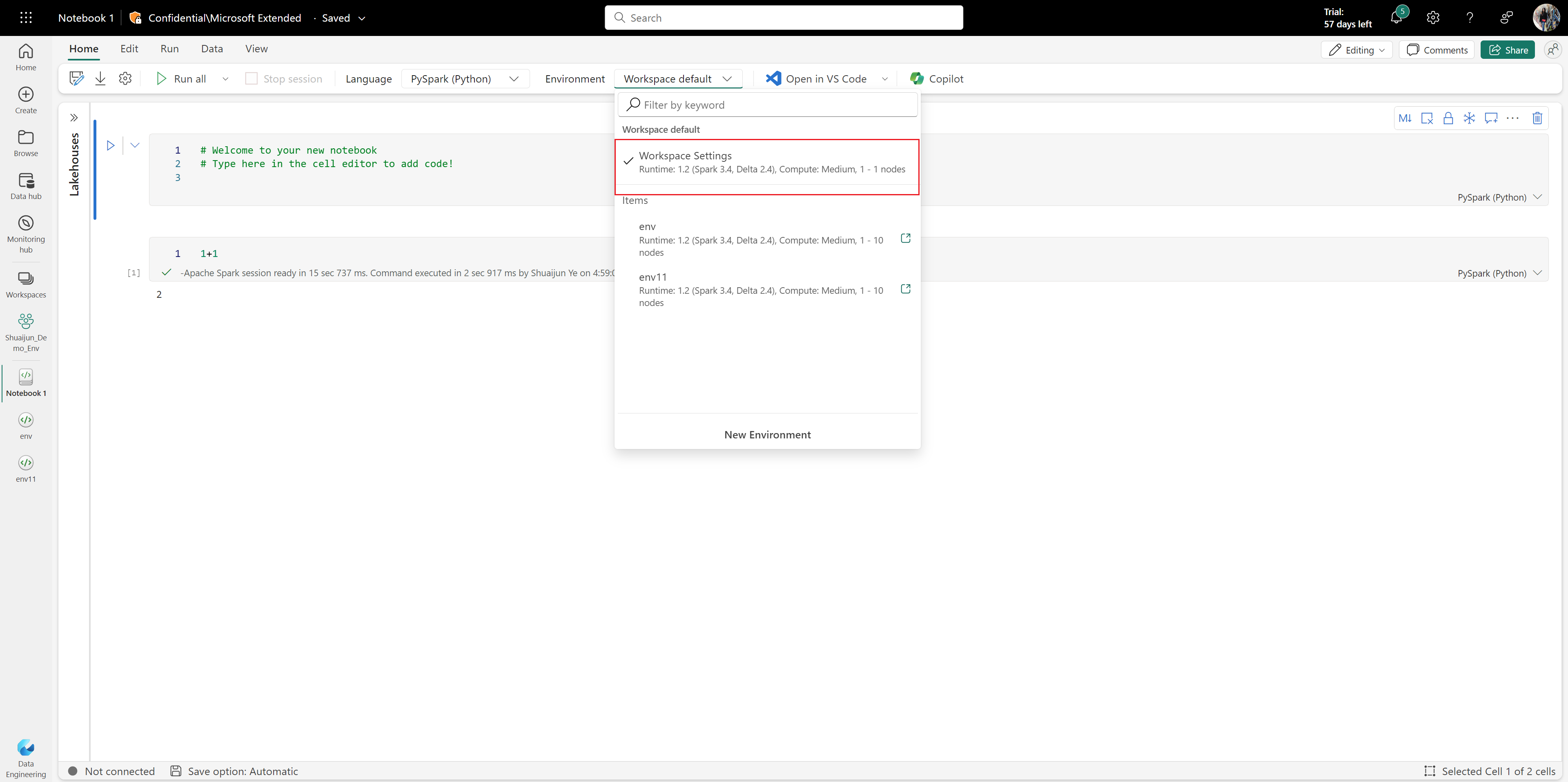

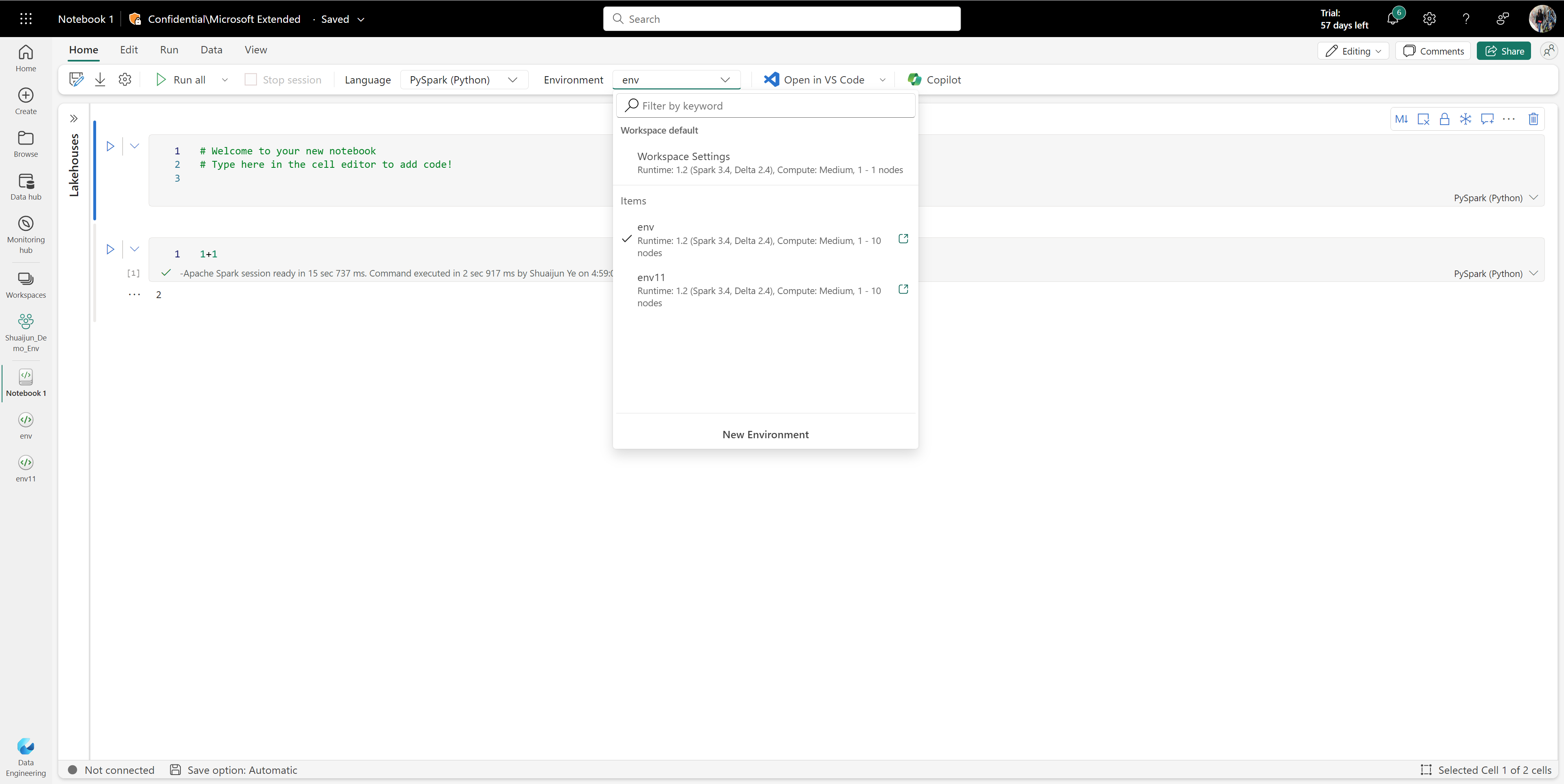

將環境連結至筆記本或 Spark 工作定義

環境可在 [筆記本 ] 和 [Spark 作業定義 ] 索引標籤上使用。 當筆記本和 Spark 任務定義連結至環境時,它們可以存取其程式庫、運算組態和資源。 「總管」會列出與您共用、來自目前工作區以及來自您有權存取的其他工作區的所有可用環境。

如果您在作用中工作階段期間切換至不同的環境,則新選取的環境要到下一個工作階段才會生效。

當您從另一個工作區連接環境時,兩個工作區必須具有 相同的容量和網路安全性設定。 雖然您可以從具有不同容量或網路安全性設定的工作區中選取環境,但工作階段無法啟動。

從另一個工作區連結環境時,系統會忽略該環境中的計算組態。 相反地,集區和計算組態預設為目前工作區的設定。

刪除環境

你可以在不再需要這個環境時刪除它。 在刪除環境之前,請考慮以下事項:

重要

- 刪除環境是永久性的,無法逆轉。

- 目前附加在環境中的任何筆記本或 Spark 工作定義,都需要重新設定以使用不同的環境或工作區設定。

- 如果環境被設定為工作區預設值,你必須先更改工作區預設設定後才能刪除。

使用 REST API 刪除環境

你可以使用 Fabric REST API 程式化刪除環境:

端點:DELETE https://api.fabric.microsoft.com/v1/workspaces/{workspaceId}/environments/{environmentId}

所需權限: Environment.ReadWrite.All 或 Item.ReadWrite.All

欲了解更多關於 REST API 的資訊,請參見 刪除環境。

![螢幕擷取畫面,顯示選取 [儲存並發佈] 的位置。](media/environment-introduction/env-save-and-publish.png)

![顯示 [工作區設定] [設定預設環境] 窗格的螢幕擷取畫面。](media/environment-introduction/env-workspace-setting-default.png)