OneLake 是適用於整個組織的單一、統一、邏輯資料湖。 如同 OneDrive,OneLake 會自動提供給每個 Microsoft Fabric 租戶,並設計成所有分析資料的唯一位置。

OneLake 為客戶提供:

- 整個組織的單一資料湖

- 唯一複本資料,用於多個分析引擎

整個組織的一個資料湖

在 OneLake 之前,許多組織為不同業務團隊建立了多個湖泊,導致管理多元資源時產生額外負擔。 OneLake 透過改善協作來消除這些挑戰:

- 每個 Fabric 租戶都會自動獲得一個 OneLake

- 你無法建立多個 OneLake,也無法刪除你的 OneLake

- 沒有額外資源需要配置或管理

這種簡單性幫助你的組織在單一且統一的資料湖上協作。

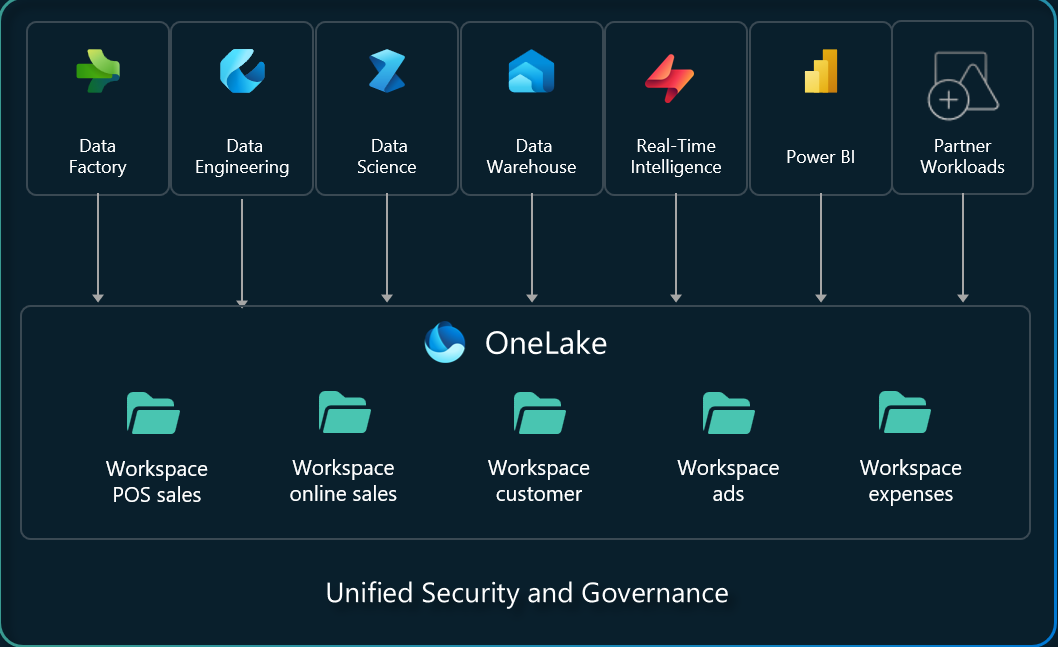

根據預設管理,分散式所有權有助於協作

Fabric 資料的最高層次組織及治理單位是租戶。 任何進入 OneLake 的資料都會自動受到租戶層級的安全性、合規性及資料管理政策保護。

在租戶內部,協作發生在 工作空間內。 你可以建立任意數量的工作區來組織資料。 工作區可使組織的不同部分能夠散發所有權與存取原則。 每個工作區都是綁定在特定區域並分別計費的容量中的一部分。

在工作區中,你可以透過 資料項目建立並存取所有資料。 類似於 Office 將 Word、Excel 和 PowerPoint 檔案儲存在 OneDrive 的方式,Fabric 會將 lakehouses、倉儲和其他項目儲存在 OneLake。 每種物品類型都能為不同角色提供量身打造的體驗,例如湖邊小屋中的 Apache Spark 開發者體驗。

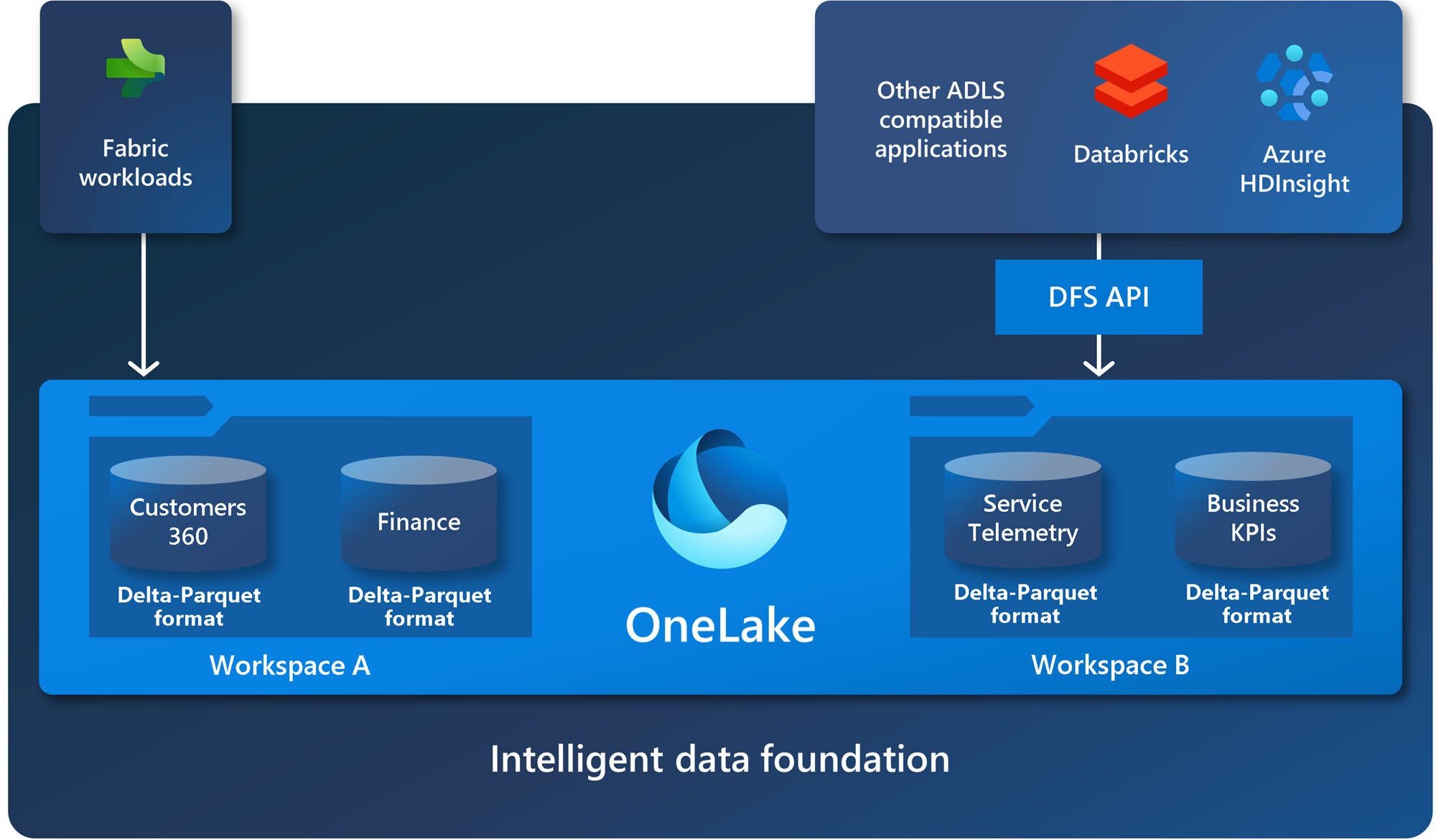

建立在開放標準與格式之上

OneLake 組建在 Azure Data Lake Storage (ADLS) Gen2 之上,可支援任何類型的檔案、結構化或非結構化檔案。 所有 Fabric 資料項目,例如資料倉儲和湖倉儲,會以 Delta Parquet 格式自動將資料儲存在 OneLake。 如果資料工程師使用 Apache Spark 將資料載入資料湖倉庫,而 SQL 開發人員接著使用 T-SQL 將資料載入具有完全交易功能的資料倉儲,那麼他們兩者都在為同一個資料湖做出貢獻。 OneLake 會以 Delta Parquet 格式儲存所有結構化資料。

OneLake 支援相同的 ADLS Gen2 API 與 SDK,以便與現有 ADLS Gen2 應用程式相容,包括 Azure Databricks。 您可以在 OneLake 中處理資料,就好像它是整個組織的一個大型 ADLS 儲存體帳戶一樣。 每個工作區都會顯示為那個儲存帳戶內的容器,而不同的資料項目會顯示為這些容器中的資料夾。

如需 API 與端點的詳細資訊,請參閱 OneLake 存取與 APIs。 如需 OneLake 與 Azure 整合的範例,請參閱 Azure Synapse Analytics、 Azure 儲存體總管、 Azure Databricks與 Azure HDInsight 文章。

適用 Windows 的 OneLake 檔案總管

你可以使用 Windows 的 OneLake 檔案總管 來探索 Windows 的 OneLake 資料。 您可以瀏覽所有工作區與資料項目,輕鬆地上傳、下載或修改檔案,就像您在 Office 中所做的一樣。 OneLake 檔案瀏覽器可簡化資料湖的操作,甚至允許非技術商務使用者使用它們。

如需相關資訊,請參閱 OpenLake 檔案總管。

一份資料複本

OneLake 旨在從單一資料副本中獲得最大價值,避免資料移動或重複。 不需要複製資料來與其他引擎一起使用或分析多個來源的資料。

捷徑會跨網域連結資料,而不需要移動資料

捷徑是指引用儲存在其他檔案位置的資料。 這些檔案位置可以在同一工作區內,也可以跨越不同的工作區,無論是在 OneLake 內部,還是像 ADLS、S3 或 Dataverse 等 OneLake 外部。 不論位置為何,捷徑的方式會讓檔案與資料夾看起來就像儲存在本機一樣。

捷徑讓你的組織能在使用者與應用程式間共享資料,而無需不必要地移動或重複資訊。 當小組在不同的工作區中獨立工作時,捷徑的方式可讓您將不同商務群組與網域的資料合併成虛擬資料產品,以符合使用者的特定需求。

如需有關如何使用捷徑的詳細資訊,請參閱 OneLake 捷徑。

將資料連接到多個分析引擎

資料通常針對單一引擎進行優化,這使得同一資料難以重複用於多個應用。 使用 Fabric 時,不同的分析引擎(T-SQL、Apache Spark、Analysis Services 等)會以開放的 Delta Parquet 格式儲存資料,讓你能在多個引擎間使用相同的資料。

你不需要複製資料才能用到其他引擎,或因為資料存放在某個引擎而覺得被綁住。 舉例來說,想像一組 SQL 工程師在建構一個完全交易式的資料倉儲。 他們可以使用 T-SQL 引擎與 T-SQL 的所有功能來建立資料表、轉換資料,以及將資料載入資料表。 如果資料科學家想利用這些資料,他們不需要經過特殊的 Spark/SQL 驅動程式。 OneLake 會以 Delta Parquet 格式儲存所有資料。 資料科學家可以直接在資料上使用 Spark 引擎及其開源函式庫的全部功能。

商業用戶可直接在 OneLake 上方建立 Power BI 報告,使用分析服務引擎中的 Direct Lake 模式。 Analysis Services 引擎驅動 Power BI 語意模型,並且一直提供兩種資料存取模式:匯入與直接查詢。 第三種模式「直接湖」模式,讓使用者無需複製資料即可快速匯入,結合匯入與直接查詢的優點。 如需詳細資訊,請參閱 Direct Lake。

後續步驟

準備好開始使用 OneLake 了嗎? 這裡說明如何開始使用: