在事件串流中新增和管理事件來源

建立事件串流之後,您可以將它連線到各種數據源和目的地。

注意

如果您想要使用處於預覽狀態的增強功能,請選取 頂端的 [增強功能 ]。 否則,請選取 [標準功能]。 如需預覽中增強功能的相關信息,請參閱 Fabric 事件串流簡介。

建立事件串流之後,您可以將它連線到各種數據源和目的地。

Eventstream 不僅可讓您串流來自Microsoft來源的數據,也支援使用新的傳訊連接器從Google Cloud和 Amazon Kinesis 等第三方平臺擷取數據。 這項擴充功能可讓您順暢地將外部資料流整合到 Fabric 中,提供更大的彈性,並讓您從多個來源取得即時見解。

在本文中,您將瞭解可新增至具有預覽功能增強的事件資料流的事件來源。

重要

Fabric 事件資料流的增強功能目前為預覽狀態。

必要條件

- 具有參與者或更高許可權之工作區的網狀架構進階工作區存取權。

- 下列來源特定文章中記載之每個來源的特定必要條件。

支援來源

具有增強功能的網狀架構事件資料流支援下列來源。 每篇文章都提供新增特定來源的詳細數據和指示。

| 來源 | 描述 |

|---|---|

| Azure 事件中樞 | 如果您有 Azure 事件中樞,您可以使用 Eventstream 將事件中樞資料擷取至 Microsoft Fabric。 |

| Azure IoT 中樞 | 如果您有 Azure IoT 中樞,您可以使用 Eventstream 將 IoT 資料擷取至 Microsoft Fabric。 |

| Azure SQL 資料庫異動資料擷取 (CDC) | Azure SQL 資料庫 CDC 來源連接器可讓您擷取 Azure SQL 資料庫中目前資料的快照集。 接著,連接器會監視並記錄此資料的任何未來資料列層級變更。 |

| PostgreSQL 資料庫 CDC | Postgre SQL 資料庫 異動資料擷取 (CDC) 來源連接器可讓您擷取 PostgreSQL 資料庫中目前資料的快照集。 接著,連接器會監視並記錄此資料的任何未來資料列層級變更。 |

| MySQL 資料庫 CDC | Azure My SQL 資料庫 異動資料擷取 (CDC) 來源連接器可讓您擷取 適用於 MySQL 的 Azure 資料庫 資料庫中目前資料的快照集。 您可以指定要監視的資料表,而 eventstream 會記錄資料表的任何未來資料列層級變更。 |

| Azure Cosmos DB CDC | Microsoft Fabric 事件串流的 Azure Cosmos DB 異動資料擷取 (CDC) 來源連接器,讓您擷取 Azure Cosmos DB 資料庫中目前資料的快照集。 接著,連接器會監視並記錄此資料的任何未來資料列層級變更。 |

| VM DB 上的 SQL Server (CDC) | 適用於 Fabric 事件數據流的 VM DB 上的 SQL Server (CDC) 來源連接器可讓您擷取 VM 上 SQL Server 資料庫中目前數據的快照集。 連接器接著會監視並記錄數據的任何未來數據列層級變更。 |

| Azure SQL 受控執行個體 CDC | Microsoft Fabric 事件數據流 Azure SQL 受控執行個體 CDC 來源連接器可讓您取 SQL 受管理執行個體 資料庫中目前數據的快照集。 接著,連接器會監視並記錄此資料的任何未來資料列層級變更。 |

| Google Cloud Pub/Sub | Google Pub/Sub 是一項傳訊服務,可讓您發佈和訂閱事件的串流。 您可以將 Google Pub/Sub 新增為 Eventstream 的來源,以擷取、轉換和路由即時事件至 Fabric 中的不同目的地。 |

| Amazon Kinesis 資料流 | Amazon Kinesis 資料流是可大幅調整、高度持久性的資料擷取,以及針對串流資料優化的處理服務。 藉由整合 Amazon Kinesis 資料流為 Eventstream 內的來源,您就可以順暢地處理即時資料流,再將它們路由至 Fabric 內的多個目的地。 |

| Confluent Cloud Kafka | Confluent Cloud Kafka 是一個串流平台,使用 Apache Kafka 提供功能強大的資料流和處理功能。 藉由整合 Confluent Cloud Kafka 為 Eventstream 中的來源,您就可以順暢地處理即時資料流,再將它們路由至 Fabric 內的多個目的地。 |

| Apache Kafka | Apache Kafka 是開放原始碼分散式平臺,可用於建置可調整的即時數據系統。 藉由將 Apache Kafka 整合到事件數據流中作為來源,您就可以順暢地從 Apache Kafka 引進即時事件,並在路由傳送至 Fabric 內的多個目的地之前加以處理。 |

| Amazon MSK Kafka | Amazon MSK Kafka 是完全受控的 Kafka 服務,可簡化設定、調整和管理。 藉由將 Amazon MSK Kafka 整合到事件串流中作為來源,您可以順暢地將 MSK Kafka 中的即時事件帶入,並加以處理,再將它們路由傳送至 Fabric 內的多個目的地。 |

| Blob 儲存體事件 | 當用戶端建立、取代或刪除 Blob 時,就會觸發 Azure Blob 儲存體事件。 連接器可讓您連結 Blob 儲存體事件至即時中樞中的 Fabric 事件。 您可以將這些事件轉換成連續資料流,並轉換資料流再將事件路由至 Fabric 中的不同目的地。 |

| Fabric 工作區項目事件 | Fabric 工作區項目事件是 Fabric 工作區進行變更時發生的離散 Fabric 事件。 這些變更包括建立、更新或刪除 Fabric 項目。 使用 Fabric 事件串流時,您可以擷取及轉換這些 Fabric 工作區事件,並將其路由至 Fabric 中的不同目的地,以執行進一步分析。 |

| 範例資料 | 您可以選擇自行車、黃色計程車或股票市場事件作為範例資料來源,藉此在設定 Eventstream 時測試資料擷取。 |

| 自訂端點 (亦即標準功能的自訂應用程式) | 自定義端點功能可讓應用程式或 Kafka 用戶端使用 連接字串 連線到 Eventstream,讓串流數據順利擷取到 Eventstream。 |

注意

一個事件資料流的來源和目的地數目上限為 11。

相關內容

必要條件

開始之前,您必須完成下列先決條件:

- 取得具有事件串流所在之參與者或更高許可權的進階工作區的存取權。

- 若要將 Azure 事件中樞 或 Azure IoT 中樞 新增為 eventstream 來源,您需要有適當的許可權才能存取其原則密鑰。 它們必須可公開存取,且不得位於防火牆後方或在虛擬網路中受到保護。

支援來源

Fabric 事件資料流支援下列來源。 使用資料表中的連結來巡覽至文章,以提供有關新增特定來源的詳細數據。

| 來源 | 描述 |

|---|---|

| Azure 事件中樞 | 如果您有 Azure 事件中樞,您可以使用 Eventstream 將事件中樞資料擷取至 Microsoft Fabric。 |

| Azure IoT 中樞 | 如果您有 Azure IoT 中樞,您可以使用 Eventstream 將 IoT 資料擷取至 Microsoft Fabric。 |

| 範例資料 | 您可以選擇自行車、黃色計程車或股票市場事件作為範例資料來源,藉此在設定 Eventstream 時測試資料擷取。 |

| 自訂應用程式 | 自定義應用程式功能可讓您的應用程式或 Kafka 用戶端使用 連接字串 連線到 Eventstream,讓串流數據順利擷取到 Eventstream。 |

注意

一個事件資料流的來源和目的地數目上限為 11。

管理來源

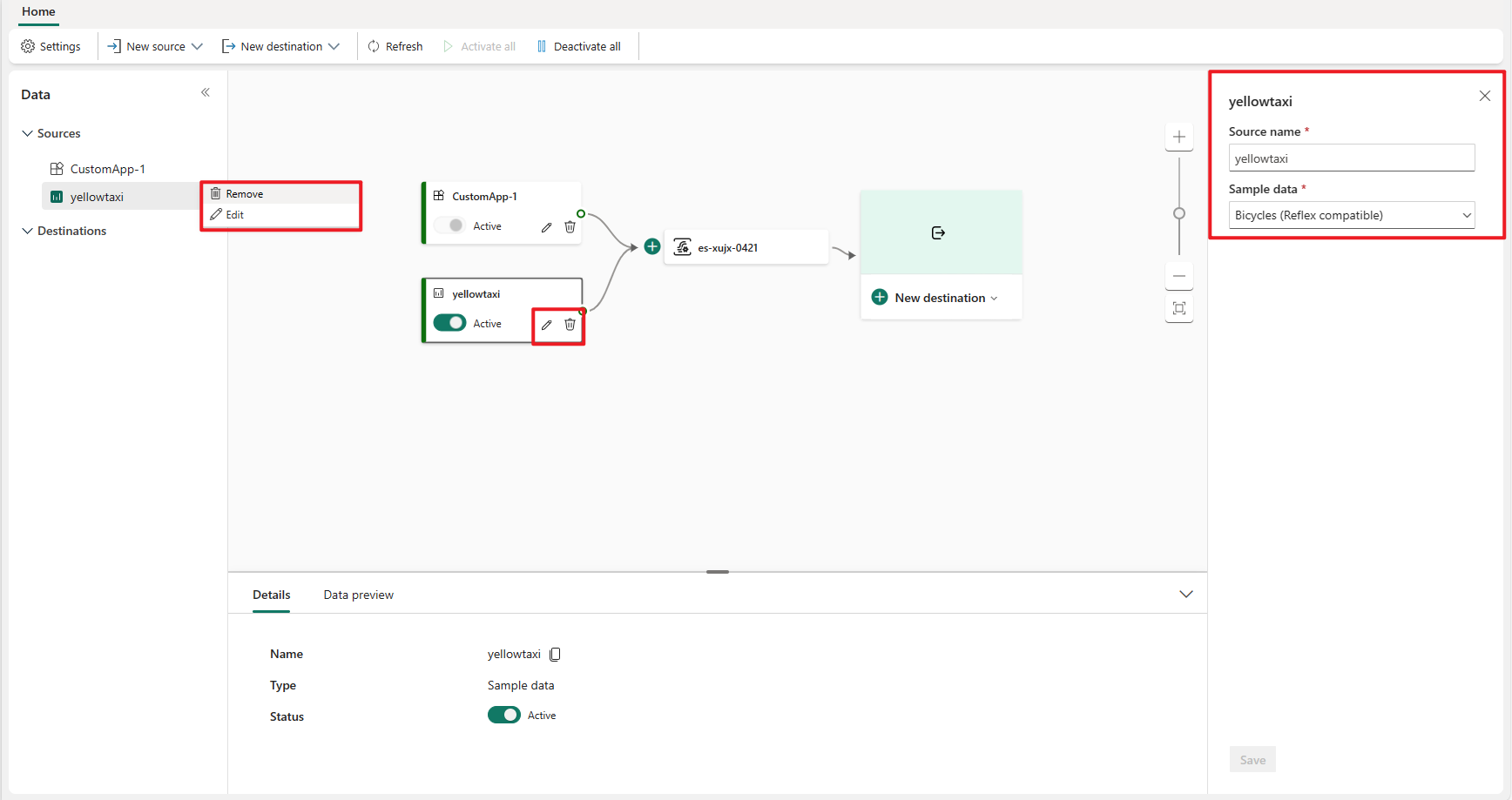

編輯/移除:您可以選取事件資料流來源,以透過瀏覽窗格或畫布編輯或移除。 當您選取 [ 編輯] 時,編輯窗格會在主編輯器的右側開啟。

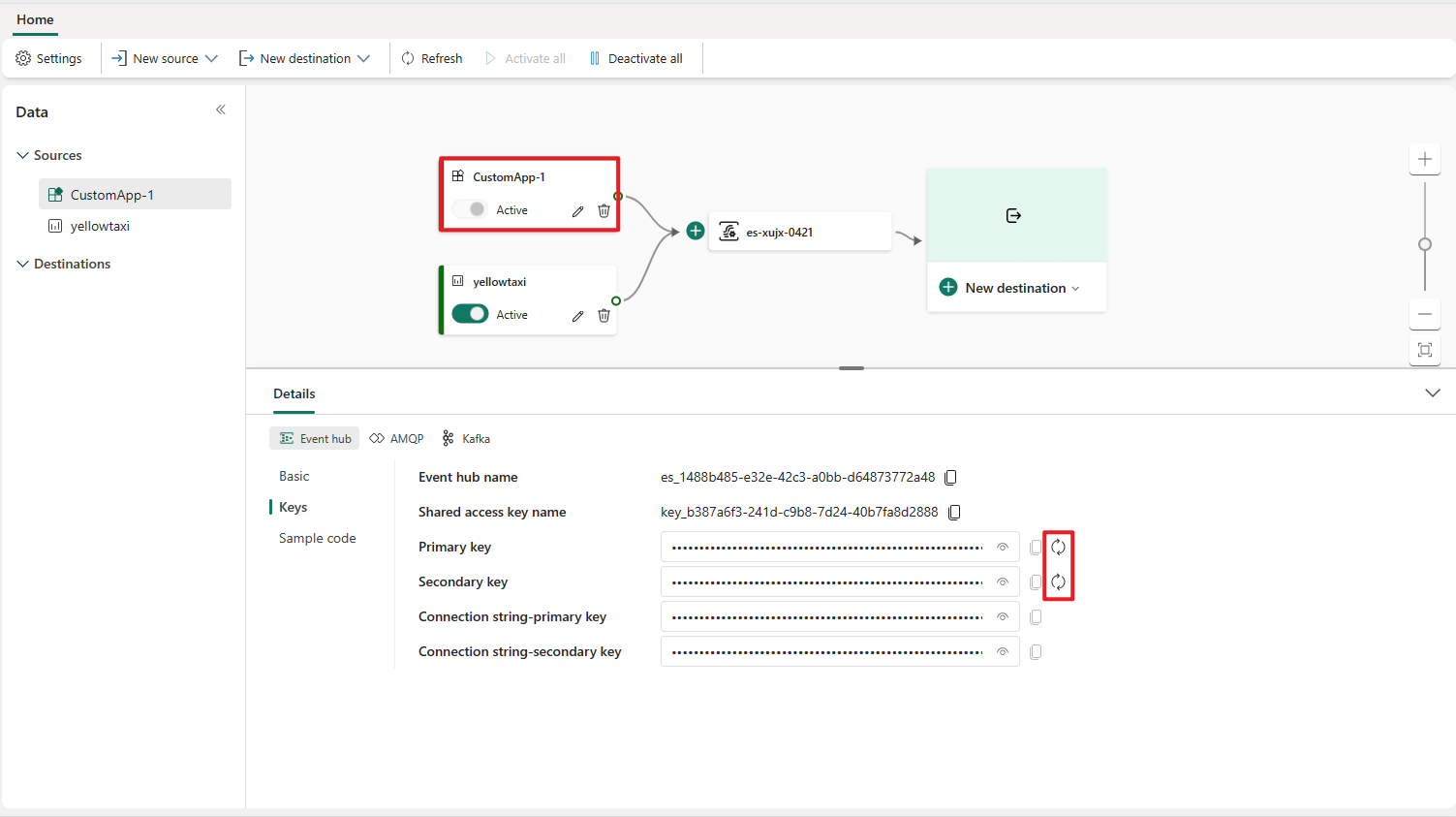

重新產生自定義應用程式的金鑰:如果您想要重新產生應用程式的新連線密鑰,請在畫布上選取其中一個自定義應用程式來源,然後選取 [ 重新 產生] 以取得新的連線金鑰。