Administración de Azure Data Lake Analytics mediante Azure Portal

Importante

Ya no se pueden crear nuevas cuentas de Azure Data Lake Analytics a menos que se haya habilitado la suscripción. Si necesita que se habilite la suscripción, póngase en contacto con el soporte técnico y proporcione su escenario empresarial.

Si ya usa Azure Data Lake Analytics, deberá crear un plan de migración de Azure Synapse Analytics para la organización antes del 29 de febrero de 2024.

En este artículo se describe cómo administrar cuentas, orígenes de datos, usuarios y trabajos de Azure Data Lake Analytics mediante Azure Portal.

Administración de cuentas de Data Lake Analytics

Crear una cuenta

- Inicie sesión en Azure Portal.

- Seleccione Crear un recurso y busque Data Lake Analytics.

- Seleccione los valores de los siguientes elementos:

- Name: nombre de la cuenta de Data Lake Analytics.

- Suscripción: suscripción de Azure usada para la cuenta.

- Grupo de recursos: grupo de recursos de Azure en el que se crea la cuenta.

- Ubicación: centro de datos de Azure para la cuenta de Data Lake Analytics.

- Data Lake Store: almacén predeterminado que se va a usar para la cuenta de Data Lake Analytics. Las cuentas de Azure Data Lake Store y de Data Lake Analytics deben estar en la misma ubicación.

- Seleccione Crear.

Eliminar una cuenta de Data Lake Analytics

Para eliminar una cuenta de Data Lake Analytics, elimine la cuenta de Data Lake Store predeterminada.

- En Azure Portal, vaya a la cuenta de Data Lake Analytics.

- Seleccione Eliminar.

- Escriba el nombre de la cuenta.

- Seleccione Eliminar.

Administración de orígenes de datos

Data Lake Analytics admite los siguientes orígenes de datos:

- Data Lake Store

- Azure Storage

Puede usar el explorador de datos para examinar los orígenes de datos y realizar operaciones básicas de administración de archivos.

Agregar un origen de datos

En Azure Portal, vaya a la cuenta de Data Lake Analytics.

Seleccione Data Explorer.

Seleccione Add Data Source.

- Para agregar una cuenta de Data Lake Store, necesita el nombre de la cuenta y acceso a ella para poder realizar consultas.

- Para agregar Azure Blob Storage, necesita la cuenta y la clave de almacenamiento. Para encontrarlos, vaya a la cuenta de almacenamiento en el portal y seleccione Claves de acceso.

Configurar reglas de firewall

Puede usar Data Lake Analytics para bloquear aún más el acceso a la cuenta de Data Lake Analytics en el nivel de red. Puede habilitar un firewall, especificar una dirección IP o definir un intervalo de direcciones IP para los clientes de confianza. Una vez habilitadas estas medidas, solo los clientes con direcciones IP del intervalo definido pueden conectarse al almacén.

Si otros servicios de Azure, como Azure Data Factory o las máquinas virtuales, se conectan a la cuenta de Data Lake Analytics, asegúrese de que Permitir los servicios de Azure esté Activado.

Configurar una regla de firewall

- En Azure Portal, vaya a la cuenta de Data Lake Analytics.

- En el menú de la izquierda, seleccione Firewall.

Agregar un nuevo usuario

Puede usar el Asistente para agregar usuarios para crear fácilmente nuevos usuarios de Data Lake.

- En Azure Portal, vaya a la cuenta de Data Lake Analytics.

- A la izquierda, en Introducción, seleccione Asistente para agregar usuario.

- Seleccione un usuario y, luego, elija Seleccionar.

- Seleccione un rol y, luego, elija Seleccionar. Para configurar un nuevo desarrollador que use Azure Data Lake, seleccione el rol Desarrollador de Data Lake Analytics.

- Seleccione las listas de control de acceso (ACL) para las bases de datos de U-SQL. Cuando esté satisfecho con las opciones seleccionadas, haga clic en Seleccionar.

- Seleccione las ACL para los archivos. Para el almacén predeterminado, no cambie las ACL de la carpeta raíz "/" ni de la carpeta /system. Seleccione la opción Seleccionar.

- Revise todos los cambios seleccionados y luego haga clic en Ejecutar.

- Cuando el asistente haya terminado, haga clic en Listo.

Administración del control de acceso basado en roles de Azure

Al igual que con otros servicios de Azure, puede usar el control de acceso basado en roles de Azure (Azure RBAC) para determinar el modo en que los usuarios interactúan los usuarios.

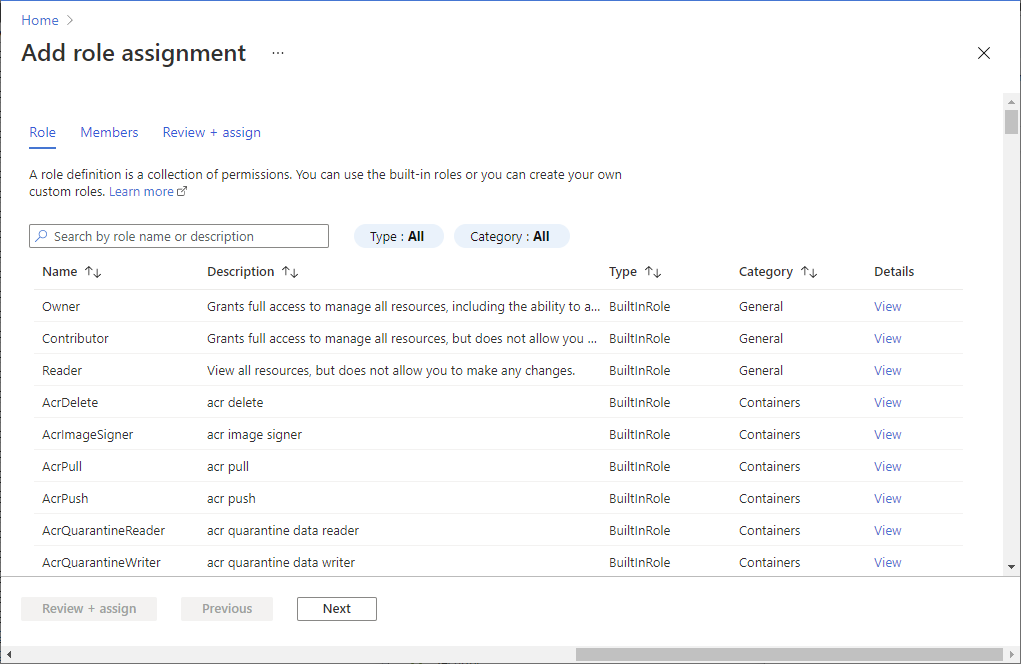

Los roles estándar de Azure tienen las siguientes funcionalidades:

- Propietario: puede enviar, supervisar y cancelar trabajos de cualquier usuario y configurar la cuenta.

- Colaborador: puede enviar, supervisar y cancelar trabajos de cualquier usuario y configurar la cuenta.

- Lector: puede supervisar trabajos.

Emplee el rol de desarrollador de Data Lake Analytics para permitir que los desarrolladores de U-SQL usen el servicio Data Lake Analytics. Puede usar el rol de desarrollador de Data Lake Analytics para:

- Enviar trabajos.

- Supervisar el estado y el progreso de los trabajos enviados por cualquier usuario.

- Ver los scripts de U-SQL de los trabajos enviados por cualquier usuario.

- Cancelar solo sus propios trabajos.

Agregar usuarios o grupos de seguridad a una cuenta de Data Lake Analytics

En Azure Portal, vaya a la cuenta de Data Lake Analytics.

Seleccione Access Control (IAM) .

Seleccione Agregar>Agregar asignación de roles para abrir la página Agregar asignación de roles.

Asigne un rol a un usuario. Para acceder a los pasos detallados, vea Asignación de roles de Azure mediante Azure Portal.

Nota

Si un usuario o un grupo de seguridad necesita enviar trabajos, también necesita permiso en la cuenta de almacenamiento. Para más información, vea Secure data stored in Data Lake Store (Protección de datos almacenados en Data Lake Store).

Trabajos de administración

Enviar un trabajo

En Azure Portal, vaya a la cuenta de Data Lake Analytics.

Seleccione Nuevo trabajo. Para cada trabajo, configure lo siguiente:

- Nombre del trabajo: Nombre del trabajo.

- Prioridad: se encuentra en Más opciones. los números más bajos tienen mayor prioridad. Si hay dos trabajos en cola, se ejecuta primero el que tenga un valor de prioridad más bajo.

- Unidades de análisis: número máximo de unidades de análisis o procesos de cálculo que se van a reservar para este trabajo.

- Tiempo de ejecución: también en Más opciones. Seleccione el tiempo de ejecución predeterminado a menos que haya recibido un entorno de ejecución personalizado.

Añada el script.

Seleccione Enviar trabajo.

Supervisión de trabajos

- En Azure Portal, vaya a la cuenta de Data Lake Analytics.

- Seleccione Ver todos los trabajos en la parte superior de la página. Se muestra una lista de todos los trabajos activos y finalizados recientemente en la cuenta.

- Opcionalmente, seleccione Filtro para encontrar los trabajos por intervalo de tiempo, estado, nombre del trabajo, identificador del trabajo, nombre de canalización o identificador de canalización, nombre de la periodicidad o identificador de la periodicidad y valores del autor.

Supervisión de trabajos de canalización

Los trabajos que forman parte de un trabajo de canalización actúan juntos, normalmente de forma secuencial, para lograr un escenario concreto. Por ejemplo, puede tener una canalización que limpia, extrae, transforma y agrega el uso para información del cliente. Los trabajos de canalización se identifican mediante la propiedad "Pipeline" al enviar el trabajo. En los trabajos programados con ADF V2 esta propiedad se rellena de forma automática.

Para ver una lista de trabajos de U-SQL que forman parte de canalizaciones:

- En Azure Portal, vaya a las cuentas de Data Lake Analytics.

- Seleccione Conclusiones de los trabajos. La pestaña "Todos los trabajos" aparece de forma predeterminada y muestra una lista de trabajos en ejecución, en cola y finalizados.

- Haga clic en la pestaña Trabajos de canalización. Se muestra una lista de trabajos de canalización junto con estadísticas añadidas de cada canalización.

Supervisión de trabajos periódicos

Un trabajo periódico es aquel que tiene la misma lógica de negocios pero usa distintos datos de entrada cada vez que se ejecuta. Lo ideal sería que los trabajos periódicos siempre fueran correctos y tuvieran un tiempo de ejecución relativamente estable; la supervisión de estos comportamientos ayuda a garantizar que el trabajo sea correcto. Los trabajos periódicos se identifican mediante la propiedad "Recurrence". En los trabajos programados con ADF V2 esta propiedad se rellena de forma automática.

Para ver una lista de trabajos de U-SQL que son periódicos:

- En Azure Portal, vaya a las cuentas de Data Lake Analytics.

- Seleccione Conclusiones de los trabajos. La pestaña "Todos los trabajos" aparece de forma predeterminada y muestra una lista de trabajos en ejecución, en cola y finalizados.

- Haga clic en la pestaña Trabajos periódicos. Se muestra una lista de trabajos periódicos junto con estadísticas añadidas de cada uno de ellos.

Pasos siguientes

- Información general de Azure Data Lake Analytics

- Manage Azure Data Lake Analytics by using Azure PowerShell (Administración de Azure Data Lake Analytics mediante Azure PowerShell)

- Administración de Azure Data Lake Analytics con directivas