Jak funguje Správce orchestrace pracovních postupů služby Azure Data Factory?

PLATÍ PRO:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Vyzkoušejte si službu Data Factory v Microsoft Fabric, řešení pro analýzy typu all-in-one pro podniky. Microsoft Fabric zahrnuje všechno od přesunu dat až po datové vědy, analýzy v reálném čase, business intelligence a vytváření sestav. Přečtěte si, jak začít používat novou zkušební verzi zdarma.

Poznámka

Správce orchestrace pracovních postupů využívá Apache Airflow.

Poznámka

Správce orchestrace pracovních postupů pro Azure Data Factory spoléhá na opensourcovou aplikaci Apache Airflow. Dokumentaci a další kurzy pro Airflow najdete na stránkách dokumentace nebo komunity Apache Airflow.

Správce orchestrace pracovních postupů ve službě Azure Data Factory používá ke spouštění pracovních postupů orchestrace řízené Acyklické grafy (DAG) založené na Pythonu. Pokud chcete tuto funkci použít, musíte ve službě Azure Blob Storage poskytnout své skupiny dagů a moduly plug-in. Uživatelské rozhraní Airflow můžete spustit z ADF pomocí rozhraní příkazového řádku (CLI) nebo sady SDK (Software Development Kit) pro správu daG.

Následující kroky nastaví a nakonfigurují prostředí Správce orchestrace pracovního postupu.

Předplatné Azure: Pokud ještě nemáte předplatné Azure, vytvořte si bezplatný účet před tím, než začnete. Vytvořte nebo vyberte existující službu Data Factory v oblasti, ve které je podporována verze Preview Správce orchestrace pracovního postupu.

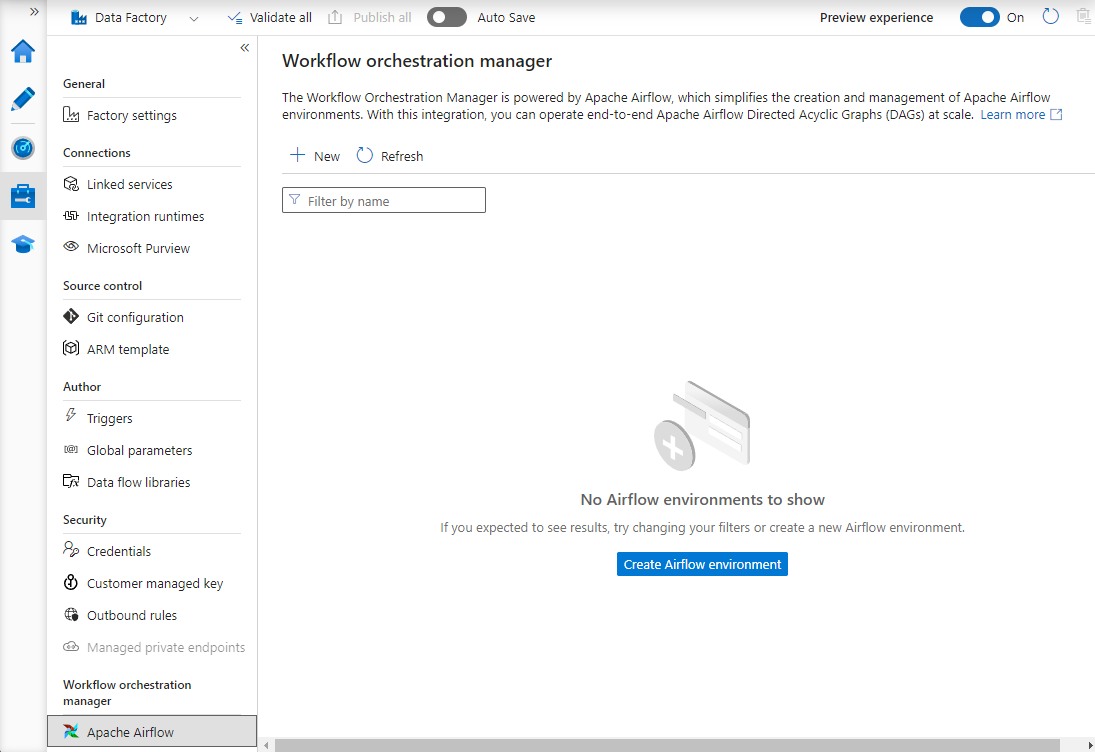

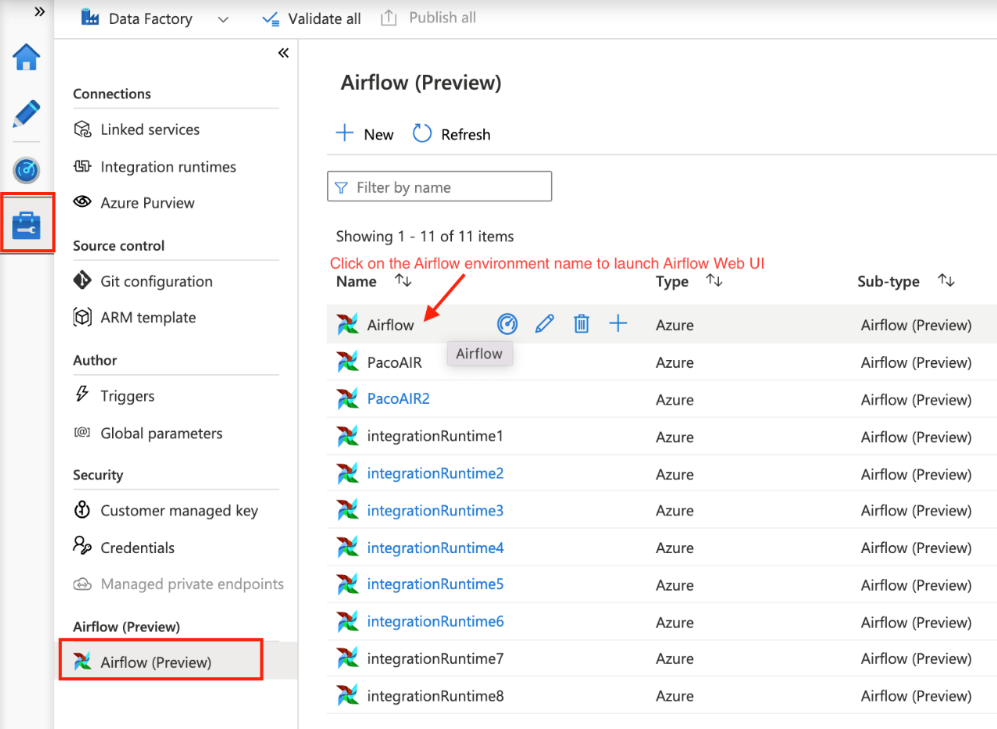

Vytvořte nové prostředí Správce orchestrace pracovních postupů. Přejděte na Spravovat centrum ->Airflow (Preview) ->+Nový a vytvořte nové prostředí Airflow.

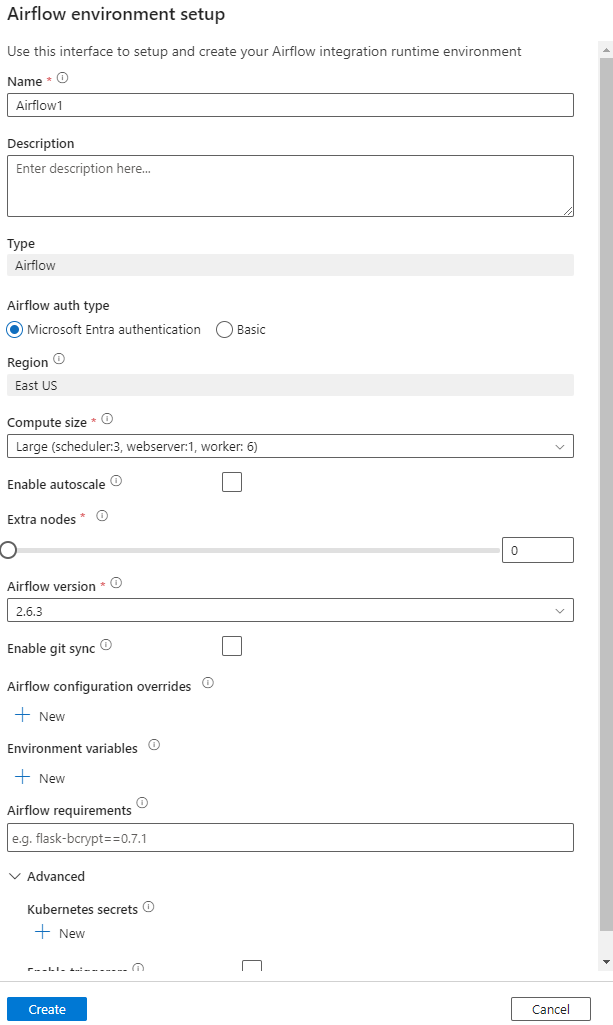

Zadejte podrobnosti (konfigurace Airflow)

Důležité

Při použití základního ověřování si zapamatujte uživatelské jméno a heslo zadané na této obrazovce. Bude potřeba se přihlásit později v uživatelském rozhraní Správce orchestrace pracovního postupu. Výchozí možností je Microsoft Entra ID a nevyžaduje vytvoření uživatelského jména nebo hesla pro vaše prostředí Airflow, ale místo toho používá přihlašovací údaje přihlášeného uživatele k Azure Data Factory k přihlášení nebo monitorování DAG.

Proměnné prostředí ukládají a načítají libovolný obsah nebo nastavení v rámci Airflow jednoduché úložiště klíč-hodnota.

Požadavky je možné použít k předběžné instalaci knihoven Pythonu. Tyto aktualizace můžete aktualizovat i později.

Následující kroky popisují, jak importovat dagy do Správce orchestrace pracovního postupu.

Ukázkovou daG budete muset nahrát do přístupného účtu úložiště (měla by být ve složce dags).

Poznámka

Blob Storage za virtuální sítí se během verze Preview nepodporuje.

Konfigurace služby KeyVault v úložištiLinkedServices se nepodporuje při importu dagů.

Ukázka Apache Airflow v2.x DAG Ukázka Apache Airflow v1.10 DAG.

Zkopírujte obsah (v2.x nebo v1.10 na základě prostředí Airflow, které máte nastavené) do nového souboru volaný jako tutorial.py.

Nahrajte tutorial.py do úložiště objektů blob. (Jak nahrát soubor do objektu blob)

Poznámka

Abyste je mohli importovat do prostředí Airflow, budete muset vybrat cestu k adresáři z účtu úložiště objektů blob, který obsahuje složky s názvem dags a pluginy . Moduly plug-in nejsou povinné. Můžete také mít kontejner s názvem dags a nahrát do něj všechny soubory Airflow.

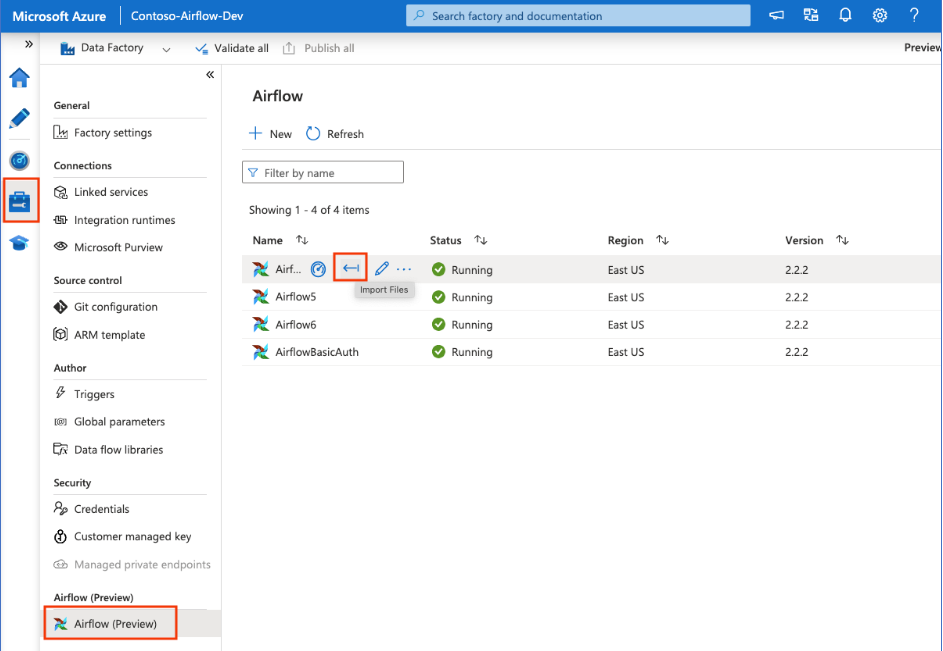

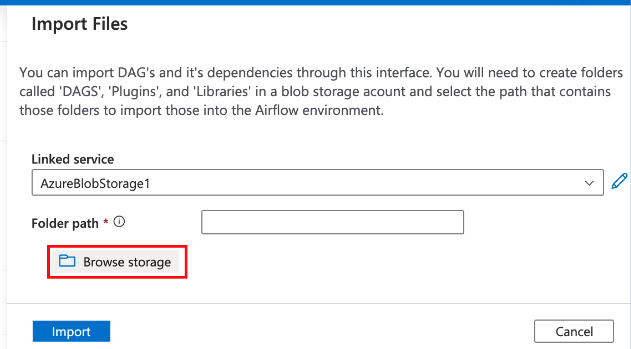

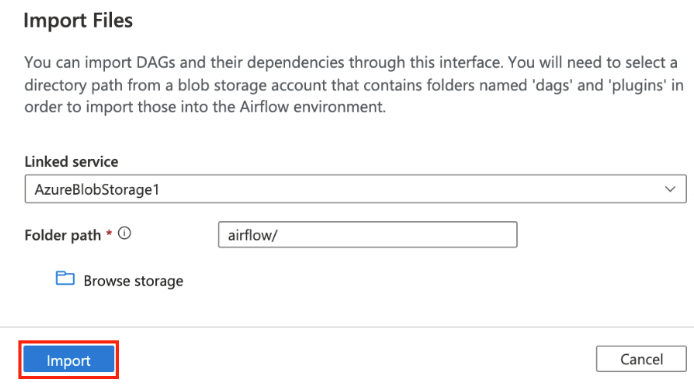

V části Spravovat rozbočovač vyberte airflow (Preview). Pak najeďte myší na dříve vytvořené prostředí Airflow a výběrem možnosti Importovat soubory naimportujte všechny daG a závislosti do prostředí Airflow.

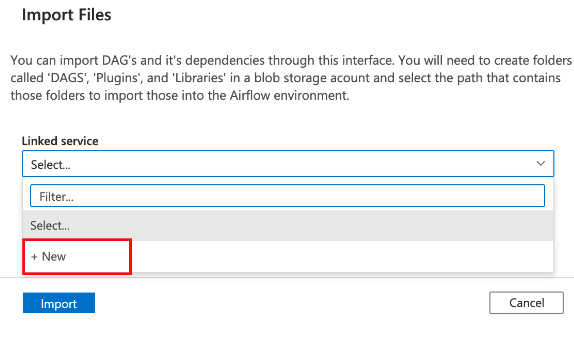

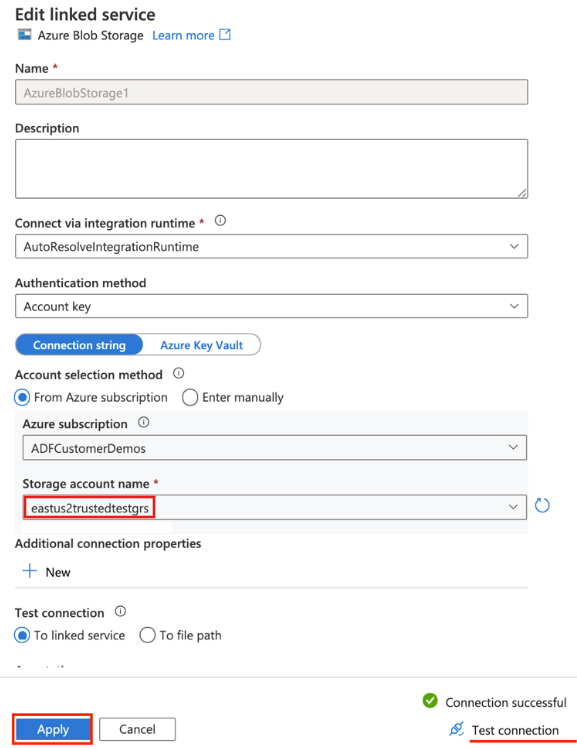

Vytvořte novou propojenou službu pro přístupný účet úložiště uvedený v předpokladu (nebo použijte existující službu, pokud už máte vlastní skupiny DAG).

Použijte účet úložiště, do kterého jste nahráli daG (zkontrolujte předpoklad). Otestujte připojení a pak vyberte Vytvořit.

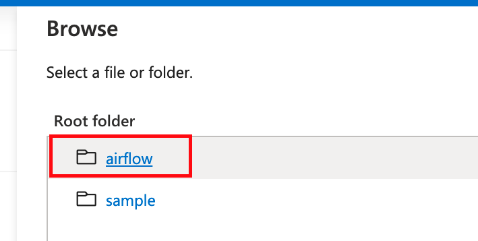

Pokud používáte ukázkovou adresu URL SAS, procházejte a vyberte složku, která obsahuje složku dags se soubory DAG.

Poznámka

Pomocí tohoto rozhraní můžete importovat skupiny DAG a jejich závislosti. Abyste je mohli importovat do prostředí Airflow, budete muset vybrat cestu k adresáři z účtu úložiště objektů blob, který obsahuje složky s názvem dags a pluginy . Moduly plug-in nejsou povinné.

Poznámka

Import dagů může během verze Preview trvat několik minut. Centrum oznámení (ikona zvonku v uživatelském rozhraní ADF) se dá použít ke sledování aktualizací stavu importu.

Problém: Zmírnění rizik importu DAG trvá více než 5 minut: Zmenšete velikost importovaných dag pomocí jednoho importu. Jedním ze způsobů, jak toho dosáhnout, je vytvoření více složek DAG s menšími skupinami DAG napříč několika kontejnery.

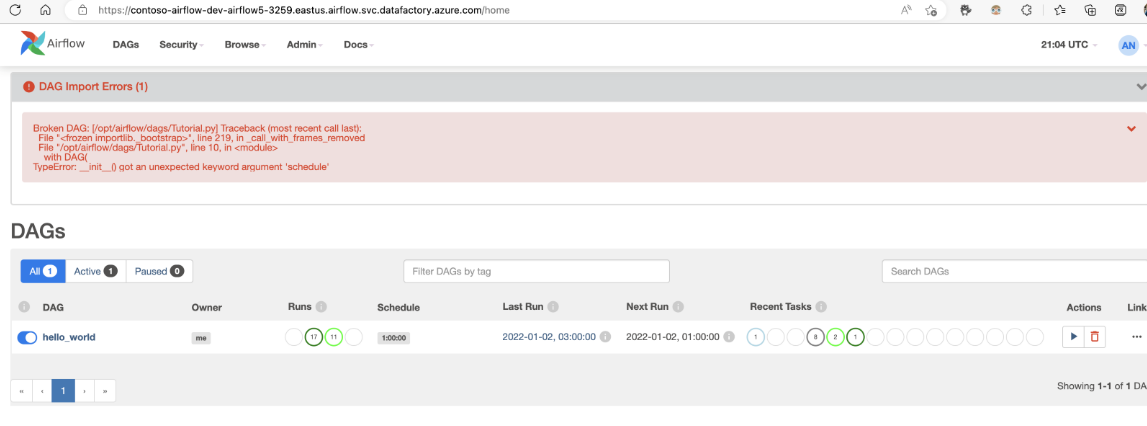

Problém: Importované DAG se nezobrazují, když se přihlásíte do uživatelského rozhraní Airflow. Zmírnění rizik: Přihlaste se do uživatelského rozhraní Airflow a zkontrolujte, jestli nedošlo k nějakým chybám analýzy DAG. K tomu může dojít v případě, že soubory DAG obsahují nekompatibilní kód. Přes uživatelské rozhraní Airflow najdete přesná čísla řádků a soubory, u kterých dochází k problému.

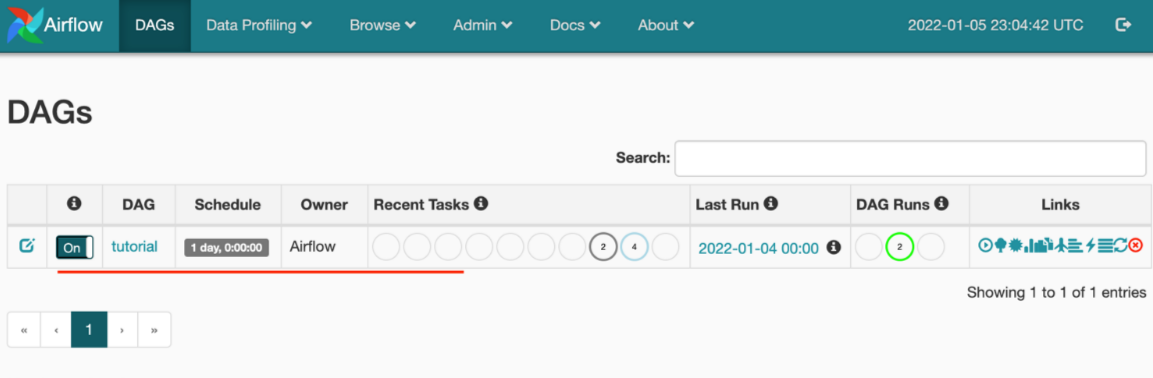

Pokud chcete monitorovat dagy Airflow, přihlaste se k uživatelskému rozhraní Airflow pomocí dříve vytvořeného uživatelského jména a hesla.

Vyberte vytvořené prostředí Airflow.

Přihlaste se pomocí uživatelského jména a hesla zadaného při vytváření prostředí Airflow Integration Runtime. (Uživatelské jméno nebo heslo můžete resetovat úpravou prostředí Airflow Integration Runtime v případě potřeby)

Pokud používáte Airflow verze 1.x, odstraňte dagy nasazené v jakémkoli prostředí Airflow (IR), musíte odstranit DAG na dvou různých místech.

- Odstranění DAG z uživatelského rozhraní Airflow

- Odstranění dag v uživatelském rozhraní ADF

Poznámka

Toto je aktuální prostředí ve verzi Public Preview a toto prostředí budeme vylepšovat.