Kurz: Vytváření clusterů Apache Hadoop na vyžádání ve službě HDInsight pomocí služby Azure Data Factory

V tomto kurzu se naučíte vytvořit cluster Apache Hadoop na vyžádání ve službě Azure HDInsight pomocí služby Azure Data Factory. Potom pomocí datových kanálů ve službě Azure Data Factory spustíte úlohy Hive a odstraníte cluster. Na konci tohoto kurzu se dozvíte, jak spustit operationalize úlohu s velkými objemy dat, ve které se provádí vytváření clusteru, spuštění úlohy a odstranění clusteru podle plánu.

Tento kurz se zabývá následujícími úkony:

- Vytvoření účtu úložiště Azure

- Vysvětlení aktivity služby Azure Data Factory

- Vytvoření datové továrny pomocí webu Azure Portal

- Vytvoření propojených služeb

- Vytvořit kanál

- Aktivace kanálu

- Monitorování kanálu

- Ověření výstupu

Pokud ještě nemáte předplatné Azure, vytvořte si napřed bezplatný účet.

Požadavky

Instanční objekt Microsoft Entra. Po vytvoření instančního objektu nezapomeňte pomocí pokynů v propojeném článku načíst ID aplikace a ověřovací klíč . Tyto hodnoty budete potřebovat později v tomto kurzu. Také se ujistěte, že instanční objekt je členem role Přispěvatel předplatného nebo skupiny prostředků, ve které je cluster vytvořen. Pokyny k načtení požadovaných hodnot a přiřazení správných rolí naleznete v tématu Vytvoření instančního objektu Microsoft Entra.

Vytvoření předběžných objektů Azure

V této části vytvoříte různé objekty, které se použijí pro cluster HDInsight, který vytvoříte na vyžádání. Vytvořený účet úložiště bude obsahovat ukázkový skript HiveQL, partitionweblogs.hqlkterý použijete k simulaci ukázkové úlohy Apache Hive, která běží v clusteru.

Tato část používá skript Azure PowerShellu k vytvoření účtu úložiště a zkopírování požadovaných souborů v rámci účtu úložiště. Ukázkový skript Azure PowerShellu v této části provede následující úlohy:

- Přihlásí se k Azure.

- Vytvoří skupinu prostředků Azure.

- Vytvoří účet služby Azure Storage.

- Vytvoří v účtu úložiště kontejner objektů blob.

- Zkopíruje ukázkový skript HiveQL (partitionweblogs.hql) kontejner objektů blob. Ukázkový skript je již k dispozici v jiném veřejném kontejneru objektů blob. Následující skript PowerShellu vytvoří kopii těchto souborů do účtu azure Storage, který vytvoří.

Vytvoření účtu úložiště a kopírování souborů

Důležité

Zadejte názvy pro skupinu prostředků Azure a účet úložiště Azure, který bude vytvořen skriptem. Poznamenejte si název skupiny prostředků, název účtu úložiště a klíč účtu úložiště, který skript vypíše. V další části je budete potřebovat.

$resourceGroupName = "<Azure Resource Group Name>"

$storageAccountName = "<Azure Storage Account Name>"

$location = "East US"

$sourceStorageAccountName = "hditutorialdata"

$sourceContainerName = "adfv2hiveactivity"

$destStorageAccountName = $storageAccountName

$destContainerName = "adfgetstarted" # don't change this value.

####################################

# Connect to Azure

####################################

#region - Connect to Azure subscription

Write-Host "`nConnecting to your Azure subscription ..." -ForegroundColor Green

$sub = Get-AzSubscription -ErrorAction SilentlyContinue

if(-not($sub))

{

Connect-AzAccount

}

# If you have multiple subscriptions, set the one to use

# Select-AzSubscription -SubscriptionId "<SUBSCRIPTIONID>"

#endregion

####################################

# Create a resource group, storage, and container

####################################

#region - create Azure resources

Write-Host "`nCreating resource group, storage account and blob container ..." -ForegroundColor Green

New-AzResourceGroup `

-Name $resourceGroupName `

-Location $location

New-AzStorageAccount `

-ResourceGroupName $resourceGroupName `

-Name $destStorageAccountName `

-Kind StorageV2 `

-Location $location `

-SkuName Standard_LRS `

-EnableHttpsTrafficOnly 1

$destStorageAccountKey = (Get-AzStorageAccountKey `

-ResourceGroupName $resourceGroupName `

-Name $destStorageAccountName)[0].Value

$sourceContext = New-AzStorageContext `

-StorageAccountName $sourceStorageAccountName `

-Anonymous

$destContext = New-AzStorageContext `

-StorageAccountName $destStorageAccountName `

-StorageAccountKey $destStorageAccountKey

New-AzStorageContainer `

-Name $destContainerName `

-Context $destContext

#endregion

####################################

# Copy files

####################################

#region - copy files

Write-Host "`nCopying files ..." -ForegroundColor Green

$blobs = Get-AzStorageBlob `

-Context $sourceContext `

-Container $sourceContainerName `

-Blob "hivescripts\hivescript.hql"

$blobs|Start-AzStorageBlobCopy `

-DestContext $destContext `

-DestContainer $destContainerName `

-DestBlob "hivescripts\partitionweblogs.hql"

Write-Host "`nCopied files ..." -ForegroundColor Green

Get-AzStorageBlob `

-Context $destContext `

-Container $destContainerName

#endregion

Write-host "`nYou will use the following values:" -ForegroundColor Green

write-host "`nResource group name: $resourceGroupName"

Write-host "Storage Account Name: $destStorageAccountName"

write-host "Storage Account Key: $destStorageAccountKey"

Write-host "`nScript completed" -ForegroundColor Green

Ověření účtu úložiště

- Přihlaste se k portálu Azure Portal.

- Zleva přejděte na Všechny služby>Obecné>skupiny prostředků.

- Vyberte název skupiny prostředků, kterou jste vytvořili ve skriptu PowerShellu. Filtr použijte, pokud máte v seznamu příliš mnoho skupin prostředků.

- V zobrazení Přehled uvidíte jeden z uvedených zdrojů, pokud skupinu prostředků nesdílíte s jinými projekty. Tento prostředek je účet úložiště s názvem, který jste zadali dříve. Vyberte název účtu úložiště.

- Vyberte dlaždici Kontejnery .

- Vyberte kontejner adfgetstarted. Zobrazí se složka s názvem

hivescripts. - Otevřete složku a ujistěte se, že obsahuje ukázkový soubor skriptu partitionweblogs.hql.

Vysvětlení aktivity služby Azure Data Factory

Azure Data Factory orchestruje a automatizuje přesun a transformaci dat. Azure Data Factory může vytvořit cluster HDInsight Hadoop just-in-time pro zpracování vstupního datového řezu a po dokončení zpracování cluster odstranit.

Ve službě Azure Data Factory může datová továrna obsahovat jeden nebo více datových kanálů. Datový kanál má jednu nebo více aktivit. Existují dva typy aktivit:

- Aktivity přesunu dat Aktivity přesunu dat slouží k přesunu dat ze zdrojového úložiště dat do cílového úložiště dat.

- Aktivity transformace dat Aktivity transformace dat slouží k transformaci a zpracování dat. Aktivita HIVe služby HDInsight je jednou z transformačních aktivit podporovaných službou Data Factory. V tomto kurzu použijete aktivitu transformace Hive.

V tomto článku nakonfigurujete aktivitu Hive tak, aby vytvořila cluster HDInsight Hadoop na vyžádání. Když se aktivita spustí ke zpracování dat, stane se toto:

Cluster HDInsight Hadoop se automaticky vytvoří, abyste mohli řez zpracovat za běhu.

Vstupní data se zpracovávají spuštěním skriptu HiveQL v clusteru. V tomto kurzu skript HiveQL přidružený k aktivitě Hive provede následující akce:

- Použije existující tabulku (hivesampletable) k vytvoření další tabulky HiveSampleOut.

- Naplní tabulku HiveSampleOut pouze konkrétními sloupci z původního hivesampletable.

Cluster HDInsight Hadoop se po dokončení zpracování odstraní a cluster je nečinný po nakonfigurovanou dobu (nastavení timeToLive). Pokud je k dispozici další řez dat ke zpracování s tímto časem nečinnostiToLive, použije se ke zpracování řezu stejný cluster.

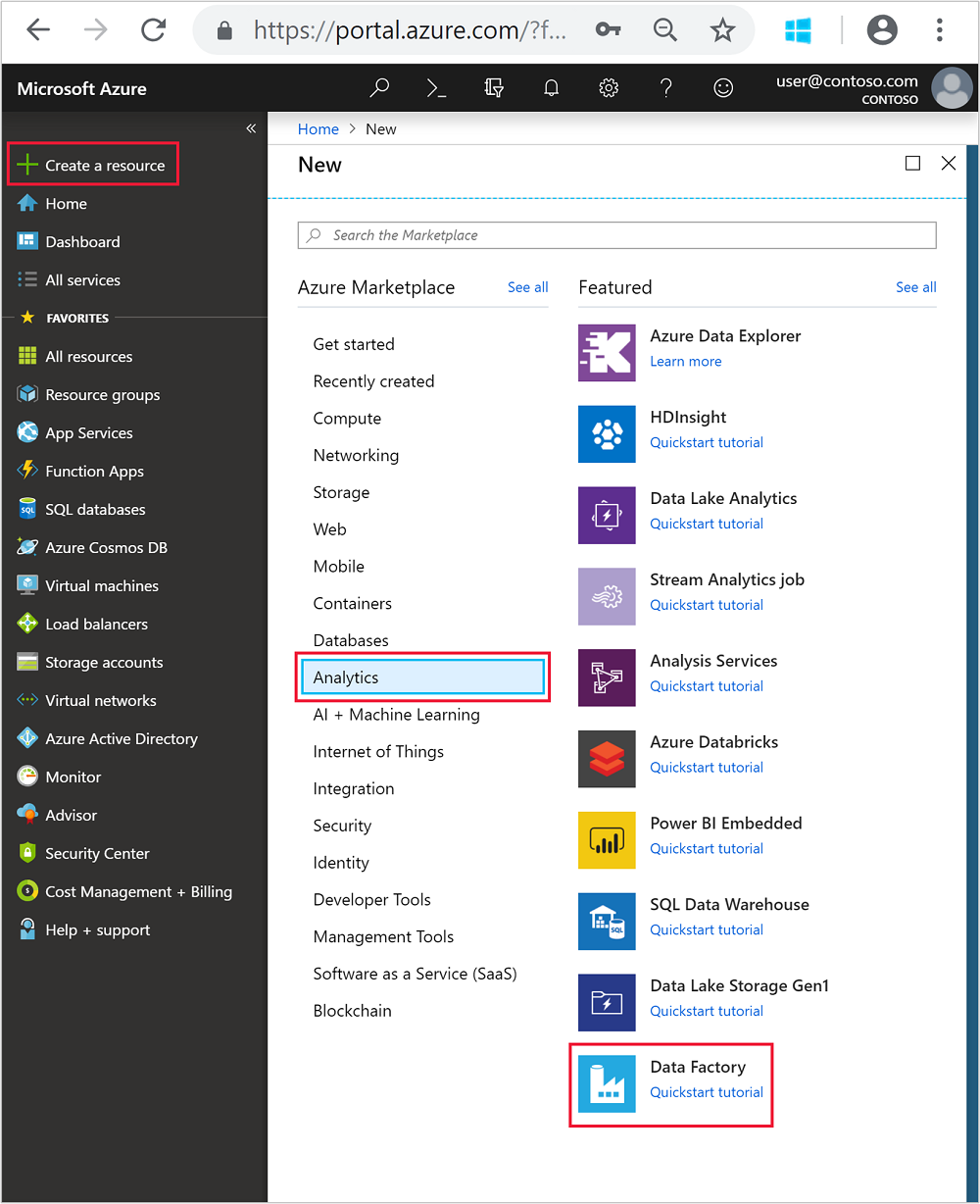

Vytvoření datové továrny

Přihlaste se k portálu Azure.

V nabídce vlevo přejděte do

+ Create a resource>služby Analytics>Data Factory.

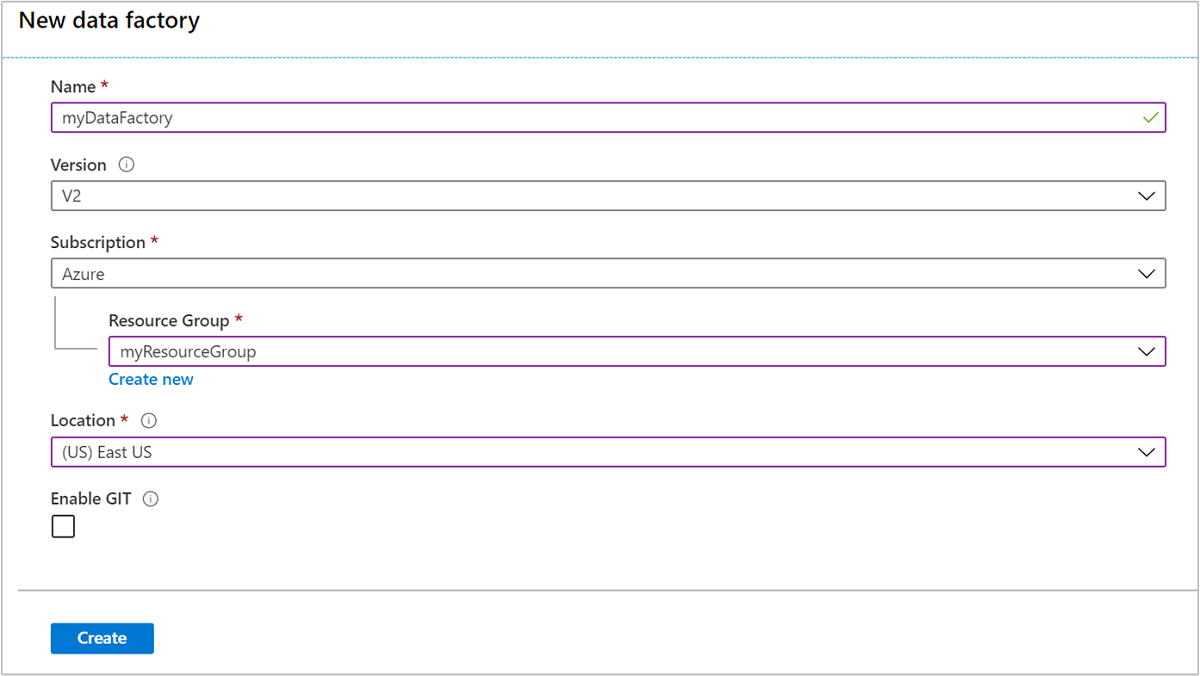

Zadejte nebo vyberte následující hodnoty pro dlaždici Nová datová továrna :

Vlastnost Hodnota Name Zadejte název datové továrny. Tento název musí být globálně jedinečný. Verze Odejděte ve verzi 2. Předplatné Vyberte své předplatné Azure. Skupina zdrojů Vyberte skupinu prostředků, kterou jste vytvořili pomocí skriptu PowerShellu. Umístění Umístění se automaticky nastaví na umístění, které jste zadali při vytváření skupiny prostředků dříve. Pro účely tohoto kurzu je umístění nastavené na USA – východ. Povolení GITu Zrušte zaškrtnutí tohoto políčka.

Vyberte Vytvořit. Vytvoření datové továrny může trvat 2 až 4 minuty.

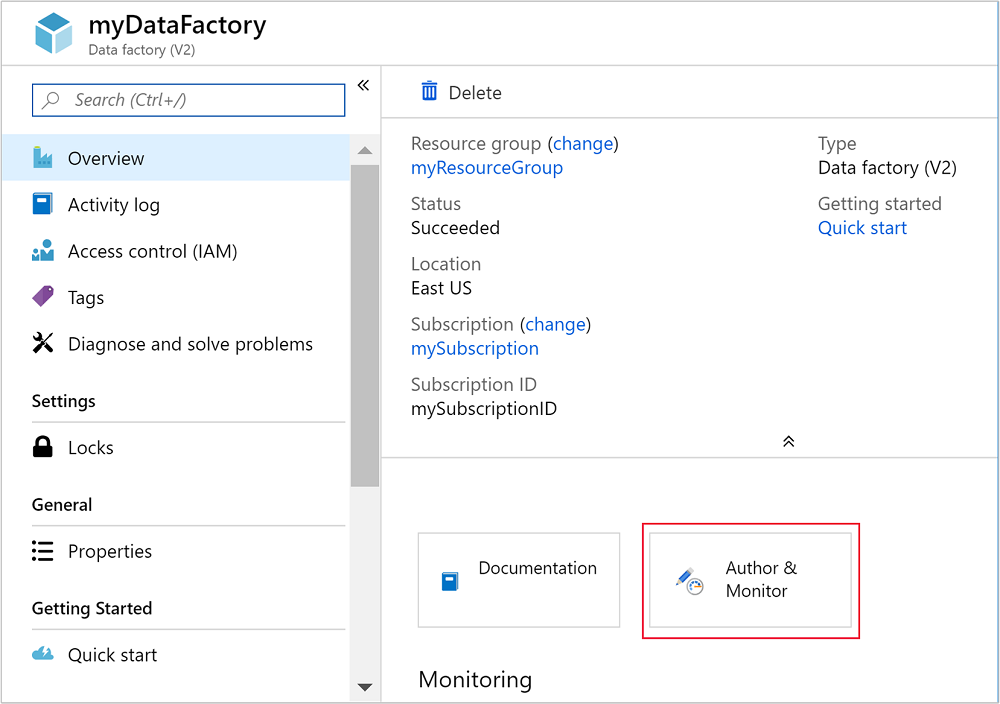

Po vytvoření datové továrny obdržíte oznámení o úspěšném nasazení s tlačítkem Přejít k prostředku . Výběrem možnosti Přejít k prostředku otevřete výchozí zobrazení služby Data Factory.

Výběrem možnosti Vytvořit a monitorovat spusťte portál pro vytváření a monitorování služby Azure Data Factory.

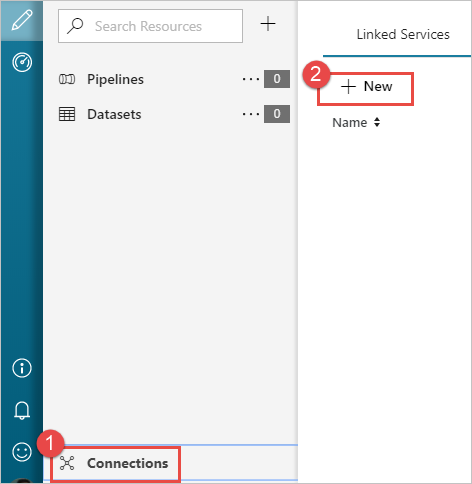

Vytvoření propojených služeb

V této části vytvoříte dvě propojené služby v datové továrně.

- Propojená služba Azure Storage, která propojí účet služby Azure Storage s datovou továrnou. Toto úložiště používá cluster HDInsight na vyžádání. Obsahuje také skript Hive, který běží v clusteru.

- Propojená služba HDInsight na vyžádání. Azure Data Factory automaticky vytvoří cluster HDInsight a spustí skript Hive. Až bude cluster HDInsight zadanou dobu nečinný, odstraní ho.

Vytvoření propojené služby Azure Storage

V levém podokně stránky Začínáme vyberte ikonu Autor .

V levém dolním rohu okna vyberte Připojení iony a pak vyberte +Nový.

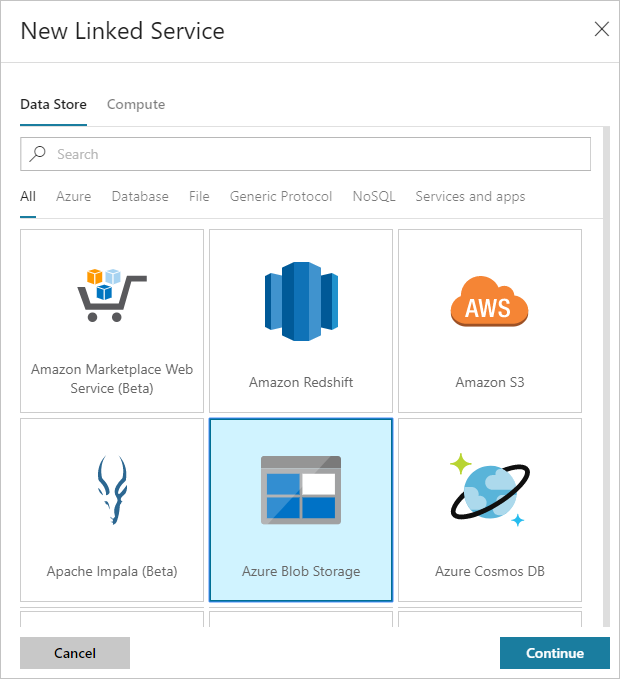

V dialogovém okně Nová propojená služba vyberte Azure Blob Storage a pak vyberte Pokračovat.

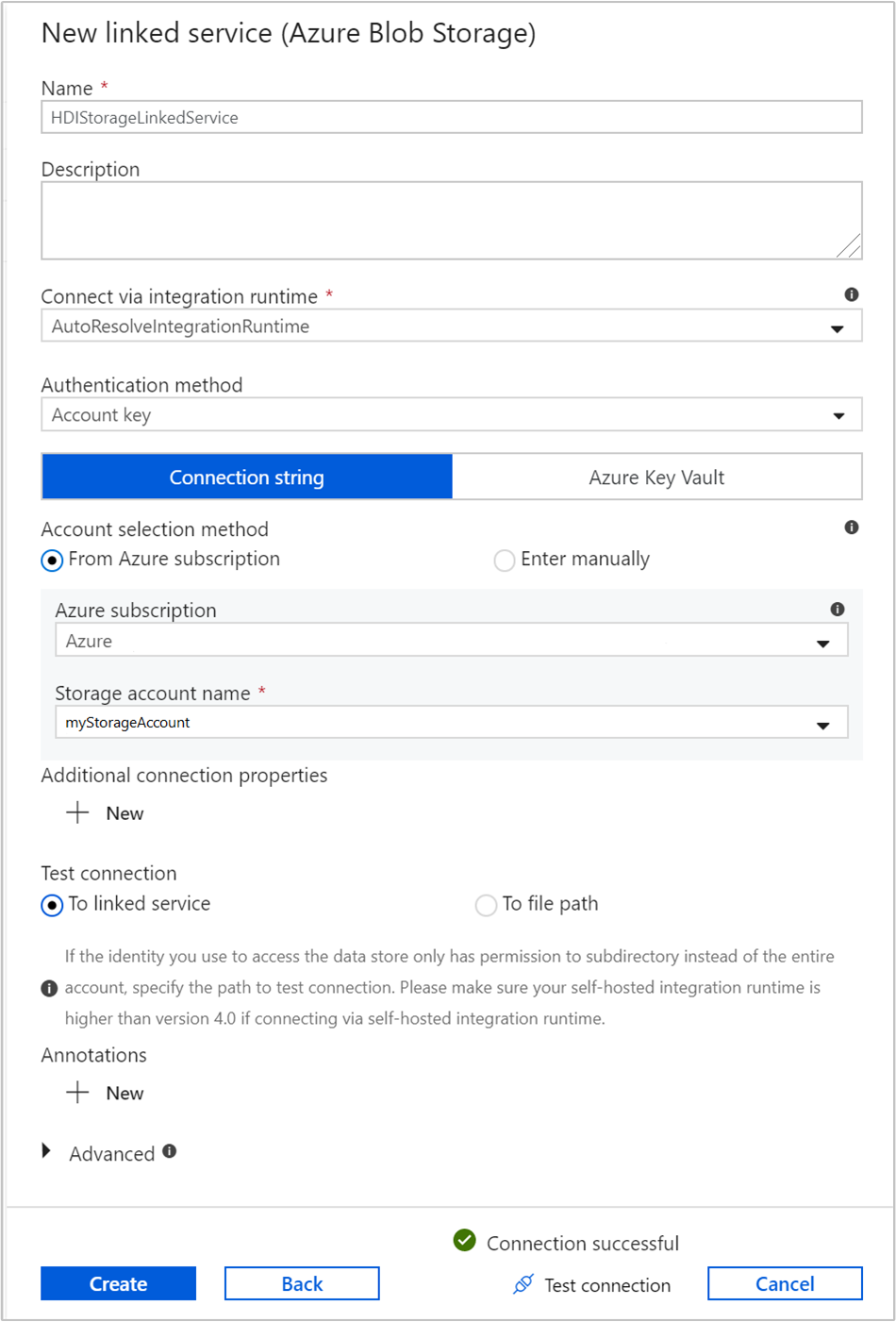

Zadejte následující hodnoty pro propojenou službu úložiště:

Vlastnost Hodnota Name Zadejte HDIStorageLinkedService.Předplatné Azure V rozevíracím seznamu vyberte své předplatné. Název účtu úložiště Vyberte účet Azure Storage, který jste vytvořili jako součást skriptu PowerShellu. Vyberte Test připojení a v případě úspěchu vyberte Vytvořit.

Vytvoření propojené služby HDInsight na vyžádání

Znovu vyberte tlačítko + Nová a vytvořte další propojenou službu.

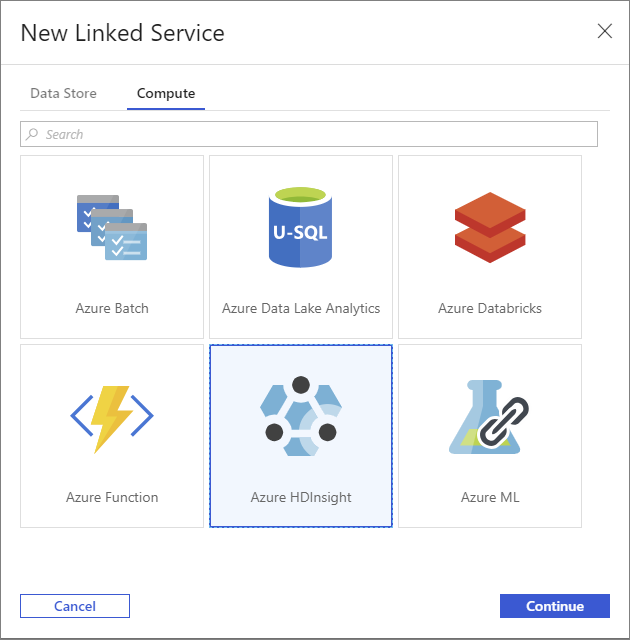

V okně Nová propojená služba vyberte kartu Výpočty .

Vyberte Azure HDInsight a pak vyberte Pokračovat.

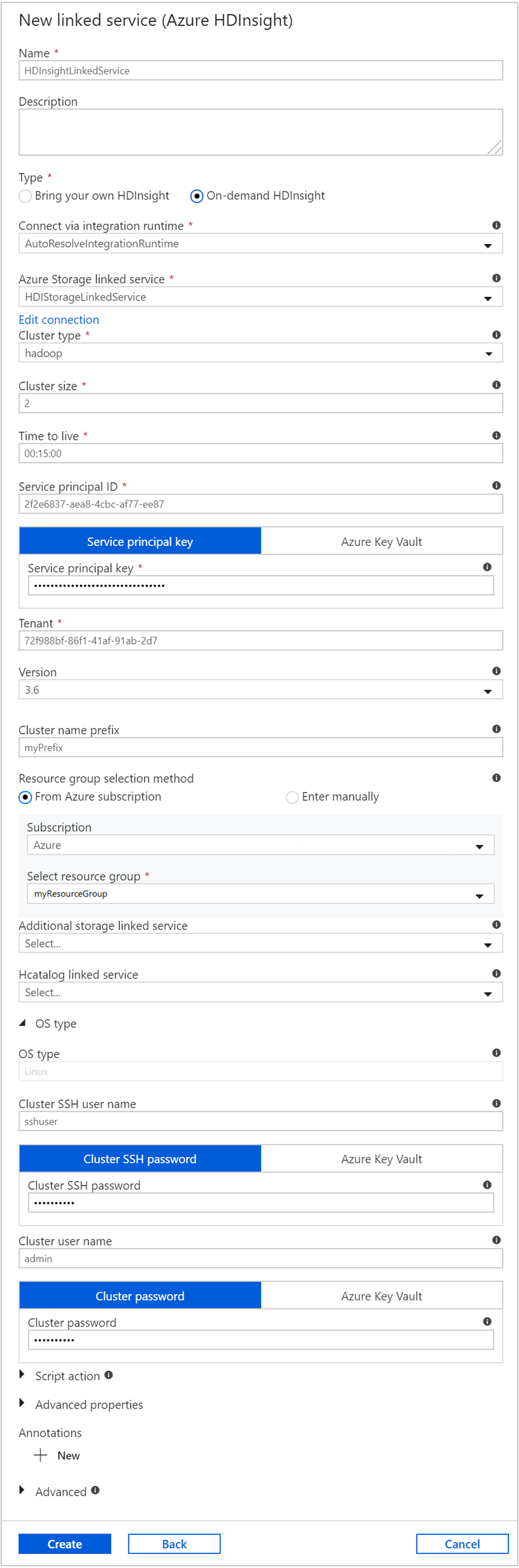

V okně Nová propojená služba zadejte následující hodnoty a zbytek ponechte jako výchozí:

Vlastnost Hodnota Name Zadejte HDInsightLinkedService.Typ Vyberte HDInsight na vyžádání. Propojená služba Azure Storage Vyberte možnost HDIStorageLinkedService.Typ clusteru Výběr hadoopu Hodnota TTL (Time to Live) Zadejte dobu, po kterou chcete, aby byl cluster HDInsight před automatickým odstraněním dostupný. ID instančního objektu Zadejte ID aplikace instančního objektu Microsoft Entra, který jste vytvořili jako součást požadavků. Klíč instančního objektu Zadejte ověřovací klíč pro instanční objekt Microsoft Entra. Předpona názvu clusteru Zadejte hodnotu, která bude mít předponu všech typů clusterů vytvořených objektem pro vytváření dat. Předplatné V rozevíracím seznamu vyberte své předplatné. Select resource group Vyberte skupinu prostředků, kterou jste vytvořili jako součást skriptu PowerShellu, který jste použili dříve. Typ operačního systému / uživatelské jméno SSH clusteru Zadejte uživatelské jméno SSH, obvykle sshuser.Typ operačního systému nebo heslo SSH clusteru Zadání hesla pro uživatele SSH Typ operačního systému / uživatelské jméno clusteru Zadejte uživatelské jméno clusteru, obvykle admin.Typ operačního systému nebo heslo clusteru Zadejte heslo pro uživatele clusteru. Pak vyberte Vytvořit.

Vytvořit kanál

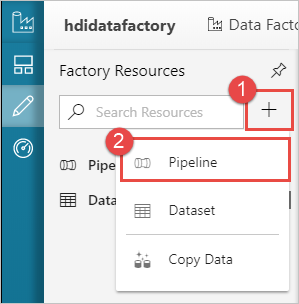

Vyberte tlačítko + (plus) a pak vyberte Kanál.

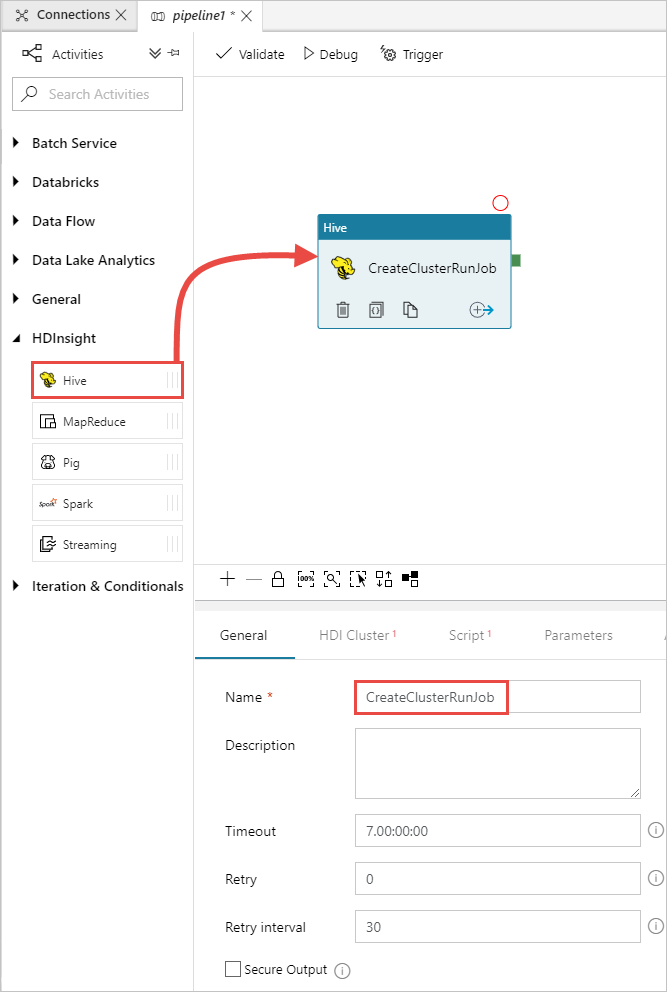

Na panelu nástrojů Aktivity rozbalte HDInsight a přetáhněte aktivitu Hive na plochu návrháře kanálu. Na kartě Obecné zadejte název aktivity.

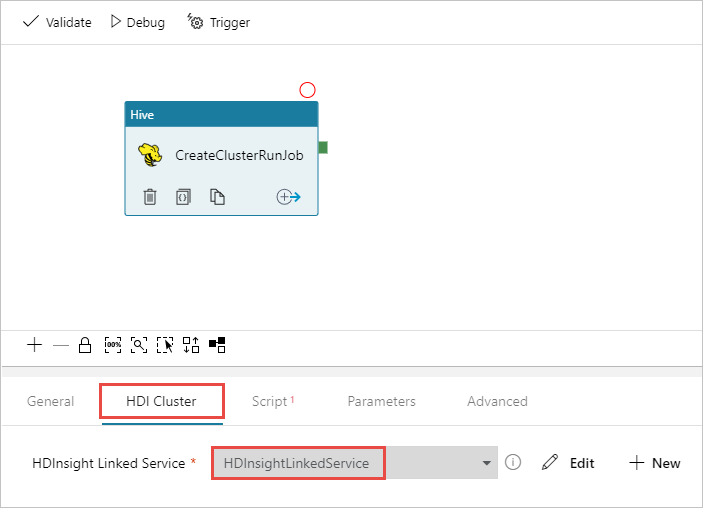

Ujistěte se, že máte vybranou aktivitu Hive, vyberte kartu Cluster HDI. V rozevíracím seznamu propojené služby HDInsight vyberte propojenou službu, kterou jste vytvořili dříve, HDInsightLinkedService pro HDInsight.

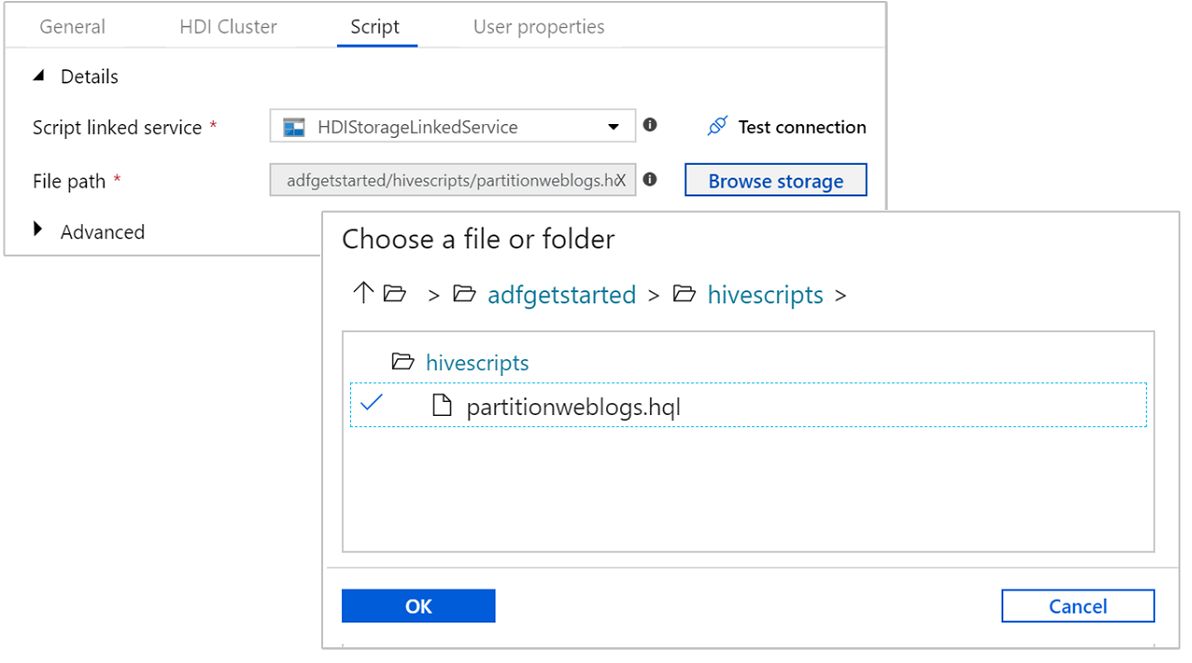

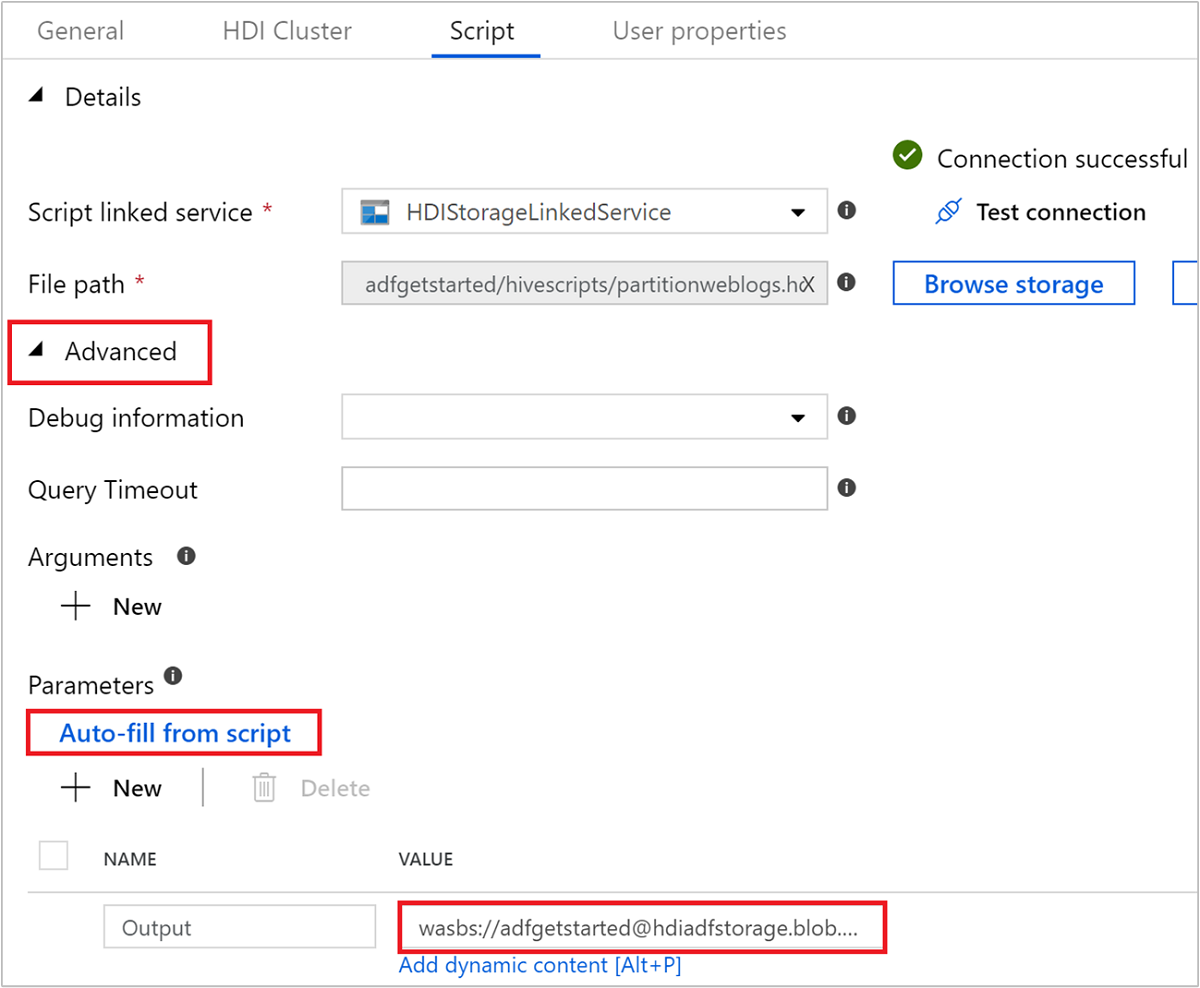

Vyberte kartu Skript a proveďte následující kroky:

V části Propojená služba skriptu vyberte z rozevíracího seznamu službu HDIStorageLinkedService . Tato hodnota je propojená služba úložiště, kterou jste vytvořili dříve.

V části Cesta k souboru vyberte Procházet úložiště a přejděte do umístění, kde je k dispozici ukázkový skript Hive. Pokud jste dříve spustili skript PowerShellu, mělo by toto umístění být

adfgetstarted/hivescripts/partitionweblogs.hql.

V části Upřesnit>parametry vyberte .

Auto-fill from scriptTato možnost vyhledá všechny parametry ve skriptu Hive, které vyžadují hodnoty za běhu.Do textového pole hodnoty přidejte existující složku ve formátu

wasbs://adfgetstarted@<StorageAccount>.blob.core.windows.net/outputfolder/. V této cestě se rozlišují velká a malá písmena. V této cestě se uloží výstup skriptu. Schémawasbsje nezbytné, protože účty úložiště teď mají ve výchozím nastavení povolený zabezpečený přenos.

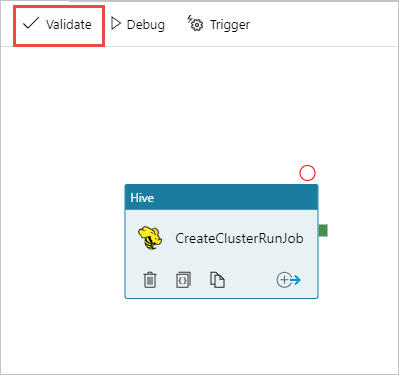

Vyberte Ověřit a ověřte kanál. Výběrem tlačítka >> (šipka doprava) zavřete okno ověřování.

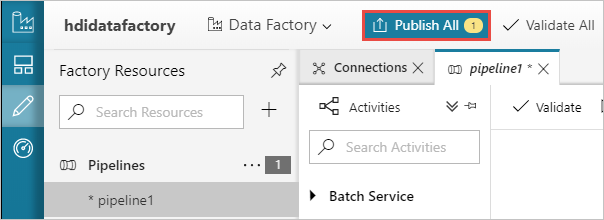

Nakonec výběrem možnosti Publikovat vše publikujte artefakty do služby Azure Data Factory.

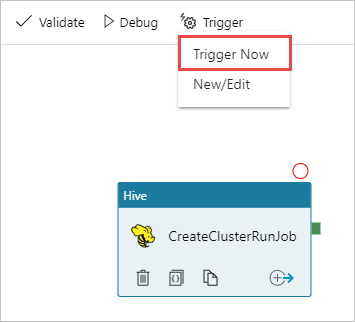

Aktivace kanálu

Na panelu nástrojů na ploše návrháře vyberte Přidat aktivační událost triggeru>Nyní.

Na místním bočním panelu vyberte OK .

Monitorování kanálu

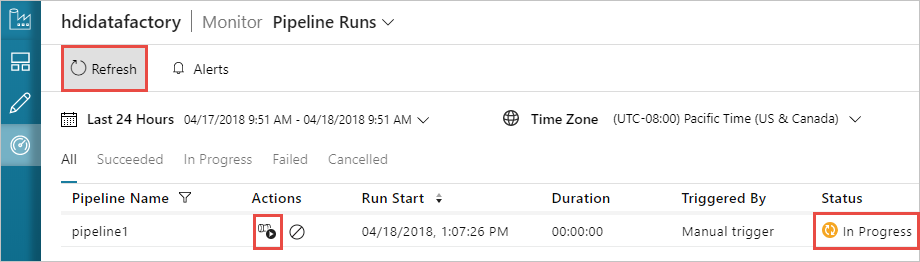

Vlevo přepněte na kartu Monitorování. V seznamu Spuštění kanálu se zobrazí spuštění kanálu. Všimněte si stavu spuštění ve sloupci Stav .

Seznam můžete aktualizovat kliknutím na Aktualizovat.

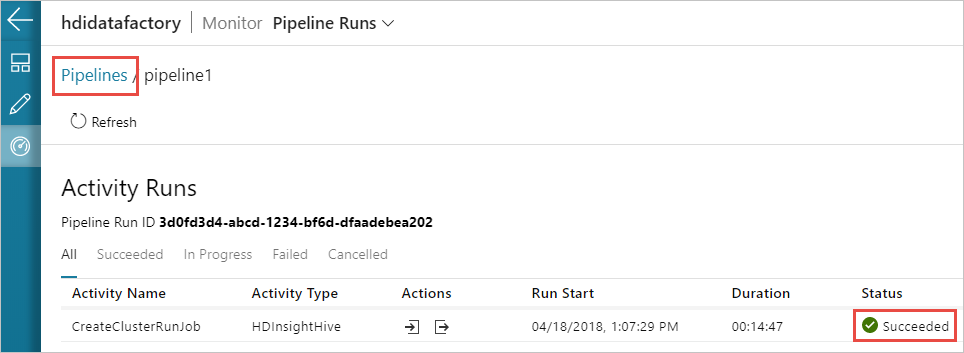

Můžete také vybrat ikonu Zobrazit spuštění aktivit a zobrazit spuštění aktivity přidružené ke kanálu. Na následujícím snímku obrazovky uvidíte jenom jedno spuštění aktivity, protože v kanálu, který jste vytvořili, je jenom jedna aktivita. Pokud chcete přepnout zpět na předchozí zobrazení, vyberte Kanály v horní části stránky.

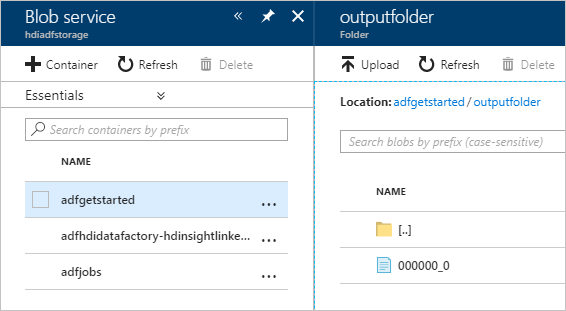

Ověření výstupu

Pokud chcete ověřit výstup, přejděte na webu Azure Portal k účtu úložiště, který jste použili pro účely tohoto kurzu. Měly by se zobrazit následující složky nebo kontejnery:

Zobrazí se adfgerstarted /outputfolder , který obsahuje výstup skriptu Hive, který byl spuštěn jako součást kanálu.

Zobrazí se kontejner adfhdidatafactory-linked-service-name-timestamp><<>. Tento kontejner je výchozí umístění úložiště clusteru HDInsight, který byl vytvořen jako součást spuštění kanálu.

Zobrazí se kontejner adfjobs , který obsahuje protokoly úloh služby Azure Data Factory.

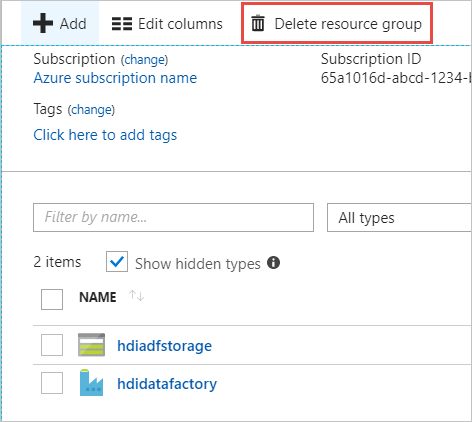

Vyčištění prostředků

Při vytváření clusteru HDInsight na vyžádání nemusíte cluster HDInsight explicitně odstraňovat. Cluster se odstraní na základě konfigurace, kterou jste zadali při vytváření kanálu. I po odstranění clusteru budou účty úložiště přidružené ke clusteru nadále existovat. Toto chování je záměrně, abyste mohli zachovat data beze změny. Pokud ale nechcete zachovat data, můžete odstranit účet úložiště, který jste vytvořili.

Nebo můžete odstranit celou skupinu prostředků, kterou jste vytvořili pro účely tohoto kurzu. Tento proces odstraní účet úložiště a službu Azure Data Factory, kterou jste vytvořili.

Odstranění skupiny prostředků

Přihlaste se k portálu Azure Portal.

V levém podokně vyberte skupiny prostředků.

Vyberte název skupiny prostředků, kterou jste vytvořili ve skriptu PowerShellu. Filtr použijte, pokud máte v seznamu příliš mnoho skupin prostředků. Otevře skupinu prostředků.

Na dlaždici Prostředky budete mít výchozí účet úložiště a datovou továrnu uvedenou, pokud skupinu prostředků nesdílíte s jinými projekty.

Vyberte Odstranit skupinu prostředků. Tím se odstraní účet úložiště a data uložená v účtu úložiště.

Zadejte název skupiny prostředků, abyste potvrdili odstranění, a pak vyberte Odstranit.

Další kroky

V tomto článku jste zjistili, jak pomocí služby Azure Data Factory vytvořit cluster HDInsight na vyžádání a spustit úlohy Apache Hive. V dalším článku se dozvíte, jak vytvářet clustery HDInsight s vlastní konfigurací.

Váš názor

Připravujeme: V průběhu roku 2024 budeme postupně vyřazovat problémy z GitHub coby mechanismus zpětné vazby pro obsah a nahrazovat ho novým systémem zpětné vazby. Další informace naleznete v tématu: https://aka.ms/ContentUserFeedback.

Odeslat a zobrazit názory pro