Katalog modelů a kolekce

Katalog modelů v studio Azure Machine Learning je centrem pro zjišťování a používání široké škály modelů, které umožňují vytvářet aplikace Generative AI. Katalog modelů nabízí stovky modelů od poskytovatelů modelů, jako je služba Azure OpenAI, Mistral, Meta, Cohere, NVIDIA, Hugging Face, včetně modelů natrénovaných Microsoftem. Modely od jiných poskytovatelů než Microsoft jsou produkty jiné společnosti než Microsoft, jak jsou definovány v podmínkách produktů společnosti Microsoft, a podléhají podmínkám poskytnutým s modelem.

Kolekce modelů

Modely jsou uspořádané podle kolekcí v katalogu modelů. V katalogu modelů existují tři typy kolekcí:

- Modely kurátorované službou Azure AI: Nejoblíbenější otevřené modely a modely propriety třetích stran zabalené a optimalizované tak, aby bez problémů fungovaly na platformě Azure AI. Použití těchto modelů podléhá licenčním podmínkám poskytovatele modelu, které jsou s modelem poskytovány. Při nasazení v Azure Machine Learning se dostupnost modelu vztahuje na příslušnou smlouvu Azure SLA a Microsoft poskytuje podporu v případě problémů s nasazením. Modely od partnerů, jako je Meta, NVIDIA, Mistral AI, jsou příklady modelů dostupných v kolekci Kurátorované podle Azure AI v katalogu. Tyto modely je možné identifikovat zelenou zaškrtávací značkou na dlaždicích modelu v katalogu, nebo je můžete filtrovat podle kolekce Kurátorované podle Azure AI.

- Modely Azure OpenAI, které jsou výhradně dostupné v Azure: Vlajkové modely Azure OpenAI prostřednictvím kolekce Azure OpenAI prostřednictvím integrace se službou Azure OpenAI. Microsoft tyto modely podporuje a jejich použití podléhá podmínkám produktu a smlouvy SLA pro službu Azure OpenAI.

- Otevřené modely z centra Hugging Face: Stovky modelů z centra HuggingFace jsou přístupné prostřednictvím kolekce Hugging Face pro odvozování online koncových bodů v reálném čase. Hugging face vytváří a udržuje modely uvedené v kolekci HuggingFace. Pokud potřebujete pomoc, použijte fórum HuggingFace nebo podporu HuggingFace. Přečtěte si další informace o tom, jak nasadit modely z Hugging Face.

Návrhy přidání do katalogu modelů: Pomocí tohoto formuláře můžete odeslat žádost o přidání modelu do katalogu modelů.

Přehled možností katalogu modelů

Informace o modelech Azure OpenAI se nachází v článku Služba Azure OpenAI.

U modelů kurátorovaných pomocí Azure AI a modelů Open z centra Hugging Face je možné některé z nich nasadit s možností spravovaného výpočetního prostředí a některé z nich je možné nasadit pomocí bezserverových rozhraní API s průběžnými platbami. Tyto modely je možné zjistit, porovnat, vyhodnotit, jemně vyladit (pokud je to podporováno) a nasadit ve velkém měřítku a integrovat je do aplikací Generative AI se zabezpečením a zásadami správného řízení dat na podnikové úrovni.

- Zjištění: Kontrola karet modelu, vyzkoušení ukázkového odvozování a procházení ukázek kódu k vyhodnocení, vyladění nebo nasazení modelu.

- Porovnání: Porovnání srovnávacích testů napříč modely a datovými sadami dostupnými v odvětví za účelem posouzení toho, která z nich vyhovuje vašemu obchodnímu scénáři.

- Vyhodnocení: Vyhodnoťte, jestli je model vhodný pro vaši konkrétní úlohu, a to poskytnutím vlastních testovacích dat. Metriky vyhodnocení usnadňují vizualizaci toho, jak dobře vybraný model ve vašem scénáři fungoval.

- Vyladění: Přizpůsobte si jemně vyladěné modely pomocí vlastních trénovacích dat a vyberte nejlepší model porovnáním metrik napříč všemi vašimi jemně vyladěnými úlohami. Integrované optimalizace urychlují vyladění a snižují paměť a výpočetní prostředky potřebné k vyladění.

- Nasazení: Nasaďte předem natrénované modely nebo jemně vyladěné modely pro odvozování. Můžete také stáhnout modely, které je možné nasadit do spravovaných výpočetních prostředků.

Nasazení modelu: Spravované výpočetní a bezserverové rozhraní API (průběžné platby)

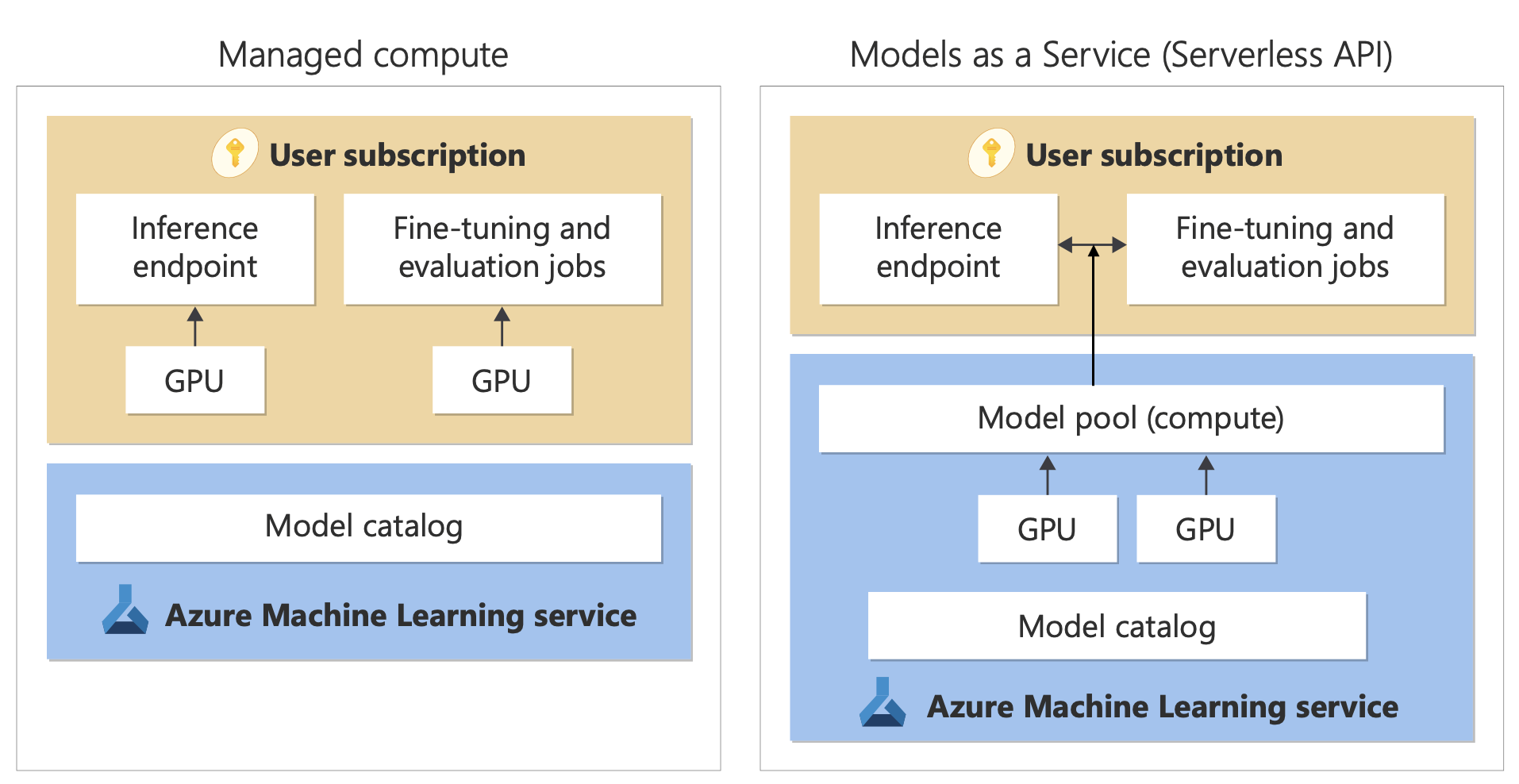

Katalog modelů nabízí dva různé způsoby nasazení modelů z katalogu pro vaše použití: spravovaná výpočetní prostředí a bezserverová rozhraní API. Možnosti nasazení dostupné pro každý model se liší. Další informace o funkcích možností nasazení a možnostech dostupných pro konkrétní modely najdete v následujících tabulkách. Přečtěte si další informace o zpracování dat pomocí možností nasazení.

| Funkce | Spravované výpočetní prostředky | Bezserverové rozhraní API (průběžné platby) |

|---|---|---|

| Prostředí nasazení a fakturace | Váhy modelu se nasazují do vyhrazených virtuálních počítačů se spravovanými online koncovými body. Spravovaný online koncový bod, který může mít jedno nebo více nasazení, zpřístupňuje rozhraní REST API pro odvozování. Účtují se vám hodiny jádra virtuálního počítače používané nasazením. | Přístup k modelům probíhá prostřednictvím nasazení, které zřídí rozhraní API pro přístup k modelu. Rozhraní API poskytuje přístup k modelu hostovaného v centrálním fondu GPU spravovaném společností Microsoft pro odvozování. Tento režim přístupu se označuje jako „Modely jako služba“. Fakturujete za vstupy a výstupy rozhraní API, obvykle v tokenech; informace o cenách jsou k dispozici před nasazením. |

| Ověřování API | Ověřování Microsoft Entra ID uživatele robota Další informace. | Jenom klíče. |

| Bezpečnost obsahu | Použijte rozhraní API služby zabezpečení obsahu Azure. | Filtry zabezpečení obsahu Azure AI jsou k dispozici integrované s rozhraními API pro odvození. Filtry zabezpečení obsahu Azure AI se můžou účtovat samostatně. |

| Izolace sítě | Spravovaná virtuální síť s koncovými body online. Další informace. |

Možnosti nasazení

| Model | Spravované výpočetní prostředky | Bezserverové rozhraní API (průběžné platby) |

|---|---|---|

| Rodinné modely Llama | Llama-3.3-70B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-3-8B Llama-3-70B |

Llama-3.3-70B-Instruct Llama-3-70B-Instruct Llama-3-8B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Modely řady Mistral | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Ministral-3B Mistral-Nemo |

| Modely rodiny cohere | Není k dispozici | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual Cohere-rerank-v3-english Cohere-rerank-v3-multilingual |

| JAIS | Není k dispozici | jais-30b-chat |

| Modely rodiny Phi-3 | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct |

| Nixtla | Není k dispozici | TimeGEN-1 |

| Další modely | dostupný | Není k dispozici |

Spravované výpočetní prostředky

Možnost nasazení modelů se spravovanými výpočetními prostředky vychází z možností platformy služby Azure Machine Learning, která umožňuje bezproblémovou integraci v celém životním cyklu GenAIOps (někdy označované jako LLMOps) široké kolekce modelů v katalogu modelů.

Jak jsou modely zpřístupněné pro spravované výpočetní prostředky?

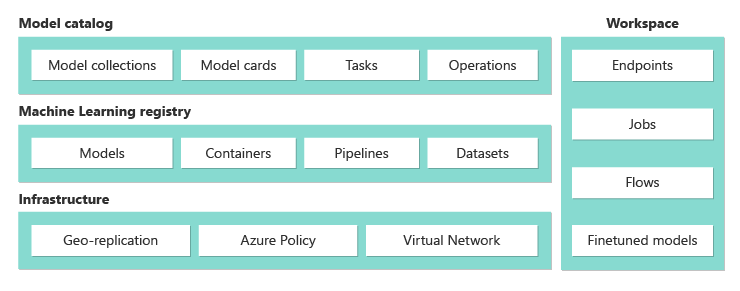

Modely jsou dostupné prostřednictvím registrů Azure Machine Learning, které umožňují první přístup ML k hostování a distribuci prostředků machine Learning, jako jsou váhy modelů, moduly runtime kontejnerů pro spouštění modelů, kanály pro vyhodnocení a vyladění modelů a datových sad pro srovnávací testy a ukázky. Tyto registry ML vycházejí z vysoce škálovatelné a podnikové infrastruktury, která:

Poskytuje artefakty modelu s nízkou latencí do všech oblastí Azure s integrovanou geografickou replikací.

Podporuje podnikové požadavky na zabezpečení, protože omezuje přístup k modelům pomocí služby Azure Policy a zabezpečené nasazení se spravovanými virtuálními sítěmi.

Vyhodnocení a vyladění modelů nasazených pomocí spravovaných výpočetních prostředků

Ve službě Azure Machine Learning můžete vyhodnotit a doladit kolekci Kurátorované podle Azure AI pomocí kanálů služby Azure Machine Learning. Můžete si buď zvolit vlastní vyhodnocení a vyladění kódu a získat přístup k váhám modelu, nebo použít komponenty služby Azure Machine Learning, které nabízejí integrované možnosti vyhodnocení a vyladění. Další informace najdete na tomto odkazu.

Nasazení modelů pro odvozování pomocí spravovaných výpočetních prostředků

Modely dostupné pro nasazení se spravovanými výpočetními prostředky je možné nasadit do online koncových bodů služby Azure Machine Learning pro odvozování v reálném čase nebo je možné je použít k odvozování dávky služby Azure Machine Learning k dávkovému zpracování dat. Nasazení do spravovaného výpočetního prostředí vyžaduje, abyste ve svém předplatném Azure měli kvótu virtuálních počítačů pro konkrétní skladové položky potřebné k optimálnímu spuštění modelu. Některé modely umožňují nasadit dočasně sdílenou kvótu pro testování modelu. Další informace o nasazování modelů:

- Nasazení modelů Meta Llama

- Nasazení otevřených modelů vytvořených službou Azure AI

- Nasazení modelů Hugging Face

Vytváření aplikací generující AI se spravovanými výpočetními prostředky

Tok instrukcí nabízí možnosti pro vytváření prototypů, experimentování, iterace a nasazování aplikací AI. Pomocí nástroje Open Model LLM můžete použít modely nasazené se spravovanými výpočetními prostředky ve službě Tok instrukcí. Rozhraní REST API vystavené spravovanými výpočetními prostředky můžete použít také v oblíbených nástrojích LLM, jako je LangChain, s rozšířením Azure Machine Learning.

Bezpečnost obsahu pro modely nasazené se spravovanými výpočetními prostředky

Služba Azure AI Content Safety (AACS) je k dispozici pro použití s modely nasazenými pro spravované výpočetní prostředky pro vyhledávání různých kategorií škodlivého obsahu, jako je sexuální obsah, násilí, nenávist a sebepoškozování a pokročilé hrozby, jako je detekce rizik jailbreaku a detekce chráněného textu. V tomto poznámkovém bloku najdete referenční integraci se službou AACS pro Llama 2 nebo pomocí nástroje Zabezpečení obsahu (Text) v toku výzvy předat odpovědi z modelu do AACS pro účely screeningu. Za toto použití se vám budou účtovat samostatně podle cen AACS.

Práce s modely, které nejsou v katalogu modelů

Pro modely, které nejsou dostupné v katalogu modelů, poskytuje Azure Machine Learning otevřenou a rozšiřitelnou platformu pro práci s modely podle vašeho výběru. Model můžete přenést s libovolnou architekturou nebo modulem runtime pomocí otevřených a rozšiřitelných funkcí platformy Azure Machine Learning, jako jsou prostředí Azure Machine Learning pro kontejnery, které můžou zabalit architektury a moduly runtime a kanály Azure Machine Learning pro účely vyhodnocování nebo vyladění modelů. V tomto poznámkovém bloku najdete ukázkové referenční informace k importu modelů a práci s integrovanými moduly runtime a kanály.

Bezserverová rozhraní API s průběžnými platbami

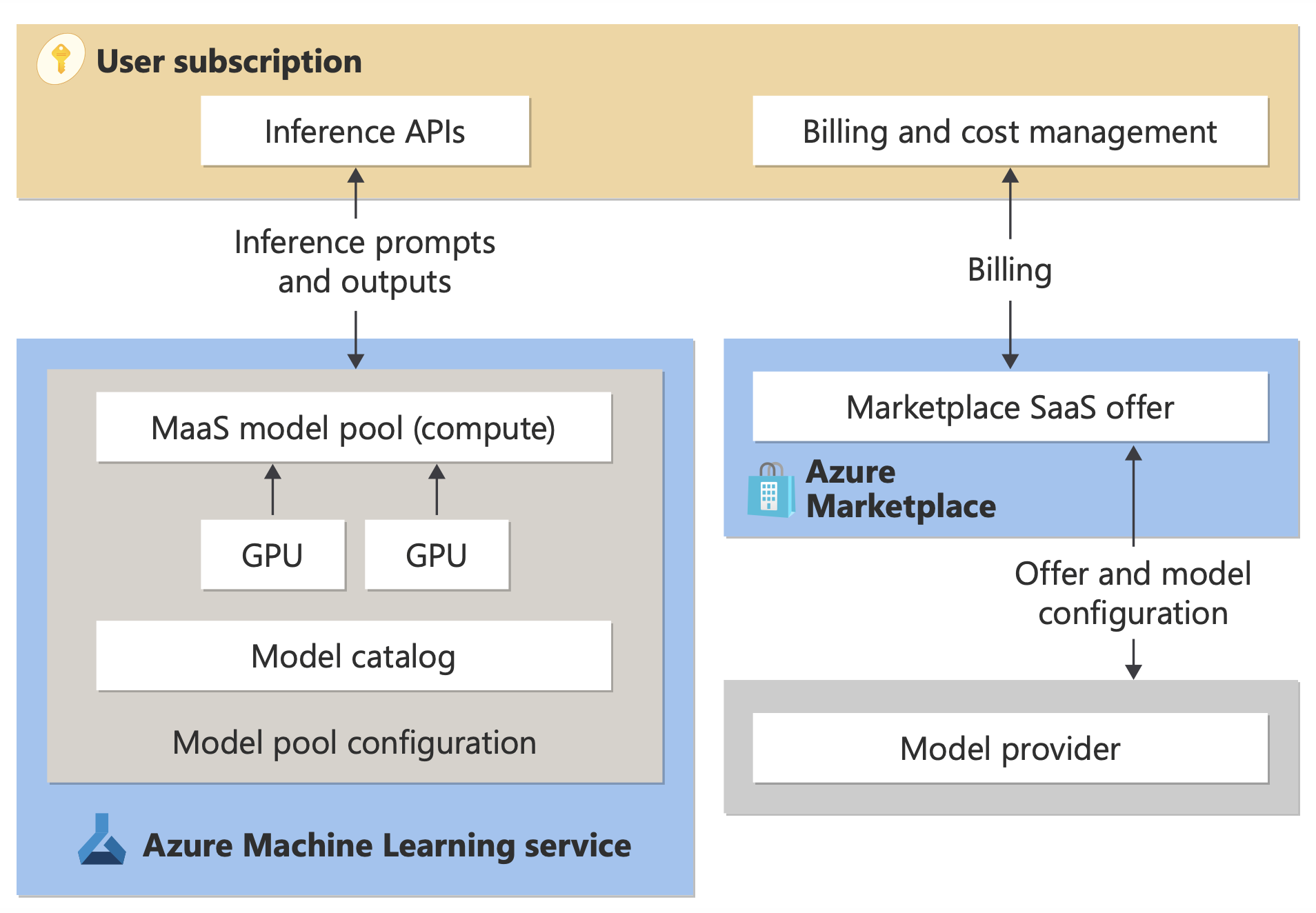

Některé modely v katalogu modelů je možné nasadit jako bezserverová rozhraní API s průběžnými platbami; tato metoda nasazení se nazývá Models-as-a Service (MaaS). Modely dostupné prostřednictvím MaaS jsou hostované v infrastruktuře spravované Microsoftem, což umožňuje přístup na základě rozhraní API k modelu poskytovatele modelu. Přístup založený na rozhraní API může výrazně snížit náklady na přístup k modelu a výrazně zjednodušit prostředí zřizování. Většina modelů MaaS má ceny založené na tokenech.

Jak jsou modely třetích stran dostupné v MaaS?

Modely, které jsou k dispozici pro nasazení jako bezserverová rozhraní API s fakturací s průběžnými platbami, nabízí poskytovatel modelu, ale hostují se v infrastruktuře Azure spravované společností Microsoft a přistupuje se k nim prostřednictvím rozhraní API. Poskytovatelé modelů definují licenční podmínky a nastavují cenu pro použití svých modelů, zatímco služba Azure Machine Learning spravuje infrastrukturu hostování, zpřístupňuje rozhraní API pro odvozování a funguje jako zpracovatel dat pro výzvy odeslané a výstup obsahu podle modelů nasazených prostřednictvím MaaS. Další informace o zpracování dat pro MaaS najdete v článku o ochraně osobních údajů .

Platba za využití modelu v MaaS

Prostředí zjišťování, předplatného a spotřeby pro modely nasazené prostřednictvím MaaS je na portálu Azure AI Foundry a studio Azure Machine Learning. Uživatelé přijímají licenční podmínky pro použití modelů a informace o cenách pro spotřebu se poskytují během nasazování. Modely od poskytovatelů třetích stran se účtují prostřednictvím Azure Marketplace v souladu s podmínkami použití na komerčním marketplace. Modely od Microsoftu se účtují pomocí měřičů Azure jako služeb consumption první strany. Jak je popsáno v podmínkách produktu, služby consumption první strany se kupují pomocí měřičů Azure, ale nejsou předmětem podmínek služeb Azure. Použití těchto modelů podléhá poskytnutým licenčním podmínkám.

Nasazení modelů pro odvozování prostřednictvím MaaS

Nasazení modelu prostřednictvím MaaS umožňuje uživatelům získat přístup k rozhraním API pro odvozování, aniž by museli konfigurovat infrastrukturu nebo zřizovat GPU, což šetří čas a prostředky přípravy. Tato rozhraní API je možné integrovat s několika nástroji LLM a využití se účtuje, jak je popsáno v předchozí části.

Vyladění modelů prostřednictvím MaaS s průběžnými platbami

U modelů, které jsou dostupné prostřednictvím MaaS a podporují vyladění, můžou uživatelé využít hostované vyladění s průběžnými platbami a přizpůsobit modely pomocí dat, která poskytují. Další informace najdete v podrobném ladění modelu Llama 2 na portálu Azure AI Foundry.

RAG s modely nasazenými prostřednictvím MaaS

Azure AI Foundry umožňuje uživatelům využívat vektorové indexy a rozšířené generování. Modely, které je možné nasadit jako bezserverová rozhraní API, je možné použít ke generování vkládání a odvozování na základě vlastních dat k vygenerování odpovědí specifických pro jejich případ použití. Další informace najdete v tématu Načítání rozšířené generace a indexů.

Regionální dostupnost nabídek a modelů

Fakturace PPay as-you-go je dostupná jenom uživatelům, jejichž předplatné Azure patří do fakturačního účtu v zemi nebo oblasti, kde poskytovatel modelu nabídku zpřístupnil. Pokud je nabídka dostupná v příslušné oblasti, musí mít uživatel v oblasti Azure centrum nebo projekt, ve které je model dostupný pro nasazení nebo vyladění podle potřeby. Podrobné informace najdete v tématu Dostupnost oblastí pro modely v koncových bodech bezserverového rozhraní API.

Bezpečnost obsahu pro modely nasazené prostřednictvím MaaS

Důležité

Tato funkce je v současné době ve verzi Public Preview. Tato verze Preview je poskytována bez smlouvy o úrovni služeb a nedoporučujeme ji pro produkční úlohy. Některé funkce se nemusí podporovat nebo mohou mít omezené možnosti.

Další informace najdete v dodatečných podmínkách použití pro verze Preview v Microsoft Azure.

U jazykových modelů nasazených prostřednictvím bezserverových rozhraní API azure AI implementuje výchozí konfiguraci filtrů moderování obsahu Azure AI , které detekují škodlivý obsah, jako je nenávist, sebeškodné, sexuální a násilné obsah. Další informace o filtrování obsahu (Preview) najdete v tématu Kategorie Poškození v Azure AI Content Safety.

Tip

Filtrování obsahu (Preview) není k dispozici pro určité typy modelů nasazené prostřednictvím bezserverových rozhraní API. Mezi tyto typy modelů patří vkládání modelů a modelů časových řad.

Filtrování obsahu (Preview) probíhá synchronně, protože služba vyzve k vygenerování obsahu. Za takové použití se vám můžou účtovat samostatně podle cen služby Azure AI Content Safety. Filtrování obsahu (Preview) můžete zakázat pro jednotlivé koncové body bez serveru:

- V době, kdy poprvé nasadíte jazykový model

- Později výběrem přepínače filtrování obsahu na stránce podrobností nasazení

Předpokládejme, že se rozhodnete použít jiné rozhraní API než rozhraní API pro odvozování modelů Azure AI k práci s modelem nasazeným prostřednictvím bezserverového rozhraní API. V takové situaci není filtrování obsahu (Preview) povolené, pokud ho neimplementujete samostatně pomocí služby Azure AI Content Safety.

Pokud chcete začít pracovat se službou Azure AI Content Safety, přečtěte si rychlý start: Analýza textového obsahu. Pokud při práci s modely nasazenými prostřednictvím bezserverových rozhraní API nepoužíváte filtrování obsahu (Preview), hrozí vyšší riziko vystavení uživatelů škodlivému obsahu.

Izolace sítě pro modely nasazené prostřednictvím bezserverových rozhraní API

Koncové body pro modely nasazené jako bezserverová rozhraní API se řídí nastavením příznaku PNA (Public Network Access) pracovního prostoru, ve kterém existuje nasazení. Pokud chcete zabezpečit koncový bod MaaS, zakažte ve svém pracovním prostoru příznak PNA. Příchozí komunikaci z klienta do koncového bodu můžete zabezpečit pomocí privátního koncového bodu pro pracovní prostor.

Nastavení příznaku PNA pro pracovní prostor:

- Přejděte na Azure Portal.

- Vyhledejte Azure Machine Learning a v seznamu pracovních prostorů vyberte svůj pracovní prostor.

- Na stránce Přehled přejděte pomocí levého navigačního podokna na Nastavení>sítě.

- Na kartě Veřejný přístup můžete nakonfigurovat nastavení příznaku přístupu k veřejné síti.

- Uložte provedené změny. Rozšíření změn může trvat až pět minut.

Omezení

- Pokud máte pracovní prostor s privátním koncovým bodem vytvořeným před 11. červencem 2024, nové koncové body MaaS přidané do tohoto pracovního prostoru nebudou dodržovat konfiguraci sítě. Místo toho musíte vytvořit nový privátní koncový bod pro pracovní prostor a vytvořit nová nasazení bezserverového rozhraní API v pracovním prostoru, aby nová nasazení mohly postupovat podle konfigurace sítě pracovního prostoru.

- Pokud máte pracovní prostor s nasazeními MaaS vytvořenými před 11. červencem 2024 a v tomto pracovním prostoru povolíte privátní koncový bod, stávající nasazení MaaS nebudou dodržovat konfiguraci sítě pracovního prostoru. Pro nasazení bezserverového rozhraní API v pracovním prostoru tak, aby postupovala podle konfigurace pracovního prostoru, musíte nasazení vytvořit znovu.

- V současné době není podpora pro vaše data dostupná pro nasazení MaaS v privátních pracovních prostorech, protože soukromé pracovní prostory mají zakázaný příznak PNA.

- Rozšíření jakékoli změny konfigurace sítě (například povolení nebo zakázání příznaku PNA) může trvat až pět minut.