Poznámka:

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

Funkce OPENROWSET(BULK...) umožňuje přístup k souborům ve službě Azure Storage.

OPENROWSET funkce čte obsah vzdáleného zdroje dat (například souboru) a vrací obsah jako sadu řádků. V rámci prostředku bezserverového fondu SQL se k poskytovateli hromadné sady řádků OPENROWSET přistupuje voláním funkce OPENROWSET a zadáním možnosti BULK.

Na OPENROWSET funkci lze odkazovat v FROM klauzuli dotazu, jako by se jednalo o název OPENROWSETtabulky . Podporuje hromadné operace prostřednictvím integrovaného zprostředkovatele BULK, který umožňuje čtení a vracení dat ze souboru jako sadu řádků.

Poznámka:

Funkce OPENROWSET není ve vyhrazeném fondu SQL podporovaná.

Zdroj dat

Funkce OPENROWSET v Synapse SQL čte obsah souborů ze zdroje dat. Zdroj dat je účet úložiště Azure, na který se dá explicitně odkazovat ve OPENROWSET funkci, nebo se může dynamicky odvozovat z adresy URL souborů, které chcete číst.

Funkce OPENROWSET může volitelně obsahovat DATA_SOURCE parametr pro určení zdroje dat, který obsahuje soubory.

OPENROWSETlze použít bezDATA_SOURCEk přímému čtení obsahu souborů z umístění adresy URL určeného pomocí možnostiBULK.SELECT * FROM OPENROWSET(BULK 'http://<storage account>.dfs.core.windows.net/container/folder/*.parquet', FORMAT = 'PARQUET') AS [file]

Jedná se o rychlý a snadný způsob, jak číst obsah souborů bez předkonfigurace. Tato možnost umožňuje použít možnost základního ověřování heslem pro přístup k úložišti (předávání ověřování Microsoft Entra pro přihlášení Microsoft Entra a token SAS pro přihlášení SQL).

OPENROWSETlze použít pro přístup k souborům v zadaném účtu úložiště:SELECT * FROM OPENROWSET(BULK '/folder/*.parquet', DATA_SOURCE='storage', --> Root URL is in LOCATION of DATA SOURCE FORMAT = 'PARQUET') AS [file]Tato možnost umožňuje nakonfigurovat umístění účtu úložiště ve zdroji dat a zadat metodu ověřování, která se má použít pro přístup k úložišti.

Důležité

OPENROWSETbezDATA_SOURCEposkytuje rychlý a snadný způsob přístupu k souborům úložiště, avšak nabízí omezené možnosti ověřování. Například uživatelé Microsoft Entra mají přístup k souborům pouze pomocí své identity Microsoft Entra nebo k veřejně dostupným souborům. Pokud potřebujete výkonnější možnosti ověřování, použijteDATA_SOURCEmožnost a definujte přihlašovací údaje, které chcete použít pro přístup k úložišti.

Zabezpečení

Uživatel databáze musí mít ADMINISTER BULK OPERATIONS oprávnění k používání OPENROWSET funkce.

Správce úložiště musí také uživateli povolit přístup k souborům zadáním platného tokenu SAS nebo povolením instančního objektu Microsoft Entra pro přístup k souborům úložiště. Další informace o řízení přístupu k úložišti najdete v tomto článku.

OPENROWSET Pomocí následujících pravidel určete, jak se ověřit v úložišti:

- Mechanismus ověřování v

OPENROWSET, pokud neníDATA_SOURCE, závisí na typu volajícího.- Každý uživatel může používat

OPENROWSETbezDATA_SOURCEčtení veřejně dostupných souborů v úložišti Azure. - Přihlášení Microsoft Entra mohou přistupovat k chráněným souborům pomocí své vlastní identity Microsoft Entra, pokud Azure Storage umožňuje uživateli Microsoft Entra přístup k podkladovým souborům (například pokud má uživatel

Storage Readeroprávnění k úložišti Azure). - Přihlášení SQL mohou také používat

OPENROWSETbezDATA_SOURCEpro přístup k veřejně dostupným souborům, souborům chráněným pomocí tokenu SAS nebo spravovanou identitu pracovního prostoru Synapse. K umožnění přístupu k souborům úložiště potřebujete vytvořit přihlašovací údaje v rozsahu serveru.

- Každý uživatel může používat

- V

OPENROWSETje mechanismusDATA_SOURCEověřování definován v přihlašovacích údajích s databázovým oborem, které jsou přiřazeny k odkazovanému zdroji dat. Tato možnost umožňuje přistupovat k veřejně dostupnému úložišti nebo přistupovat k úložišti pomocí tokenu SAS, spravované identity pracovního prostoru nebo identity volajícího Microsoft Entra (pokud je volajícím instanční objekt Microsoft Entra). PokudDATA_SOURCEodkazujete na úložiště Azure, které není veřejné, budete muset vytvořit přihlašovací údaje s oborem databáze a odkazovat na nějDATA SOURCE, abyste umožnili přístup k souborům úložiště.

Volající musí mít REFERENCES oprávnění k přihlašovacím údajům, aby je mohl použít k autentizaci v úložišti.

Syntaxe

--OPENROWSET syntax for reading Parquet or Delta Lake files

OPENROWSET

( { BULK 'unstructured_data_path' , [DATA_SOURCE = <data source name>, ]

FORMAT= ['PARQUET' | 'DELTA'] }

)

[WITH ( {'column_name' 'column_type' }) ]

[AS] table_alias(column_alias,...n)

--OPENROWSET syntax for reading delimited text files

OPENROWSET

( { BULK 'unstructured_data_path' , [DATA_SOURCE = <data source name>, ]

FORMAT = 'CSV'

[ <bulk_options> ]

[ , <reject_options> ] }

)

WITH ( {'column_name' 'column_type' [ 'column_ordinal' | 'json_path'] })

[AS] table_alias(column_alias,...n)

<bulk_options> ::=

[ , FIELDTERMINATOR = 'char' ]

[ , ROWTERMINATOR = 'char' ]

[ , ESCAPECHAR = 'char' ]

[ , FIRSTROW = 'first_row' ]

[ , FIELDQUOTE = 'quote_characters' ]

[ , DATA_COMPRESSION = 'data_compression_method' ]

[ , PARSER_VERSION = 'parser_version' ]

[ , HEADER_ROW = { TRUE | FALSE } ]

[ , DATAFILETYPE = { 'char' | 'widechar' } ]

[ , CODEPAGE = { 'ACP' | 'OEM' | 'RAW' | 'code_page' } ]

[ , ROWSET_OPTIONS = '{"READ_OPTIONS":["ALLOW_INCONSISTENT_READS"]}' ]

<reject_options> ::=

{

| MAXERRORS = reject_value,

| ERRORFILE_DATA_SOURCE = <data source name>,

| ERRORFILE_LOCATION = '/REJECT_Directory'

}

Argumenty

Pro vstupní soubory, které obsahují cílová data pro dotazování, máte tři možnosti. Platné hodnoty jsou:

CSV – obsahuje libovolný textový soubor s oddělovači řádků a sloupců. Libovolný znak lze použít jako oddělovač polí, například TSV: FIELDTERMINATOR = tab.

ParqueT – binární soubor ve formátu Parquet.

DELTA – sada souborů Parquet uspořádaných ve formátu Delta Lake (Preview).

Hodnoty s prázdnými mezerami nejsou platné. Například CSV není platná hodnota.

"unstructured_data_path"

Unstructured_data_path, která vytváří cestu k datům, může být absolutní nebo relativní cesta:

- Absolutní cesta ve formátu

\<prefix>://\<storage_account_path>/\<storage_path>umožňuje uživateli přímo číst soubory. - Relativní cesta ve formátu

<storage_path>, který musí být použit s parametremDATA_SOURCEa popisuje vzor souboru v rámci <storage_account_path> umístění definovaném vEXTERNAL DATA SOURCE.

Níže najdete příslušné <cesty účtu úložiště>, které budou propojení s vaším konkrétním externím zdrojem dat.

| Externí zdroj dat | Předpona | Cesta k úložišti účtu |

|---|---|---|

| Azure Blob Storage (úložiště objektů Azure) | http[s] | < >storage_account.blob.core.windows.net/path/file |

| Azure Blob Storage (úložiště objektů Blob Azure) | wasb[s] | <container>@<storage_account.blob.core.windows.net/path/file> |

| Azure Data Lake Store Gen1 | http[s] | < >storage_account.azuredatalakestore.net/webhdfs/v1 |

| Azure Data Lake Store Gen2 | http[s] | < >storage_account.dfs.core.windows.net/path/file |

| Azure Data Lake Store Gen2 | abfs[s] | <file_system>@<account_name>.dfs.core.windows.net/path/file |

"<cesta_úložiště>"

Určuje cestu v úložišti, která odkazuje na složku nebo soubor, který chcete přečíst. Pokud cesta odkazuje na kontejner nebo složku, budou všechny soubory načteny z tohoto konkrétního kontejneru nebo složky. Soubory v podsložkách nebudou zahrnuty.

Pomocí zástupných znaků můžete cílit na více souborů nebo složek. Je povoleno použití více nekonekutivních zástupných znaků.

Níže je příklad, který čte všechny soubory CSV začínající populacíze všech složek počínaje /csv/population:

https://sqlondemandstorage.blob.core.windows.net/csv/population*/population*.csv

Pokud zadáte unstructured_data_path jako složku, dotaz bezserverového fondu SQL načte soubory z této složky.

Můžete povolit bezserverovému fondu SQL procházet složky zadáním /* na konci cesty, například: https://sqlondemandstorage.blob.core.windows.net/csv/population/**

Poznámka:

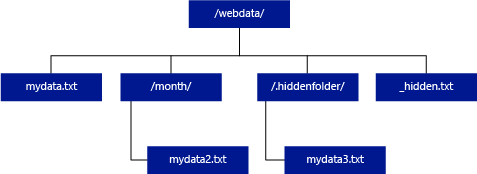

Na rozdíl od Hadoopu a PolyBase bezserverový fond SQL nevrací podsložky, pokud na konci cesty nezadáte /**. Stejně jako Hadoop a PolyBase nevrací soubory, pro které název souboru začíná podtržením (_) nebo tečkou (.).

Pokud v následujícím příkladu unstructured_data_path=https://mystorageaccount.dfs.core.windows.net/webdata/, dotaz fondu SQL bez serveru vrátí řádky z mydata.txt. Nevrátí mydata2.txt a mydata3.txt, protože jsou umístěné v podsložce.

[WITH ( {'column_name' 'column_type' [ 'column_ordinal'] }) ]

Klauzule WITH umožňuje zadat sloupce, které chcete číst ze souborů.

U datových souborů CSV můžete číst všechny sloupce a zadat názvy sloupců a jejich datové typy. Pokud chcete podmnožinu sloupců, vyberte sloupce z původních datových souborů s použitím řadových čísel řadově. Sloupce budou uspořádány pořadovým označením. Pokud se použije HEADER_ROW = PRAVDA, vazba sloupce se provádí podle názvu sloupce místo řadové pozice.

Tip

U souborů CSV také můžete vynechat klauzuli WITH. Datové typy se automaticky odvozí z obsahu souboru. Argument HEADER_ROW můžete použít k určení existence řádku záhlaví, ve kterém budou názvy sloupců čteny z tohoto řádku. Podrobnosti najdete v tématu Automatické zjišťování schématu.

Pro soubory Parquet nebo Delta Lake zadejte názvy sloupců, které odpovídají názvům sloupců v původních datových souborech. Sloupce budou svázány podle názvu a je rozlišována velikost písmen. Pokud je klauzule WITH vynechána, vrátí se všechny sloupce ze souborů Parquet.

Důležité

U názvů sloupců v souborech Parquet a Delta Lake se rozlišují malá a velká písmena. Pokud zadáte název sloupce s jiným použitím velkých a malých písmen, než je ve souborech, vrátí se pro tento sloupec hodnoty

NULL.

column_name = Název výstupního sloupce. Pokud existuje, tento název přepíše název sloupce ve zdrojovém souboru a název sloupce zadaný v cestě JSON. Pokud není zadaný json_path, přidá se automaticky jako $.column_name. Zkontrolujte chování json_path argumentu.

column_type = Datový typ pro výstupní sloupec. Tady se provede implicitní převod datového typu.

column_ordinal = pořadové číslo sloupce ve zdrojových souborech. Tento argument se pro soubory Parquet ignoruje, protože vazba se provádí podle názvu. Následující příklad by vrátil druhý sloupec pouze ze souboru CSV:

WITH (

--[country_code] VARCHAR (5) COLLATE Latin1_General_BIN2,

[country_name] VARCHAR (100) COLLATE Latin1_General_BIN2 2

--[year] smallint,

--[population] bigint

)

json_path = výraz cesty JSON pro sloupec nebo vnořenou vlastnost. Výchozí režim cesty je laxní.

Poznámka:

Dotaz v přísném režimu selže s chybou, pokud zadaná cesta neexistuje. V lax režimu dotaz bude úspěšný a výraz cesty JSON se vyhodnotí jako NULL.

<hromadné_možnosti>

FIELDTERMINATOR ='oddělovač_pole'

Určuje ukončovací znak pole, který se má použít. Výchozí ukončovací znak pole je čárka (",").

ROWTERMINATOR ='row_terminator''

Určuje ukončovací znak řádku, který se má použít. Pokud není zadaný ukončovací znak řádku, použije se jeden z výchozích ukončovačů. Výchozí ukončovací znaky pro PARSER_VERSION = 1.0 jsou \r\n, \n a \r. Výchozí ukončovací znaky pro PARSER_VERSION = 2.0 jsou \r\n a \n.

Poznámka:

Pokud použijete PARSER_VERSION='1.0' a jako znak konce řádku zadáte \n (nový řádek), automaticky mu předchází znak \r (návrat na začátek řádku), což vede k oddělovači řádku \r\n.

ESCAPE_CHAR = 'char'

Určuje znak v souboru, který se používá k escapování sebe sama a všech hodnot oddělovače v souboru. Pokud za řídicím znakem následuje jiná hodnota než samotná nebo jakákoli hodnota oddělovače, při čtení hodnoty se řídicí znak zahodí.

Parametr ESCAPECHAR se použije bez ohledu na to, jestli je pole FIELDQUOTE nebo není povolené. Nebude použit k úniku z uvozujícího znaku. Znak uvozování musí být escapován jiným znakem uvozování. Znak uvozování se může objevit v hodnotě sloupce pouze tehdy, pokud je hodnota uzavřena do znaků uvozování.

FIRSTROW = 'first_row'

Určuje počet prvního řádku, který se má načíst. Výchozí hodnota je 1 a označuje první řádek v zadaném datovém souboru. Čísla řádků jsou určena počítáním ukončovačů řádků. FIRSTROW je založená na 1.

FIELDQUOTE = 'field_quote'

Určuje znak, který se použije jako znak uvozovek v souboru CSV. Pokud není zadaný, použije se znak uvozovky (").

DATA_COMPRESSION = 'metoda_komprese_dat'

Určuje metodu komprese. Podporováno pouze v PARSER_VERSION='1.0'. Podporuje se následující metoda komprese:

- GZIP

PARSER_VERSION = 'parser_version'

Určuje verzi analyzátoru, která se má použít při čtení souborů. Aktuálně podporované verze analyzátoru CSV jsou 1.0 a 2.0:

- PARSER_VERSION = '1.0'

- PARSER_VERSION = '2.0'

Analyzátor CSV verze 1.0 je výchozí a je bohatý na funkce. Verze 2.0 je vytvořená pro výkon a nepodporuje všechny možnosti a kódování.

Specifika analyzátoru CSV verze 1.0:

- Následující možnosti nejsou podporované: HEADER_ROW.

- Výchozí ukončovací znaky jsou \r\n, \n a \r.

- Pokud jako ukončovací znak řádku zadáte \n (nový řádek), bude automaticky předcházen znakem \r (návrat na začátek řádku), což má za následek ukončovací znak \r\n.

Specifika analyzátoru CSV verze 2.0:

- Nepodporují se všechny datové typy.

- Maximální délka sloupce znaků je 8000.

- Maximální limit velikosti řádku je 8 MB.

- Následující možnosti nejsou podporované: DATA_COMPRESSION.

- Prázdný řetězec v uvozovkách ("") se interpretuje jako prázdný řetězec.

- Možnost DATEFORMAT SET není dodržena.

- Podporovaný formát pro datový typ DATE: RRRR-MM-DD

- Podporovaný formát pro datový typ TIME: HH:MM:SS[.zlomek sekund]

- Podporovaný formát pro datový typ DATETIME2: RRRR-MM-DD HH:MM:SS[.zlomkové sekundy]

- Výchozí ukončovací znaky jsou \r\n a \n.

HEADER_ROW = { TRUE | FALSE }

Určuje, jestli soubor CSV obsahuje řádek záhlaví. Výchozí hodnota je FALSE. podporována v PARSER_VERSION='2.0'. Pokud je hodnota TRUE, názvy sloupců se načtou z prvního řádku podle argumentu FIRSTROW. Pokud je zadána hodnota TRUE a schéma pomocí klauzule WITH, vázání názvů sloupců bude provedeno podle názvu sloupce, nikoli řadových pozic.

DATAFILETYPE = { 'char' | "widechar" }

Určuje kódování: char používá se pro UTF8, widechar slouží pro soubory UTF16.

CODEPAGE = { 'ACP' | 'OEM' | 'RAW' | 'code_page' }

Určuje znakovou stránku dat v datovém souboru. Výchozí hodnota je 65001 (kódování UTF-8). Další podrobnosti o této možnosti najdete tady.

ROWSET_OPTIONS = '{"READ_OPTIONS":["ALLOW_INCONSISTENT_READS"]}'

Tato možnost zakáže kontrolu úprav souborů během provádění dotazu a přečte soubory, které se aktualizují během spuštění dotazu. To je užitečná možnost, když potřebujete číst soubory jen pro připojení, které jsou připojeny při běhu dotazu. V doplňovatelných souborech se stávající obsah neaktualizuje a přidají se jenom nové řádky. Proto je pravděpodobnost nesprávných výsledků minimalizovaná ve srovnání s aktualizovatelnými soubory. Tato možnost vám může umožnit čtení často připojených souborů bez zpracování chyb. Další informace najdete v části dotazování na rozšiřitelné CSV soubory.

Možnosti odmítnutí

Poznámka:

Funkce odmítnutých řádků je ve verzi Public Preview. Upozorňujeme, že funkce odmítnutých řádků funguje pro textové soubory s oddělovači a PARSER_VERSION 1.0.

Můžete zadat parametry zamítnutí, které určují, jak bude služba zpracovávat nezašpiněné záznamy, které načítá z externího zdroje dat. Datový záznam se považuje za 'špinavý', pokud skutečné datové typy neodpovídají definicím sloupců vnější tabulky.

Pokud nezadáte nebo změníte možnosti zamítnutí, služba použije výchozí hodnoty. Služba použije možnosti zamítnutí k určení počtu řádků, které je možné odmítnout před selháním skutečného dotazu. Dotaz vrátí (částečné) výsledky, dokud nedojde k překročení prahové hodnoty zamítnutí. Poté selže s příslušnou chybovou zprávou.

MAXERRORS = reject_value

Určuje počet řádků, které lze odmítnout před selháním dotazu. MAXERRORS musí být celé číslo od 0 do 2 147 483 647.

ERRORFILE_DATA_SOURCE = zdroj dat

Určuje zdroj dat, kam mají být zapsány zamítnuté řádky a odpovídající chybový soubor.

ERRORFILE_LOCATION = umístění adresáře

Určuje adresář v rámci DATA_SOURCE nebo ERROR_FILE_DATASOURCE, pokud je zadán, do kterého by měly být zapsány odmítnuté řádky a odpovídající chybový soubor. Pokud zadaná cesta neexistuje, služba ji vytvoří vaším jménem. Vytvoří se podřízený adresář s názvem "rejectedrows". Znak "" zajistí, že adresář bude escapován pro jiné zpracování dat, pokud není explicitně pojmenován v parametru 'location'. V tomto adresáři existuje složka vytvořená na základě času odeslání v YearMonthDay_HourMinuteSecond_StatementID formátu (např. 20180330-173205-559EE7D2-196D-400A-806D-3BF5D007F891). ID příkazu můžete použít ke korelaci složky s dotazem, který ho vygeneroval. V této složce jsou zapsány dva soubory: error.json soubor a datový soubor.

error.json soubor obsahuje pole JSON s zjištěnými chybami souvisejícími s odmítnutými řádky. Každý prvek představující chybu obsahuje následující atributy:

| Vlastnost | Popis |

|---|---|

| Chyba | Důvod, proč je řádek zamítnut |

| Řádek | Odmítnuté pořadové číslo řádku v souboru |

| Sloupec | Odmítnuté pořadové číslo sloupce |

| Hodnota | Odmítnutá hodnota sloupce Pokud je hodnota větší než 100 znaků, zobrazí se pouze prvních 100 znaků. |

| Soubor | Cesta k souboru, do kterého řádek patří. |

Rychlá analýza textu s oddělovači

K dispozici jsou dvě verze parseru textu s oddělovači, které můžete použít. Analyzátor CSV verze 1.0 je výchozí a má bohatou funkci, zatímco analyzátor verze 2.0 je vytvořený pro zajištění výkonu. Zlepšení výkonu analyzátoru 2.0 pochází z pokročilých technik analýzy a více vláken. Rozdíl v rychlosti bude větší, jakmile poroste velikost souboru.

Automatické zjišťování schématu

Soubory CSV i Parquet můžete snadno dotazovat, aniž byste museli znát nebo zadávat schéma tak, že vynecháte klauzuli WITH. Názvy sloupců a datové typy se odvozí ze souborů.

Soubory Parquet obsahují metadata sloupců, která se budou číst, mapování typů lze najít v mapování typů pro Parquet. Zkontrolujte čtení souborů Parquet bez zadání schématu pro ukázky.

U souborů CSV je možné názvy sloupců číst z řádku záhlaví. Pomocí argumentu HEADER_ROW můžete určit, zda řádek záhlaví existuje. Pokud HEADER_ROW = FALSE, použijí se obecné názvy sloupců: C1, C2, ... Cn, kde n je počet sloupců v souboru. Datové typy budou odvozeny z prvních 100 datových řádků. Pro ukázky zkontrolujte čtení souborů CSV bez zadání schématu.

Mějte na paměti, že pokud čtete více souborů najednou, schéma bude odvozeno z prvního souboru, který služba načte z úložiště. To může znamenat, že některé z očekávaných sloupců jsou vynechány, protože soubor používaný službou k definování schématu tyto sloupce neobsahuje. V takovém případě použijte klauzuli OPENROWSET WITH.

Důležité

Existují případy, kdy nelze příslušný datový typ odvodit z důvodu nedostatku informací a místo toho se použije větší datový typ. To přináší režii na výkon a je zvláště důležité pro sloupce znaků, které budou odvozeny jako varchar(8000). Pokud chcete dosáhnout optimálního výkonu, zkontrolujte odvozené datové typy a použijte vhodné datové typy.

Mapování typů pro Parquet

Soubory Parquet a Delta Lake obsahují popisy typů pro každý sloupec. Následující tabulka popisuje, jak se typy Parquet mapují na nativní typy SQL.

| Typ Parquet | Typ Parquet (logická poznámka) | Datový typ SQL |

|---|---|---|

| BOOLEAN | bitové | |

| BINARY / BYTE_ARRAY | varbinary | |

| DVOJITÝ | float | |

| FLOAT | skutečný | |

| INT32 | int | |

| INT64 | bigint | |

| INT96 | datetime2 | |

| FIXED_LEN_BYTE_ARRAY | binární | |

| BINÁRNÍ | UTF8 | varchar *(Kolace UTF-8) |

| BINÁRNÍ | STRING | varchar *(řazení UTF8) |

| BINÁRNÍ | VÝČET | varchar *(porovnávání UTF8) |

| FIXED_LEN_BYTE_ARRAY | UUID | jedinečný identifikátor |

| BINÁRNÍ | DESETINNÝ | desetinný |

| BINÁRNÍ | JSON | varchar(8000) *(UTF8 kolace) |

| BINÁRNÍ | BSON | Nepodporováno |

| FIXED_LEN_BYTE_ARRAY | DESETINNÝ | desetinný |

| BYTE_ARRAY | INTERVAL | Nepodporováno |

| INT32 | INT(8; true) | smallint |

| INT32 | INT(16; true) | smallint |

| INT32 | INT(32; true) | int |

| INT32 | INT(8, false) | tinyint |

| INT32 | INT(16; false) | int |

| INT32 | INT(32; false) | bigint |

| INT32 | Datum | datum |

| INT32 | DESETINNÝ | desetinný |

| INT32 | ČAS (MILIS) | čas |

| INT64 | INT(64; true) | bigint |

| INT64 | INT(64; false) | decimal(20;0) |

| INT64 | DESETINNÝ | desetinný |

| INT64 | ČAS (MIKROSEKUNDY) | čas |

| INT64 | ČAS (NANOS) | Nepodporováno |

| INT64 | TIMESTAMP (normalizováno na UTC) (MILLIS / MICROS) | datetime2 |

| INT64 | TIMESTAMP (není normalizováno na utc) (MILLIS / MICROS) | bigint – nezapomeňte před převodem na hodnotu datetime explicitně upravit bigint hodnotu s ohledem na posun časového pásma. |

| INT64 | ČASOVÉ RAZÍTKO (NANOS) | Nepodporováno |

| Komplexní typ | SEZNAM | varchar(8000), serializovaný do formátu JSON |

| Komplexní typ | MAPA | varchar(8000), serializovaný do formátu JSON |

Příklady

Čtení souborů CSV bez zadání schématu

Následující příklad přečte soubor CSV, který obsahuje řádek záhlaví bez zadání názvů sloupců a datových typů:

SELECT

*

FROM OPENROWSET(

BULK 'https://pandemicdatalake.blob.core.windows.net/public/curated/covid-19/ecdc_cases/latest/ecdc_cases.csv',

FORMAT = 'CSV',

PARSER_VERSION = '2.0',

HEADER_ROW = TRUE) as [r]

Následující příklad přečte soubor CSV, který neobsahuje řádek záhlaví bez zadání názvů sloupců a datových typů:

SELECT

*

FROM OPENROWSET(

BULK 'https://pandemicdatalake.blob.core.windows.net/public/curated/covid-19/ecdc_cases/latest/ecdc_cases.csv',

FORMAT = 'CSV',

PARSER_VERSION = '2.0') as [r]

Čtení souborů Parquet bez zadání schématu

Následující příklad vrátí všechny sloupce prvního řádku ze sady dat sčítání lidu ve formátu Parquet a bez zadání názvů sloupců a datových typů:

SELECT

TOP 1 *

FROM

OPENROWSET(

BULK 'https://azureopendatastorage.blob.core.windows.net/censusdatacontainer/release/us_population_county/year=20*/*.parquet',

FORMAT='PARQUET'

) AS [r]

Čtení souborů Delta Lake bez zadání schématu

Následující příklad vrátí všechny sloupce prvního řádku ze sady dat sčítání lidu ve formátu Delta Lake a bez zadání názvů sloupců a datových typů:

SELECT

TOP 1 *

FROM

OPENROWSET(

BULK 'https://azureopendatastorage.blob.core.windows.net/censusdatacontainer/release/us_population_county/year=20*/*.parquet',

FORMAT='DELTA'

) AS [r]

Čtení konkrétních sloupců ze souboru CSV

Následující příklad vrátí pouze dva sloupce s pořadovými čísly 1 a 4 ze souborů population*.csv. Vzhledem k tomu, že v souborech není žádný řádek záhlaví, začne číst z prvního řádku:

SELECT

*

FROM OPENROWSET(

BULK 'https://sqlondemandstorage.blob.core.windows.net/csv/population/population*.csv',

FORMAT = 'CSV',

FIRSTROW = 1

)

WITH (

[country_code] VARCHAR (5) COLLATE Latin1_General_BIN2 1,

[population] bigint 4

) AS [r]

Čtení konkrétních sloupců ze souboru Parquet

Následující příklad vrátí pouze dva sloupce prvního řádku ze sady dat sčítání lidu ve formátu Parquet:

SELECT

TOP 1 *

FROM

OPENROWSET(

BULK 'https://azureopendatastorage.blob.core.windows.net/censusdatacontainer/release/us_population_county/year=20*/*.parquet',

FORMAT='PARQUET'

)

WITH (

[stateName] VARCHAR (50),

[population] bigint

) AS [r]

Určení sloupců pomocí cest JSON

Následující příklad ukazuje, jak můžete použít výrazy cesty JSON v klauzuli WITH a demonstrovat rozdíl mezi striktními a laxními režimy cesty:

SELECT

TOP 1 *

FROM

OPENROWSET(

BULK 'https://azureopendatastorage.blob.core.windows.net/censusdatacontainer/release/us_population_county/year=20*/*.parquet',

FORMAT='PARQUET'

)

WITH (

--lax path mode samples

[stateName] VARCHAR (50), -- this one works as column name casing is valid - it targets the same column as the next one

[stateName_explicit_path] VARCHAR (50) '$.stateName', -- this one works as column name casing is valid

[COUNTYNAME] VARCHAR (50), -- STATEname column will contain NULLs only because of wrong casing - it targets the same column as the next one

[countyName_explicit_path] VARCHAR (50) '$.COUNTYNAME', -- STATEname column will contain NULLS only because of wrong casing and default path mode being lax

--strict path mode samples

[population] bigint 'strict $.population' -- this one works as column name casing is valid

--,[population2] bigint 'strict $.POPULATION' -- this one fails because of wrong casing and strict path mode

)

AS [r]

Určete více souborů nebo složek v cestě BULK

Následující příklad ukazuje, jak v parametru BULK použít více cest k souborům nebo složkám:

SELECT

TOP 10 *

FROM

OPENROWSET(

BULK (

'https://azureopendatastorage.blob.core.windows.net/censusdatacontainer/release/us_population_county/year=2000/*.parquet',

'https://azureopendatastorage.blob.core.windows.net/censusdatacontainer/release/us_population_county/year=2010/*.parquet'

),

FORMAT='PARQUET'

)

AS [r]

Další kroky

Další ukázky najdete v průvodci ukládáním dat, kde se dozvíte, jak použít OPENROWSET ke čtení formátů souborů CSV, PARQUET, DELTA LAKE, a JSON. Projděte si osvědčené postupy pro dosažení optimálního výkonu. Dozvíte se také, jak uložit výsledky dotazu do Služby Azure Storage pomocí CETAS.