Poznámka:

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

Platí pro:✅ Datové inženýrství a datová věda v Microsoft Fabric

Prostředí Microsoft Fabric pro datové inženýrství a datovou vědu fungují na plně spravované výpočetní platformě Apache Spark. Tato platforma je navržená tak, aby poskytovala jedinečnou rychlost a efektivitu. U startovacích poolů můžete očekávat rychlou inicializaci relace Apache Spark, obvykle během 5 až 10 sekund, bez nutnosti ručního nastavení. Získáte také flexibilitu při přizpůsobení fondů Apache Sparku podle vašich specifických požadavků na datové inženýrství a datové vědy. Platforma umožňuje optimalizované a přizpůsobené analytické prostředí. Stručně řečeno, počáteční fond představuje rychlý způsob použití předem nakonfigurovaného Sparku, zatímco fond Spark nabízí přizpůsobení a flexibilitu.

Startovací bazény

Počáteční fondy jsou rychlým a snadným způsobem, jak ve vteřině používat Spark na platformě Microsoft Fabric. Spark relace můžete využívat okamžitě, aniž byste museli čekat, až vám Spark nastaví uzly, což vám umožní dělat více s daty a rychleji získávat poznatky.

Spouštěcí fondy mají clustery Apache Spark s relacemi, které jsou vždy aktivní a připravené pro vaše požadavky. Používají střední uzly, které se dynamicky škálují na základě vašich potřeb úloh Sparku.

Pokud používáte startovací pool bez jakýchkoli závislostí knihovny nebo specifických vlastností Sparku, relace obvykle začíná za 5 až 10 sekund. Toto rychlé spuštění je možné, protože cluster je již spuštěný a nevyžaduje čas zřizování.

Poznámka:

Počáteční sady uzlů jsou podporovány pouze pro uzly střední velikosti, a výběr jakýchkoli jiných velikostí uzlů nebo přizpůsobení konfigurací výpočetních prostředků povede ke spuštění relace na vyžádání, což může trvat 2 až 5 minut.

Existuje však několik scénářů, kdy spuštění relace může trvat déle:

Máte vlastní knihovny nebo vlastnosti Sparku.

Pokud jste ve svém prostředí nakonfigurovali knihovny nebo vlastní nastavení, musí Spark relaci po vytvoření přizpůsobit. Tento proces může do doby spuštění přidat přibližně 30 sekund až 5 minut v závislosti na počtu a velikosti závislostí knihovny.Startovací fondy ve vaší oblasti jsou plně využity

Ve výjimečných případech můžou být počáteční fondy oblastí dočasně vyčerpány kvůli vysokému provozu. Když k tomu dojde, Fabric spustí nový cluster tak, aby vyhovoval vašemu požadavku, což trvá přibližně 2 až 5 minut. Jakmile bude nový cluster dostupný, spustí se relace. Pokud máte k instalaci také vlastní knihovny, musíte přidat dalších 30 sekund až 5 minut potřebných pro přizpůsobení.Pokročilé síťové funkce nebo funkce zabezpečení (privátní propojení nebo spravované virtuální sítě)

Pokud má váš pracovní prostor síťové funkce, jako jsou privátní propojení tenanta nebo spravované virtuální sítě, startovací fondy nejsou podporovány. V této situaci musí Fabric vytvořit cluster na vyžádání, který přidá 2 až 5 minut do doby spuštění relace. Pokud máte také závislosti na knihovnách, může tento krok přizpůsobení znovu přidat dalších 30 sekund až 5 minut.

Tady je několik ukázkových scénářů, které ilustrují potenciální časy spuštění:

| Scénář | Typický čas spuštění |

|---|---|

| Výchozí nastavení, žádné knihovny | 5 – 10 sekund |

| Výchozí nastavení + závislosti knihovny | 5 – 10 sekund + 30 sekund – 5 min (pro nastavení knihovny) |

| Vysoký provoz v oblasti, žádné knihovny | 2 – 5 minut |

| Vysoký provoz + závislosti knihoven | 2 – 5 minut + 30 sekund – 5 min (pro knihovny) |

| Zabezpečení sítě (privátní propojení/ virtuální síť), žádné knihovny | 2 – 5 minut |

| Zabezpečení sítě + závislosti knihoven | 2 – 5 minut + 30 sekund – 5 min (pro knihovny) |

Pokud jde o fakturaci a spotřebu kapacity, účtuje se vám spotřeba kapacity při spuštění poznámkového bloku nebo definice úlohy Apache Spark. Za dobu nečinnosti clusterů ve fondu vám nejsou účtovány poplatky.

Pokud například odešlete úlohu poznámkového bloku do počátečního fondu, účtuje se vám jenom časové období, ve kterém je relace poznámkového bloku aktivní. Fakturovaný čas nezahrnuje dobu nečinnosti ani čas potřebný k přizpůsobení relace s kontextem Sparku. Další informace najdete v tématu konfigurace počátečních poolů v Fabric.

Fondy úloh Sparku

Fond Sparku je způsob, jak sparku sdělit, jaký druh prostředků potřebujete pro úlohy analýzy dat. Můžete pojmenovat pool Sparku a zvolit, kolik uzlů a jak velké tyto uzly (počítače, které dělají práci) mají být. Sparku také můžete říct, jak upravit počet uzlů v závislosti na tom, kolik práce máte. Vytvoření fondu Sparku je zdarma; platíte jenom v případě, že ve fondu spustíte úlohu Sparku a pak Spark nastaví uzly za vás.

Pokud fond Spark nepoužíváte 2 minuty po vypršení platnosti relace, váš fond Spark bude deallocován. Toto výchozí časové období vypršení platnosti relace je nastavené na 20 minut a pokud chcete, můžete ho změnit. Pokud jste správcem pracovního prostoru, můžete také vytvořit vlastní fondy Sparku pro váš pracovní prostor a nastavit je jako výchozí pro ostatní uživatele. Díky tomu můžete ušetřit čas a vyhnout se nastavení nového fondu Spark při každém spuštění poznámkového bloku nebo úlohy Sparku. Spuštění uživatelských poolů Spark trvá přibližně tři minuty, protože Spark musí získat uzly z Azure.

Můžete dokonce vytvořit fondy Spark s jedním uzlem nastavením minimálního počtu uzlů na jeden, takže ovladač a executor běží v jednom uzlu, který je součástí prostředí s obnovitelnou vysokou dostupností a je přizpůsobený pro malé úlohy.

Velikost a počet uzlů, které můžete mít ve vlastním fondu Sparku, závisí na vaší kapacitě Microsoft Fabric. Kapacita je míra výpočetního výkonu, který můžete použít v Azure. Jedním ze způsobů, jak si to představit, je, že dvě virtuální jádra Apache Sparku (jednotka výpočetního výkonu Sparku) se rovná jedné kapacitní jednotce.

Poznámka:

V Apache Sparku uživatelé získají dvě virtuální jádra Apache Sparku pro každou jednotku kapacity, kterou si rezervují jako součást své skladové položky. Jedna jednotka kapacity = dvě virtuální jádra Sparku, takže F64 => 128 virtuálních jader Sparku a na kterých se použije 3x burstový násobitel, který poskytuje celkem 384 virtuálních jader Sparku

Skladová položka kapacity Fabric F64 má například 64 jednotek kapacity, což odpovídá 384 virtuálním jádrům Sparku (64 × 2 × 3X Burst Multiplier). Pomocí těchto virtuálních jader Sparku můžete vytvořit uzly různých velikostí pro vlastní fond Sparku, pokud celkový počet virtuálních jader Sparku nepřekračuje 384.

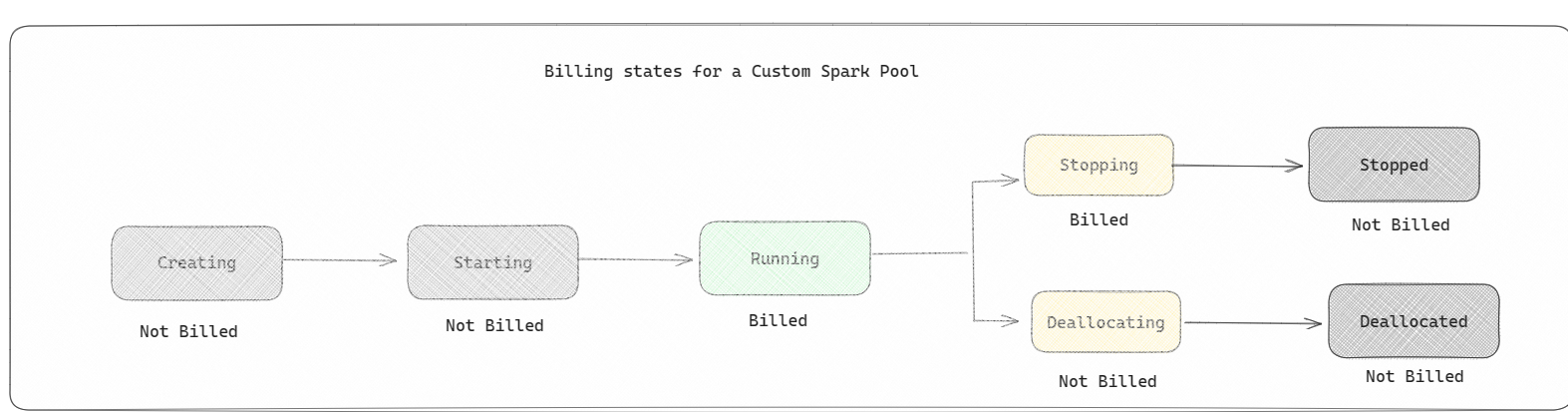

Fondy Sparku se účtují jako počáteční fondy; Za vlastní fondy Sparku, které jste vytvořili, neplatíte, pokud nemáte vytvořenou aktivní relaci Sparku pro spuštění poznámkového bloku nebo definice úlohy Sparku. Účtujeme vám pouze dobu skutečného běhu úlohy. Po dokončení úlohy vám nebudou účtovány činnosti, jako je vytvoření a uvolnění clusteru.

Pokud například odešlete úlohu poznámkového bloku do vlastního fondu Sparku, bude se vám účtovat jenom časové období, kdy je relace aktivní. Fakturace za danou relaci poznámkového bloku se zastaví, jakmile se relace Spark zastaví nebo vyprší její platnost. Za dobu potřebnou k získání instancí clusteru z cloudu ani za dobu potřebnou k inicializaci kontextu Sparku se vám neúčtují poplatky.

Možné vlastní konfigurace fondu pro F64 na základě předchozího příkladu. Menší velikosti uzlů mají kapacitu rozloženou mezi více uzlů, takže maximální počet uzlů je vyšší. Vzhledem k tomu, že větší uzly jsou bohaté na prostředky, takže je potřeba méně uzlů:

| Skladová položka kapacity fabricu | Jednotky kapacity | Maximální Spark VCores s faktorem burstu | Velikost uzlu | Maximální počet uzlů |

|---|---|---|---|---|

| F64 | 64 | 384 | Malý | 96 |

| F64 | 64 | 384 | Střední | 48 |

| F64 | 64 | 384 | Velká | dvacet čtyři |

| F64 | 64 | 384 | X -Large | 12 |

| F64 | 64 | 384 | XX-Large | 6 |

Poznámka:

Pokud chcete vytvořit vlastní fondy, potřebujete oprávnění správce pro pracovní prostor. A správce kapacity Microsoft Fabric musí udělit oprávnění, aby správci pracovního prostoru mohli měnit velikost vlastních fondů Sparku. Další informace najdete v tématu Začínáme s uživatelskými fondy Sparku ve Fabricu.

Uzly

Instance fondu Apache Spark se skládá z jednoho hlavního uzlu a několika pracovních uzlů a v instanci Sparku může být spuštěn minimálně jeden uzel. Hlavní uzel spouští další služby pro správu, jako jsou Livy, Yarn Resource Manager, Zookeeper a ovladač Apache Spark. Všechny uzly spouštějí služby, jako je agent node a Yarn Node Manager. Všechny pracovní uzly spouští službu Apache Spark Executor.

Poznámka:

Ve Fabricu je poměr uzlů k exekutorům vždy 1:1. Při nastavování fondu je jeden uzel vyhrazen pro ovladač a zbývající uzly se používají pro exekutory. Jedinou výjimkou je konfigurace s jedním uzlem, kde jsou prostředky pro ovladač i exekutor halvovány.

Velikosti uzlů

Fond Sparku je možné definovat s velikostmi uzlů v rozsahu od malého výpočetního uzlu (se 4 virtuálními jádry a 32 GB paměti) až po dvojitý velký výpočetní uzel (s 64 virtuálními jádry a 512 GB paměti na uzel). Velikosti uzlů je možné po vytvoření fondu změnit, i když by se aktivní relace musela restartovat.

| Velikost | virtuální jádro | Memory (Paměť) |

|---|---|---|

| Malý | 4 | 32 GB |

| Střední | 8 | 64 GB |

| Velká | 16 | 128 GB |

| X -Large | 32 | 256 GB |

| XX-Large | 64 | 512 GB |

Poznámka:

Velikosti uzlů X-Large a XX-Large jsou povoleny pouze pro nezkušební Fabric SKU.

Automatické škálování

Automatické škálování fondů Apache Spark umožňuje automatické vertikální navýšení a snížení kapacity výpočetních prostředků na základě množství aktivity. Když povolíte funkci automatického škálování, nastavíte minimální a maximální počet uzlů, které se mají škálovat. Když funkci automatického škálování zakážete, počet nastavených uzlů zůstane pevný. Toto nastavení můžete po vytvoření fondu změnit, i když možná budete muset instanci restartovat.

Poznámka:

Ve výchozím nastavení je spark.yarn.executor.decommission.enabled nastaven na hodnotu true a umožňuje automatické vypnutí nevyužitých uzlů za účelem optimalizace efektivity výpočetních prostředků. Pokud je upřednostňované méně agresivní vertikální snížení kapacity, může být tato konfigurace nastavená na false.

Dynamické přidělování

Dynamické přidělování umožňuje aplikaci Apache Spark požadovat více exekutorů, pokud úlohy překračují zatížení, které můžou aktuální exekutory nést. Po dokončení úloh také uvolní exekutory a pokud se aplikace Spark přesune do stavu nečinnosti. Podnikoví uživatelé často obtížně ladí konfigurace exekutoru, protože se výrazně liší v různých fázích procesu provádění úloh Sparku. Tyto konfigurace jsou také závislé na objemu zpracovaných dat, které se mění od času do času. Jako součást konfigurace fondu můžete povolit dynamické přidělování exekutorů, což umožňuje automatické přidělování exekutorů do aplikace Spark na základě uzlů dostupných ve fondu Spark.

Když povolíte možnost dynamického přidělování pro každou odeslanou aplikaci Spark, systém si během kroku odeslání úlohy rezervuje exekutory na základě minimálních uzlů. Zadáte maximální počet uzlů pro podporu úspěšných scénářů automatického škálování.