Poznámka:

Přístup k této stránce vyžaduje autorizaci. Můžete se zkusit přihlásit nebo změnit adresáře.

Přístup k této stránce vyžaduje autorizaci. Můžete zkusit změnit adresáře.

Tento kurz vám pomůže urychlit proces vyhodnocení služby Data Factory v Microsoft Fabric tím, že poskytne kroky pro scénář úplné integrace dat do jedné hodiny. Na konci tohoto kurzu rozumíte hodnotám a klíčovým funkcím služby Data Factory a víte, jak dokončit běžný komplexní scénář integrace dat.

Scénář je rozdělený na úvod a tři moduly:

- Úvod do kurzu a proč byste měli používat službu Data Factory v Microsoft Fabric.

- Modul 1: Vytvoření datového kanálu pomocí služby Data Factory pro příjem nezpracovaných dat z úložiště objektů Blob do tabulky bronzové datové vrstvy v datovém jezeře Lakehouse.

- Modul 2: Transformace dat pomocí toku dat ve službě Data Factory za účelem zpracování nezpracovaných dat z bronzové tabulky a jejich přesunutí do tabulky zlaté datové vrstvy v data Lakehouse.

- Modul 3: Dokončete svou první cestu integrace dat a odešlete e-mail s upozorněním, jakmile jsou všechny úlohy dokončené, a nakonec nastavte celý tok tak, aby běžel podle plánu.

Proč Data Factory v Microsoft Fabricu?

Microsoft Fabric poskytuje jednu platformu pro všechny analytické potřeby podniku. Zahrnuje spektrum analýz, včetně pohybu dat, datových jezer, přípravy dat, integrace dat, datové vědy, analýz v reálném čase a business intelligence. S Fabric není nutné spojovat různé služby od více dodavatelů. Místo toho se vaši uživatelé mohou těšit z komplexního produktu, který je snadno pochopitelný, vytvářený, integrovaný a ovladatelný.

Data Factory ve službě Fabric kombinuje snadné použití Power Query se škálovatelností a výkonem Azure Data Factory. Přináší to nejlepší z obou produktů dohromady do jediného prostředí. Cílem je, aby občané i profesionální vývojáři dat měli správné nástroje pro integraci dat. Data Factory poskytuje prostředí pro přípravu a transformaci dat s nízkou úrovní kódu, přípravu a transformaci s podporou umělé inteligence, petabajtovou transformaci a stovky konektorů s hybridním a multicloudovým připojením.

Tři klíčové funkce služby Data Factory

- Načítání dat: Aktivita Kopírování v potrubích (nebo samostatná úloha Kopírování) umožňuje přesouvat petabajtová data ze stovek zdrojů dat do data Lakehouse pro další zpracování.

- Transformace a příprava dat: Tok dat Gen2 poskytuje rozhraní s nízkým kódem pro transformaci dat pomocí 300+ transformací dat s možností načíst transformované výsledky do více cílů, jako jsou databáze Azure SQL, Lakehouse a další.

- Kompletní automatizace: Kanály poskytují orchestraci aktivit, které zahrnují aktivity kopírování, toku dat a poznámkových bloků a dalších. Aktivity v pipeline mohou být zřetězeny tak, aby fungovaly postupně, nebo mohou pracovat nezávisle vedle sebe paralelně. Celý tok integrace dat se spouští automaticky a dá se monitorovat na jednom místě.

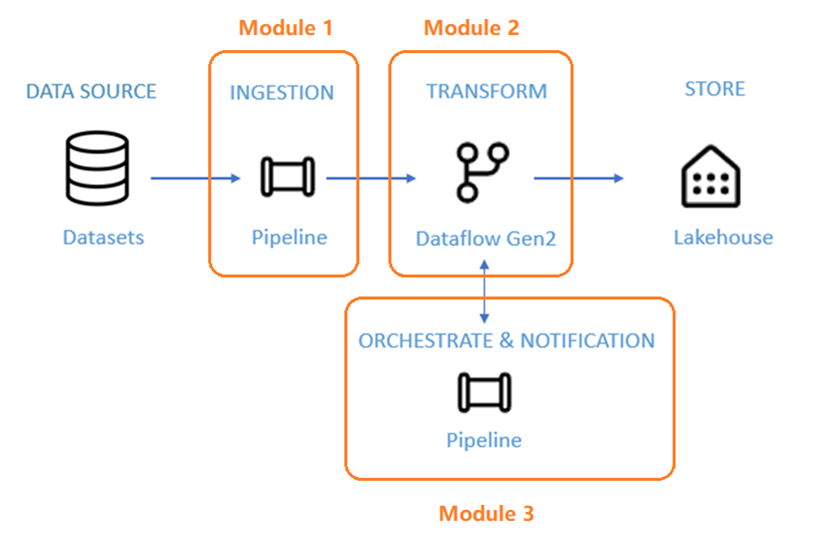

Architektura kurzu

Během následujících 50 minut se seznámíte se všemi třemi klíčovými funkcemi služby Data Factory při dokončení kompletního scénáře integrace dat.

Scénář je rozdělený do tří modulů:

- Modul 1: Vytvoření kanálu pomocí služby Data Factory pro příjem nezpracovaných dat z Blob úložiště do tabulky bronzové datové vrstvy v datovém Lakehouse.

- Modul 2: Transformace dat pomocí toku dat ve službě Data Factory za účelem zpracování nezpracovaných dat z bronzové tabulky a jejich přesunutí do tabulky zlaté datové vrstvy v data Lakehouse.

- Modul 3: Dokončete svou první cestu integrace dat a odešlete e-mail s upozorněním, jakmile jsou všechny úlohy dokončené, a nakonec nastavte celý tok tak, aby běžel podle plánu.

Jako zdroj dat pro kurz použijete ukázkovou datovou sadu NYC-Taxi . Po dokončení budete moct získat přehled o denních slevách na jízdné ve taxislužbě po určitou dobu pomocí služby Data Factory v Microsoft Fabric.

Další krok

Pokračujte k další části a vytvořte kanál.