Bemærk

Adgang til denne side kræver godkendelse. Du kan prøve at logge på eller ændre mapper.

Adgang til denne side kræver godkendelse. Du kan prøve at ændre mapper.

Python-notesbogen er en ny oplevelse, der er bygget oven på Fabric-notesbogen. Det er et alsidigt og interaktivt værktøj, der er designet til dataanalyse, visualisering og maskinel indlæring. Det giver en problemfri udviklingsoplevelse til skrivning og udførelse af Python-kode. Denne funktion gør den til et vigtigt værktøj for dataforskere, analytikere og BI-udviklere, især til udforskningsopgaver, der ikke kræver big data og distribueret databehandling.

Med en Python-notesbog kan du få:

Flere indbyggede Python-kerner: Python-notesbøger tilbyder et rent Python-kodemiljø uden Spark med to versioner af Python-kerne – Python 3.10 og 3.11 som standard, og de oprindelige ipython-funktioner understøttes, f.eks. iPyWidget, magiske kommandoer.

Omkostningseffektiv: Den nye Python-notesbog giver omkostningsbesparende fordele ved at køre på en enkelt nodeklynge med 2vCores/16 GB hukommelse som standard. Denne konfiguration sikrer effektiv ressourceudnyttelse for dataudforskningsprojekter med mindre datastørrelse.

Lakehouse & Ressourcer er oprindeligt tilgængelige: Fabric Lakehouse sammen med de indbyggede ressourcer for notesbogen er alle funktioner tilgængelige i Python-notesbogen. Denne funktion gør det nemt for brugerne at overføre dataene til Python-notesbogen. Prøv blot at trække & slip for at hente kodestykket.

Mix programmering med T-SQL: Python-notesbog er en nem måde at interagere med Data Warehouse og SQL-slutpunkter i Stifinder på. Ved hjælp af dataconnector til notebookutils kan du nemt udføre T-SQL-scripts under pythonkonteksten.

understøttelse af populære dataanalysebiblioteker: Python-notesbøger leveres med forudinstallerede biblioteker som DuckDB, Polars og Scikit-learn, hvilket giver en omfattende værktøjskasse til datamanipulation, analyse og maskinel indlæring.

Avanceret intellisense: Python notebook anvender Pylance som intellisense-motor sammen med andre Fabric-tilpassede sprogtjenester, der har til formål at give den nyeste kodningsoplevelse til notebook-udviklere.

NotebookUtils & semantisk link: Effektive API-værktøjssæt gør det nemt at bruge Fabric- og Power BI-funktioner med kode førstegangsoplevelse.

Rich VisualizationCapabilities: Med undtagelse af den populære avancerede datarammevisningsfunktion 'Tabel' og 'Diagram'-funktion understøtter vi også populære visualiseringsbiblioteker som Matplotlib, Seaborn og Plotly. PowerBIClient understøtter også disse biblioteker for at hjælpe brugerne med bedre at forstå datamønstre og indsigt.

Almindelige funktioner for Fabric Notebook-: Alle funktioner på notesbogniveau gælder naturligt for Python-notesbog, f.eks. redigeringsfunktioner, AutoSave, samarbejde, deling og tilladelsesstyring, Git-integration, import/eksport osv.

Full stack Data Science Capabilities: Den avancerede værktøjspakke med lav kode data Wrangler, MACHINE Learning Framework MLFlow og den effektive Copilot er alle tilgængelige i Python-notesbogen.

Sådan får du adgang til Python-notesbog

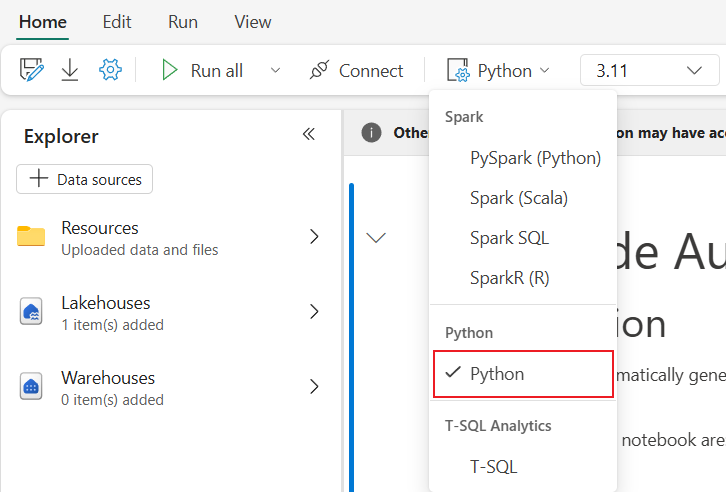

Når du har åbnet en Fabric Notebook, kan du skifte til Python i rullemenuen for sprog på fanen Hjem og konvertere hele notesbogsopsætningen til Python.

De fleste af de almindelige funktioner understøttes som et notesbogniveau. Du kan se Sådan bruger du Microsoft Fabric-notesbøger og Udvikl, udfør og administrer Microsoft Fabric-notesbøger for at få mere at vide om den detaljerede brug. Her kan du se nogle nøglefunktioner, der er specifikke for Python-scenarier.

Kør Python-notesbøger

Python-notesbog understøtter flere måder at udføre job på:

- Interaktiv kørsel: Du kan køre en Python-notesbog interaktivt som en oprindelig Jupyter-notesbog.

- Planlæg kørsel: Du kan bruge den lette planlægningsoplevelse på siden med notesbogsindstillinger til at køre Python-notesbog som et batchjob.

- Pipelinekørsel: Du kan orkestrere Python-notesbøger som notesbogsaktiviteter i Pipeline. Snapshot oprettes efter udførelsen af jobbet.

-

Referencekørsel: Du kan bruge

notebookutils.notebook.run()ellernotebookutils.notebook.runMultiple()referere til kørsler af Python-notesbøger i en anden Python-notesbog som batchjob. Snapshot oprettes, når referencekørslen er fuldført. - offentlige API kører: Du kan planlægge, at pythonnotesbogen køres med den notesbog køre offentlige API-, skal du kontrollere, at sprog- og kerneegenskaberne i notesbogmetadata for den offentlige API-nyttedata er angivet korrekt.

Du kan overvåge kørselsoplysningerne for Python-notesbogen under fanen Kør ->Vis alle kørsler.

Interaktion med data

Du kan interagere med Lakehouse, Warehouses, SQL-slutpunkter og indbyggede ressourcemapper i Python-notesbogen.

Note

- Python Notebook-runtime leveres forudinstalleret med delta-rs- og duckdb-biblioteker for at understøtte både læsning og skrivning af Delta Lake-data. Bemærk dog, at nogle Delta Lake-funktioner muligvis ikke understøttes fuldt ud på nuværende tidspunkt. For flere detaljer og de seneste opdateringer henvises til de officielle delta-rs og duckdb hjemmesider.

- Vi understøtter i øjeblikket ikke deltalake(delta-rs) version 1.0.0 eller nyere. Hold dig opdateret.

Lakehouse interaktion

Du kan angive et Lakehouse som standard, eller du kan også tilføje flere Lakehouses for at udforske og bruge dem i notesbøger.

Hvis du ikke er fortrolig med at læse dataobjekter som deltatabel, kan du prøve at trække og slippe filen og deltatabellen til notesbogens lærred eller bruge rullemenuen Indlæs data i objektets rullemenu. Notesbog indsætter automatisk kodestykke i kodecellen og genererer kode til læsning af destinationsdataobjektet.

Note

Hvis du støder på OOM, når du indlæser store mængder data, kan du prøve at bruge DuckDB-, Polars- eller PyArrow-dataramme i stedet for pandas.

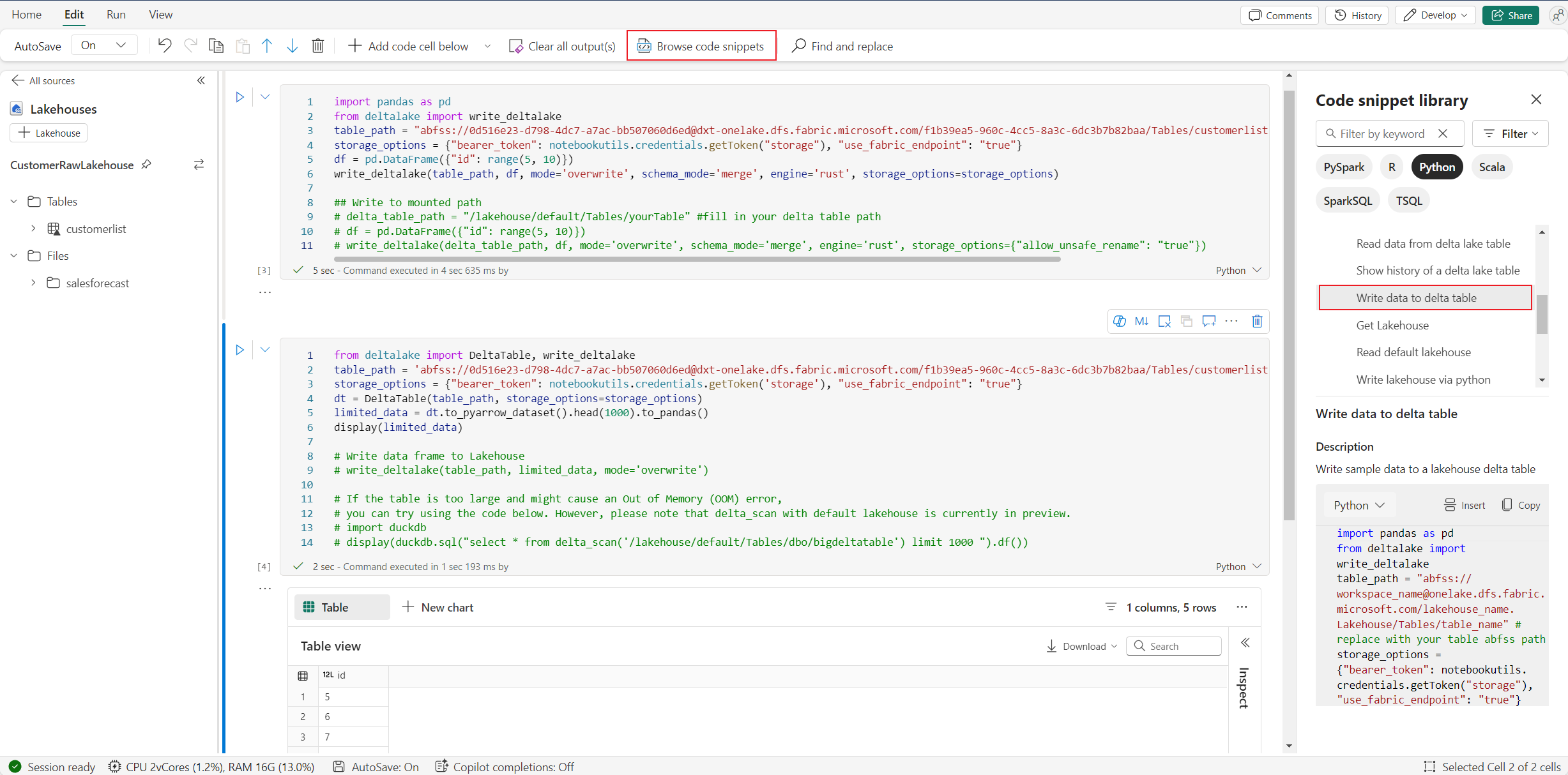

Du kan finde handlingen write Lakehouse i Gennemse kodestykke –>Skriv data til deltatabellen.

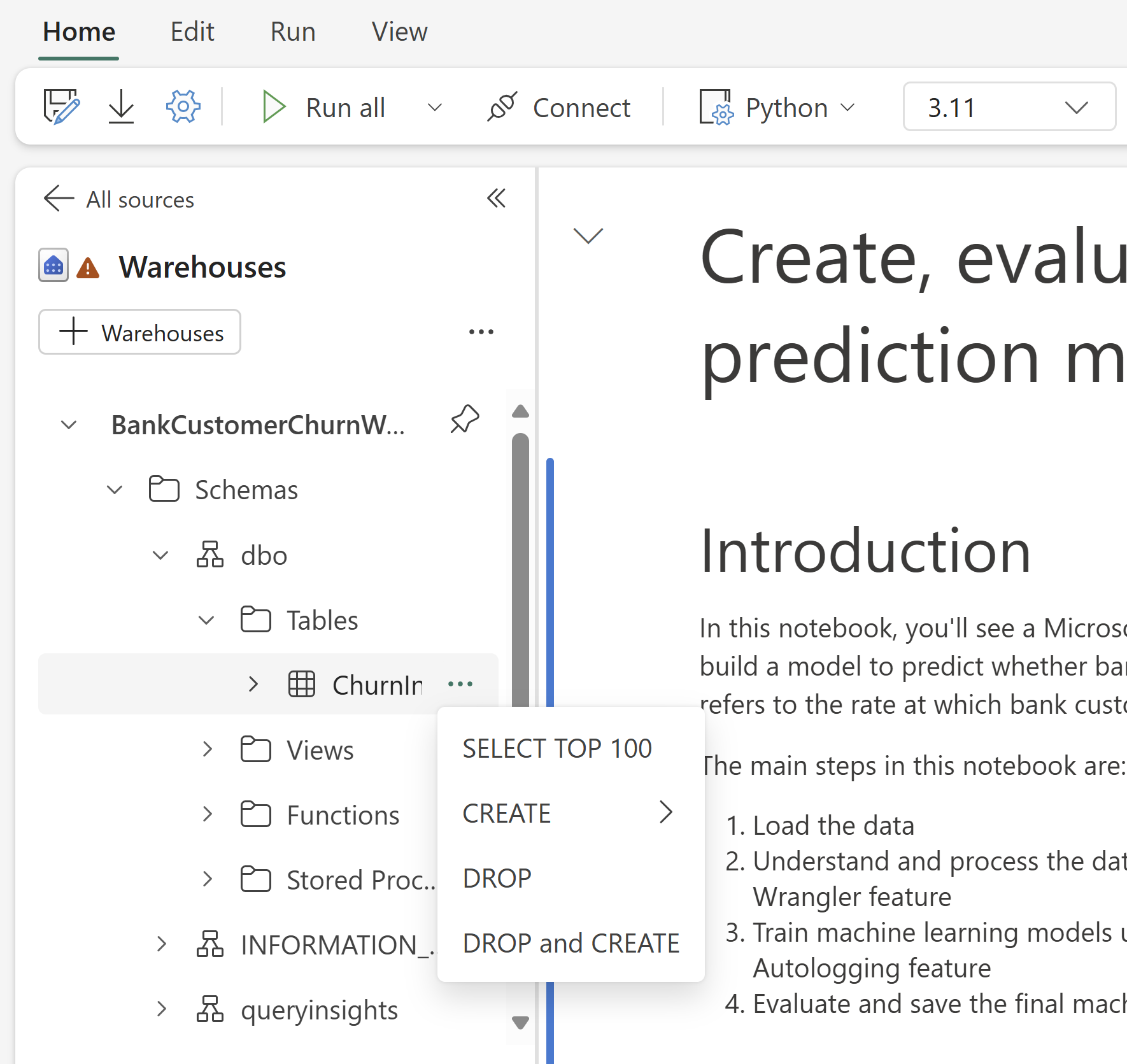

Lagerinteraktion og mix programmering med T-SQL

Du kan tilføje Data Warehouses eller SQL-slutpunkter fra Warehouse Explorer of Notebook. På samme måde kan du trække og slippe tabellerne på notesbogens lærred eller bruge genvejshandlinger i rullemenuen i tabellen. Notesbog genererer automatisk kodestykke for dig. Du kan bruge notebookutils.data hjælpeprogrammer til at oprette forbindelse til Warehouses og forespørge dataene ved hjælp af T-SQL-sætningen i forbindelse med Python.

Note

SQL-slutpunkter er skrivebeskyttede her.

Mappe med notesbogressourcer

Den indbyggede ressourcemappe Notebook-ressourcer er oprindeligt tilgængelig på Python Notebook. Du kan nemt interagere med filerne i den indbyggede ressourcemappe ved hjælp af Python-kode, som om du arbejder med dit lokale filsystem. Mappen Miljøressource understøttes ikke i øjeblikket.

Kerne operationer

Python notebook understøtter to indbyggede kerner lige nu, de er Python 3.10 og Python 3.11, den valgte standard kerne er Python 3.11. du kan nemt skifte mellem dem.

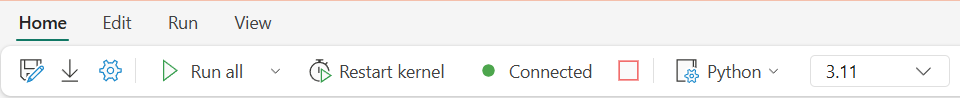

Du kan afbryde, genstarte eller skifte kerne på fanen Hjem på båndet. Afbrydelse af kernen i Python-notesbøger er det samme som at annullere cellen i Spark-notesbogen.

Unormal kerneafslutning medfører, at udførelsen af kode afbrydes og mister variabler, men det stopper ikke notesbogsessionen.

Der er kommandoer, der kan føre til kerne død. For eksempel quit(), exit().

Biblioteksledelse

Du kan bruge %pip og %conda kommandoer til indbyggede installationer, kommandoerne understøtter både offentlige biblioteker og tilpassede biblioteker.

For tilpassede biblioteker kan du overføre biblioteksfilerne til mappen Indbyggede ressourcer . Vi understøtter flere typer biblioteker, herunder formater som Wheel (.whl), JAR (.jar), DLL (.dll) og Python (.py). Bare prøv at trække og slippe til filen, og kodestykket genereres automatisk.

Du skal muligvis genstarte kernen for at bruge de opdaterede pakker.

For bedre at forstå og bruge lignende kommandoer tydeligt, se tabellen nedenfor.

| Command/Syntax | Hovedformål | Sådan fungerer det i Jupyter-notesbogen | Typisk use case | Notes |

|---|---|---|---|---|

%pip install package |

Installér Python-pakker | Kører pip i notesbogens Python-kerne | Anbefalet måde at installere pakker på | I Python Notebook er det samme som !pip; genstarter ikke kernen automatisk |

!pip install package |

Installér Python-pakker via shell | Kører pip som en shell-kommando | Alternativ måde at installere pakker på | I Python Notebook er det samme som %pip; genstarter ikke kernen automatisk |

import sys; sys.exit(0) |

Genstart notesbogkernen | Genstarter straks kernen | Genstart kernen programmatisk | Rydder alle variabler og tilstande; anbefales ikke at bruge direkte |

notebookutils.session.restartPython() |

Genstart notesbogkernen | Opkald sys.exit(0) internt |

Anbefalet måde at genstarte kernen på | Officiel API, sikrere og mere kompatibel end direkte brug sys.exit(0) |

Note

- I Python Notebook,

%pipog!piphar samme adfærd: begge installerer pakker i den aktuelle kernes miljø, og ingen af dem genstarter automatisk kernen efter installationen. - Hvis du har brug for at genstarte kernen (f.eks. efter installation af visse pakker), anbefales det at bruge

notebookutils.session.restartPython()i stedet forimport sys; sys.exit(0).-

notebookutils.session.restartPython()er en officiel API, der ombrydessys.exit(0), og den er sikrere og mere kompatibel i notesbogmiljøer.

-

- Det anbefales ikke at bruge

sys.exit(0)direkte, medmindre det er nødvendigt.

Overvågning af ressourceforbrug i realtid i Python-notesbog

Vigtigt

Denne funktion er en prøveversion.

Med ruden Ressourceovervågning kan du spore vigtige kørselsoplysninger, f.eks. sessionsvarighed, beregningstype og ressourcemålepunkter i realtid, herunder CPU- og hukommelsesforbrug, direkte i din notesbog. Denne funktion giver et øjeblikkeligt overblik over din aktive session og de ressourcer, der bruges.

Ressourcemonitoren forbedrer synligheden af, hvordan Python-arbejdsbelastninger bruger systemressourcer. Det hjælper dig med at optimere ydeevnen, administrere omkostninger og reducere risikoen for OOM-fejl (Out of Memory). Ved at overvåge målepunkter i realtid kan du identificere ressourcekrævende handlinger, analysere brugsmønstre og træffe informerede beslutninger om skalering eller ændring af kode.

Hvis du vil begynde at bruge det, skal du angive sproget i notesbogen til Python og starte en session. Du kan derefter åbne skærmen enten ved at klikke på beregningsressourcerne på notesbogens statuslinje eller ved at vælge Vis ressourceforbrug på værktøjslinjen. Ruden Ressourceovervågning vises automatisk, hvilket giver en integreret overvågningsoplevelse for Python-kode i Fabric-notesbøger.

Magisk kommando til konfiguration af session

På samme måde som med tilpasning af en Spark-sessionkonfiguration i notesbogen, kan du også bruge %%configure i Python-notesbogen. Python-notesbog understøtter tilpasning af størrelsen på beregningsnoden, tilslutningspunkter og standard lakehouse for notesbogsessionen. De kan bruges i både interaktive aktiviteter for notesbøger og pipelinenotesbøger. Vi anbefaler, at du bruger kommandoen %%configure i starten af notesbogen, eller du skal genstarte notesbogsessionen for at få indstillingerne til at træde i kraft.

Her er de understøttede egenskaber i Python-notesbogen %%configure:

%%configure -f

{

"vCores": 4, // Recommended values: [4, 8, 16, 32, 64], Fabric will allocate matched memory according to the specified vCores.

"defaultLakehouse": {

// Will overwrites the default lakehouse for current session

"name": "<lakehouse-name>",

"id": "<(optional) lakehouse-id>",

"workspaceId": "<(optional) workspace-id-that-contains-the-lakehouse>" // Add workspace ID if it's from another workspace

},

"mountPoints": [

{

"mountPoint": "/myMountPoint",

"source": "abfs[s]://<file_system>@<account_name>.dfs.core.windows.net/<path>"

},

{

"mountPoint": "/myMountPoint1",

"source": "abfs[s]://<file_system>@<account_name>.dfs.core.windows.net/<path1>"

},

],

}

Du kan få vist opdateringen af beregningsressourcer på statuslinjen for notesbogen og overvåge cpu- og hukommelsesforbruget for beregningsnoden i realtid.

NotebookUtils

Notebook Utilities (NotebookUtils) er en indbygget pakke, der hjælper dig med nemt at udføre almindelige opgaver i Fabric Notebook. Den er forudinstalleret på Python-kørsel. Du kan bruge NotebookUtils til at arbejde med filsystemer, til at hente miljøvariabler, til at sammenkæde notesbøger, til at få adgang til eksternt lager og til at arbejde med hemmeligheder.

Du kan bruge notebookutils.help() til at liste tilgængelige API'er og også få hjælp til metoder eller referere til dokumentet NotebookUtils.

Dataværktøjer

Note

Funktionen er i øjeblikket en prøveversion.

Du kan bruge notebookutils.data hjælpeprogrammer til at oprette forbindelse til den angivne datakilde og derefter læse og forespørge om data ved hjælp af T-SQL-sætningen.

Kør følgende kommando for at få en oversigt over de tilgængelige metoder:

notebookutils.data.help()

Output:

Help on module notebookutils.data in notebookutils:

NAME

notebookutils.data - Utility for read/query data from connected data sources in Fabric

FUNCTIONS

connect_to_artifact(artifact: str, workspace: str = '', artifact_type: str = '', **kwargs)

Establishes and returns an ODBC connection to a specified artifact within a workspace

for subsequent data queries using T-SQL.

:param artifact: The name or ID of the artifact to connect to.

:param workspace: Optional; The workspace in which the provided artifact is located, if not provided,

use the workspace where the current notebook is located.

:param artifactType: Optional; The type of the artifact, Currently supported type are Lakehouse, Warehouse and MirroredDatabase.

If not provided, the method will try to determine the type automatically.

:param **kwargs Optional: Additional optional configuration. Supported keys include:

- tds_endpoint : Allow user to specify a custom TDS endpoint to use for connection.

:return: A connection object to the specified artifact.

:raises UnsupportedArtifactException: If the specified artifact type is not supported to connect.

:raises ArtifactNotFoundException: If the specified artifact is not found within the workspace.

Examples:

sql_query = "SELECT DB_NAME()"

with notebookutils.data.connect_to_artifact("ARTIFACT_NAME_OR_ID", "WORKSPACE_ID", "ARTIFACT_TYPE") as conn:

df = conn.query(sql_query)

display(df)

help(method_name: str = '') -> None

Provides help for the notebookutils.data module or the specified method.

Examples:

notebookutils.data.help()

notebookutils.data.help("connect_to_artifact")

:param method_name: The name of the method to get help with.

DATA

__all__ = ['help', 'connect_to_artifact']

FILE

/home/trusted-service-user/jupyter-env/python3.10/lib/python3.10/site-packages/notebookutils/data.py

Forespørg om data fra Lakehouse

conn = notebookutils.data.connect_to_artifact("lakehouse_name_or_id", "optional_workspace_id", "optional_lakehouse_type")

df = conn.query("SELECT * FROM sys.schemas;")

Forespørg om data fra lager

conn = notebookutils.data.connect_to_artifact("warehouse_name_or_id", "optional_workspace_id", "optional_warehouse_type")

df = conn.query("SELECT * FROM sys.schemas;")

Forespørgsel data fra SQL-databasen

conn = notebookutils.data.connect_to_artifact("sqldb_name_or_id", "optional_workspace_id", "optional_sqldatabase_type")

df = conn.query("SELECT * FROM sys.schemas;")

Note

Dataværktøjerne i NotebookUtils er indtil videre kun tilgængelige på Python-notesbogen.

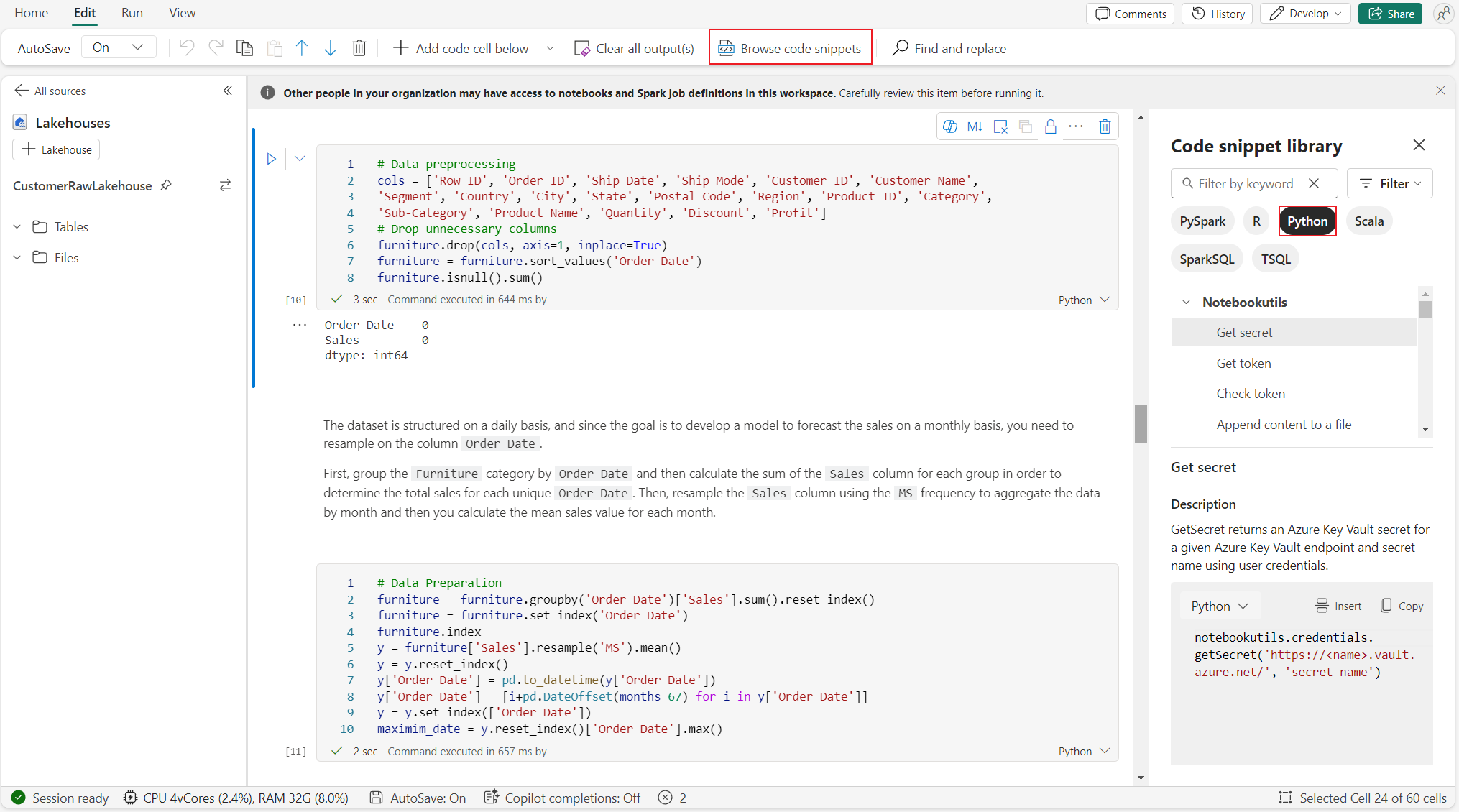

Gennemse kodestykker

Du kan finde nyttige python-kodestykker på fanen Rediger ->Gennemse kodestykke, nye Python-eksempler er nu tilgængelige. Du kan lære af Python-kodestykket for at begynde at udforske notesbogen.

Semantisk link

Semantisk link er en funktion, der giver dig mulighed for at oprette en forbindelse mellem semantiske modeller og Synapse Data Science i Microsoft Fabric. Det understøttes oprindeligt i Python-notesbogen. BI-teknikere og Power BI-udviklere kan nemt bruge Semantisk link til at oprette forbindelse og administrere semantisk model. Læs det offentlige dokument for at få mere at vide om semantisk link.

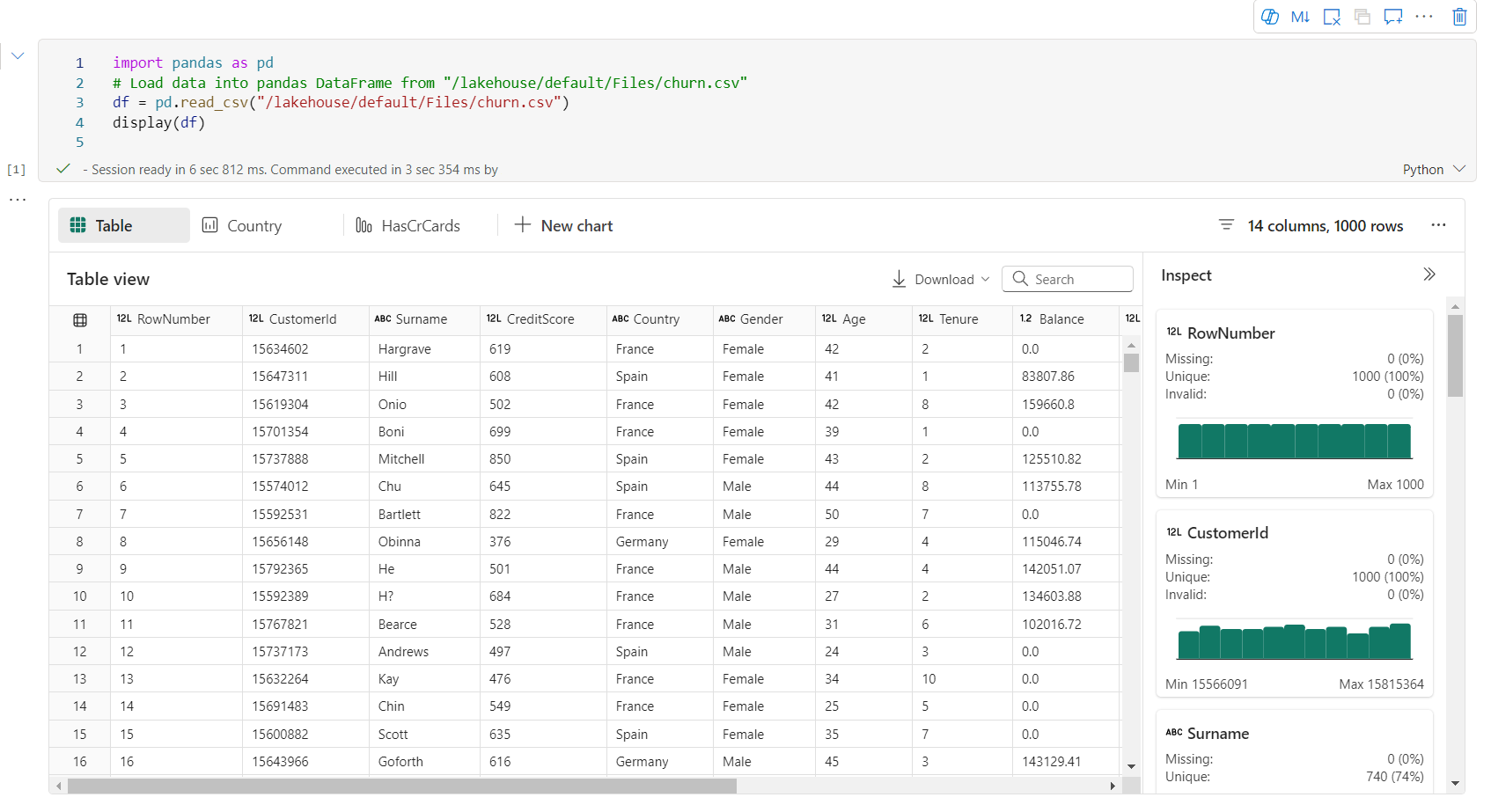

Visualization

Ud over at tegne diagrammer med biblioteker giver den indbyggede visualiseringsfunktion dig mulighed for at omdanne DataFrames til datavisualiseringer i rigt format. Du kan bruge funktionen display() på datarammer til at oprette den omfattende datarammetabelvisning og diagramvisning.

Note

Diagramkonfigurationerne bevares i Python-notesbogen, hvilket betyder, at de gemte diagrammer stadig bevares, når kodecellen er kørt igen, hvis måldatarammeskemaet ikke ændres.

Kode intelliSense

Python-notesbogen bruger også Pylance som sprogserver. Du kan få flere oplysninger under forbedre Python-udvikling med Pylance-.

Datavidenskabsegenskaber

Besøg Data Science-dokumentation i Microsoft Fabric for at få mere at vide om datavidenskab og AI-erfaring i Fabric. Her viser vi et par vigtige datavidenskabsfunktioner, der oprindeligt understøttes i Python-notesbogen.

Data Wrangler: Data Wrangler er et notesbogsbaseret værktøj, der giver en fordybende grænseflade til analyse af udforskningsdata. Denne funktion kombinerer en gitterlignende datavisning med dynamisk oversigtsstatistik, indbyggede visualiseringer og et bibliotek med almindelige datarensningshandlinger. Det leverer datarensning, datatransformation og integration, hvilket fremskynder dataforberedelse med Data Wrangler.

MLflow: Et eksperiment til maskinel indlæring er den primære enhed for organisering og kontrol for alle relaterede kørsler af maskinel indlæring. En kørsel svarer til en enkelt udførelse af modelkoden.

Fabric Auto Logging: Synapse Data Science i Microsoft Fabric omfatter automatisklogging, hvilket reducerer mængden af kode, der kræves for automatisk at logføre parametre, målepunkter og elementer i en model til maskinel indlæring under oplæringen.

Automatisklogging udvider MLflow Tracking-funktioner. Automatisk logning kan registrere forskellige målepunkter, herunder nøjagtighed, tab, F1-score og brugerdefinerede målepunkter, som du definerer. Ved hjælp af autologging kan udviklere og datateknikere nemt spore og sammenligne ydeevnen af forskellige modeller og eksperimenter uden manuel sporing.

Copilot: Copilot til notesbøger til datavidenskab og datateknik er en AI-assistent, der hjælper dig med at analysere og visualisere data. Den fungerer sammen med lakehouse-tabeller, Power BI-datasæt og pandas/spark-datarammer og giver svar og kodestykker direkte i notesbogen. Du kan bruge Copilot-chatpanelet og Char-magics i notesbogen, og AI'en giver svar eller kode, der kan kopieres til din notesbog.

Kendte begrænsninger

Live pool-oplevelsen er ikke garanteret for hver python-notesbogkørsel. Starttidspunktet for sessionen kan tage op til 3 minutter, hvis notesbogens kørsel ikke rammer den dynamiske gruppe. I takt med at forbruget af Python-notesbøger vokser, øger vores intelligente puljemetoder gradvist allokeringen af dynamiske puljer for at imødekomme efterspørgslen.

Miljøintegration er ikke tilgængelig i Python notebook.

Angiv timeout for session er ikke tilgængelig i øjeblikket.

Copilot kan generere Spark-sætning, som muligvis ikke kan eksekveres i Python-notesbogen.

I øjeblikket understøttes Copilot på Python-notesbogen ikke fuldt ud i flere områder. Udrulningsprocessen er stadig i gang, mens vi fortsætter med at udrulle support i flere områder.