Data Factory fra slutpunkt til slutpunkt-scenarie: introduktion og arkitektur

Dette selvstudium hjælper dig med at fremskynde evalueringsprocessen for Data Factory i Microsoft Fabric ved at levere en trinvis vejledning til et komplet dataintegrationsscenarie inden for én time. I slutningen af dette selvstudium forstår du værdien og nøglefunktionerne i Data Factory og ved, hvordan du fuldfører et almindeligt komplet dataintegrationsscenarie.

Oversigt: Hvorfor Data Factory i Microsoft Fabric?

Dette afsnit hjælper dig med at forstå Fabrics rolle generelt, og hvilken rolle Data Factory spiller i den.

Forstå værdien af Microsoft Fabric

Microsoft Fabric leverer en one-stop-shop til alle de analytiske behov for hver virksomhed. Den dækker et komplet udvalg af tjenester, herunder dataflytning, data lake, data engineering, dataintegration og datavidenskab, analyse i realtid og business intelligence. Med Fabric er der ingen grund til at sy forskellige tjenester fra flere leverandører. I stedet kan dine brugere godt lide et komplet, yderst integreret, enkelt og omfattende produkt, der er let at forstå, onboarde, oprette og betjene.

Forstå værdien af Data Factory i Microsoft Fabric

Data Factory i Fabric kombinerer brugervenligheden af Power Query med skaleringen og styrken ved Azure Data Factory. Det bringer det bedste fra begge produkter sammen til en samlet oplevelse. Målet er at sikre, at Data Integration in Factory fungerer godt for både borgere og professionelle dataudviklere. Det giver mulighed for dataforberedelse og transformation med lav kode, AI-aktiverede dataforberedelses- og transformationsoplevelser, transformation i petabyte-skala, hundredvis af connectors med hybride multicloud-forbindelser. Purview leverer styring, og tjenesten indeholder virksomhedsnøgledata/Op-forpligtelser, CI/CD, administration af programlivscyklus og overvågning.

Introduktion – Forstå tre vigtige funktioner i Data Factory

- Dataindtagelse: Kopiér aktivitet i pipelines gør det muligt at flytte petabyteskaleringsdata fra hundredvis af datakilder til dit data Lakehouse for yderligere behandling.

- Datatransformation og -forberedelse: Dataflow Gen2 giver en grænseflade med lav kode til transformering af dine data ved hjælp af mere end 300 datatransformationer med mulighed for at indlæse de transformerede resultater i flere destinationer, f.eks. Azure SQL-databaser, Lakehouse og meget mere.

- Automatisering af integrationsflow fra ende til anden: Pipelines leverer orkestrering af aktiviteter, der omfatter kopierings-, dataflow- og notesbogaktiviteter m.m. Dette giver dig mulighed for at administrere aktiviteter på ét sted. Aktiviteter i en pipeline kan sammenkædes for at fungere sekventielt, eller de kan fungere uafhængigt parallelt.

I denne brugscase for dataintegration fra ende til anden får du mere at vide:

- Sådan henter du data ved hjælp af kopiassistenten i en pipeline

- Sådan transformerer du dataene ved hjælp af et dataflow enten uden kode eller ved at skrive din egen kode for at behandle dataene med en script- eller notesbogaktivitet

- Sådan automatiserer du hele dataintegrationsflowet fra ende til anden ved hjælp af en pipeline med udløsere og fleksible styringsflowaktiviteter.

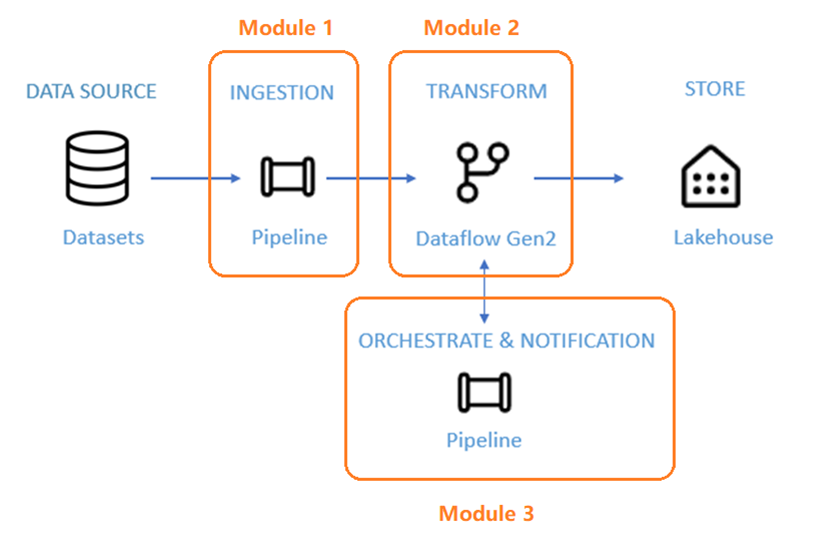

Arkitektur

I de næste 50 minutter har du til opgave at fuldføre et scenarie for dataintegration fra ende til anden. Dette omfatter indtagelse af rå data fra en kildebutik i bronzetabellen i en Lakehouse, behandling af alle dataene, flytning af dem til tabellen Gold i data Lakehouse, afsendelse af en mail for at give dig besked, når alle job er fuldført, og endelig konfiguration af hele flowet til at køre på en planlagt basis.

Scenariet er opdelt i tre moduler:

- Modul 1: Opret en pipeline med Data Factory til at indtage rådata fra et Blob Storage til en Bronze-tabel i et data Lakehouse.

- Modul 2: Transformér data med et dataflow i Data Factory for at behandle rådata fra din Bronze-tabel og flytte dem til en Guld-tabel i data Lakehouse.

- Modul 3: Fuldfør din første dataintegrationsrejse for at sende en mail for at give dig besked, når alle job er fuldført, og til sidst skal du konfigurere hele flowet til at køre på et planlagt grundlag.

Du kan bruge eksempeldatasættet NYC-Taxi som datakilde til selvstudiet. Når du er færdig, kan du få indsigt i daglige rabatter på taxapriser i en bestemt periode ved hjælp af Data Factory i Microsoft Fabric.

Relateret indhold

I denne introduktion til vores komplette selvstudium om din første dataintegration ved hjælp af Data Factory i Microsoft Fabric har du lært:

- Værdien og rollen af Microsoft Fabric

- Data Factorys værdi og rolle i Fabric

- Vigtige funktioner i Data Factory

- Det lærer du i dette selvstudium

Fortsæt til næste afsnit nu for at oprette din datapipeline.

Feedback

Kommer snart: I hele 2024 udfaser vi GitHub-problemer som feedbackmekanisme for indhold og erstatter det med et nyt feedbacksystem. Du kan få flere oplysninger under: https://aka.ms/ContentUserFeedback.

Indsend og få vist feedback om