Microsoft Purview-Datenschutz und Complianceschutz für generative KI-Anwendungen

Microsoft 365-Lizenzierungsleitfaden für Sicherheit & Compliance

Verwenden Sie Microsoft Purview, um die mit der KI-Nutzung verbundenen Risiken zu mindern und zu verwalten und entsprechende Schutz- und Governancekontrollen zu implementieren.

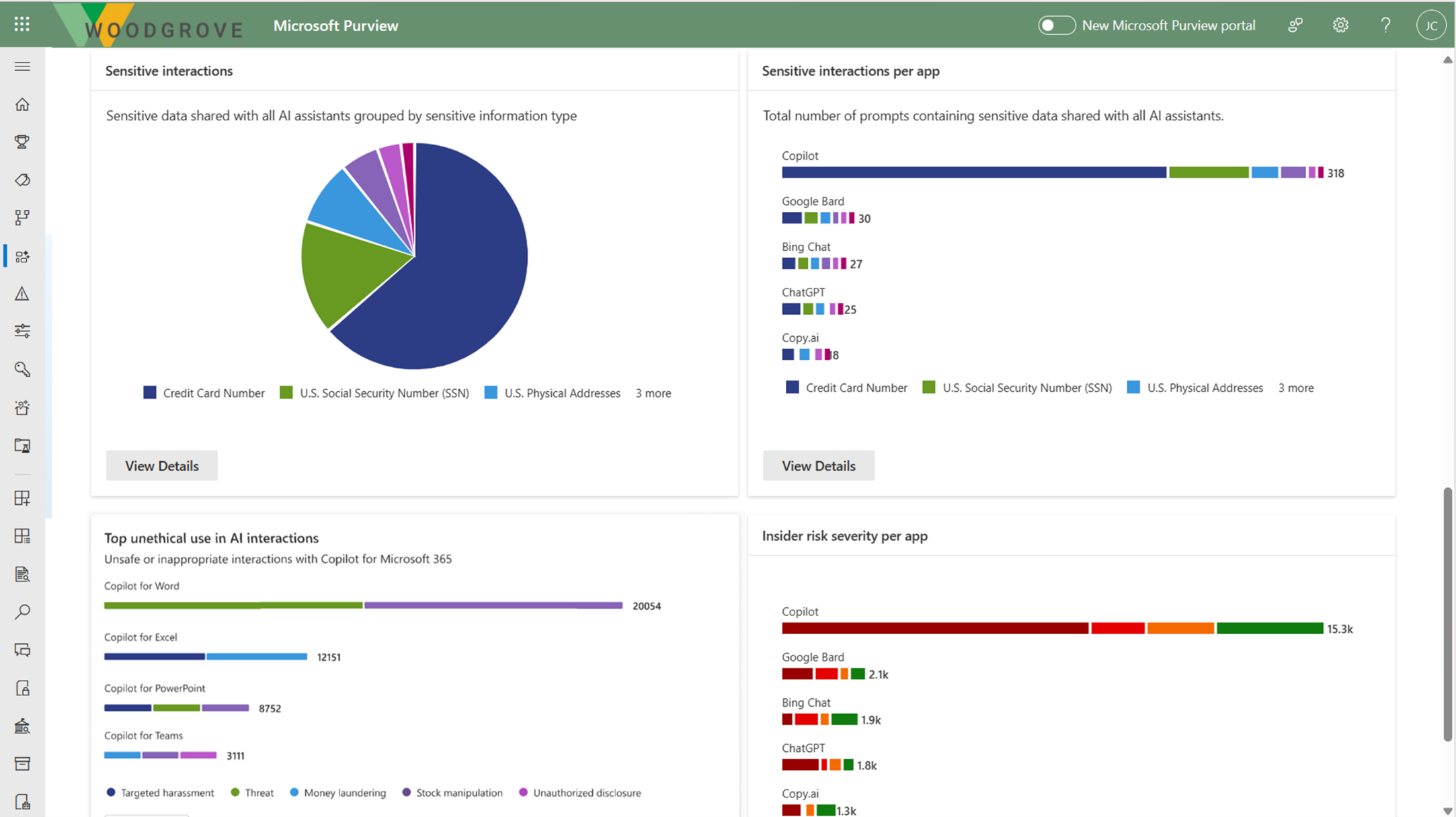

Microsoft Purview KI-Hub befindet sich derzeit in der Vorschauphase und bietet benutzerfreundliche grafische Tools und Berichte, mit denen Sie schnell Einblicke in die KI-Verwendung in Ihrem organization erhalten. 1-Klick-Richtlinien helfen Ihnen, Ihre Daten zu schützen und gesetzliche Anforderungen zu erfüllen.

Verwenden Sie den KI-Hub in Verbindung mit anderen Microsoft Purview-Funktionen, um Ihre Datensicherheit und Compliance für Microsoft 365 Copilot und Microsoft Copilot zu verbessern:

- Vertraulichkeitsbezeichnungen und Von Microsoft Purview Information Protection verschlüsselte Inhalte

- Datenklassifizierung

- Kundenschlüssel

- Kommunikationscompliance

- Überwachung

- Inhaltssuche

- eDiscovery

- Aufbewahrung und Löschung

- Customer Lockbox

Hinweis

Um zu überprüfen, ob die Lizenzierungspläne Ihrer organization diese Funktionen unterstützen, sehen Sie sich den Link lizenzierungsleitfaden oben auf der Seite an. Lizenzierungsinformationen für Microsoft 365 Copilot selbst finden Sie in der Dienstbeschreibung für Microsoft 365 Copilot.

Verwenden Sie die folgenden Abschnitte, um mehr über den KI-Hub und die Microsoft Purview-Funktionen zu erfahren, die zusätzliche Datensicherheits- und Compliancekontrollen bieten, um die Einführung von Microsoft 365 Copilot und anderen generativen KI-Apps durch Ihre organization zu beschleunigen. Wenn Sie noch nicht mit Microsoft Purview sind, finden Sie möglicherweise auch eine Übersicht über das Produkt hilfreich: Informationen zu Microsoft Purview.

Allgemeine Informationen zu Sicherheits- und Complianceanforderungen für Microsoft 365 Copilot finden Sie unter Daten, Datenschutz und Sicherheit für Microsoft 365 Copilot. Informationen zu Microsoft Copilot finden Sie unter Copilot Privacy and protections (Datenschutz und Schutz von Copilot).

Microsoft Purview KI-Hub bietet Einblicke, Richtlinien und Steuerelemente für KI-Apps

Hinweis

Microsoft Purview KI-Hub befindet sich derzeit in der Vorschauphase und kann geändert werden.

Der KI-Hub über das Microsoft Purview-Portal oder die Microsoft Purview-Complianceportal bietet einen zentralen Verwaltungsstandort, mit dem Sie Daten für KI-Apps schnell sichern und die KI-Nutzung proaktiv überwachen können. Zu diesen Apps gehören Microsoft 365 Copilot- und KI-Apps aus Drittanbietermodulen (Large Language Modules, LLMs).

Sehen Sie sich die folgende Videodemonstration an, um den KI-Hub in Aktion zu sehen:

Der KI-Hub bietet eine Reihe von Funktionen, mit denen Sie KI sicher einführen können, ohne zwischen Produktivität und Schutz wählen zu müssen:

Einblicke und Analysen zu KI-Aktivitäten in Ihrem organization

Sofort einsatzbereite Richtlinien zum Schutz von Daten und zum Verhindern von Datenverlust in KI-Eingabeaufforderungen

Compliancekontrollen zum Anwenden optimaler Datenverarbeitungs- und Speicherrichtlinien

Eine Liste der unterstützten KI-Websites von Drittanbietern, z. B. für Gemini und ChatGPT, finden Sie unter Unterstützte KI-Websites von Microsoft Purview für Datensicherheit und Complianceschutz.

Verwenden des KI-Hubs

Damit Sie schneller Einblicke in die KI-Nutzung gewinnen und Ihre Daten schützen können, bietet der KI-Hub einige vorkonfigurierte Richtlinien , die Sie mit nur einem Klick aktivieren können. Warten Sie mindestens 24 Stunden, bis diese neuen Richtlinien Daten sammeln, um die Ergebnisse im KI-Hub anzuzeigen oder änderungen widerzuspiegeln, die Sie an den Standardeinstellungen vornehmen.

Für die ersten Schritte mit dem KI-Hub können Sie entweder das Microsoft Purview-Portal oder die Microsoft Purview-Complianceportal verwenden. Sie benötigen ein Konto, das über die entsprechenden Berechtigungen für die Complianceverwaltung verfügt, z. B. ein Konto, das Mitglied der Gruppenrolle Microsoft Entra Complianceadministrator ist.

Navigieren Sie abhängig vom verwendeten Portal zu einem der folgenden Speicherorte:

Anmelden beim Microsoft Purview-Portal>KI-Hub (Vorschau) Karte.

Wenn der KI-Hub (Vorschau) Karte nicht angezeigt wird, wählen Sie Alle Lösungen anzeigen und dann KI-Hub (Vorschau) im Abschnitt Datensicherheit aus.

Melden Sie sich beim Microsoft Purview-Complianceportal>AI-Hub (Vorschau) an.

Lesen Sie in Analytics den Abschnitt Erste Schritte , um mehr über den KI-Hub und die unmittelbaren Aktionen zu erfahren, die Sie ergreifen können. Wählen Sie die einzelnen Optionen aus, um den Flyoutbereich anzuzeigen, um mehr zu erfahren, Aktionen auszuführen und Ihre aktuelle status zu überprüfen.

Aktion Weitere Informationen Aktivieren von Microsoft Purview Audit Die Überwachung ist für neue Mandanten standardmäßig aktiviert, sodass Sie diese Voraussetzung möglicherweise bereits erfüllen. Wenn Sie dies tun und Benutzern bereits Lizenzen für Copilot zugewiesen sind, erhalten Sie im Abschnitt KI-Datenanalyse weiter unten auf der Seite Erkenntnisse zu Copilot-Aktivitäten. Installieren der Microsoft Purview-Browsererweiterung Eine Voraussetzung für KI-Websites von Drittanbietern. Integrieren von Geräten in Microsoft Purview Auch eine Voraussetzung für KI-Websites von Drittanbietern. Erweitern Ihrer Erkenntnisse für die Datenermittlung 1-Klick-Richtlinien zum Sammeln von Informationen über Benutzer, die generative KI-Websites von Drittanbietern besuchen und ihnen vertrauliche Informationen senden. Die Option ist identisch mit der Schaltfläche Erweitern Ihrer Erkenntnisse im Abschnitt KI-Datenanalysen weiter unten auf der Seite. Weitere Informationen zu den Voraussetzungen finden Sie unter Voraussetzungen für den KI-Hub.

Weitere Informationen zu den vorkonfigurierten Richtlinien, die Sie aktivieren können, finden Sie unter 1-Klick-Richtlinien vom KI-Hub.

Überprüfen Sie dann den Abschnitt Empfehlungen , und entscheiden Sie, ob Optionen implementiert werden sollen, die für Ihren Mandanten relevant sind. Zum Beispiel:

- Wählen Sie Details anzeigen aus , um Anleitungen zu KI-Vorschriften zu erhalten , die gesetzliche Vorlagen für die Steuerungszuordnung aus dem Compliance-Manager verwenden.

- Wählen Sie Details anzeigen für Schützen vertraulicher Daten aus, auf die in Copilot-Antworten verwiesen wird, um Inhalte zu identifizieren, auf die von Microsoft 365 Copilot verwiesen wurde und nicht mit einer Vertraulichkeitsbezeichnung geschützt ist.

Wählen Sie Richtlinien im KI-Hub aus, wo Sie schnell Standardrichtlinien aktivieren können, um vertrauliche Daten zu schützen, die an generative KI-Websites von Drittanbietern gesendet werden, und schützen Sie Ihre Daten mit Vertraulichkeitsbezeichnungen. Weitere Informationen zu diesen Richtlinien finden Sie unter 1-Klick-Richtlinien aus dem KI-Hub. Sie müssen mindestens einen Tag warten, bis die Berichte aufgefüllt werden.

Wählen Sie unter Empfehlungen und Erhöhen Der Datensicherheit für KI die Option Erste Schritte aus, um mehr zu erfahren, Maßnahmen zu ergreifen und Ihre aktuelle status zu überprüfen.

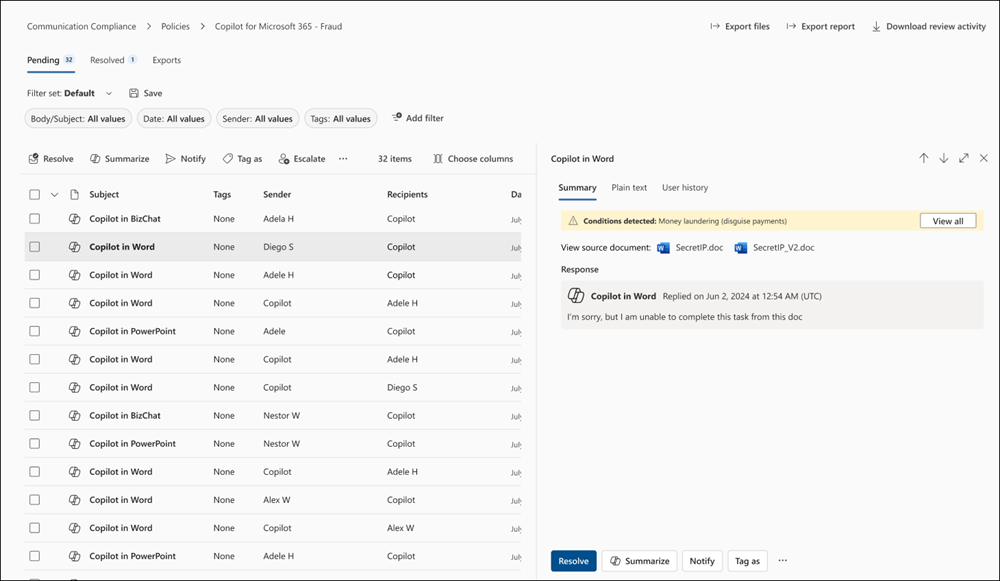

Wenn Ihre Richtlinien erstellt werden, einschließlich der Richtlinien aus Analytics, können Sie deren status auf dieser Seite überwachen. Um sie zu bearbeiten, verwenden Sie die entsprechende Verwaltungslösung im Portal. Beispielsweise können Sie für die Steuerung von unethischem Verhalten in KIdie Übereinstimmungen aus der Kommunikationscompliance-Lösung überprüfen und korrigieren.

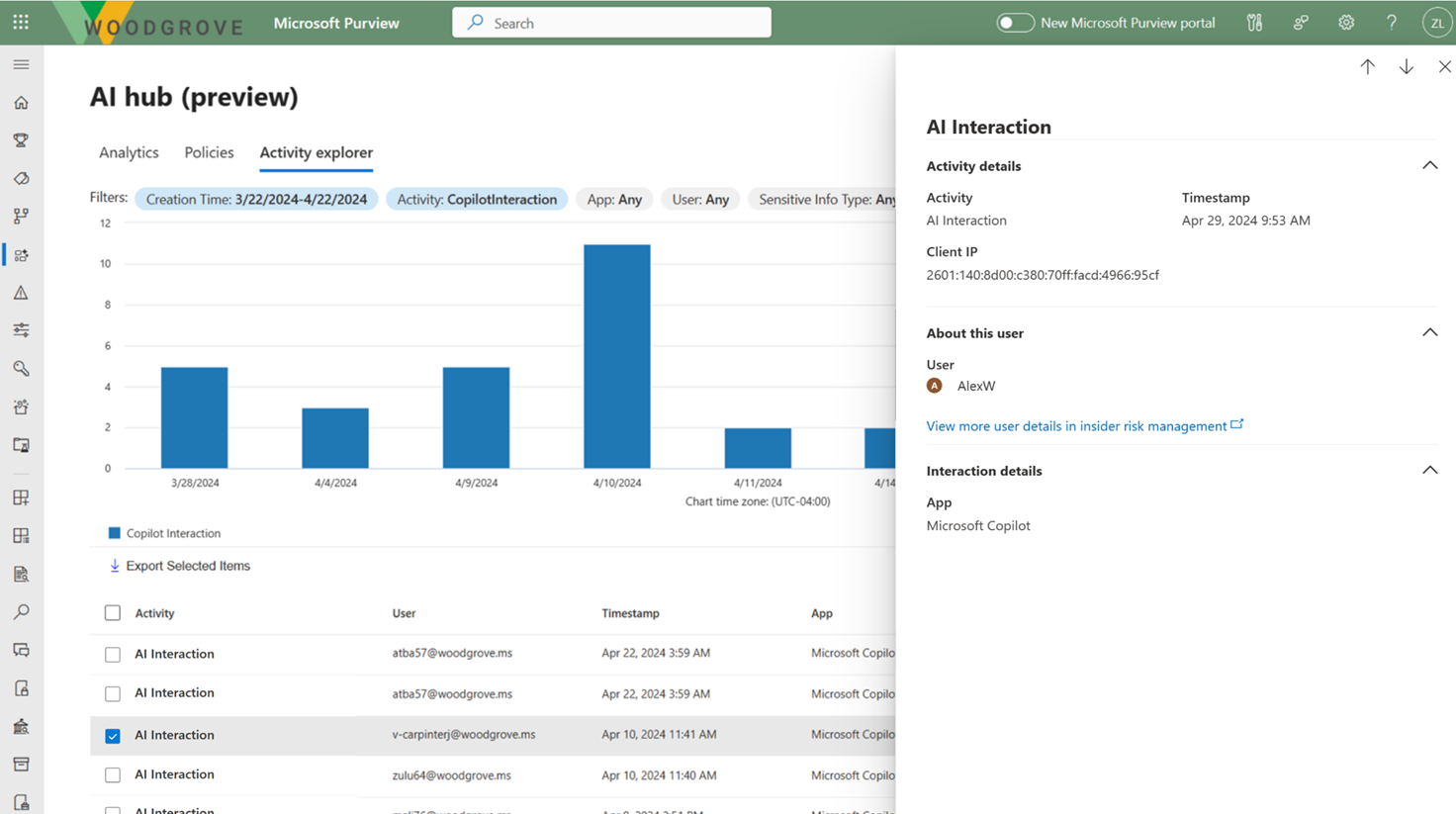

Wählen Sie im KI-Hub Aktivitäts-Explorer aus, um Details zu den daten anzuzeigen, die aus Ihren Richtlinien gesammelt wurden. Wenn Sie details anzeigen aus einem der Diagramme auf der Seite Analyse oder auf der Seite Richtlinien auswählen, gelangen Sie auch zum Aktivitäts-Explorer.

Diese detaillierteren Informationen umfassen Aktivität, Workload und App, Benutzer, Datum und Uhrzeit sowie alle erkannten vertraulichen Informationstypen.

Beispiele für Aktivitäten sind KI-Interaktion, Klassifizierungsstempel, DLP-Regelmatch und KI-Besuch. Copilot-Eingabeaufforderungen und -antworten sind in den KI-Interaktionsereignissen enthalten, wenn Sie über die richtigen Berechtigungen verfügen. Weitere Informationen zu den Ereignissen finden Sie unter Aktivitäts-Explorer-Ereignisse.

Beispiele für Apps sind Microsoft 365 Copilot und Andere KI-Apps.

Verwenden Sie für Microsoft 365 Copilot und Microsoft Copilot diese Richtlinien und Erkenntnisse in Verbindung mit zusätzlichen Schutz- und Compliancefunktionen von Microsoft Purview.

Microsoft Purview stärkt den Informationsschutz für Copilot

Microsoft 365 Copilot verwendet vorhandene Steuerelemente, um sicherzustellen, dass in Ihrem Mandanten gespeicherte Daten niemals an den Benutzer zurückgegeben oder von einem großen Sprachmodell (LLM) verwendet werden, wenn der Benutzer keinen Zugriff auf diese Daten hat. Wenn für die Daten Vertraulichkeitsbezeichnungen aus Ihrem organization auf den Inhalt angewendet werden, gibt es eine zusätzliche Schutzebene:

Wenn eine Datei in Word, Excel, PowerPoint oder ähnlich einem E-Mail- oder Kalenderereignis in Outlook geöffnet ist, wird die Vertraulichkeit der Daten für Benutzer in der App mit dem Bezeichnungsnamen und den Inhaltsmarkierungen (z. B. Kopf- oder Fußzeilentext) angezeigt, die für die Bezeichnung konfiguriert wurden. Loop Komponenten und Seiten unterstützen auch die gleichen Vertraulichkeitsbezeichnungen.

Wenn die Vertraulichkeitsbezeichnung eine Verschlüsselung anwendet, müssen Benutzer über das EXTRACT-Nutzungsrecht sowie ÜBER VIEW verfügen, damit Copilot die Daten zurückgeben kann.

Dieser Schutz erstreckt sich auf Daten, die außerhalb Ihres Microsoft 365-Mandanten gespeichert sind, wenn sie in einer Office-App (verwendete Daten) geöffnet sind. Beispielsweise lokaler Speicher, Netzwerkfreigaben und Cloudspeicher.

Tipp

Falls noch nicht geschehen, empfehlen wir Ihnen, Vertraulichkeitsbezeichnungen für SharePoint und OneDrive zu aktivieren und sich auch mit den Dateitypen und Bezeichnungskonfigurationen vertraut zu machen, die von diesen Diensten verarbeitet werden können. Wenn Vertraulichkeitsbezeichnungen für diese Dienste nicht aktiviert sind, sind die verschlüsselten Dateien, auf die Microsoft 365 Copilot zugreifen können, auf Daten beschränkt, die von Office-Apps unter Windows verwendet werden.

Anweisungen finden Sie unter Aktivieren von Vertraulichkeitsbezeichnungen für Office-Dateien in SharePoint und OneDrive.

Wenn Sie Business Chat (ehemals Graph-geerdeter Chat und Microsoft 365 Chat) verwenden, der auf Daten aus einer vielzahl von Inhalten zugreifen kann, wird die Vertraulichkeit der von Microsoft 365 Copilot zurückgegebenen bezeichneten Daten für Benutzer sichtbar gemacht, wobei die Vertraulichkeitsbezeichnung für Zitate und die in der Antwort aufgeführten Elemente angezeigt wird. Mithilfe der Prioritätsnummer der Vertraulichkeitsbezeichnungen, die im Microsoft Purview-Portal oder im Microsoft Purview-Complianceportal definiert ist, zeigt die neueste Antwort in Copilot die Vertraulichkeitsbezeichnung mit der höchsten Priorität aus den Daten an, die für diesen Copilot-Chat verwendet werden.

Obwohl Complianceadministratoren die Priorität einer Vertraulichkeitsbezeichnung definieren, bedeutet eine höhere Prioritätszahl in der Regel eine höhere Vertraulichkeit des Inhalts mit restriktiveren Berechtigungen. Daher werden Copilot-Antworten mit der restriktivsten Vertraulichkeitsbezeichnung bezeichnet.

Hinweis

Wenn Elemente von Microsoft Purview Information Protection verschlüsselt werden, aber keine Vertraulichkeitsbezeichnung haben, gibt Microsoft 365 Copilot diese Elemente auch nicht an Benutzer zurück, wenn die Verschlüsselung nicht die Extract- oder VIEW-Nutzungsrechte für den Benutzer enthält.

Wenn Sie noch keine Vertraulichkeitsbezeichnungen verwenden, finden Sie weitere Informationen unter Erste Schritte mit Vertraulichkeitsbezeichnungen.

Obwohl DLP-Richtlinien noch keine Interaktionen für Microsoft 365 Copilot unterstützen, wird die Datenklassifizierung für vertrauliche Informationstypen und trainierbare Klassifizierer unterstützt, um vertrauliche Daten in Benutzeraufforderungen an Copilot und Antworten zu identifizieren.

Copilot-Schutz mit Vertraulichkeitsbezeichnungsvererbung

Wenn Sie Microsoft 365 Copilot verwenden, um neue Inhalte basierend auf einem Element zu erstellen, auf das eine Vertraulichkeitsbezeichnung angewendet wurde, wird die Vertraulichkeitsbezeichnung aus der Quelldatei automatisch mit den Schutzeinstellungen der Bezeichnung geerbt.

Beispielsweise wählt ein Benutzer Entwurf mit Copilot in Word und dann Auf eine Datei verweisen aus. Oder ein Benutzer wählt Präsentation aus Datei in PowerPoint erstellen aus. Auf den Quellinhalt ist die Vertraulichkeitsbezeichnung Confidential\Anyone (uneingeschränkt) angewendet, und diese Bezeichnung ist so konfiguriert, dass eine Fußzeile angewendet wird, die "Vertraulich" anzeigt. Der neue Inhalt wird automatisch mit derselben Fußzeile als Vertraulich\Jeder (uneingeschränkt) bezeichnet.

Um ein Beispiel dafür in Aktion zu sehen, watch die folgende Demo aus der Ignite 2023-Sitzung "Getting your enterprise ready for Microsoft 365 Copilot". Die Demo zeigt, wie die Standard-Vertraulichkeitsbezeichnung " Allgemein " durch eine Vertrauliche Bezeichnung ersetzt wird, wenn ein Benutzer einen Entwurf mit Copilot erstellt und auf eine beschriftete Datei verweist. Die Informationsleiste unter dem Menüband informiert den Benutzer darüber, dass von Copilot erstellte Inhalte dazu geführt haben, dass die neue Bezeichnung automatisch angewendet wurde:

Wenn mehrere Dateien zum Erstellen neuer Inhalte verwendet werden, wird die Vertraulichkeitsbezeichnung mit der höchsten Priorität für die Bezeichnungsvererbung verwendet.

Wie bei allen automatischen Bezeichnungsszenarien kann der Benutzer eine geerbte Bezeichnung immer außer Kraft setzen und ersetzen (oder entfernen, wenn Sie keine obligatorische Bezeichnung verwenden).

Microsoft Purview-Schutz ohne Vertraulichkeitsbezeichnungen

Auch wenn keine Vertraulichkeitsbezeichnung auf Inhalte angewendet wird, können Dienste und Produkte die Verschlüsselungsfunktionen des Azure Rights Management-Diensts verwenden. Daher können Microsoft 365 Copilot weiterhin nach den VIEW- und EXTRACT-Nutzungsrechten suchen, bevor Sie Daten und Links an einen Benutzer zurückgeben, aber es erfolgt keine automatische Vererbung des Schutzes für neue Elemente.

Tipp

Sie erhalten die beste Benutzererfahrung, wenn Sie immer Vertraulichkeitsbezeichnungen verwenden, um Ihre Daten zu schützen und die Verschlüsselung durch eine Bezeichnung angewendet wird.

Beispiele für Produkte und Dienste, die die Verschlüsselungsfunktionen des Azure Rights Management-Diensts ohne Vertraulichkeitsbezeichnungen verwenden können:

- Microsoft Purview-Nachrichtenverschlüsselung

- Microsoft Information Rights Management (IRM)

- Microsoft Rights Management-Connector

- Microsoft Rights Management SDK

Für andere Verschlüsselungsmethoden, die den Azure Rights Management-Dienst nicht verwenden:

S/MIME-geschützte E-Mails werden von Copilot nicht zurückgegeben, und Copilot ist in Outlook nicht verfügbar, wenn eine mit S/MIME geschützte E-Mail geöffnet ist.

Auf kennwortgeschützte Dokumente kann von Microsoft 365 Copilot nicht zugegriffen werden, es sei denn, sie sind bereits vom Benutzer in derselben App geöffnet (verwendete Daten). Kennwörter werden nicht von einem Zielelement geerbt.

Wie bei anderen Microsoft 365-Diensten wie eDiscovery und Search werden mit Microsoft Purview Customer Key oder Ihrem eigenen Stammschlüssel (BYOK) verschlüsselte Elemente unterstützt und können von Microsoft 365 Copilot zurückgegeben werden.

Microsoft Purview unterstützt die Complianceverwaltung für Copilot.

Verwenden Sie die Microsoft Purview-Compliancefunktionen mit dem Schutz von Unternehmensdaten, um Ihre Risiko- und Complianceanforderungen für Microsoft 365 Copilot und Microsoft Copilot zu unterstützen.

Interaktionen mit Copilot können für jeden Benutzer in Ihrem Mandanten überwacht werden. Daher können Sie die Klassifizierungsfunktionen von Purview (Typen vertraulicher Informationen und trainierbare Klassifizierer), Inhaltssuche, Kommunikationscompliance, Überwachung, eDiscovery und automatische Aufbewahrung und Löschung mithilfe von Aufbewahrungsrichtlinien verwenden.

Zur Einhaltung der Kommunikation können Sie Benutzereingabeaufforderungen und Copilot-Antworten analysieren, um unangemessene oder riskante Interaktionen oder die Weitergabe vertraulicher Informationen zu erkennen. Weitere Informationen finden Sie unter Konfigurieren einer Kommunikationskonformitätsrichtlinie zur Erkennung von Copilot-Interaktionen.

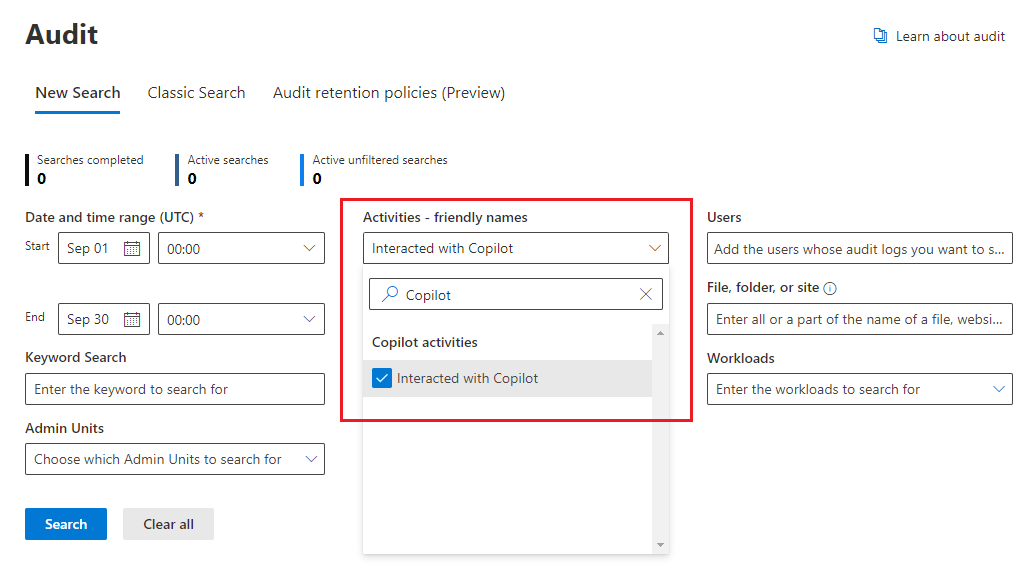

Für die Überwachung werden Details im einheitlichen Überwachungsprotokoll erfasst , wenn Benutzer mit Copilot interagieren. Zu den Ereignissen gehören, wie und wann Benutzer mit Copilot interagieren, in dem der Microsoft 365-Dienst die Aktivität stattfand, sowie Verweise auf die in Microsoft 365 gespeicherten Dateien, auf die während der Interaktion zugegriffen wurde. Wenn auf diese Dateien eine Vertraulichkeitsbezeichnung angewendet wird, wird diese ebenfalls erfasst. Wählen Sie in der Überwachungslösung im Microsoft Purview-Portal oder im Microsoft Purview-Complianceportaldie Option Copilot-Aktivitäten und Interagiert mit Copilot aus. Sie können auch Copilot als Workload auswählen. Beispiel: Über das Complianceportal:

Da Bei der Inhaltssuche Benutzeraufforderungen zu Copilot und Antworten von Copilot im Postfach eines Benutzers gespeichert werden, können sie durchsucht und abgerufen werden, wenn das Postfach des Benutzers als Quelle für eine Suchabfrage ausgewählt wird. Wählen Sie diese Daten aus, und rufen Sie sie aus dem Quellpostfach ab, indem Sie im Abfrage-Generator bedingungstyp>>entspricht einer der> Optionen >Hinzufügen/EntfernenCopilot-Interaktionen auswählen.

In ähnlicher Weise verwenden Sie für eDiscovery denselben Abfrageprozess, um Postfächer auszuwählen und Benutzeraufforderungen an Copilot und Antworten von Copilot abzurufen. Nachdem die Sammlung erstellt und der Überprüfungsphase in eDiscovery (Premium) zugeordnet wurde, sind diese Daten für alle vorhandenen Überprüfungsaktionen verfügbar. Diese Sammlungen und Überprüfungssätze können dann weiterhin zurückgehalten oder exportiert werden. Wenn Sie diese Daten löschen müssen, lesen Sie Suchen nach und Löschen von Daten für Copilot.

Für Aufbewahrungsrichtlinien , die die automatische Aufbewahrung und Löschung unterstützen, werden Benutzeraufforderungen an Copilot und Antworten von Copilot durch den Standort Teams-Chats und Copilot-Interaktionen identifiziert. Bisher nur Teams-Chats genannt, müssen Benutzer keinen Teams-Chat verwenden, damit diese Richtlinie auf sie angewendet wird. Alle vorhandenen Aufbewahrungsrichtlinien, die zuvor für Teams-Chats konfiguriert wurden, umfassen jetzt automatisch Benutzereingabeaufforderungen und Antworten zu und von Microsoft 365 Copilot und Microsoft Copilot:

Ausführliche Informationen zu dieser Aufbewahrung finden Sie unter Informationen zur Aufbewahrung für Copilot.

Wie bei allen Aufbewahrungsrichtlinien und Aufbewahrungsrichtlinien lösen die Prinzipien der Aufbewahrung alle Konflikte, wenn mehr als eine Richtlinie für denselben Speicherort für einen Benutzer gilt. Beispielsweise werden die Daten für die längste Dauer aller angewendeten Aufbewahrungsrichtlinien oder eDiscovery-Haltebereiche aufbewahrt.

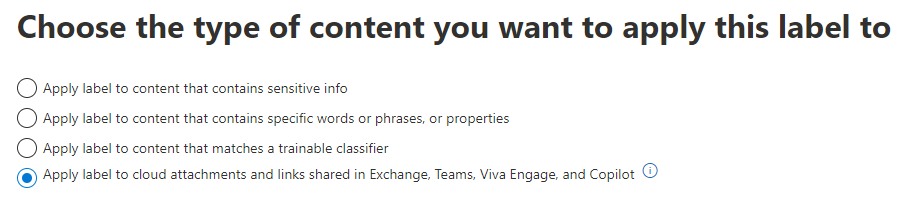

Damit Aufbewahrungsbezeichnungen Dateien, auf die in Copilot verwiesen wird, automatisch aufbewahren können, wählen Sie die Option für Cloudanlagen mit automatisch angewendeter Aufbewahrungsbezeichnungsrichtlinie aus: Bezeichnung auf Cloudanlagen und links anwenden, die in Exchange, Teams, Viva Engage und Copilot freigegeben sind. Wie bei allen beibehaltenen Cloudanlagen wird die Dateiversion zum Zeitpunkt des Verweises beibehalten.

Ausführliche Informationen zur Funktionsweise dieser Aufbewahrung finden Sie unter Funktionsweise der Aufbewahrung mit Cloudanlagen.

Konfigurationsanweisungen:

Informationen zum Konfigurieren von Kommunikationscompliancerichtlinien für Copilot-Interaktionen finden Sie unter Erstellen und Verwalten von Kommunikationscompliancerichtlinien.

Informationen zum Durchsuchen des Überwachungsprotokolls nach Copilot-Interaktionen finden Sie unter Durchsuchen des Überwachungsprotokolls.

Informationen zum Suchen nach Copilot-Interaktionen mithilfe der Inhaltssuche finden Sie unter Suchen nach Inhalten.

Informationen zur Verwendung von eDiscovery für Copilot-Interaktionen finden Sie unter Microsoft Purview-eDiscovery Lösungen.

Informationen zum Erstellen oder Ändern einer Aufbewahrungsrichtlinie für Copilot-Interaktionen finden Sie unter Erstellen und Konfigurieren von Aufbewahrungsrichtlinien.

Informationen zum Erstellen einer Automatisch angewendeten Aufbewahrungsbezeichnungsrichtlinie für Dateien, auf die in Copilot verwiesen wird, finden Sie unter Automatisches Anwenden einer Aufbewahrungsbezeichnung zum Aufbewahren oder Löschen von Inhalten.

Weitere Dokumentation für den KI-Hub und Copilot

Ankündigung eines Blogbeitrags: Schützen Sie Ihre Daten, um die vorteile der generativen KI mit Microsoft Purview sicher zu nutzen

Ausführlichere Informationen finden Sie unter Überlegungen zu Microsoft Purview KI-Hub und Datensicherheit und Complianceschutz für Copilot.

Microsoft 365 Copilot: